L'IA ce n'est pas de la magie!!

@_Akanoa_

https://lafor.ge

Yannick Guern

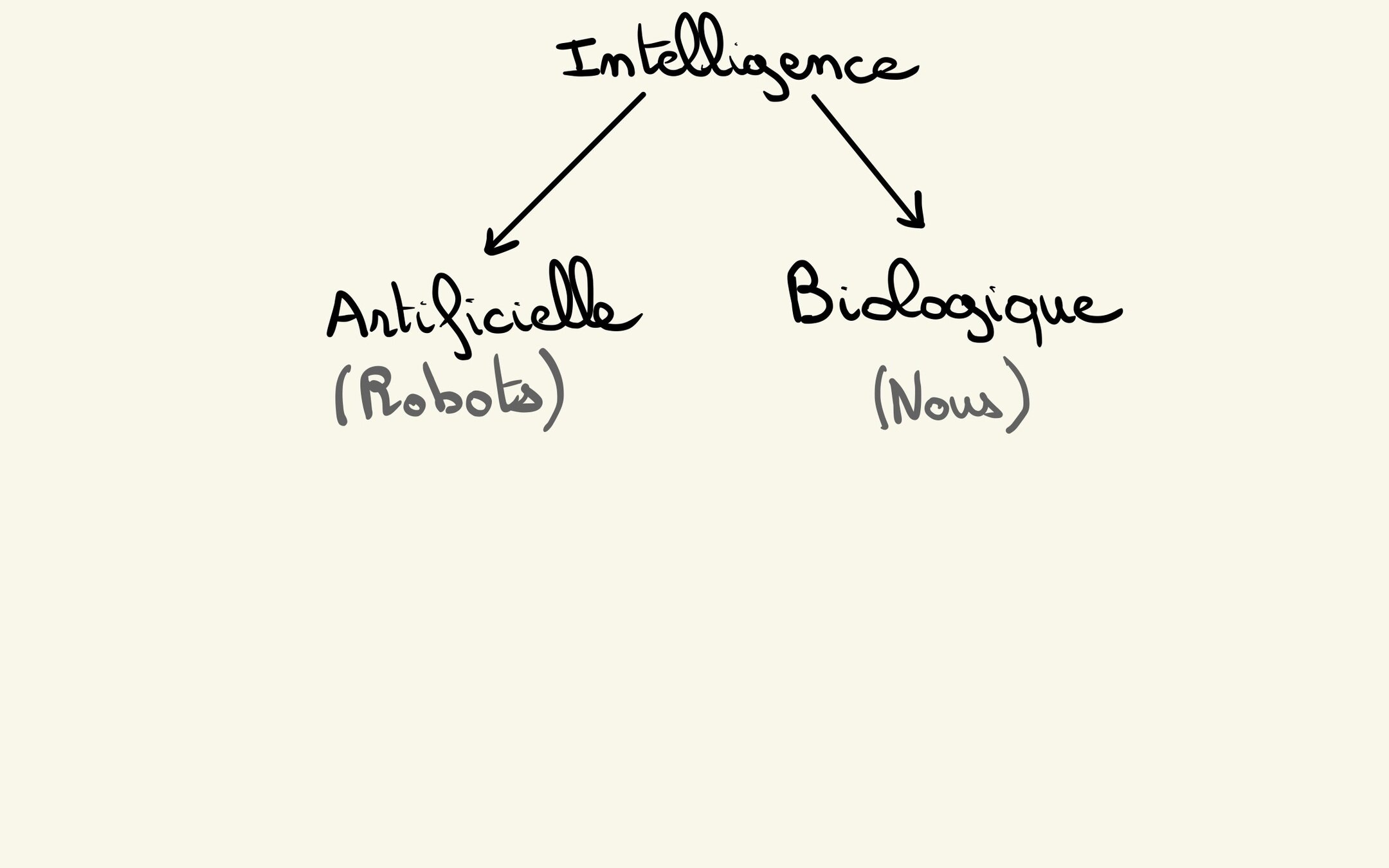

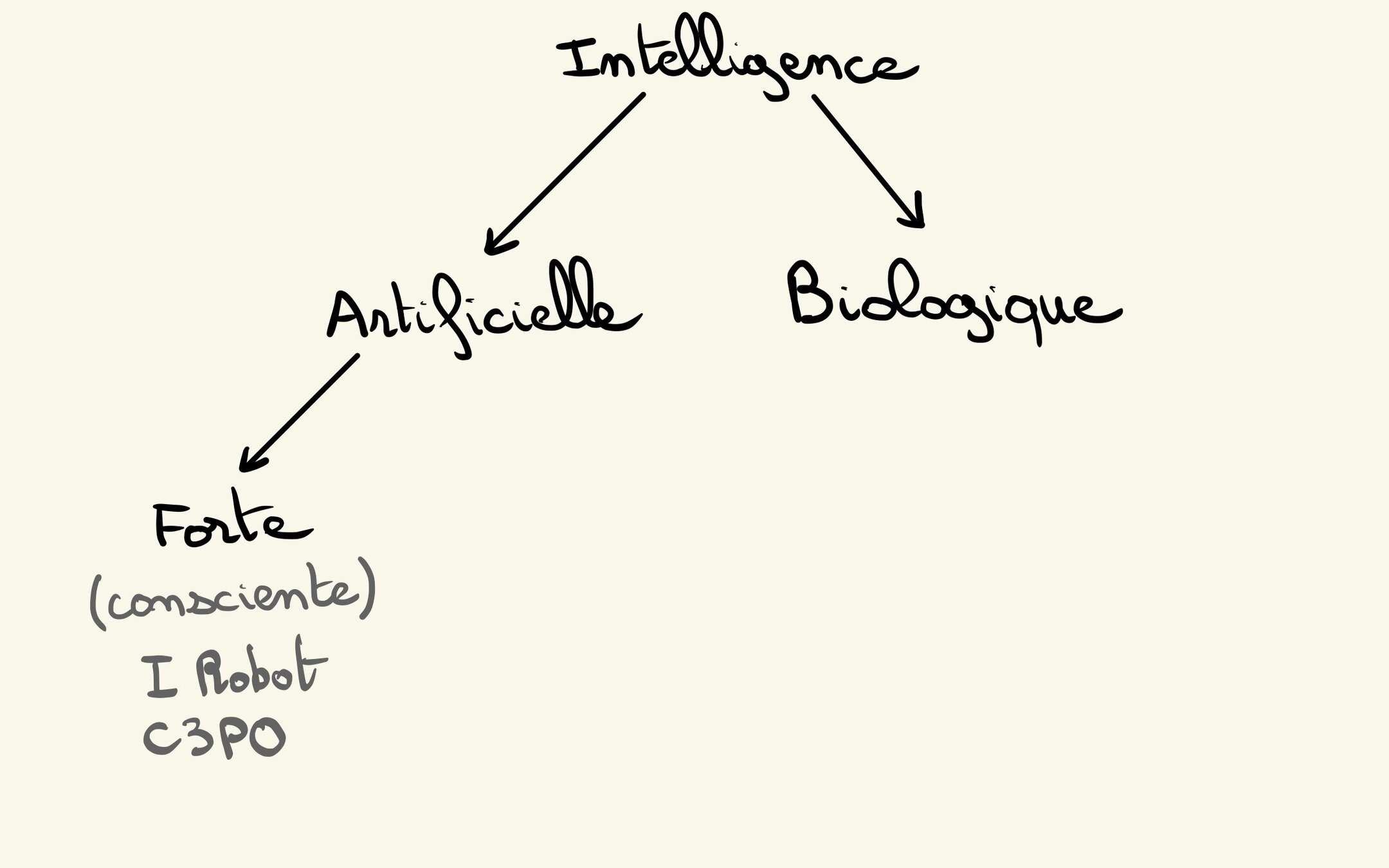

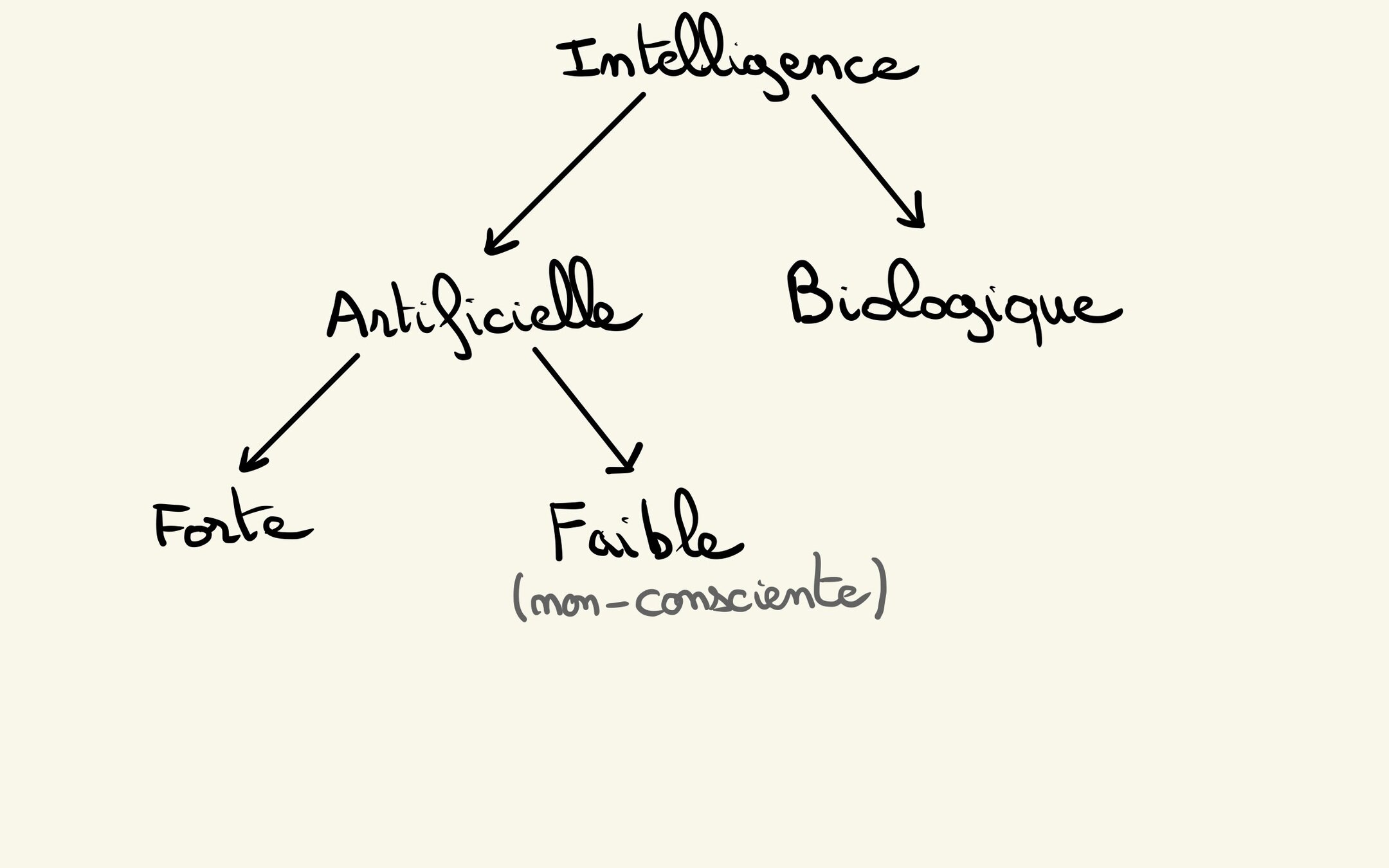

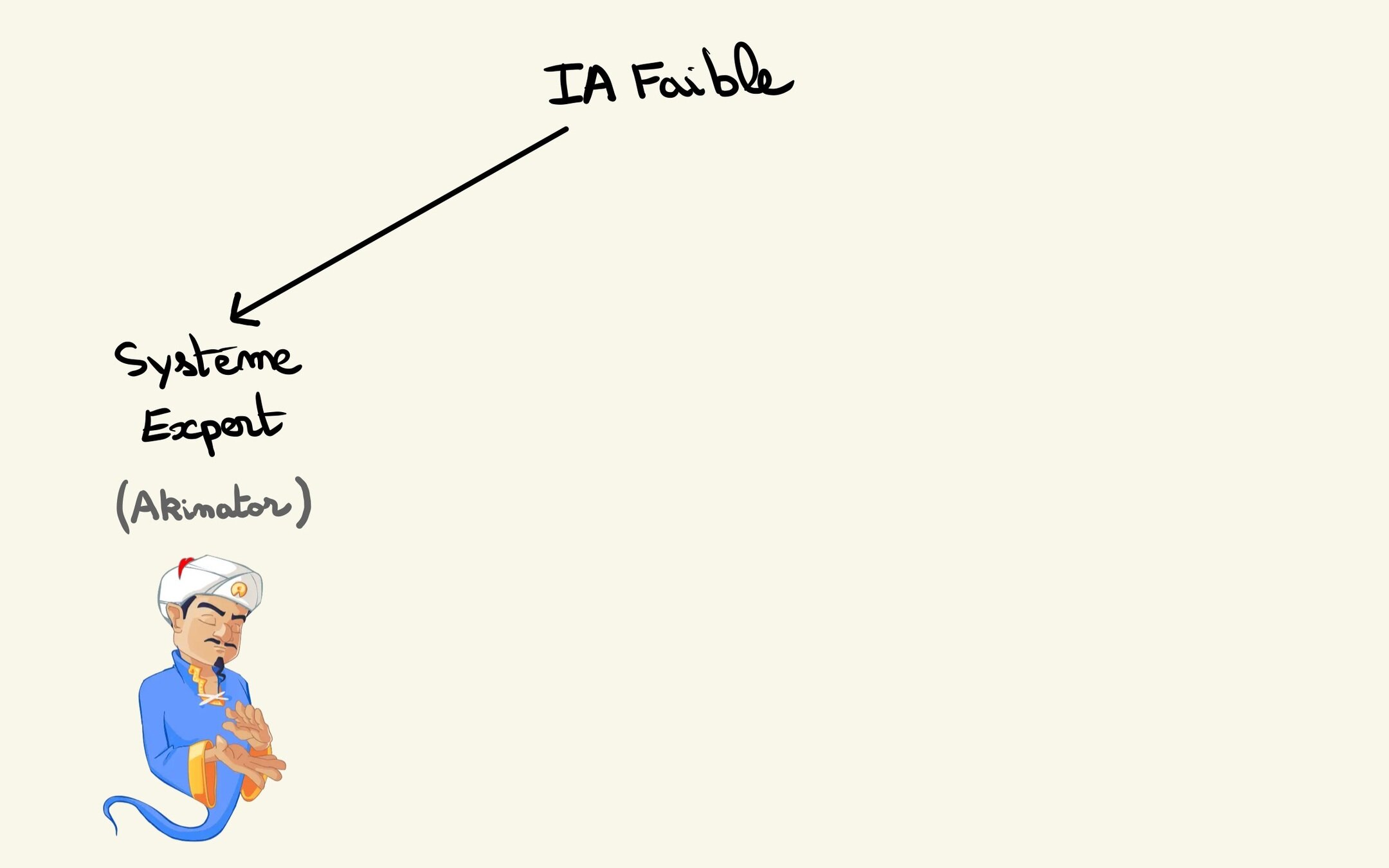

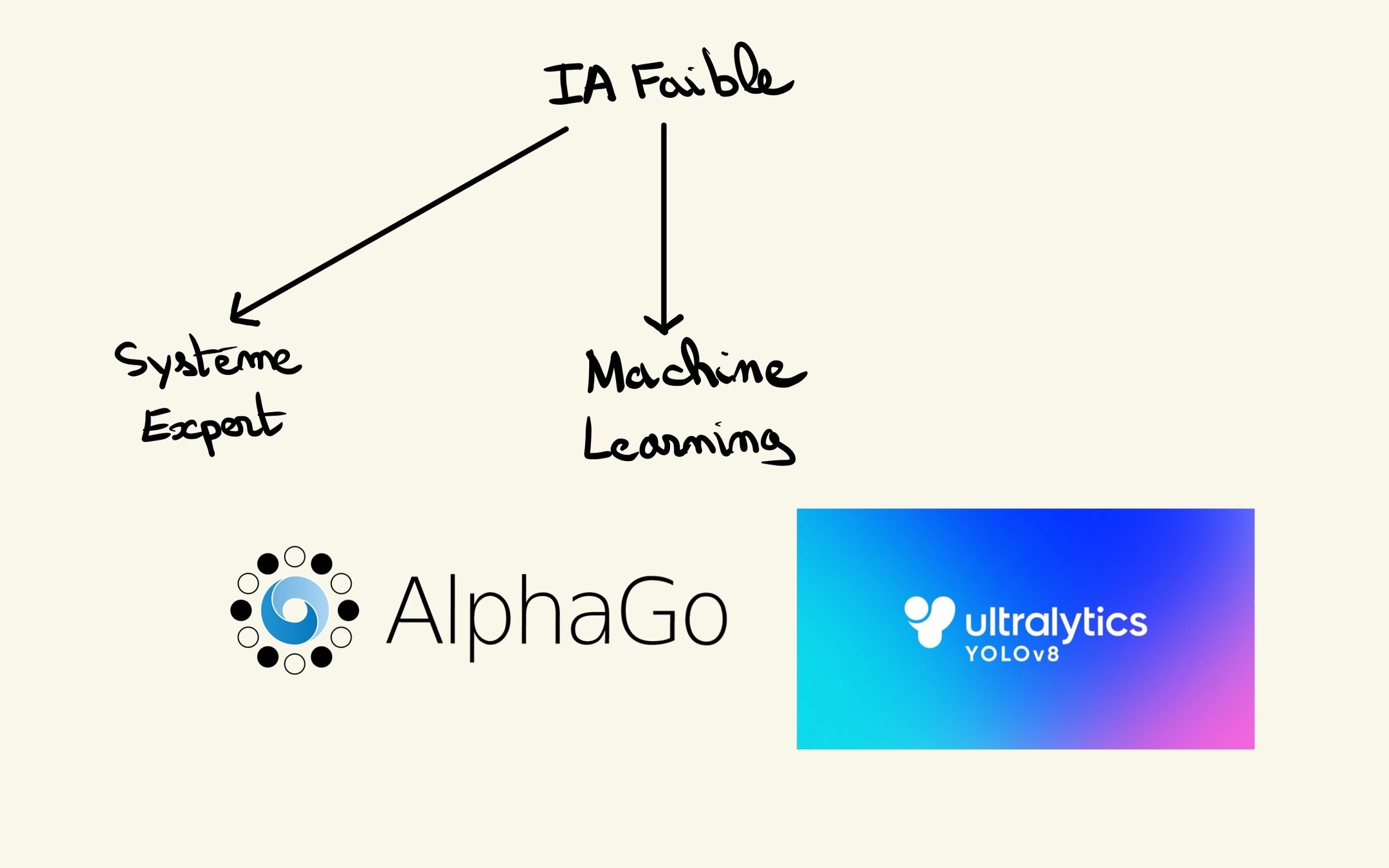

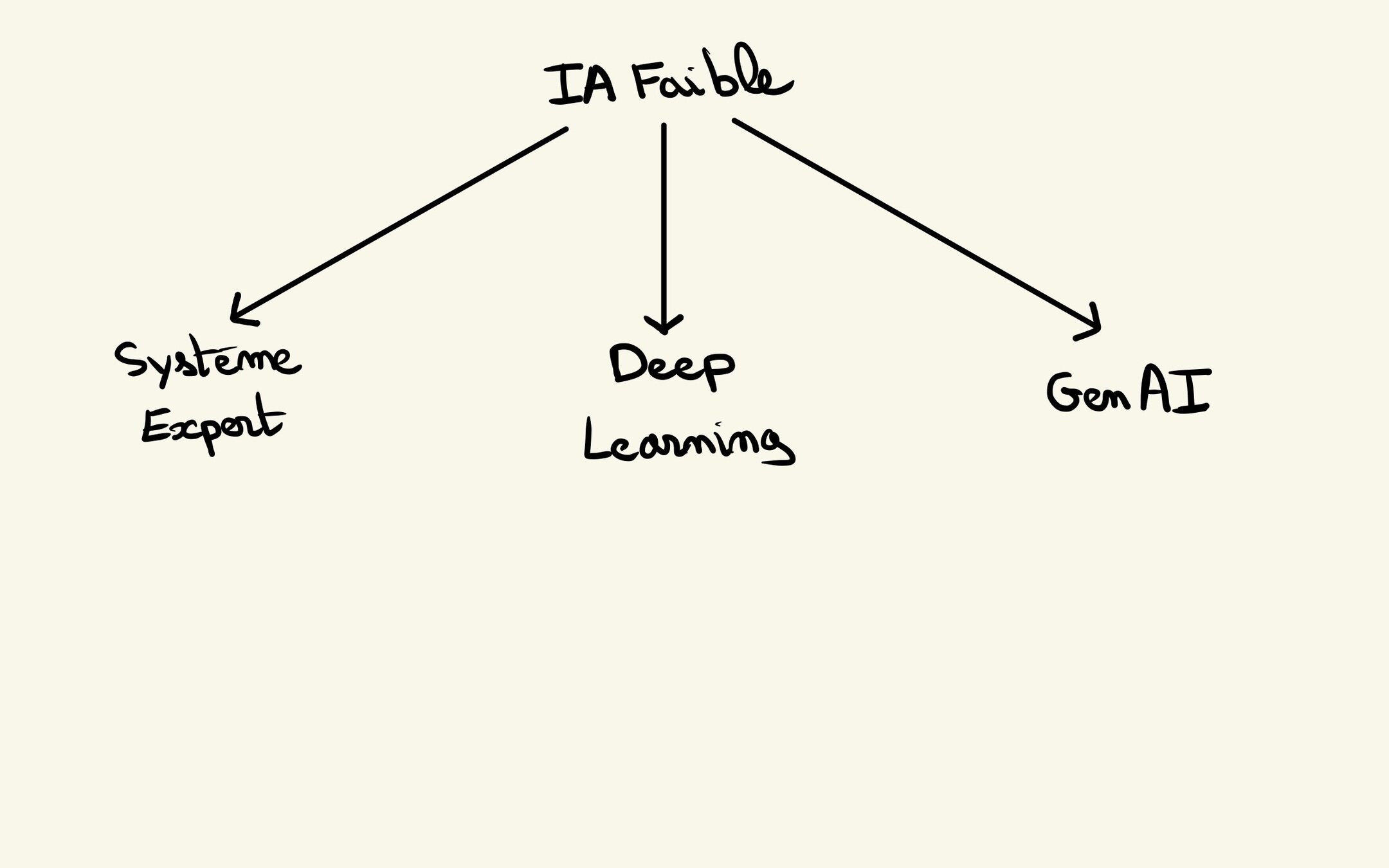

Centrons le sujet

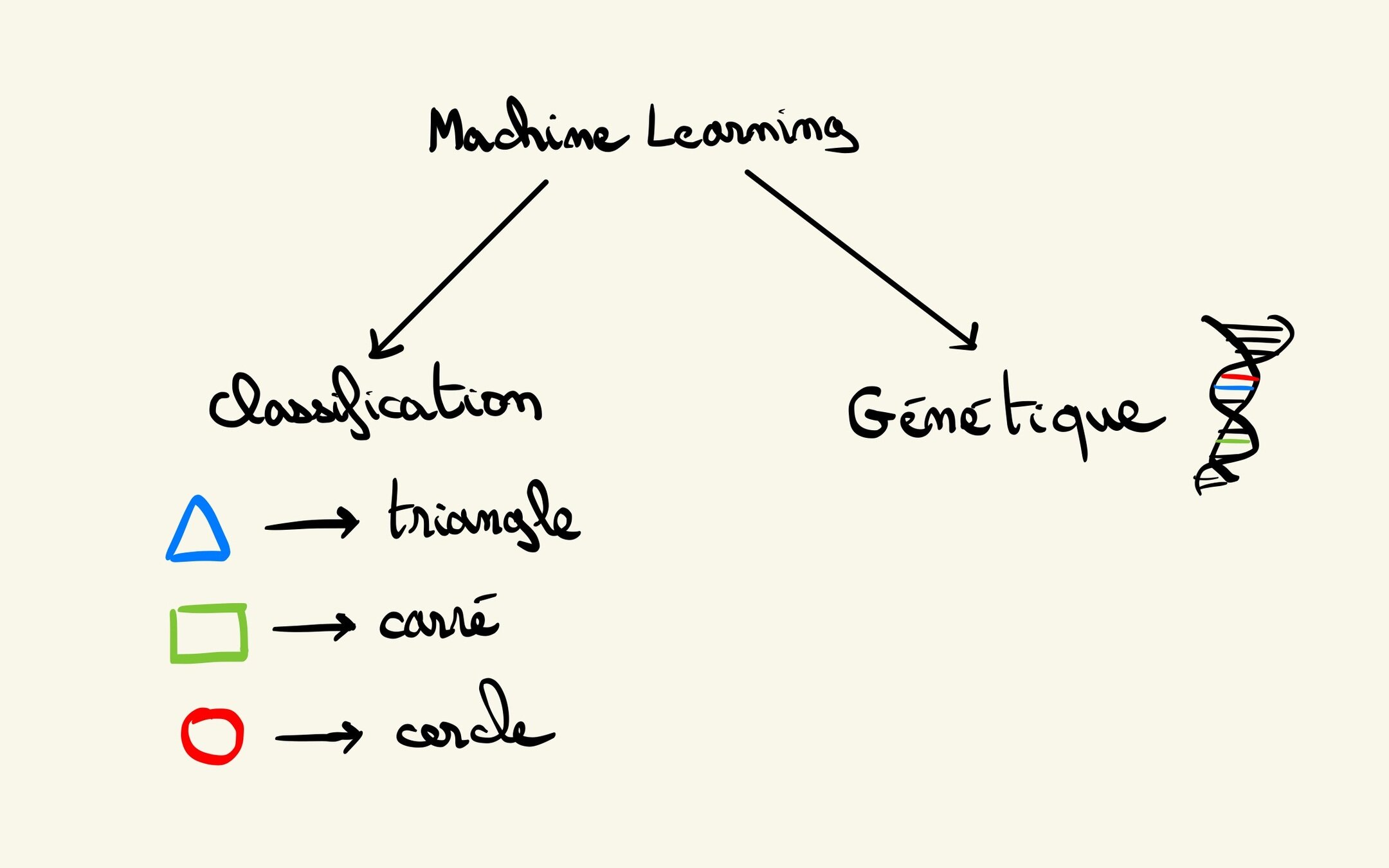

Machine Learning

Comment la machine s'adapte à son environnement ?

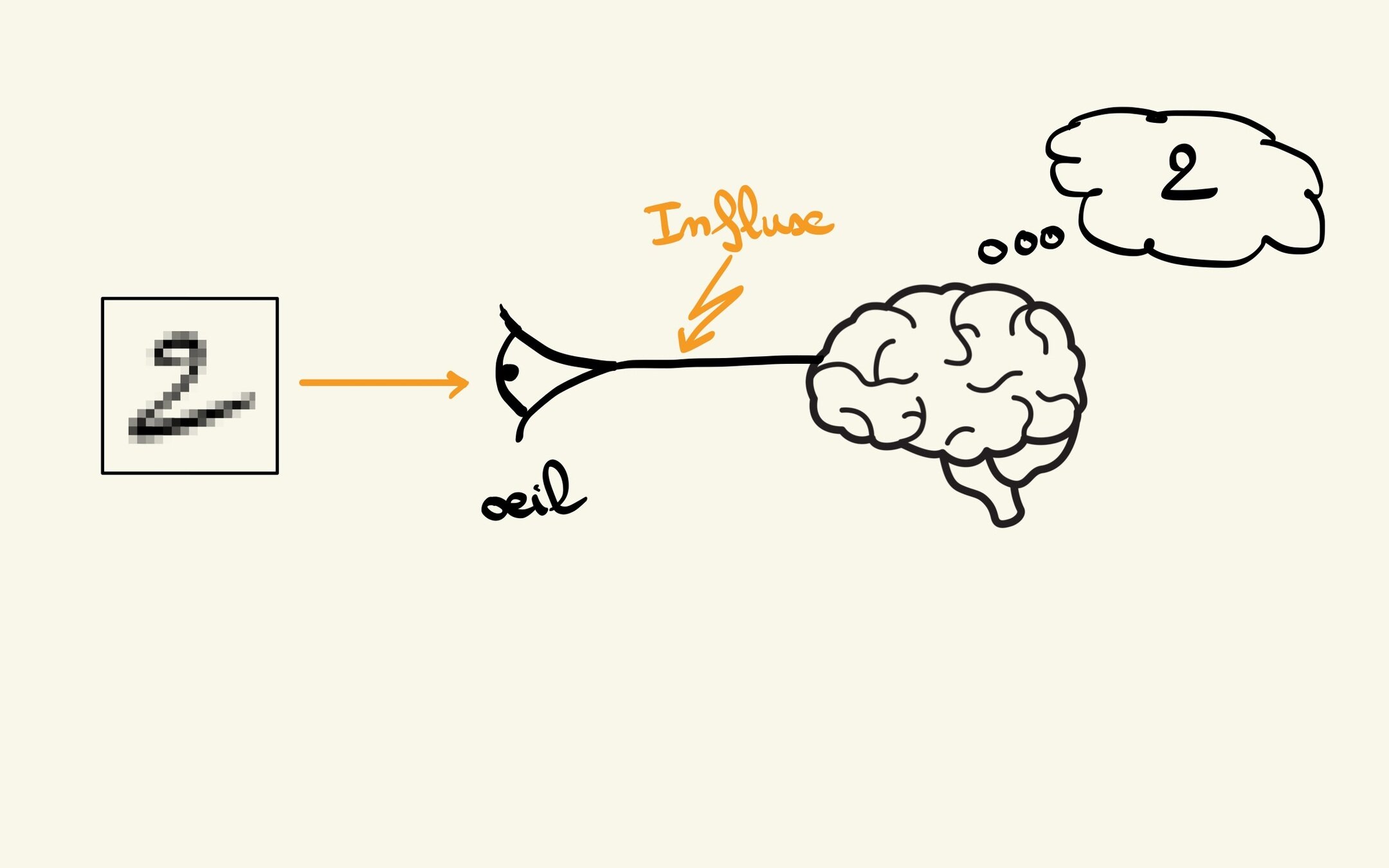

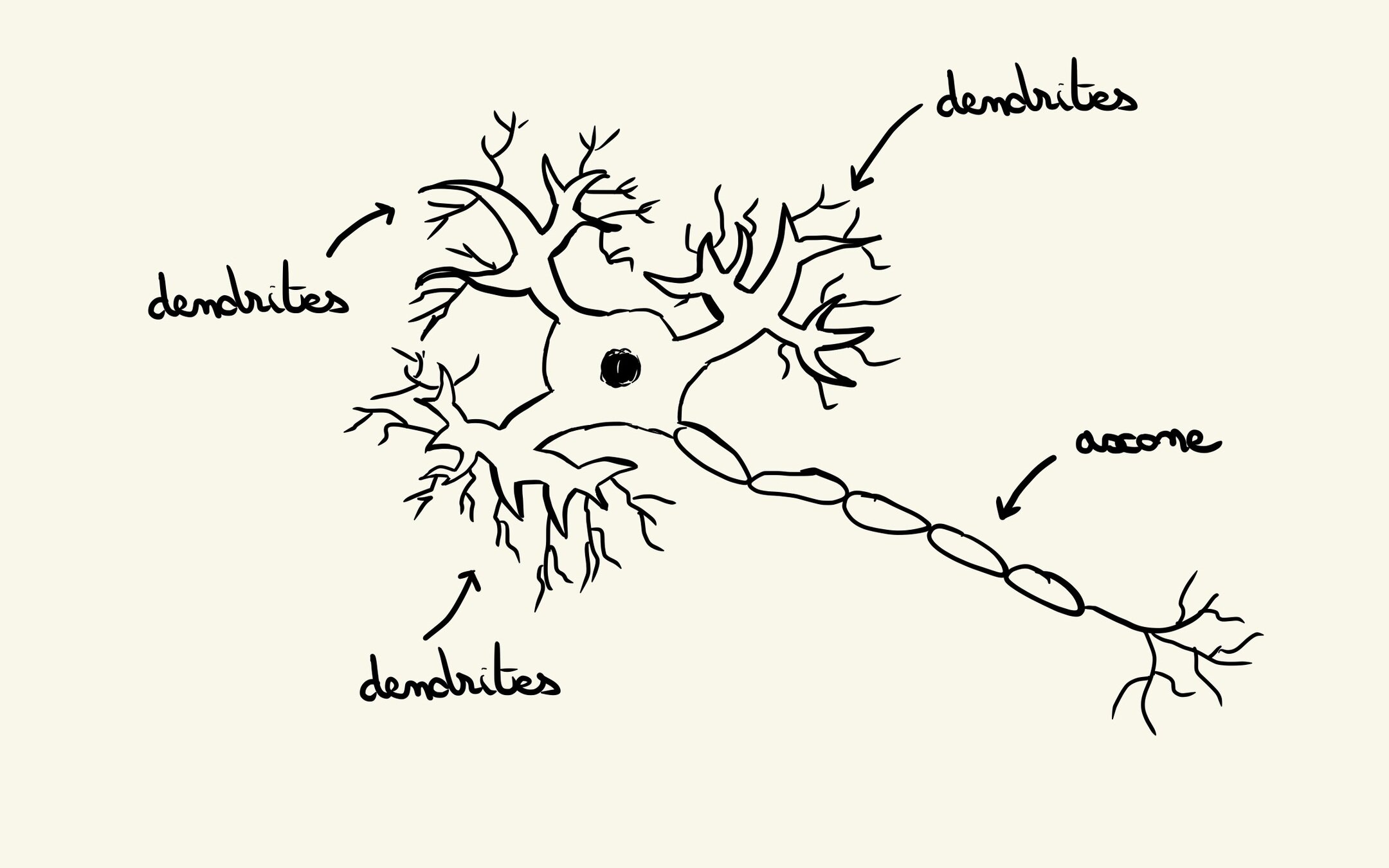

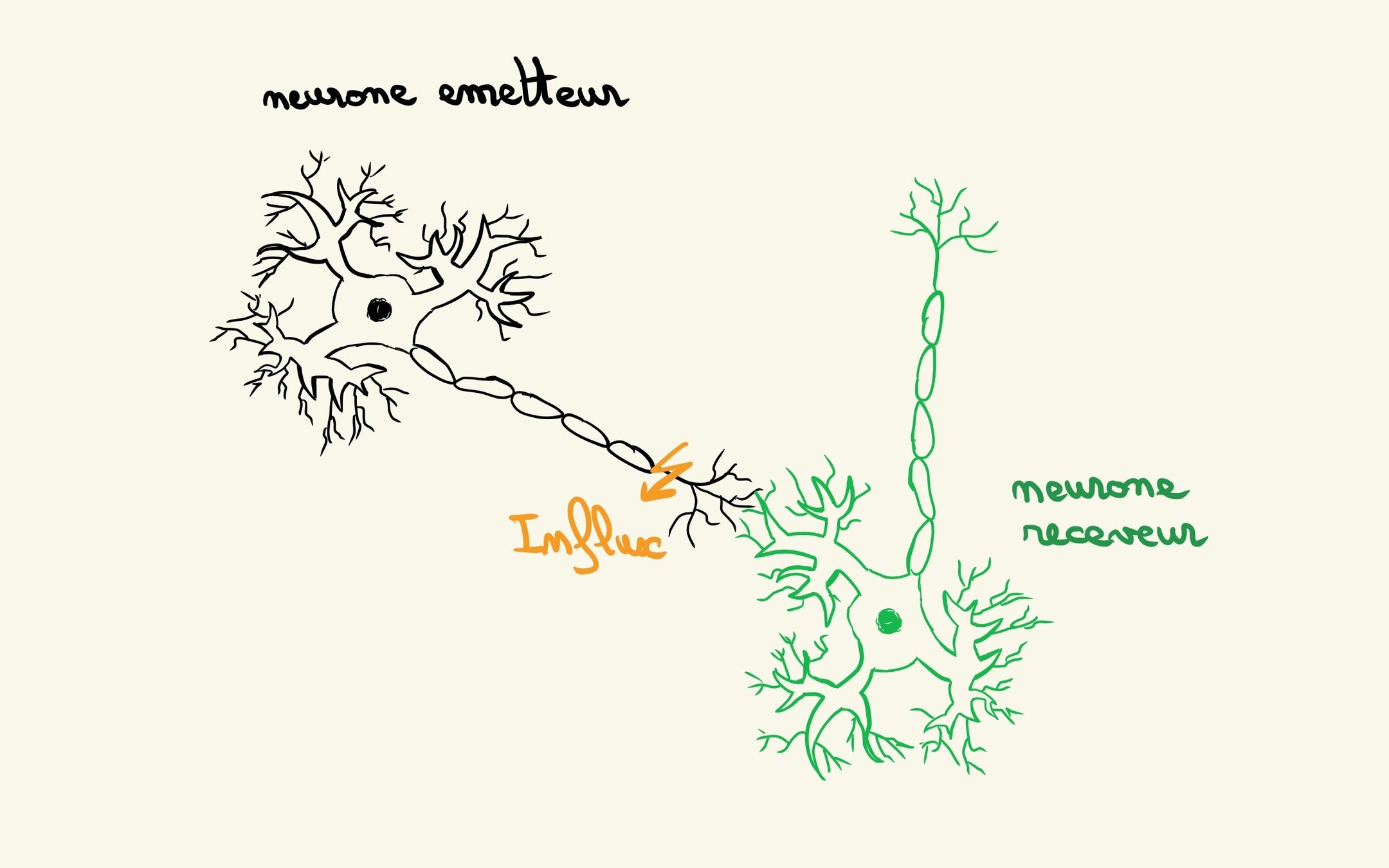

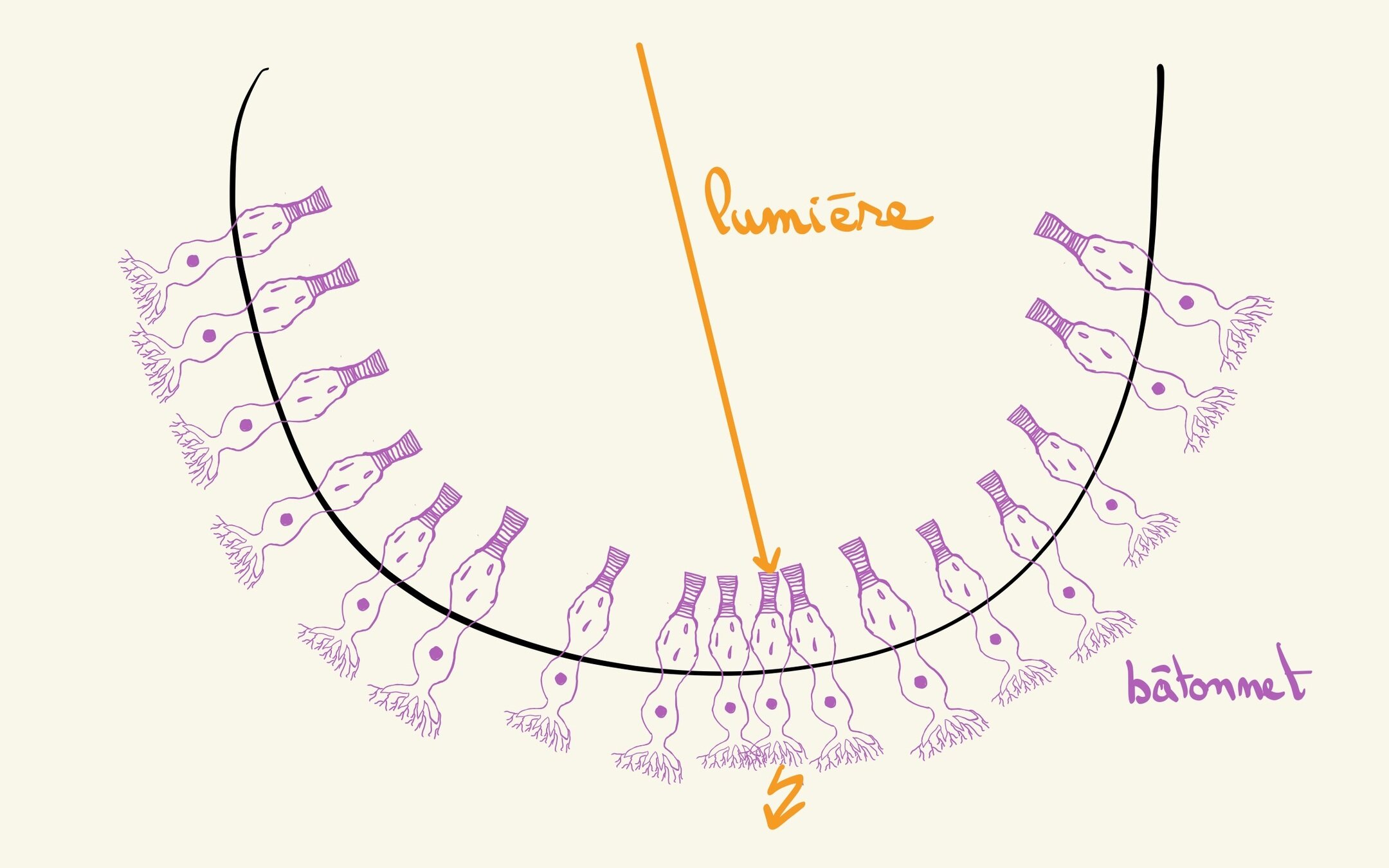

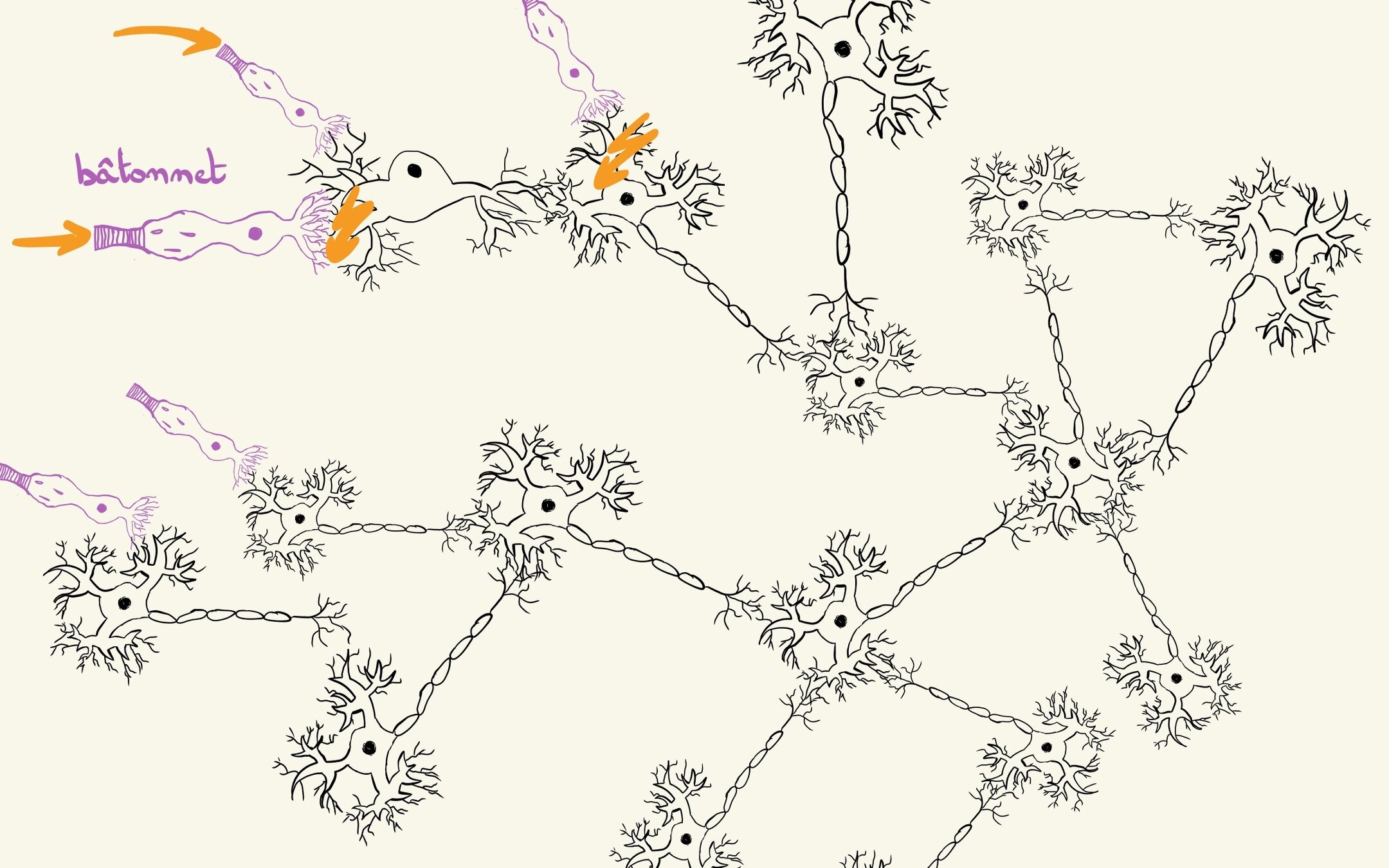

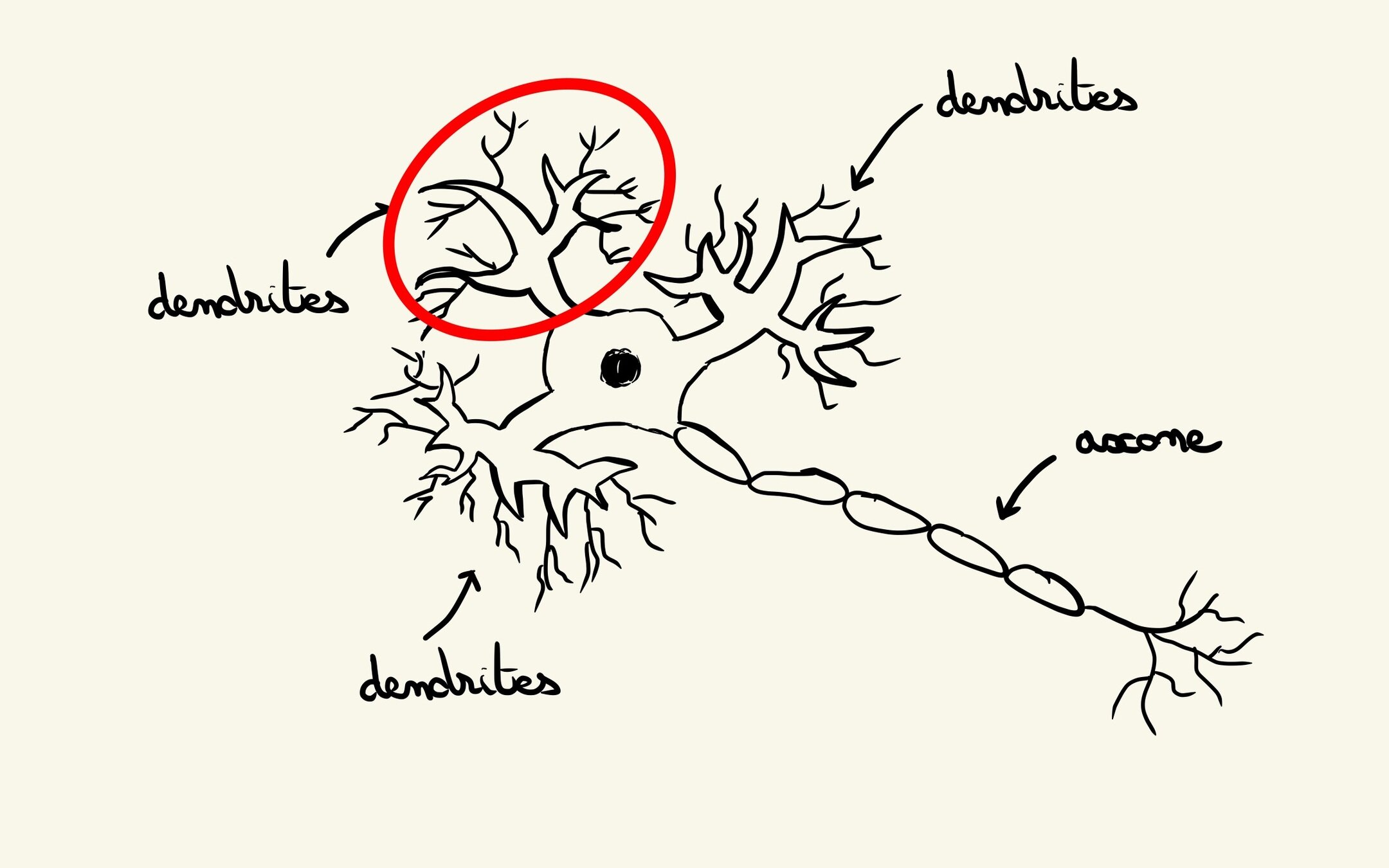

Passage par le biologique

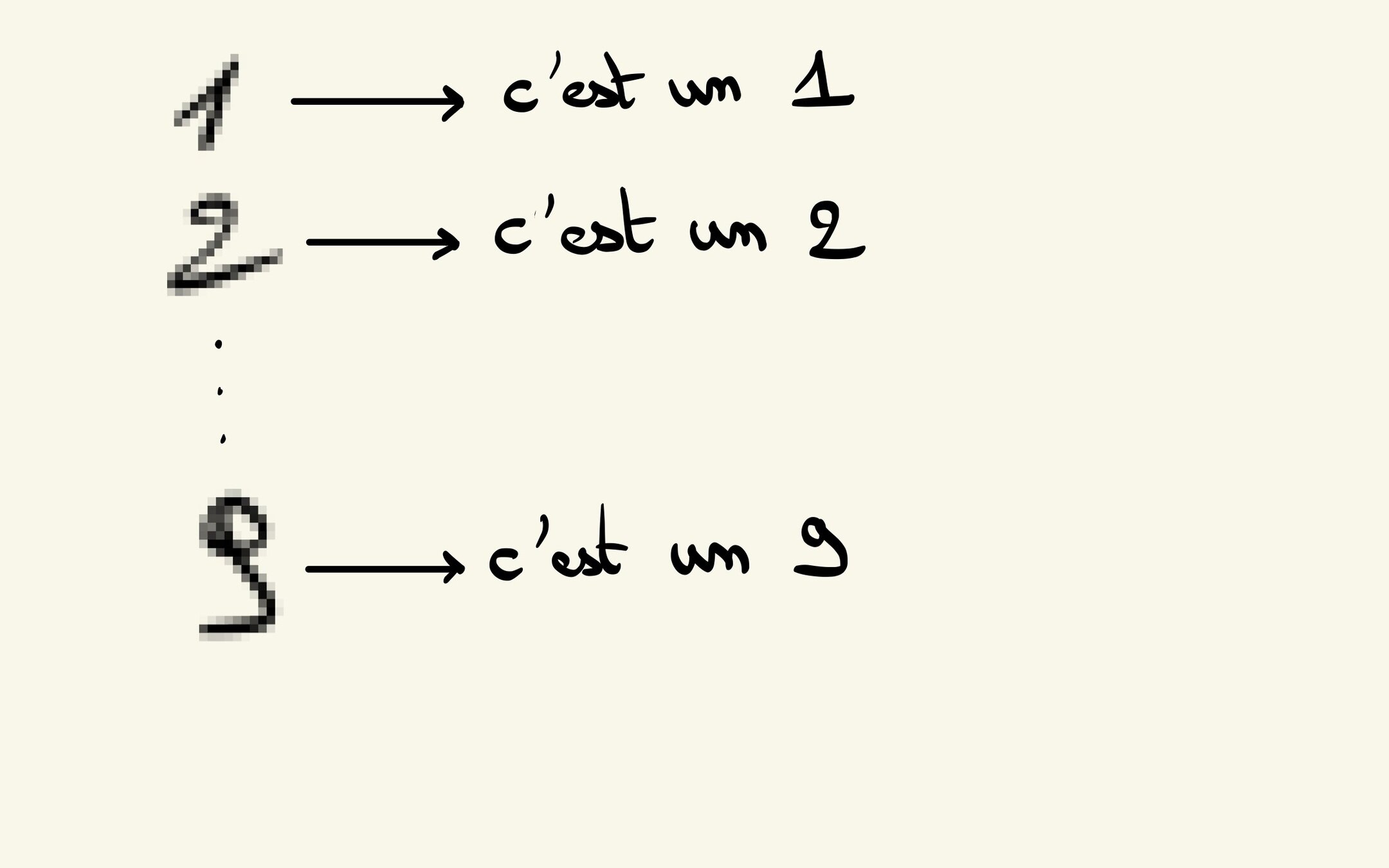

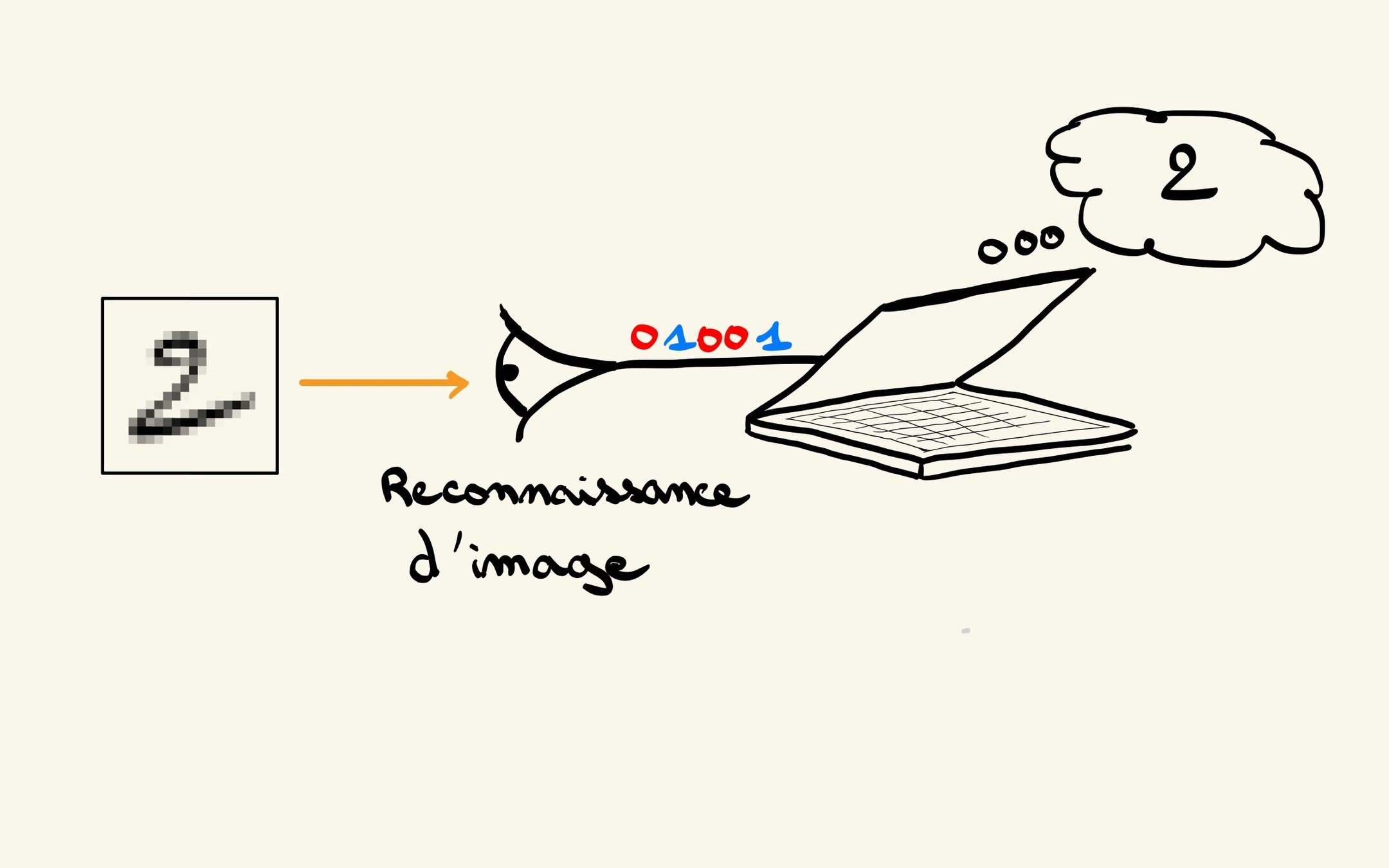

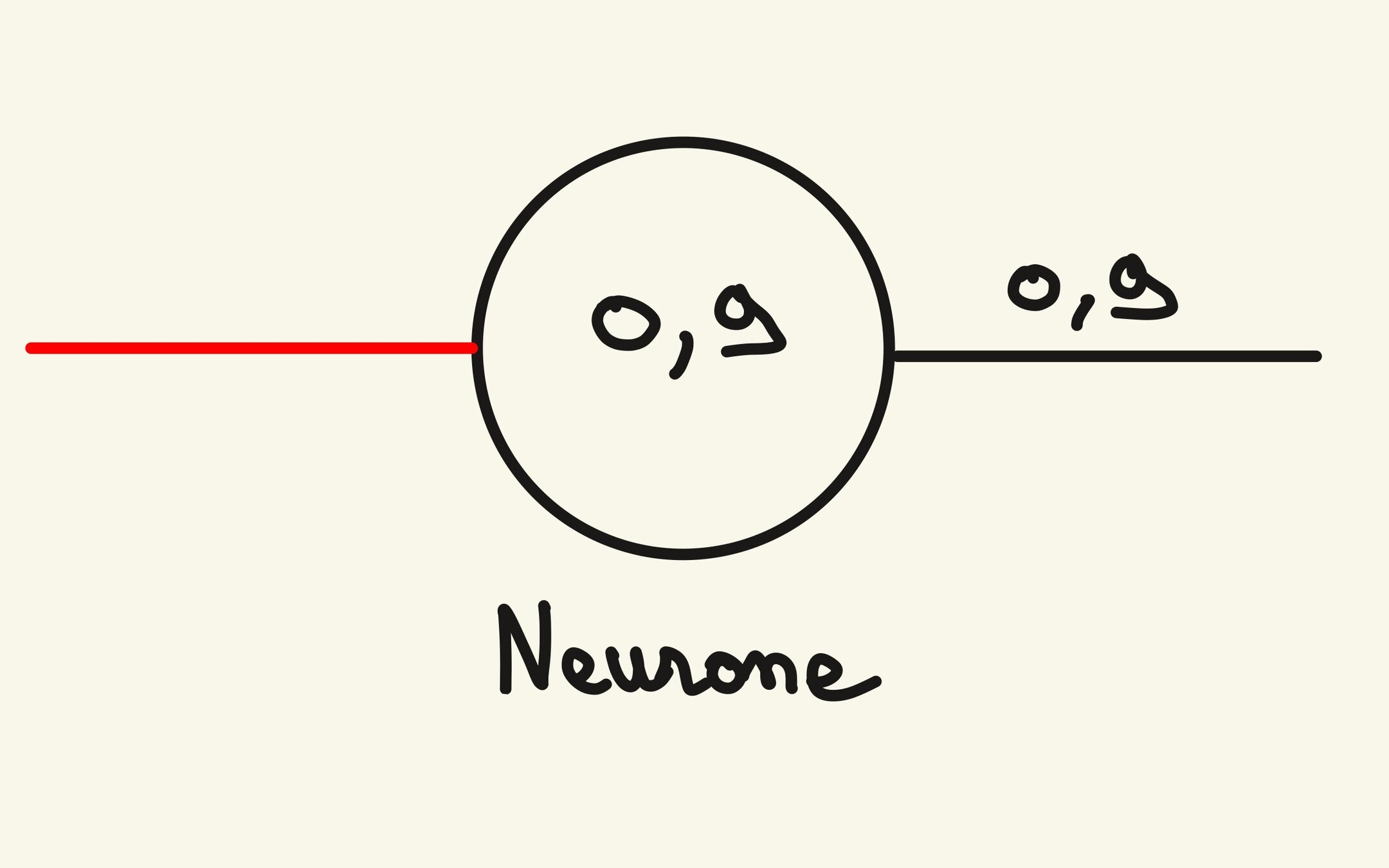

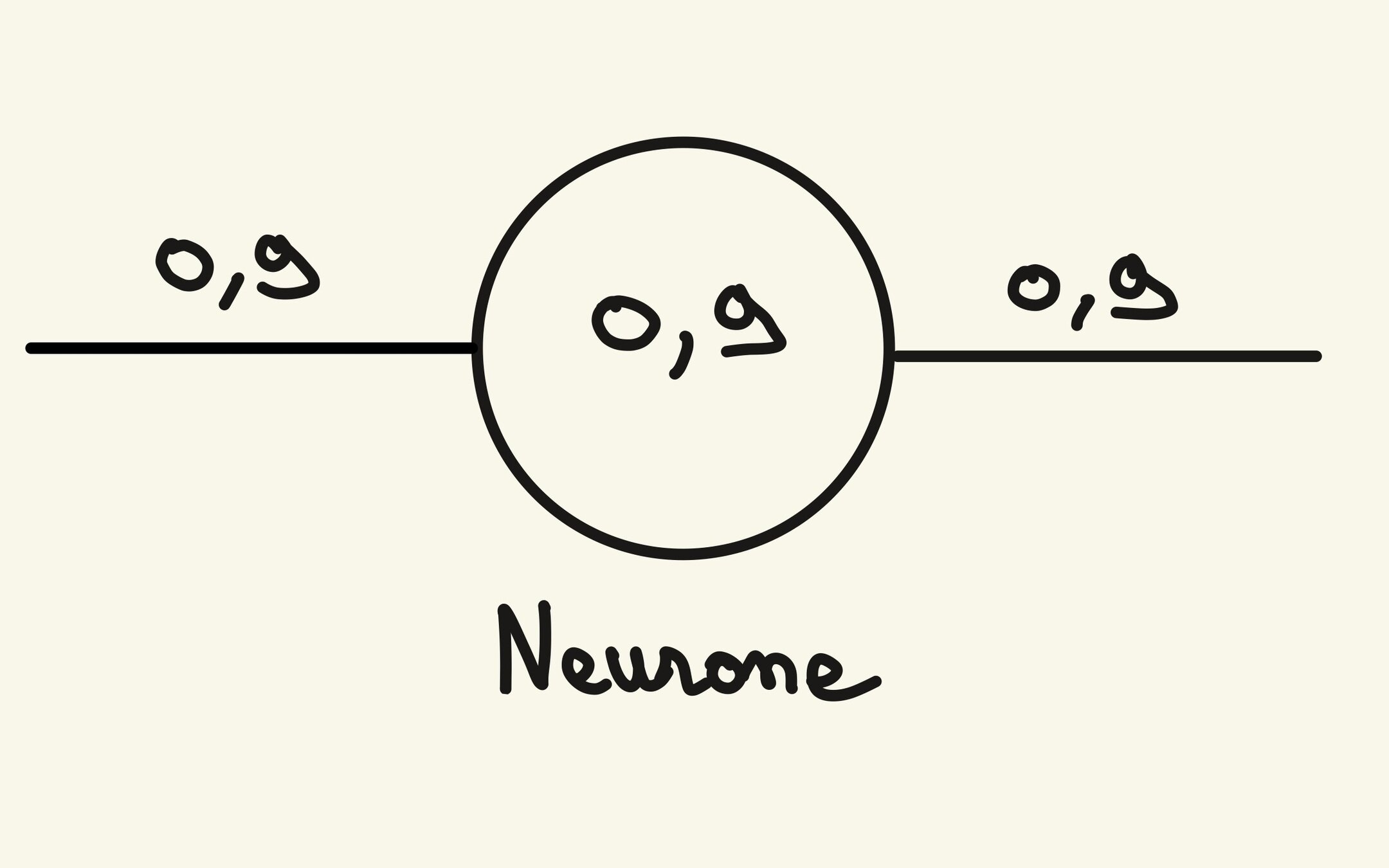

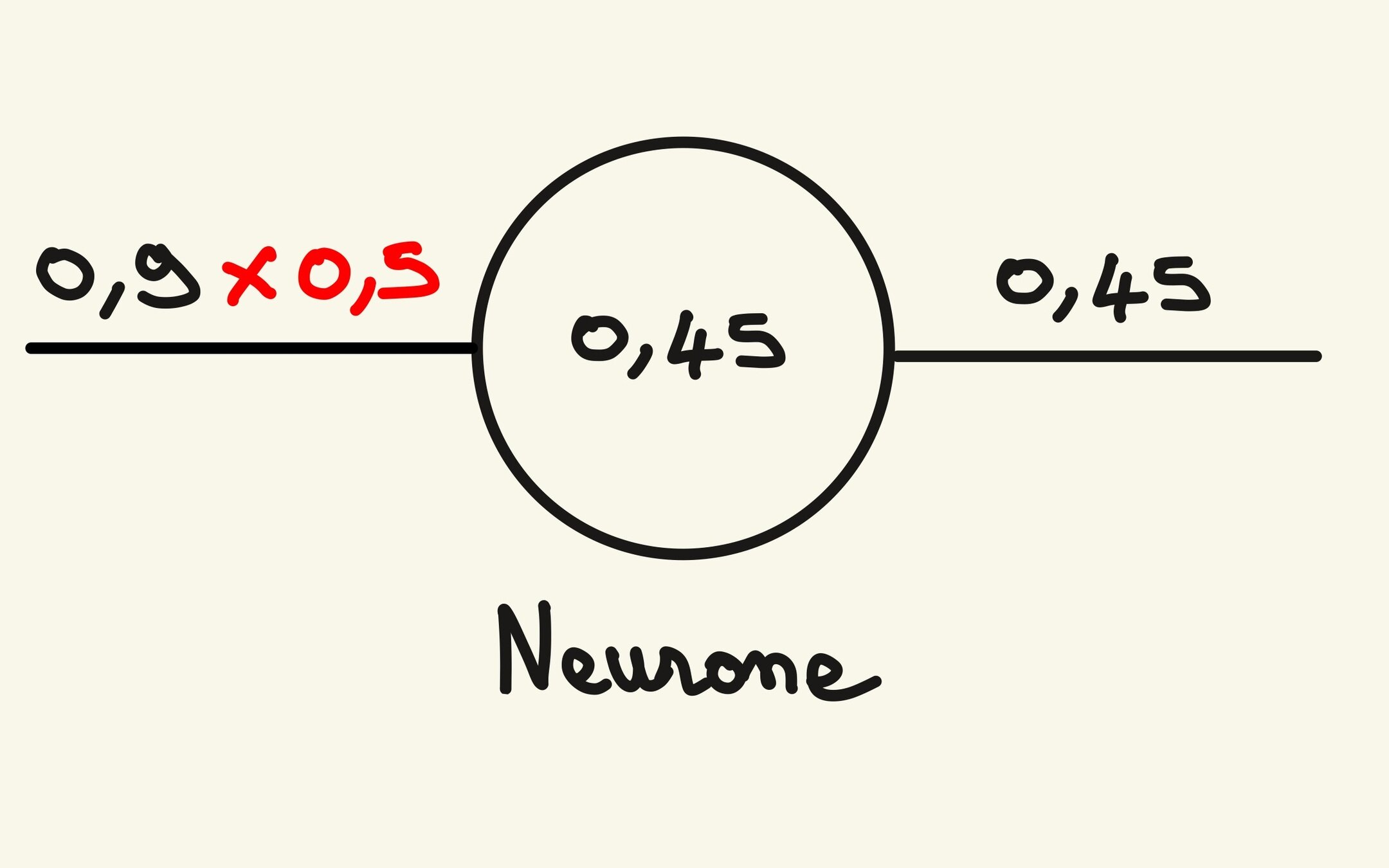

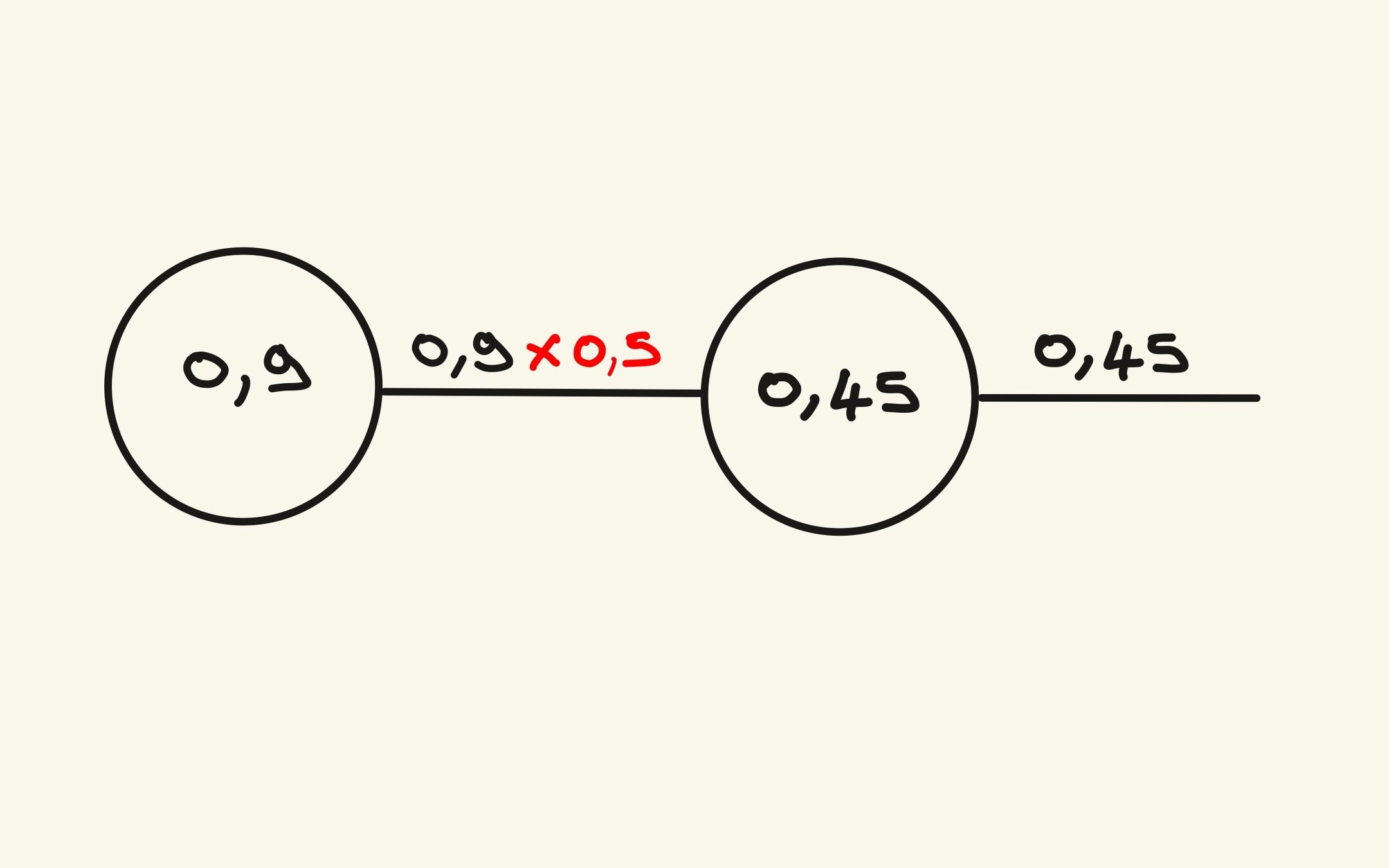

Et la machine dans tout ça ?

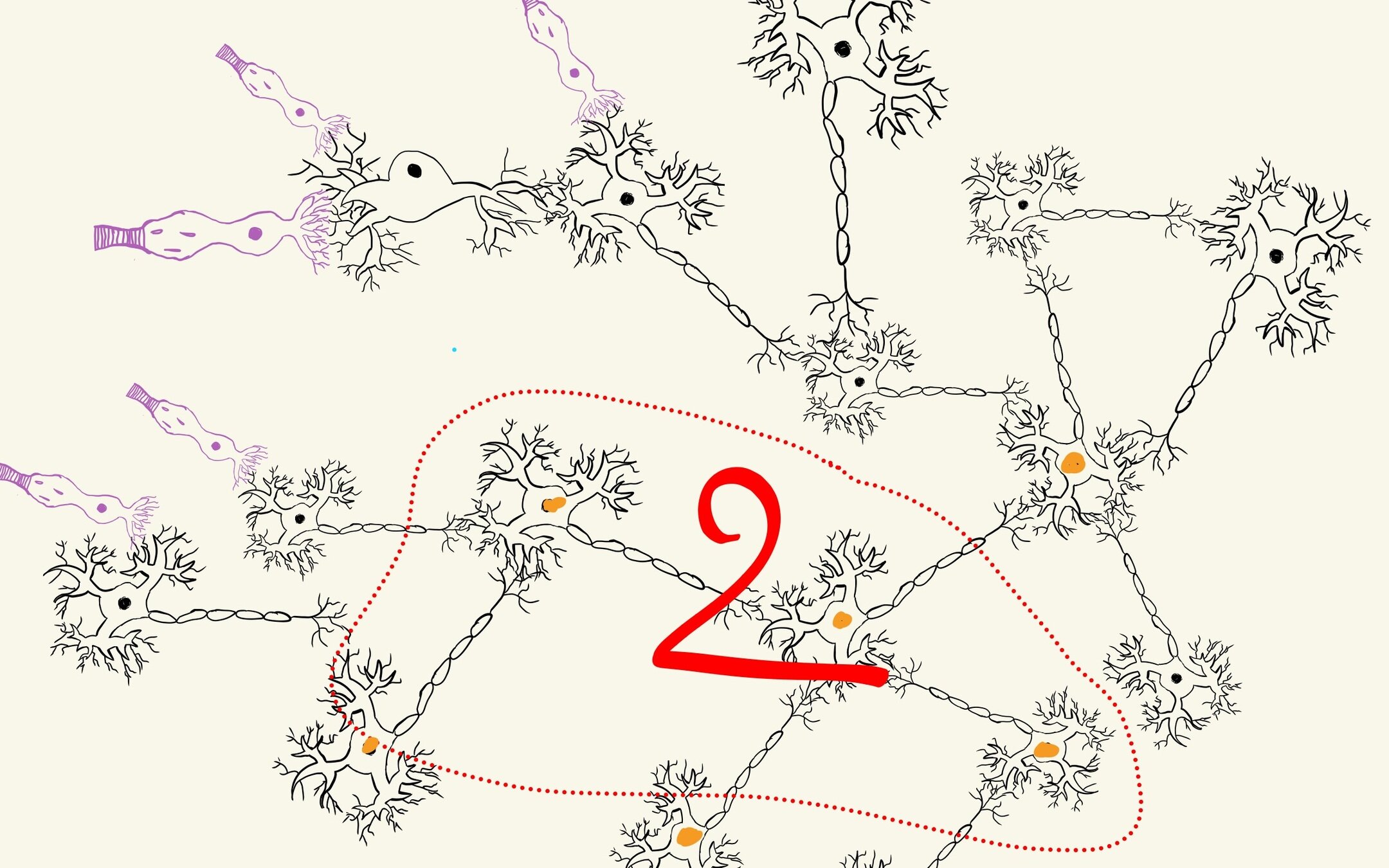

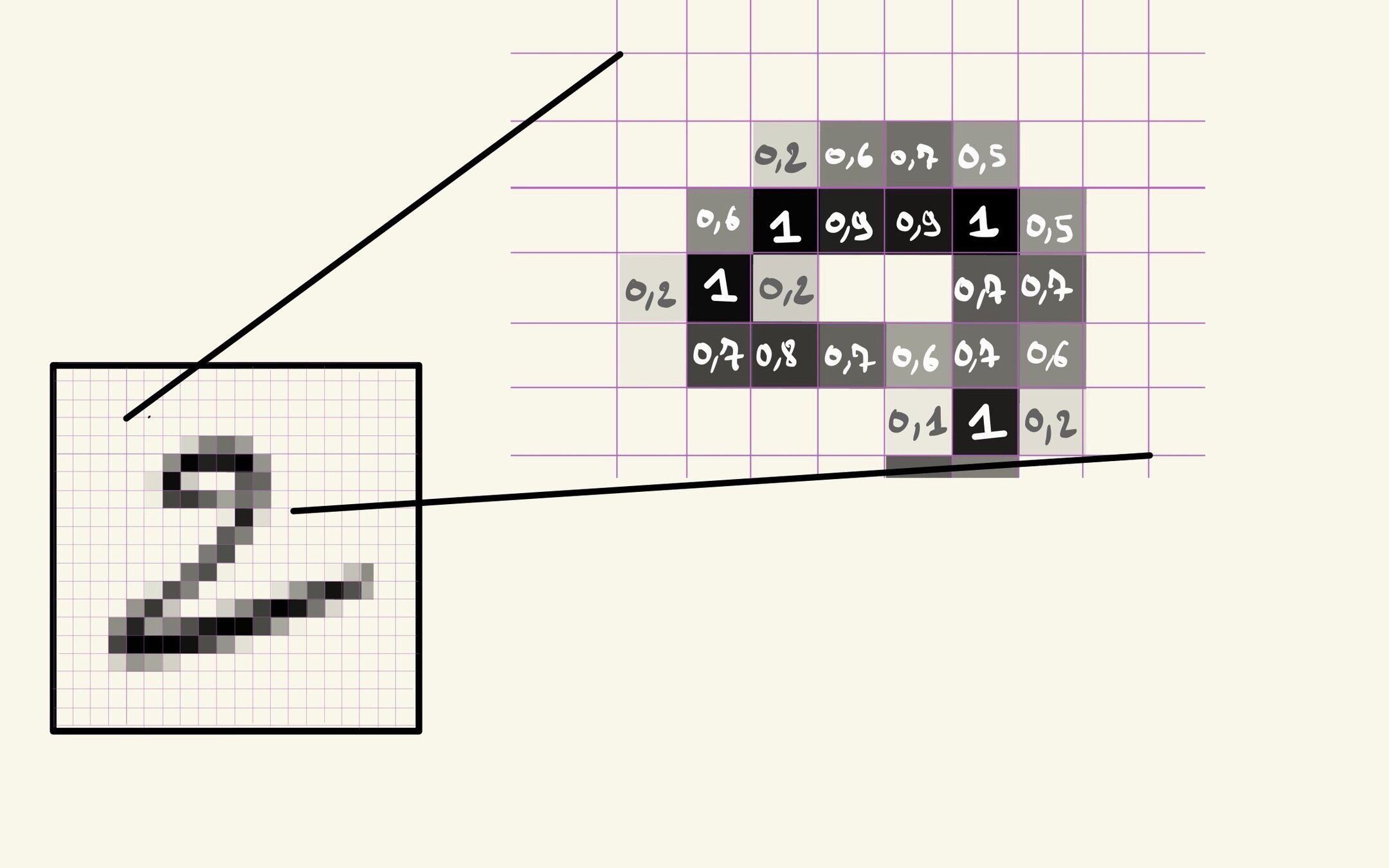

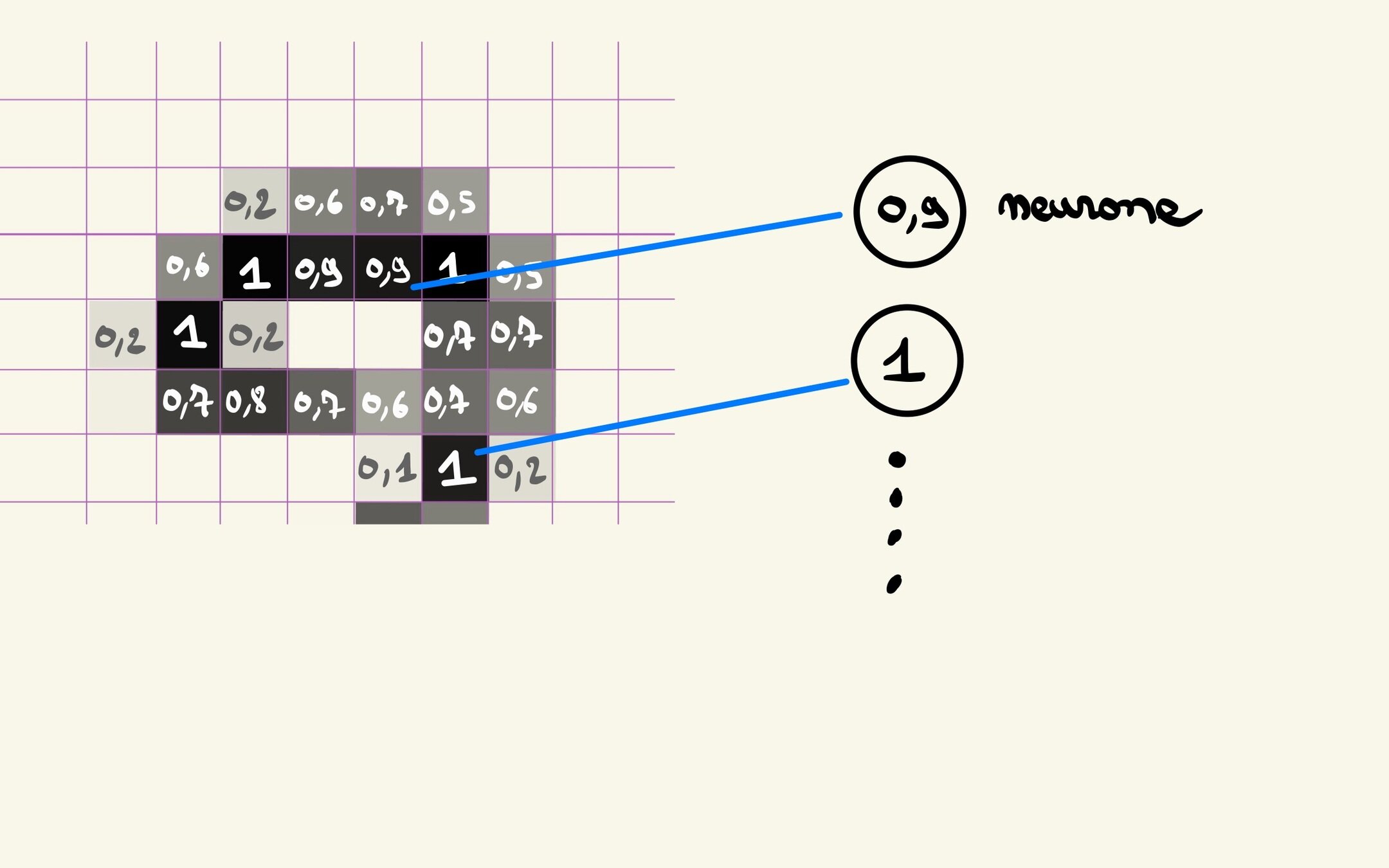

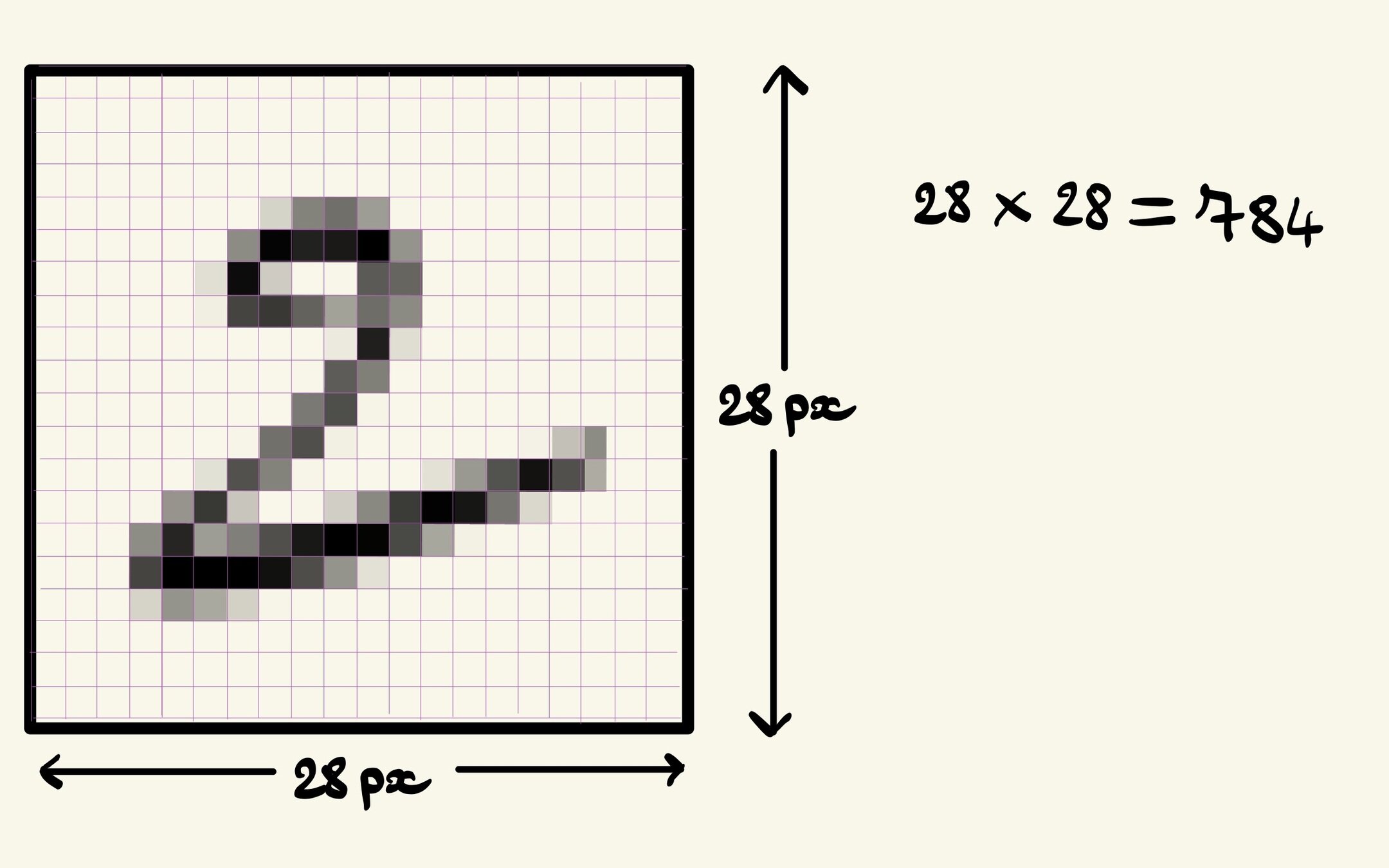

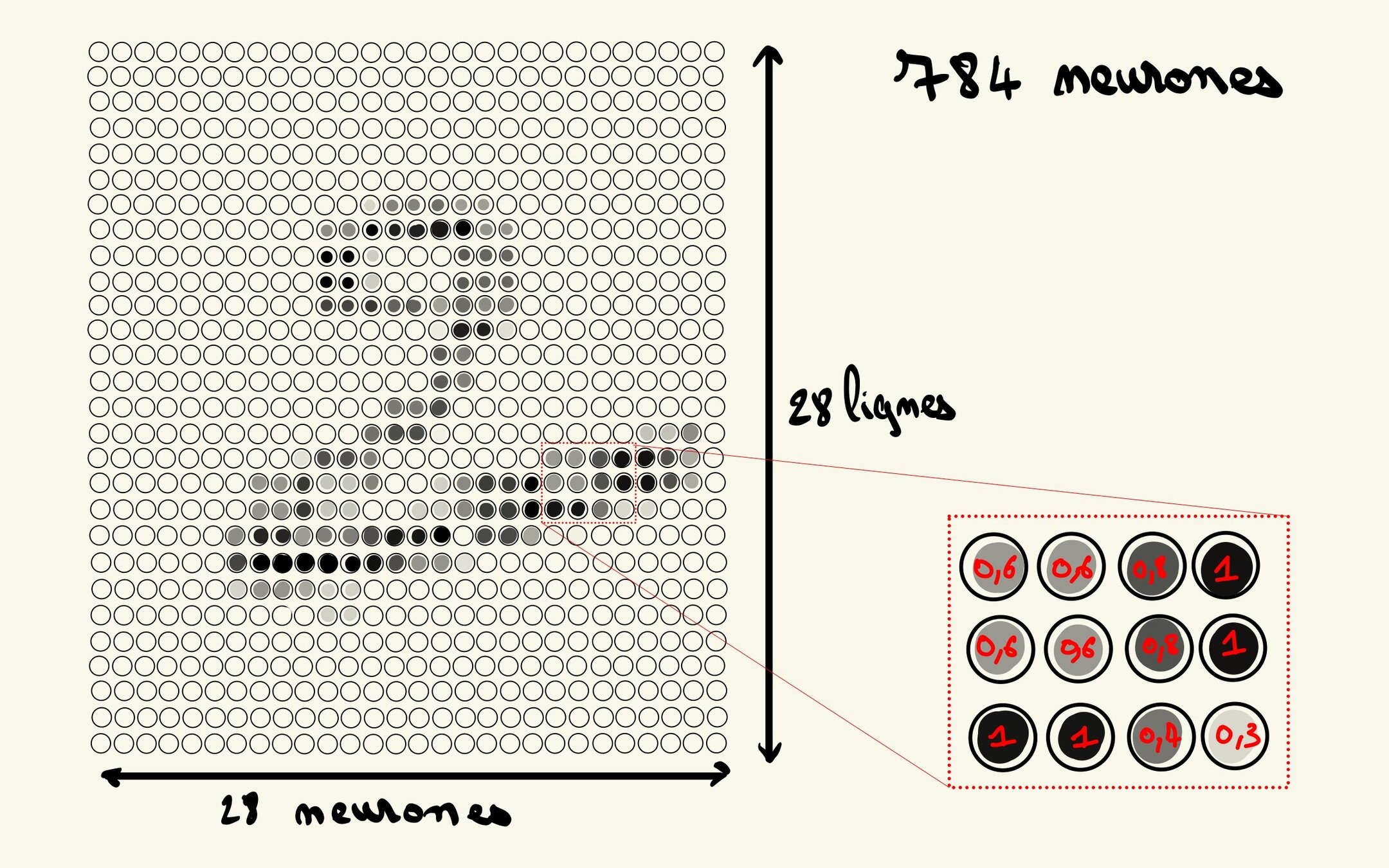

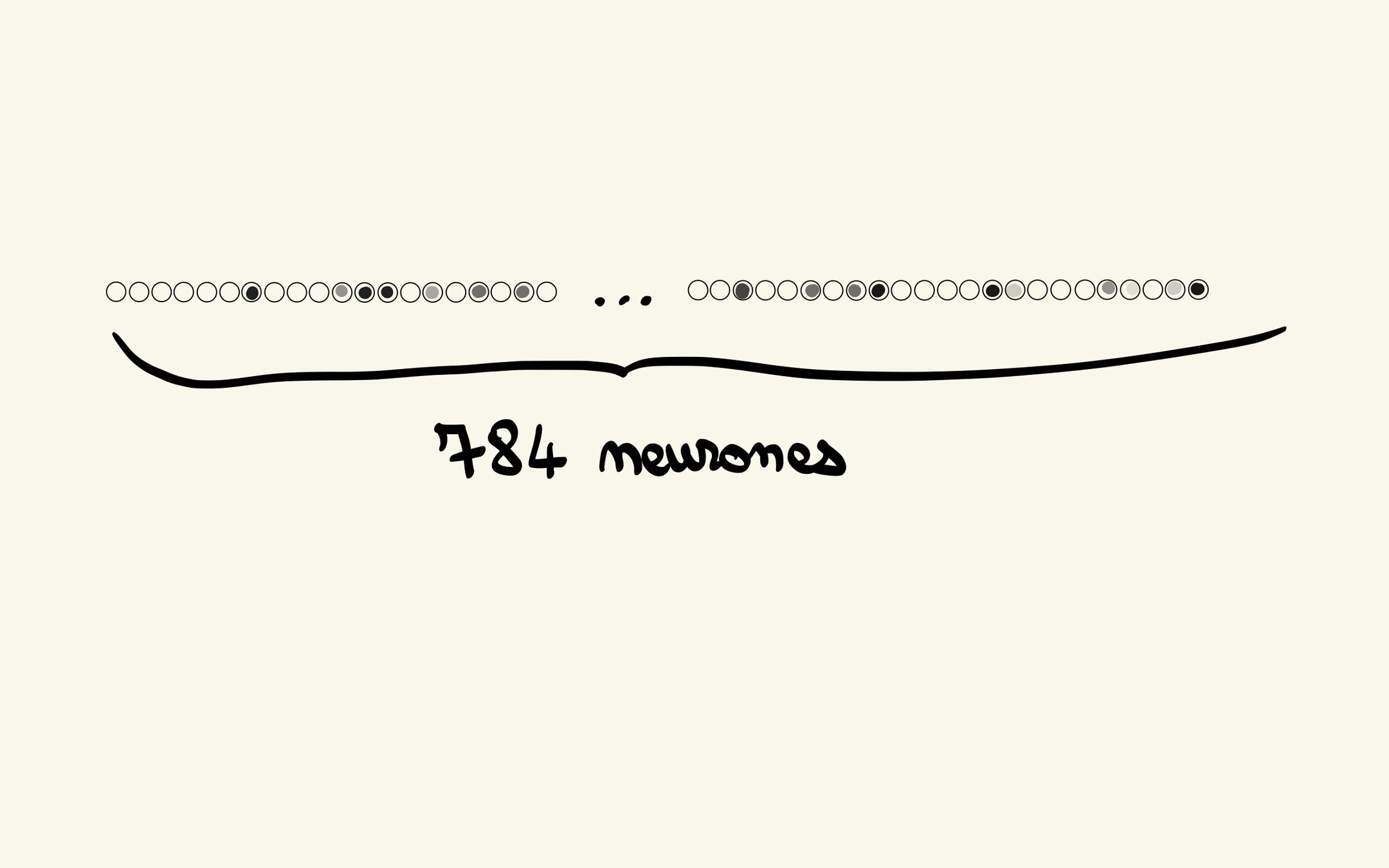

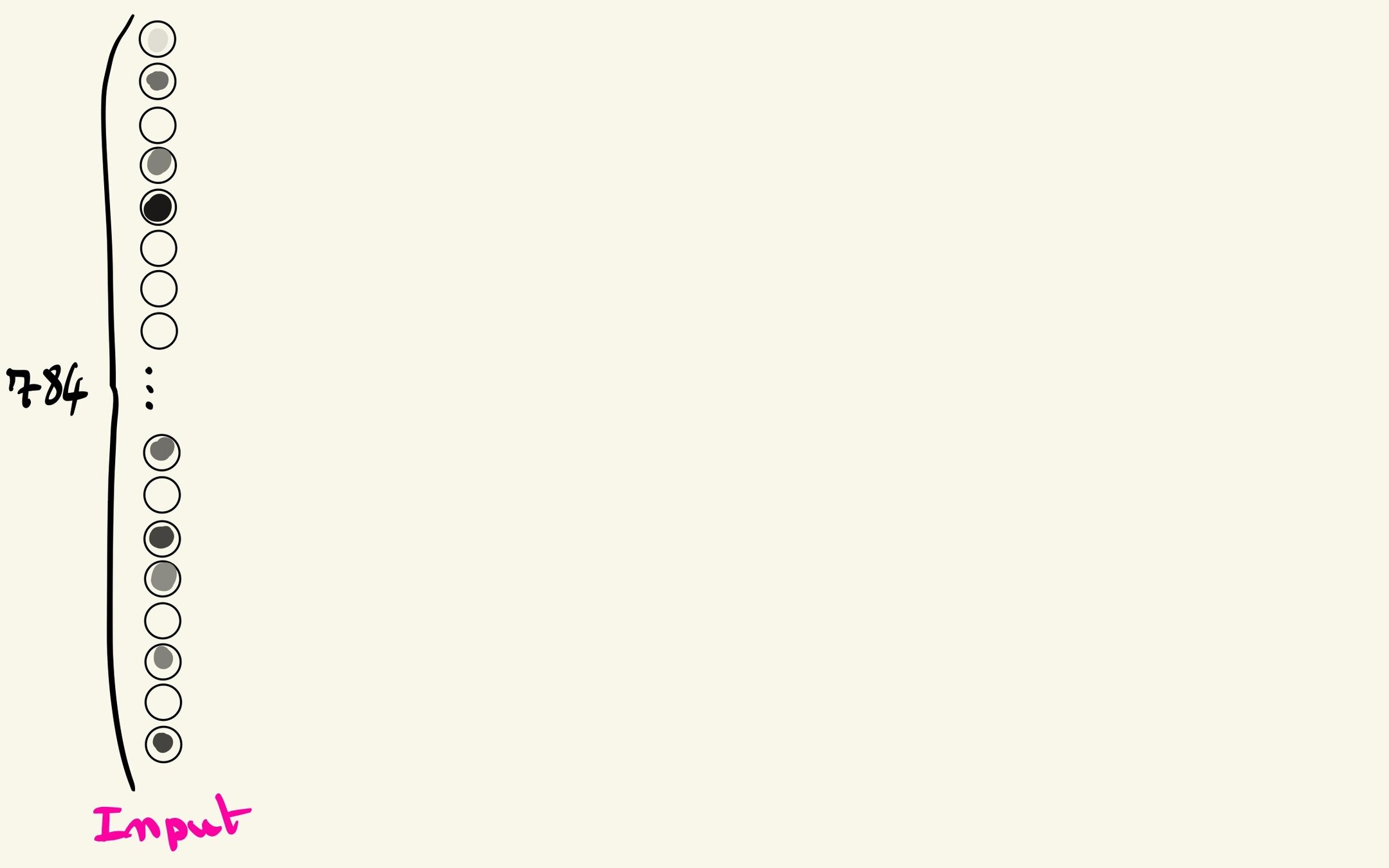

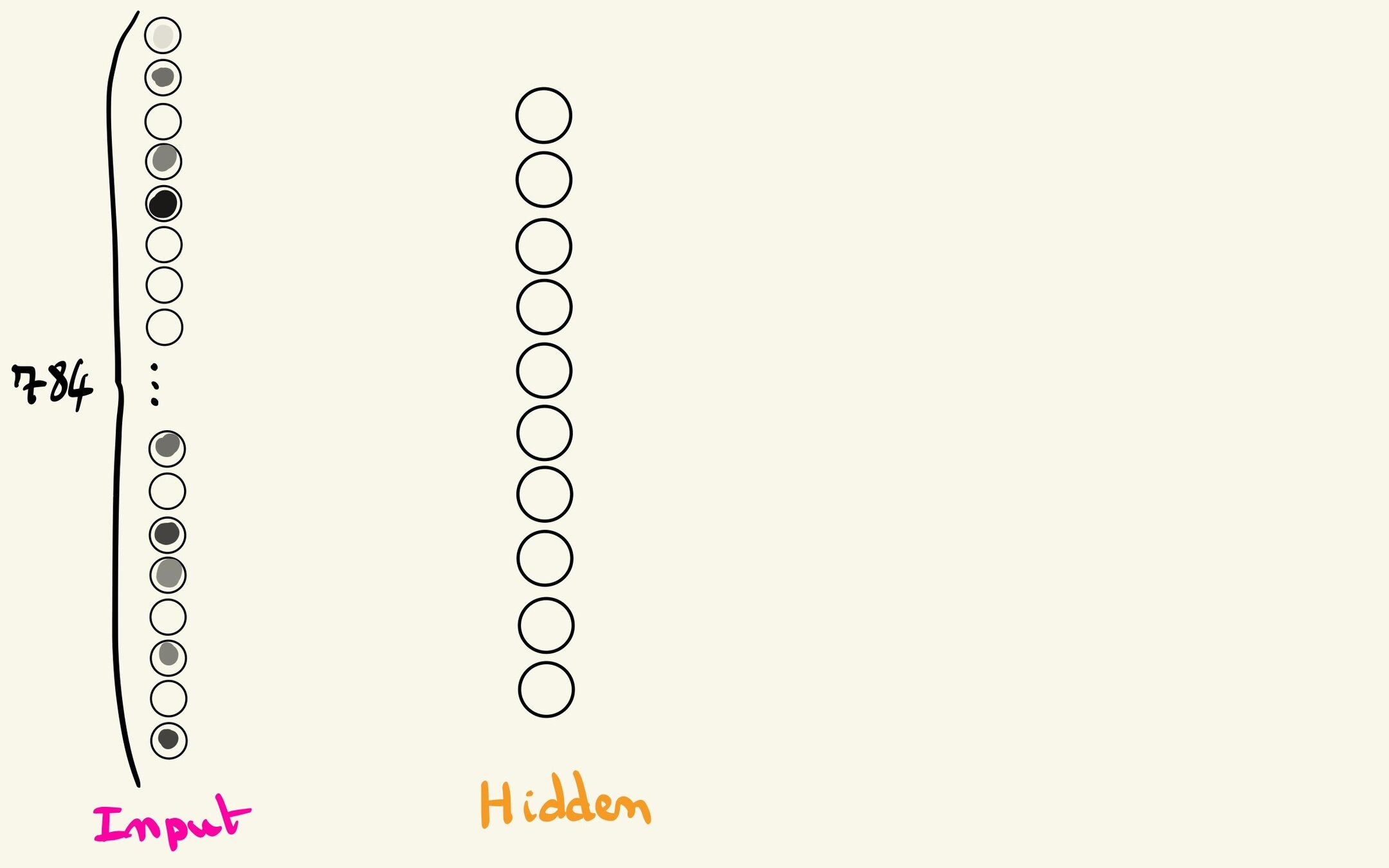

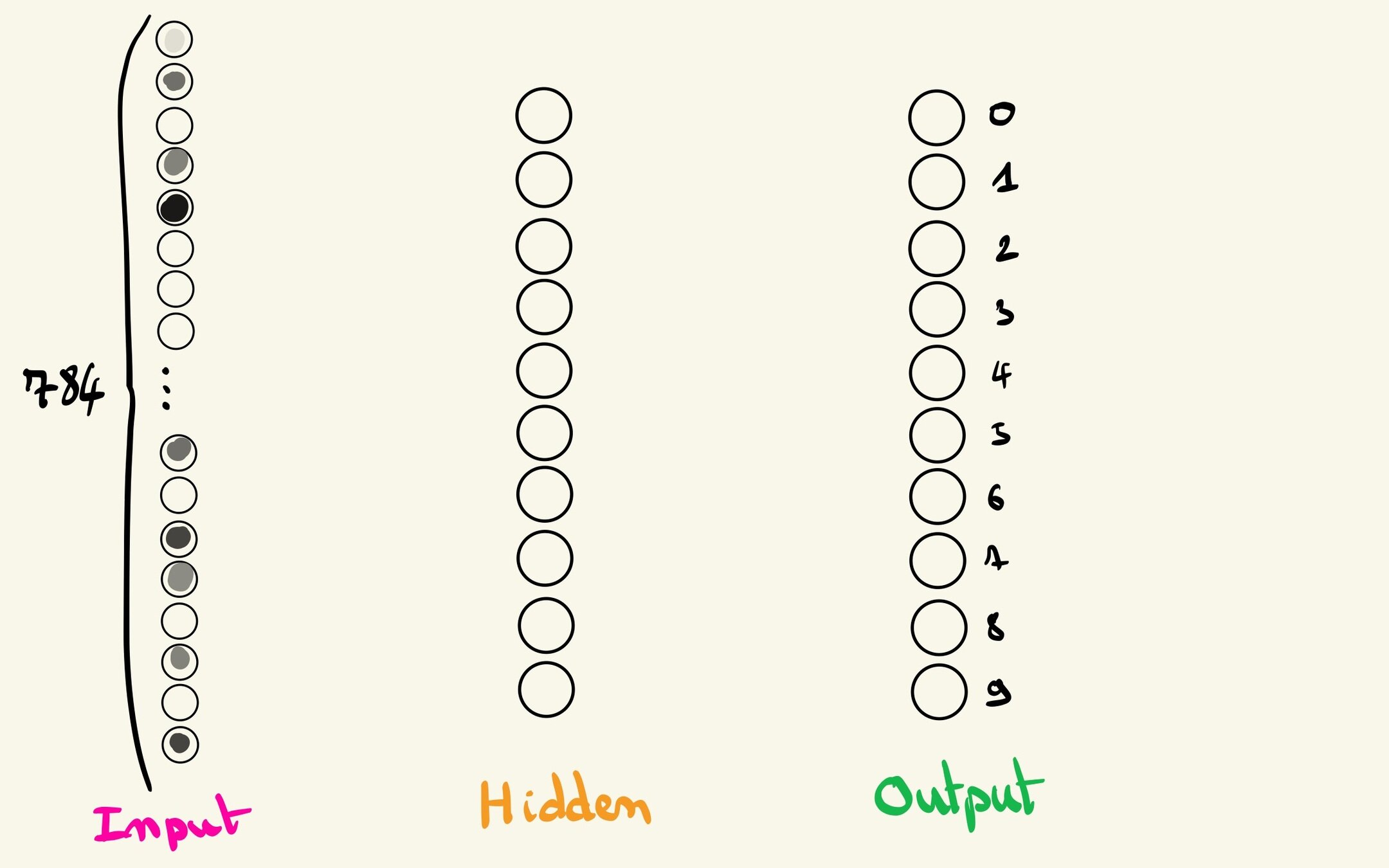

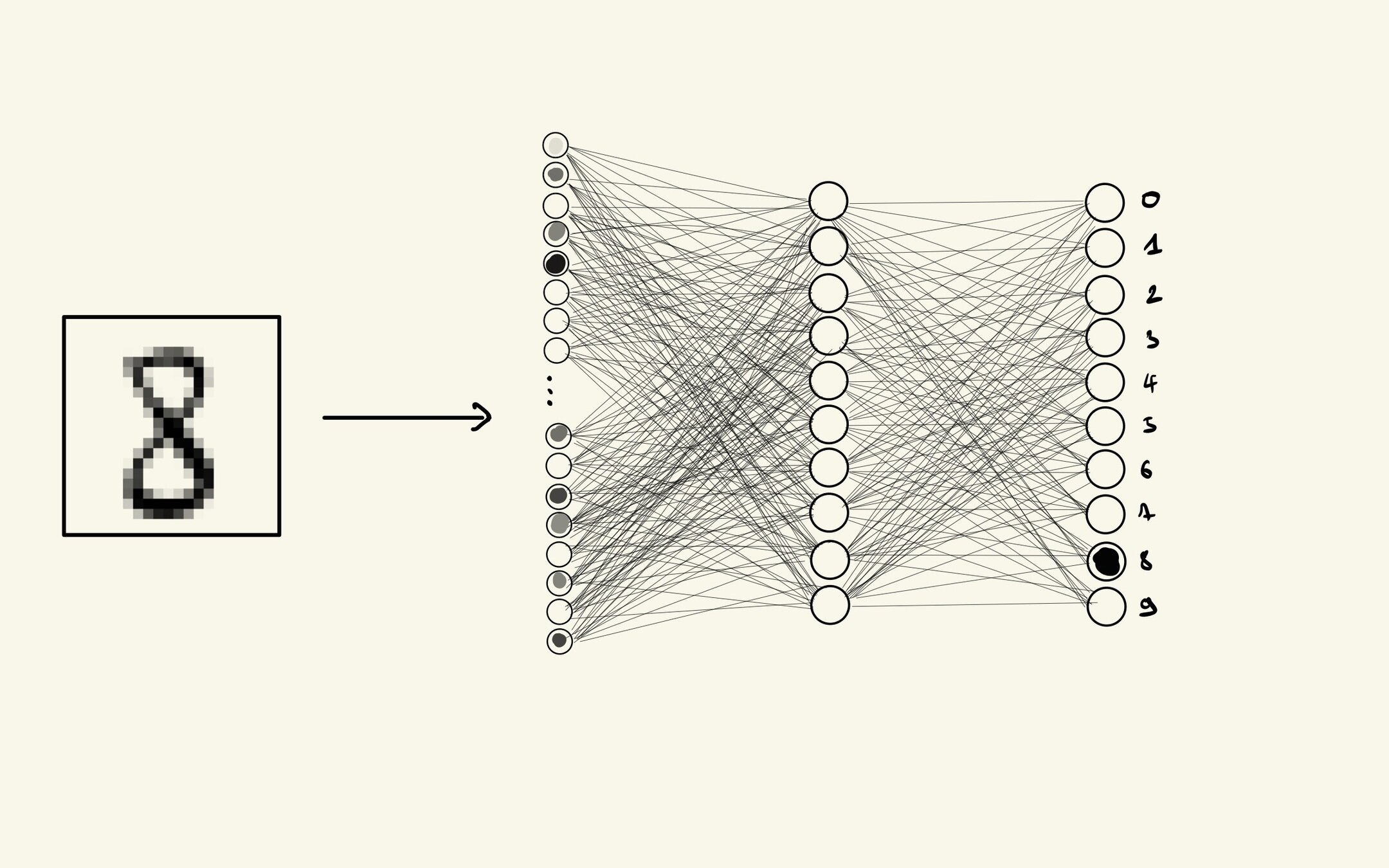

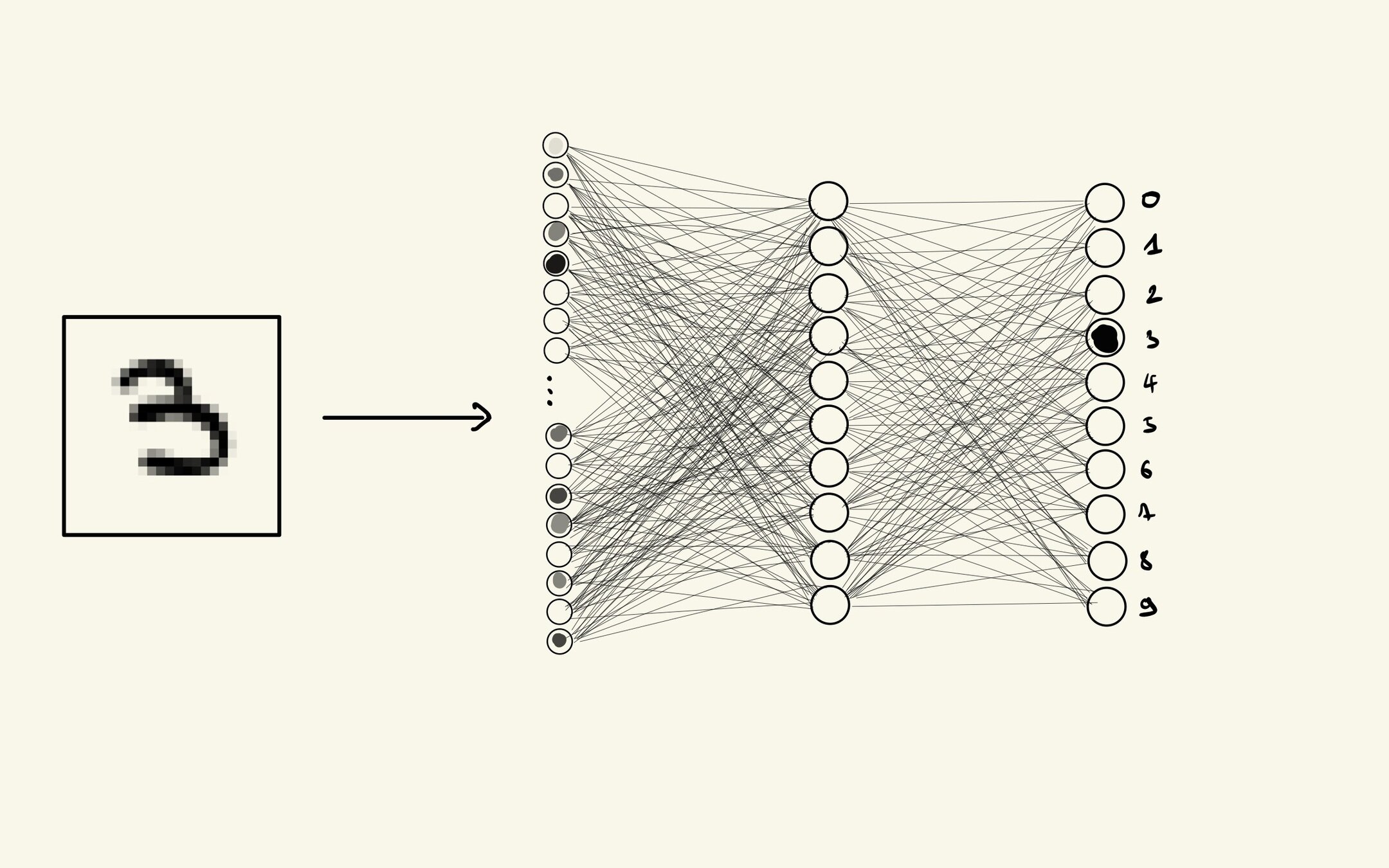

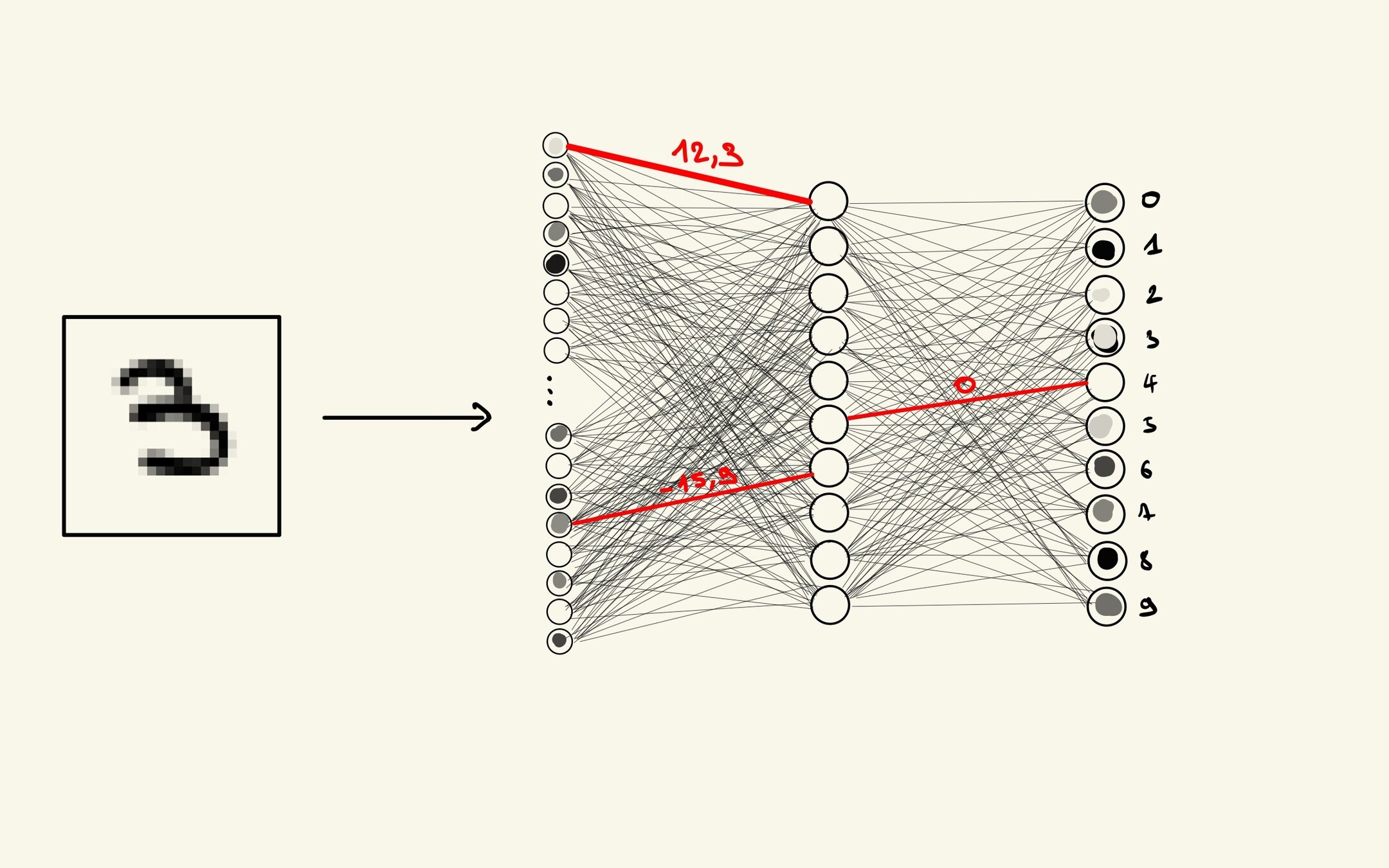

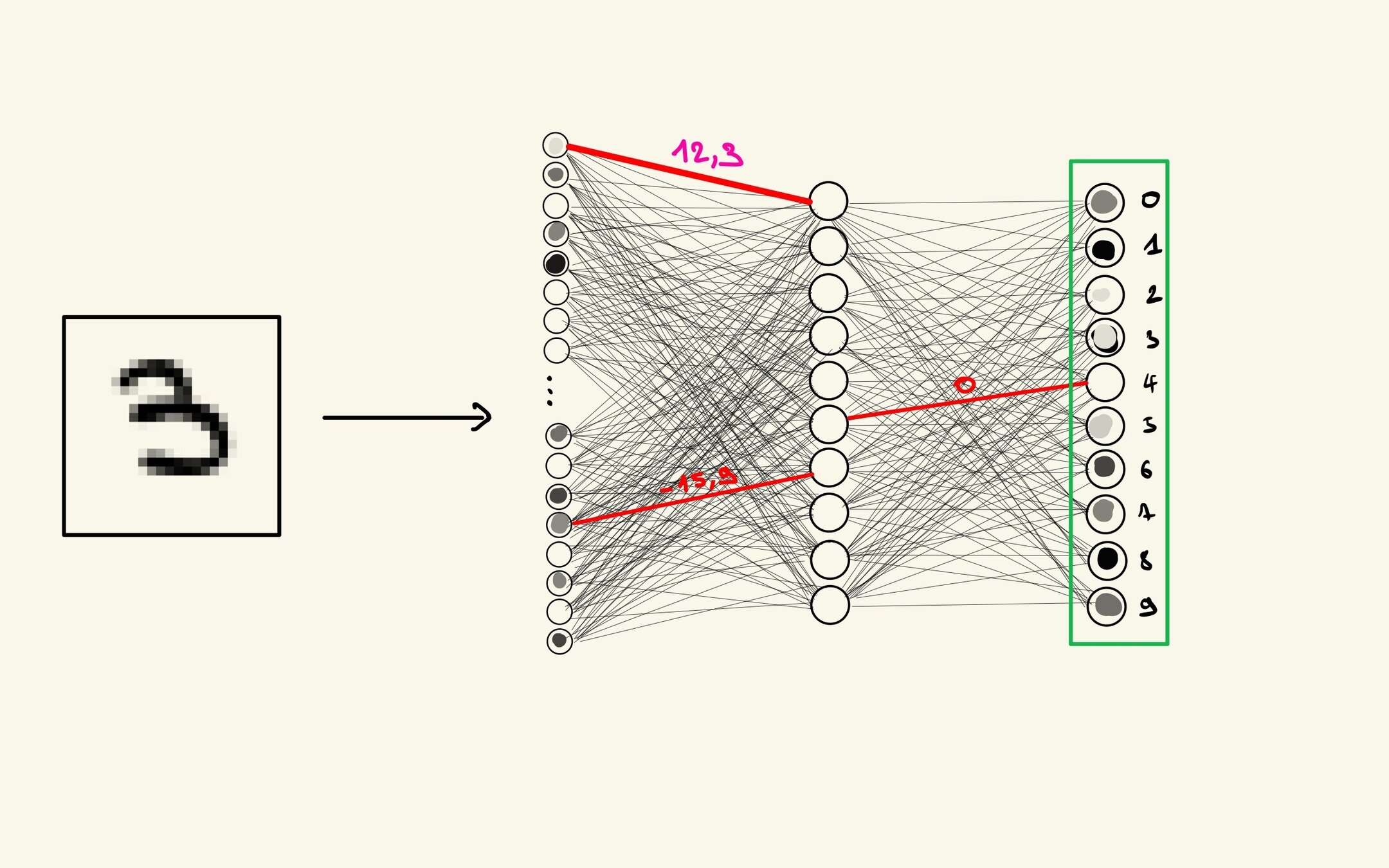

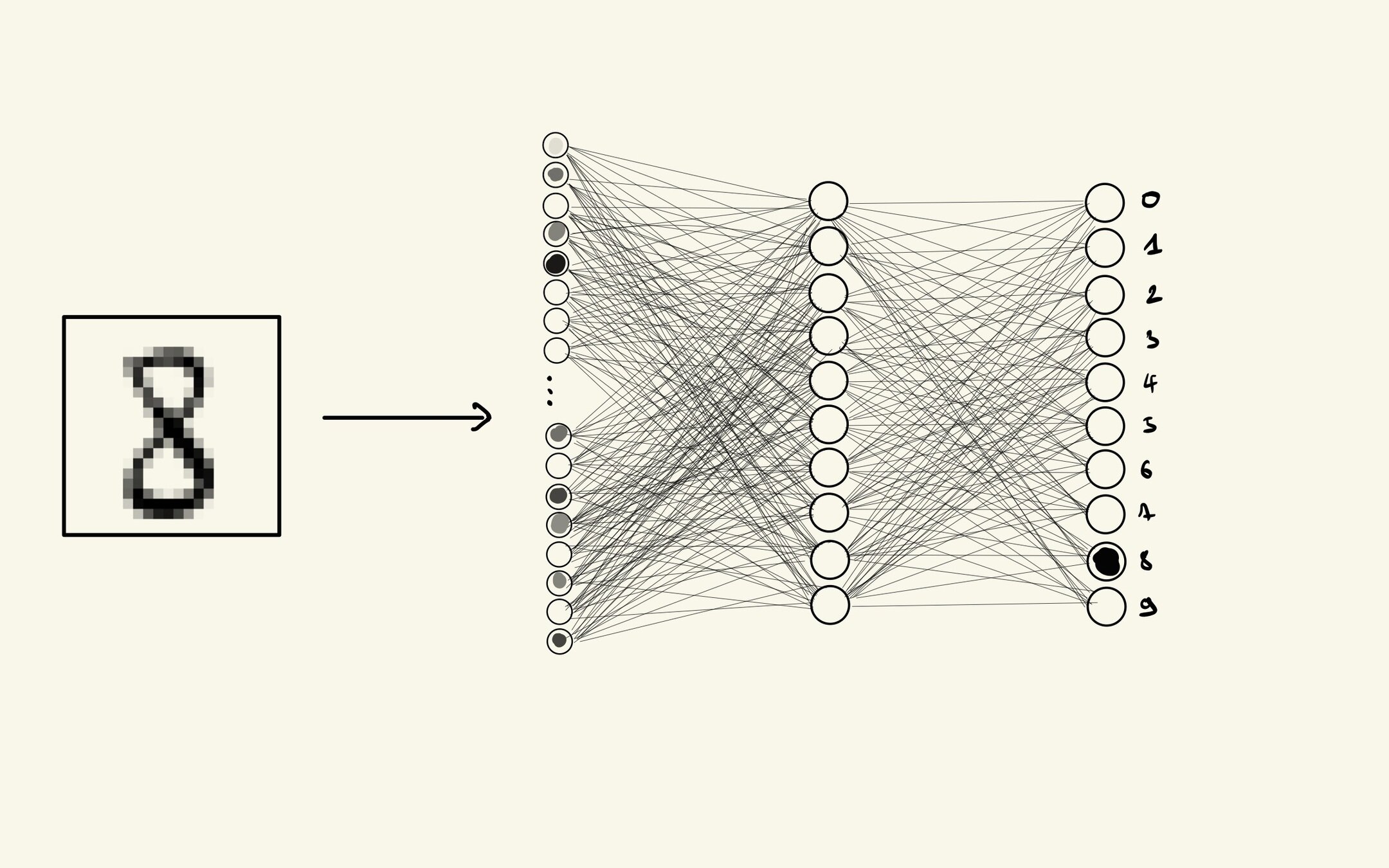

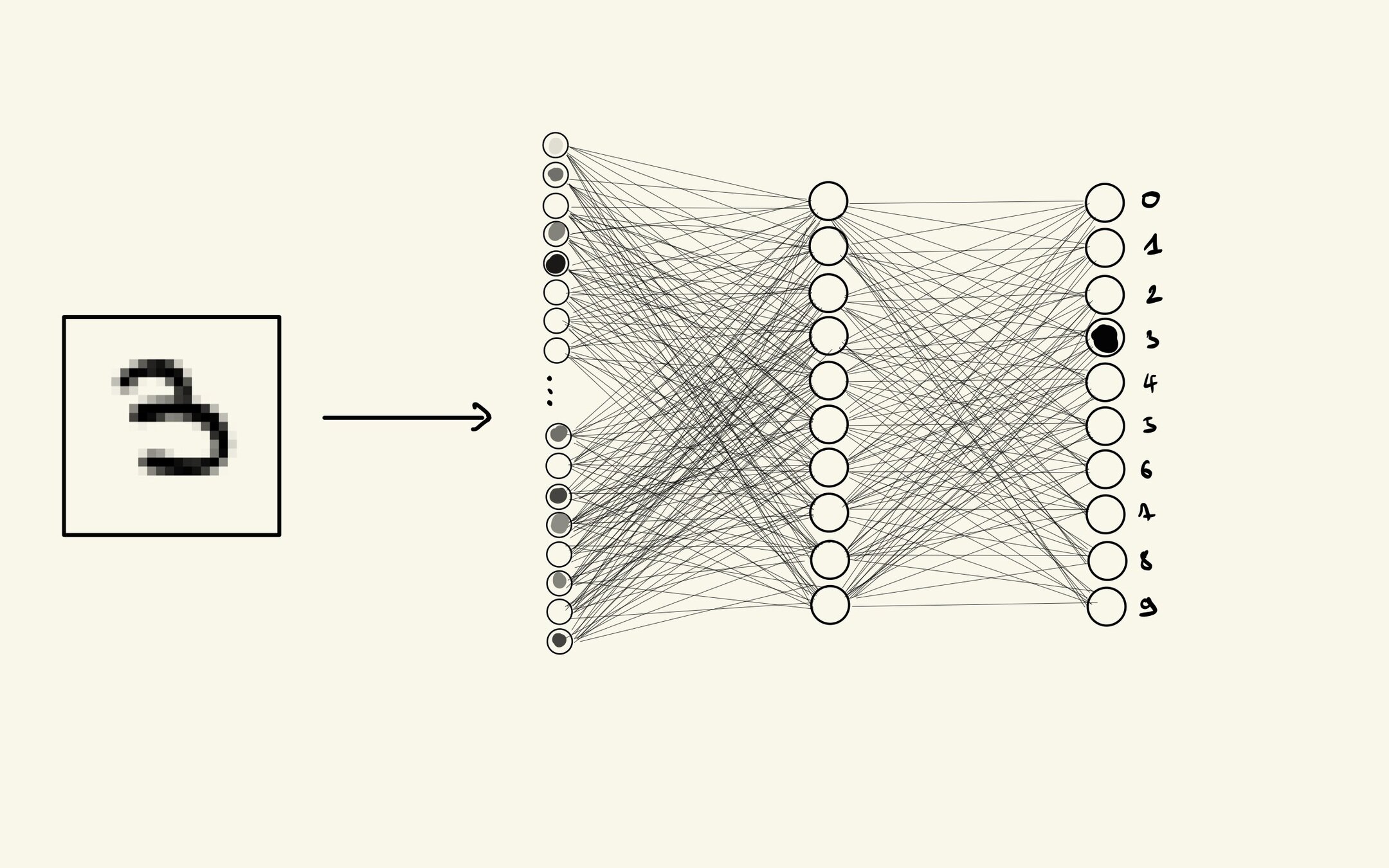

Réseau de neurones artificiels

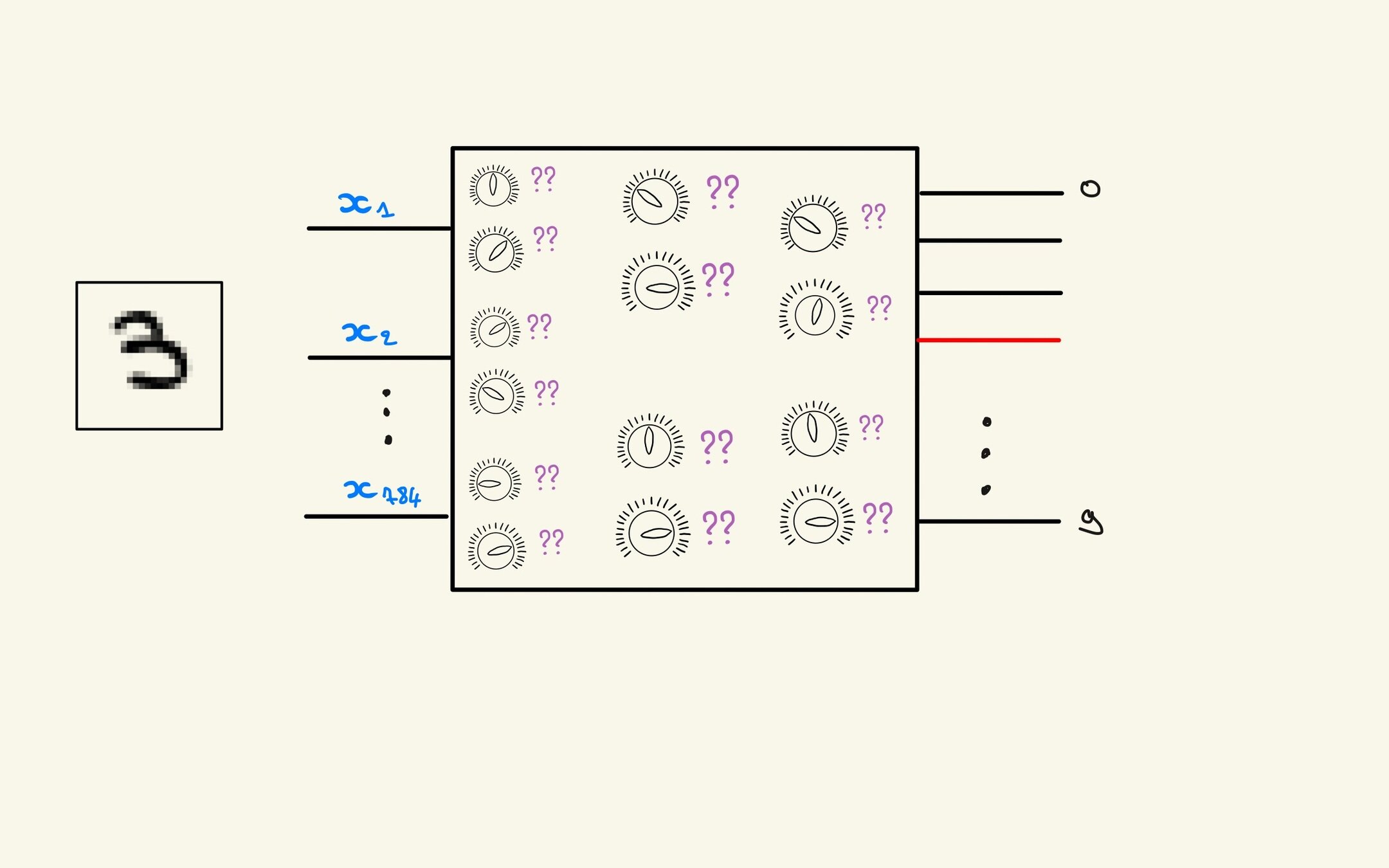

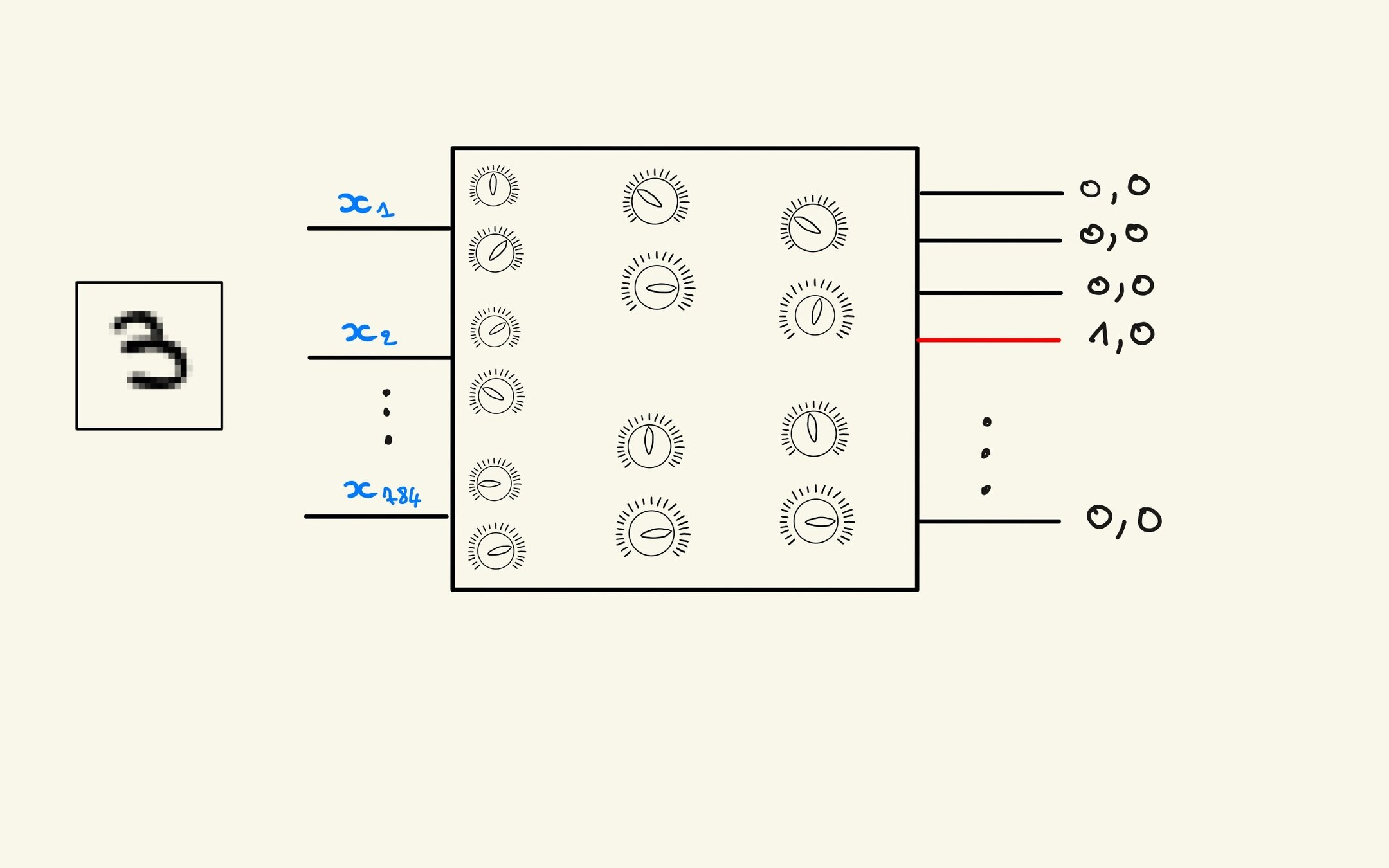

Attentes

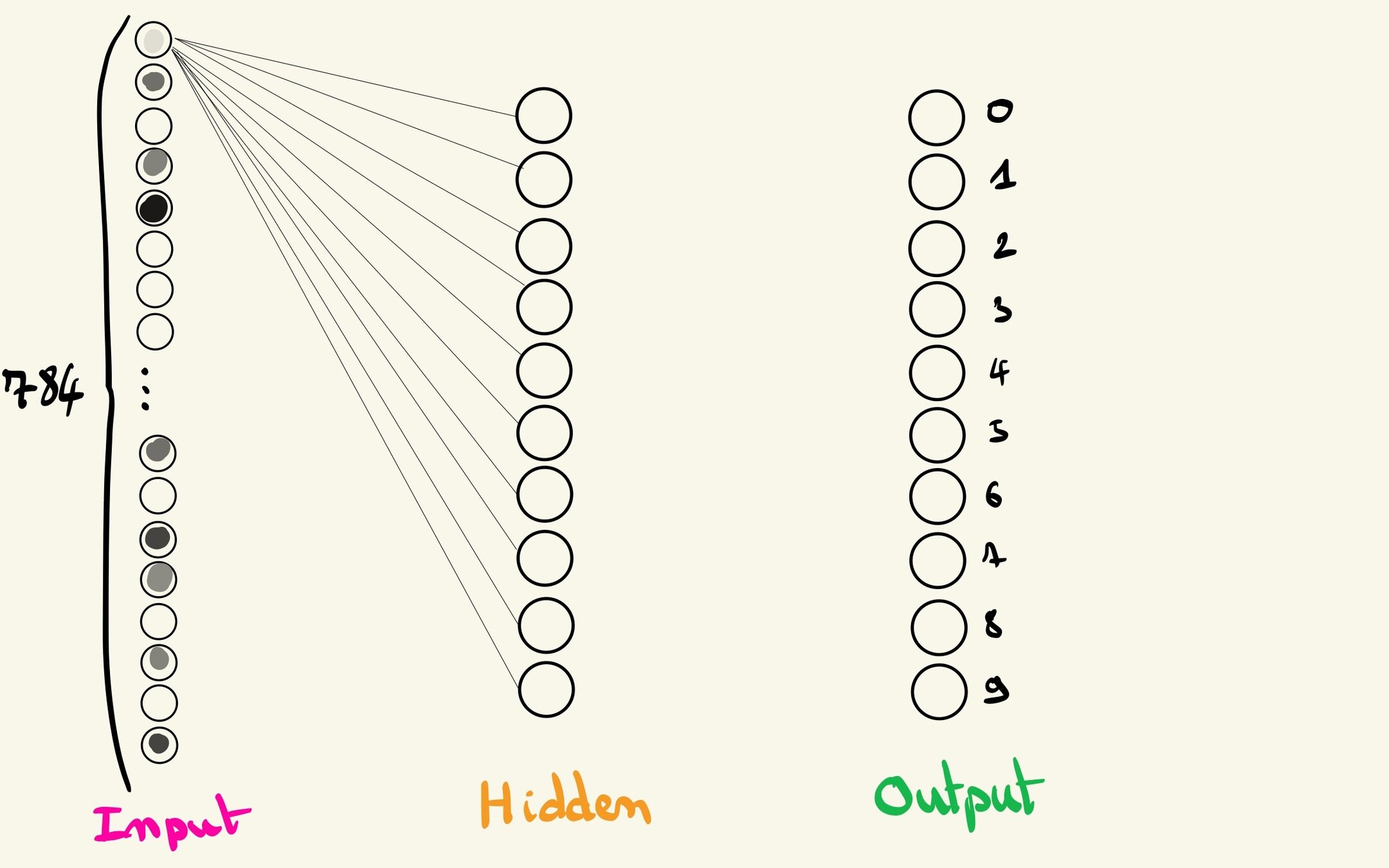

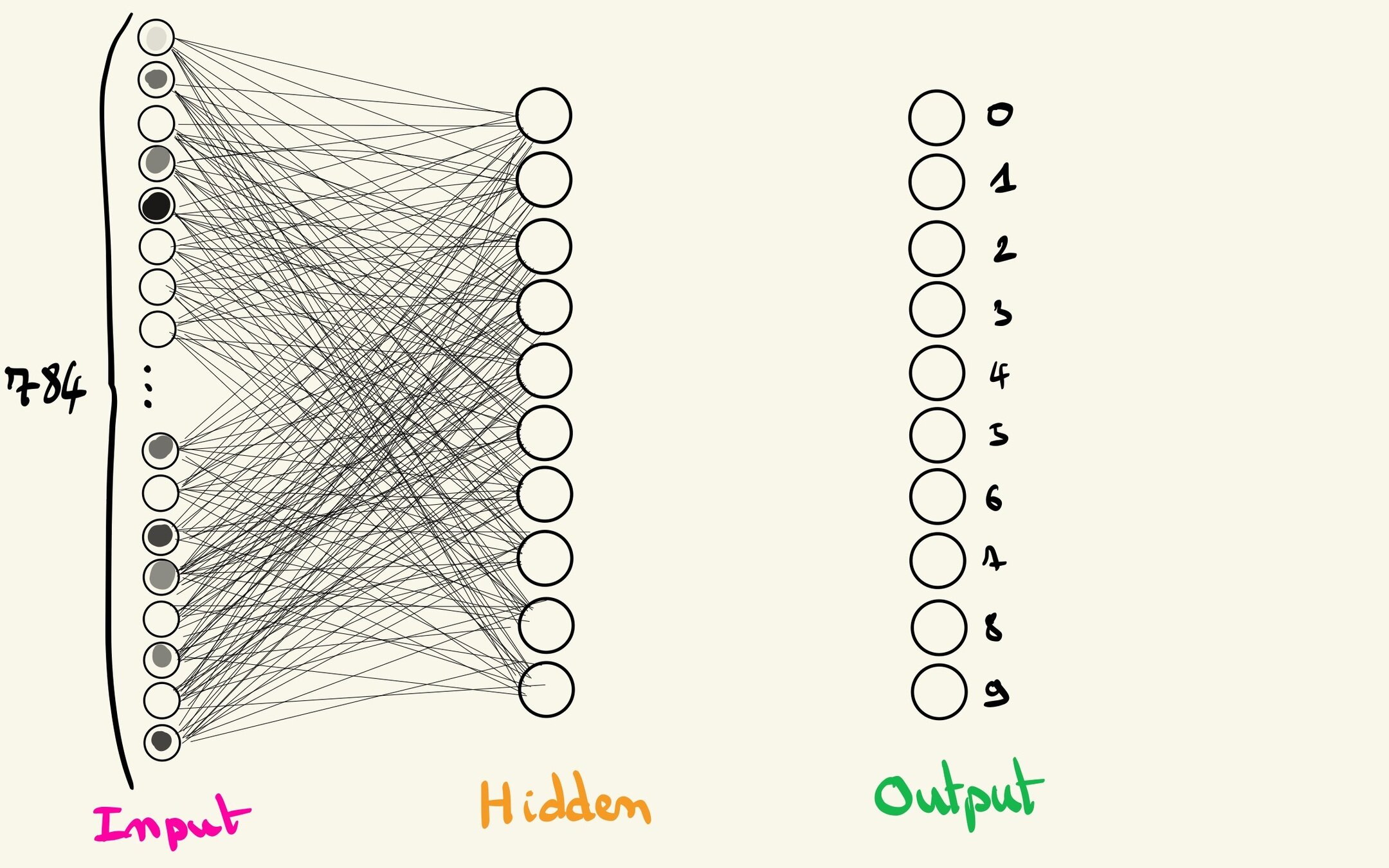

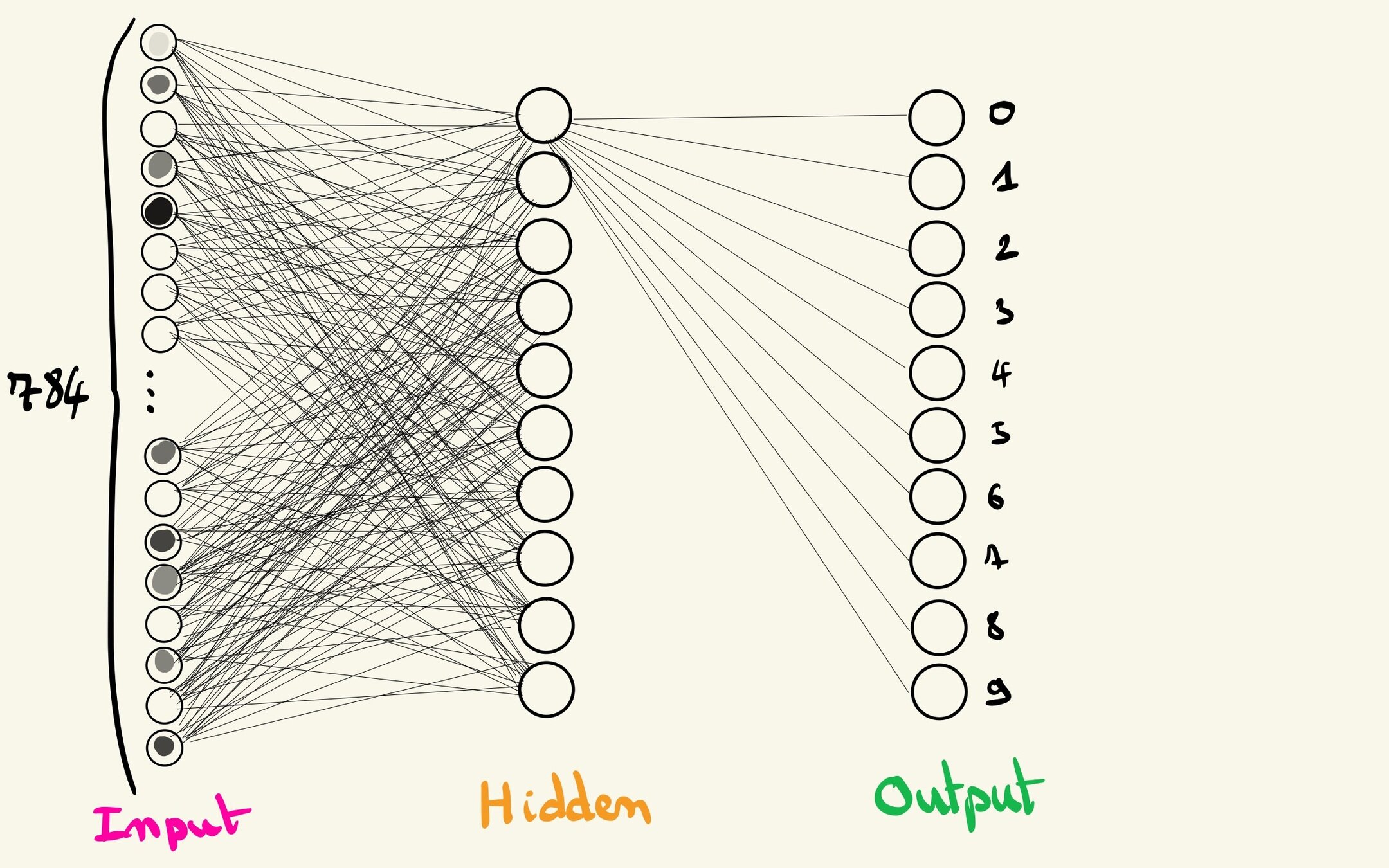

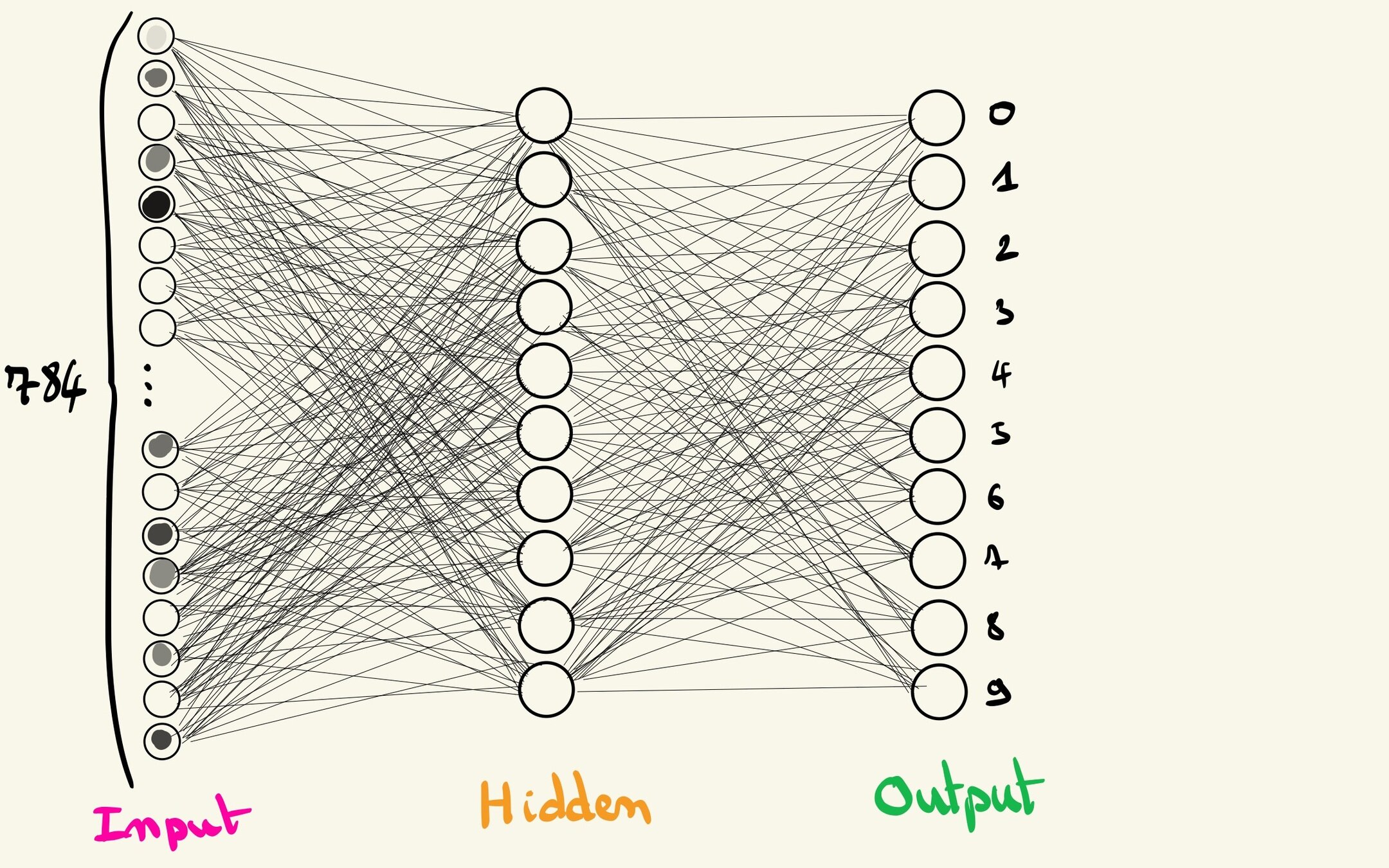

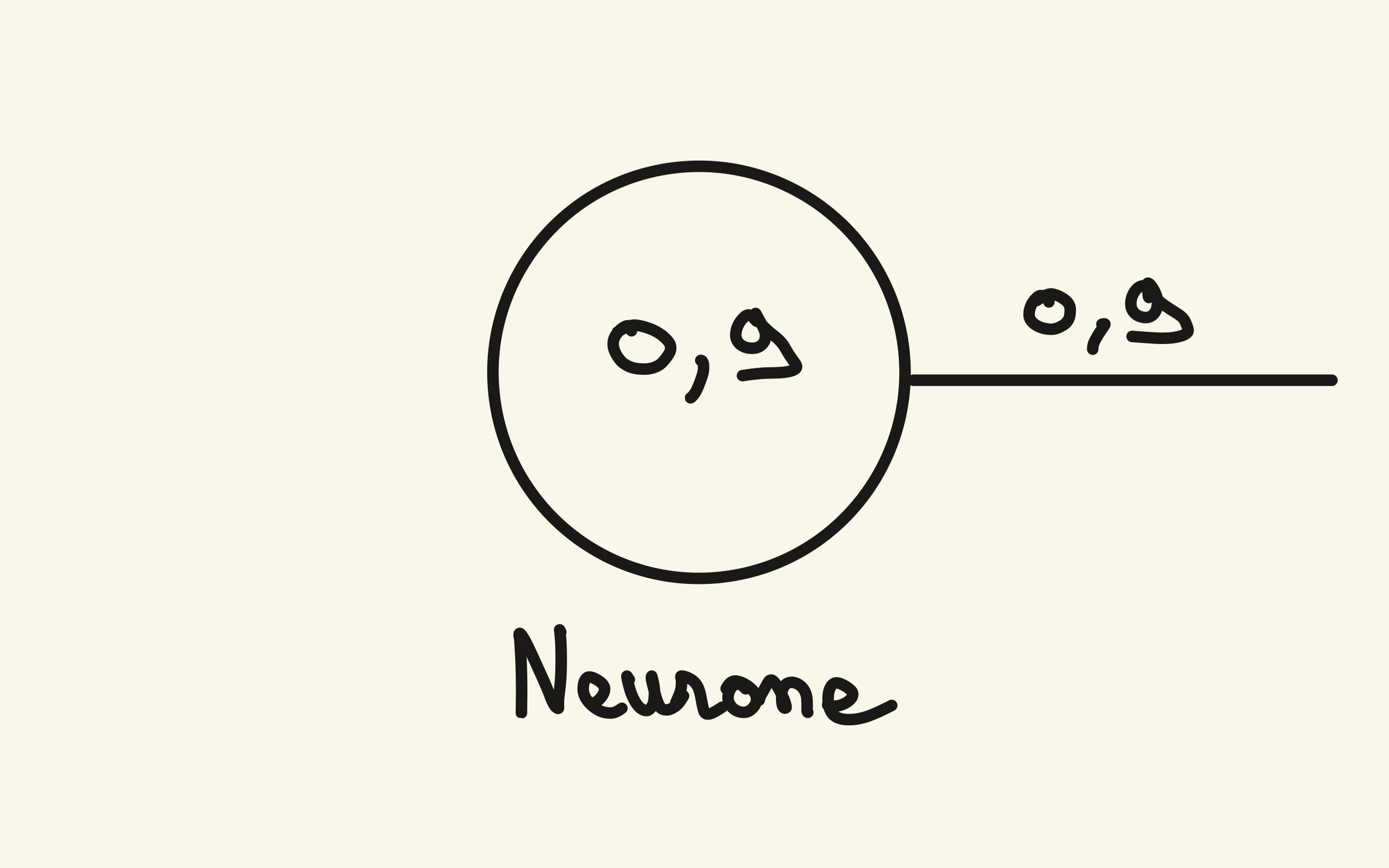

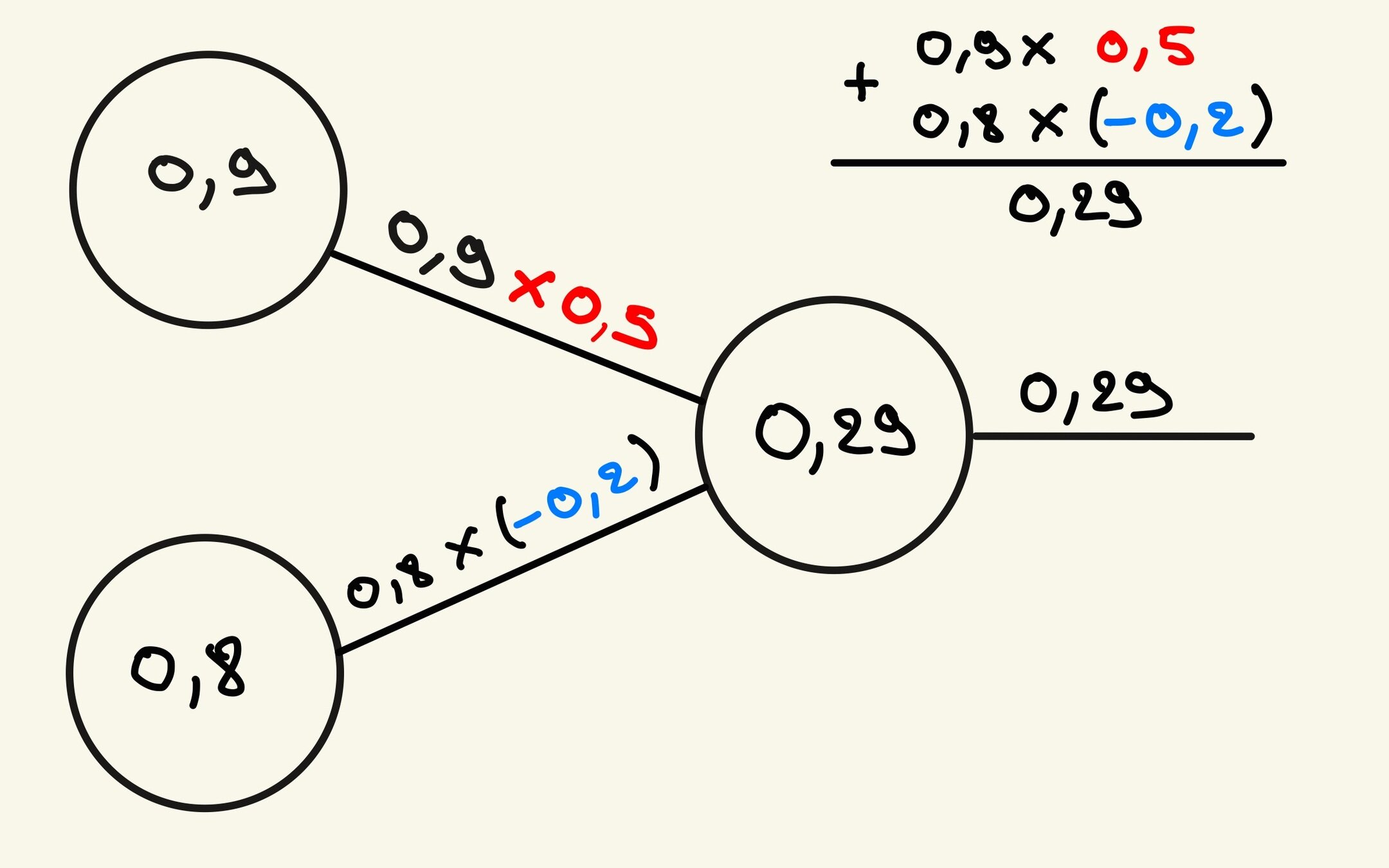

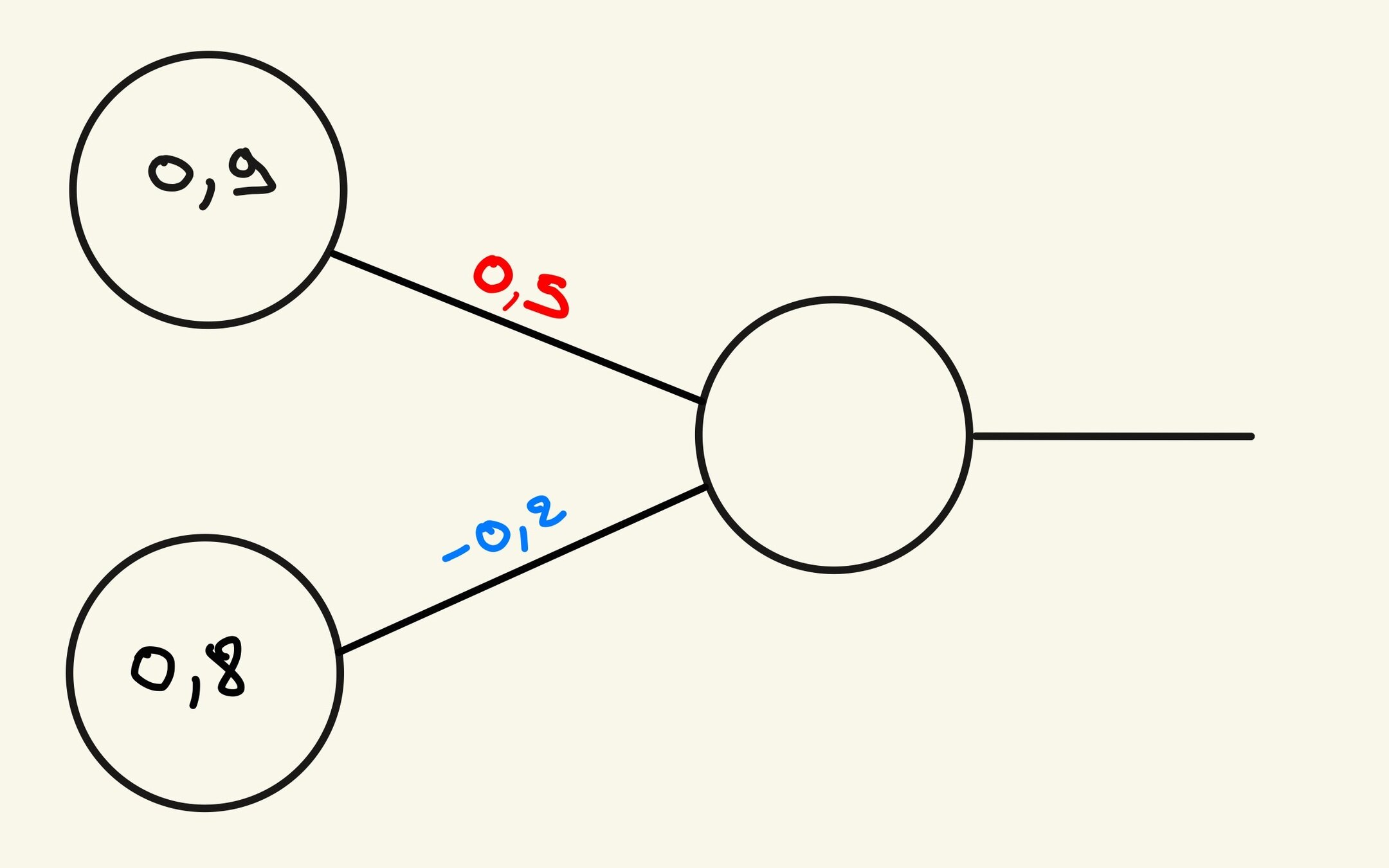

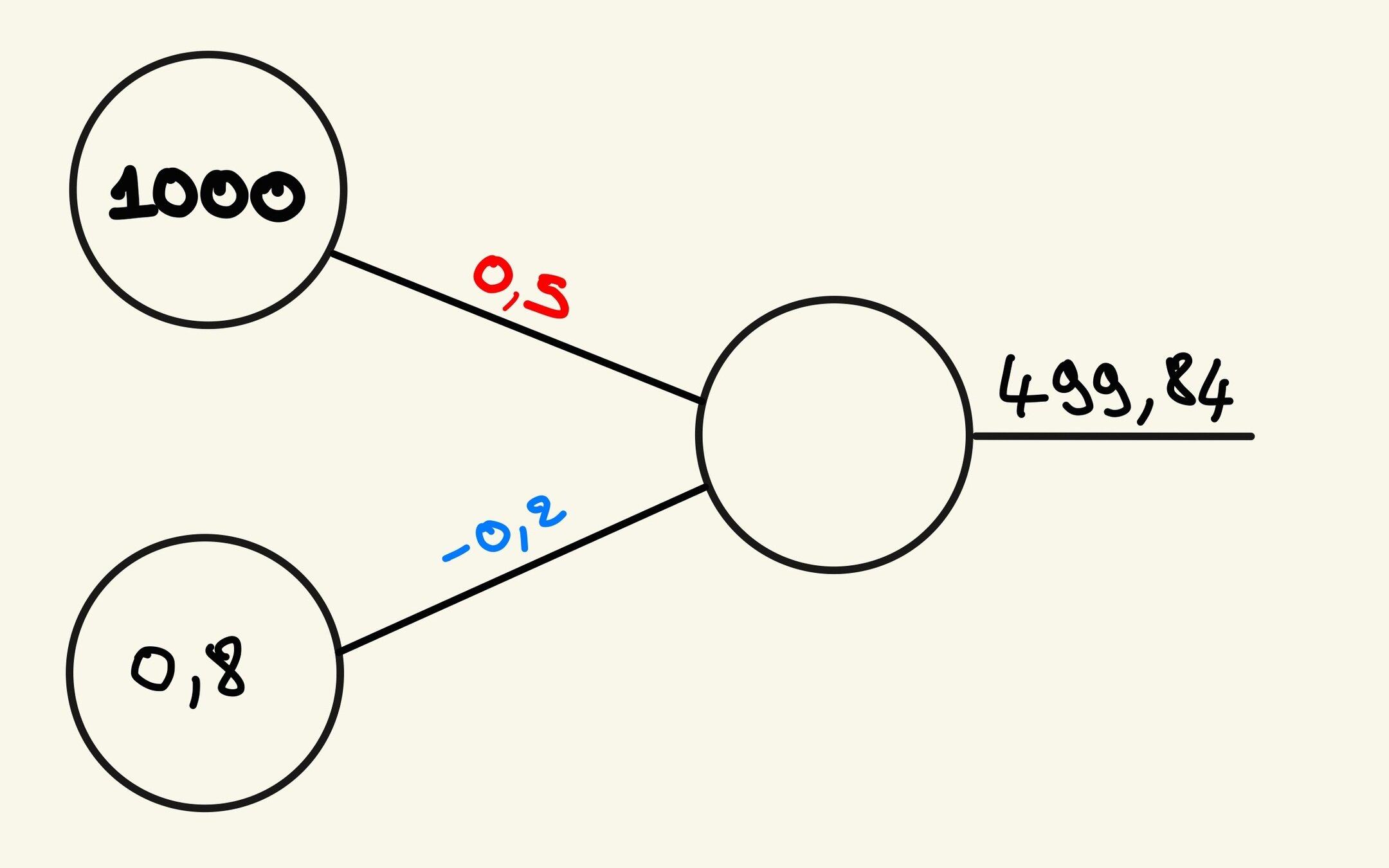

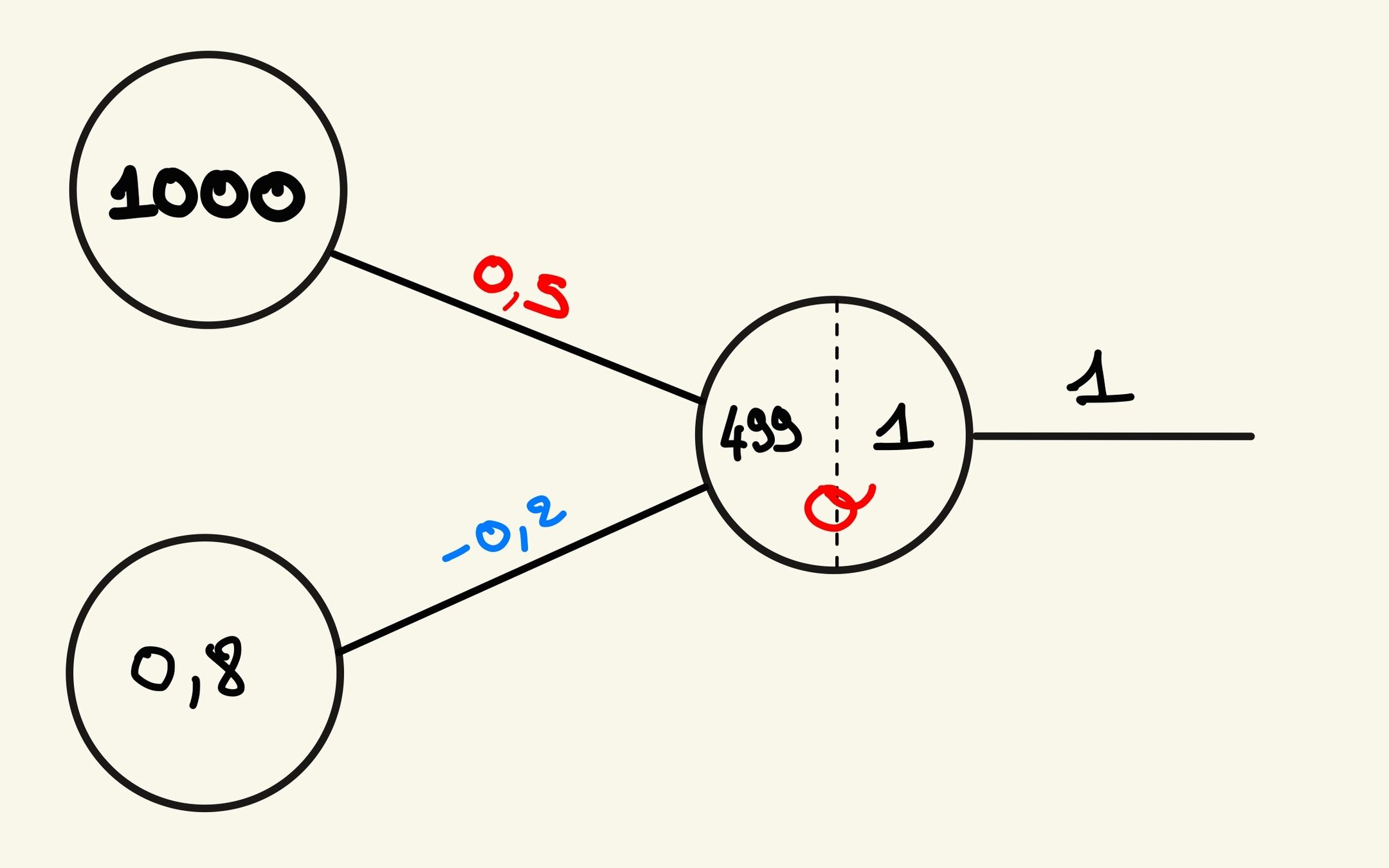

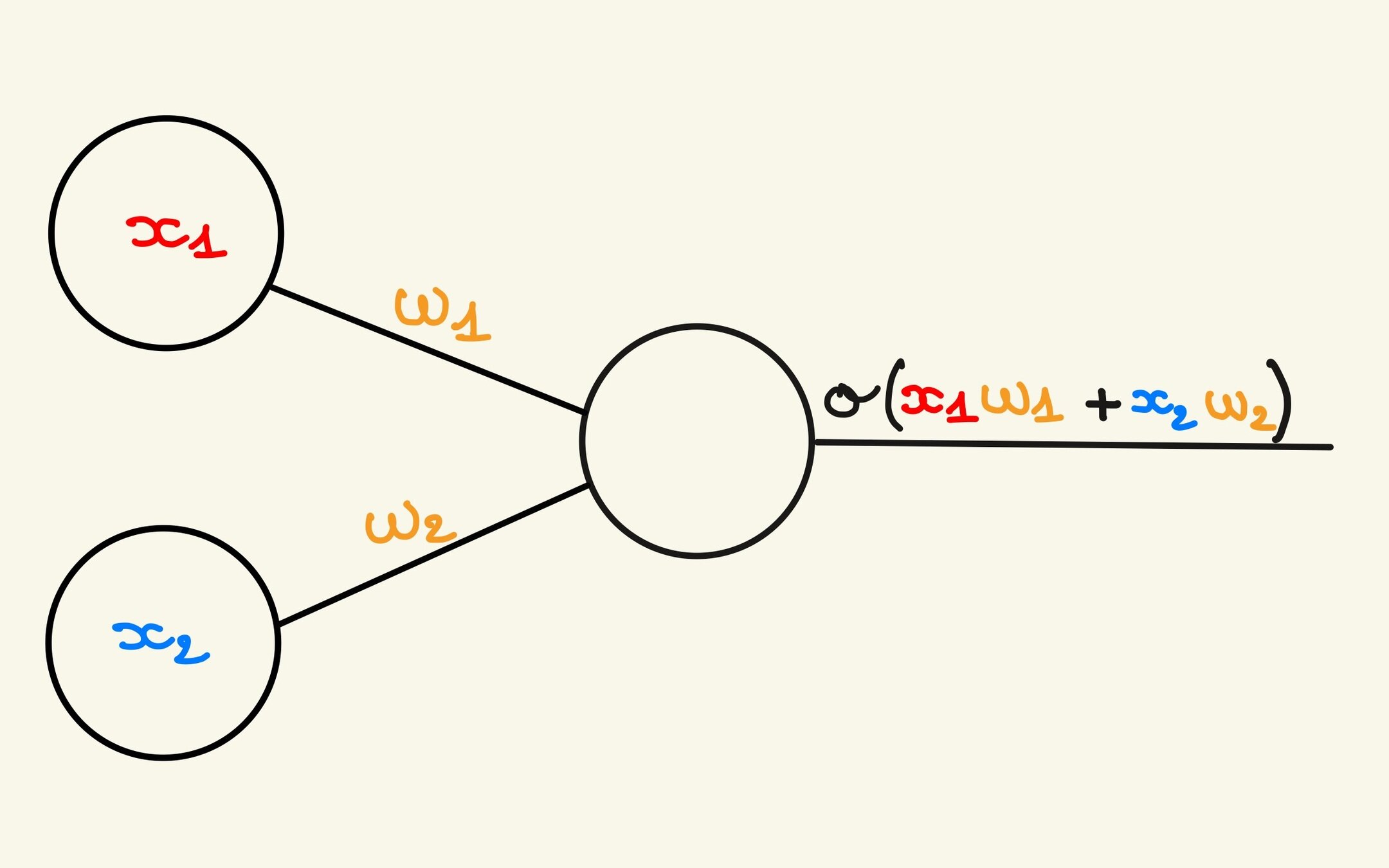

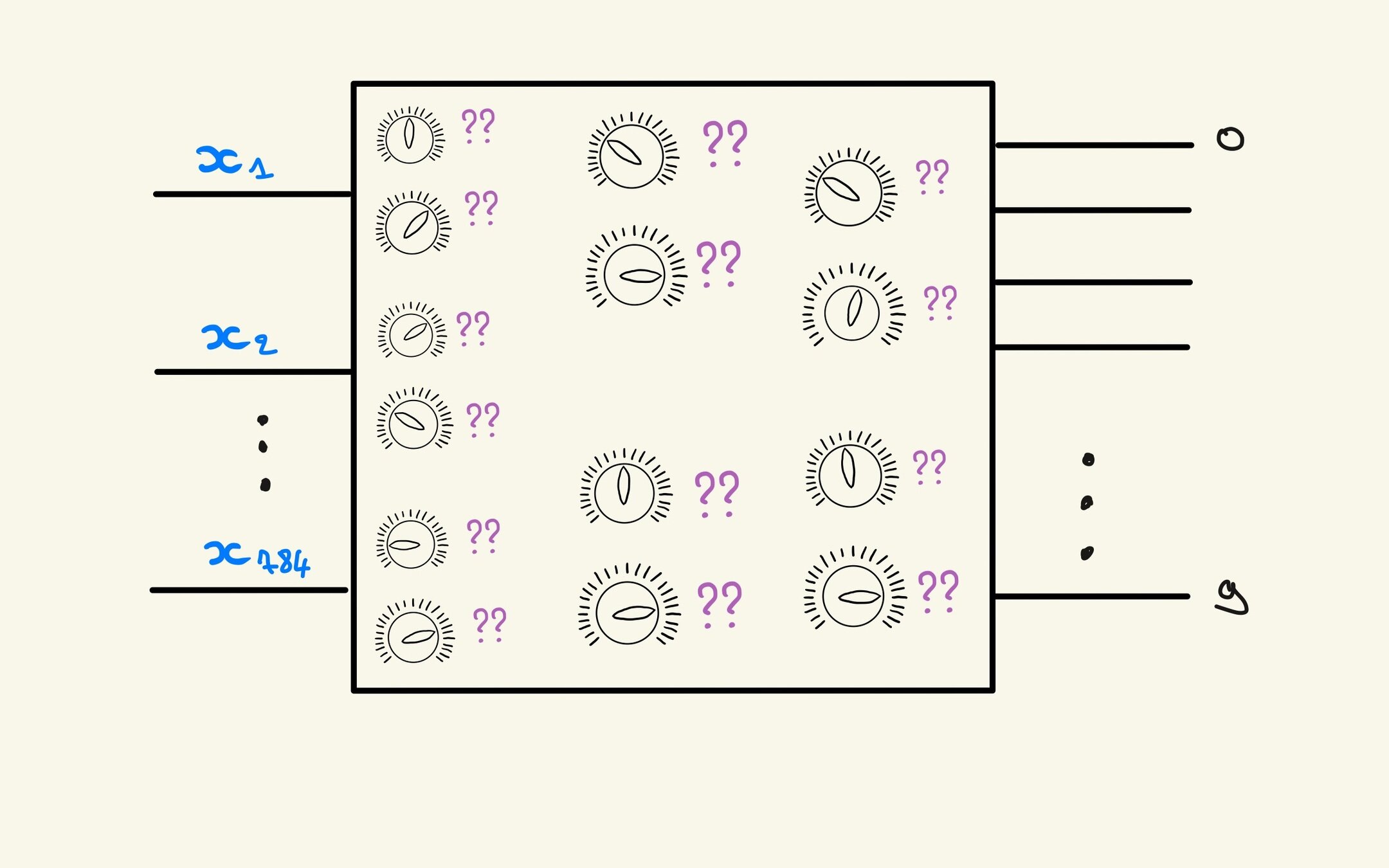

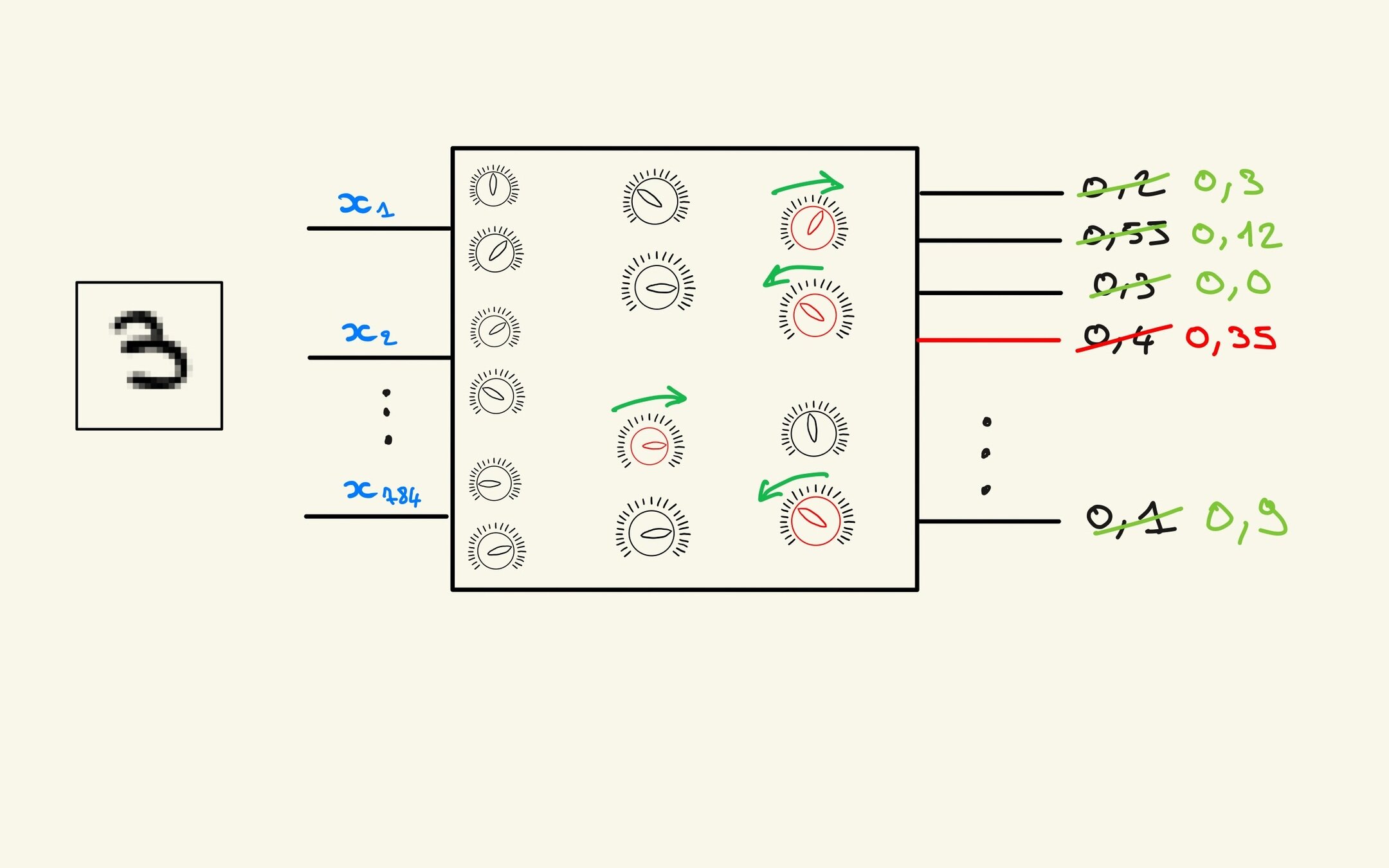

Perceptron et Multilayer Perceptron

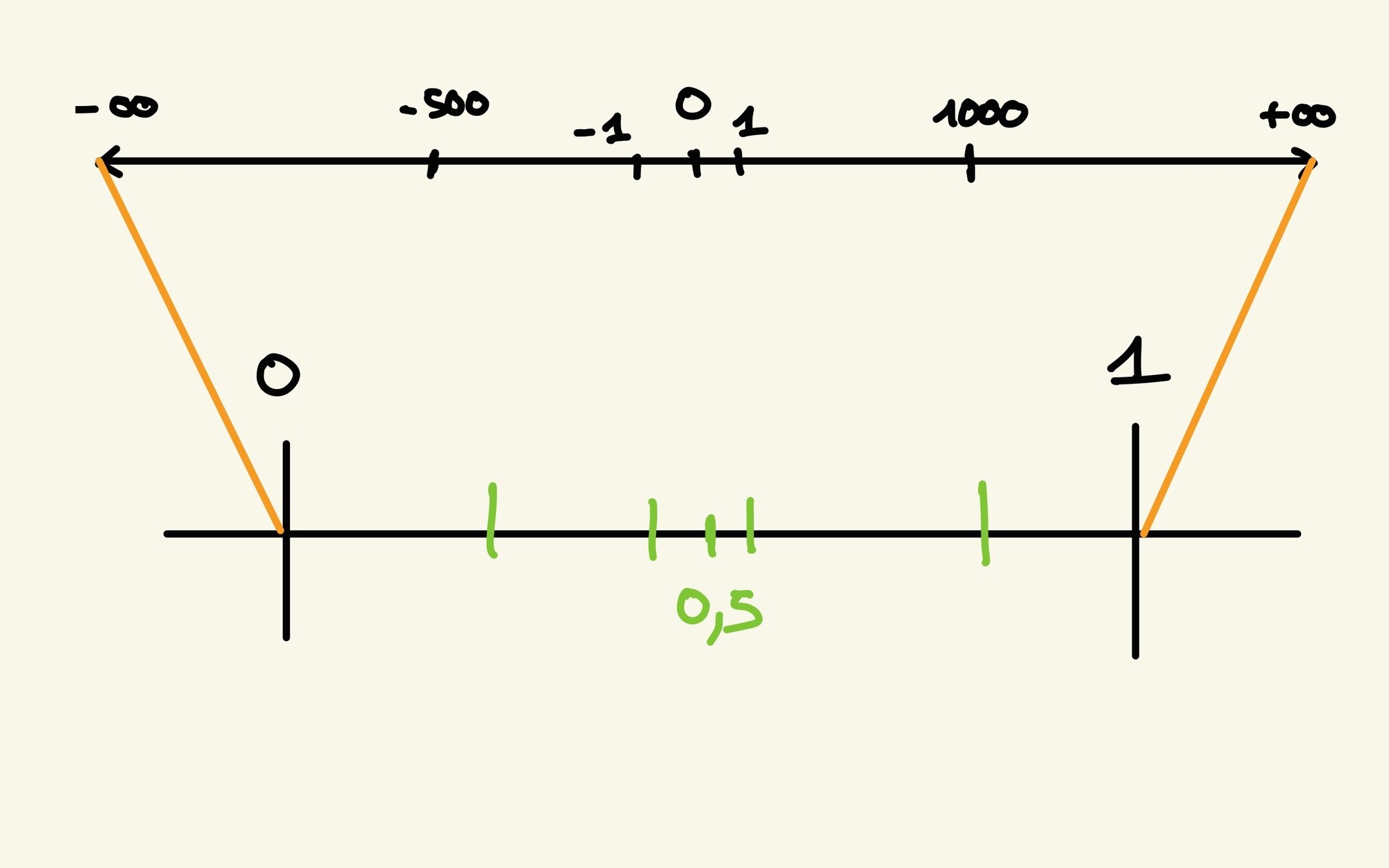

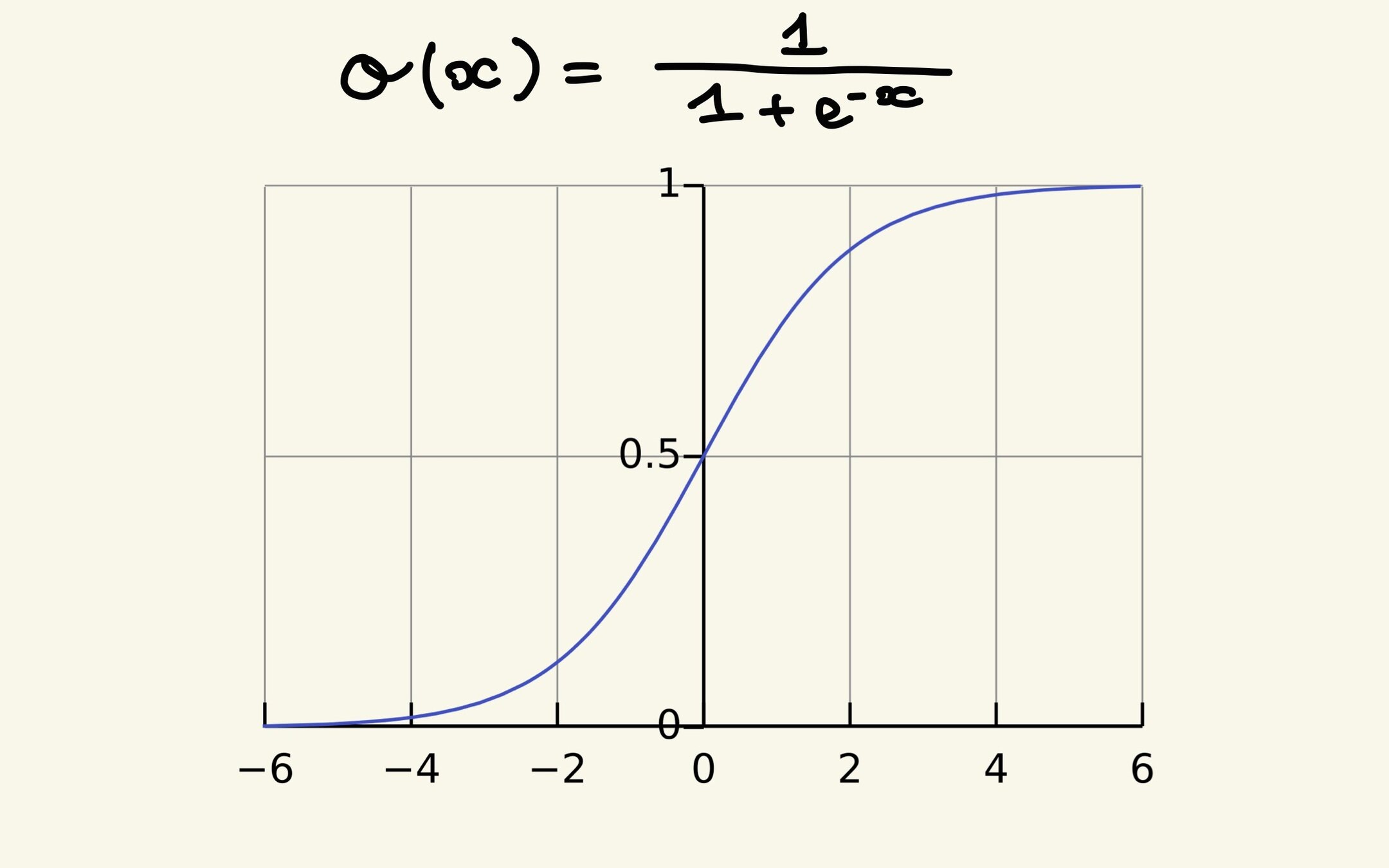

Fonction d'activation : Sigmoid

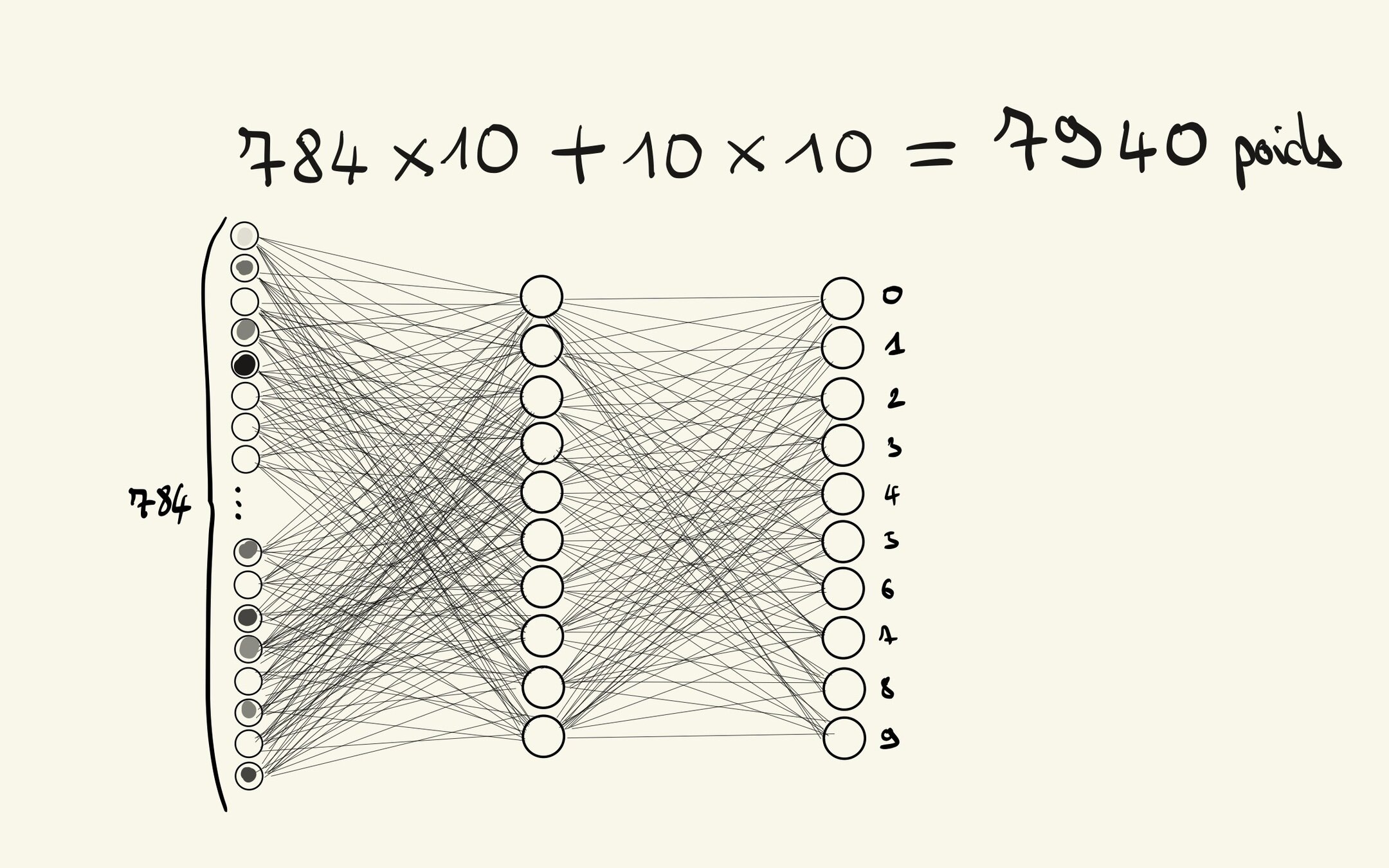

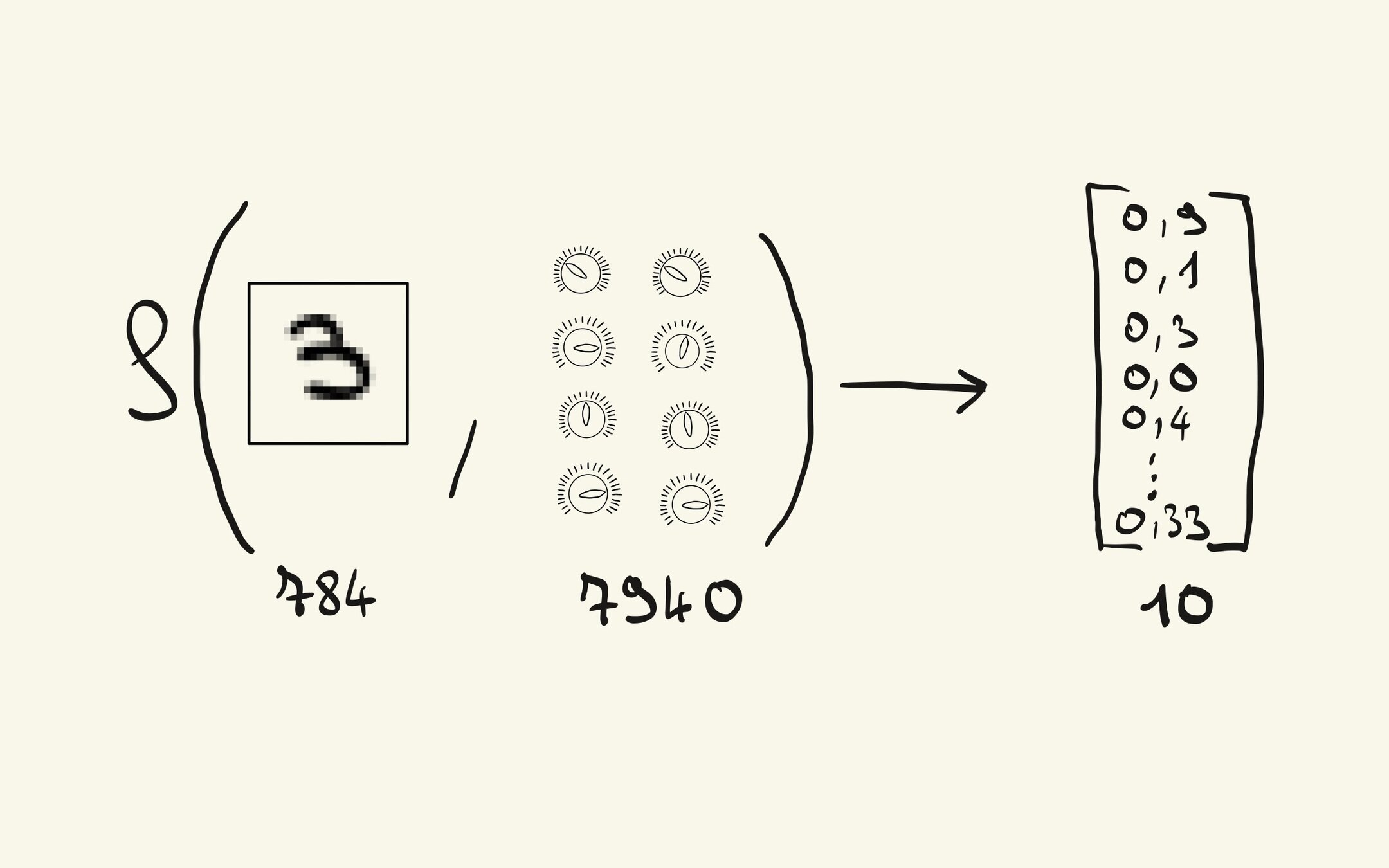

Configuration du réseau

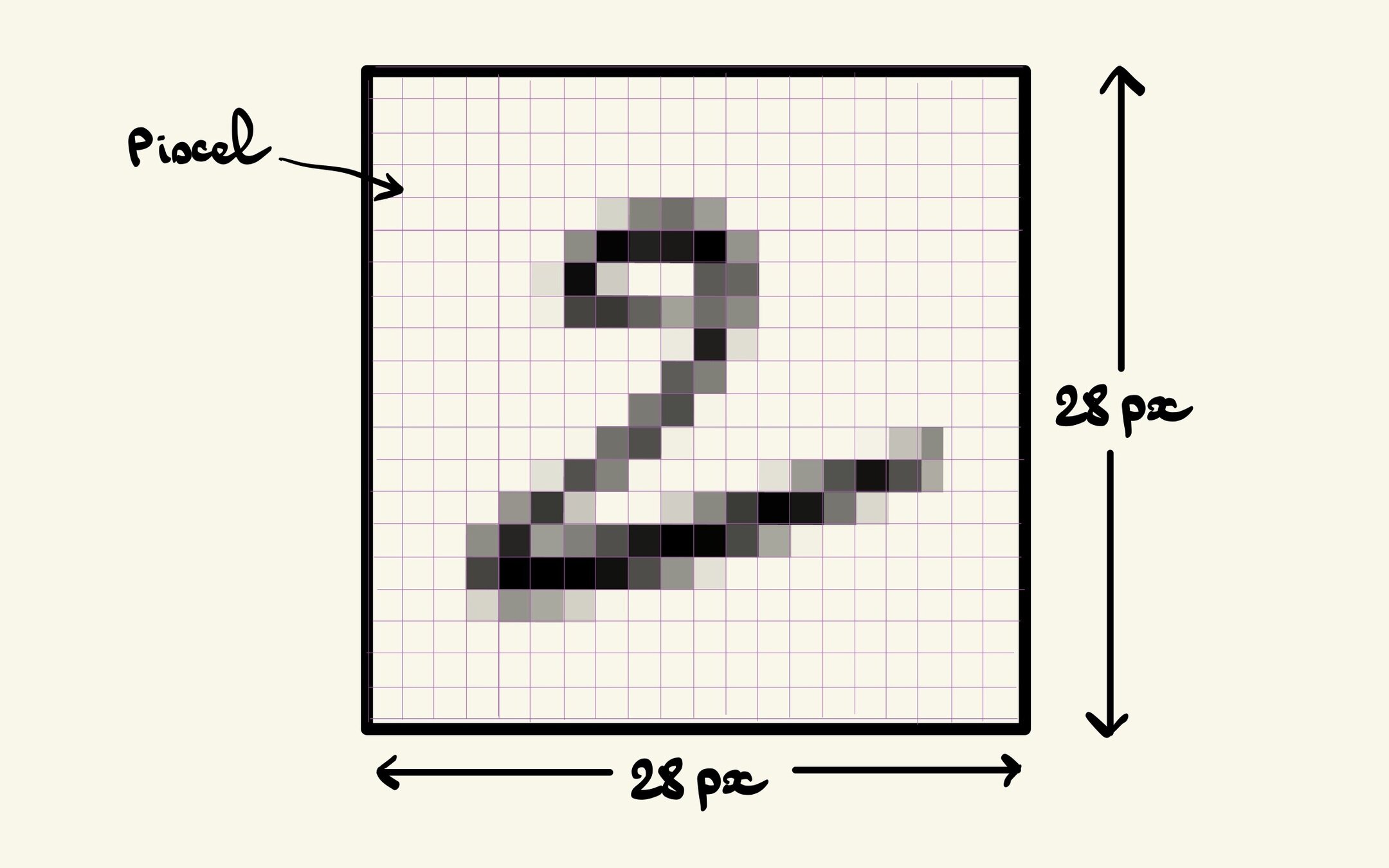

Données quantitatives et récapitulatif

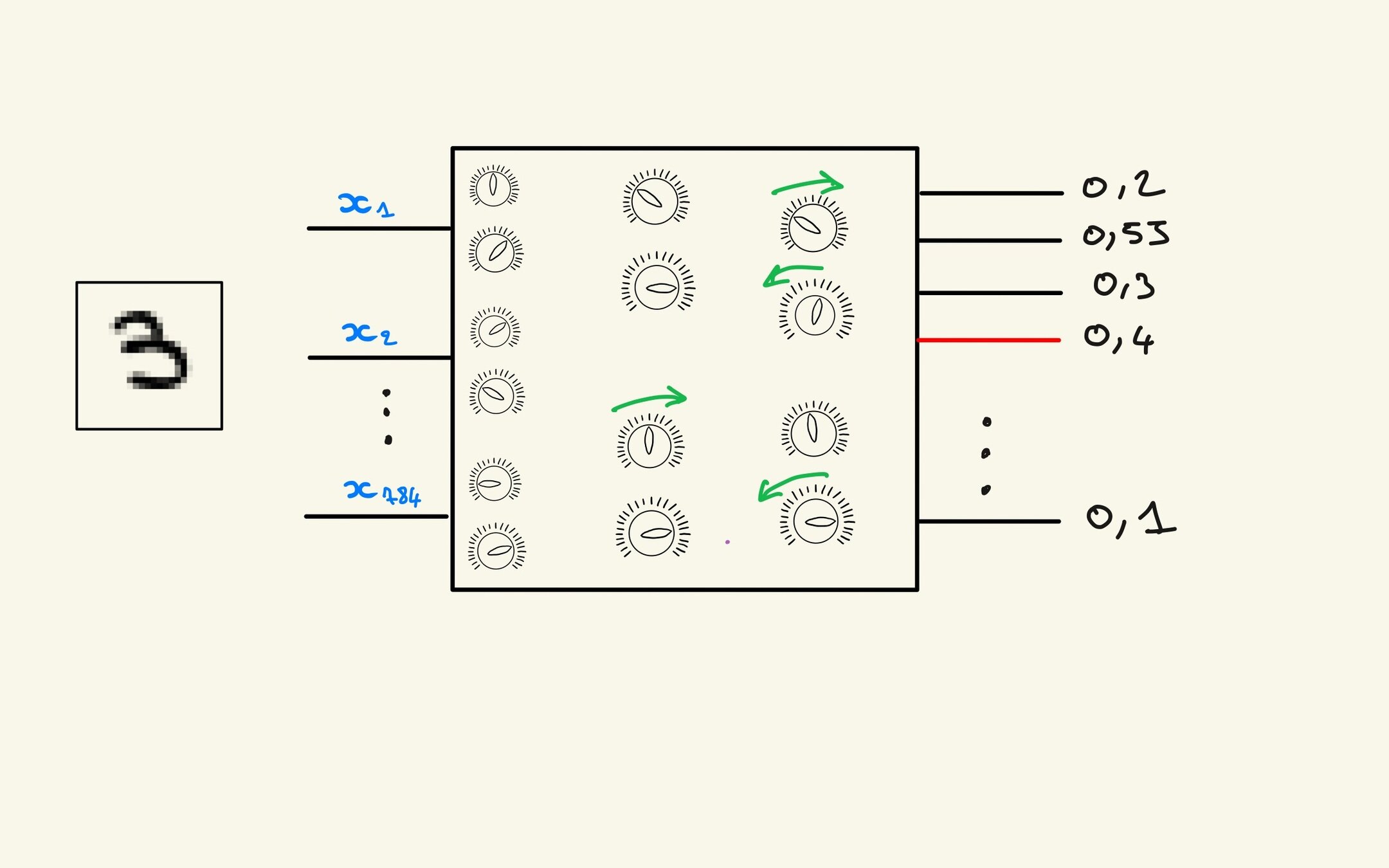

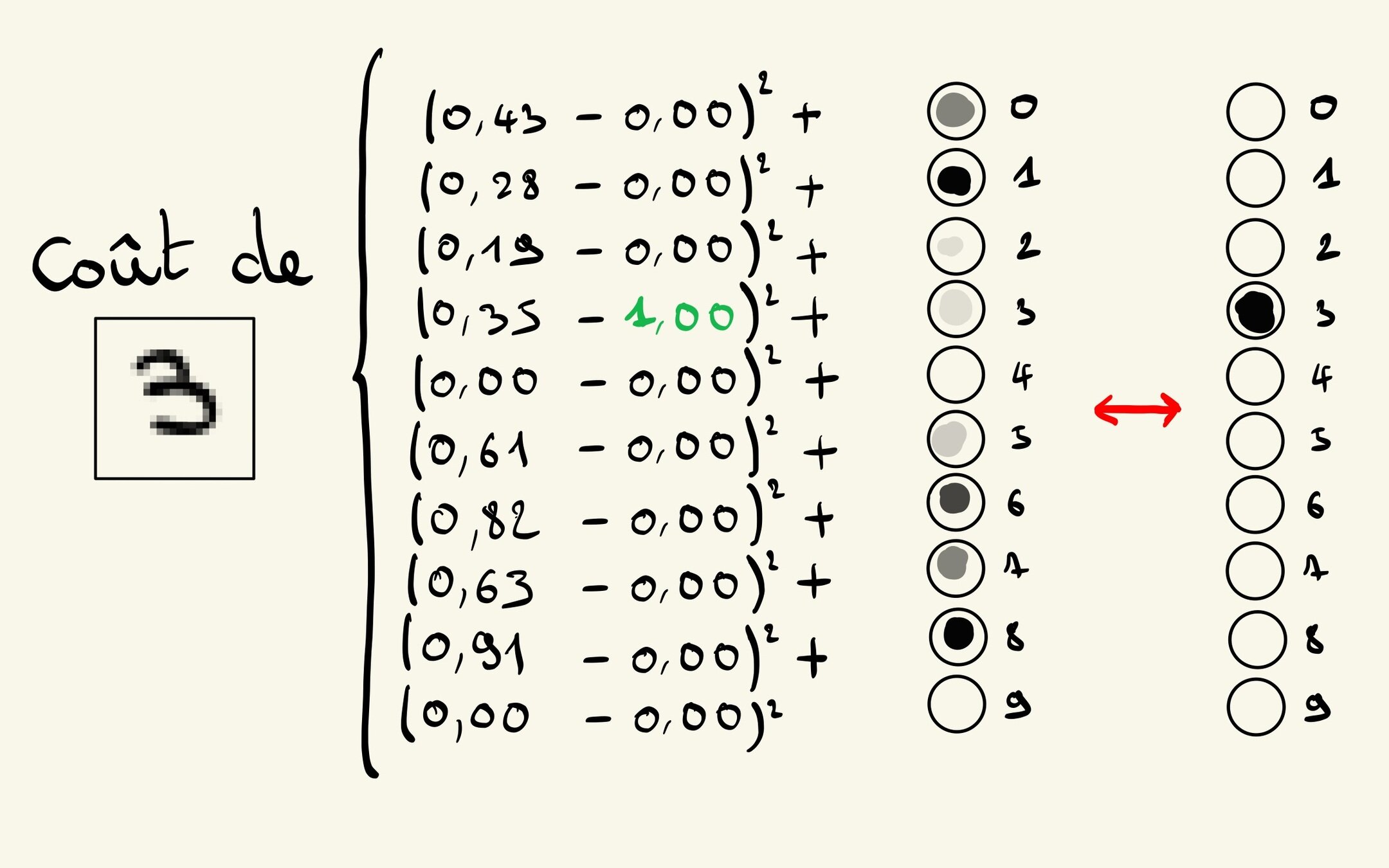

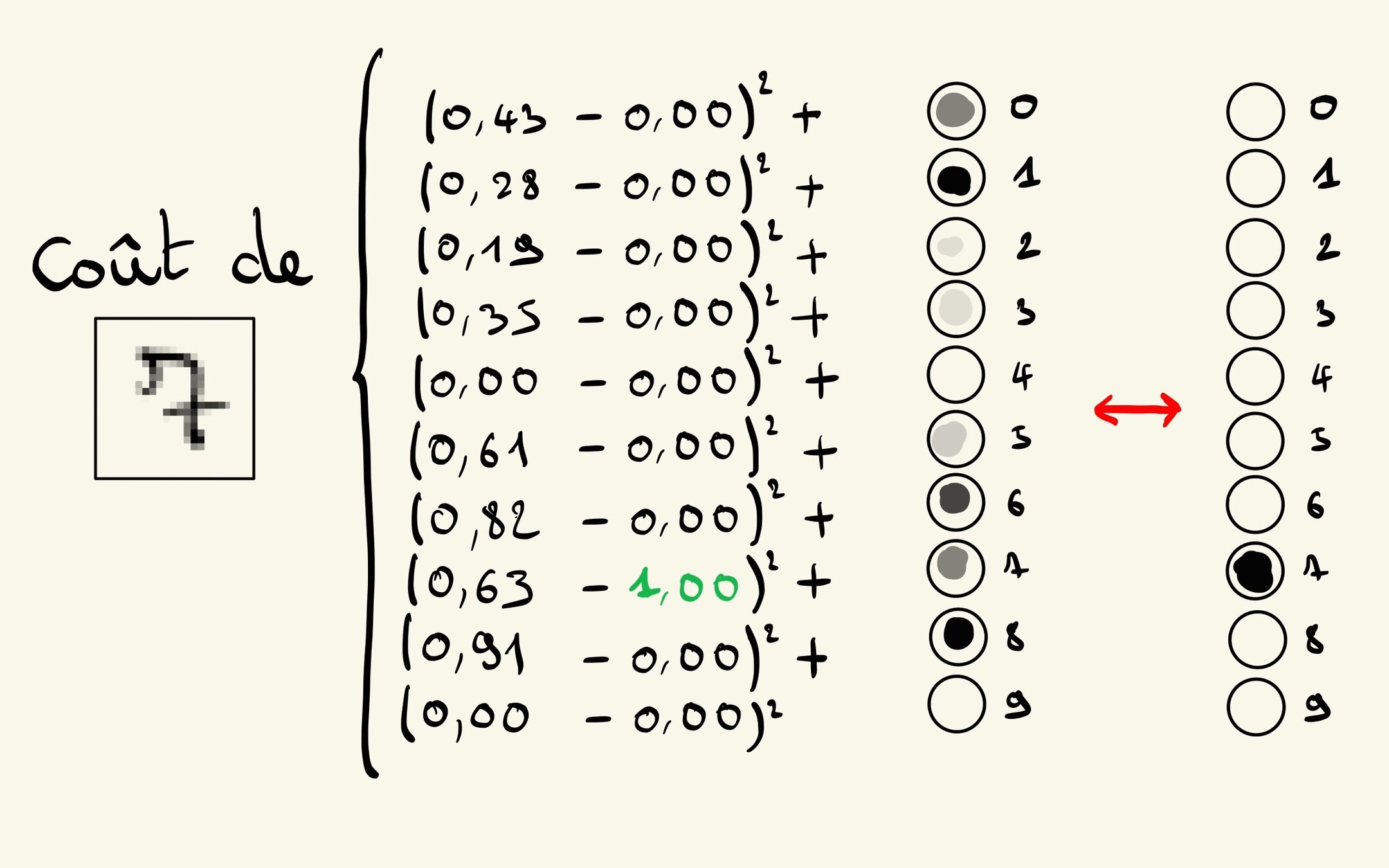

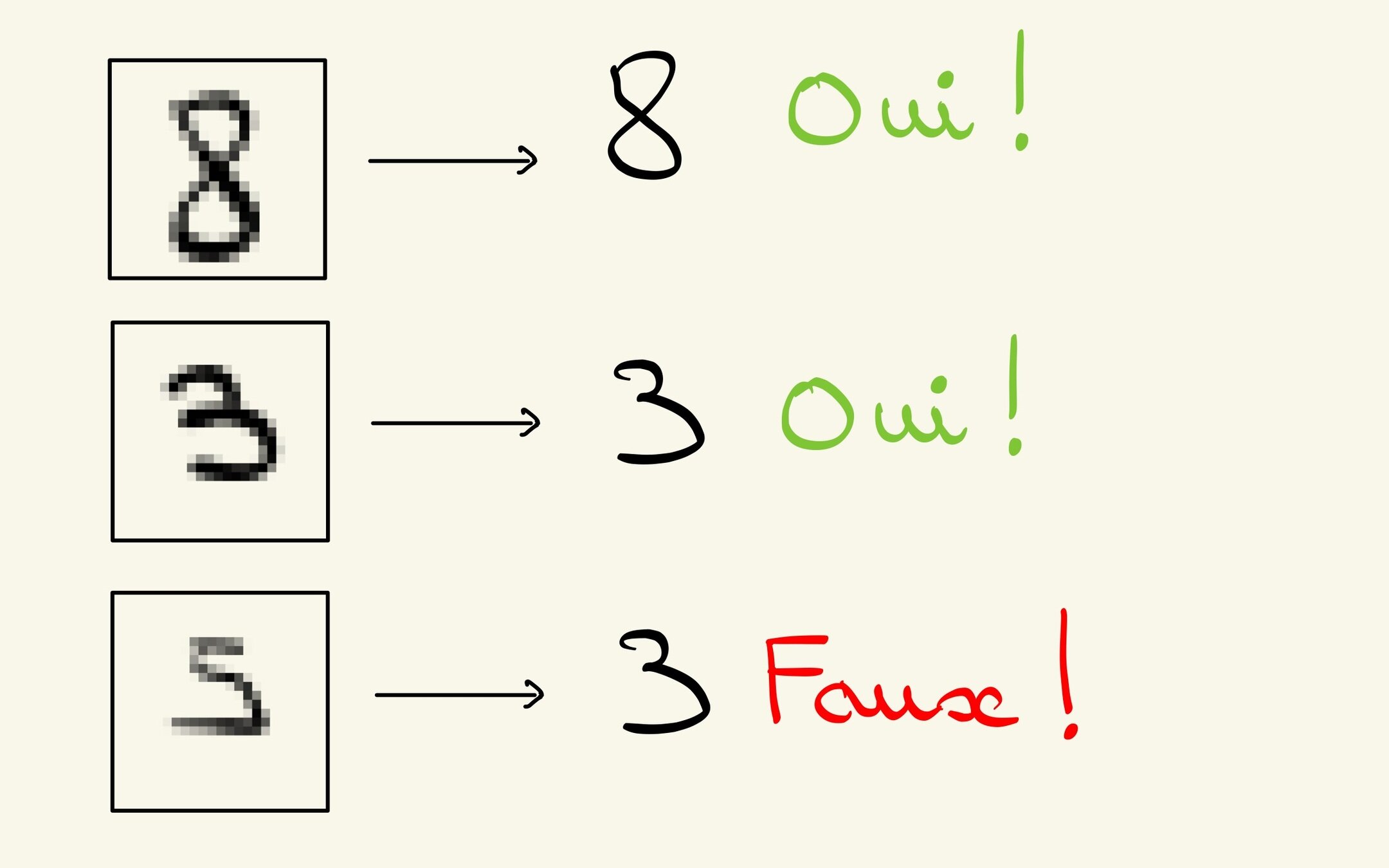

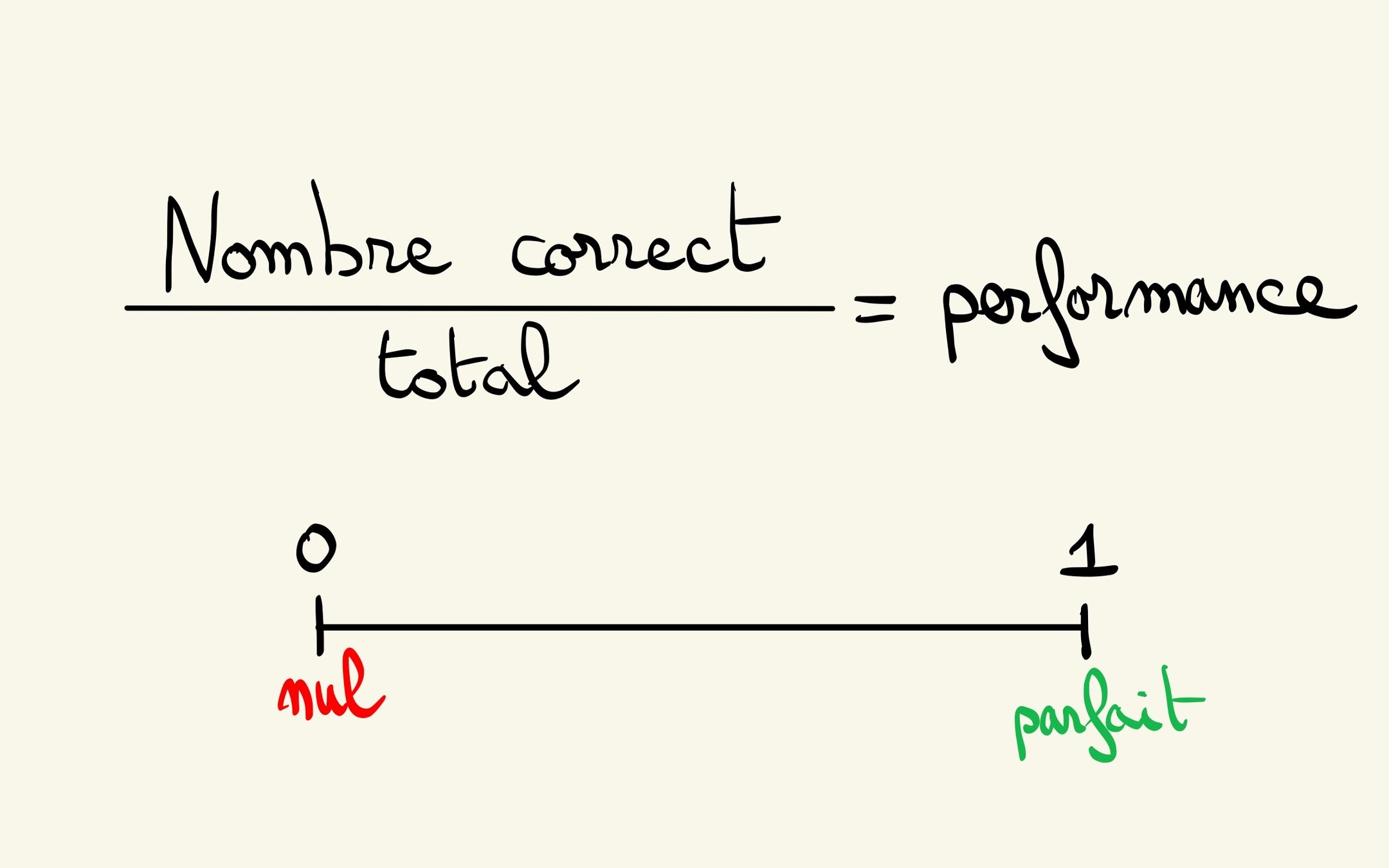

Écart entre les attentes et la réalité

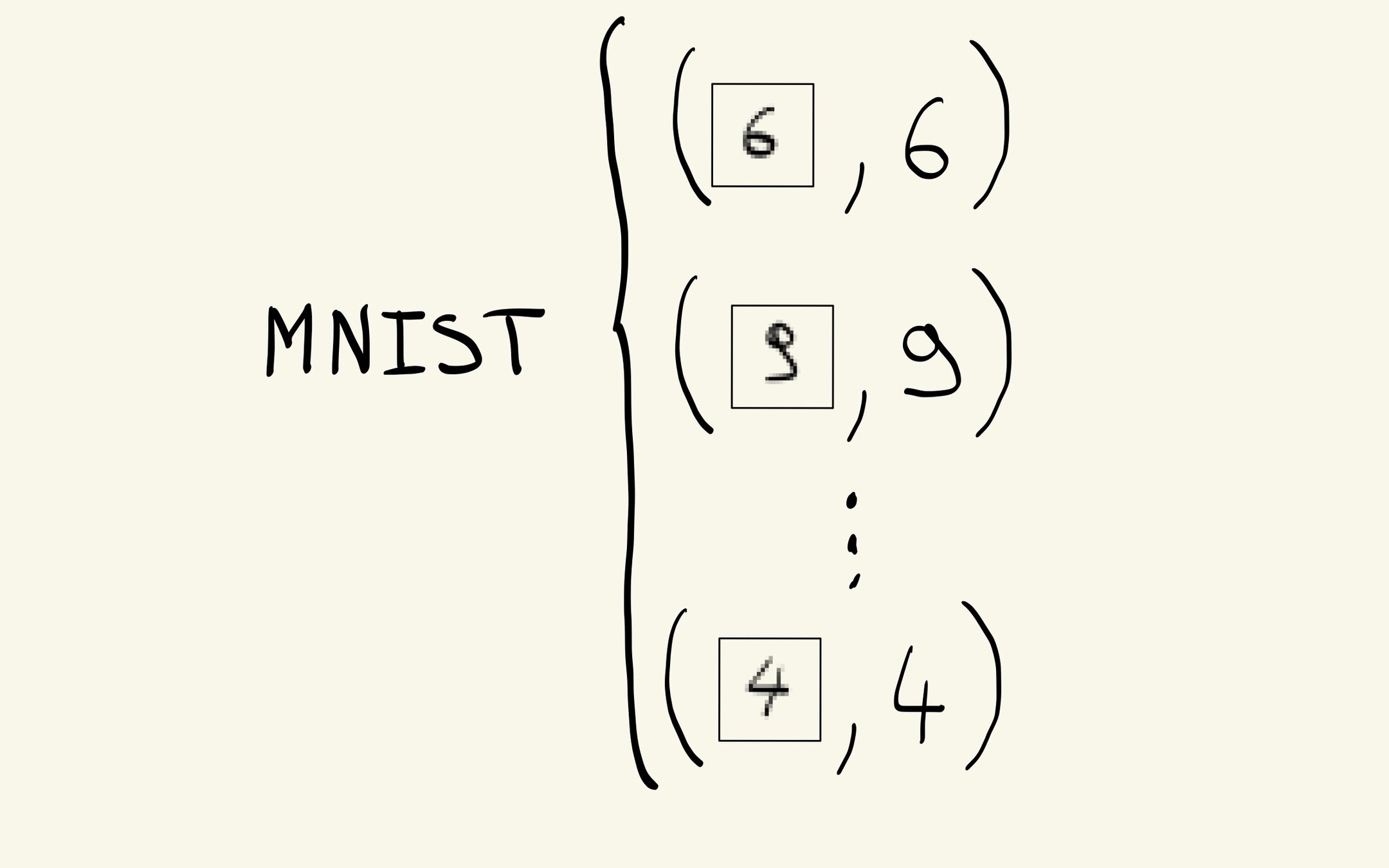

Corpus d'entraînement

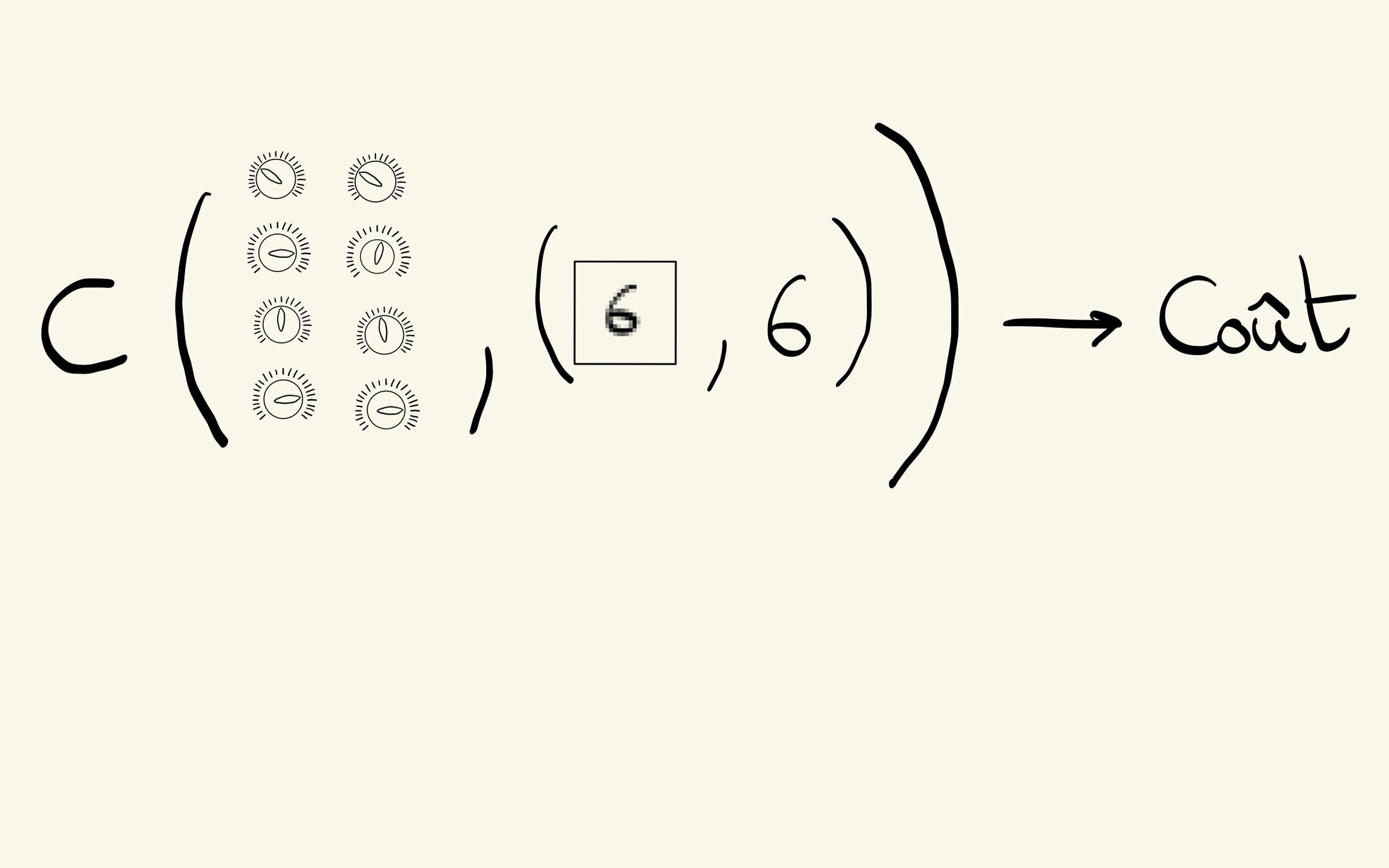

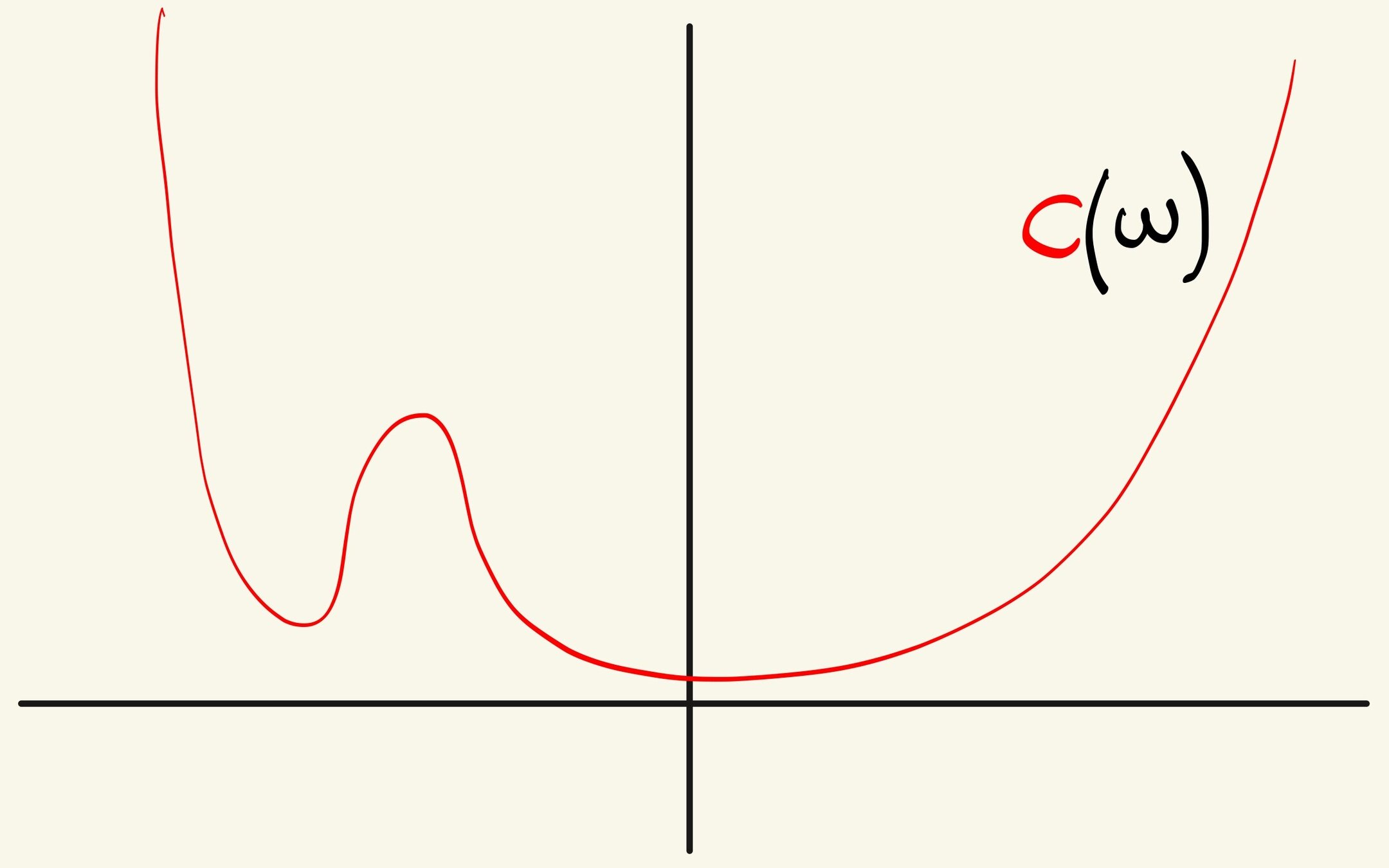

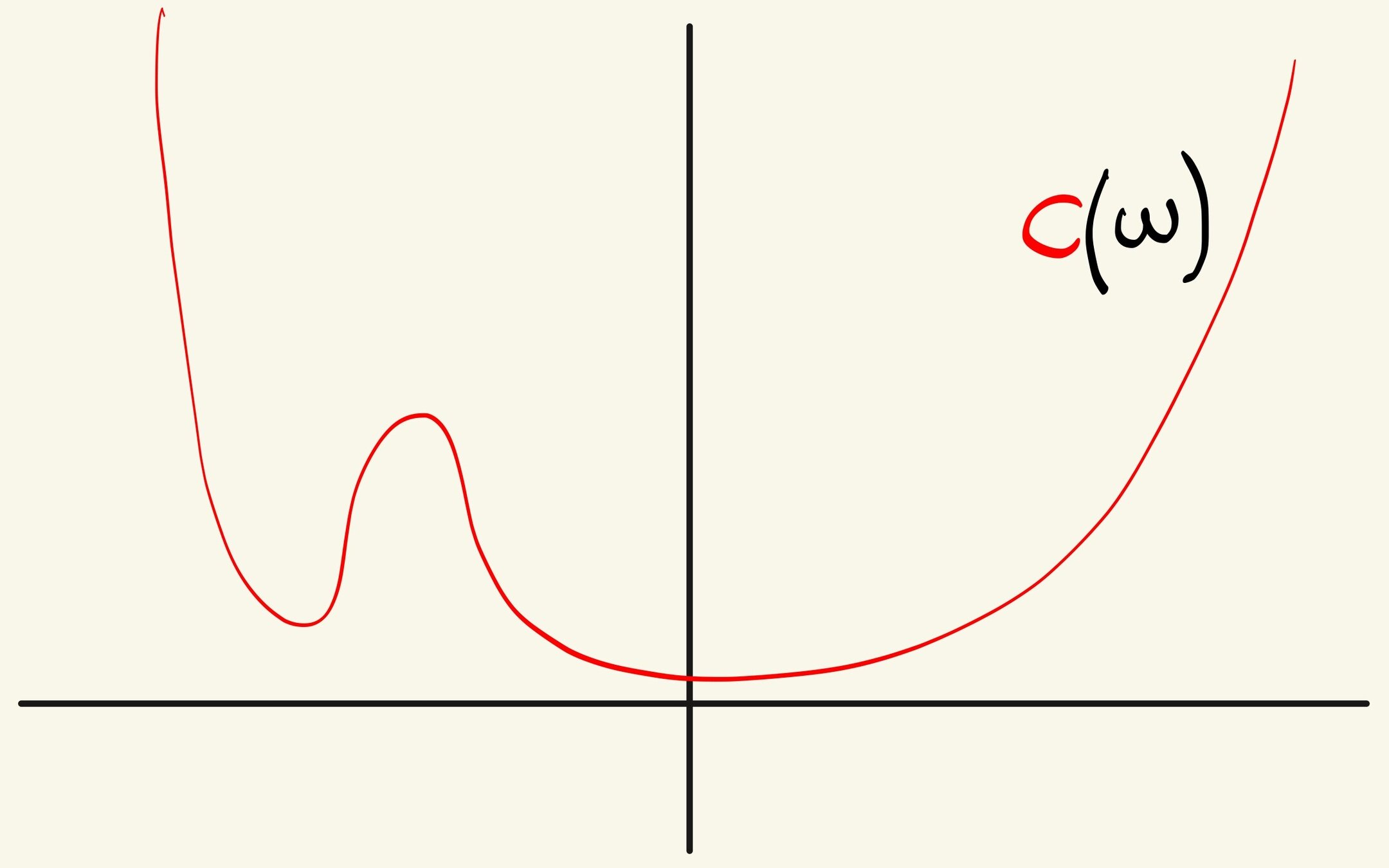

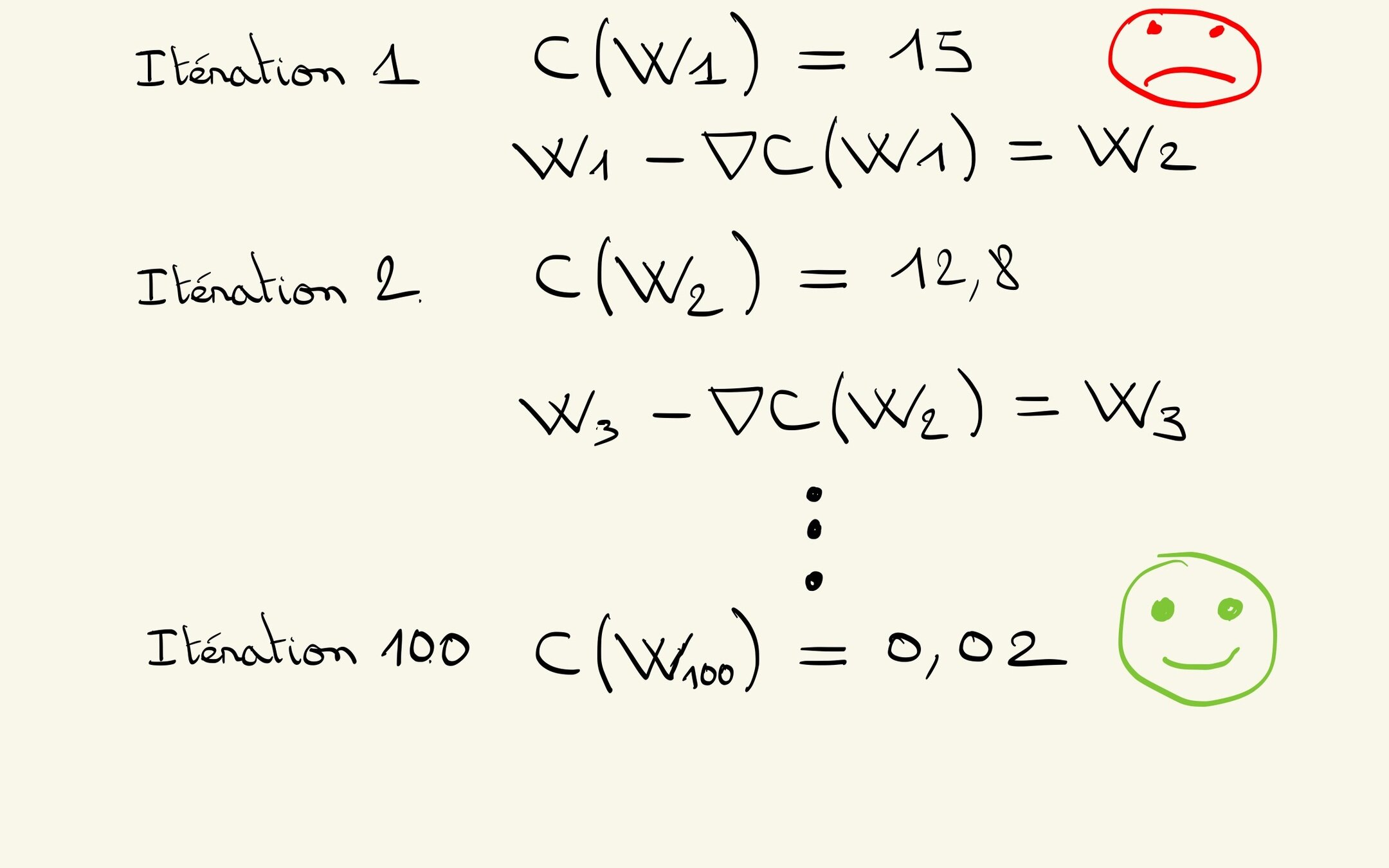

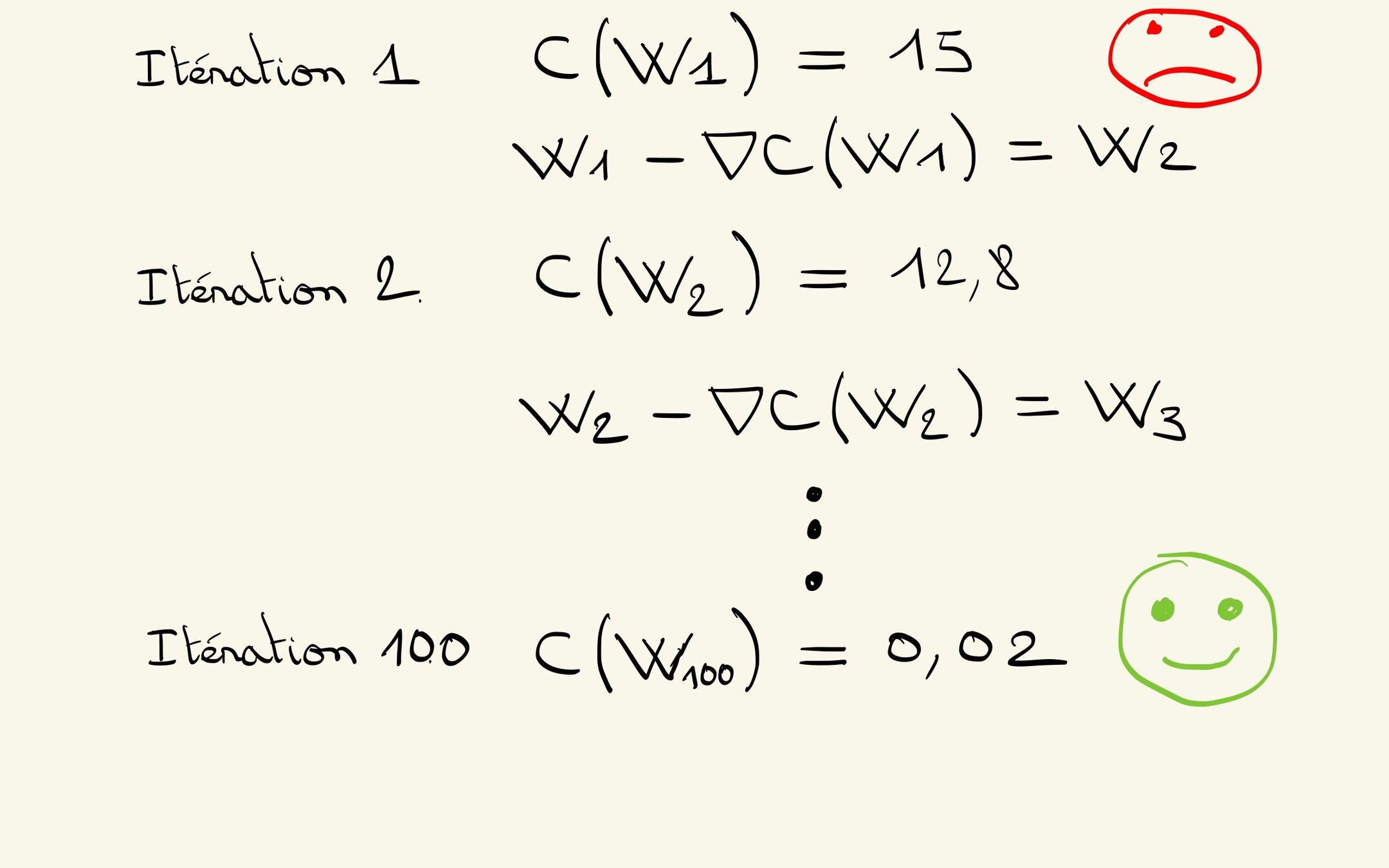

Fonction de Coût

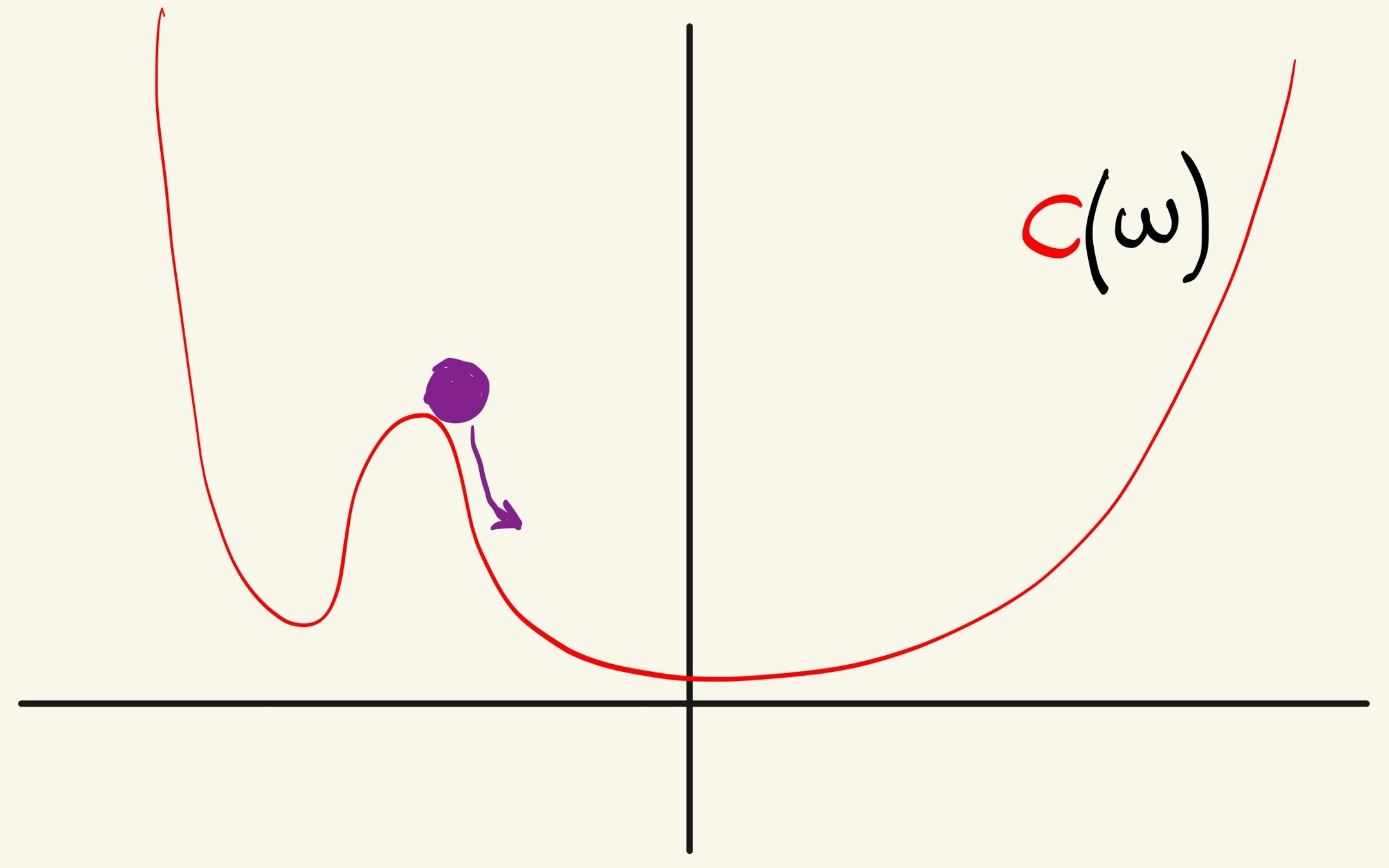

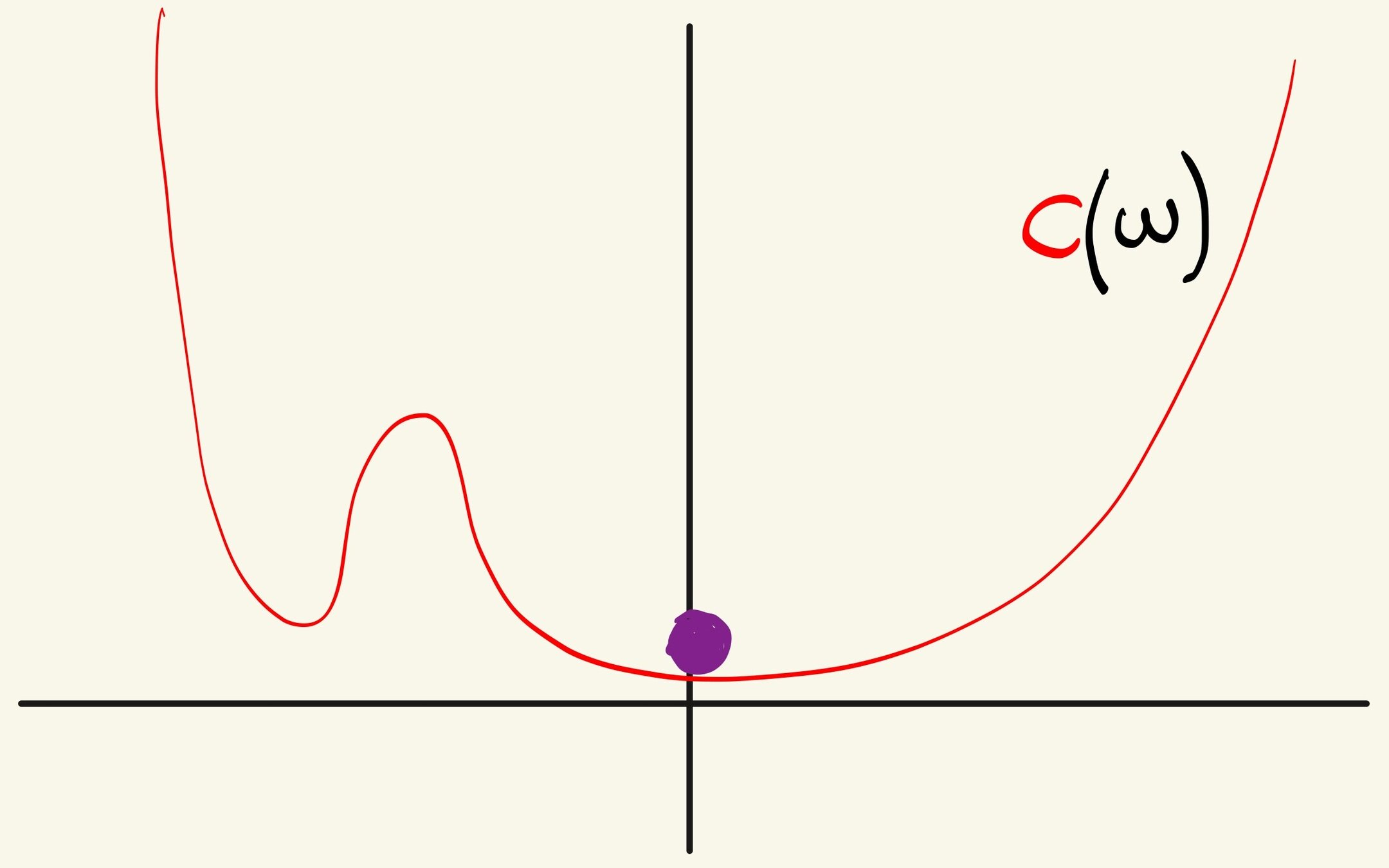

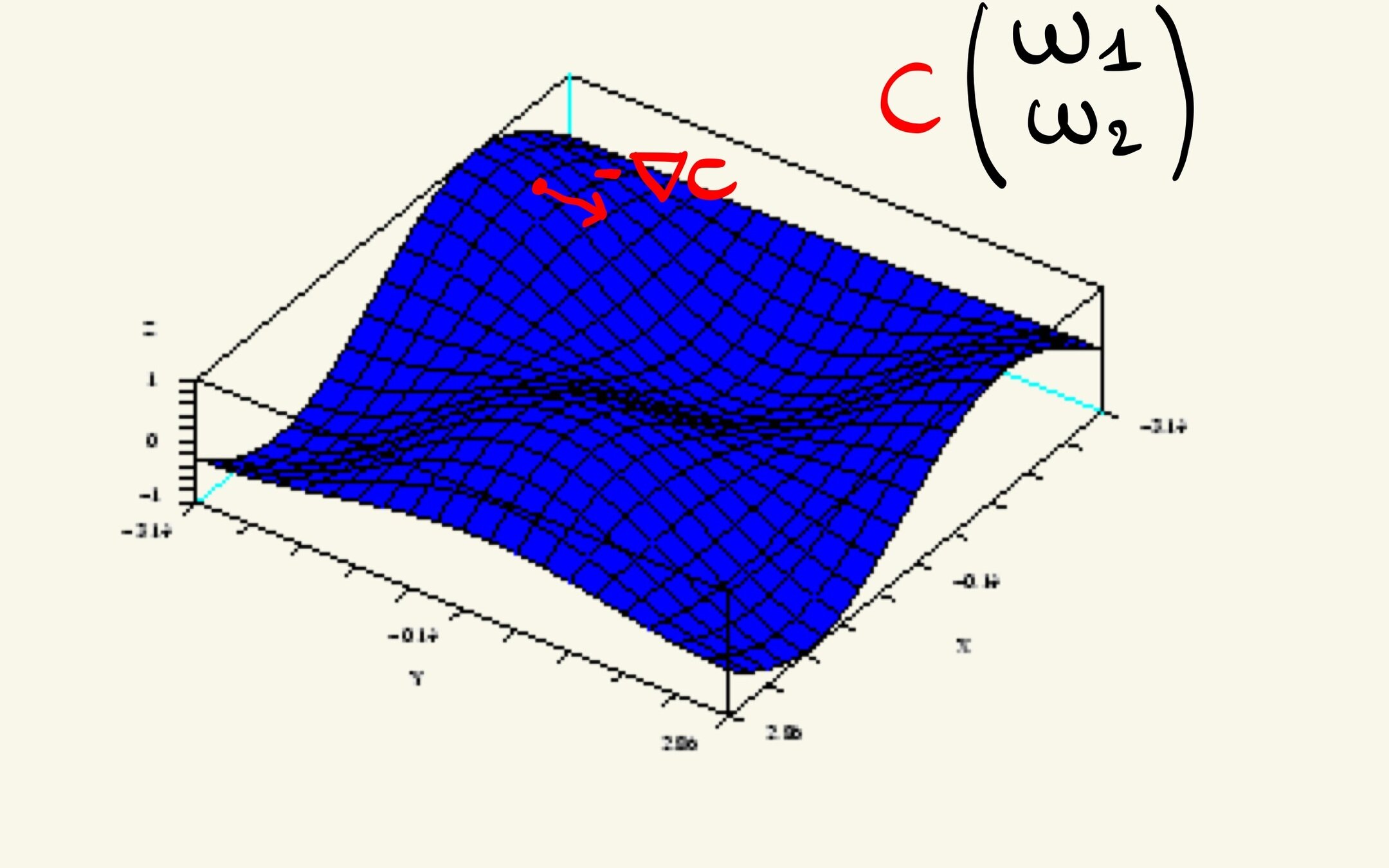

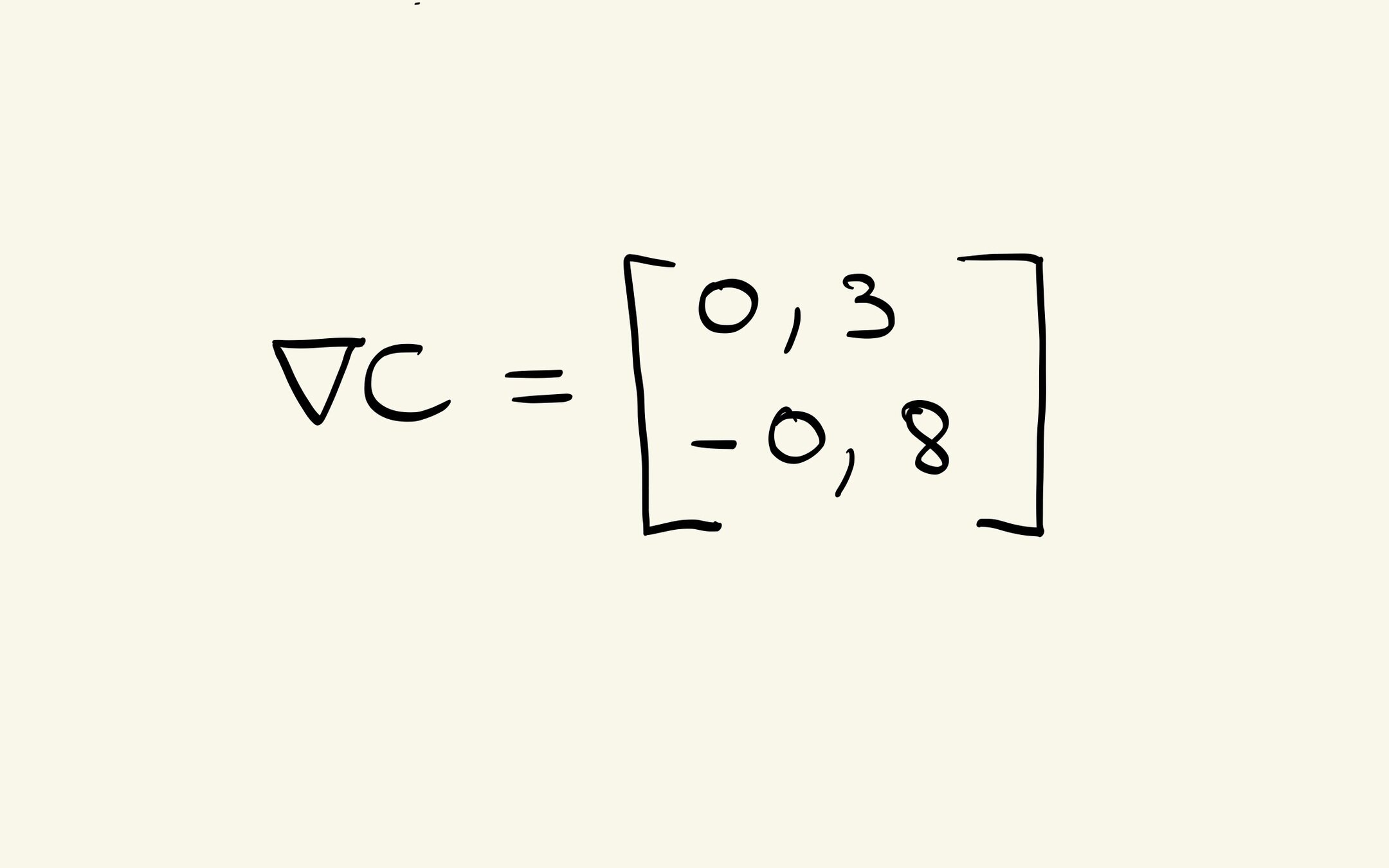

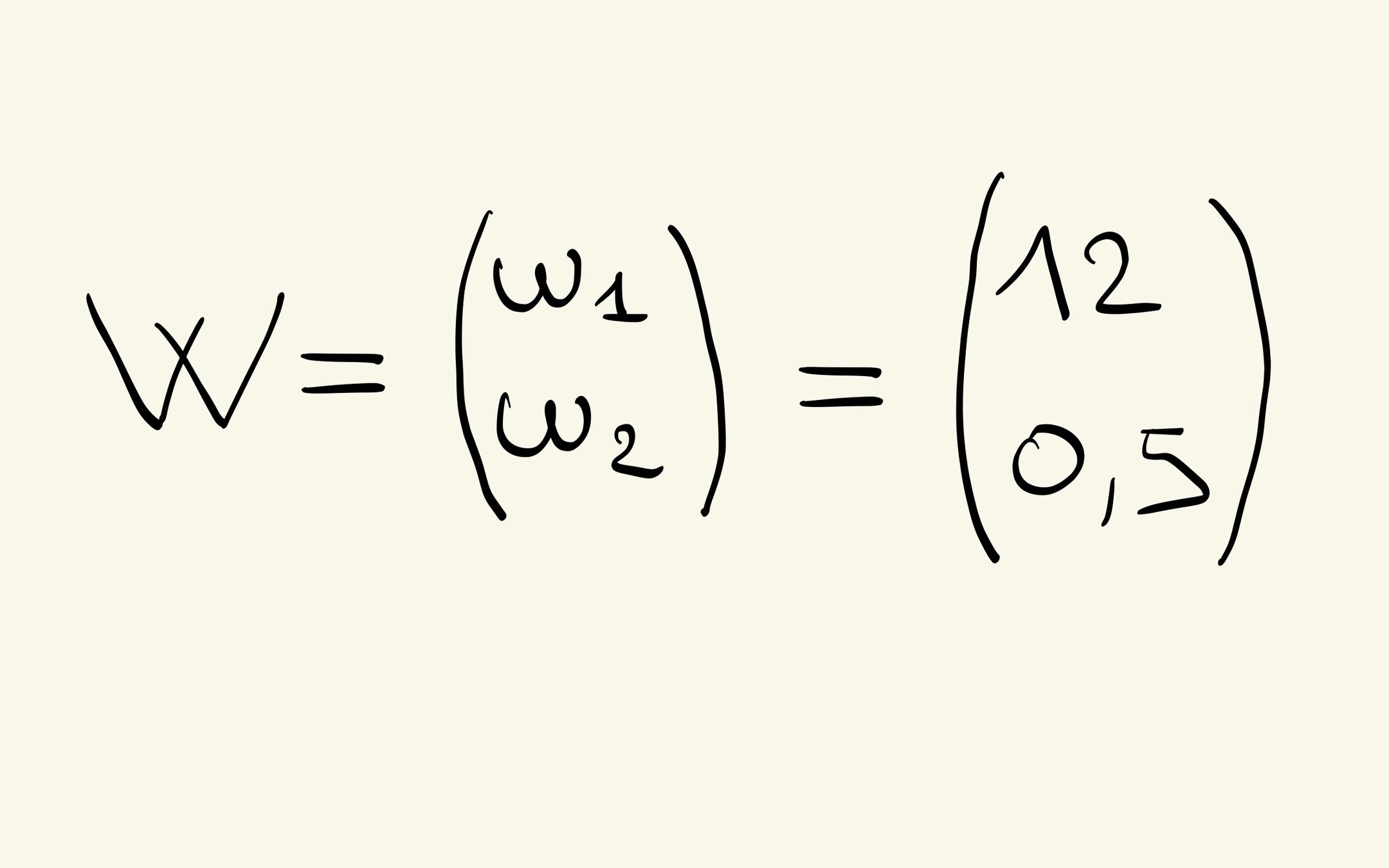

Minimiser la fonction de Coût

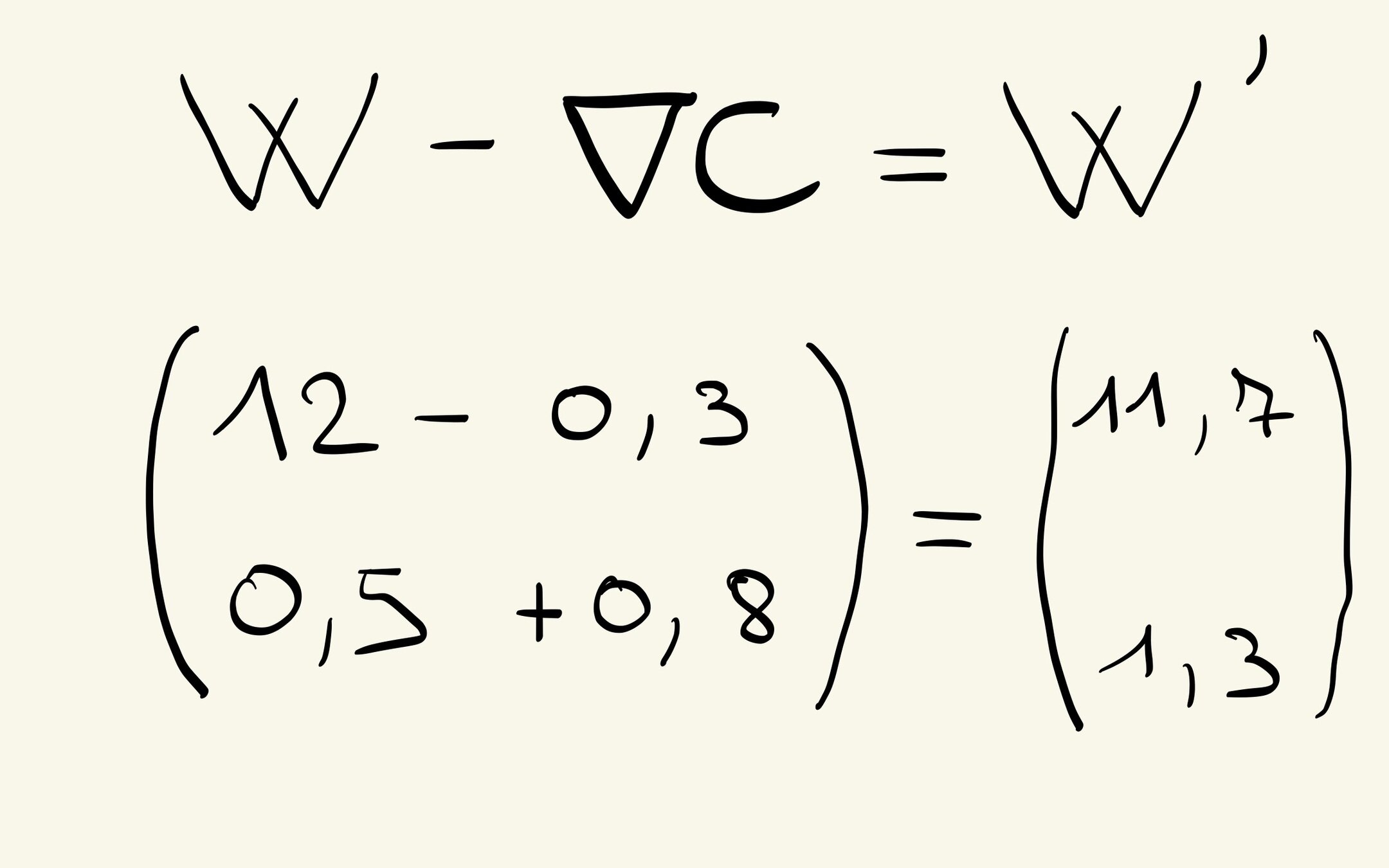

Pour 1 poids

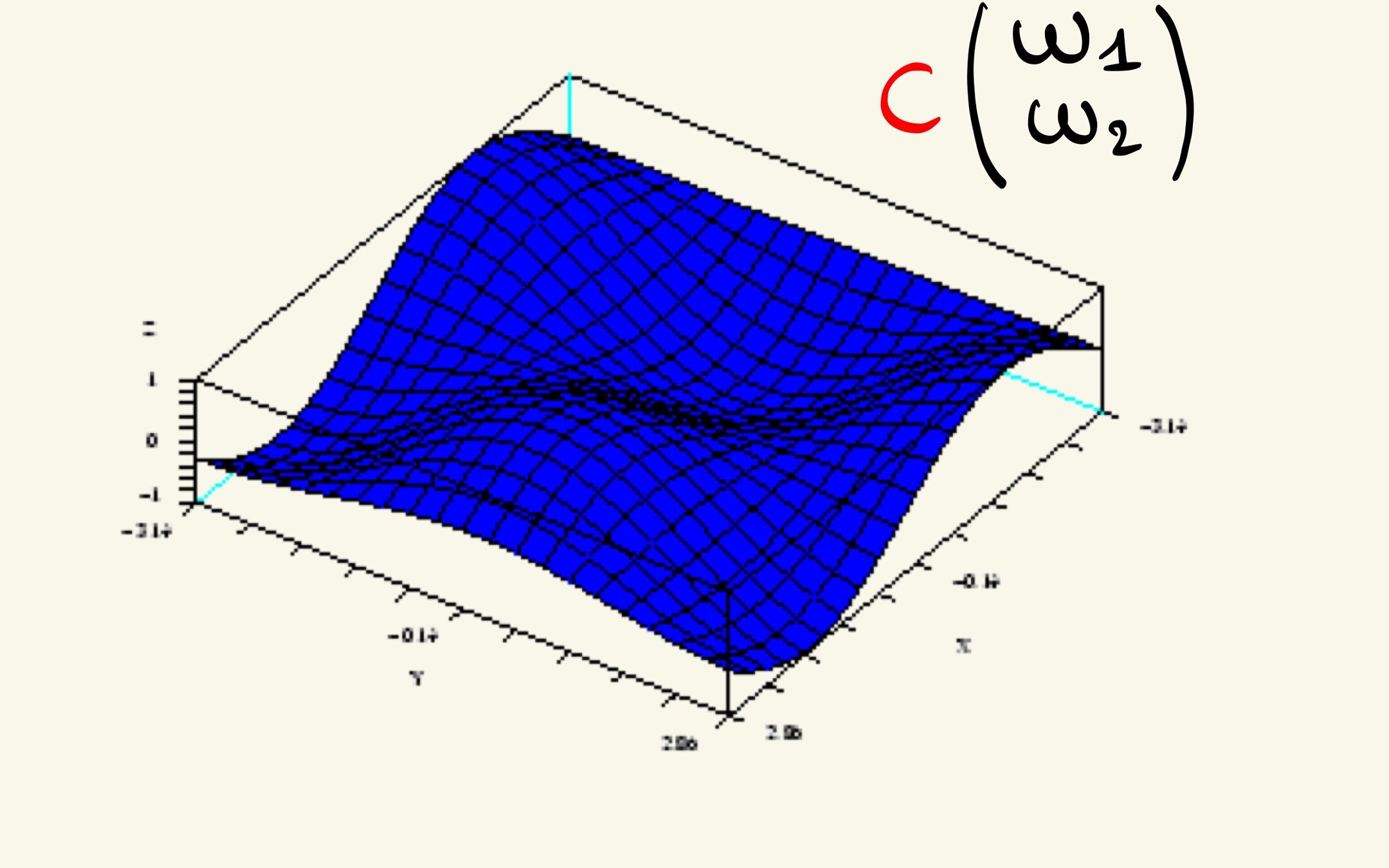

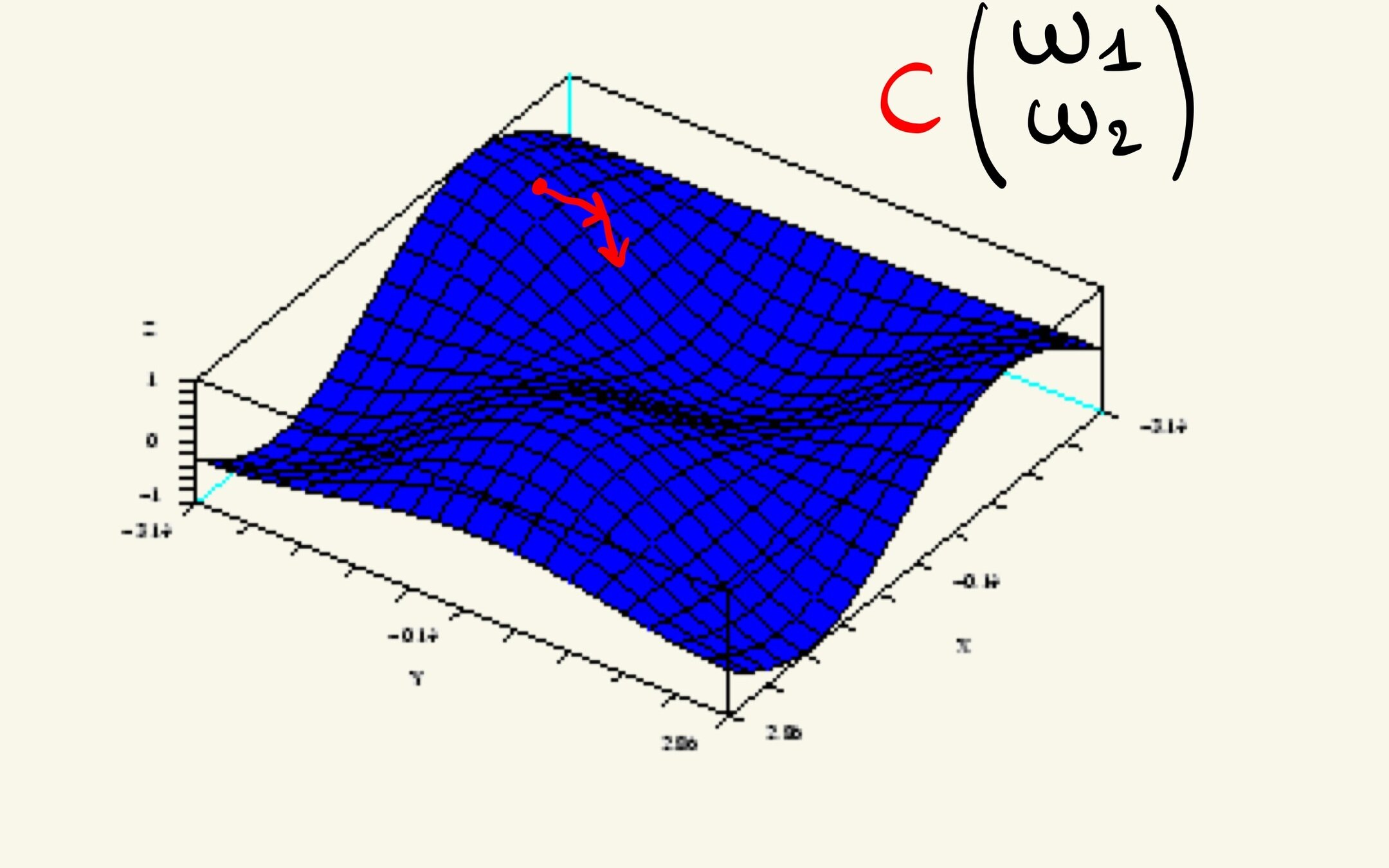

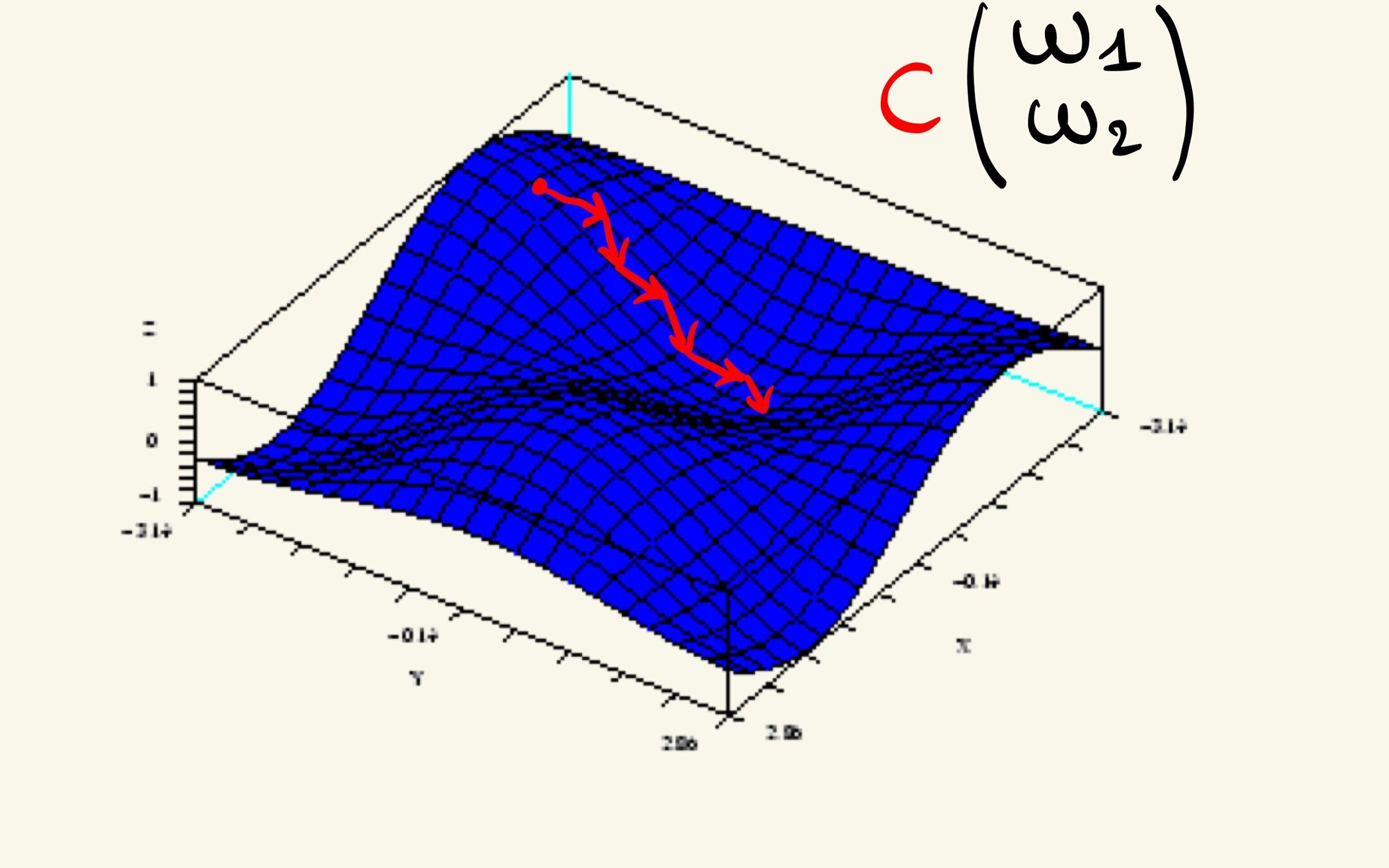

Pour 2 poids

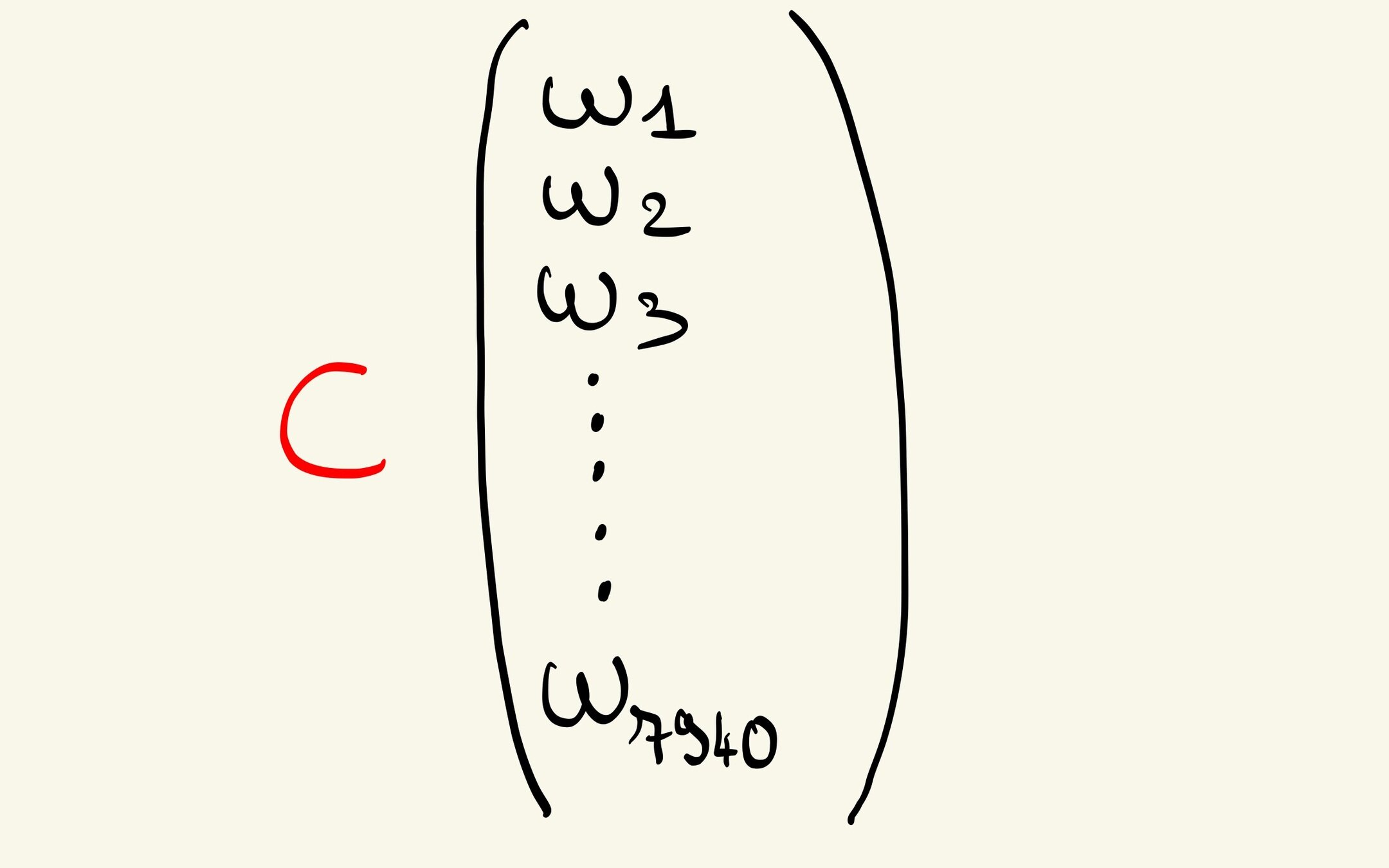

On généralise pour le réseau entier

Feed Forward

Natural Language Processing

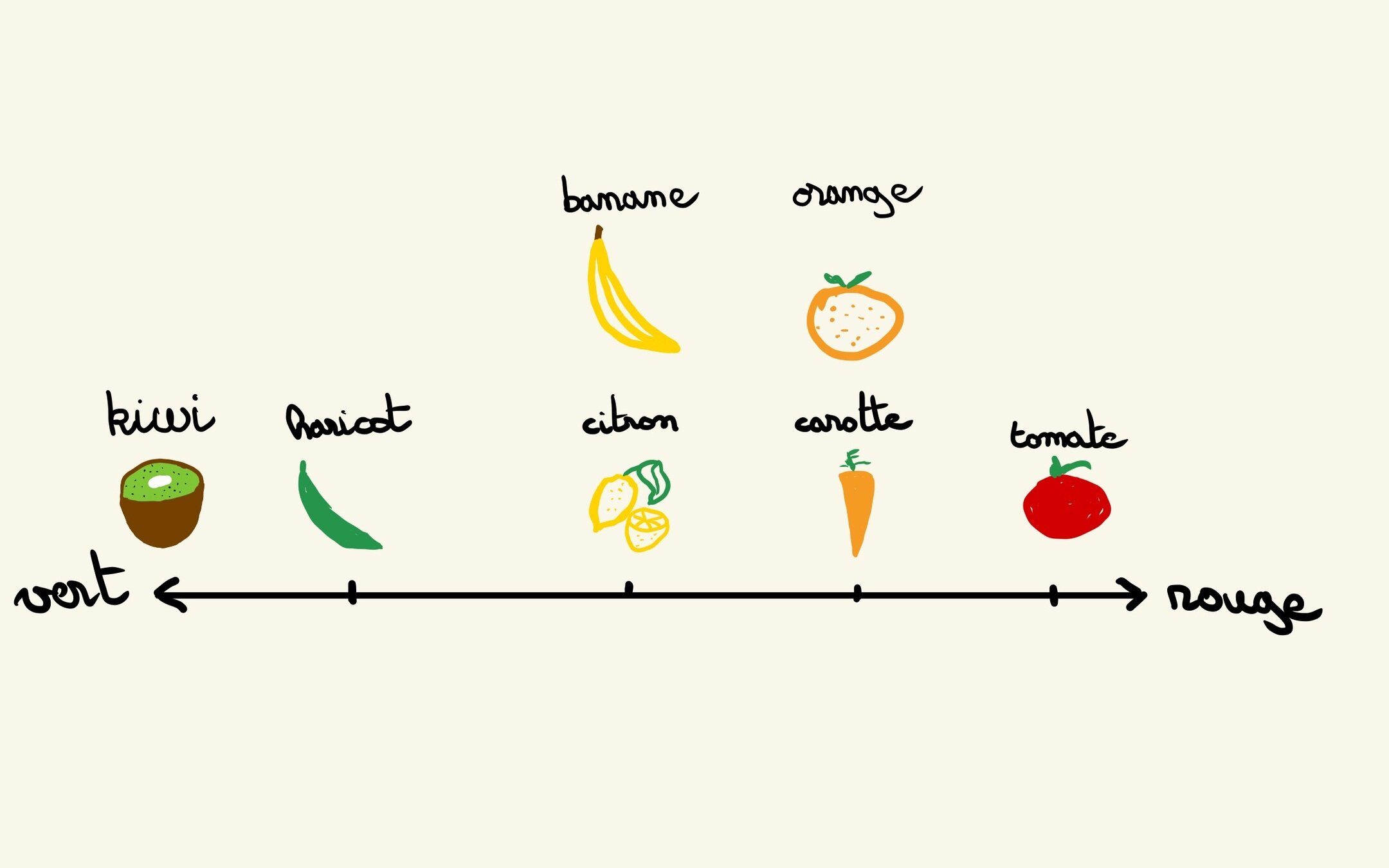

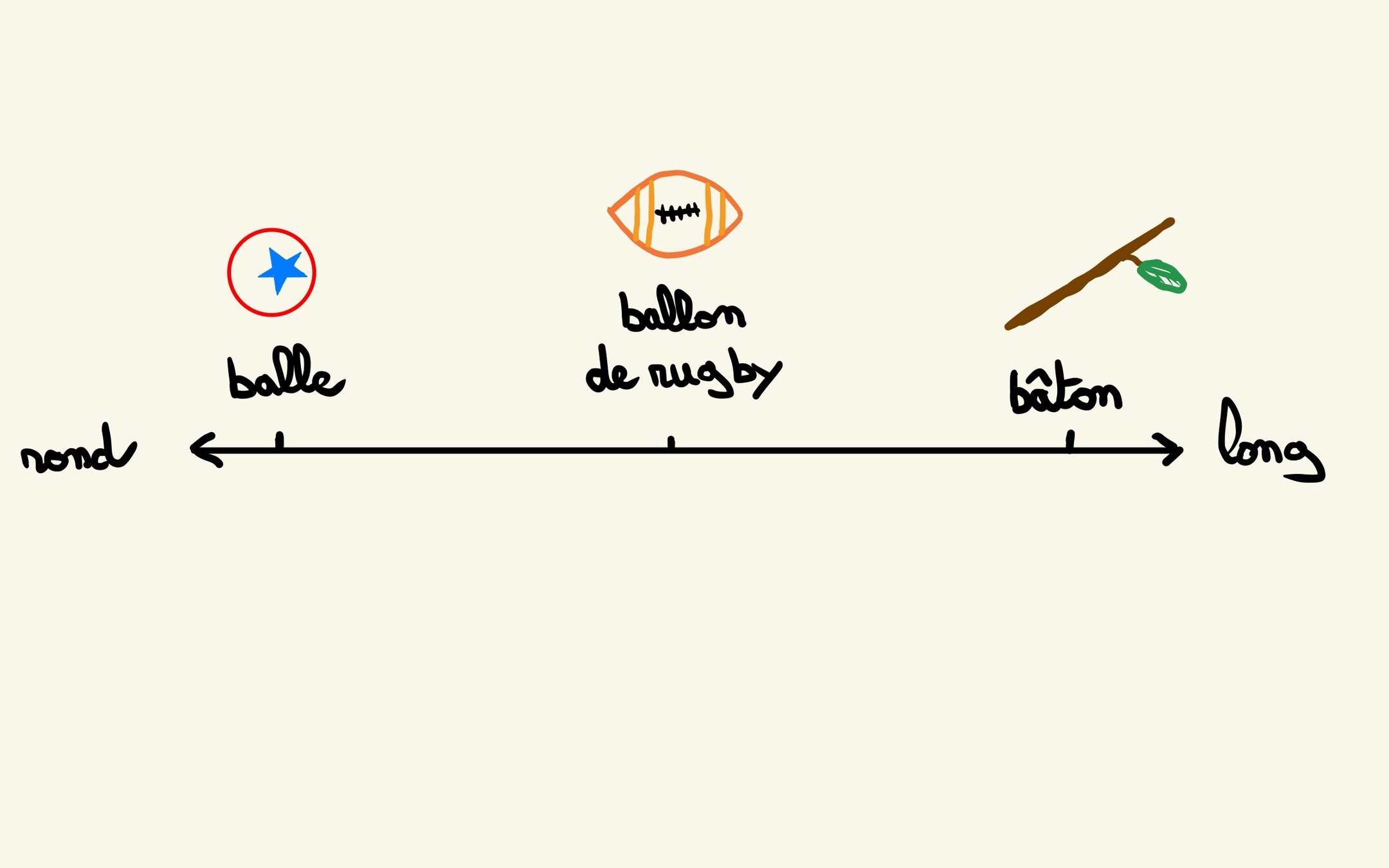

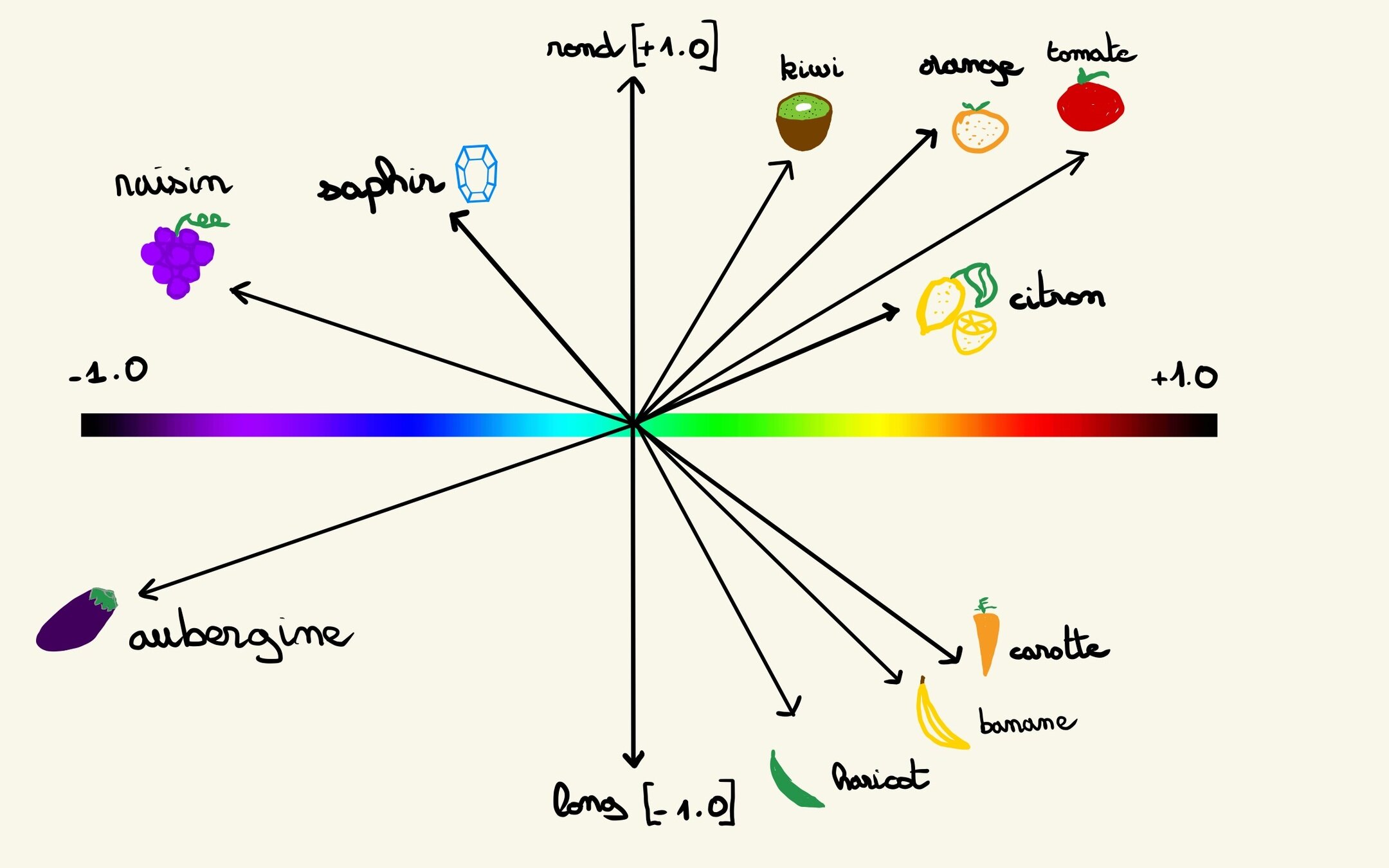

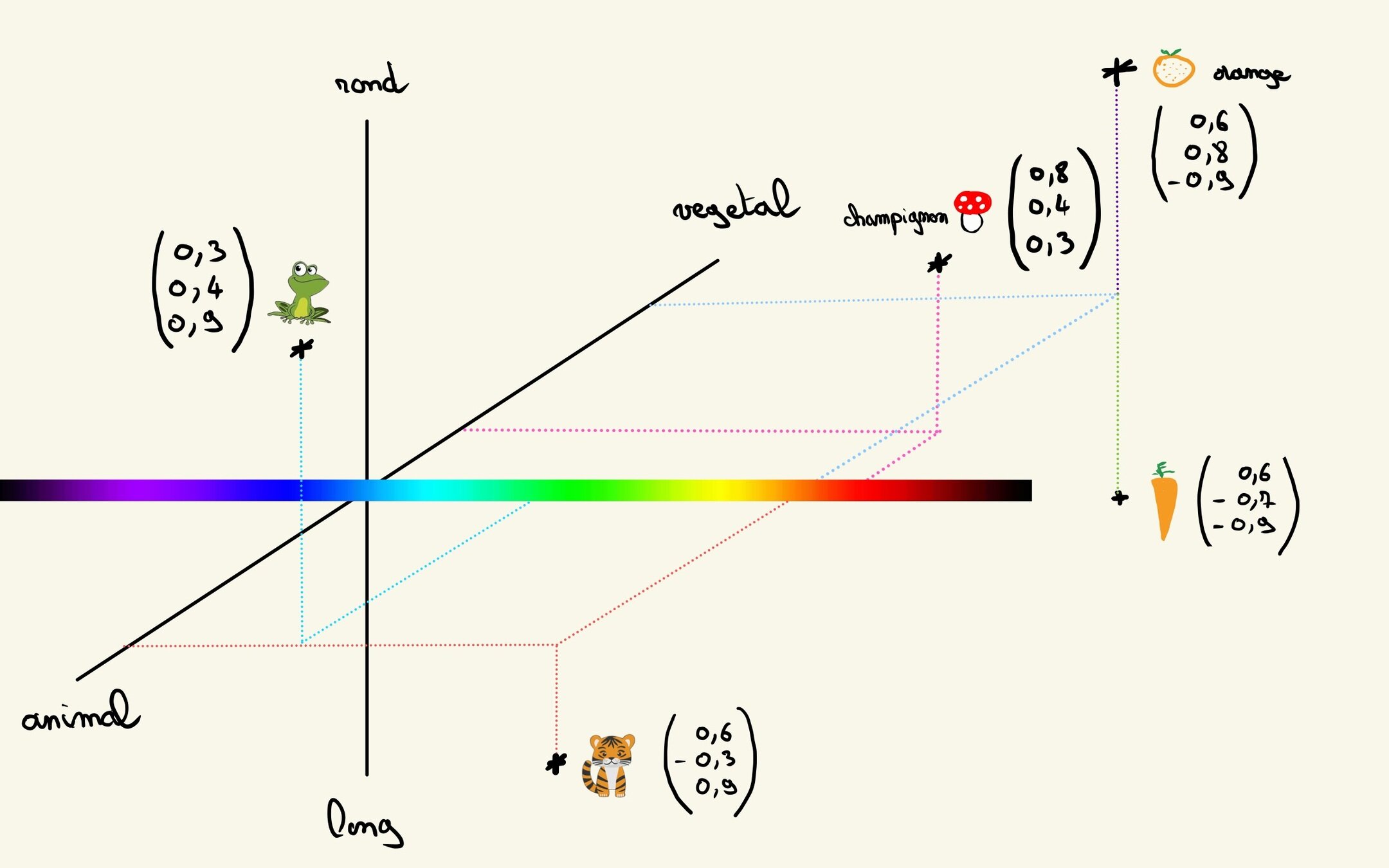

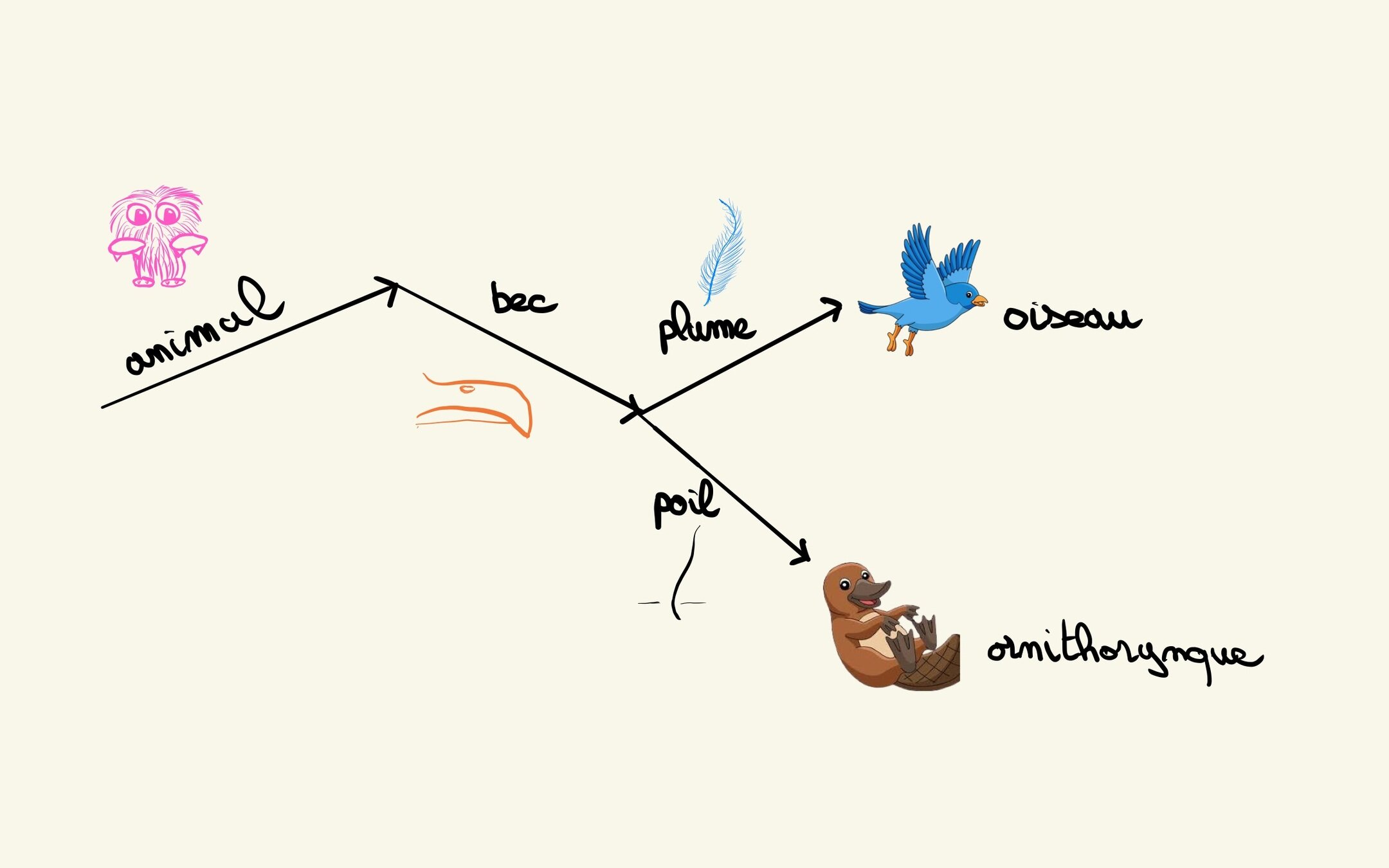

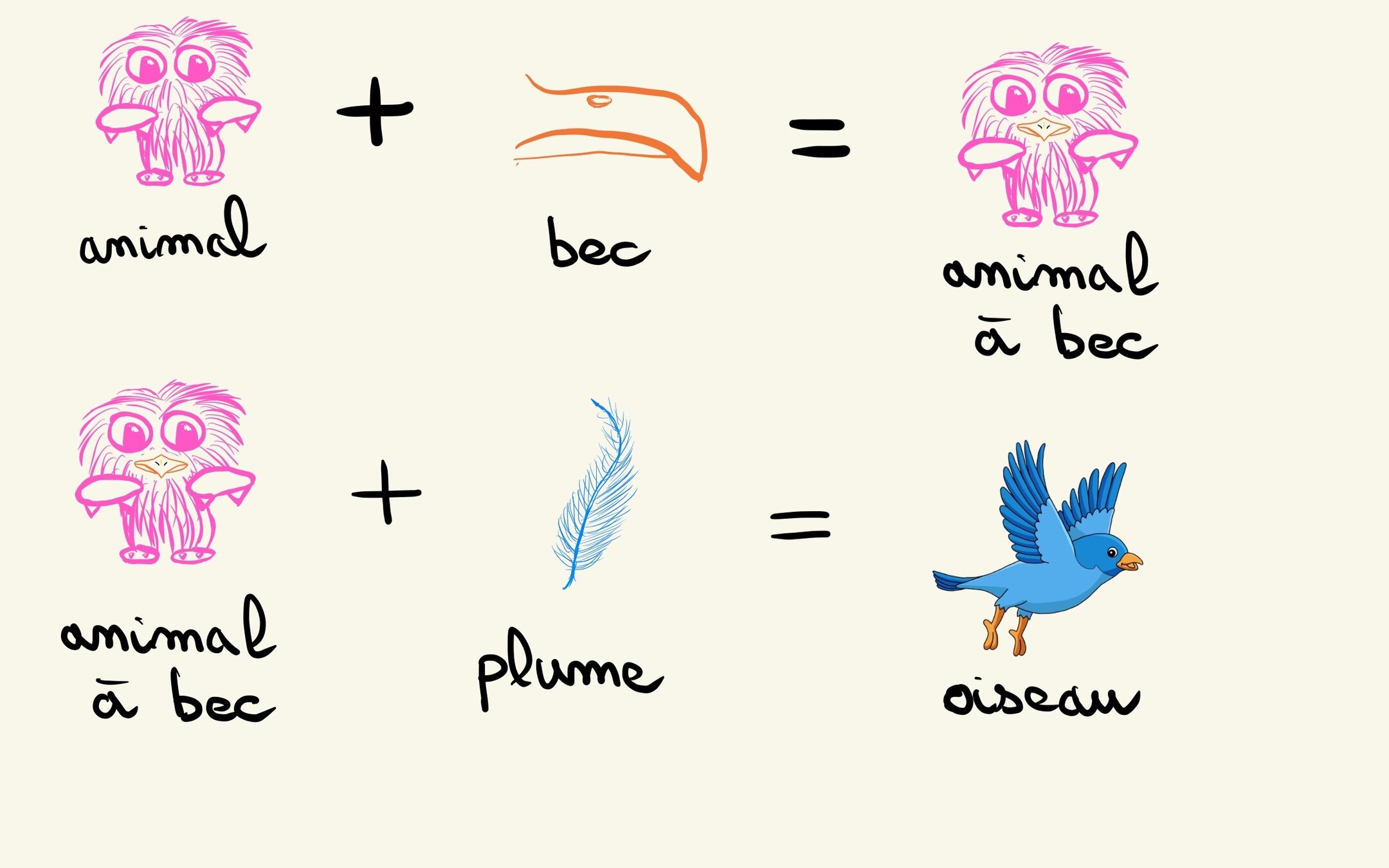

Encoder les concepts

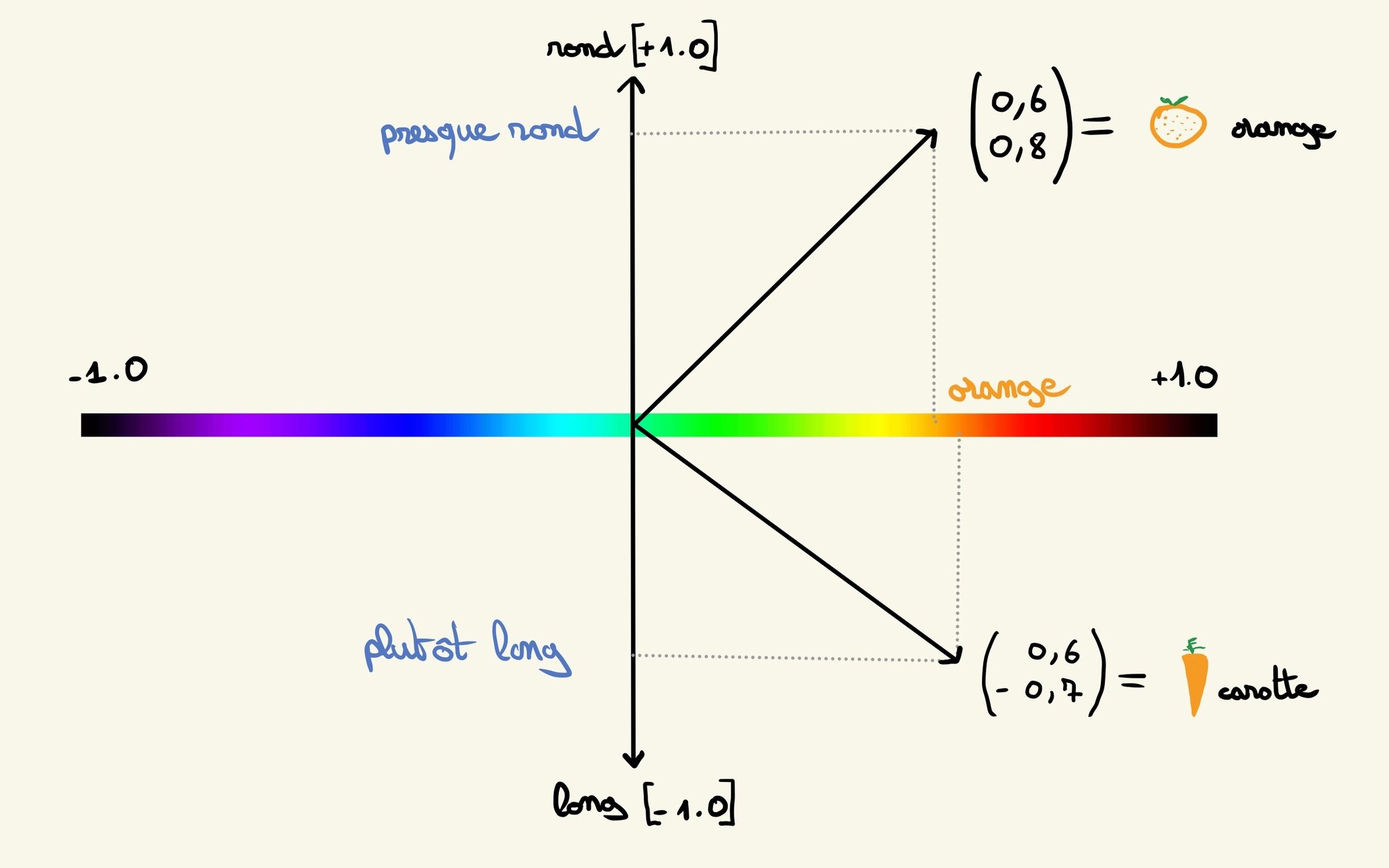

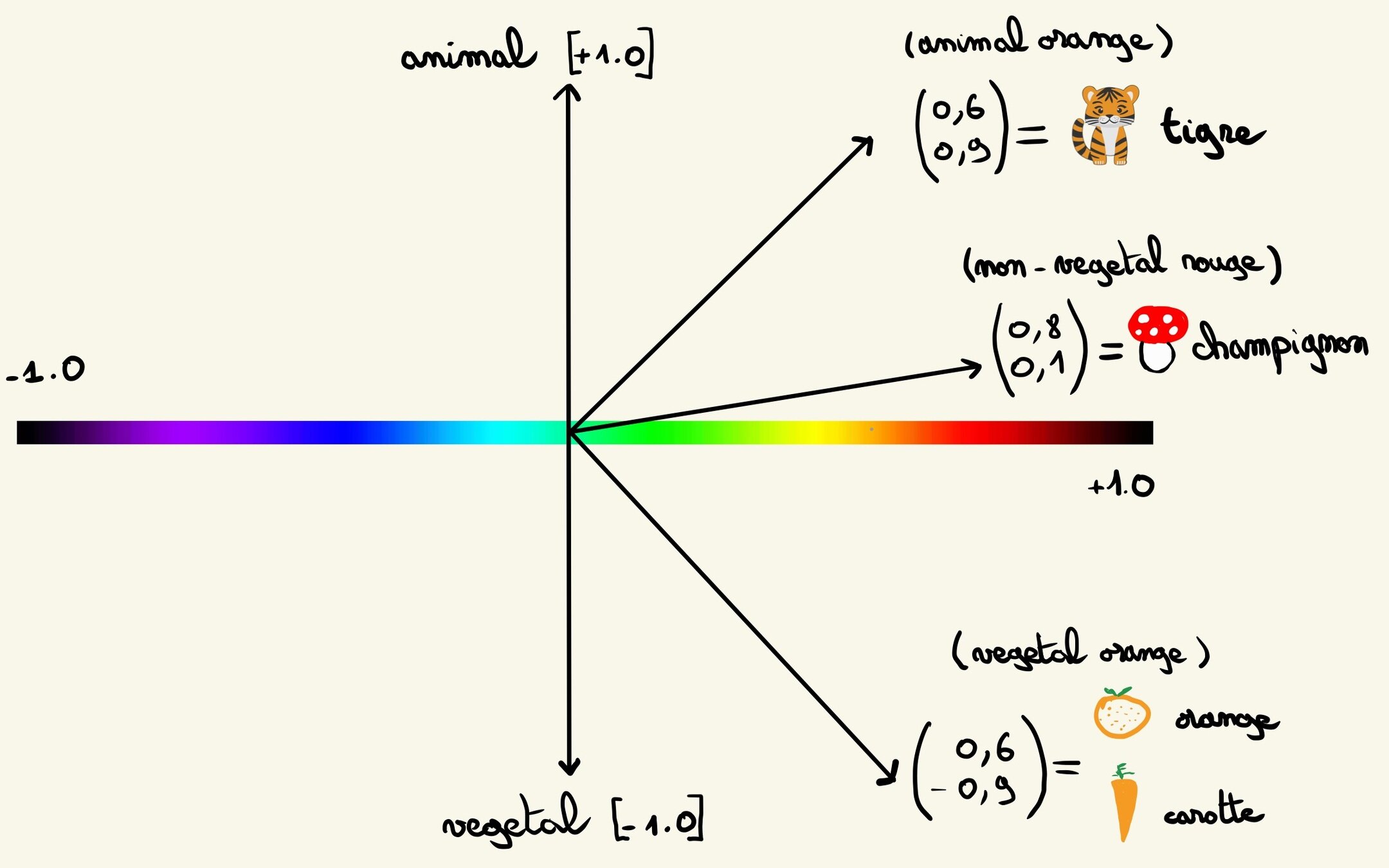

Comparer les choses par rapport aux concepts

Se balader dans l'espace des concepts

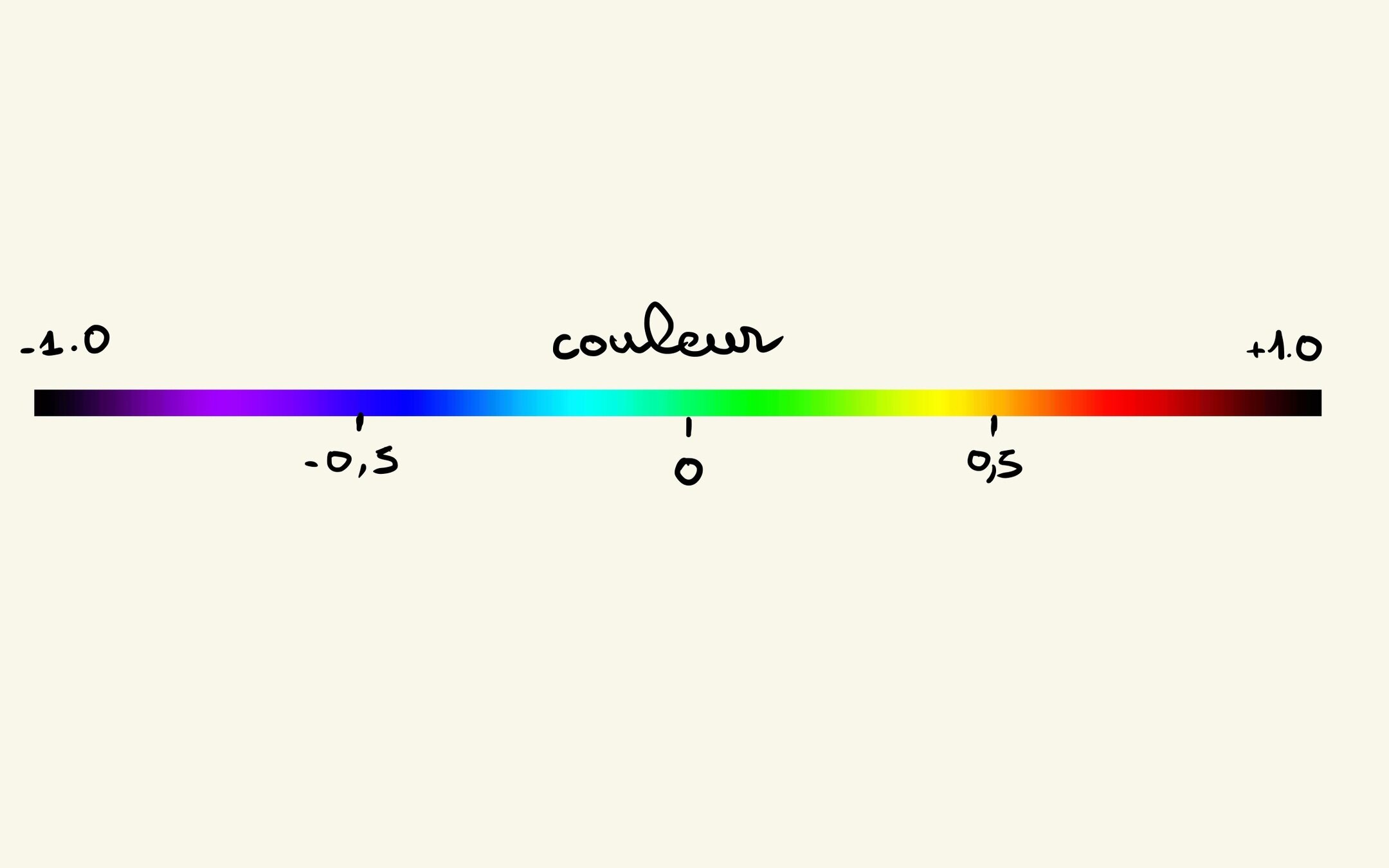

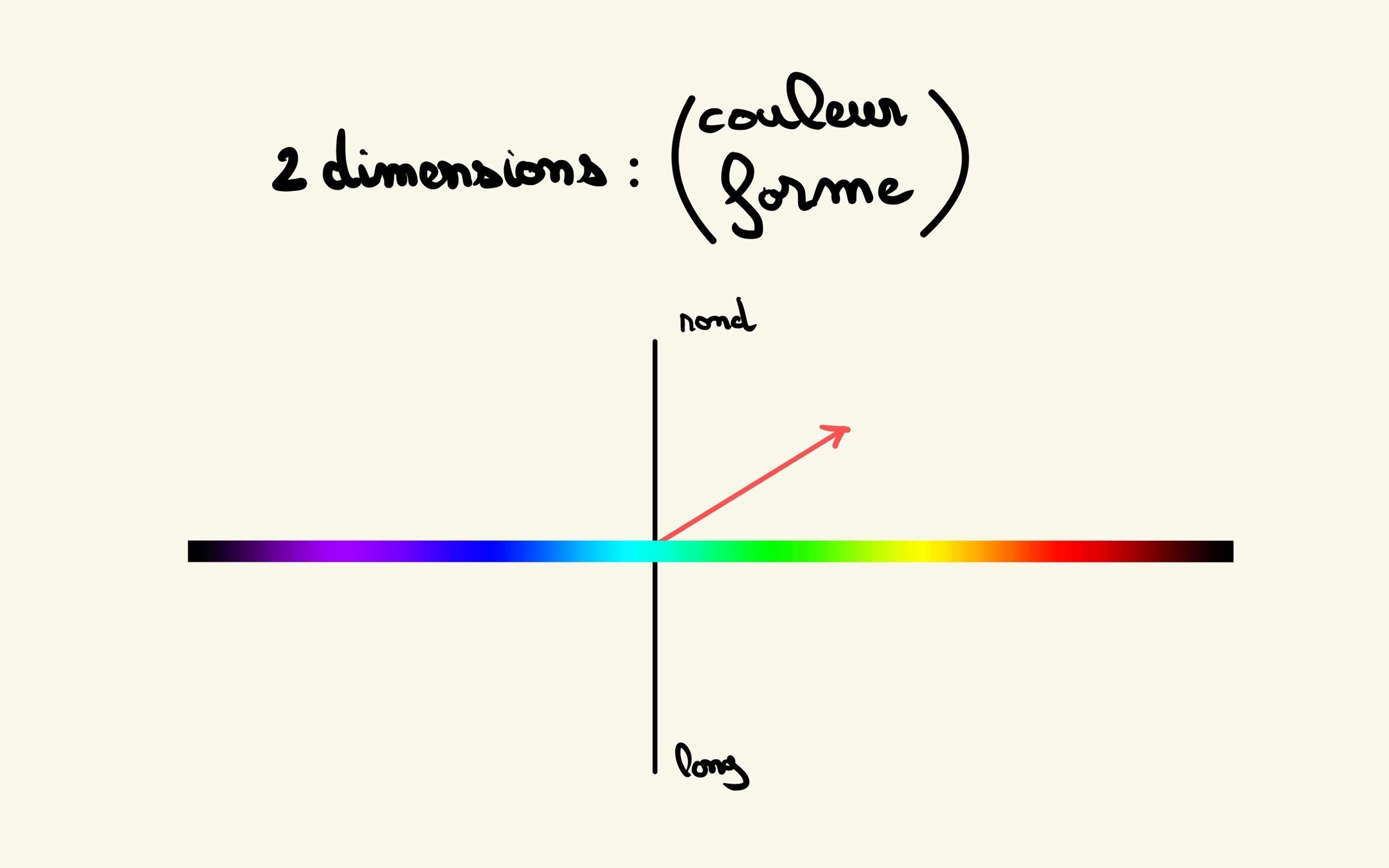

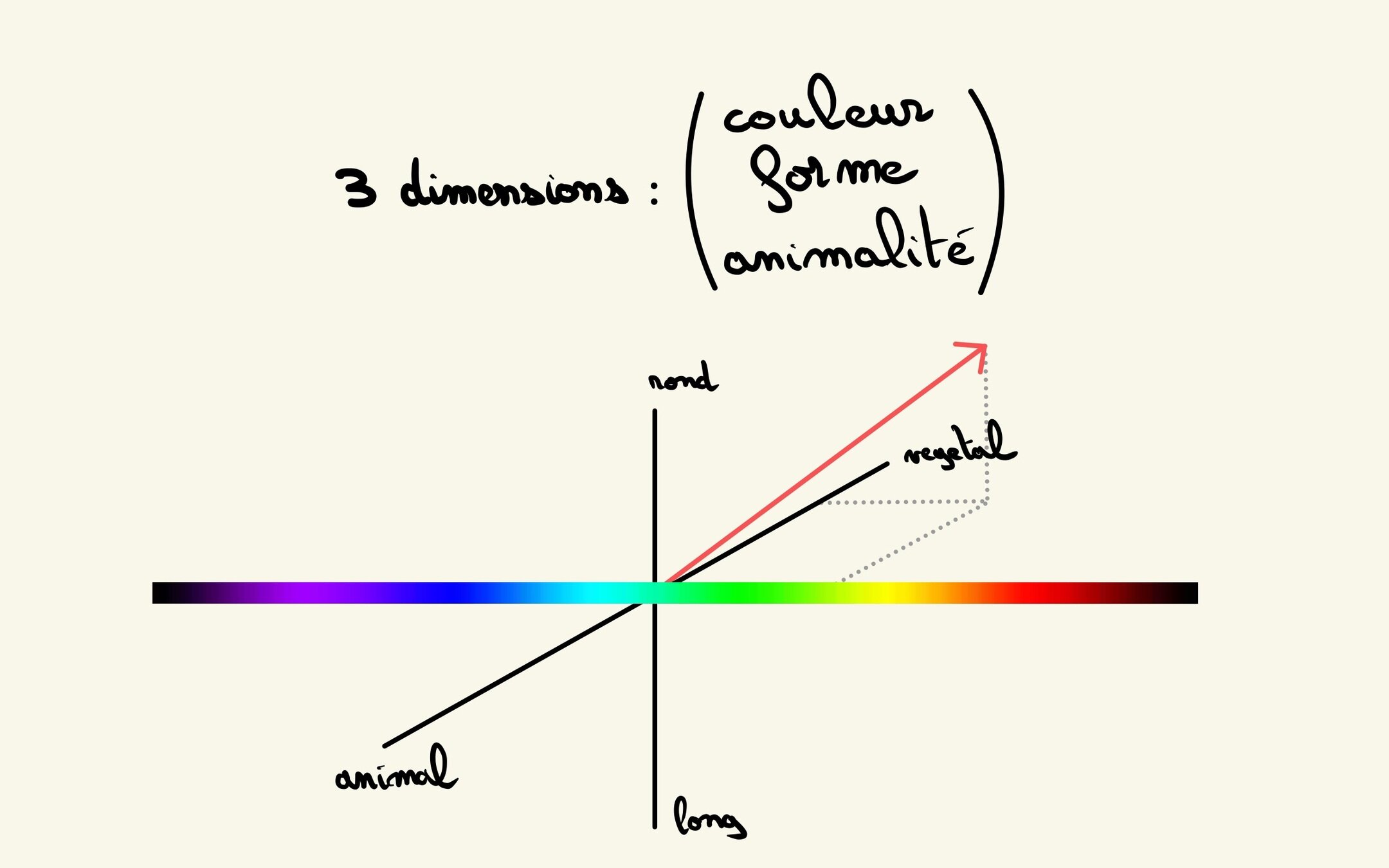

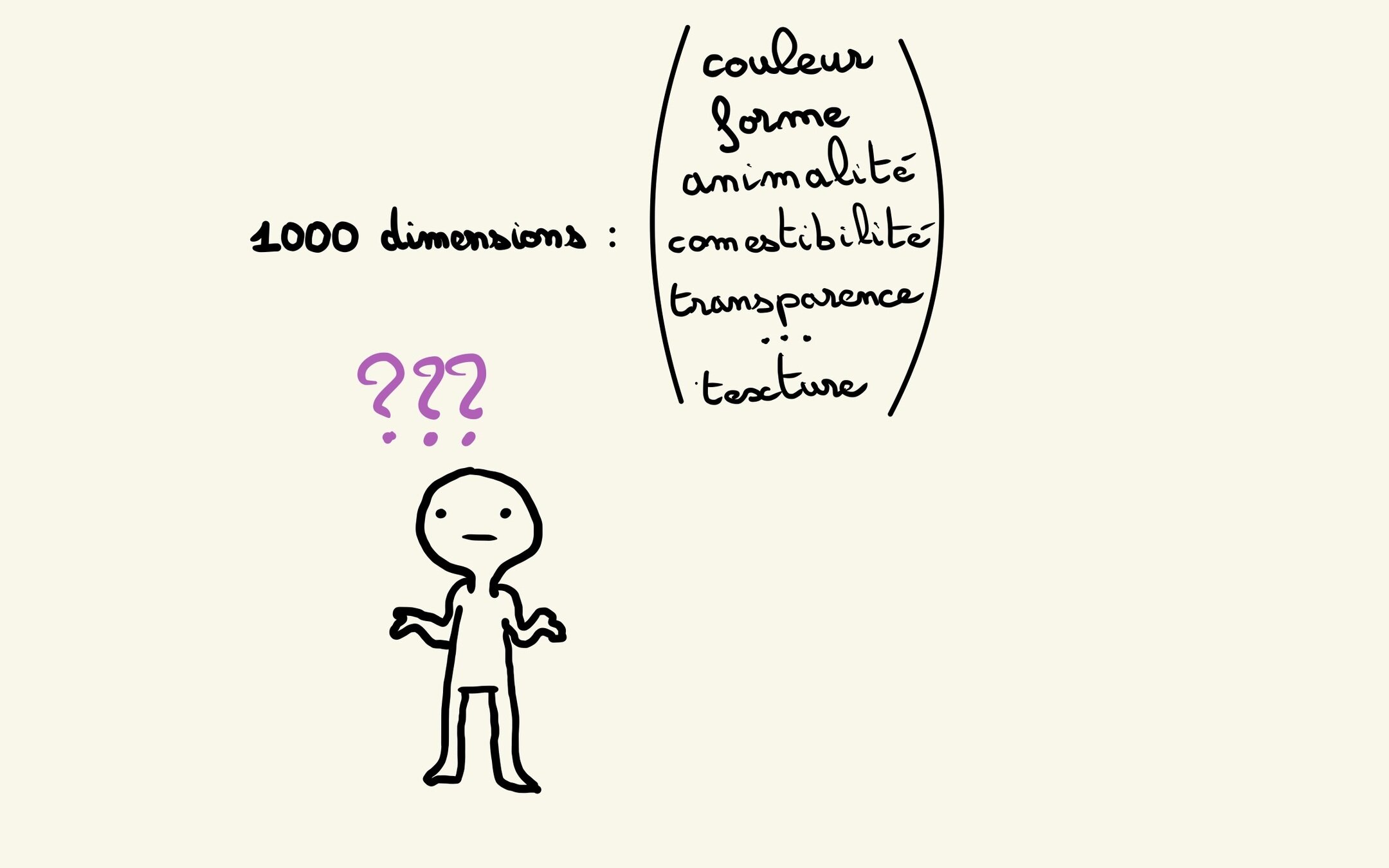

Dimensions

Encoder le langage

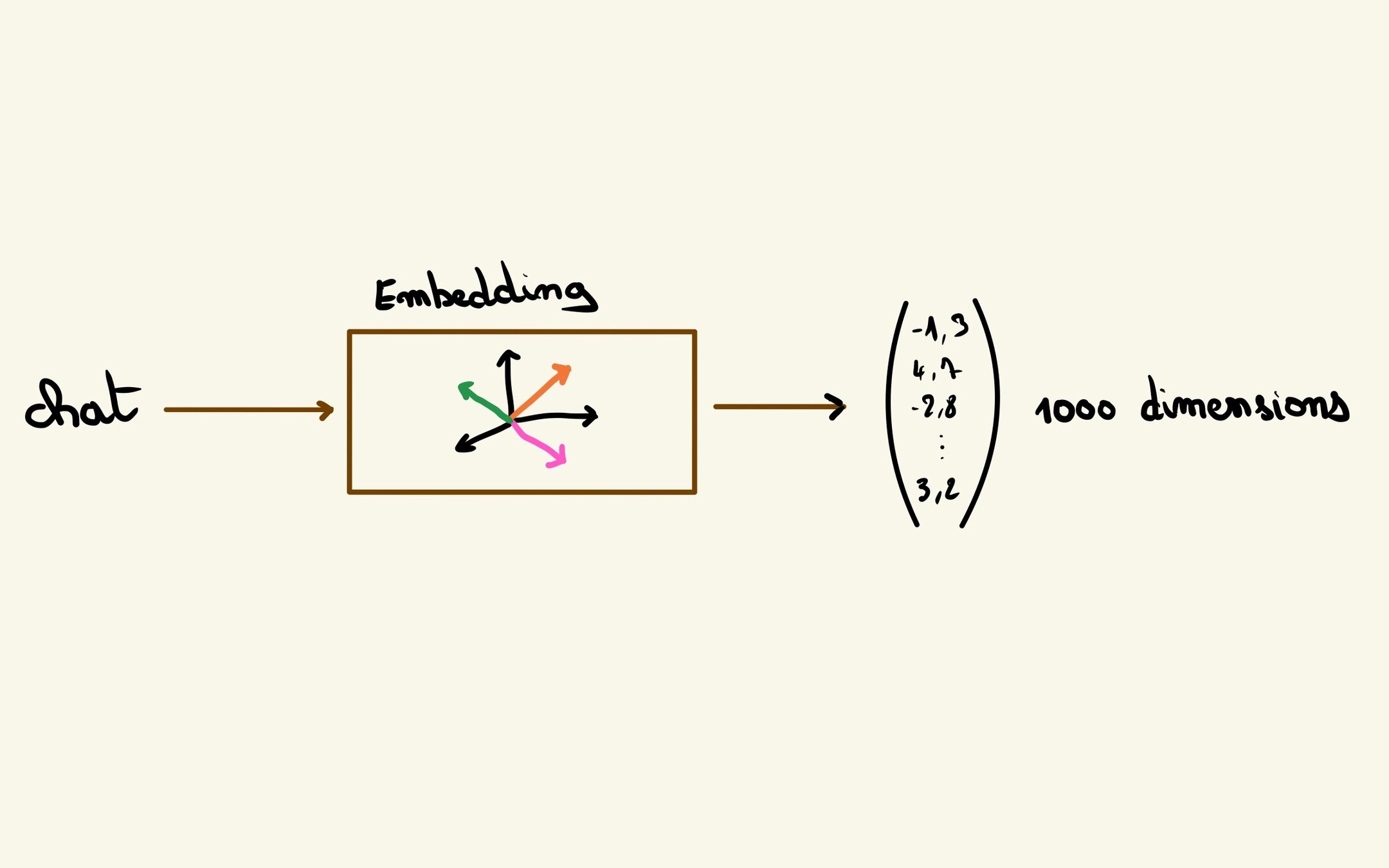

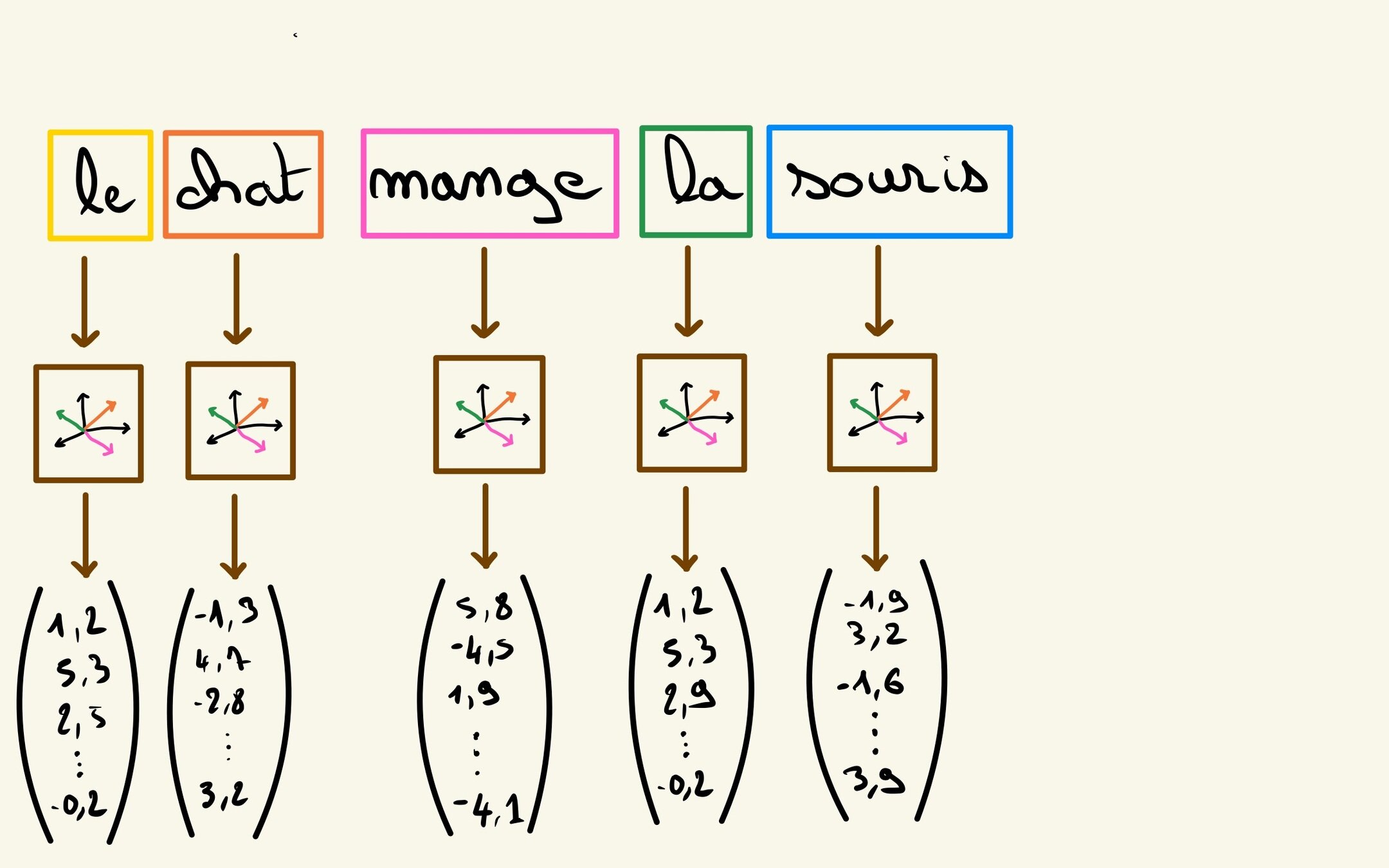

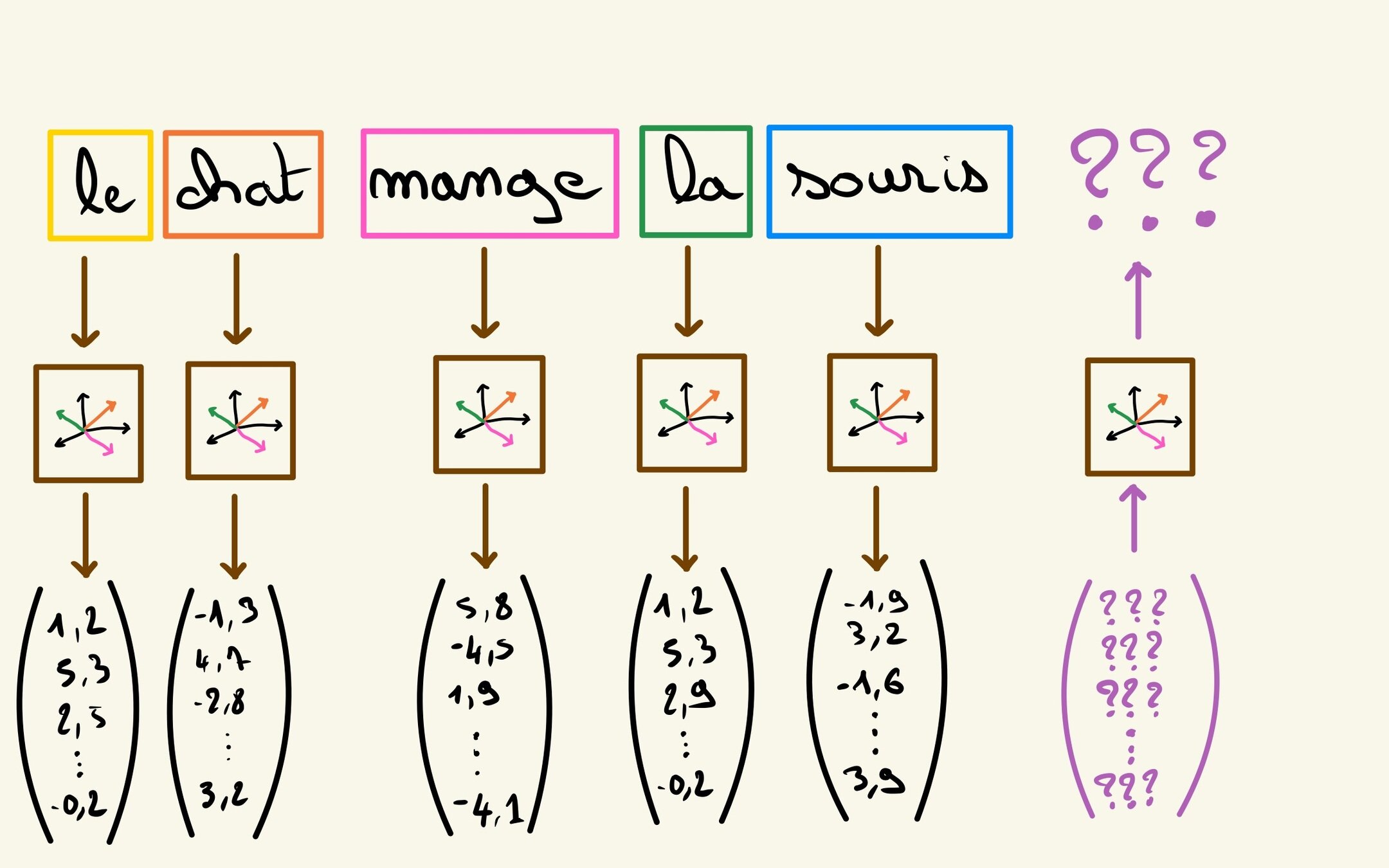

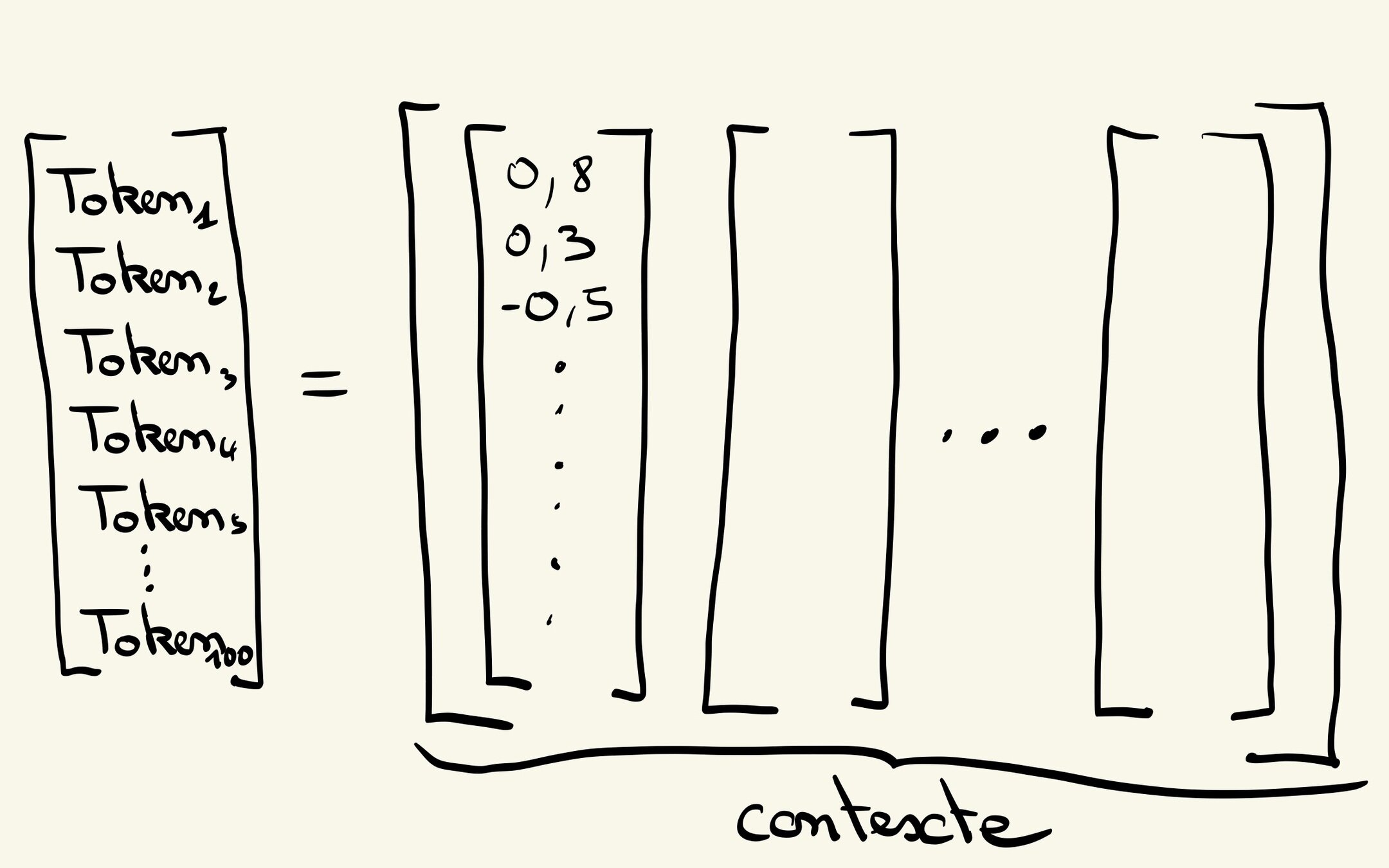

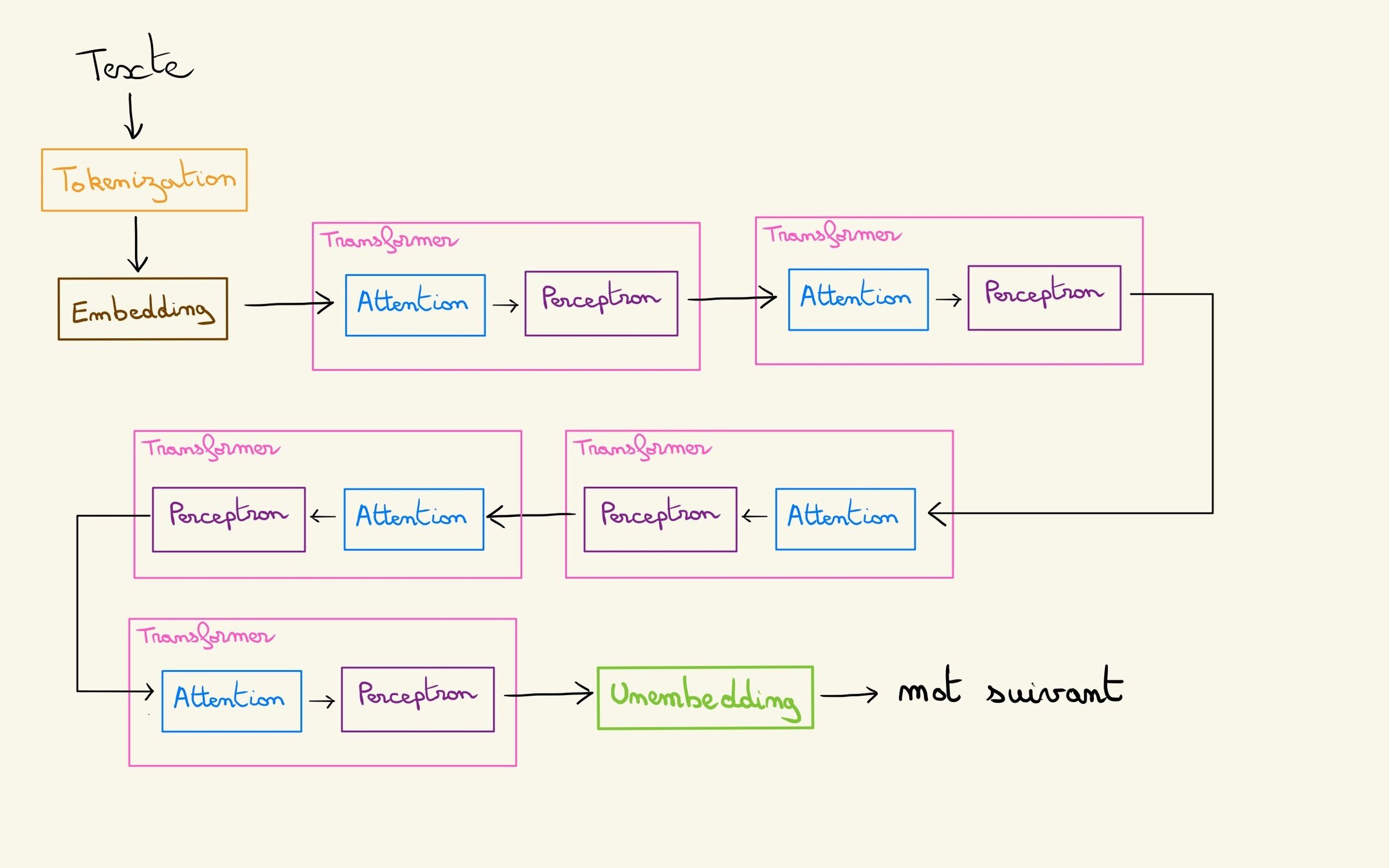

Embedding

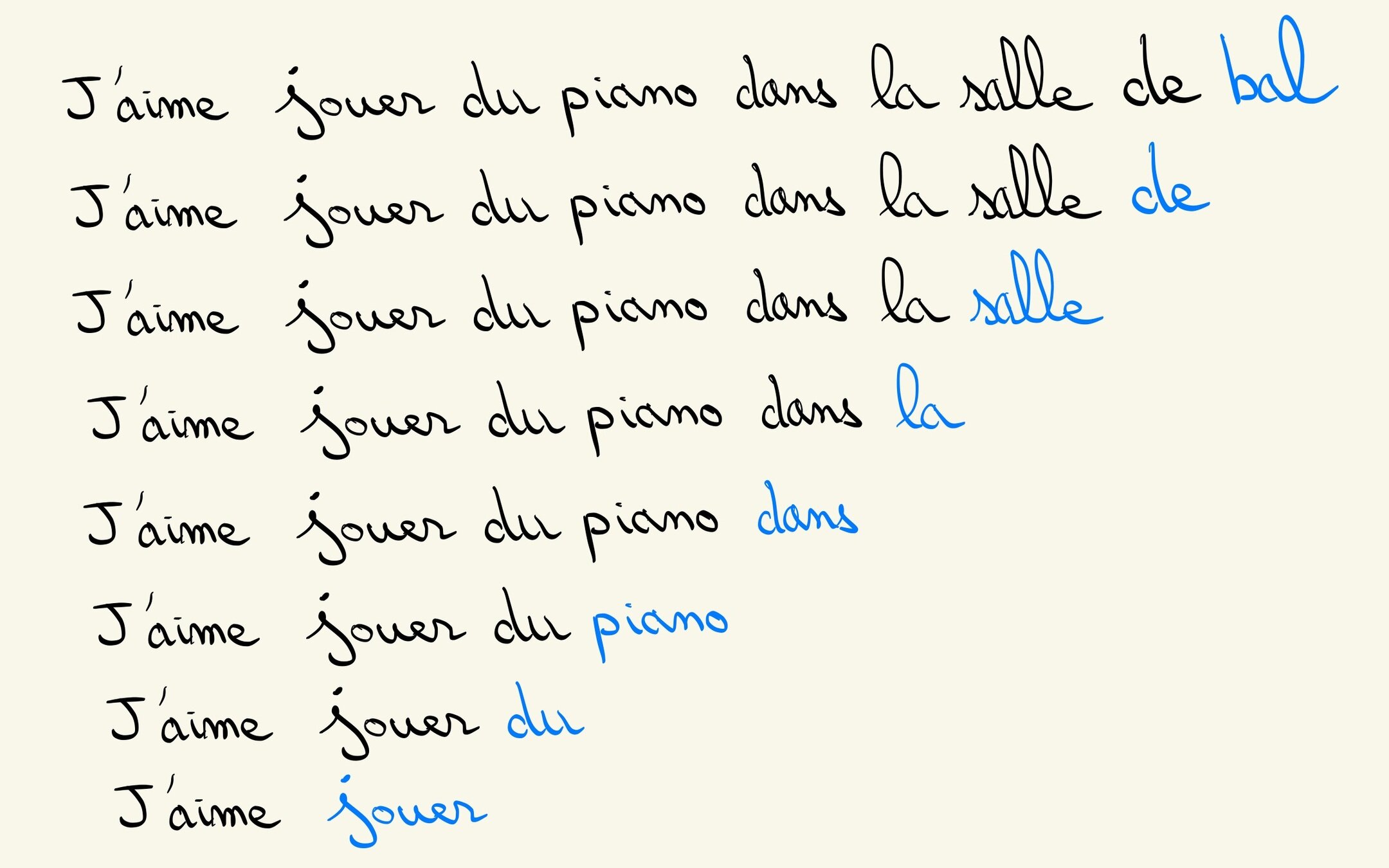

Tokenisation

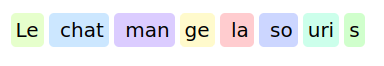

Vraie tokenisation

https://tokens-lpj6s2duga-ew.a.run.app/

Guillaume Laforge:

Notre objectif

Comprendre le langage des humains

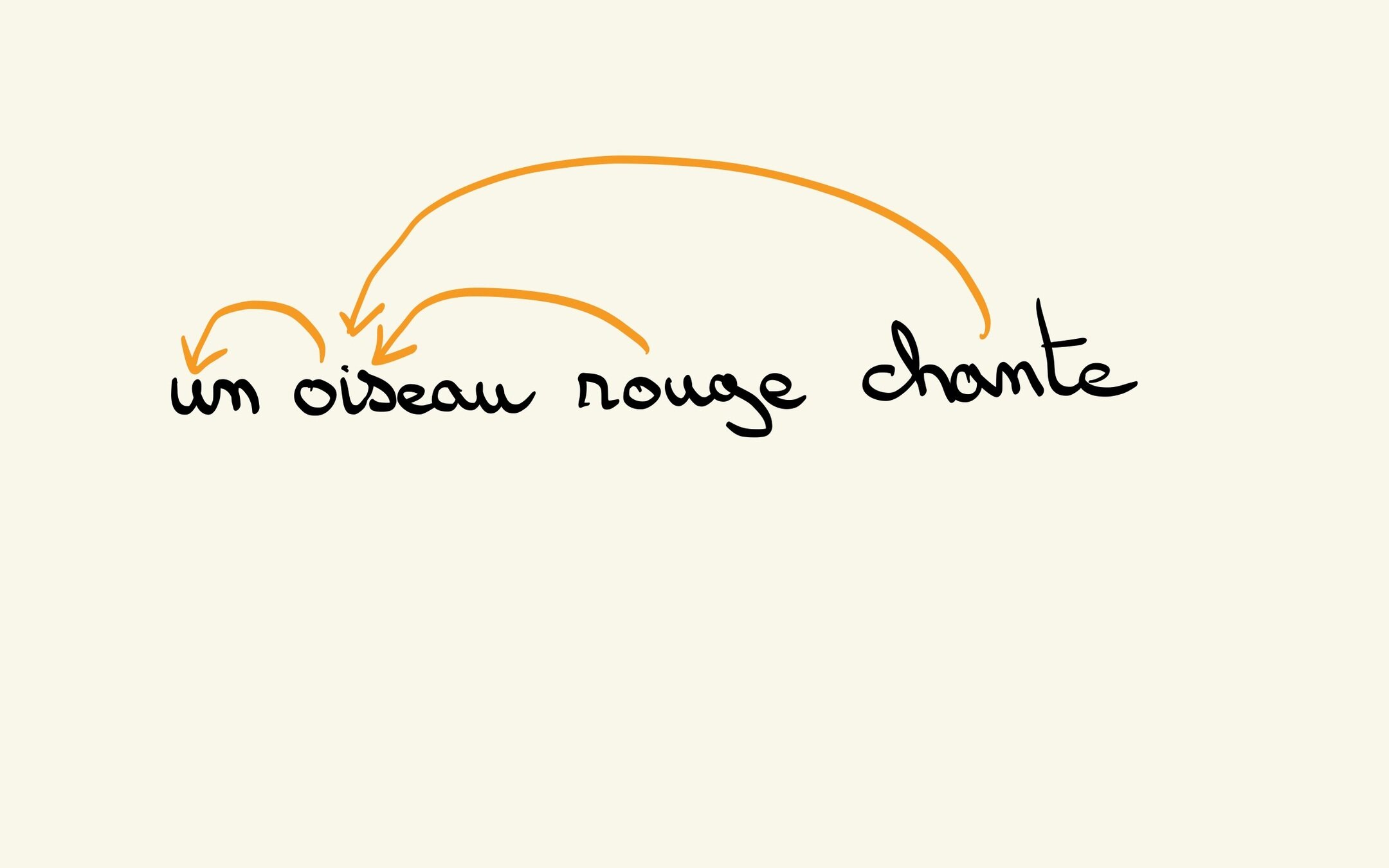

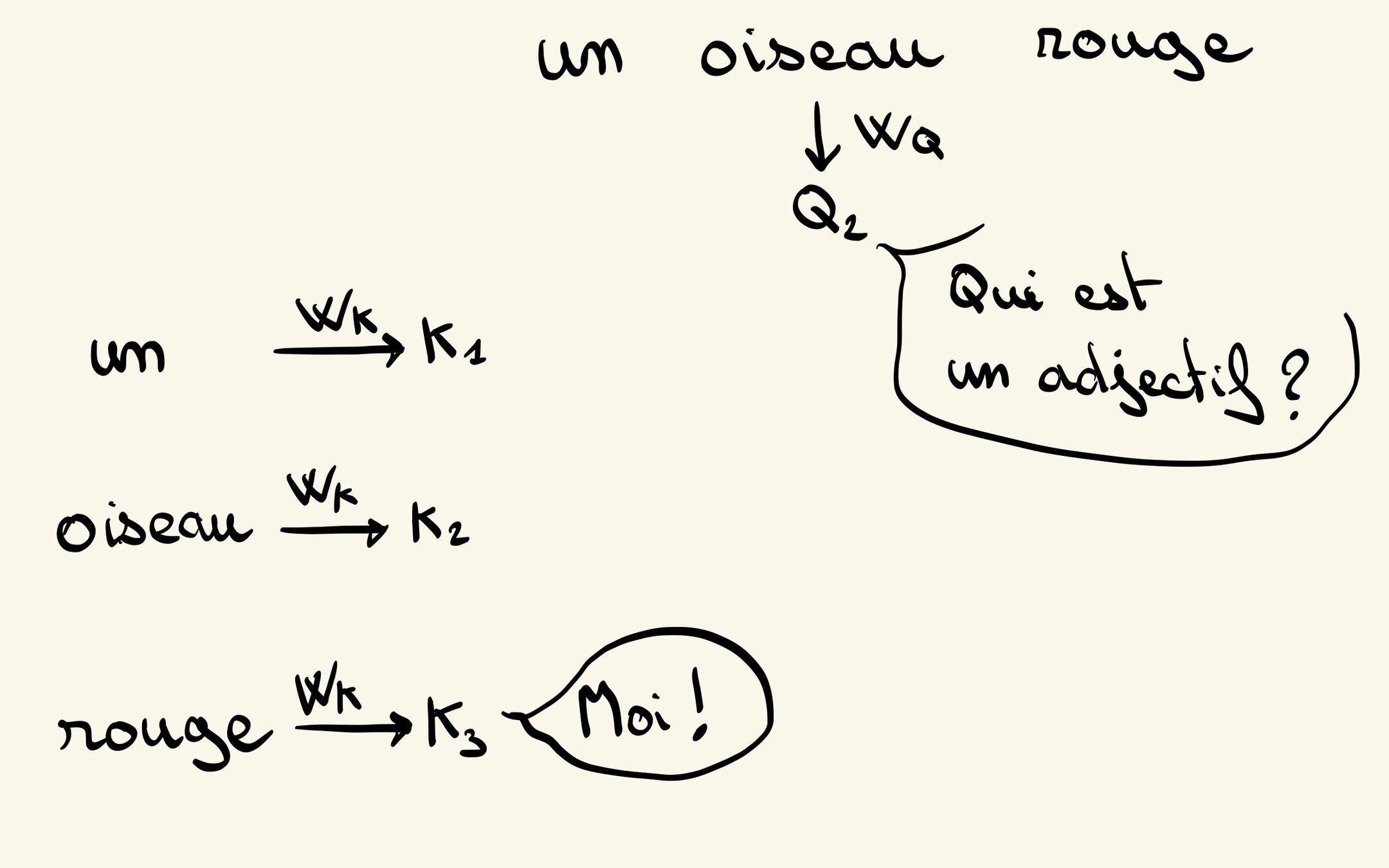

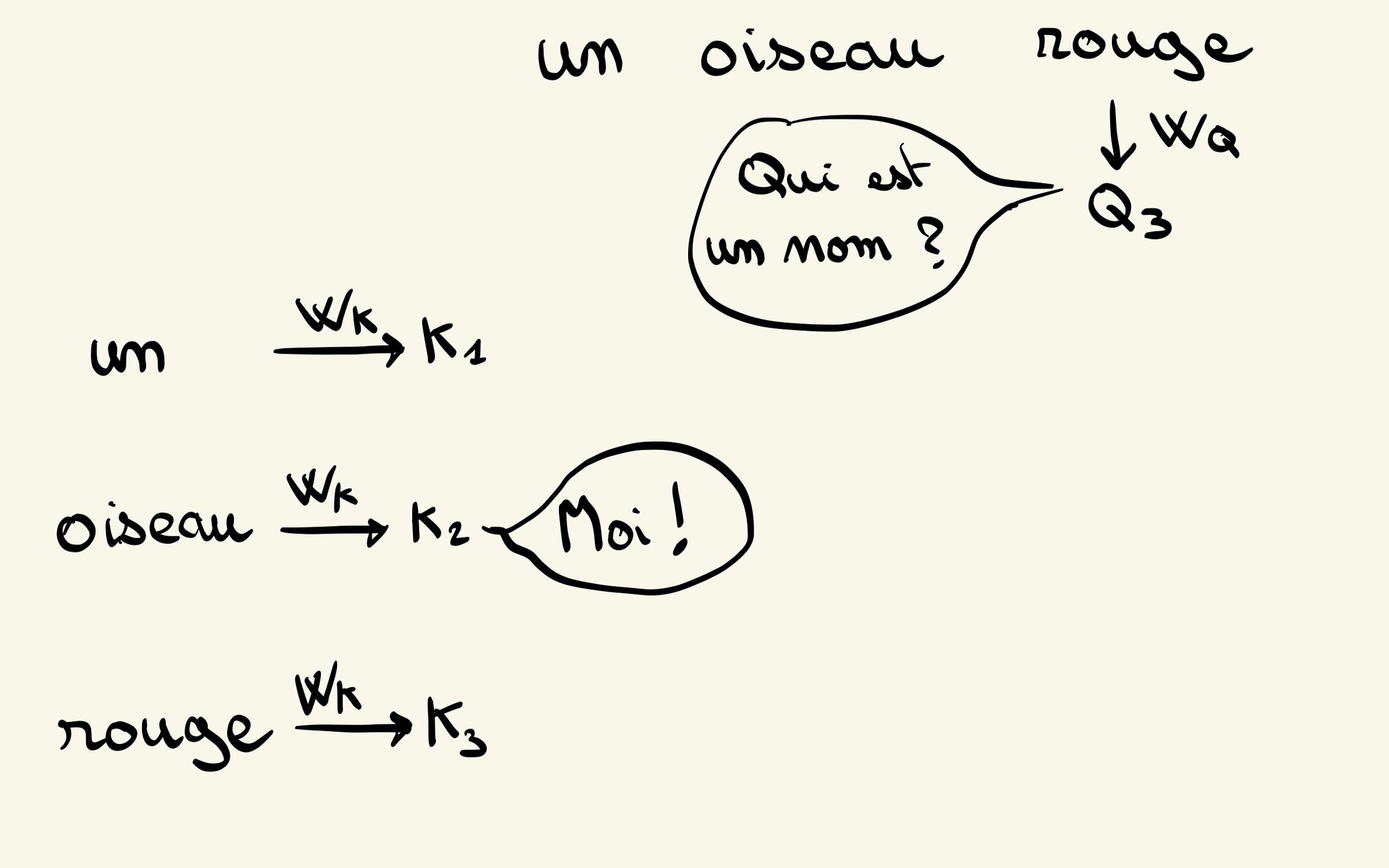

Interroger les tokens environnant

Répondre au question posées

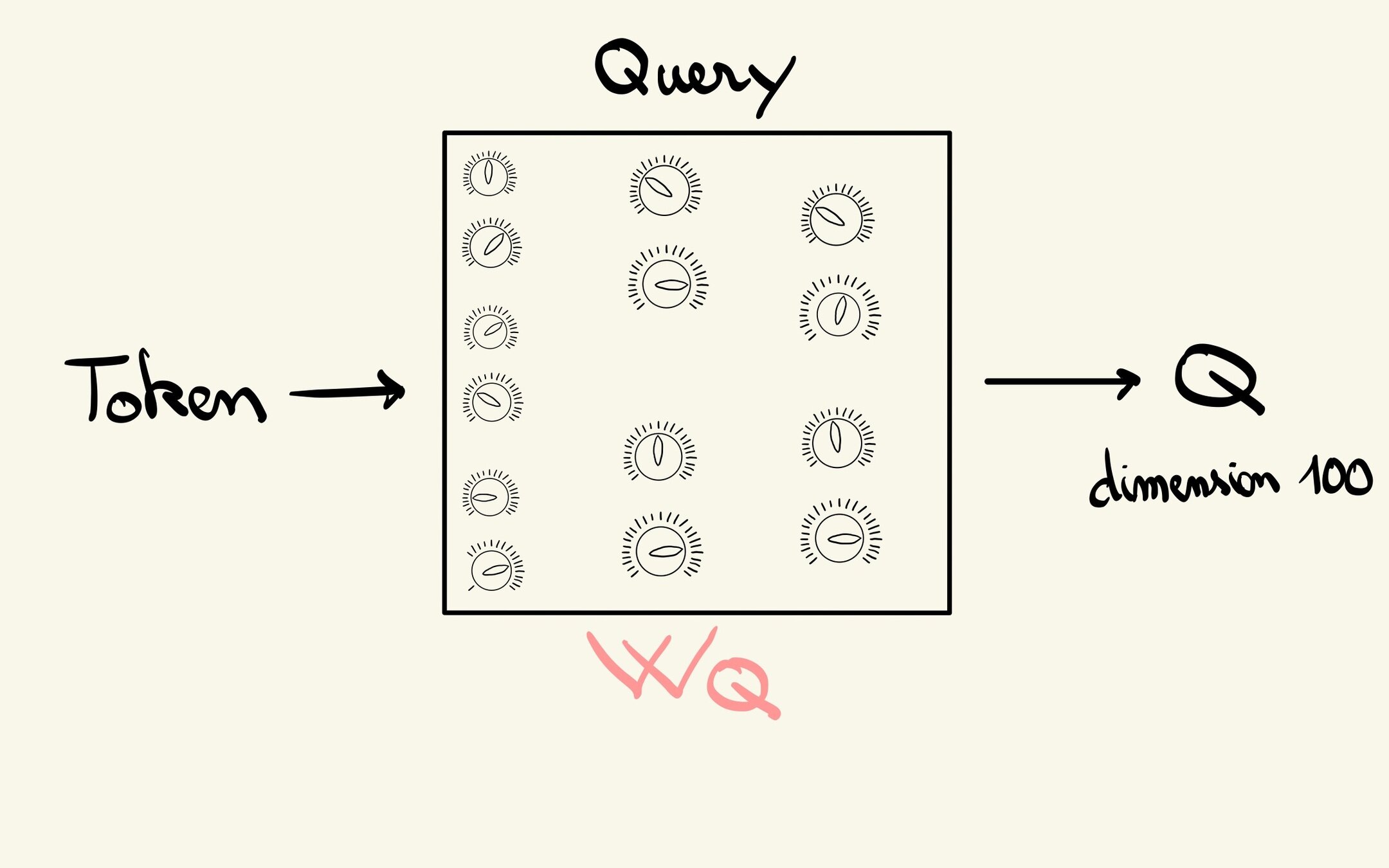

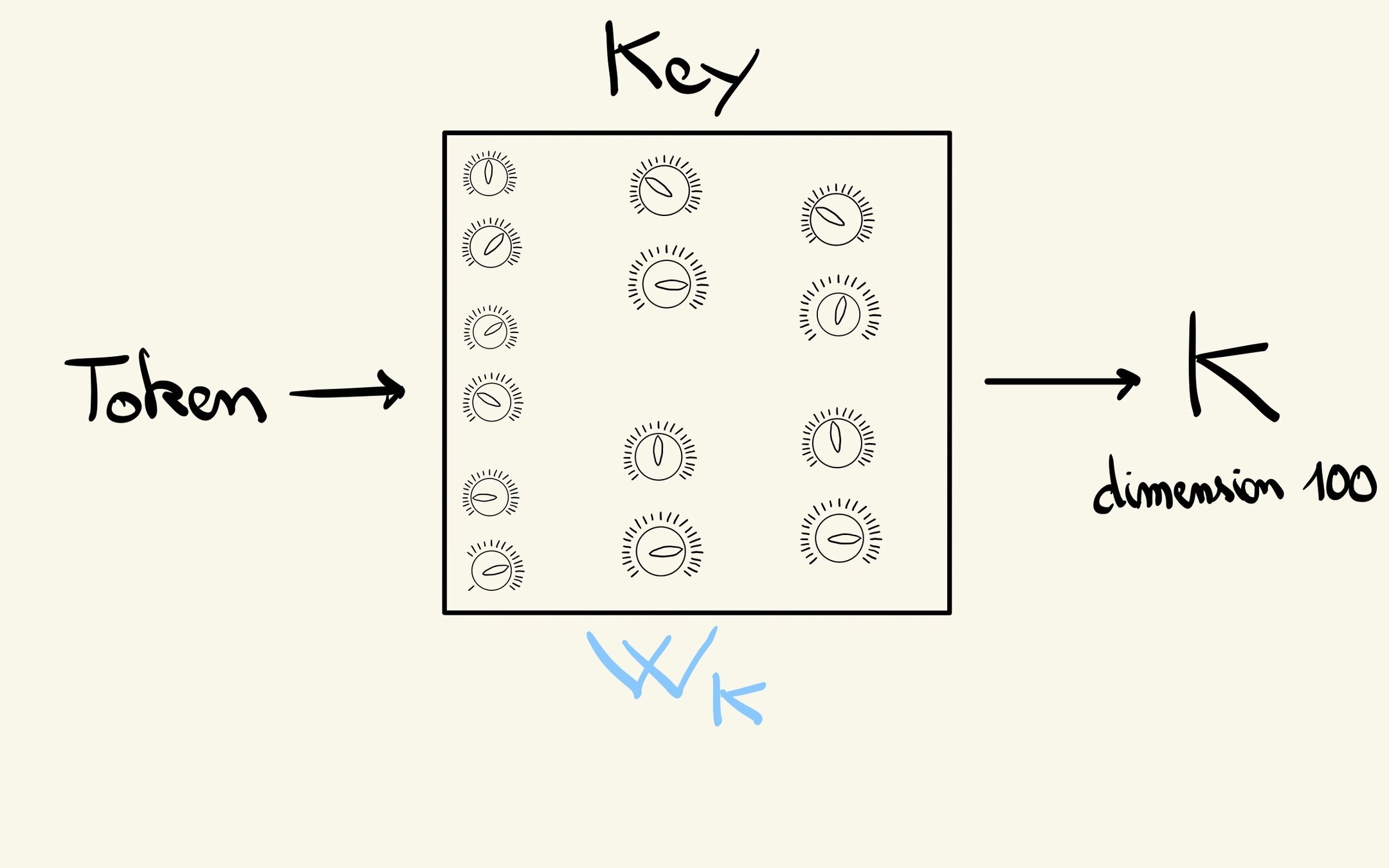

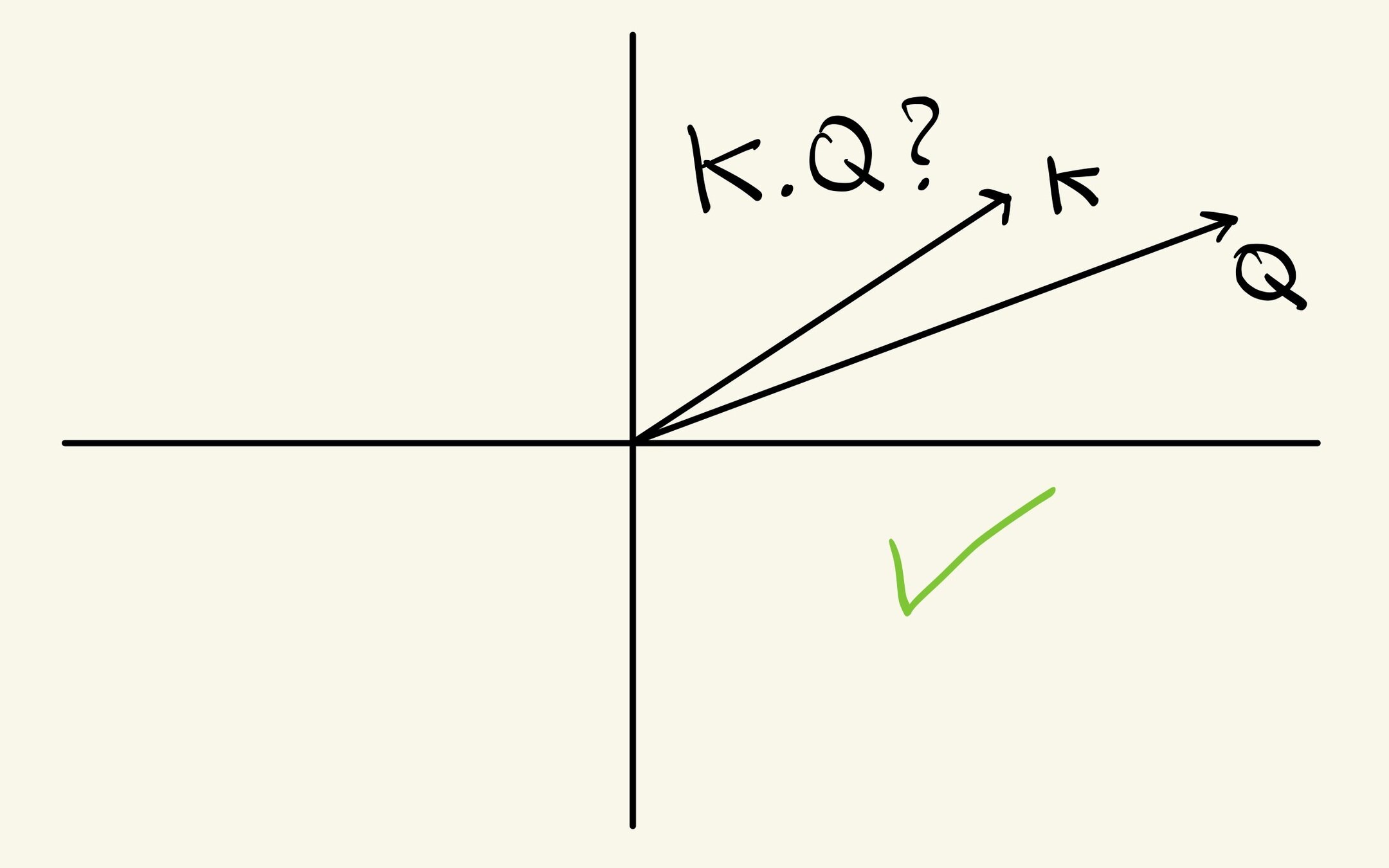

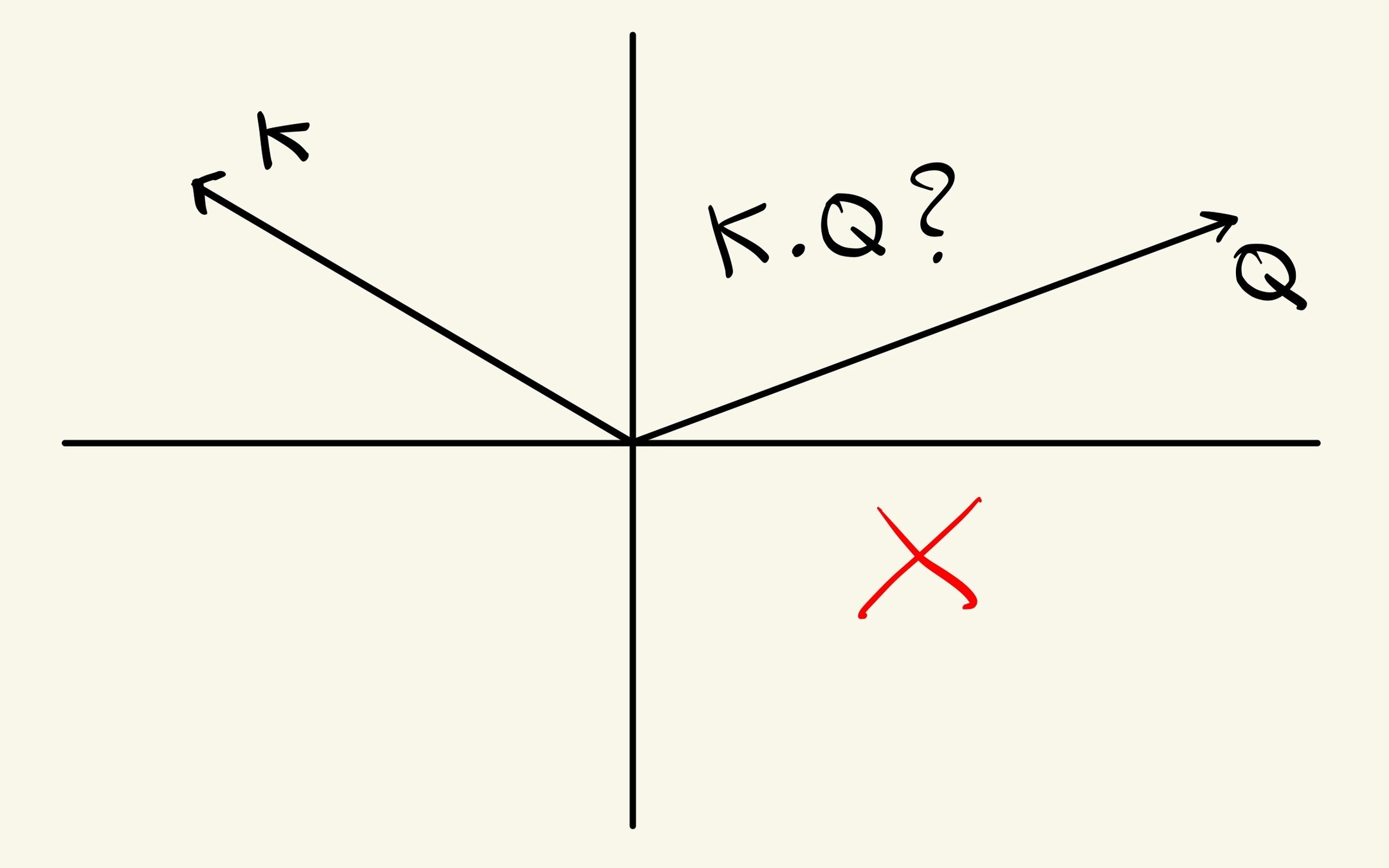

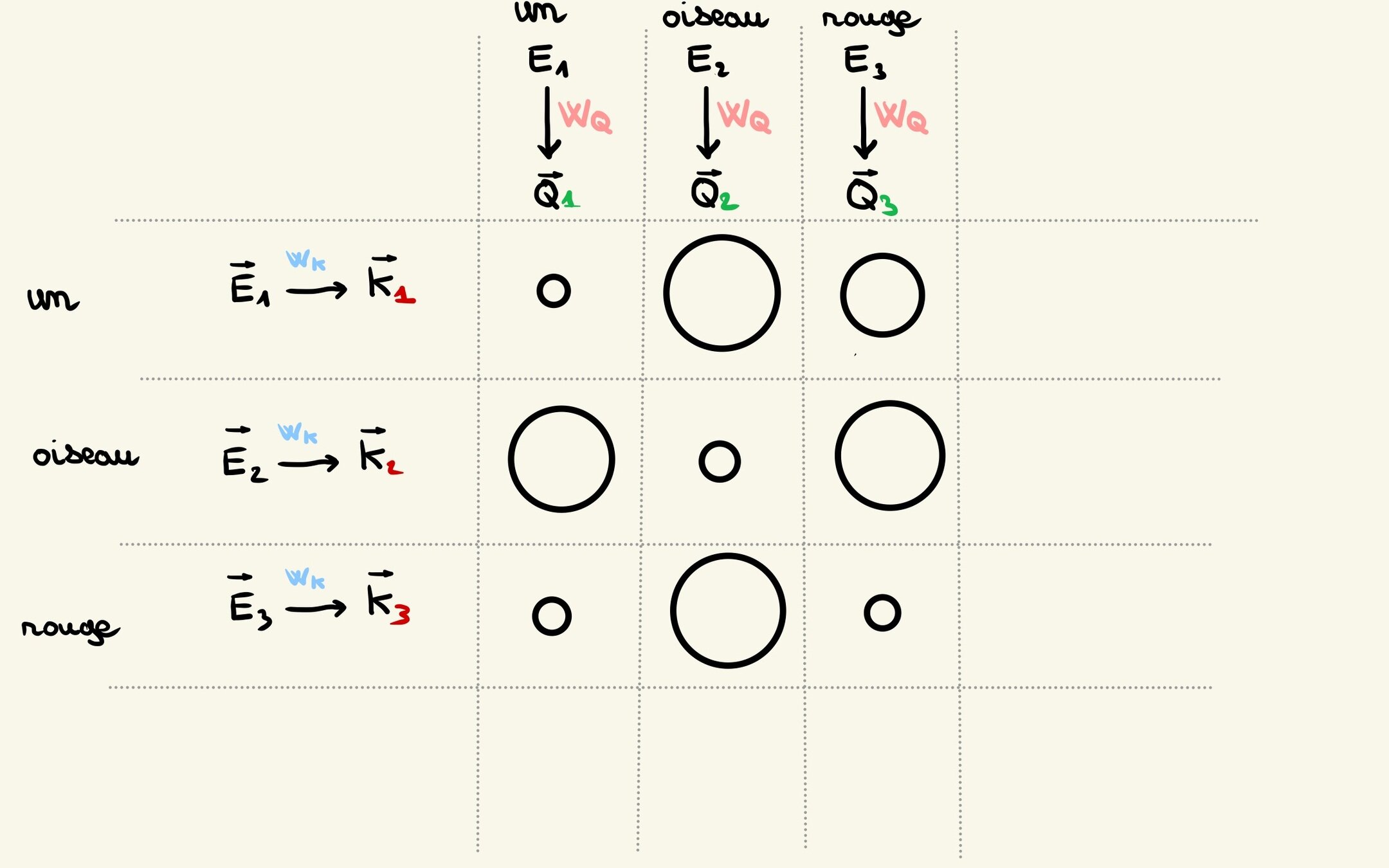

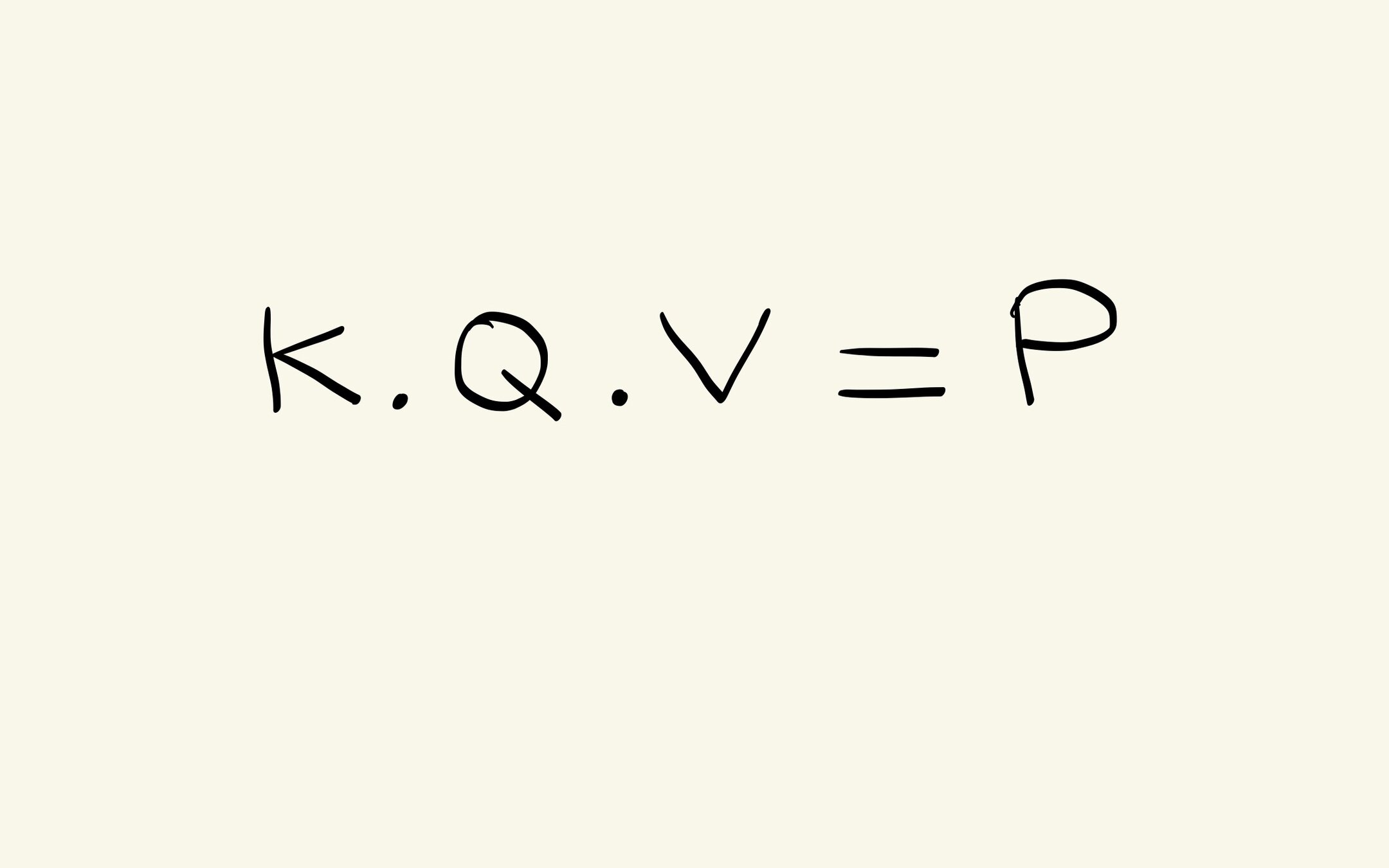

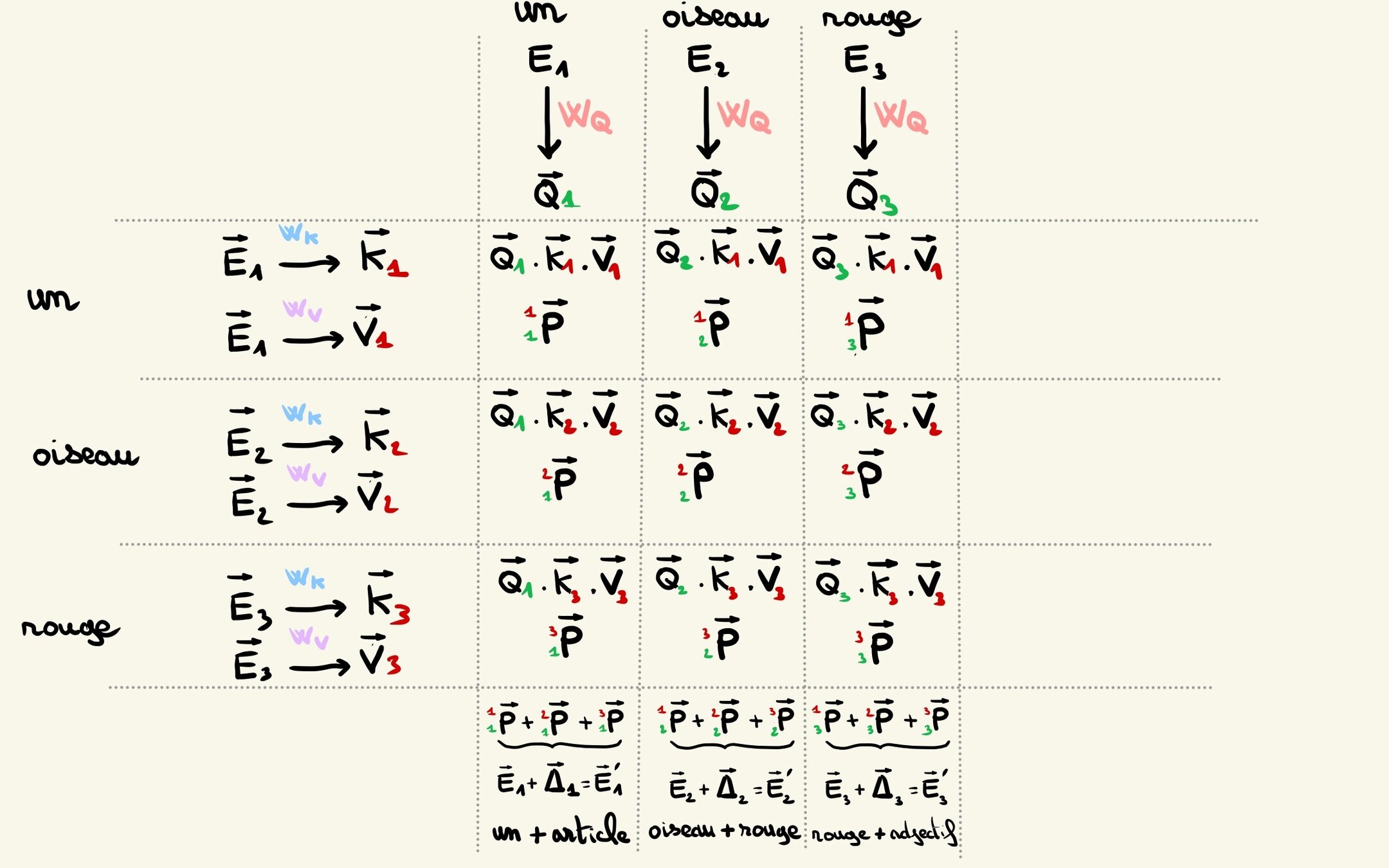

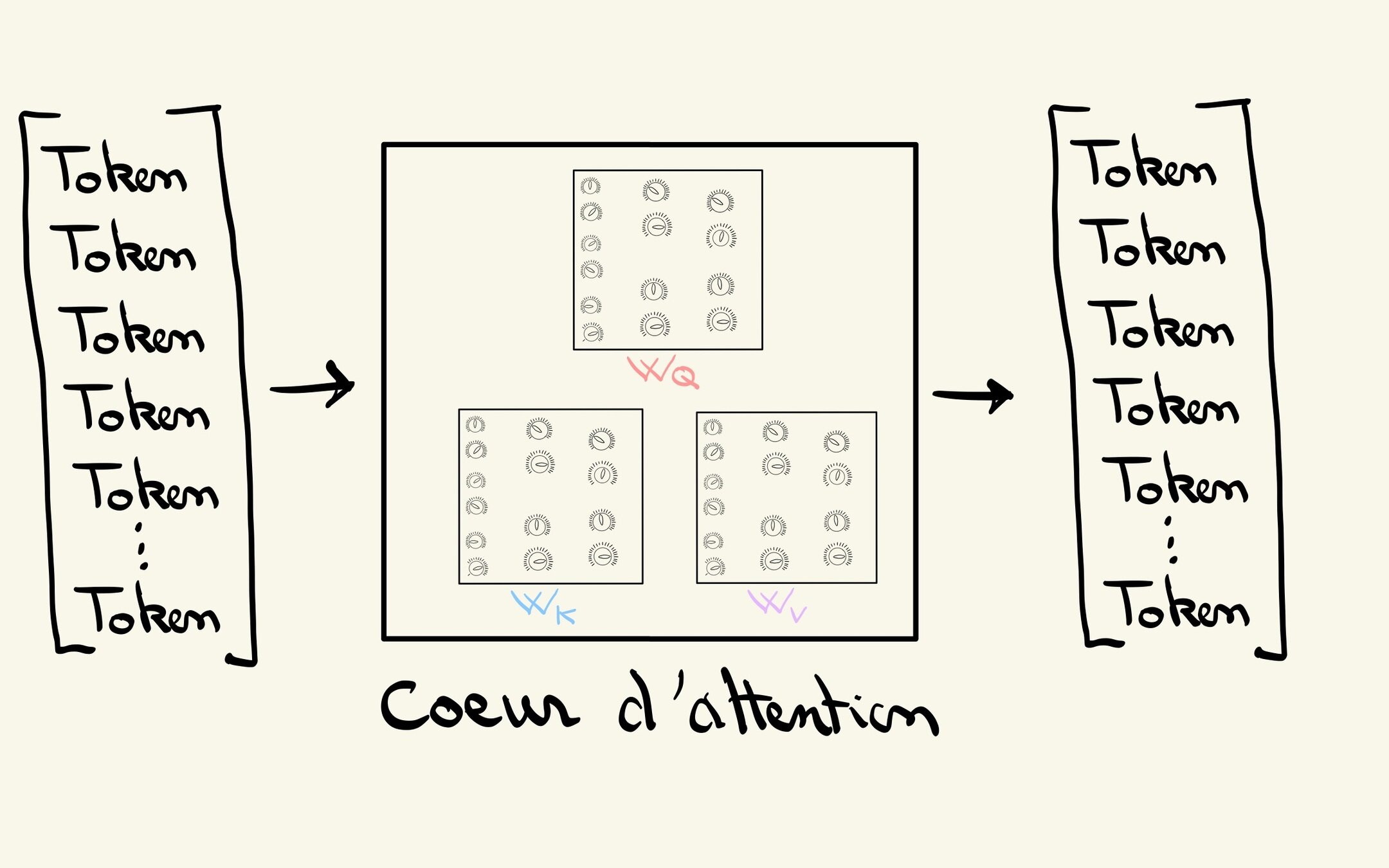

Matrice d'attention

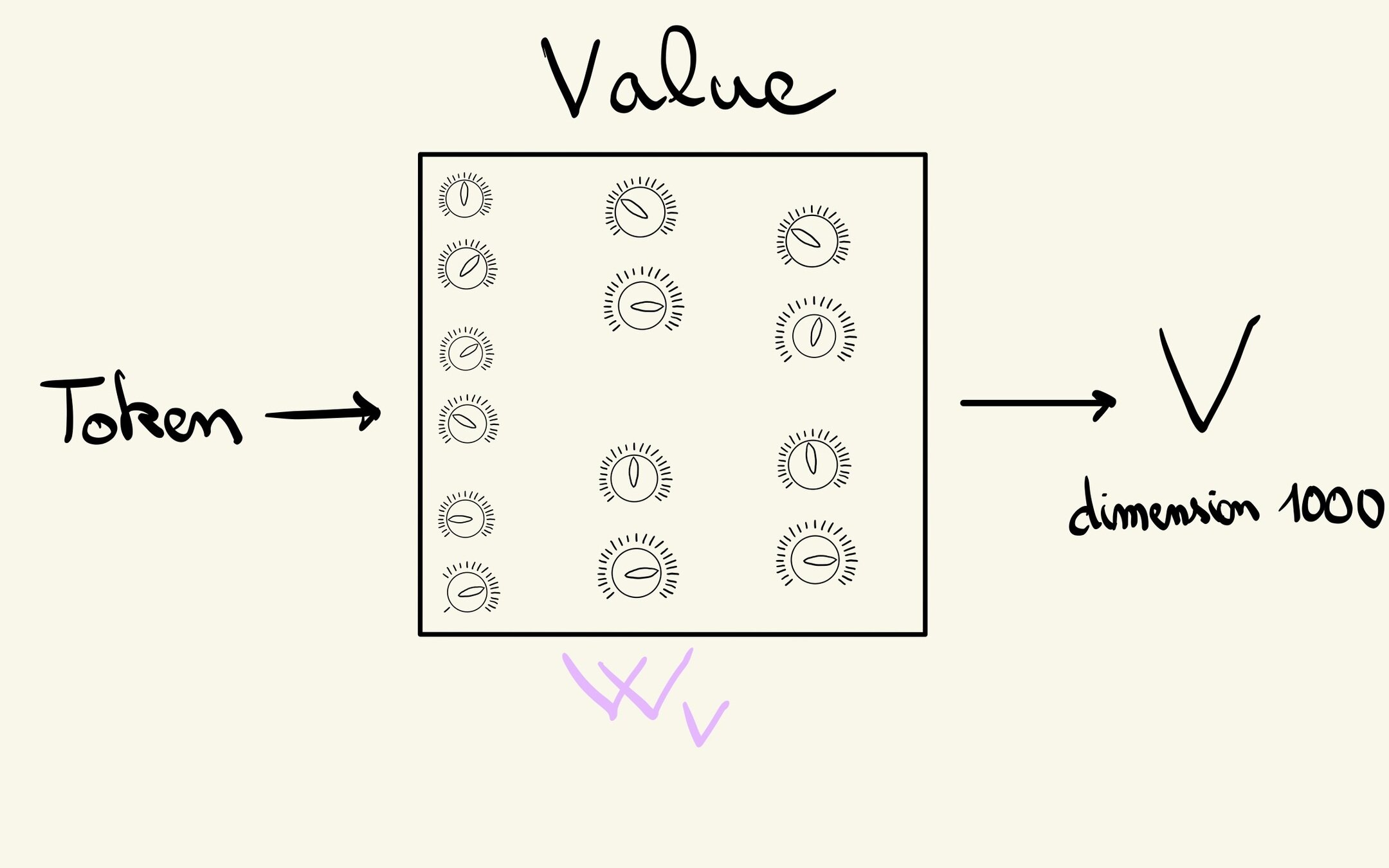

Enrichir un token par rapport à son environnement

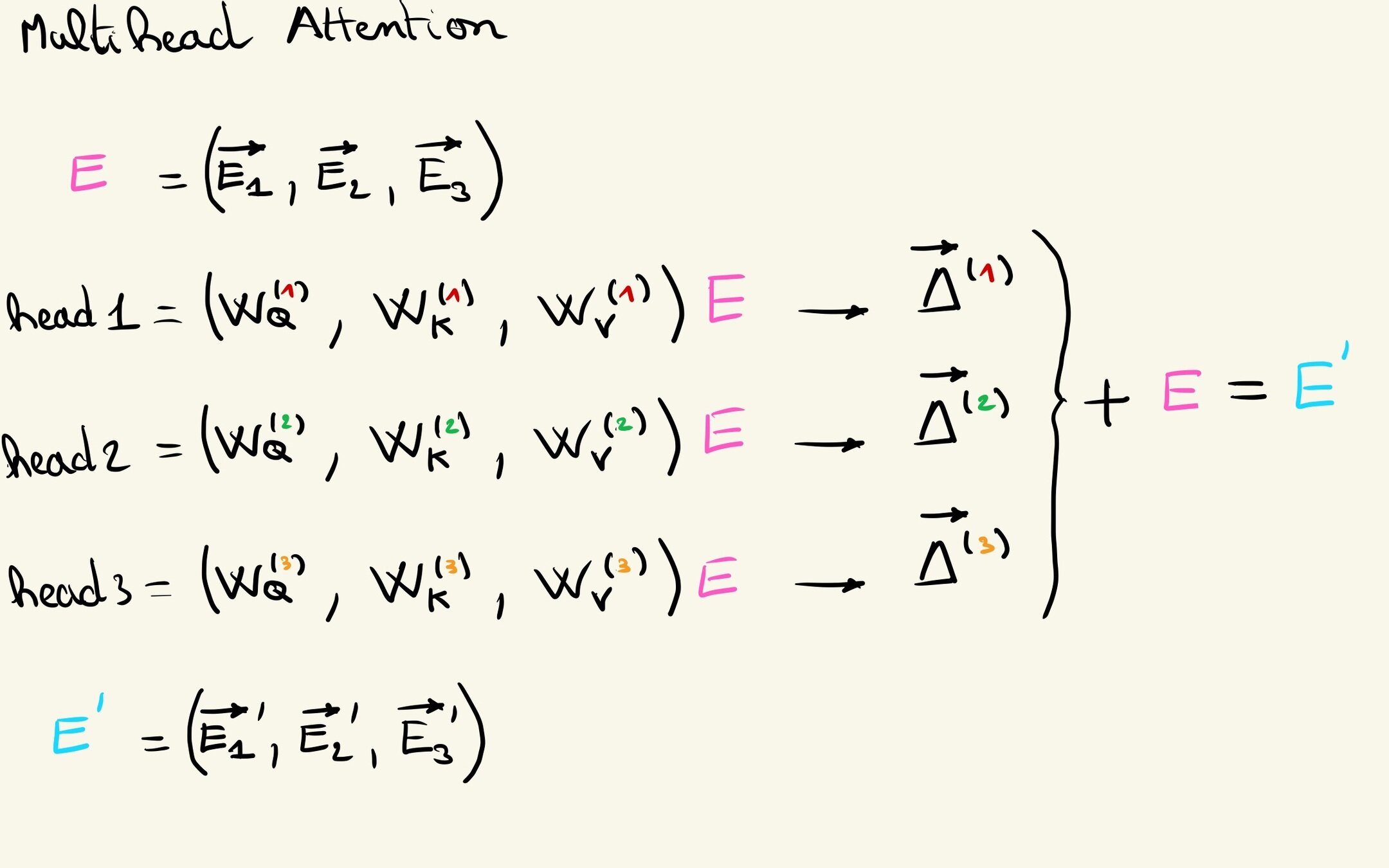

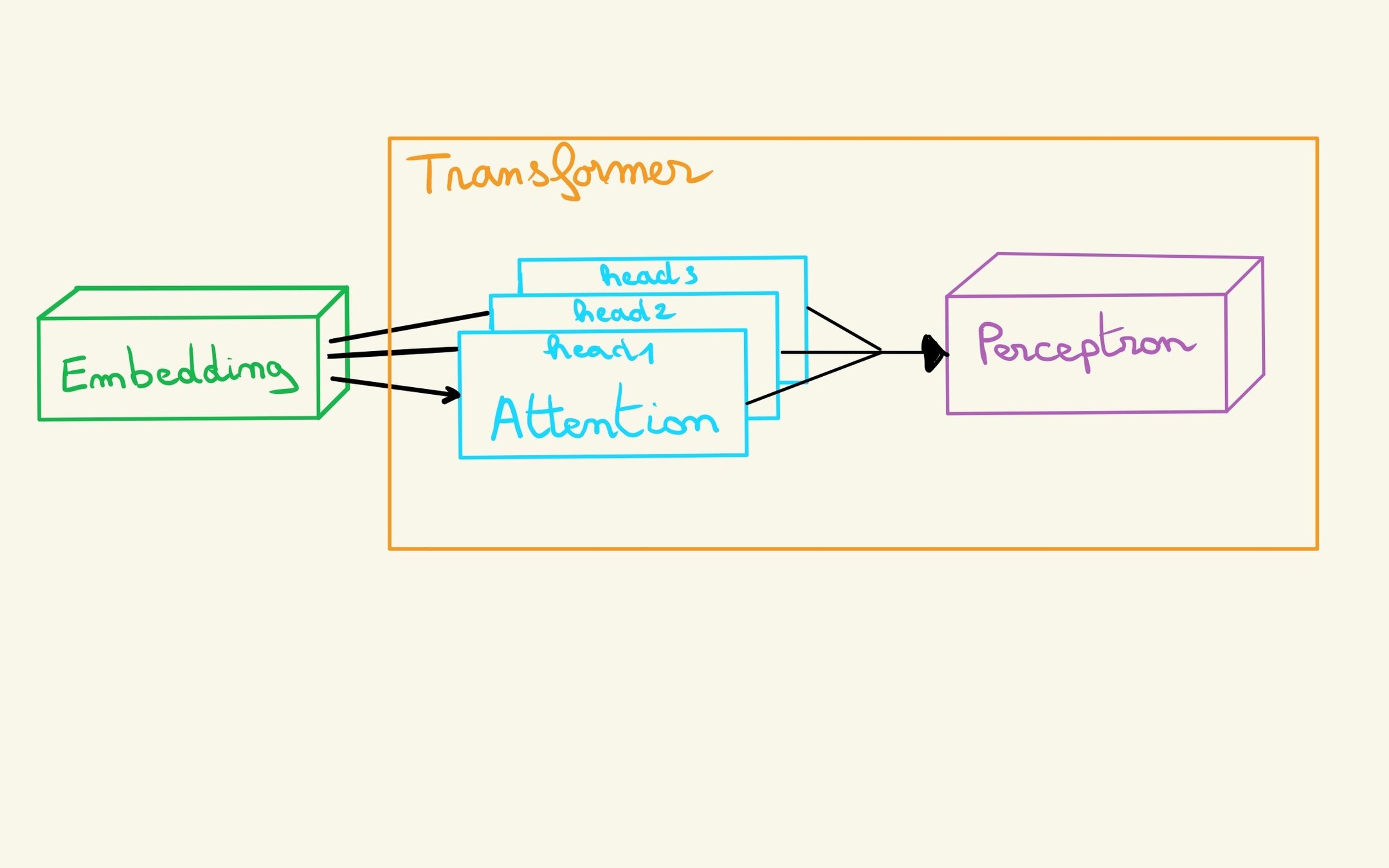

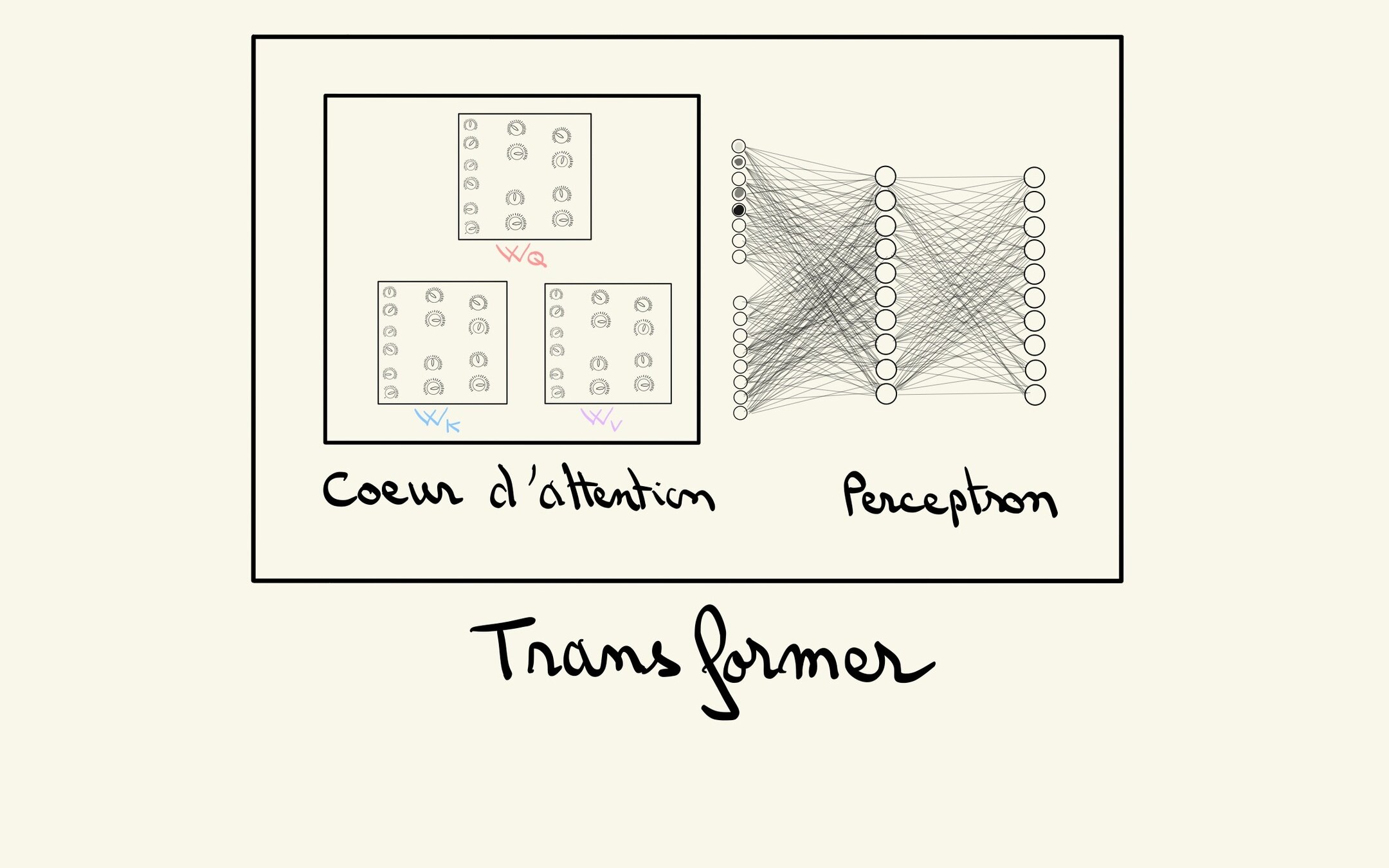

Vers le Transformer

Le fameux contexte

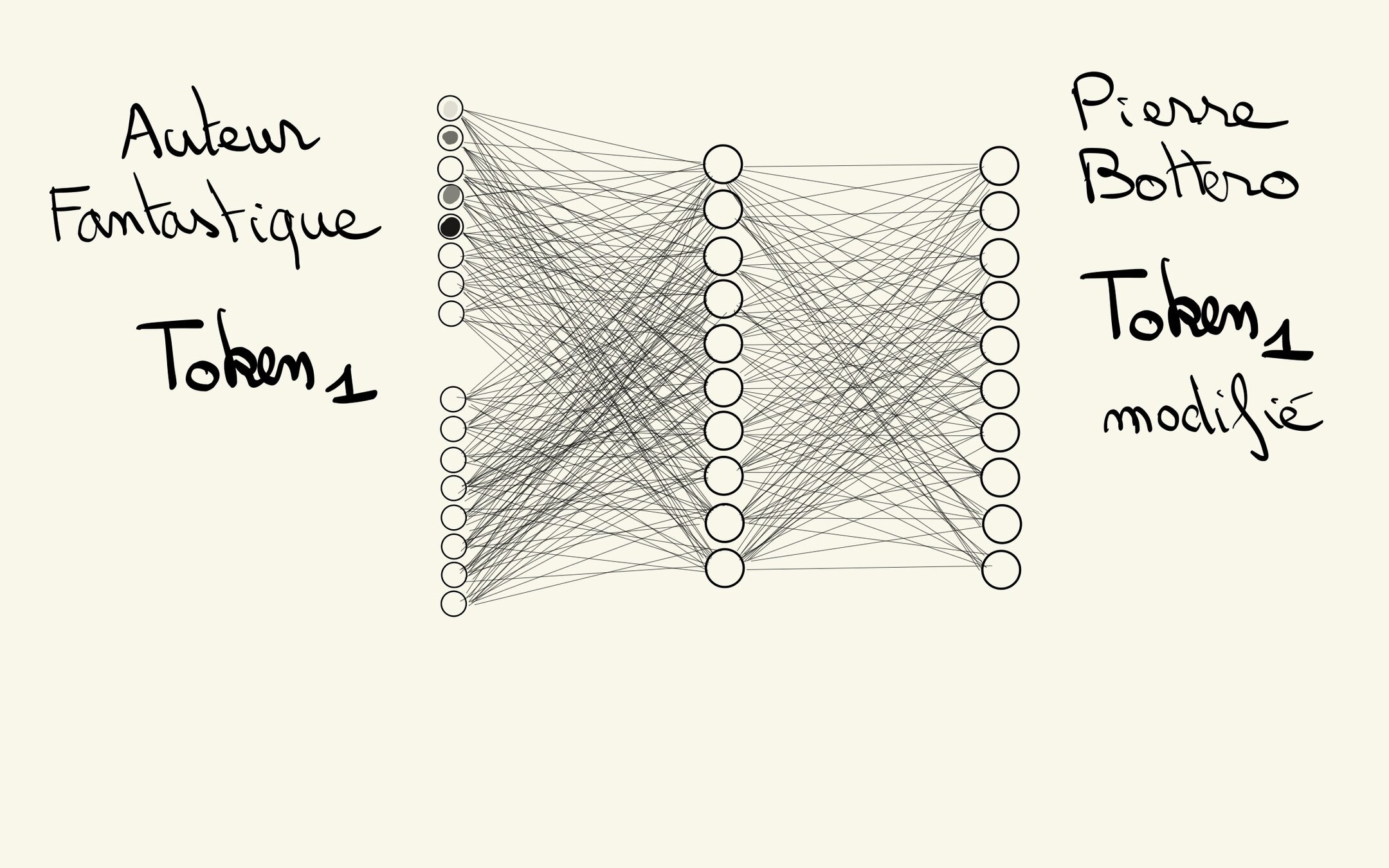

MLP : Enrichir un Token

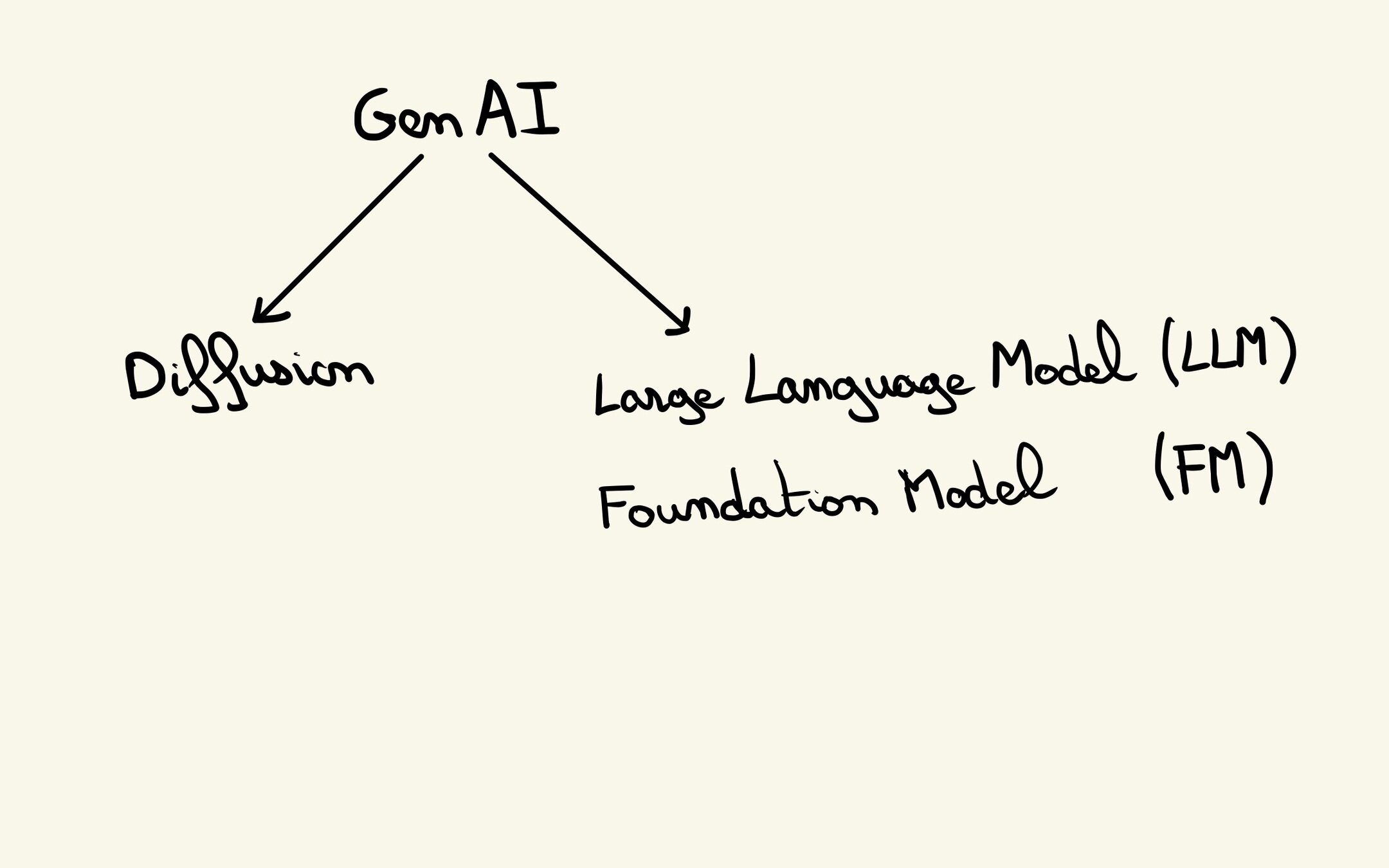

L'avancé majeur de Genarative Pretrained Transformer

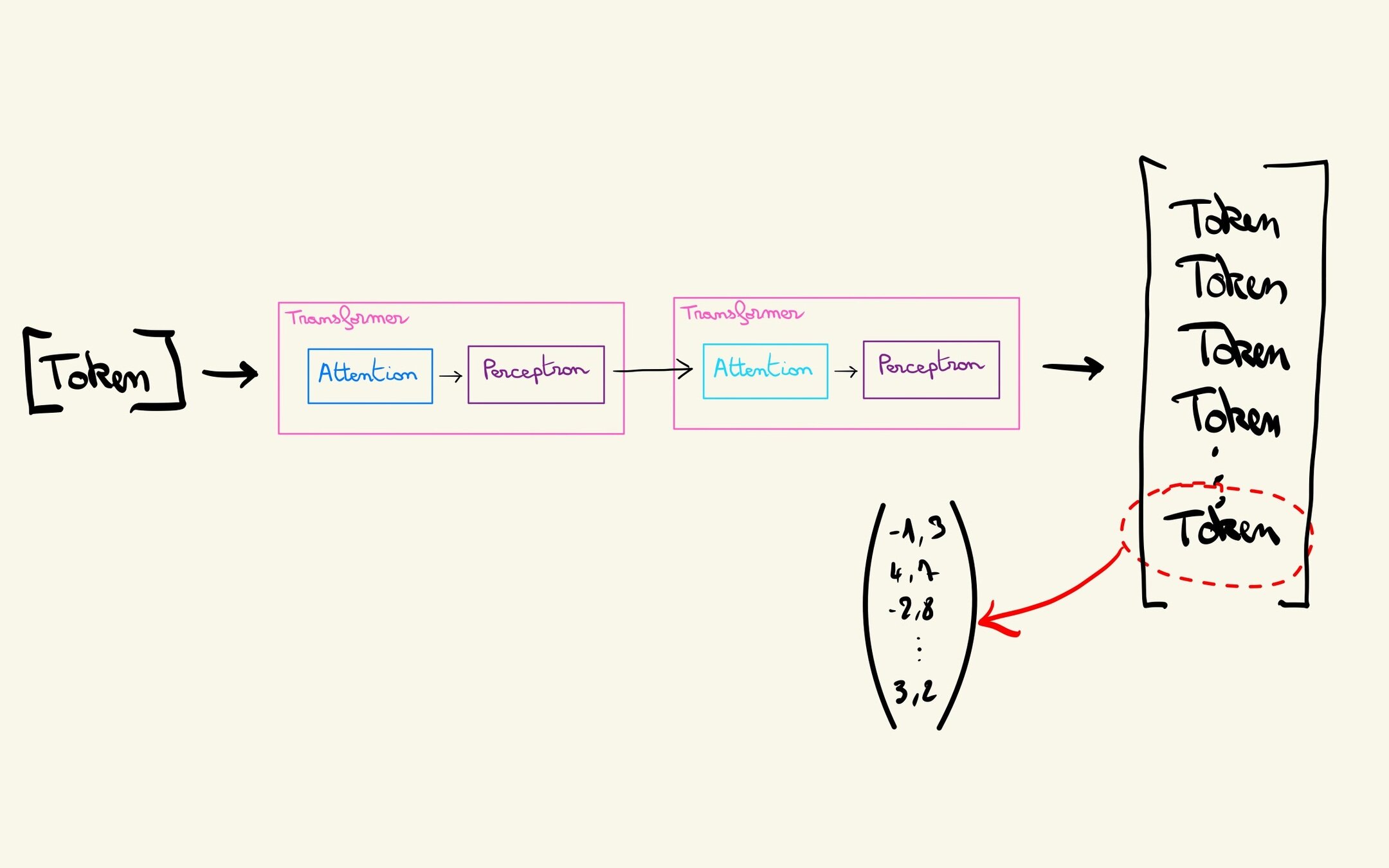

On récupère le dernier

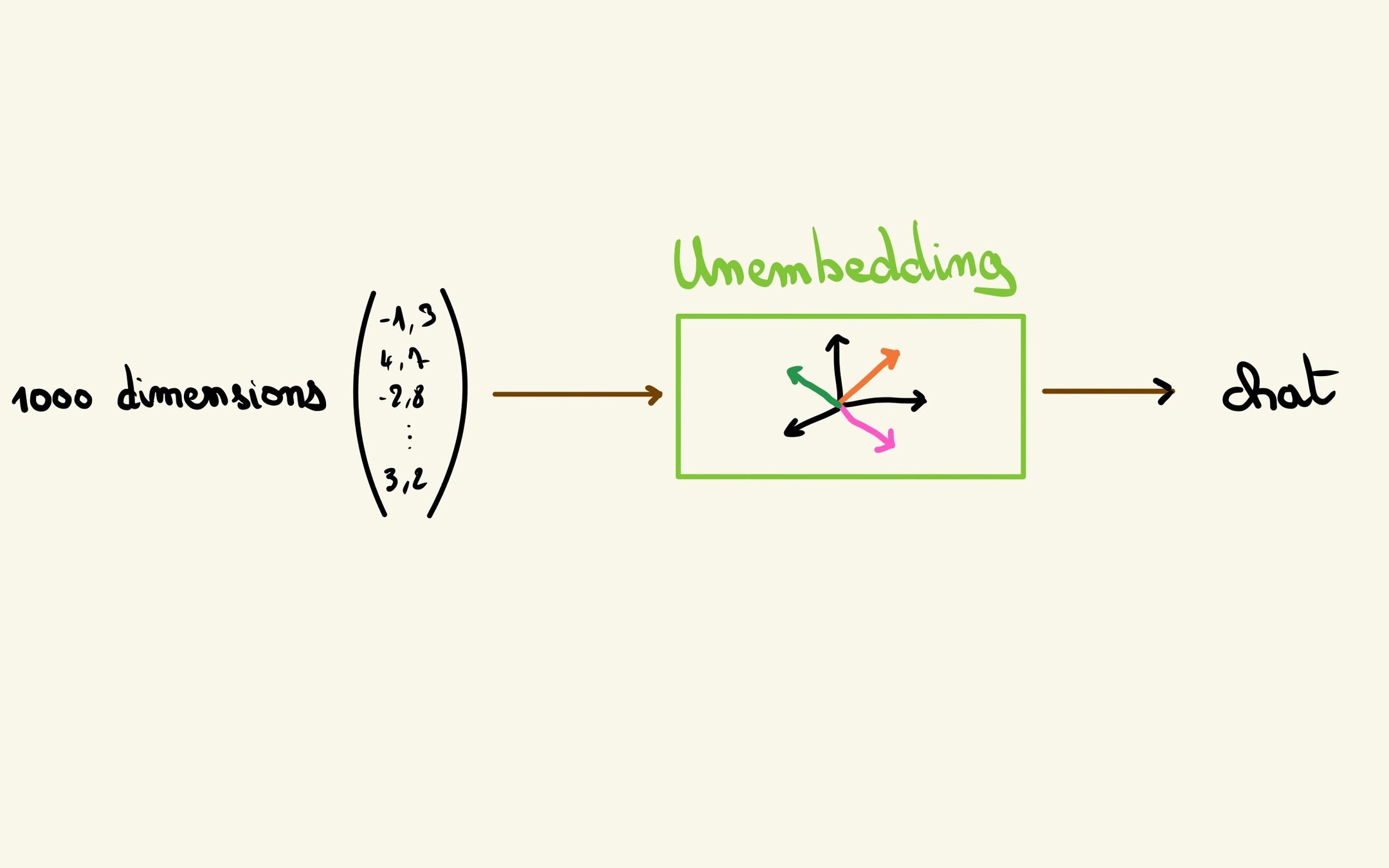

Revenir au langage

Schéma de principe d'un GPT

Comment l'entraîner ?

Pour aller plus loin

3Blue1Brown :

https://www.3blue1brown.com/topics/neural-networks

Attention

- https://ig.ft.com/generative-ai/

- https://proceedings.neurips.cc/paper_files/paper/2017/file/3f5ee243547dee91fbd053c1c4a845aa-Paper.pdf

- https://slds-lmu.github.io/seminar_nlp_ss20/attention-and-self-attention-for-nlp.html

Tokenization: Guillaume LaForge

https://tokens-lpj6s2duga-ew.a.run.app/

Merci à toutes et tous 😃

@_Akanoa_

https://lafor.ge