NLP 自然語言處理

(2) 深度學習

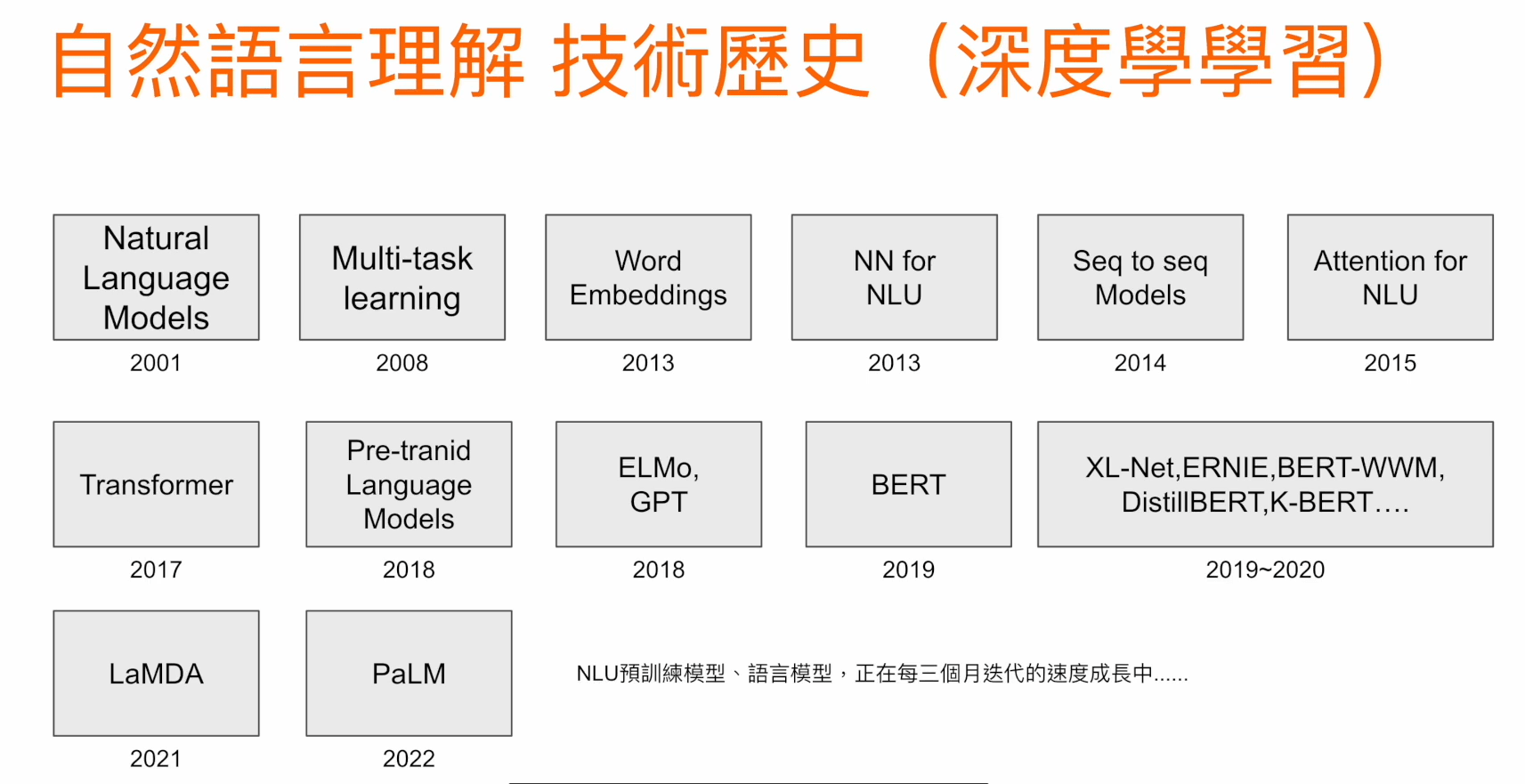

自然語言理解 - 技術歷史

以深度學習為基礎的發展

NLP 的深度學習

2013

運用深度學習的 NLP

word2vec

2014

2017

2018

2020

Seq2seq

Transformer

BERT

GPT-3

透過分散式表徵,模型可以

輸出固定長度的單詞向量

透過注意力機制

使模型能夠平行運算

用龐大的資料進行訓練

成功生成自然的文章

用 Encode-decode 構造的模型提高器翻譯的精度

透過微調在多種任務上

取得高精度的結果

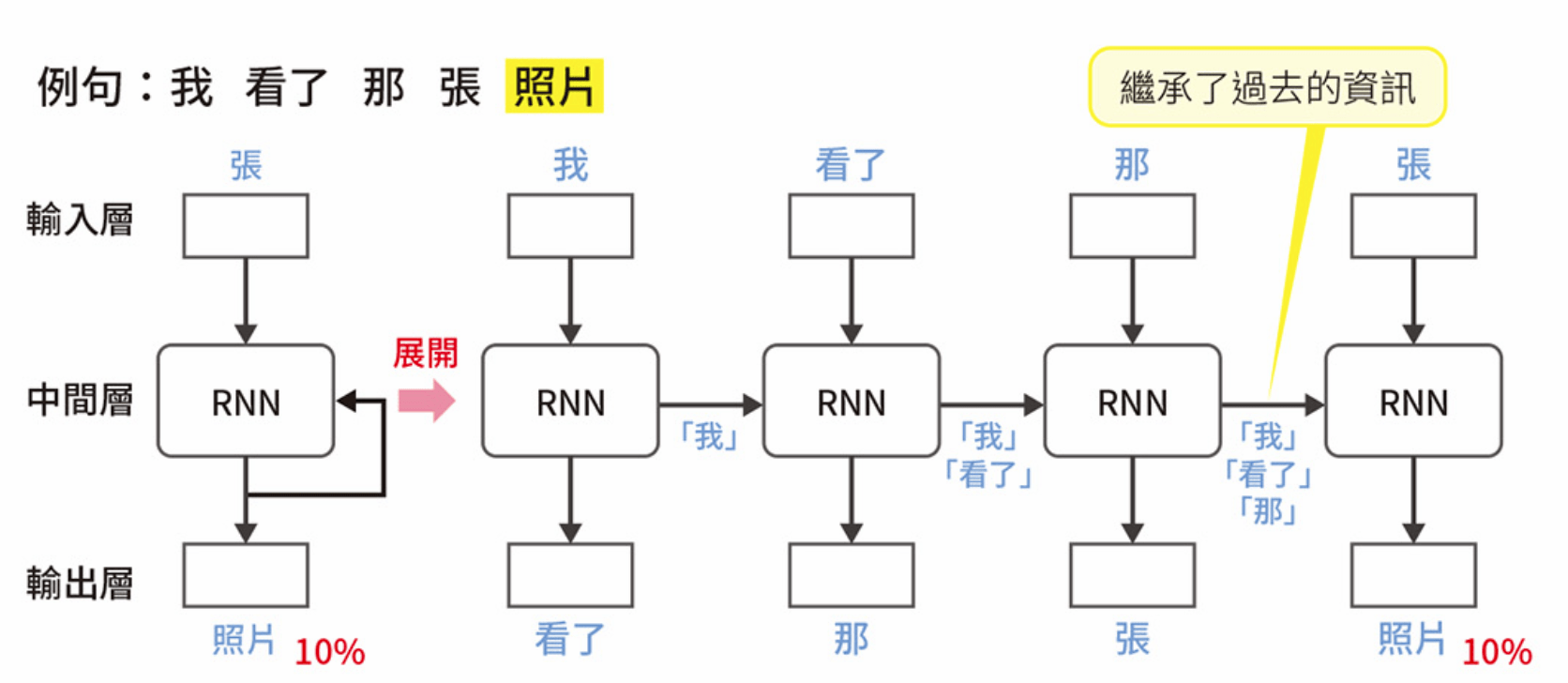

RNN

例句:我 看了 那 張 照片

讓資訊循環進行學習

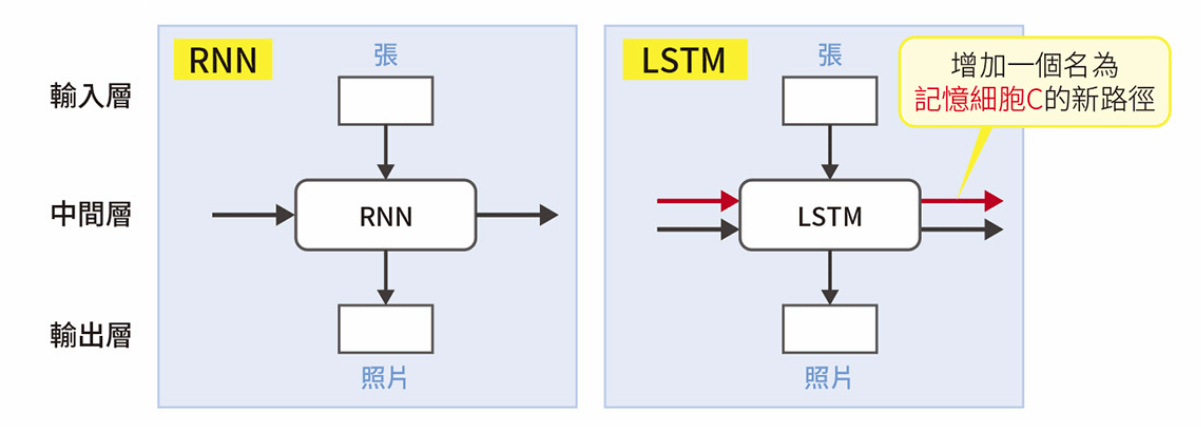

LSTM, Long Short-Memory

RNN 和 LSTM 的差異

會取捨資訊選擇記憶

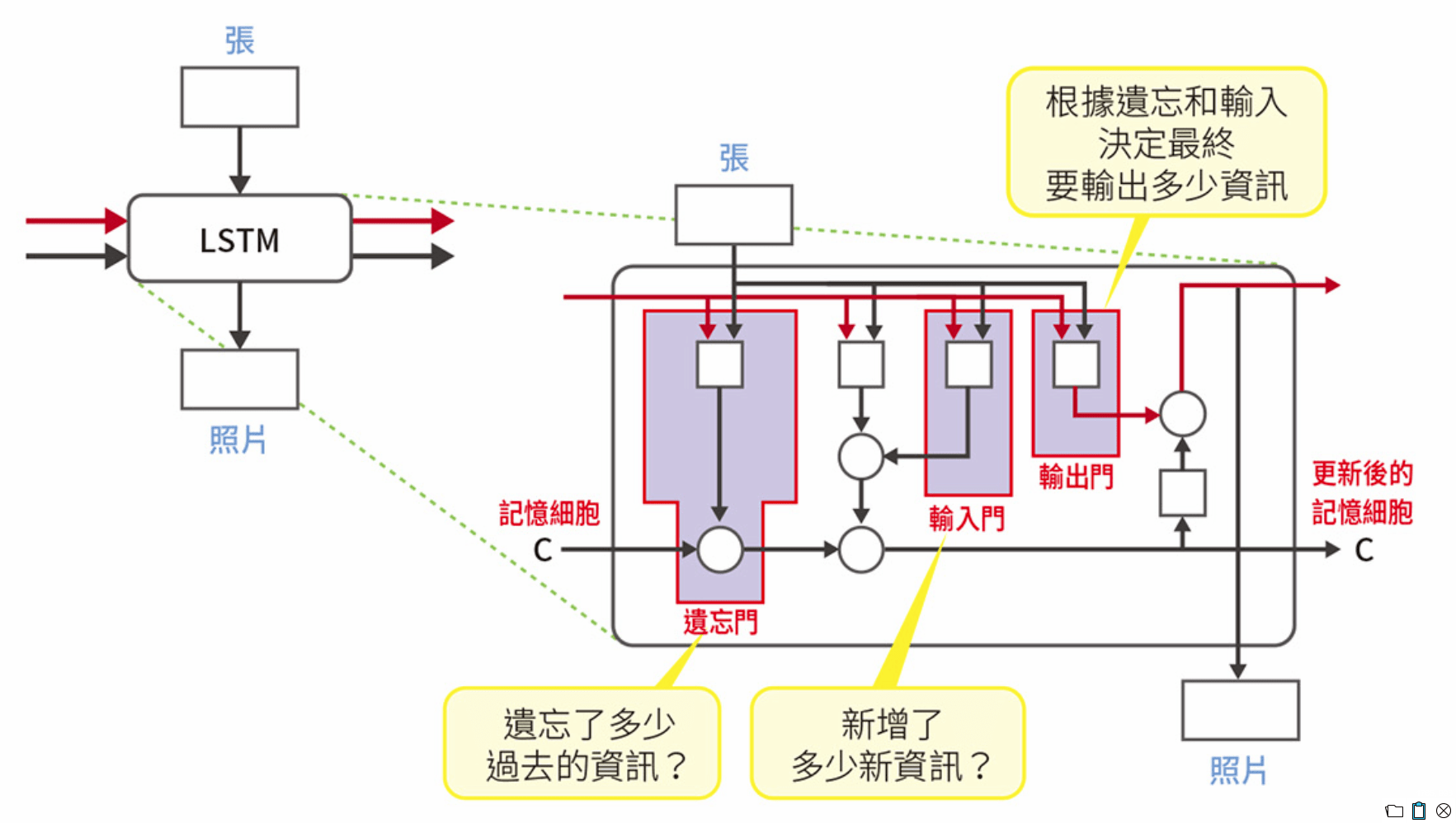

LSTM

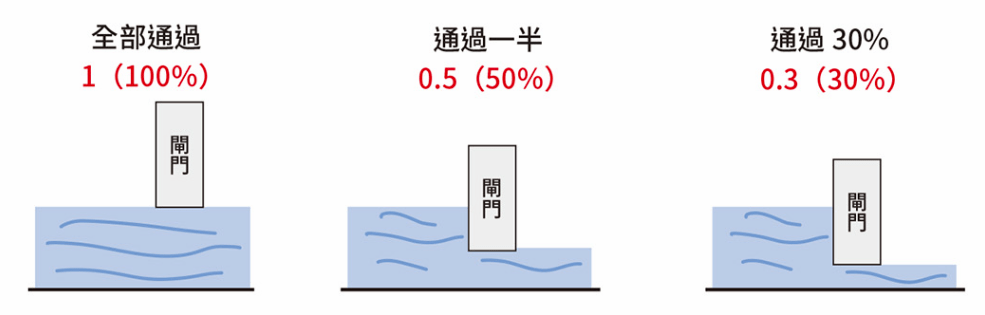

LSTM 的閘門概念

LSTM

LSTM 的構造

LSTM

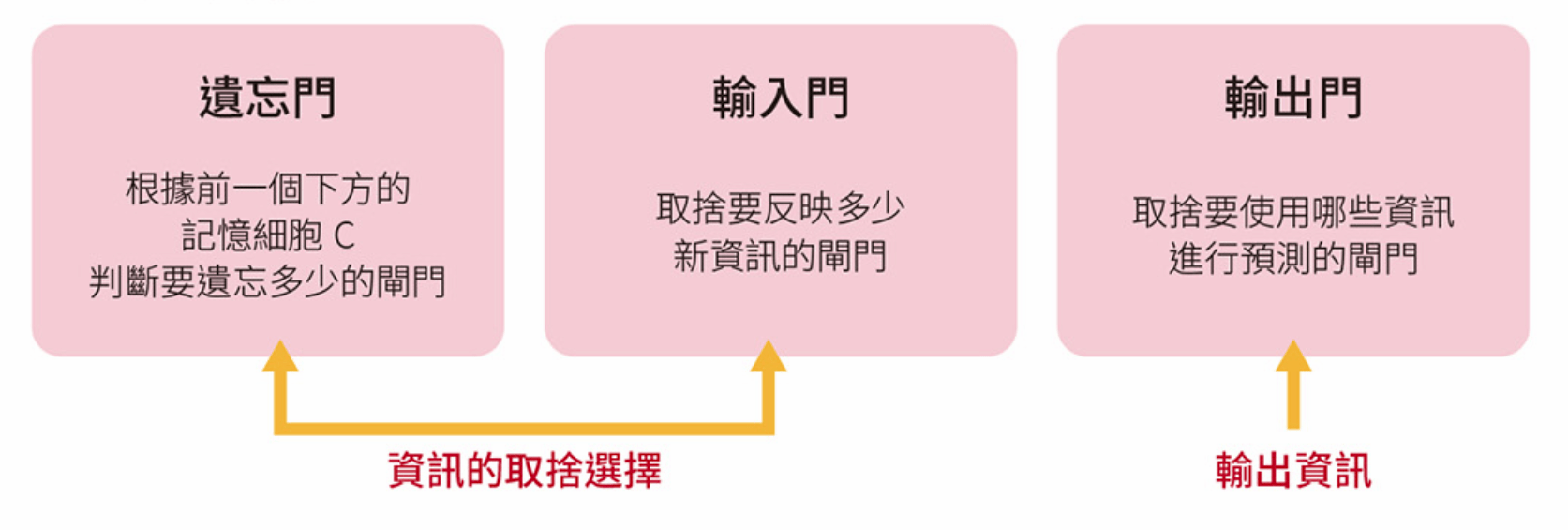

LSTM 的三種閘門

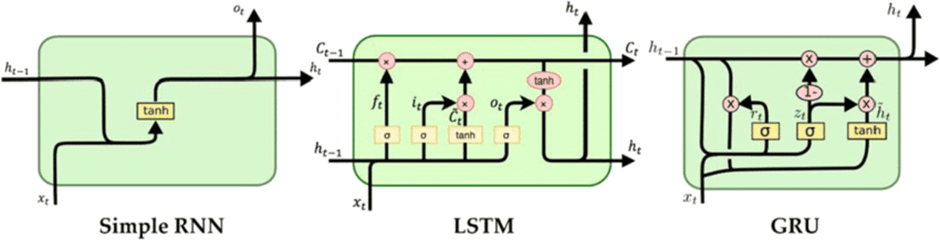

GRU, Gate Recurrent Unit

透過減少閘門數量來縮短計算時間

RNN vs LSTM vs GRU

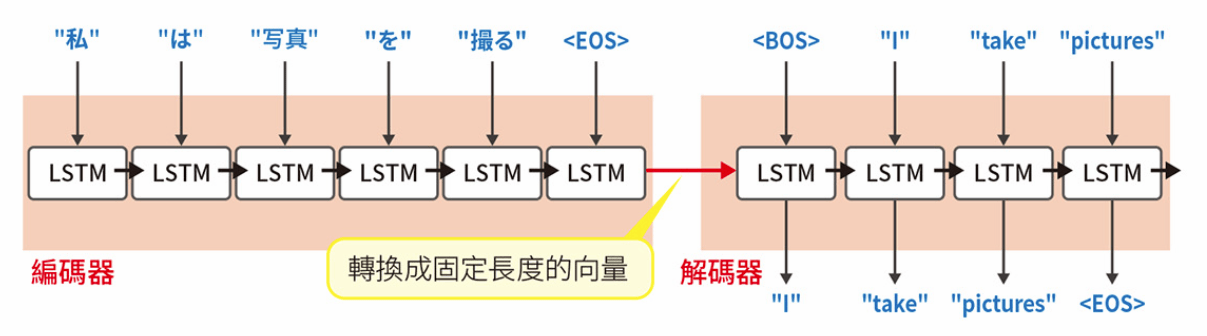

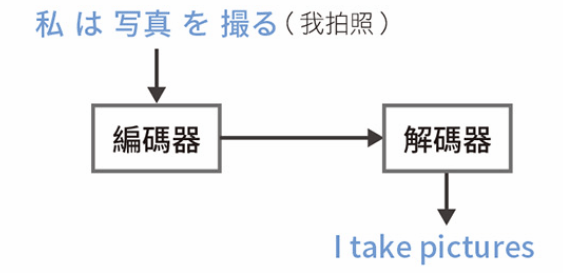

Seq2Seq

輸出的不是單詞,而是序列資料

Sequence to Sequence

又稱為 Encoder-decoder 模型

Seq2Seq (輸出序列資料)

Seq2Seq 的構造

Attention Mechanism

注意力機制

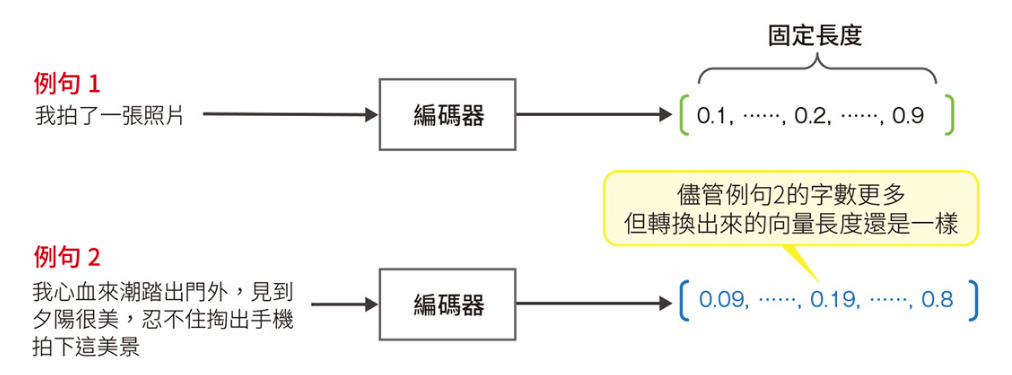

Seq2Seq 的問題

不論輸入的文本是長是短,都會生成固定長度的向量,因此,輸入的文本愈長,模型精度愈低。

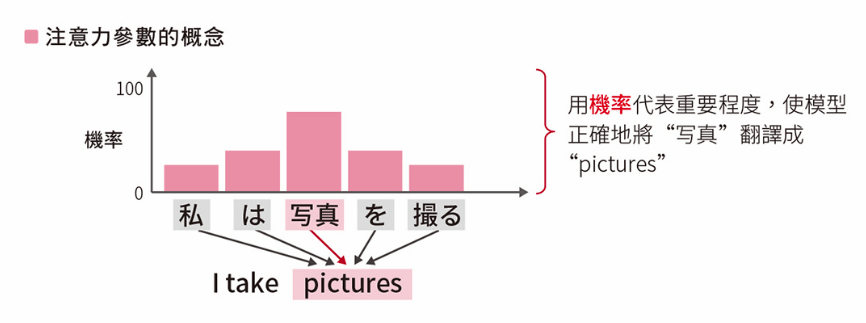

注意力機制

Attention Mechanism

用機率來代表翻譯時用來對照的原始語言中各單字的重要程度

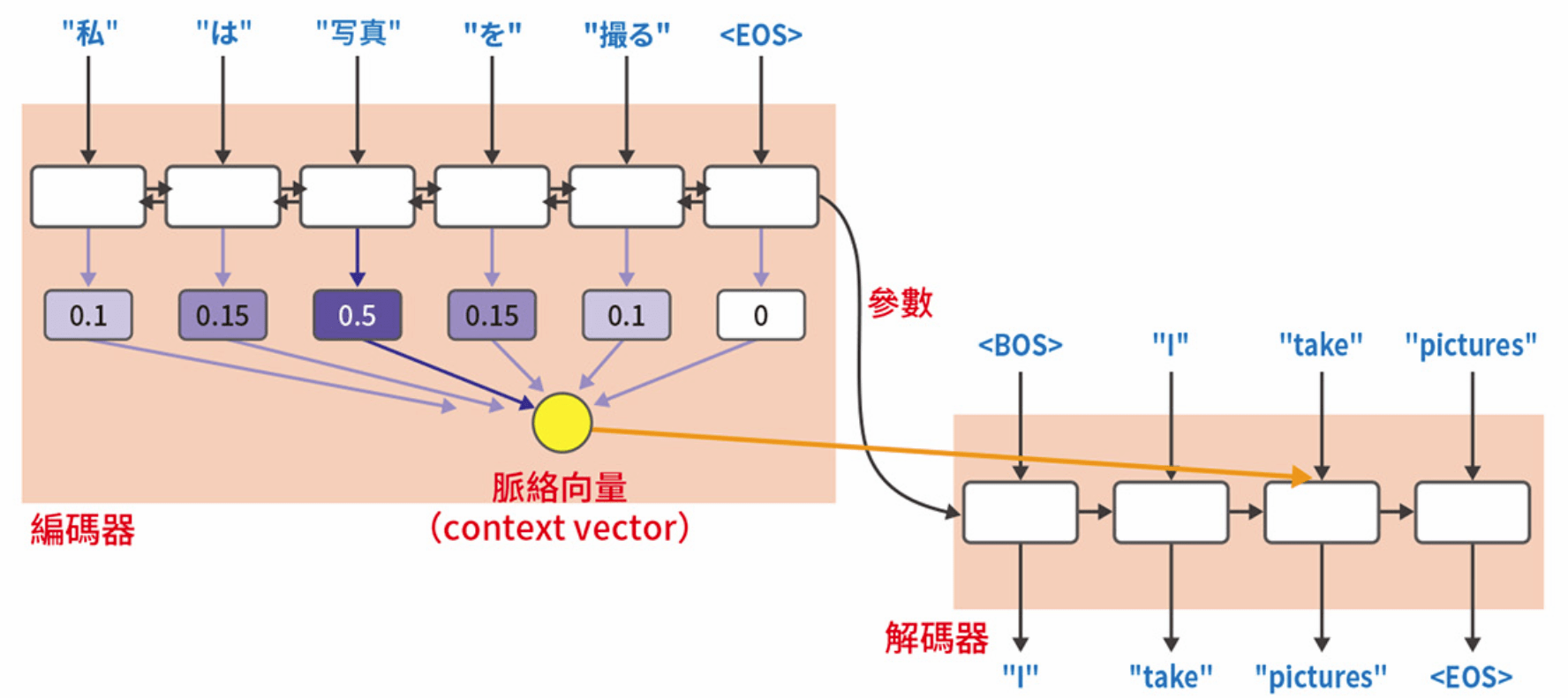

Context Vector 脈絡向量

Seq2Seq (輸出序列資料)

加上注意力機制的 Seq2Seq 結構

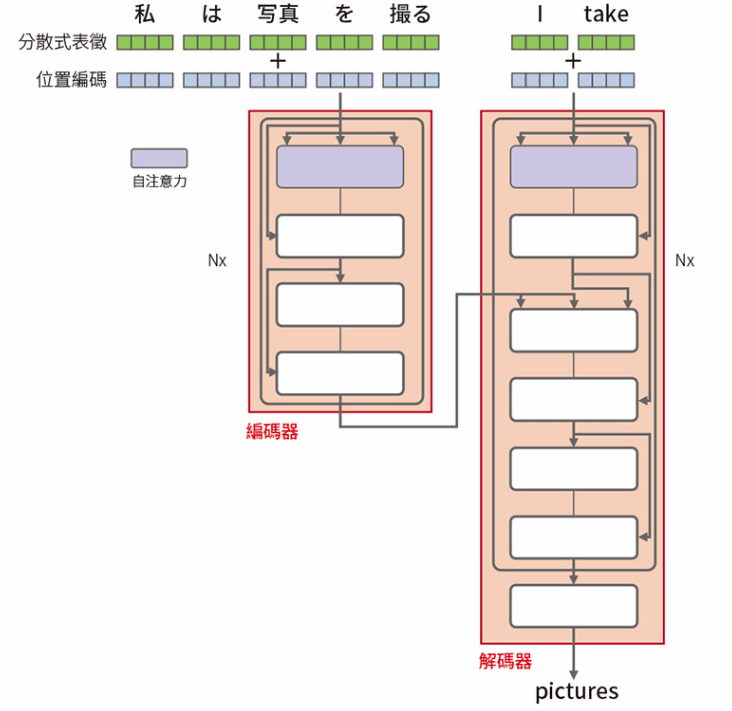

Transformer

可平行計算的自注意力機制

Seq2Seq 的注意力機制是關注:

原始語言文章和目標語言文章之間的對應關係

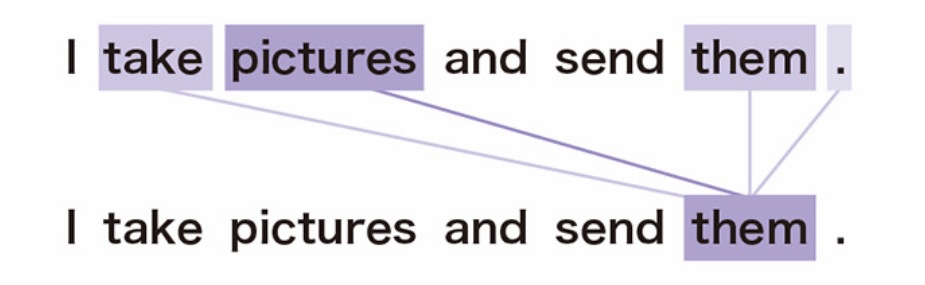

自注意力機制

Transformer 使用『自注意力機制』

Self-Attention

關注「自己」文章的對應關係

舉例:I take pictures and send them.

(我拍了幾張照片,並把它們發送出去)

自注意力機制

先找出輸入文章的各單詞之間的對應關係

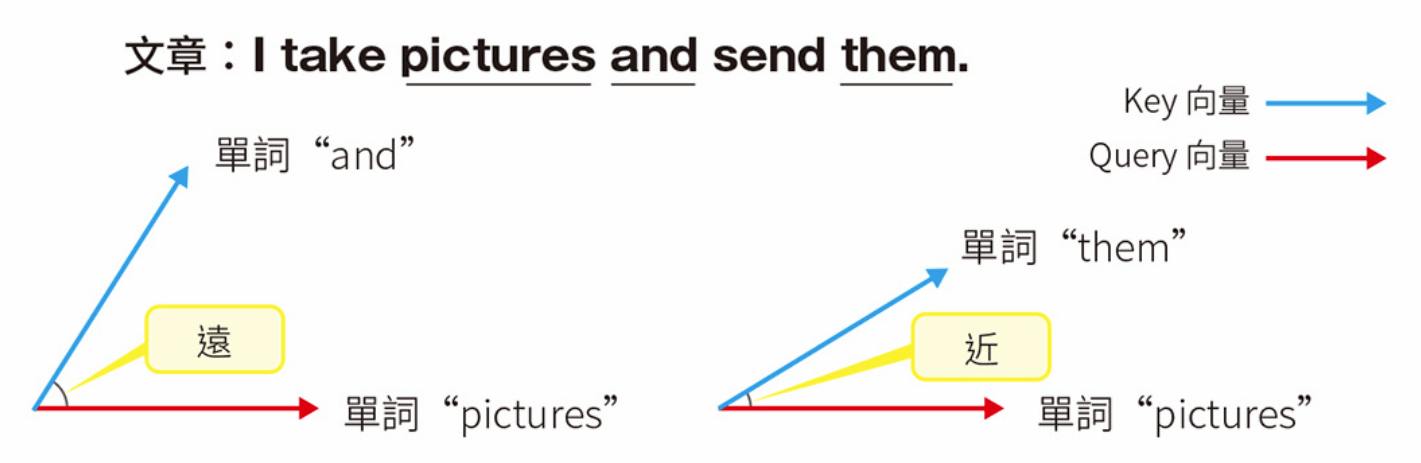

用自注意力計算相似度

可平行計算的自注意力機制

替每個單詞建立 Q (query), K (key) ,V (value) 三個向量

Transformer 透過比較 query 和 key 的向量來計算相似度

Transformer 架構

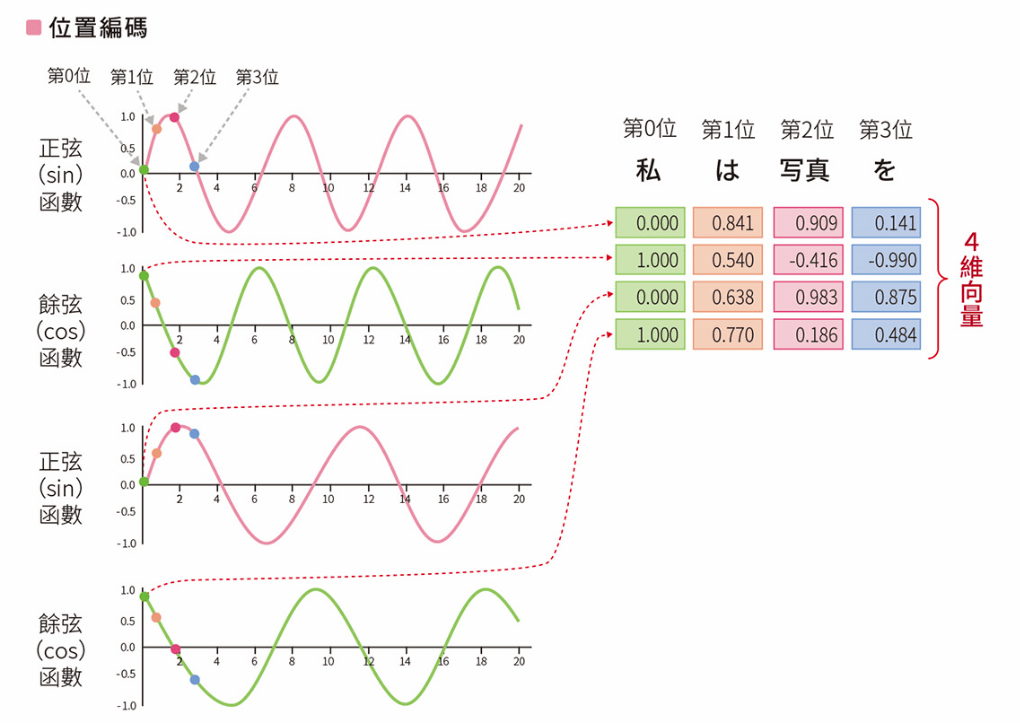

Position Encoding, PE

- Transformer 引進位置編碼的機制來處理各單詞的位置資訊

- 利用正弦餘弦函數將文章中的單詞順序向量化

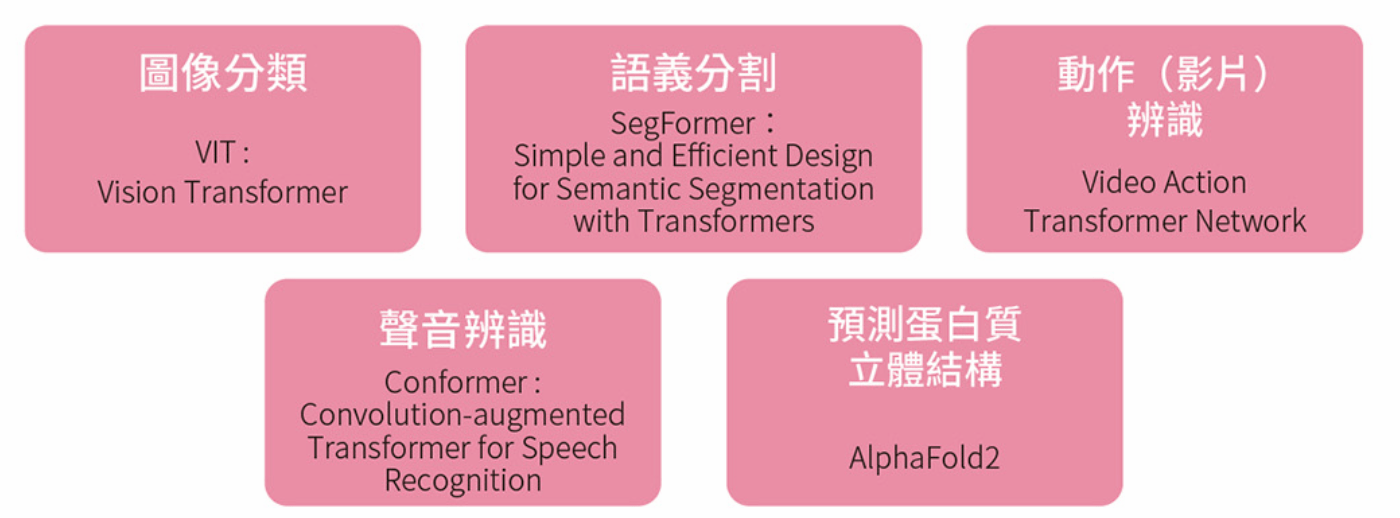

Transformer 主要應用案例

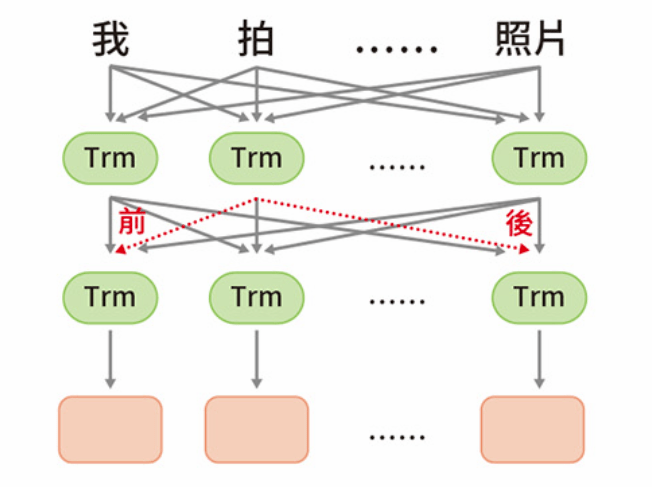

BERT

Bidirectional Encoder Representations from Transformers

(2018, Google)

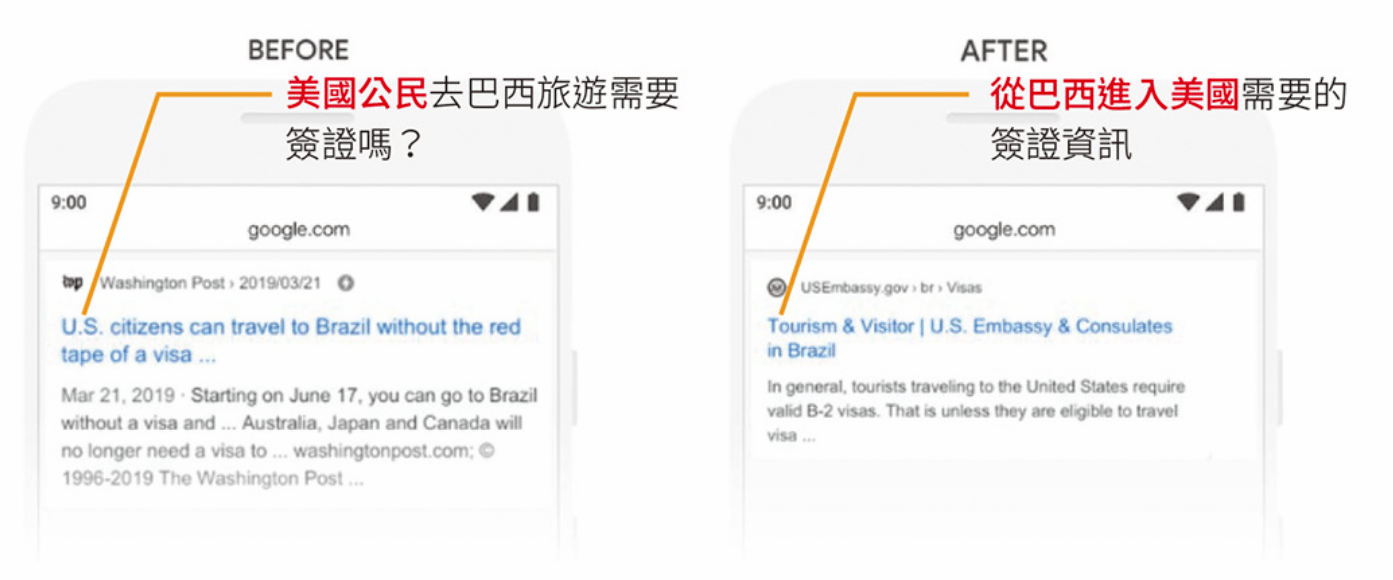

BERT 的應用案例

- Google:『2019 brazil traveler to usa need a visa』

(2019年巴西遊客到美國需要簽証)

重點在『to』介系詞的重要性

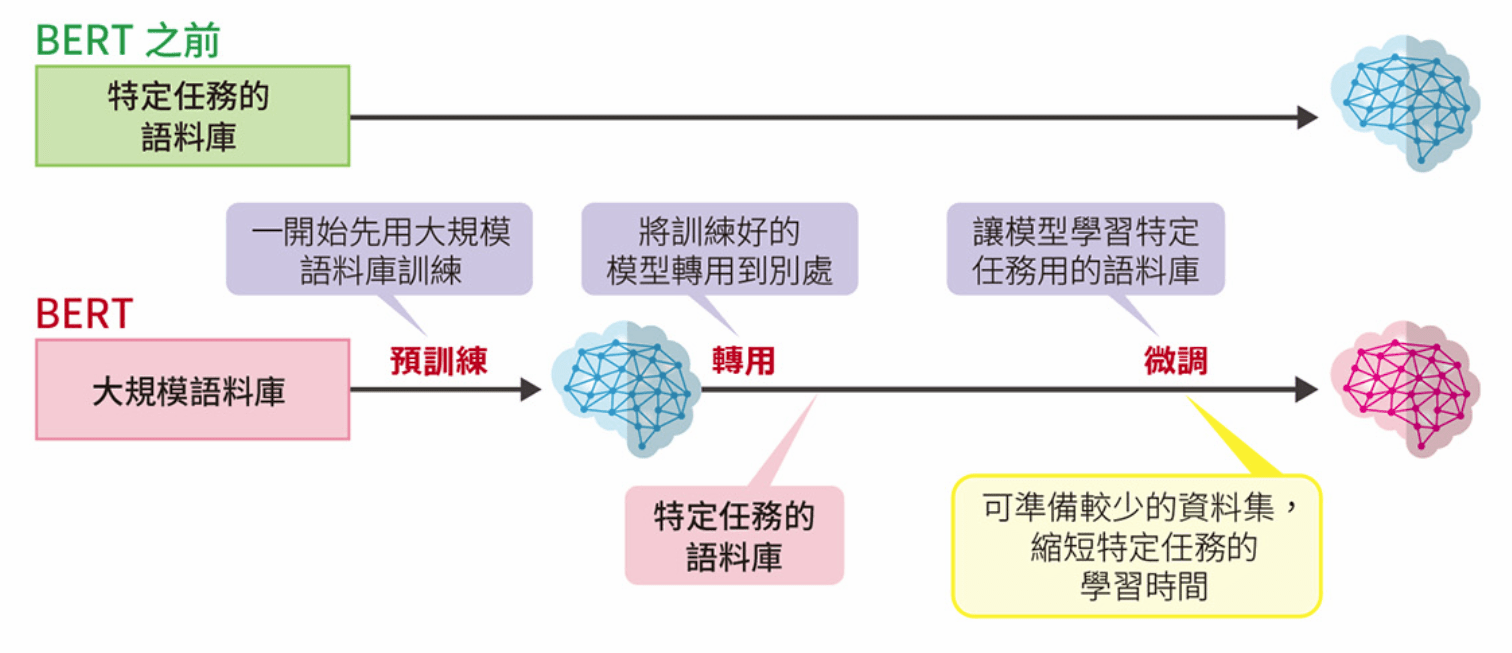

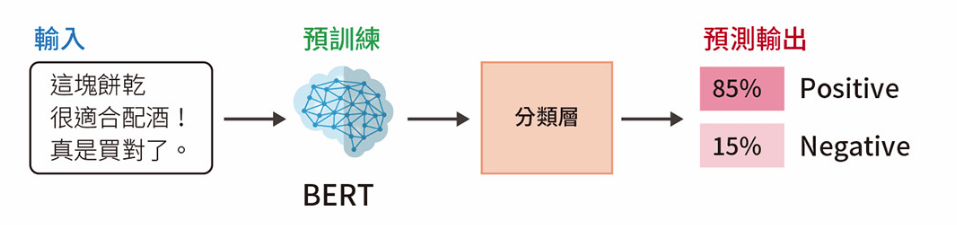

利用預訓練和微調縮短學習時間

- Pre-training

- Fine-tuning

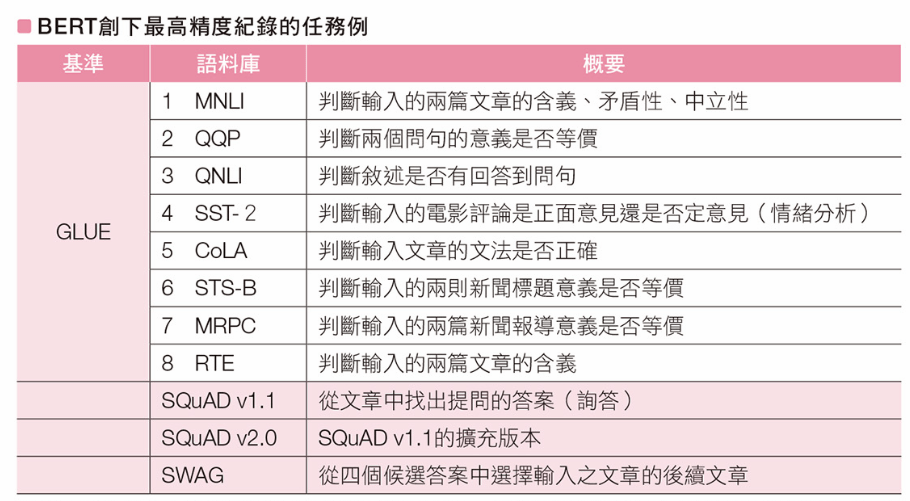

BERT 能表現出較高精度的任務

GLUE (The General Language Understanding Evaluation)

自然語言模型的綜合評價基準

評估語言模型在情緒分析、含義、等價性判斷各方面的性能表現

首次超越人類

的平均正確率

具備雙向性的 BERT

堆疊了 24 層的 Transformer

BERT

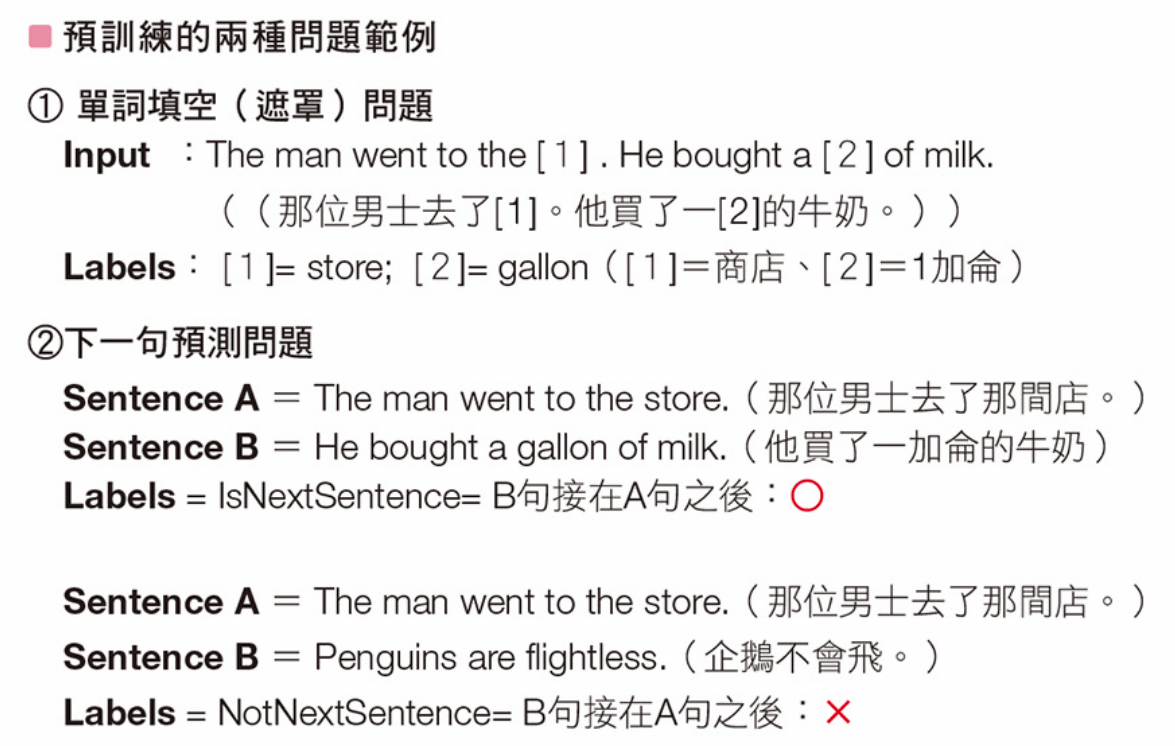

BERT 訓練:

- 使用 16GB (3300 萬個單詞) 來進行雙向預測的預訓練

- 解以下兩種問題:

- Masked Language Model (單詞填空)

- Next Sentence Prediction, NSP (下一句預測)

BERT

BERT 微調的概念

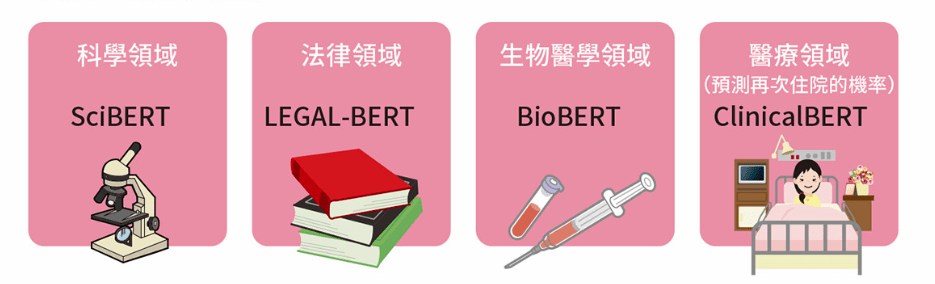

BERT 的應用領域

GPT-3

Generative Pre-Training

OpenAI's GPT-3 may be the biggest thing since bitcoin

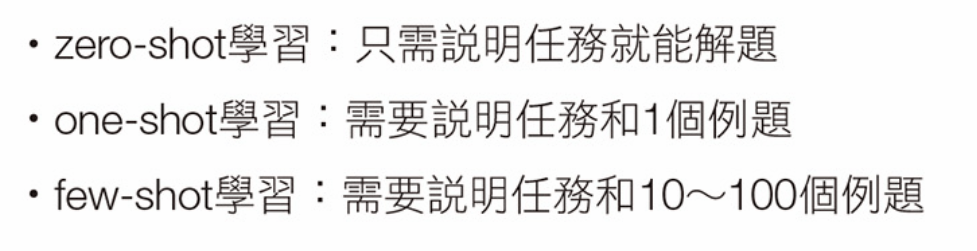

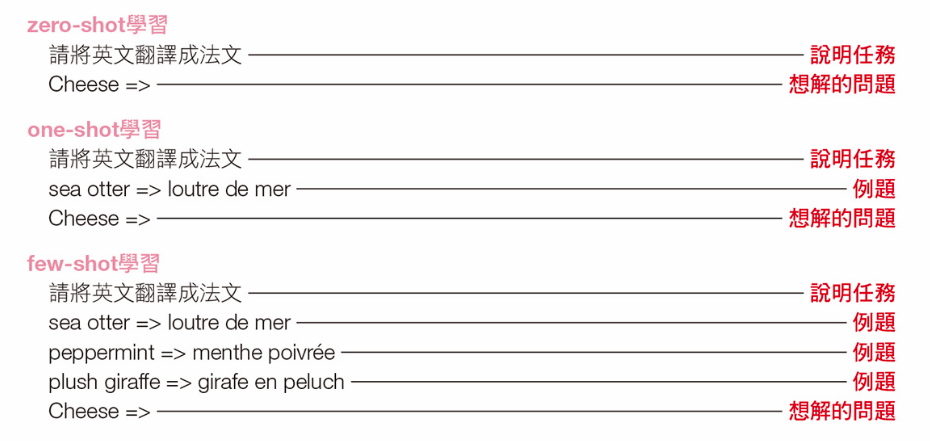

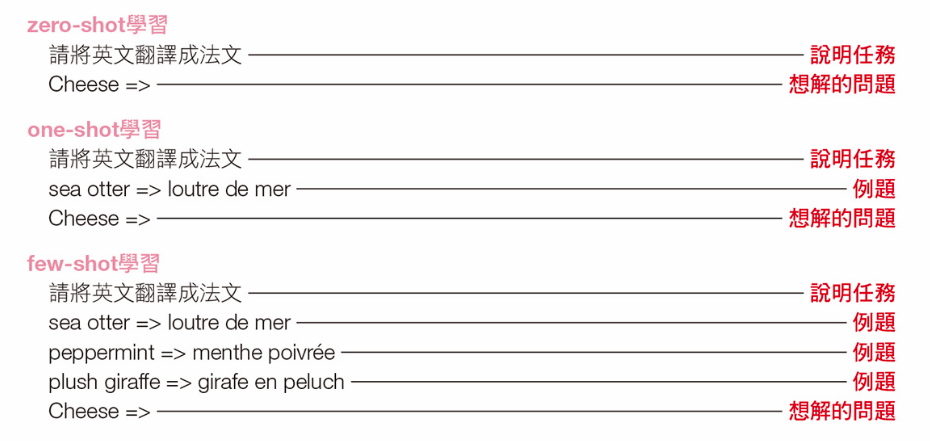

易於處理特定任務的三種學習方法

易於處理特定任務的三種學習方法

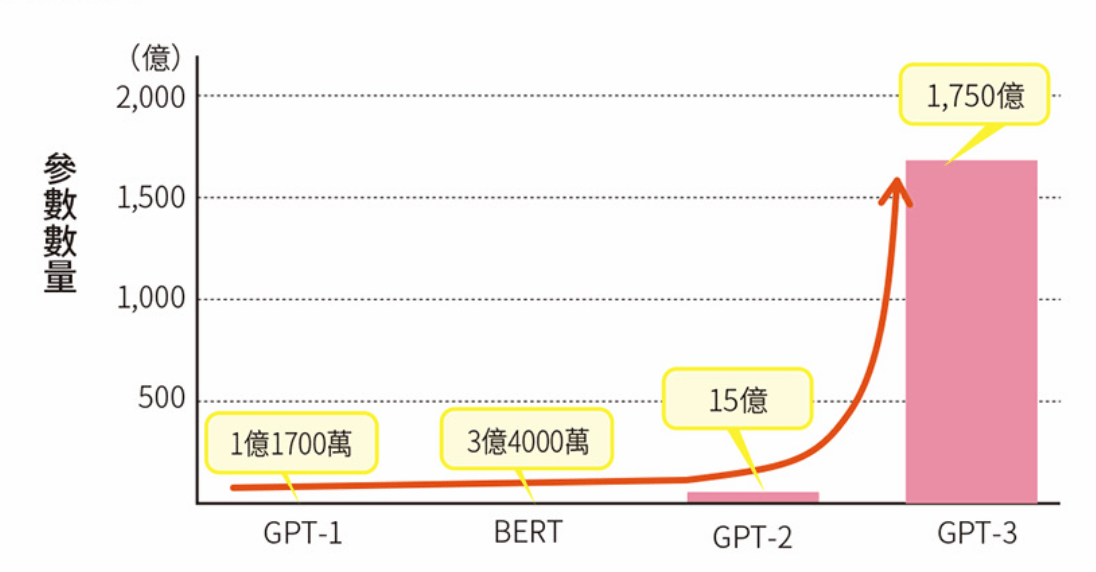

GTP-3 龐大的參數數量

Transformer 層數

12

48

96

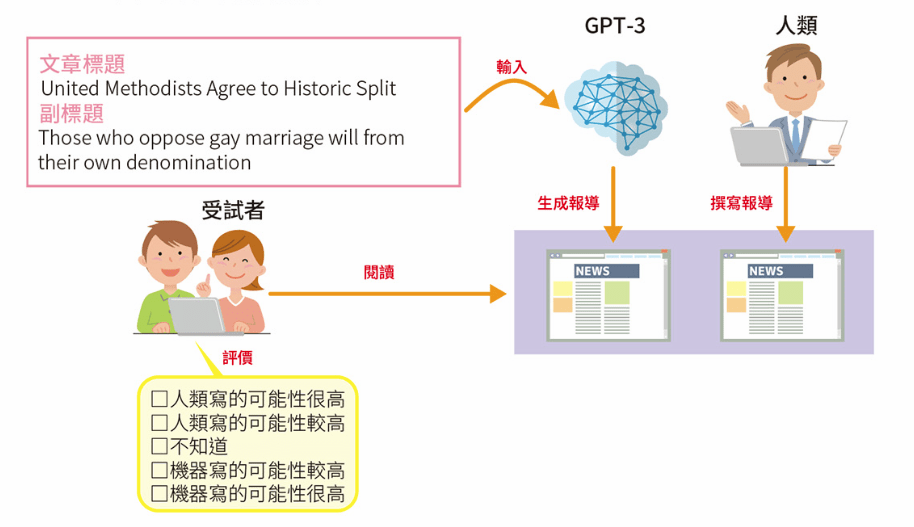

GTP-3 生成之文章的品質評價

正確判斷出「這是 GPT-3 生成文章」的受試者:52%

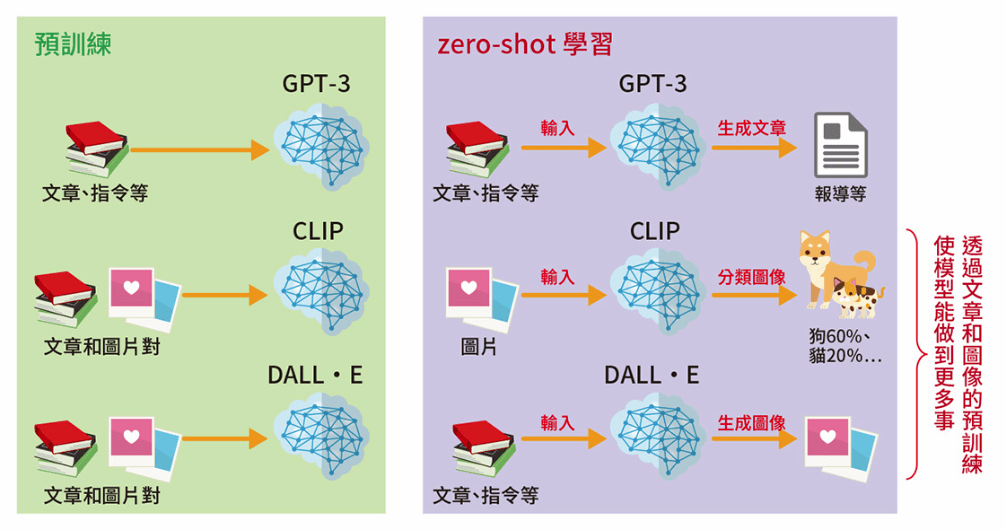

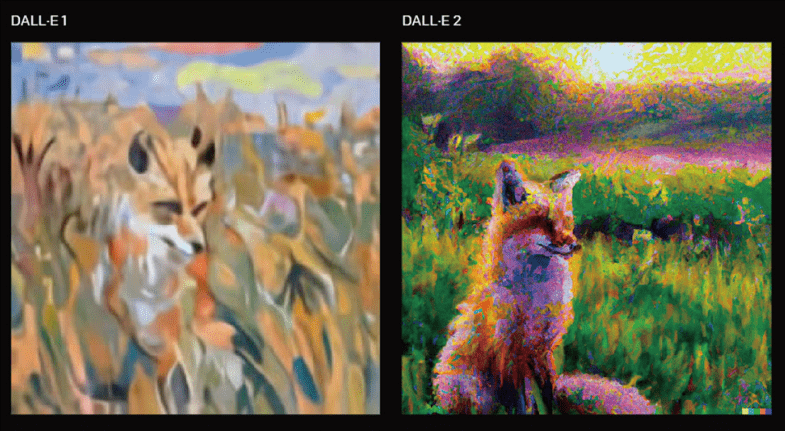

改進文字和圖像輸入的趨勢

GPT-3 之延伸

- CLIP, Contrastive Language Image Pre-training

輸入圖片後用 zero-shot 對圖片進行分類

- DALL.E

輸文章後用 zero-shot 生成圖片

- 更多模型應用:

- DALL.E2 (四倍的寫實圖片)

- Stable Diffusion

- Midjourney

- Imagen

- ......

生成圖片

a painting of a fox sitting in a field at sunrise in the style of Claude Monet