Backpropagation

Marcelo Finger Alan Barzilay

Função custo (Loss)

Utilizando um modelo chegamos em uma previsão ŷ, como saber se esta é uma boa previsão?

Text

Função custo (Loss)

A função custo é responsável por quantificar o quão distante nossa previsão esta do valor esperado, quanto maior o custo, pior a previsão.

Logo, a otimização de nosso modelo pode ser formulada como uma minimização da função custo.

Função custo (Loss)

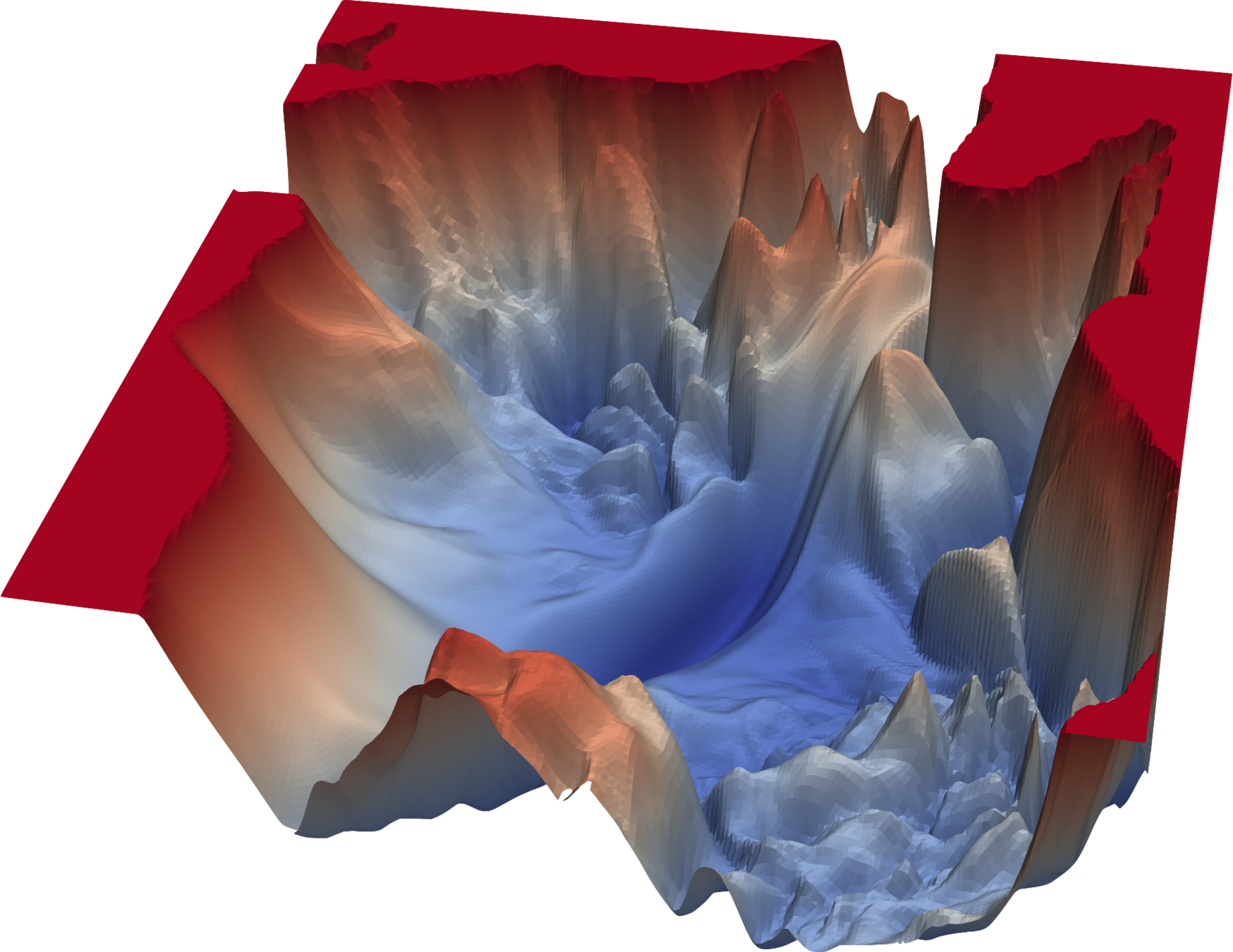

Uma estratégia comum é caminhar no sentido contrario ao do gradiente para encontrar um mínimo da função custo:

Essa estratégia é conhecida como gradiente descendente

Função custo (Loss)

A funcão custo nem sempre é convexa, podemos encontrar um mínimo local ao invés de um mínimo global

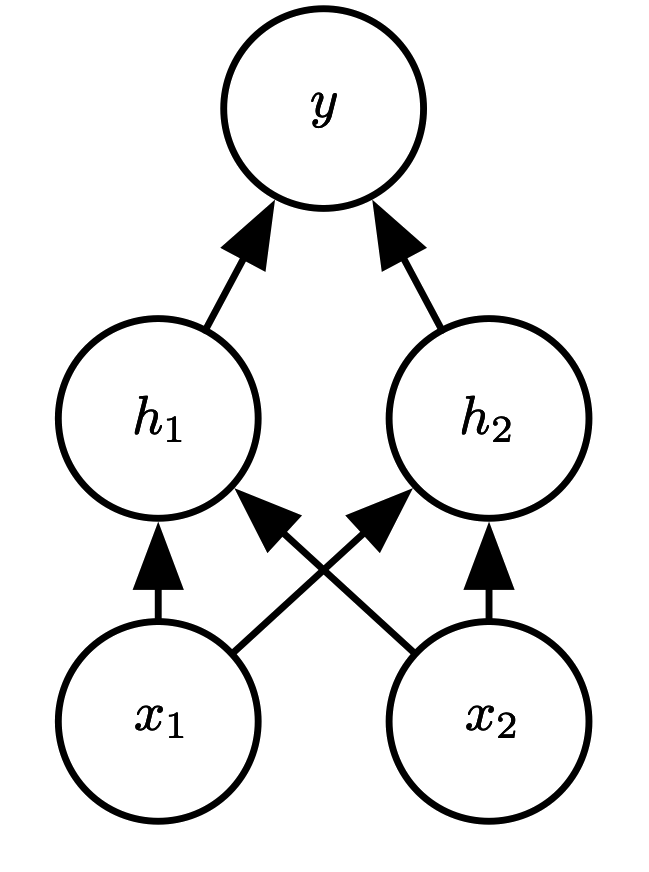

Como realizar gradiente descendente numa rede neural?

Backpropagation

O algoritmo de backpropagation pode ser dividido em 3 partes:

- passo para frente, com os pesos atuais

- calculo da loss

- passo para trás, atualizando os pesos

Backpropagation

Cálculo da loss

passo para frente

passo para trás

Backpropagation

Quando propagamos para trás o gradiente do custo, nós nos utilizamos da regra da cadeia para percorrer a rede

Para se aprofundar

Titulo Proxima Aula

Proxima aula!