Reinforcement Learning course

Artem Sorokin

Pavel Temirchev

Sergey Ivanov

Instructors:

Our team

- Artem Sorokin

- Lead Researcher at AIRI

- PhD student at MIPT

- Category Prize at Animal AI Olympics'19

- 2nd place at DeepHack.RL'17

- Pavel Temirchev

- Software Developer at Yandex

- PhD student at Skoltech

- Sergey Ivanov

- PhD student at Lomonosov MSU

As a team, we have conducted several RL courses:

- Lomonosov MSU course at CMC department

- YSDA course: "Advanced topics in RL"

- HSE course: "Reinforcement Learing"

Reinforcement Learning Problem

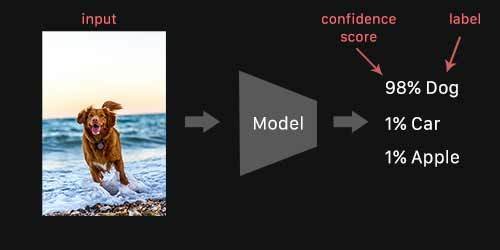

Supervised Learning case:

- Train a model to imitate expert decisions:

Reinforcement Learining case:

- we don't know the right decisions:

Reinforcement Learning Problem

Reinforcement Learining case

- but we know when result is good:

Reinforcement Learning Problem

RL Setting

action

observation

and reward

Learn optimal actions

to maximize the reward

agent

environment

RL is a harder problem

Rewards provide less information than ground truth:

fox

bread

truck

dog

0.

0.

0.

1.

We have ground truth labels!

fox

bread

truck

dog

-3

We have rewards

?

?

?

Other problems include:

- Distributional Shift

- Credit Assignment Problem

- Reward Specification

Is it just an optimal control?

NO!

environment is unknown

Exploration vs. Exploitation

Not just EXPLOITATION

Where it is applicable?

Everywhere and nowhere!

Why should you participate?

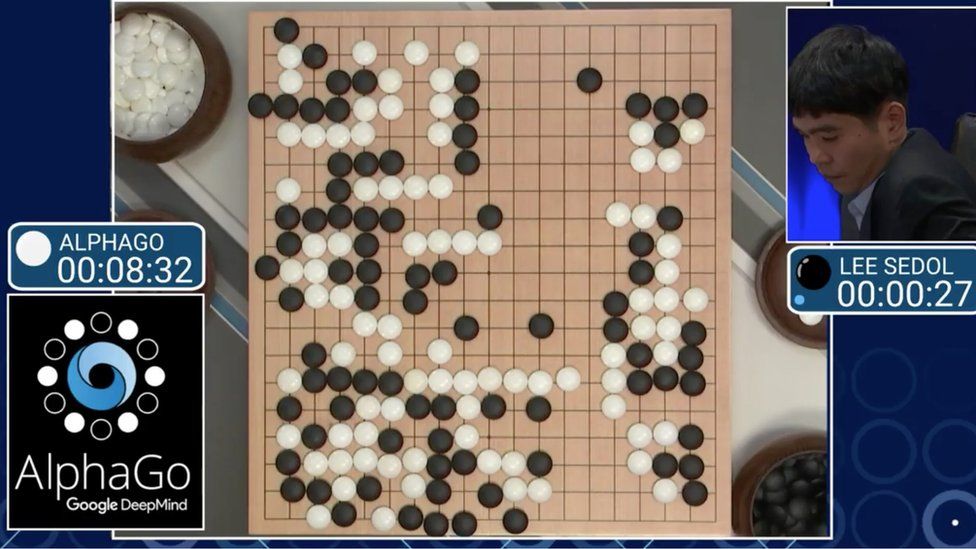

RL is developing rapidly

Over-performs humans in many tasks

A lot of competitions are available

Can help solve your own problem

It is just interesting

Состав Курса:

Основы RL:

- Введение

- Динамическое программирование

- Табличное обучение с подкреплением

Глубокое обучение с покреплением:

- Глубокое обучение с подкреплением и DQN

- Градиент по стратегии 1

- Градиент по стратегии 2

- Задача непрерывного управления

- Аппроксимация распределения будущих наград

Продвинутые темы в RL:

- Планирование

- Проблема исследования и использования

- Перенос знаний и Мета-обучение

- Память в обучении с подкреплением

Simple Homeworks

Big Important Homeworks

Almost No Homeworks :(

Итоговые Оценки

Оценка выставляется по десятибальной шкале.

Планируется 6 заданий. Задания приносят 2 или 1 балла в зависимости от сложности.

Если задание сдается в течение двух недель после дедлайна, то ценность задания составляет 80% изначальной, если позже то только 60%.

В конце курса будет необязательный тест общей стоимостью в 2 балла.

Детали:

- Все домашки во время: отлично / 10 баллов

- Все домашки в последний момент + идеальный тест: отлично / 8 баллов

- Только тест: неуд / 2 балла

Thank you for your attention!