by deeplearning.ai

딥레스콜라 스터디그룹

모두의연구소 DLC 강화학습Lab 박석

Week 1

Welcome

AI = New Electricity ?

Leading Big Transformation

This course

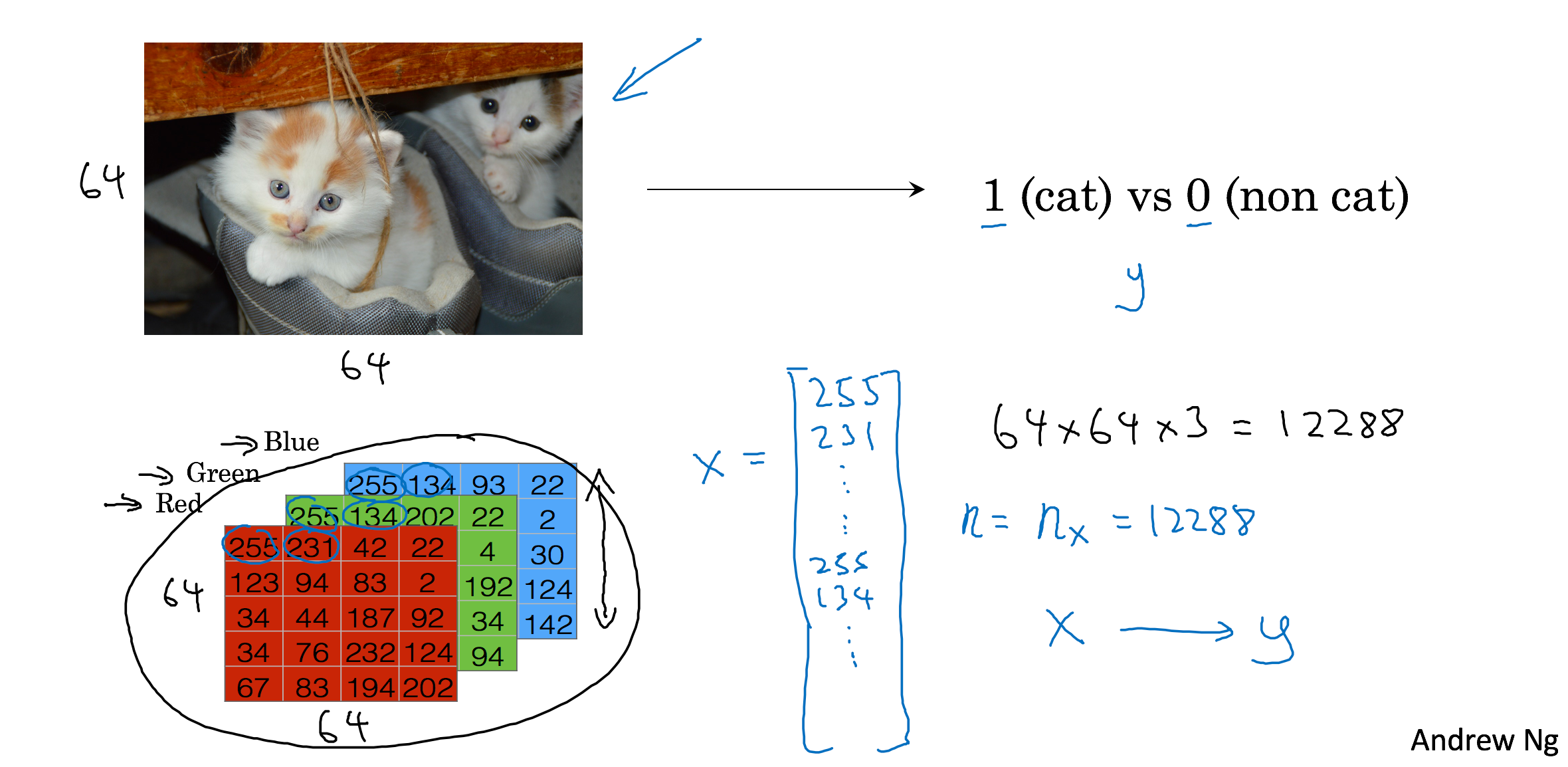

- Neural Networks and Deep Learning - Cat Recognition

- Improving DNN by Hyper-parameter Tuning, Regularization and Optimization

- Structuring your ML Project - Train/Dev/Test - Very Tough

- Convolutional Neural Network - Image

- Natural Language Processing - building sequence model by RNN,LSTM

Intro

Introduction

to deep learning

Be able to explain the major trends driving the rise of deep learning, and understand where and how it is applied today

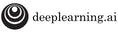

What is neural network?

It is a powerful learning algorithm inspired by how the brain works.

Example 1 - Single NN

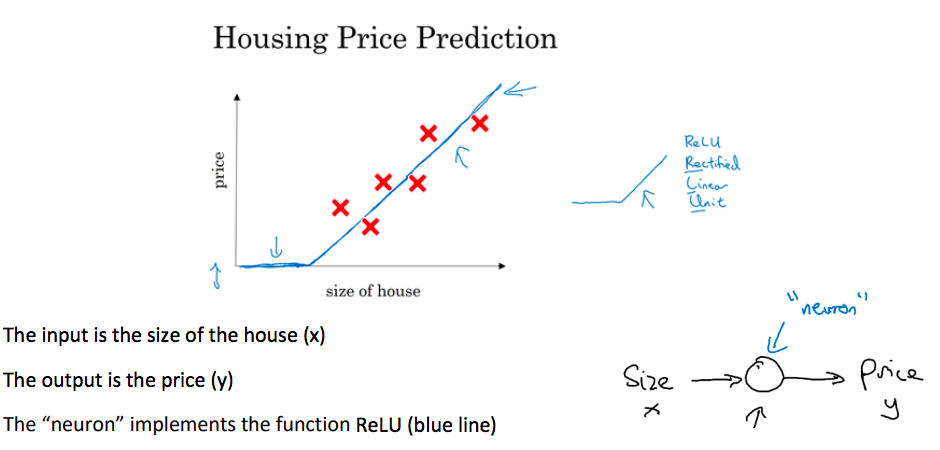

Example 2 - Multiple NN

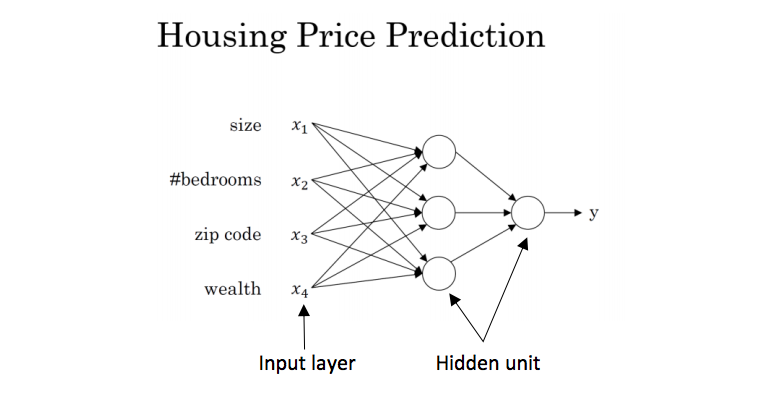

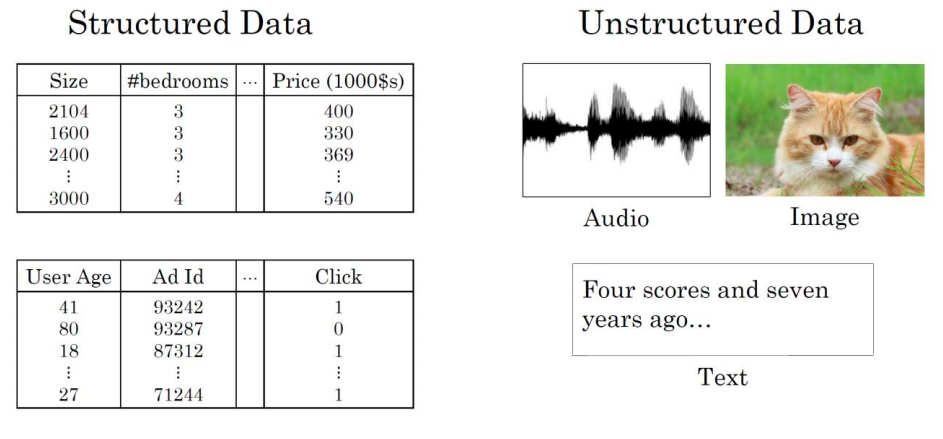

Supervised learning for Neural Network

In supervised learning, we are given a data set and already know what our correct output should look like, having the idea that there is a relationship between the input and the output.

Supervised learning problems are categorized into "regression" and "classification" problems.

Examples - SL

Structured vs. Unstructured

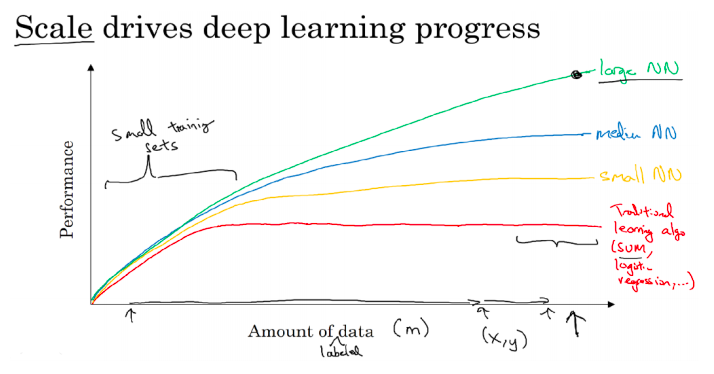

Why DL is taking off?

Deep learning is taking off due to a large amount of data available through the digitization of the society, faster computation and innovation in the development of neural network algorithm.

Data + GPU H/W + Algorithm

1. Being able to train a big enough neural network

2. Huge amount of labeled data

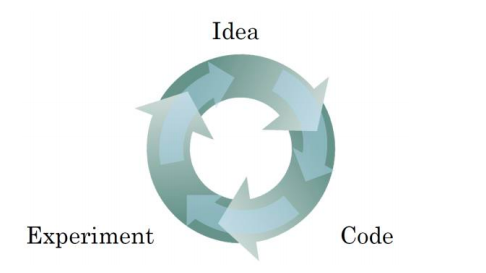

Iterative NN Training Process

Faster computation helps to iterate and improve new algorithm

Interview

Geoffrey Hitton

- 1966 : 고등학교시절, 수학을 잘했던 친구로 부터 인간두뇌 홀로그램을 보게 되면서 처음 관심을 갖게 됨(Lashley's experiments : 기억은 두뇌의 여러부분에 흩어져서 저장되어 있다는 사실을 실험)

- 대학시절 : physiology and physics 로 시작...philosophy...결국...psychology 선택..."지능이란 무엇인가?" 라는 문제 풀기..

- psychology는 해답을 주지 못했다...carpenter

- PhD in AI @Edinburgh in Britain...couldn't get a job

- 1982 : backprop algorithm 연구 시작 @UCSD in California w/ David Rumelhart and Ron Williams ( 실제 최초의 아이디어는 Rumerlhart 것이지만...논문으로 최초로 나온 것은 Paul Werbos 이었다. 별로 관심을 받지 못했음)

- 1986 : backprop algorithm 논문발표 into Nature

- 1990 : Word Embedding 를 이야기 하기 시작 w/ Benzio

Geoffrey Hitton's Story

- 가장 멋진일 : Boltzmann machines 을 w/ Terry Sejnowski 발견한 일

- 2007 : resurgence of neural net 을 이끌어 내어 현재의 Deep Learning 이 나온 것은 restricted Boltzmann machines 의 역할이 크다.

- 1993 : 1st variational Bayesian learning 관련 논문 발표 w/ Van Camp

- 2014 : @Google about using ReLUs and initializing with the identity matrix

- 1987 : recirculation algorithm w/ Jay McClelland ( euroscientists의 Spike-timing-dependent plasticity 이론과 같음...where the new thing is good and the old thing is bad in the learning rule.)

- 2015 : Multiple Time Skill w/ Jimmy Ba => LSTM

- Now : have a little Google Brain team in Toronto => Unsupervised Learning, Wegstein algorithm, GAN

Geoffrey Hitton's Story

Hinton's Advice

-

Keep on doing

-

Never stop programming

-

Go for it and find out

<학생들에게>

- 같은 관심 주제를 가진 Advisor를 찾아라.

<회사원들에게>

- 모든 조직은 Revolution에 느리게 되어 있다.

- 회사 안의 교육이 중요.

Paradigm Shift

Von Neumann

Symbolic(=Rule) AI

Current AI : reasoning

Logic

Symbolic Expression

Reasoning

Big Vector

[Symbolic AI]

- 인간이 세상의 규칙, 체계를 기술하여 만듬. (온톨로지라고도 할 수 있음)

- 어떤 것에 적용할 수 있는 룰인가 정의 필요. 따라서 Symbol을 정의 함. 그래서 이름이 Symbolic AI

- 단점

1. 룰을 정의하기 어려운 것이 많음. 사람의 이해가 부족할 수도

2. 룰 정의시 사람의 기록 과정에서 손실이 있음. 따라서 Hole이 많이 생김

[Current AI]

[Machine Learning]

- Input - Output 넣어주고 Machine이 알아서 모델을 만들도록 한다.

- 데이터 기반의 학습으로 충분한 데이터가 필요하다.

- 신경망, Decision Tree, SVM

[Decision Tree]

- Rule AI와 비슷하지만 다름

- Decision Tree는 어떤 결정에 필요한 Threshold 값을 스스로 만듬

[Support Vector Machine]

- 대조군 2개를 나누려한다.

- 두 집단간 거리가 가장 먼 Vector를 찾는

- n 차원이라 기묘하게 꺾여 있음.

출처: http://runningup.tistory.com/71 [RunningUP]

[신경망]

- Input, Hidden Layer, Output으로 이루어짐.

- Hidden Layer가 3개 이상이면 Deep이라고 함. ( Hidden Layer가 많아지면 성능이 좋아질 것이라는 것을 알지만 예전에는 Layer를 늘렸을 때 Training을 시키는 방법을 찾지 못했었음)

- Deep Learning : 2006 3 Layer 이상 학습 방법 만듬, 학습 방법 + Architecture 를 말함

Week 2

One

Logistic Regression with Neural Network

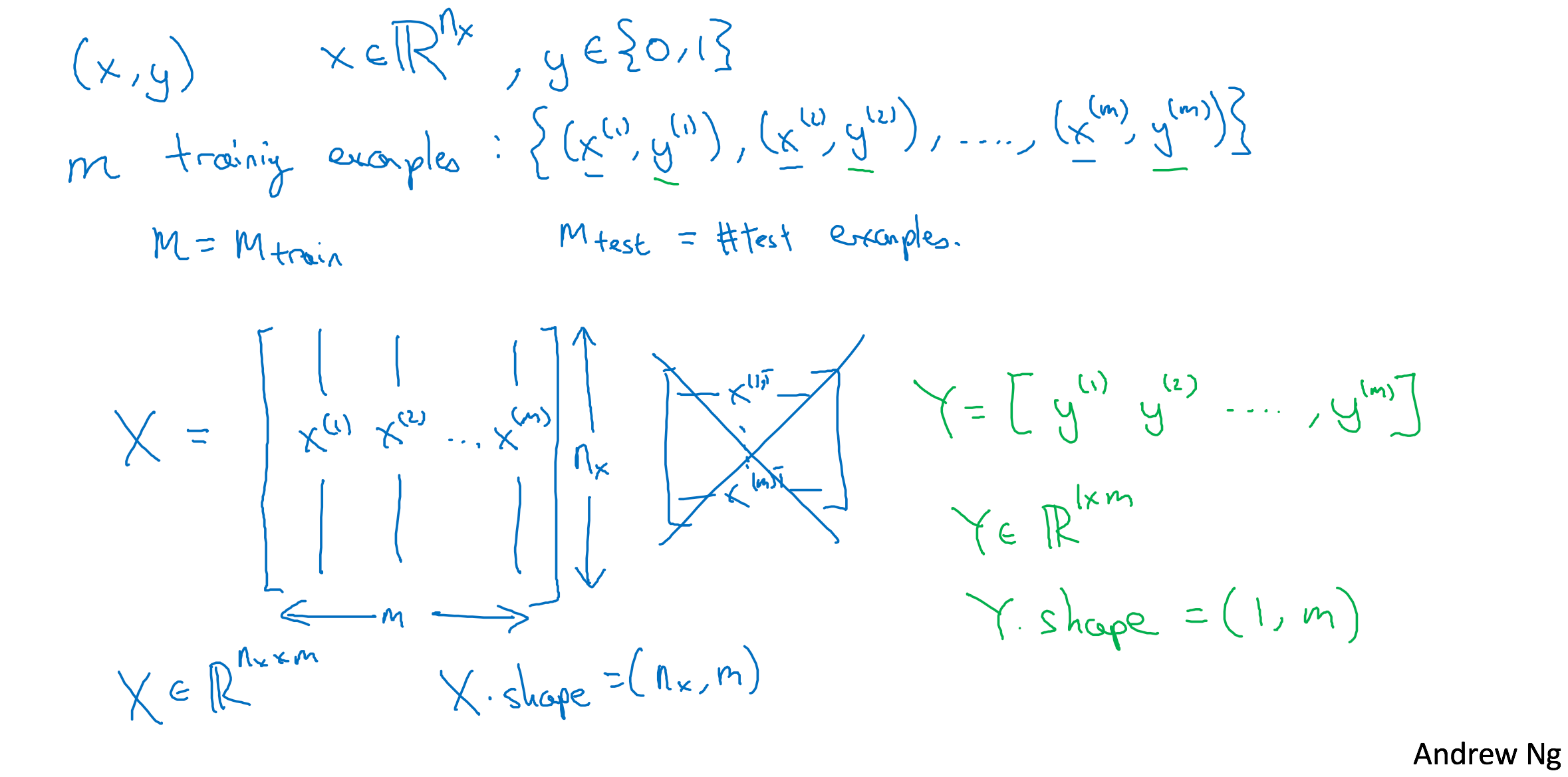

Binary Classification

Notation

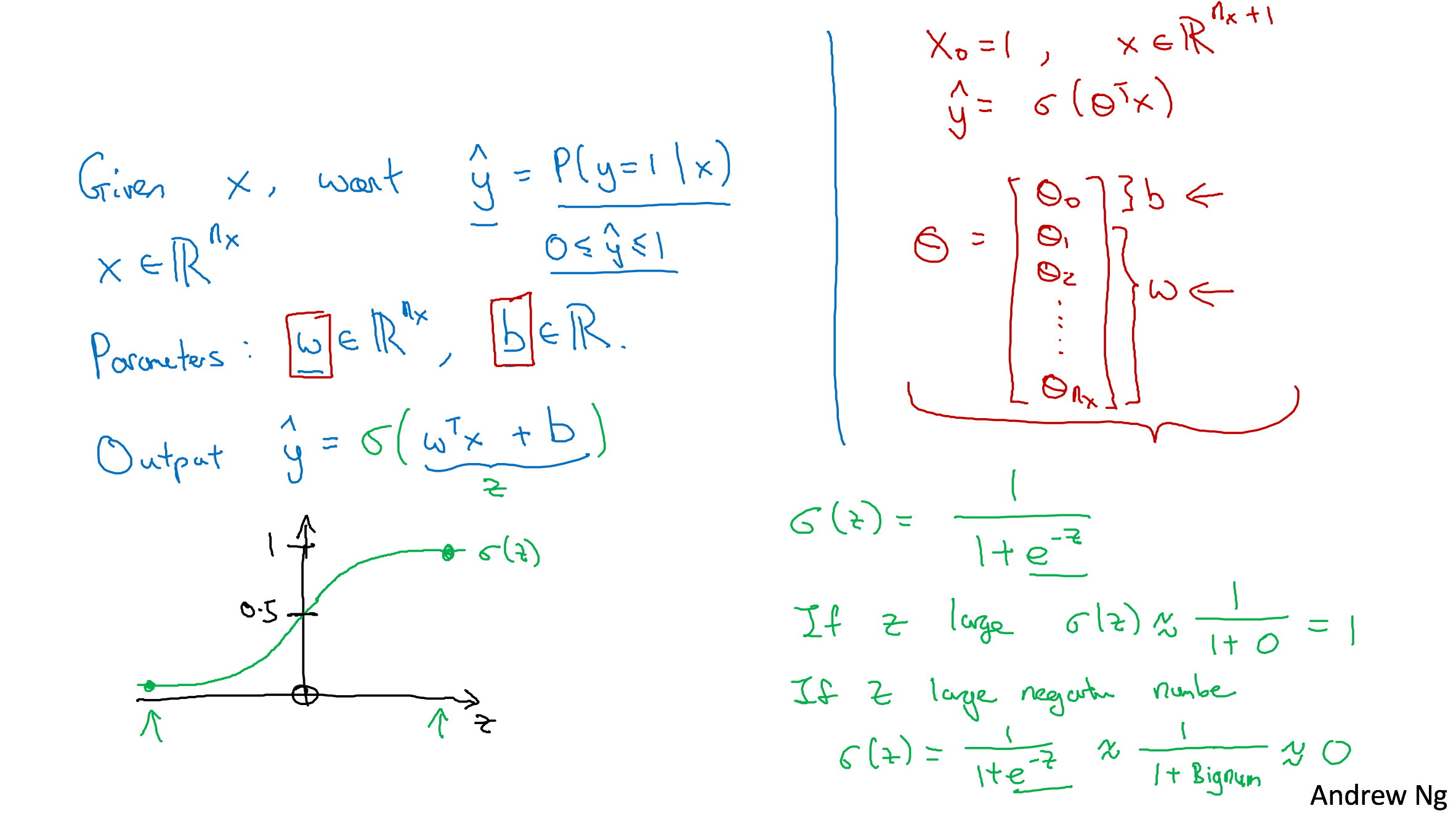

Logistic Regression

Logistic Regression

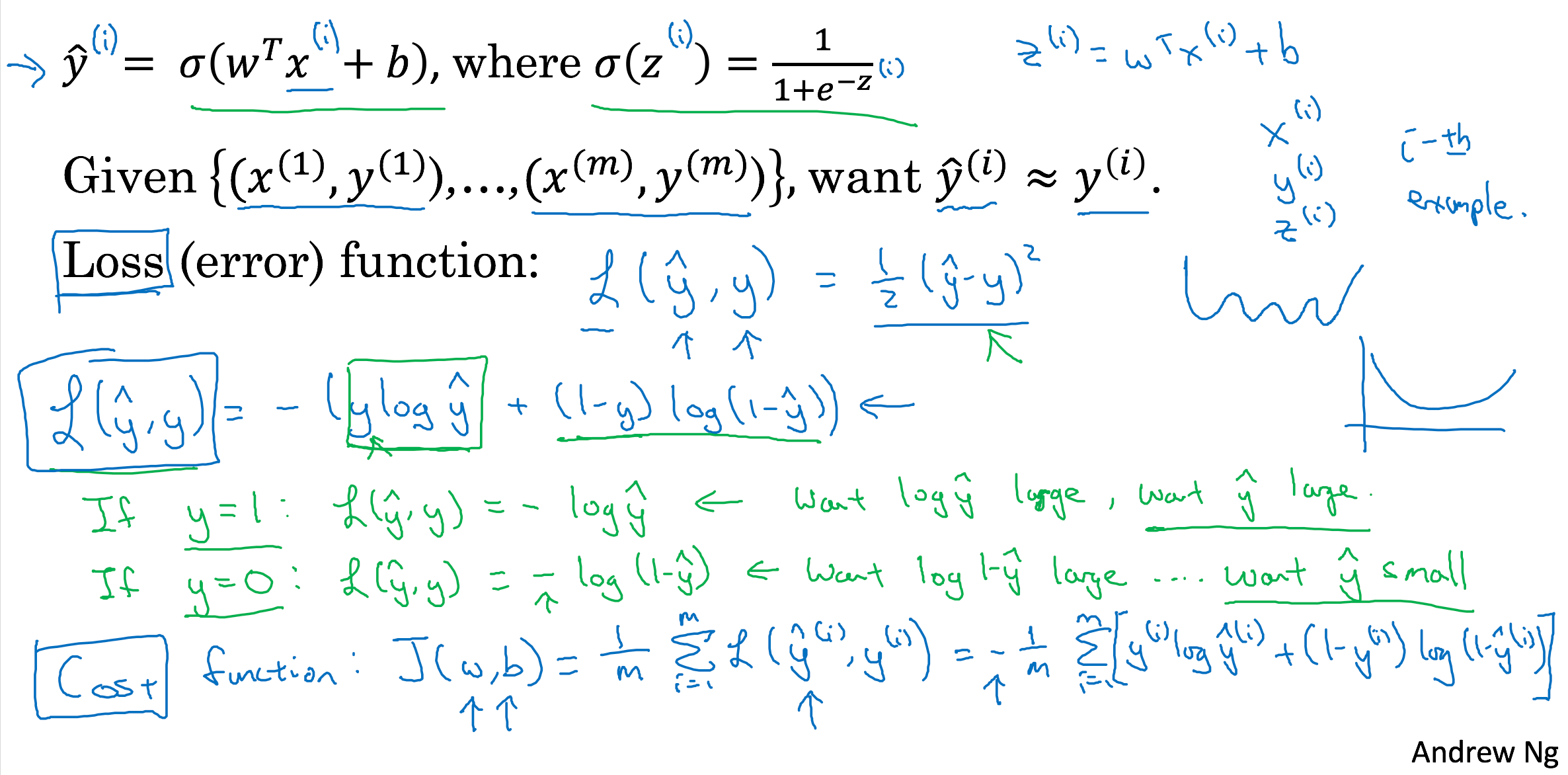

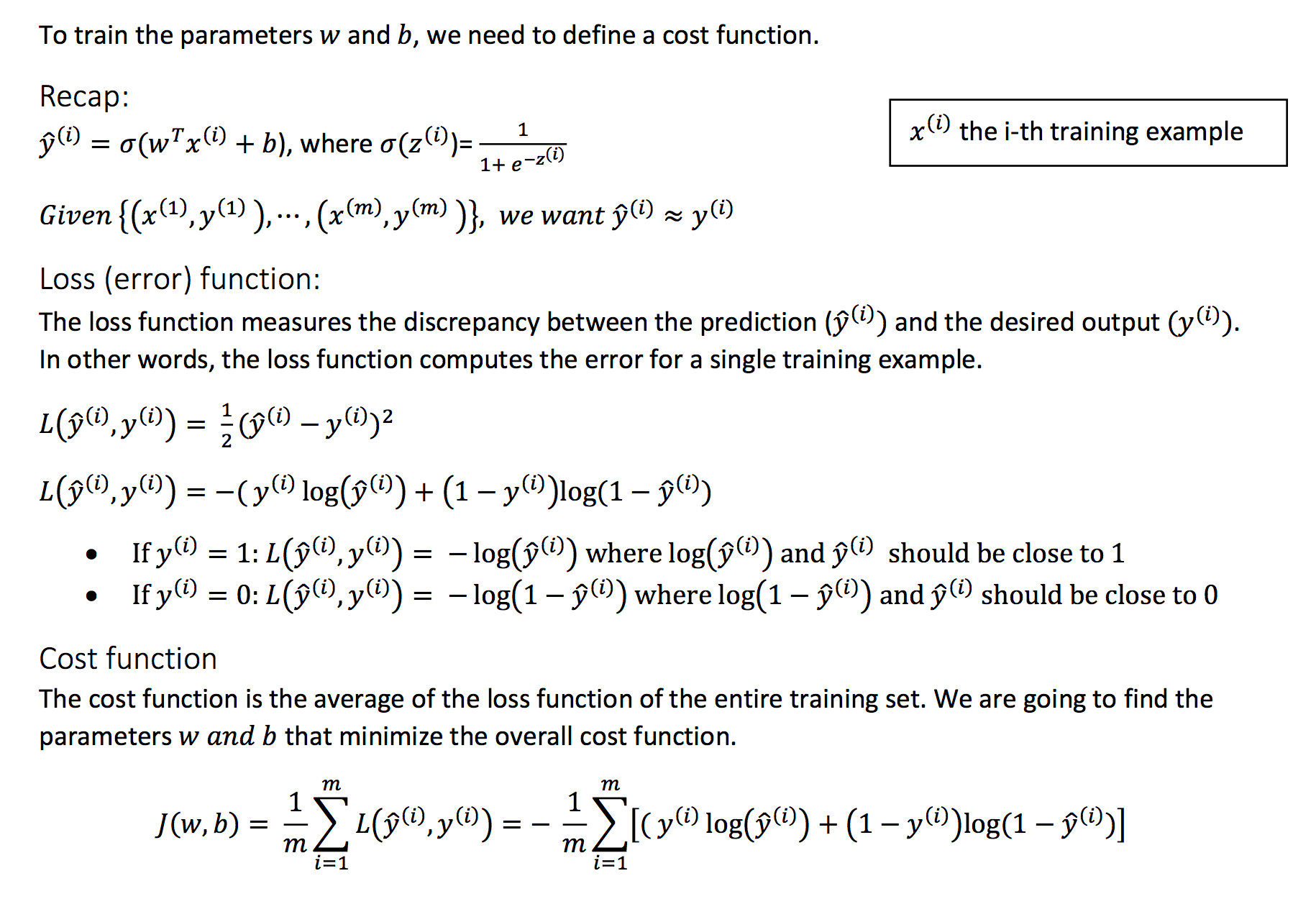

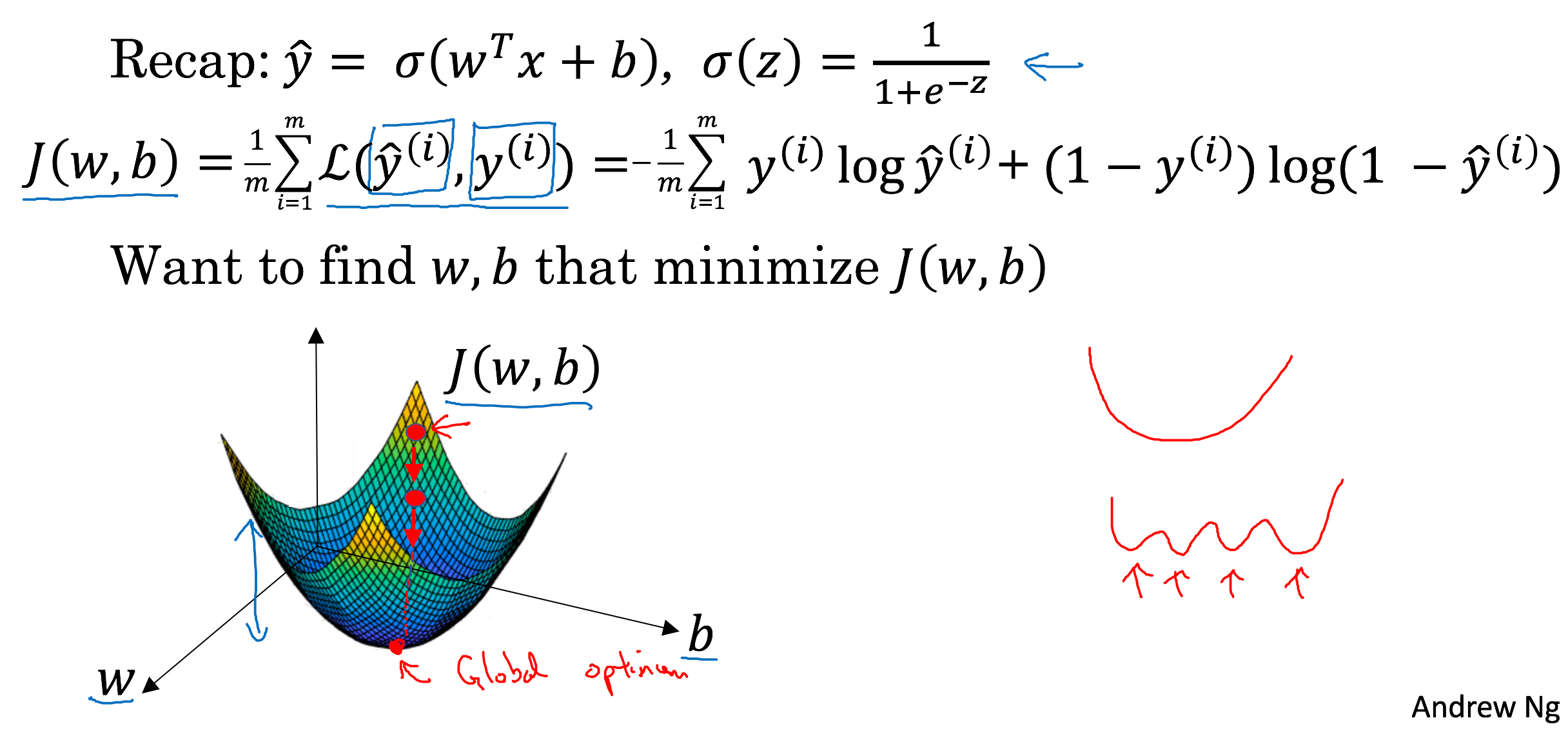

Cost Function

Logistic Regression Cost Function

Gradient Descent

Gradient Descent

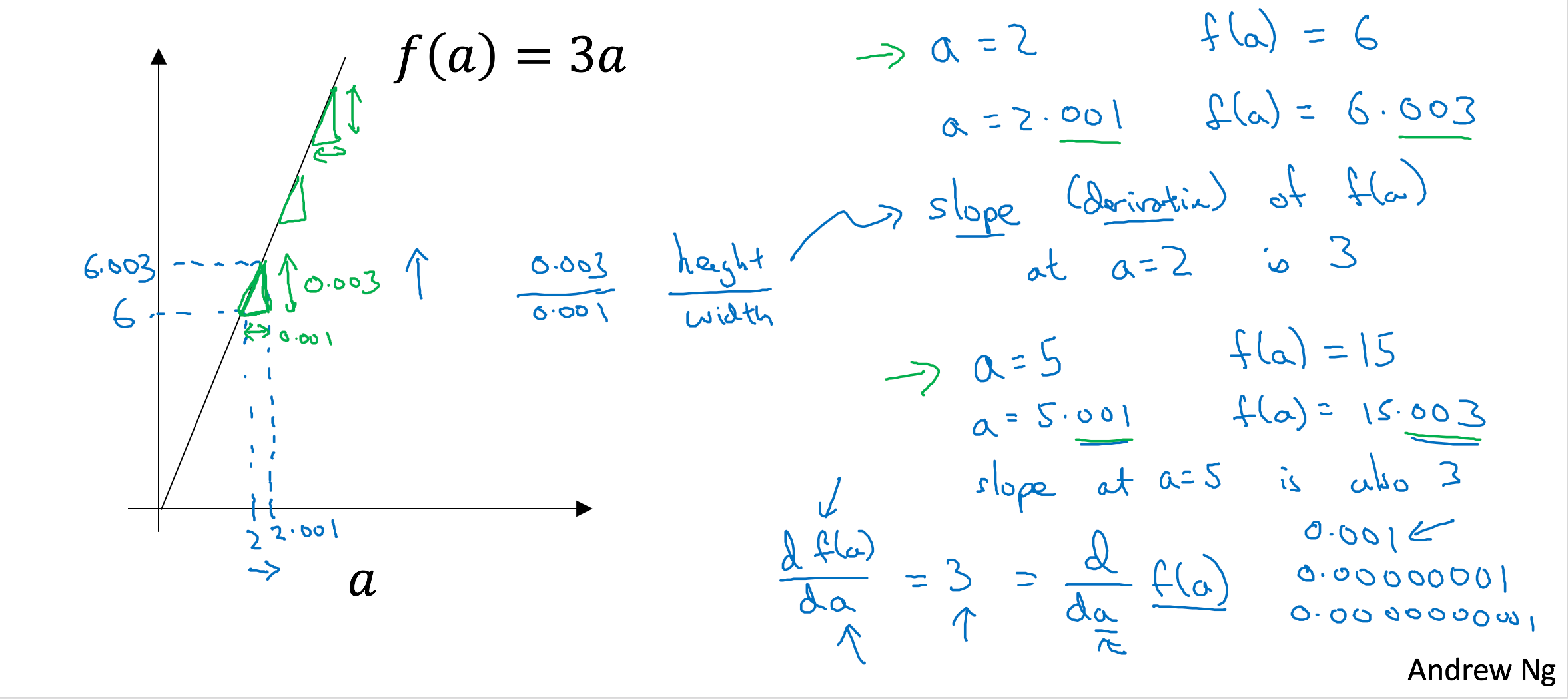

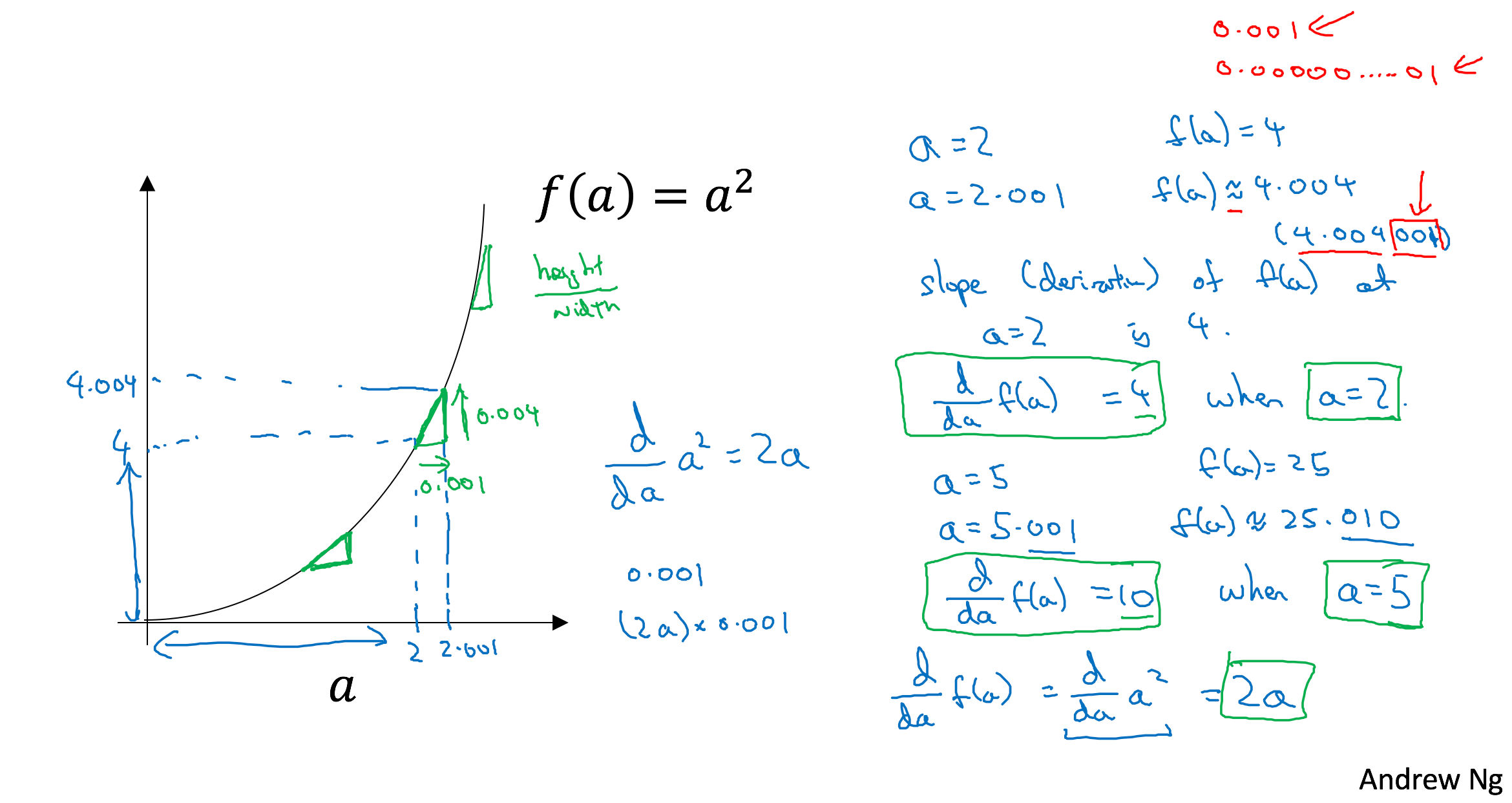

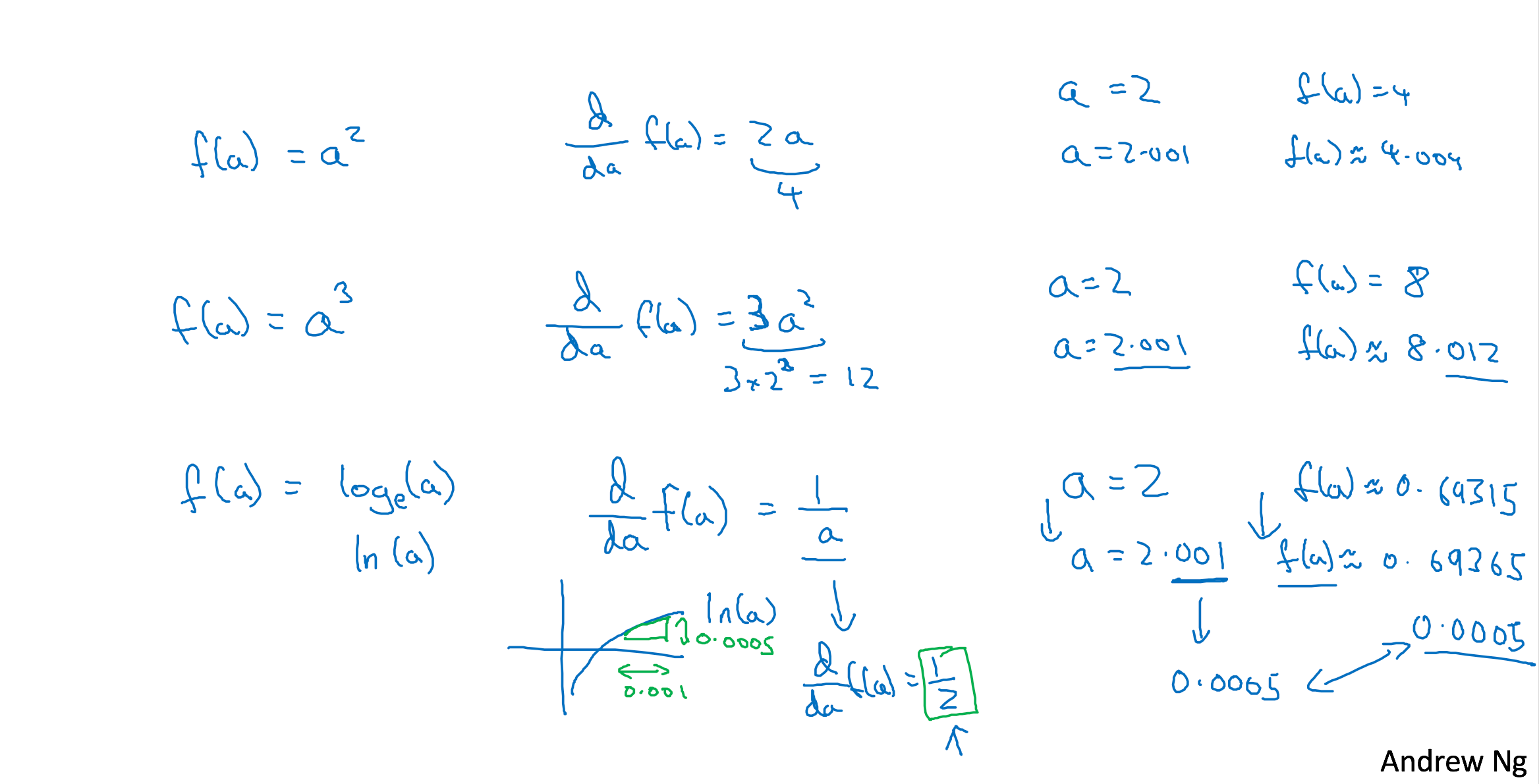

Derivatives

Derivatives

Derivatives

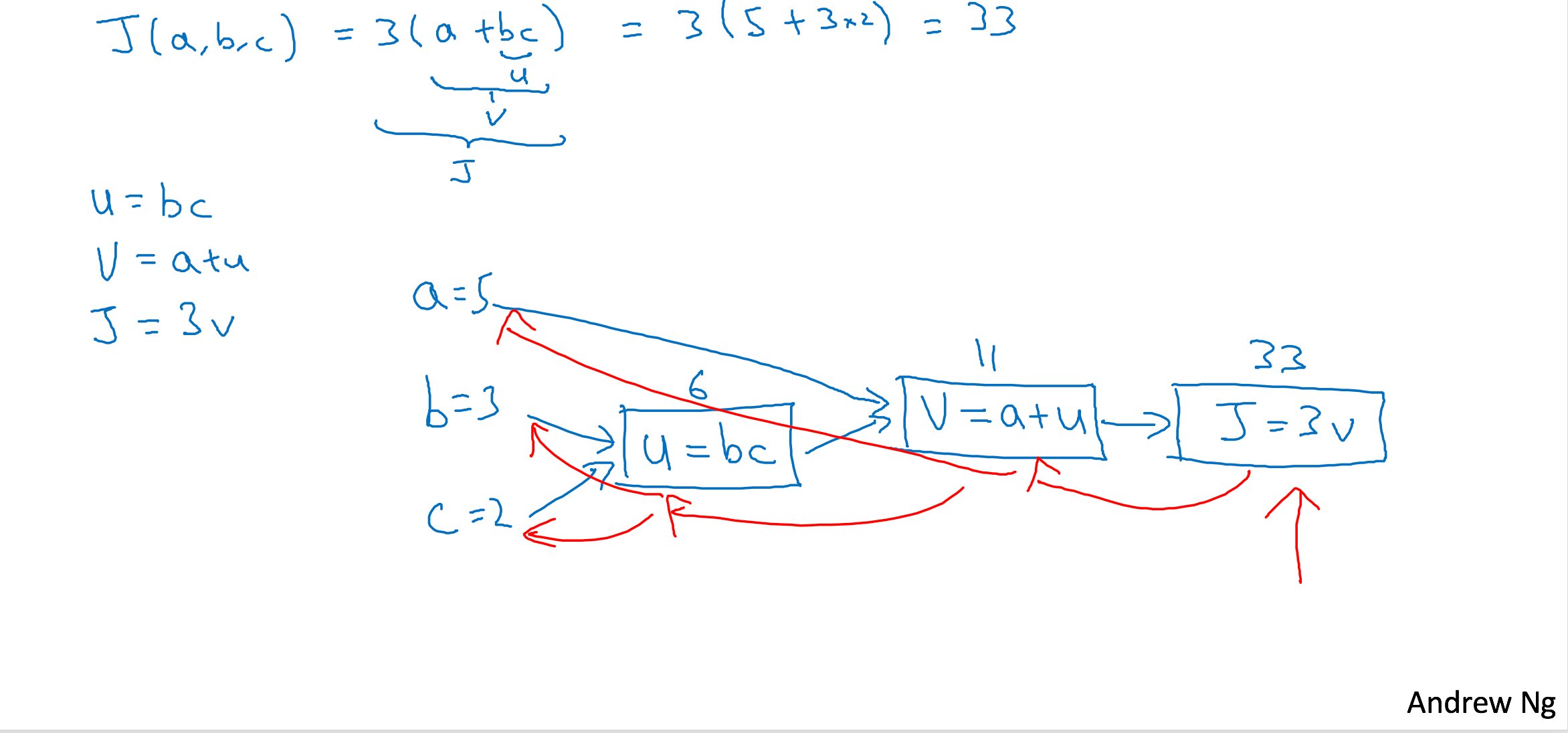

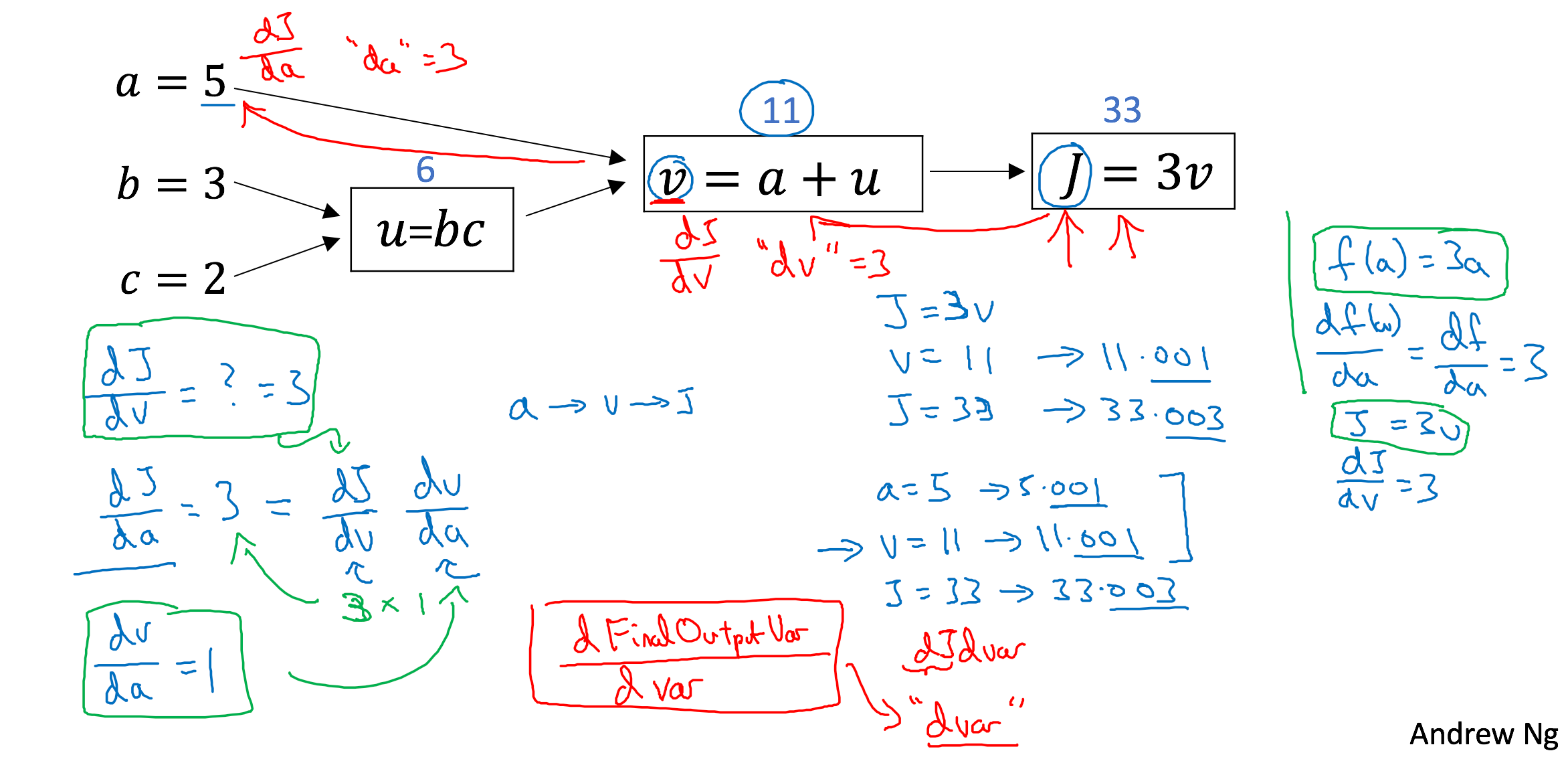

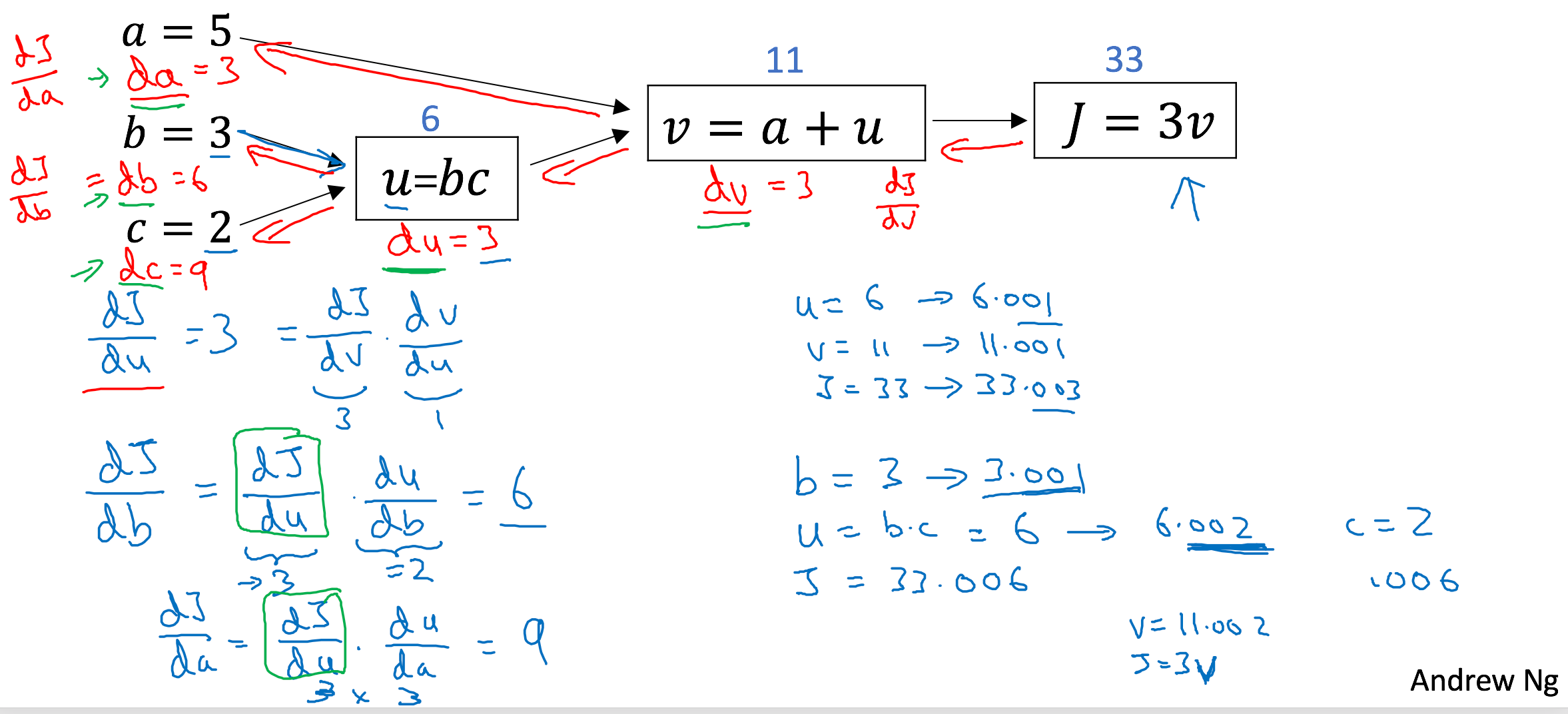

Computing Graph

Computing Graph

Computing Graph

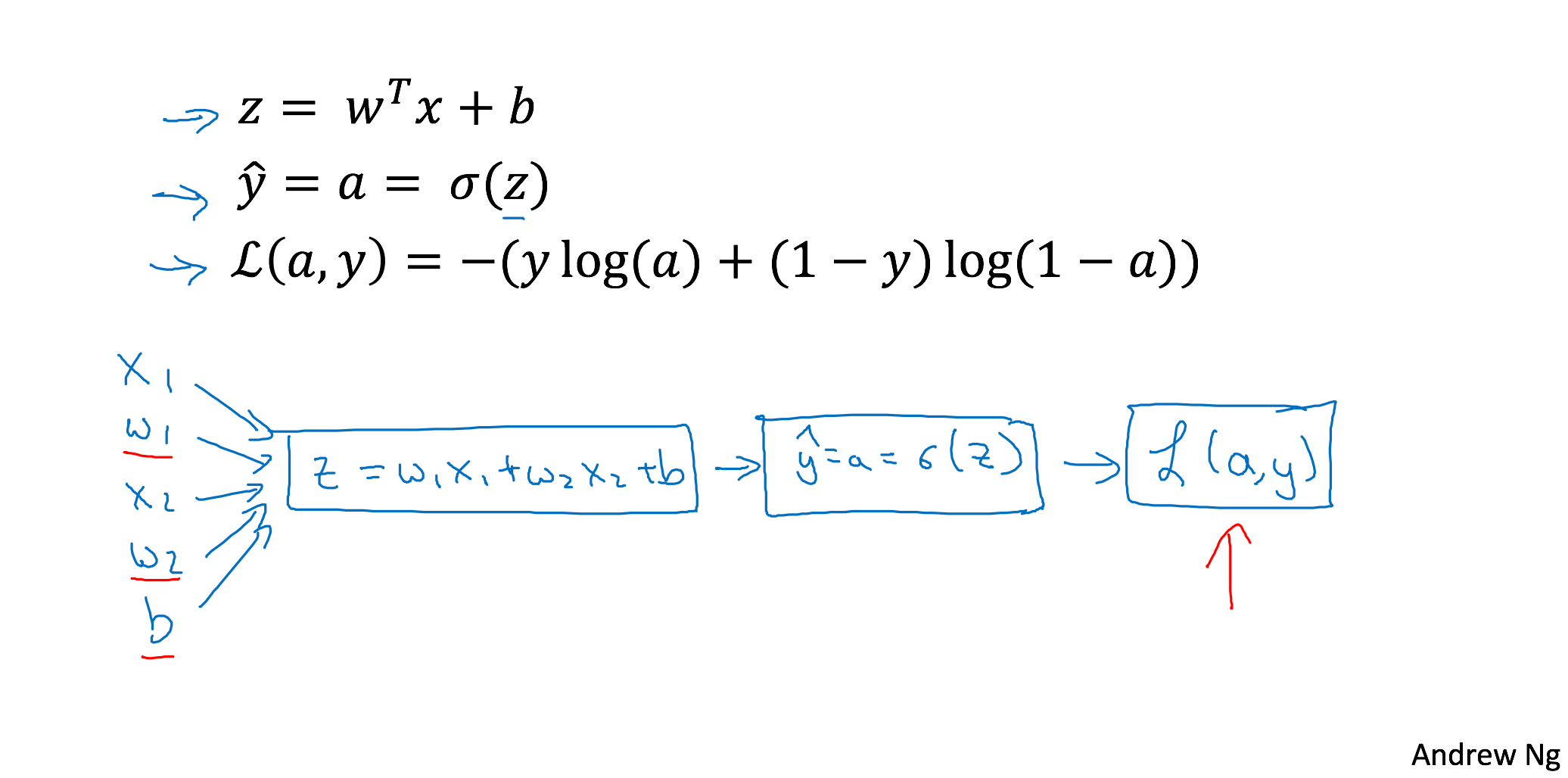

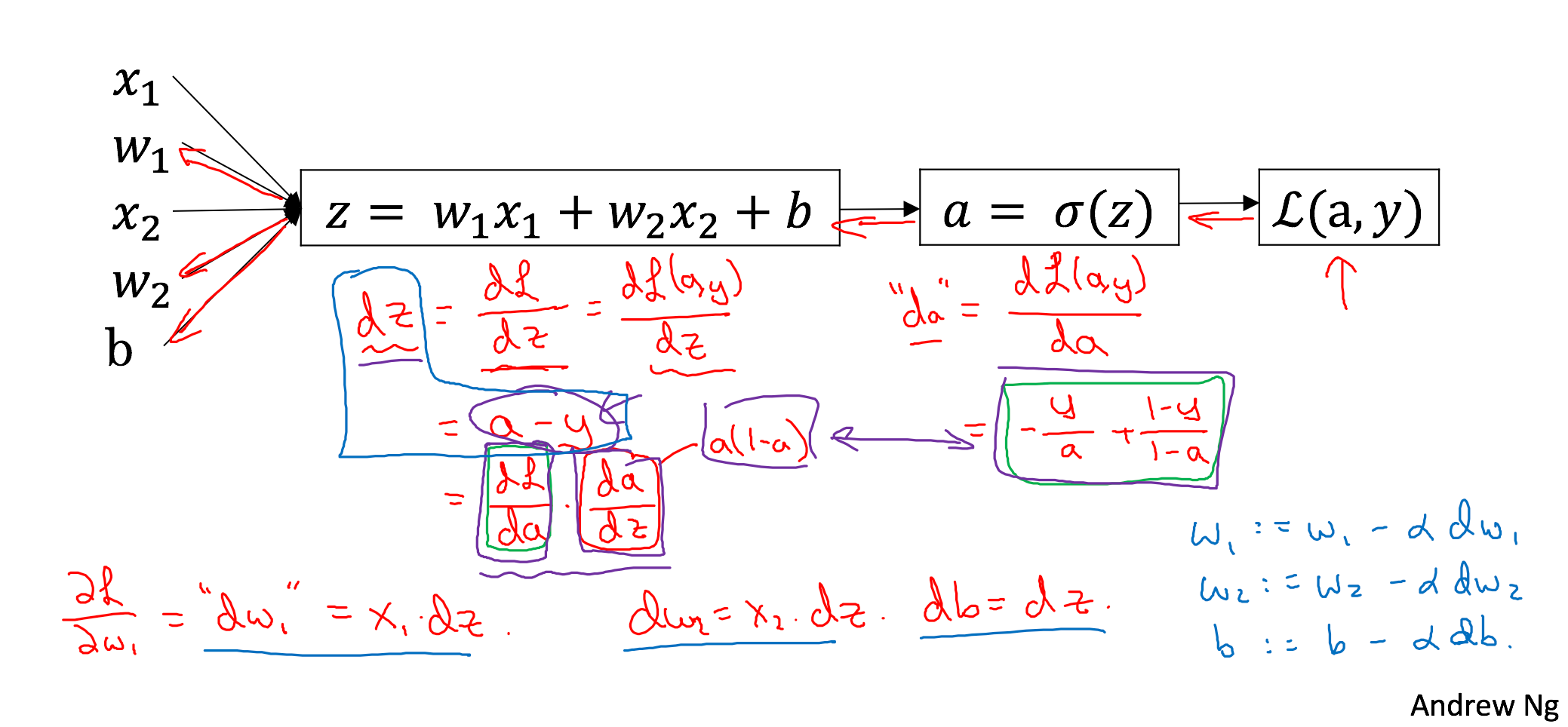

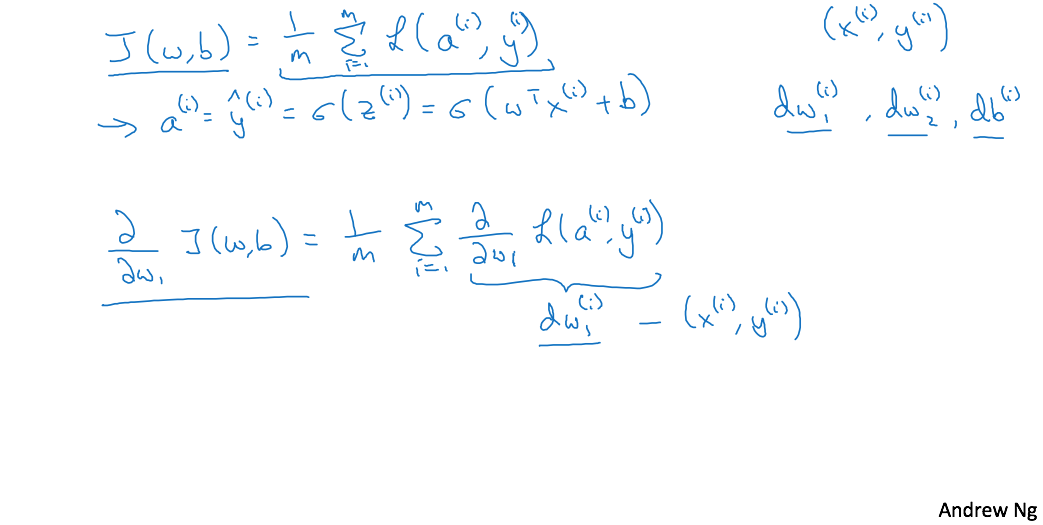

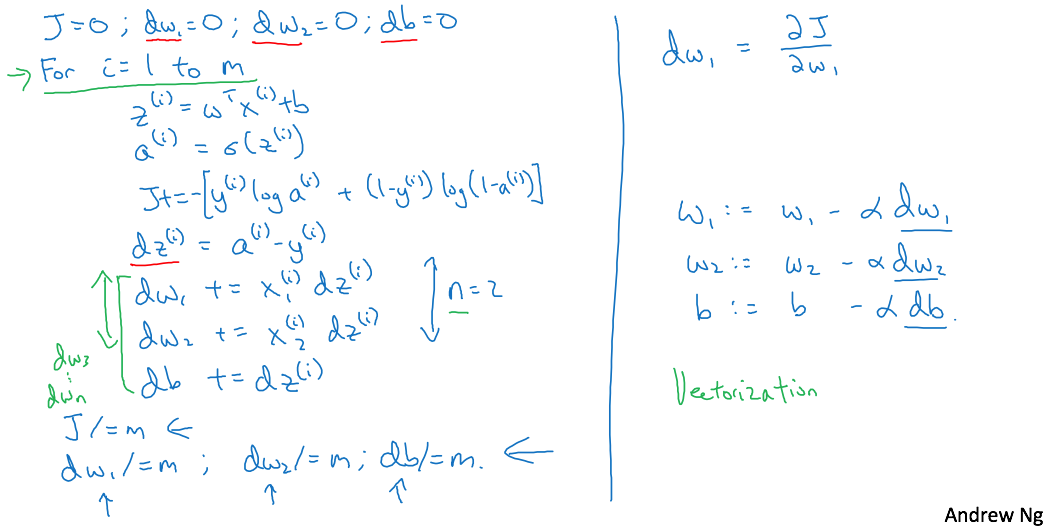

Logistic Regression Gradient Descent

Logistic Regression Gradient Descent

Logistic Regression Gradient Descent

Logistic Regression Gradient Descent

Two

Python and Vectorization