MACHINE LEARNING

Lecture 4

邏輯回歸(logistic regression)

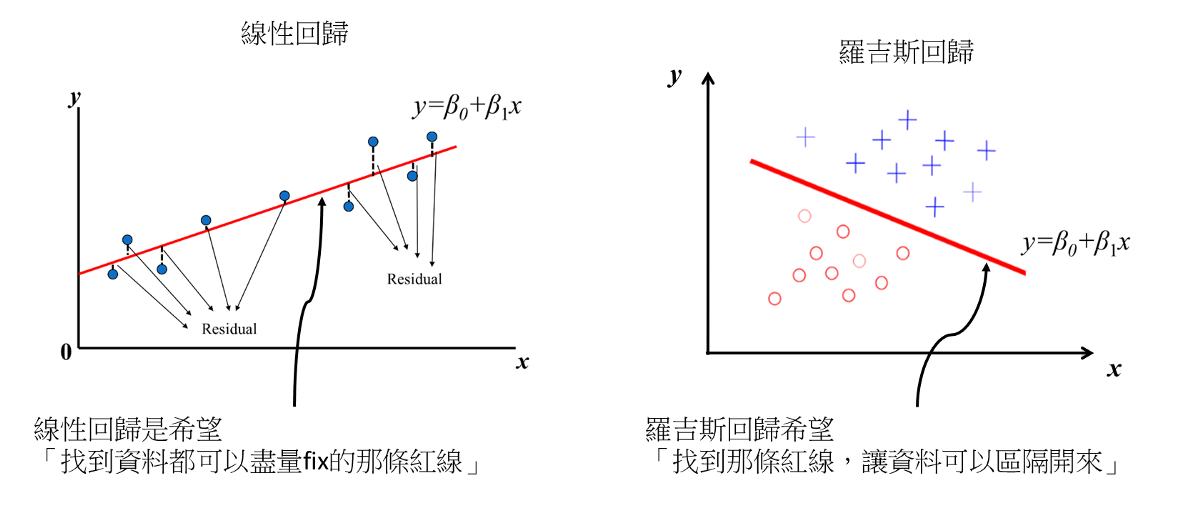

線性回歸 => 找趨勢

邏輯回歸 => 做分類

Linear Regression

Logistic Regression

模型

損失函數

優化方法

二元邏輯回歸

(binary logistic regression)

模型...?

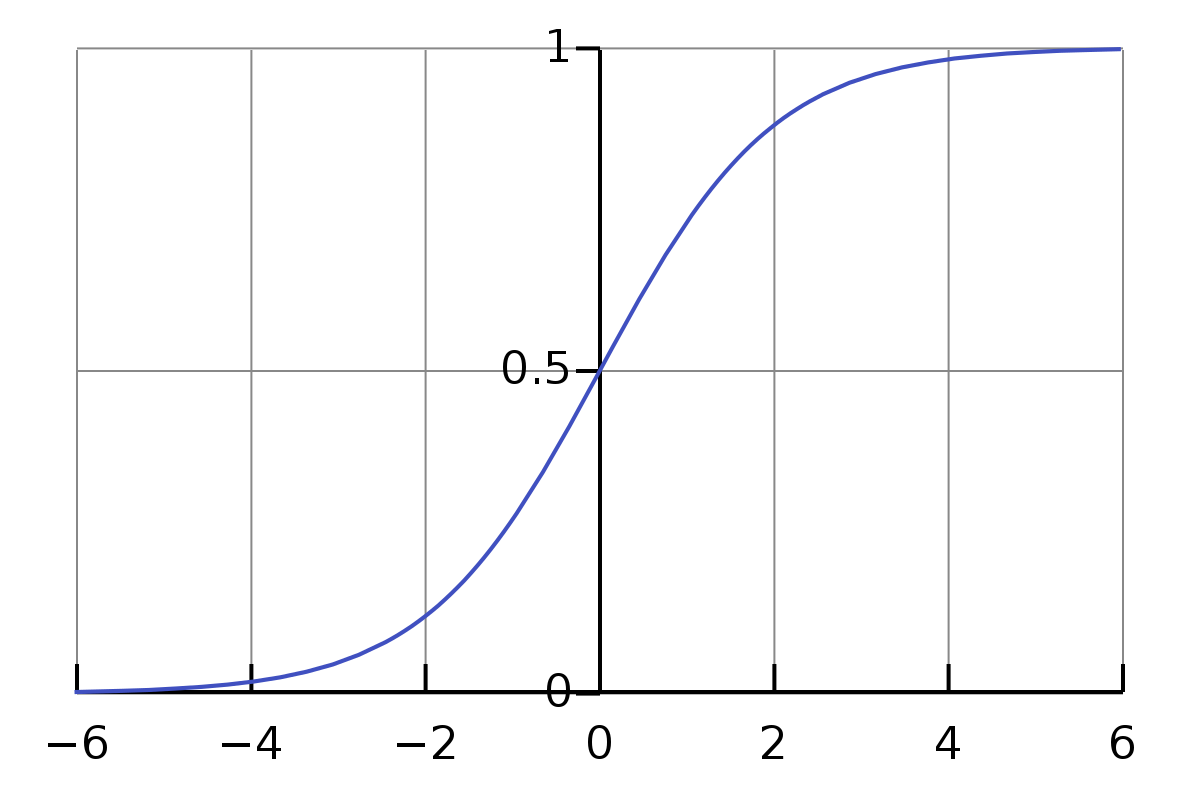

Sigmoid function

h_{\theta}(x)=\frac{1}{1+e^{-\theta^{T}x}}

沒什麼用的資訊

其實他是一種廣義的線性回歸(?)

ln \frac{y}{1-y} = \theta^{T} x

只是多了對數

沒有人在乎

還是Cost function

J(\theta)=\frac{1}{m}\sum_{i=1}^{m} (cost func)

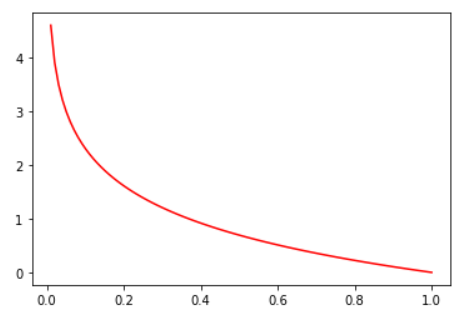

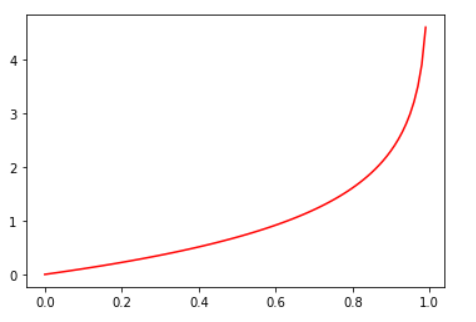

costfunc=-y\times log(h_{\theta}(x))-(1-y)\times log(1-h_{\theta}(x))

y=0 : -log(1-h_{\theta}(x))

y=1 : -log(h_{\theta}(x))

來看看他會長成甚麼酷樣

y=0

y=1

為甚麼要用這麼淇怪的函式???

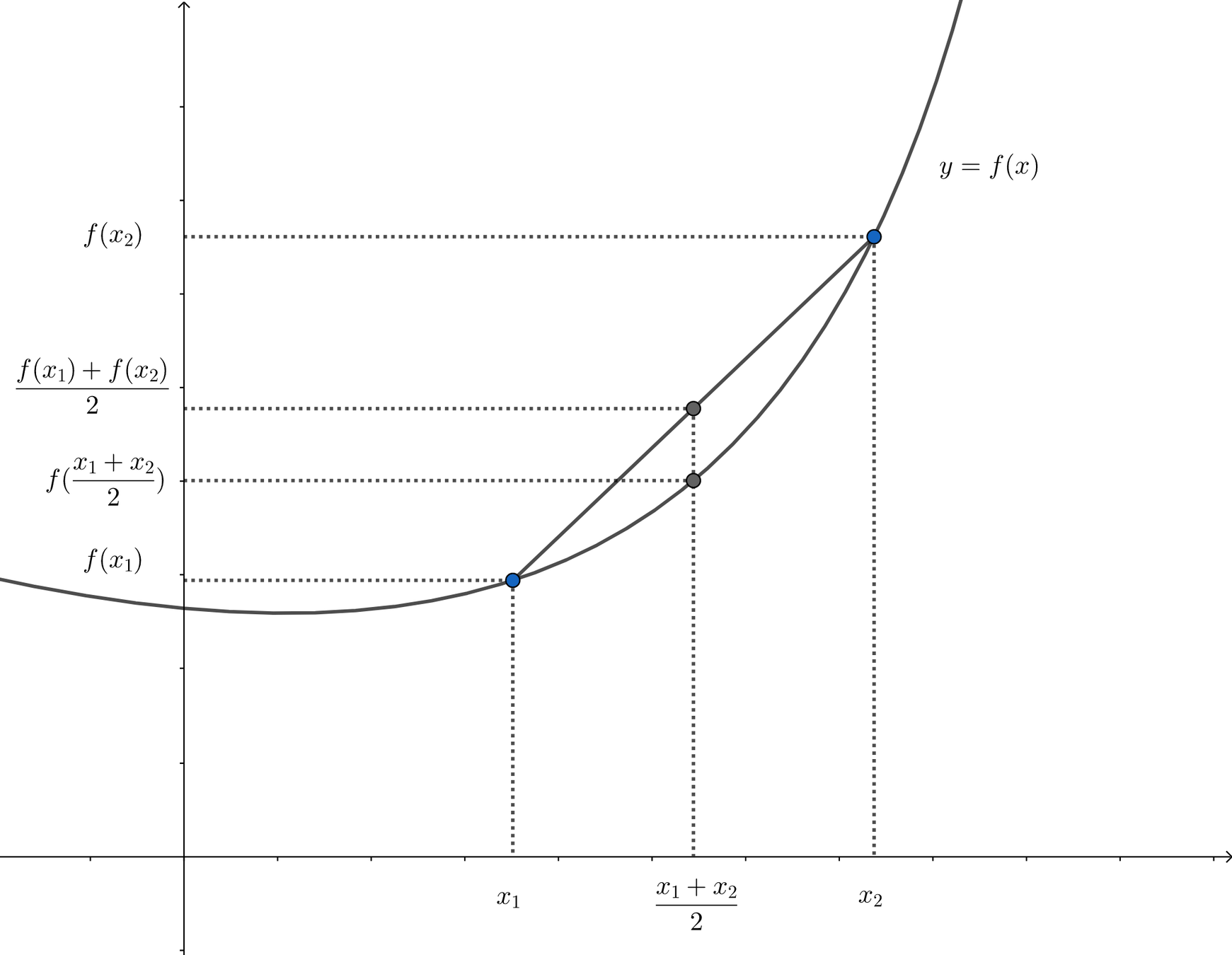

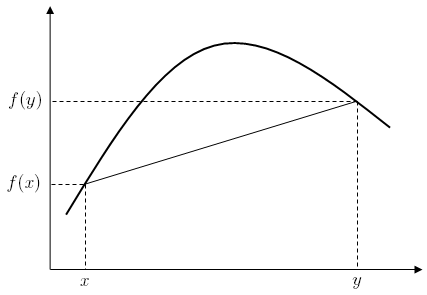

他是凸函數:D

凸ㄉ

凹ㄉ

有一些函數會起起落落只會掉到局部最小值

怎麼優化...?

\theta = \theta - \alpha x^{T}(\hat y -y)

寫累了就直接不推導 沒問題的

好耶