Линейные методы

Среднеквадратичная ошибка

Линейные модели

\(w_j\) - вес j-го признака;

\(x^j\) - значение j-го признака;

\(w_0 = const\)

Линейные модели

\(w_j\) - вес j-го признака;

\(x^j\) - значение j-го признака;

\(w_0 = w_0 x^0\)

Добавим константный признак \(x_0 = 1\)

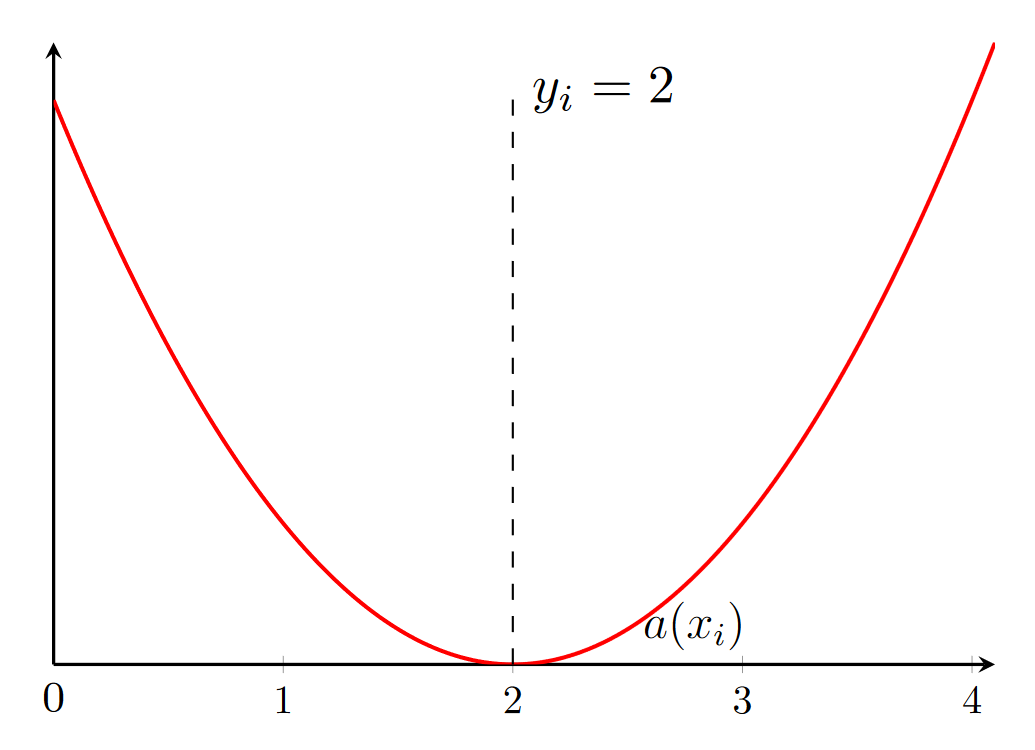

Среднеквадратичная ошибка

\(w\) - вещественный вектор весов модели;

\(x_i\) - вектор значений признаков объекта;

\(y_i\) - истинный ответ для i-го объекта;

\(l\) - количество объектов выборки

Задача регрессии

- d неизвестных

- константный признак

- выпуклая функция (т.к. ср.кв. ошибка)

Аналитическое решение

- вычислительно затратно по времени обращать матрицу при большом количестве признаков и на большой выборке

Градиентный спуск

Инициализируем веса нулями:

Итерируемся, пока изменение весов на \(\eta_t\) в сторону антиградиента значимо:

Градиентный спуск для линейной регрессии

Рассмотрим случай с одним признаком:

\( a(x) = w_0 + w_1 x \)

Градиентный спуск для линейной регрессии

Градиентный спуск для линейной регрессии

Градиентный спуск для линейной регрессии - ошибки

Стохастический градиентный спуск

В обычном градиентном спуске:

- проход по всей выборке

Стохастический градиентный спуск

\(x_i\) - случайный объект из выборки

Правдоподобие выборки

Как оценить неизвестный параметр по выборке?

Метод максимума правдоподобия

Пусть \(X \sim F(x, \theta) \),

\(\theta\) - неизвестные параметры распределения

Метод максимума правдоподобия

Сумму легче оптимизировать, чем произведение

Метод наименьших квадратов

Пусть \(a\) - константа

Пусть мы знаем распределение \(y \sim y(t) \)

Какое \(a\) оптимально?

Метод наименьших квадратов

Теперь более общий случай. Пусть \(a\) - функция от \(x\)

Пусть мы знаем распределение \(y \sim y(t) \)

Перейдем к конечной выборке

Лучшая аппроксимация минимума ошибки

Ошибка

Переобучение линейных моделей

Регуляризация

- Большие веса переобученной модели

- Идея: включить их в функционал ошибки, чтобы минимизировать не только отклонения ответов, но и веса модели

\(L_2\)-регуляризация

Будем минимизировать сумму квадратов весов: \(||w||^2 = \sum\limits_{j=1}^{d}w_j^2 \)

- Чем \(\lambda\) больше, тем модель проще

- Чем \(\lambda\) меньше, тем выше риск переобучения

\(L_2\)-регуляризация

То же самое:

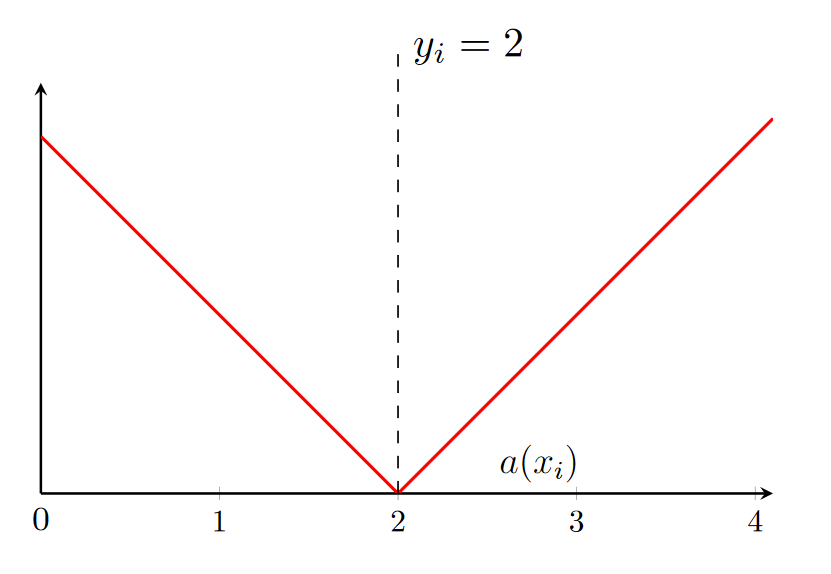

\(L_1\)-регуляризация

Будем минимизировать сумму модулей весов: \(||w||_1 = \sum\limits_{j=1}^{d}|w_j| \)

- Чем \(\lambda\) больше, тем модель проще, при этом могут занулиться некоторые признаки (при совсем большом \(\lambda\) - все)

- Чем \(\lambda\) меньше, тем выше риск переобучения

Выбор типа регуляризации

\(L_2\)-регуляризатор:

- штрафует модель за сложность

- гладкий и выпуклый - легко проводить минимизацию градиентными методами

\(L_1\)-регуляризатор:

- негладкий - сложнее оптимизировать

- зануляет признаки

- позволяет проводить отбор признаков

Линейная классификация

Линейный классификатор

\(\langle w, x \rangle = 0 \)

уравнение гиперплоскости

Отступ

Будем решать задачу бинарной классификации на множество классов \(Y = \{-1, +1\}\)

\(M_i > 0\) - правильный ответ

\(M_i < 0\) - неправильный ответ

Чем больше отступ, тем больше уверенность

Метрики качества

Доля неправильных ответов:

Пороговая функция потерь

Снова та же проблема - сложно оптимизировать

Пороговая функция потерь

Возьмем гладкую оценку пороговой функции:

Оценим ее через функционал ошибки:

Минимизируем верхнюю оценку и надеемся, что пороговая функция потерь тоже уменьшится

Пороговая функция потерь

Логистическая функция потерь

- Отсюда можно выразить вероятность принадлежности объекта классу +1

Вероятность принадлежности классу

Хотим оценить \(P(y=1|x)\)

Введем \(\pi(x) = P(y=1|x)\)

\(\pi(x) = 1P(y=1|x)+0P(y=0|x)=\mathbb{E}(y|x) \)

Введем обобщенную линейную модель:

\(g(\mathbb{E}(y|x)) \approx \langle w, x\rangle \)

\( \mathbb{E}(y|x) \approx g^{-1}( \langle w, x\rangle) \)

Вероятность принадлежности классу

Вероятность принадлежности классу

логит

Правдоподобие обучающей выборки

Возьмем это выражение с минусом и переобозначим \(y = 0 \) за \(y = -1 \) - получим логистическую функцию потерь. А верхнее выражение - легко минимизировать

Использование полиномиальных признаков в линейных моделях

Задание

- Обучить логистическую регрессию на своих данных, подобрать параметры.

- Сравнить результаты применения \(L_1\) и \(L_2\) регуляризаций. Посмотреть веса признаков, объяснить полученные значения.

- Провести отбор признаков с помощью \(L_1\) регуляризации, подобрать оптимальный C, объяснить результат.