Roberto Piva

Sviluppo di competenze

trasversali per l’apprendistato

Quando è nato Internet: storia completa dalla nascita a oggi

Dalle origini militari negli anni '60 alla rete globale di oggi: ripercorriamo le date chiave della nascita di Internet e la sua evoluzione, inclusa la creazione del World Wide Web.

Internet è oggi una presenza costante nelle nostre vite: lavoriamo, studiamo, ci divertiamo e comunichiamo attraverso questa rete globale che connette miliardi di dispositivi in tutto il mondo. Ma quando è nato Internet, esattamente? La risposta non è così semplice come potrebbe sembrare, perché quella che oggi chiamiamo Internet è il risultato di un'evoluzione che ha attraversato diverse fasi cruciali.

La data più comunemente indicata come "nascita di Internet" è il 29 ottobre 1969. Tuttavia, solo una quindicina di anni più tardi nascerà il protocollo TCP/IP, ovvero il “linguaggio” che consente ai computer di comunicare e che noi oggi conosciamo come Internet.

Quando è nato Internet: storia completa dalla nascita a oggi

Quando è nato Internet: le due date chiave

La nascita di Internet è segnata da due momenti fondamentali che hanno trasformato per sempre il modo in cui i computer comunicano tra loro:

1969: la nascita ufficiale con ARPANET

Il 29 ottobre 1969 è considerata la data di nascita ufficiale di Internet. Quel giorno, presso l'Università della California di Los Angeles (UCLA), venne stabilita la prima connessione tra due computer attraverso ARPANET (Advanced Research Projects Agency Network).

Il secondo computer si trovava allo Stanford Research Institute, a circa 500 km di distanza.

Quando è nato Internet: le due date chiave

La nascita di Internet è segnata da due momenti fondamentali che hanno trasformato per sempre il modo in cui i computer comunicano tra loro:

1969: la nascita ufficiale con ARPANET

Questo primo tentativo di comunicazione fu tanto storico quanto modesto: il sistema si bloccò dopo che erano state trasmesse solo le lettere "L" e "O" del comando "LOGIN". Un secondo tentativo, tuttavia, ebbe successo e segnò l'inizio di una nuova era nelle telecomunicazioni. Entro la fine dello stesso anno, la rete ARPANET collegava già quattro nodi universitari, permettendo a ricercatori e scienziati di condividere risorse computazionali a distanza.

Quando è nato Internet: le due date chiave

1983: l'adozione del protocollo TCP/IP

Se il 1969 rappresenta il primo vagito di Internet, il 1° gennaio 1983 può essere considerato il momento in cui la rete come la conosciamo oggi ha mosso i suoi primi veri passi. In questa data, infatti, ARPANET adottò ufficialmente il protocollo TCP/IP (Transmission Control Protocol/Internet Protocol), sviluppato da Vinton Cerf e Robert Kahn.

Questo passaggio fu rivoluzionario perché il TCP/IP permise per la prima volta a reti diverse di comunicare tra loro in modo standardizzato. È proprio da questa capacità di interconnessione tra reti diverse che deriva il termine "Internet" (Interconnected Networks). Il nuovo protocollo divenne così efficace e versatile che è ancora oggi il fondamento della comunicazione su Internet.

Prima di Internet: le origini negli anni '50 e '60

Ma facciamo un passo indietro e cerchiamo di rispondere a una domanda diversa: perché è nato Internet? In risposta a quale esigenza?

La storia di questo strumento eccezionale affonda le sue radici nel clima politico della Guerra Fredda, quando la competizione tecnologica tra Stati Uniti e Unione Sovietica raggiunse il suo apice.

La Guerra Fredda e il progetto ARPA

Nel 1957, il lancio del satellite sovietico Sputnik 1 creò grande preoccupazione negli Stati Uniti, evidenziando un potenziale gap tecnologico con l'URSS. Come risposta diretta a questa sfida, nel 1958 il presidente Eisenhower istituì l'ARPA (Advanced Research Projects Agency), un'agenzia del Dipartimento della Difesa con il compito di mantenere la supremazia tecnologica americana.

Una delle principali preoccupazioni dell'epoca era la vulnerabilità del sistema di comunicazioni americano in caso di attacco nucleare.

Gli Stati Uniti avevano bisogno di un sistema di comunicazione che potesse sopravvivere anche se parte della rete fosse stata distrutta. Questo requisito fondamentale influenzò profondamente l'architettura di quella che sarebbe poi diventata Internet.

I pionieri delle reti di computer

Nel 1962, J.C.R. Licklider del MIT fu il primo a teorizzare una "rete galattica" di computer interconnessi. Come primo direttore del programma di ricerca informatica di ARPA, Licklider convinse i suoi successori dell'importanza di questo concetto di rete.

Un primo tassello fondamentale era stato posto da Leonard Kleinrock, che nel 1961 pubblicò il primo articolo sulla teoria della commutazione a pacchetto.

Questa tecnologia innovativa permetteva di dividere i dati in piccoli pacchetti che potevano viaggiare indipendentemente attraverso la rete, per poi essere riassemblati a destinazione.

Era la soluzione ideale per creare una rete resistente e affidabile.

Le prime tecnologie che hanno reso possibile Internet

Nel 1965, Lawrence Roberts e Thomas Merrill realizzarono il primo esperimento di connessione tra computer distanti, collegando un computer TX-2 in Massachusetts con un Q-32 in California attraverso una linea telefonica.

Questo test dimostrò che i computer potevano lavorare insieme efficacemente, ma evidenziò anche i limiti del sistema telefonico tradizionale per la trasmissione dei dati.

Parallelamente, tre gruppi di ricerca stavano lavorando sulla commutazione a pacchetto senza conoscere l'uno il lavoro dell'altro:

- Il MIT (1961-1967)

- La RAND Corporation (1962-1965)

- Il National Physical Laboratory nel Regno Unito (1964-1967)

Le prime tecnologie che hanno reso possibile Internet

Fu proprio dalla convergenza di questi studi indipendenti che nacque il concetto di rete distribuita: una rete senza un punto di comando centrale, dove ogni nodo poteva comunicare direttamente con gli altri: un’architettura decentralizzata che è ancora oggi una caratteristica fondamentale di Internet.

Questi sviluppi teorici e tecnologici posero le basi per la creazione di ARPANET nel 1969. La rete militare e accademica americana si sarebbe poi evoluta, nel corso dei decenni successivi, nell'Internet globale che utilizziamo oggi per connetterci e comunicare con il resto del mondo

Gli anni '80: Internet diventa realtà

Gli anni '80 rappresentano il decennio in cui Internet inizia a prendere la forma che conosciamo oggi. È in questo periodo che si definiscono gli standard tecnici fondamentali e la rete si espande oltre i confini militari e accademici originari.

Come abbiamo visto, il 1983 rappresenta un momento spartiacque: è l’anno in cui ARPANET adotta ufficialmente il protocollo TCP/IP.

Non si trattava solo di una (fondamentale) innovazione tecnologica, ma rappresentava un modo completamente nuovo di concepire le reti di computer:

- permetteva a reti diverse di comunicare tra loro;

- garantiva la consegna affidabile dei dati;

- funzionava anche in caso di danneggiamento parziale della rete;

- non richiedeva un controllo centralizzato.

La nascita del DNS

Ancora oggi, ogni computer connesso a Internet è identificato attraverso il suo indirizzo IP, una sequenza numerica come "192.168.1.1".

All'inizio di Internet, per facilitare la connessione tra computer, esisteva un'unica tabella centrale che associava questi indirizzi numerici a nomi più facilmente memorizzabili per gli esseri umani. Era come un enorme elenco telefonico che doveva essere continuamente aggiornato e distribuito a tutti i computer della rete.

Con la crescita esponenziale della rete, questo sistema divenne rapidamente ingestibile: aggiornare e distribuire manualmente queste tabelle a tutti i computer connessi era un compito sempre più complesso e inefficiente.

La nascita del DNS

Ecco che nel 1983, Paul Mockapetris e Jon Postel svilupparono il Domain Name System (DNS), una soluzione che permetteva di:

- convertire automaticamente i nomi dei computer in indirizzi IP;

- gestire in modo distribuito e scalabile i nomi di dominio;

- creare una gerarchia di domini (.com, .edu, .org, ecc.)

Il DNS rappresentò una svolta fondamentale che rese Internet più facile da utilizzare e gestire, aprendo la strada alla sua futura espansione commerciale.

Quando nasce il web?

La data di nascita del World Wide Web è il 1989, quando Tim Berners-Lee, un ricercatore del CERN di Ginevra, propose un sistema innovativo per gestire e collegare le informazioni disponibili sui computer della rete.

È importante sottolineare che il Web non è sinonimo di Internet: è piuttosto un servizio che funziona attraverso l'infrastruttura di Internet, rivoluzionando il modo in cui accediamo alle informazioni online.

1989: Tim Berners-Lee e la nascita del Web

Il progetto iniziale di Berners-Lee era relativamente semplice: creare un sistema che permettesse ai ricercatori del CERN di condividere facilmente documenti e informazioni. Per realizzare questa visione, sviluppò tre elementi fondamentali che ancora oggi sono alla base del funzionamento della rete:

- HTML (HyperText Markup Language), un linguaggio per formattare i documenti;

- HTTP (HyperText Transfer Protocol), il protocollo per la trasmissione di questi documenti;

- URL (Uniform Resource Locator), un sistema per assegnare indirizzi univoci alle risorse sul Web.

Il 6 agosto 1991, Berners-Lee pubblicò il primo sito web della storia, spiegando il progetto World Wide Web e rendendo pubblicamente disponibile il codice necessario per creare siti web e visualizzarli. Questa decisione di rendere la tecnologia libera e gratuita si rivelò fondamentale per la sua rapida diffusione.

Come il Web ha cambiato Internet

Prima del Web, Internet era uno strumento utilizzato principalmente da ricercatori e specialisti, con interfacce testuali poco intuitive. Il Web ha trasformato radicalmente questo scenario introducendo:

- un'interfaccia grafica intuitiva;

- la possibilità di collegare documenti attraverso link ipertestuali;

- un modo semplice per pubblicare contenuti online;

- l'accesso immediato a informazioni distribuite in tutto il mondo;

- i primi browser e la democratizzazione della rete;

La vera esplosione del Web iniziò nel 1993 con il lancio di Mosaic, il primo browser di facile utilizzo sviluppato da Marc Andreessen. Mosaic introdusse innovazioni fondamentali come la possibilità di visualizzare immagini insieme al testo nella stessa pagina, rendendo il Web molto più attraente e accessibile per gli utenti comuni.

Come il Web ha cambiato Internet

Il successo di Mosaic portò alla nascita di Netscape Navigator nel 1994, che divenne rapidamente il browser più popolare al mondo con circa 10 milioni di utenti. Microsoft rispose nel 1995 con Internet Explorer, dando inizio all'era dei browser moderni.

Questa evoluzione trasformò rapidamente il Web da strumento accademico a fenomeno di massa: tra il 1993 e il 1996, il numero di siti web passò da 130 a oltre 100.000, segnando l'inizio di quella che oggi conosciamo come era digitale.

La semplicità del Web nell'accedere alle informazioni e la sua natura aperta hanno reso Internet accessibile a tutti, trasformandolo da strumento per specialisti a piattaforma universale per la comunicazione, il commercio e l'intrattenimento.

30 aprile 1986: il primo collegamento italiano

Il 30 aprile 1986 è una data storica per il digitale italiano: quel giorno, dalla sede del CNUCE-CNR (Centro Nazionale Universitario di Calcolo Elettronico) di Pisa, il ricercatore Blasco Bonito lanciò il comando "ping" verso il computer della stazione di Roaring Creek in Pennsylvania, ricevendo la risposta positiva dagli Stati Uniti. Era la prima volta che l'Italia si collegava alla rete ARPANET.

Questo collegamento fu il risultato di una collaborazione tra il CNR, Italcable e Telespazio, che utilizzarono la rete satellitare atlantica Satnet. Curiosamente, questo evento rivoluzionario passò quasi inosservato dai media dell'epoca, probabilmente oscurato dalla contemporanea tragedia di Chernobyl.

1987: il primo dominio .it

L'anno successivo segna un'altra tappa fondamentale: nel 1987 viene registrato il primo dominio italiano, "cnuce.cnr.it".

Con questa registrazione nasce ufficialmente il Registro .it, l'anagrafe dei nomi Internet italiani, ancora oggi gestito dall'Istituto di Informatica e Telematica del CNR di Pisa.

La diffusione commerciale negli anni '90

La vera diffusione di Internet in Italia inizia però nei primi anni '90. Un momento chiave è il 1994, quando nasce Video On Line, tra i primi Internet Service Provider italiani.

Fondato a Cagliari dall'editore Nicola Grauso, Video On Line fu pioniere nel fornire accesso a Internet al pubblico italiano, arrivando a contare circa 15.000 abbonati nel 1995, pari al 30% degli utenti Internet italiani dell'epoca.

Nello stesso anno, L'Unione Sarda diventa il primo quotidiano in Europa ad avere una versione online, segnando l'inizio della presenza dei media italiani su Internet.

Internet in Italia oggi: i dati sulla diffusione

Secondo i dati Istat più recenti del 2023, la diffusione di Internet in Italia ha raggiunto livelli significativi:

- l'84,1% delle famiglie italiane dispone di una connessione internet;

- il 79,5% degli italiani di 6 anni e più ha utilizzato Internet negli ultimi tre mesi;

- il 67,5% della popolazione accede a Internet quotidianamente.

Tuttavia, persistono ancora alcuni divari significativi nel nostro Paese. A livello geografico, il digital divide tra Nord e Sud rimane evidente, con uno scarto di oltre 5 punti percentuali nella disponibilità di accesso a Internet.

L'età rappresenta un altro fattore discriminante: mentre oltre il 91% delle persone tra gli 11 e i 54 anni usa regolarmente Internet, la percentuale crolla al 24,7% tra gli over 75.

Internet in Italia oggi: i dati sulla diffusione

Anche il livello di istruzione influenza fortemente l'utilizzo della rete, con il 90,3% dei diplomati che naviga regolarmente contro il 66,2% di chi ha conseguito la licenza media.

Questi dati mostrano come, nonostante la crescita significativa, esistano ancora importanti margini di miglioramento per rendere Internet uno strumento davvero accessibile a tutti gli italiani.

In ogni caso, i dati dimostrano come, a quasi 40 anni dal primo collegamento, Internet sia diventato uno strumento fondamentale nella vita degli italiani: dalla formazione al lavoro, dall'intrattenimento all'accesso alle informazioni, la rete è ormai parte integrante della nostra quotidianità.

Da strumento militare a necessità quotidiana

Ripercorrere la storia di Internet significa attraversare alcune delle più grandi innovazioni tecnologiche degli ultimi 50 anni. Da progetto militare nato nel clima della Guerra Fredda, Internet si è evoluto in una rete accademica e di ricerca negli anni '80, per poi trasformarsi, grazie all'avvento del World Wide Web nei primi anni '90, in uno strumento di comunicazione globale.

Oggi Internet è il tessuto connettivo della nostra società digitale. Attraverso la rete gestiamo le nostre attività quotidiane: lavoriamo da remoto, accediamo ai servizi della Pubblica Amministrazione, comunichiamo con amici e familiari, facciamo acquisti, ci intratteniamo con streaming video e gaming online. L'Internet delle Cose (IoT) sta inoltre collegando alla rete un numero sempre crescente di dispositivi, dalle automobili agli elettrodomestici, dai sistemi di sicurezza domestica ai dispositivi indossabili.

Da strumento militare a necessità quotidiana

In questo contesto, disporre di una connessione Internet stabile e veloce è diventato fondamentale.

Che si tratti di partecipare a una videoconferenza di lavoro, seguire una lezione online, guardare un film in streaming o gestire i dispositivi della casa intelligente, la qualità della connessione determina in larga misura la qualità della nostra esperienza digitale.

Dall'esperimento ARPANET del 1969 a oggi, Internet ha trasformato radicalmente il nostro modo di vivere, lavorare e comunicare, diventando una risorsa essenziale per la società contemporanea.

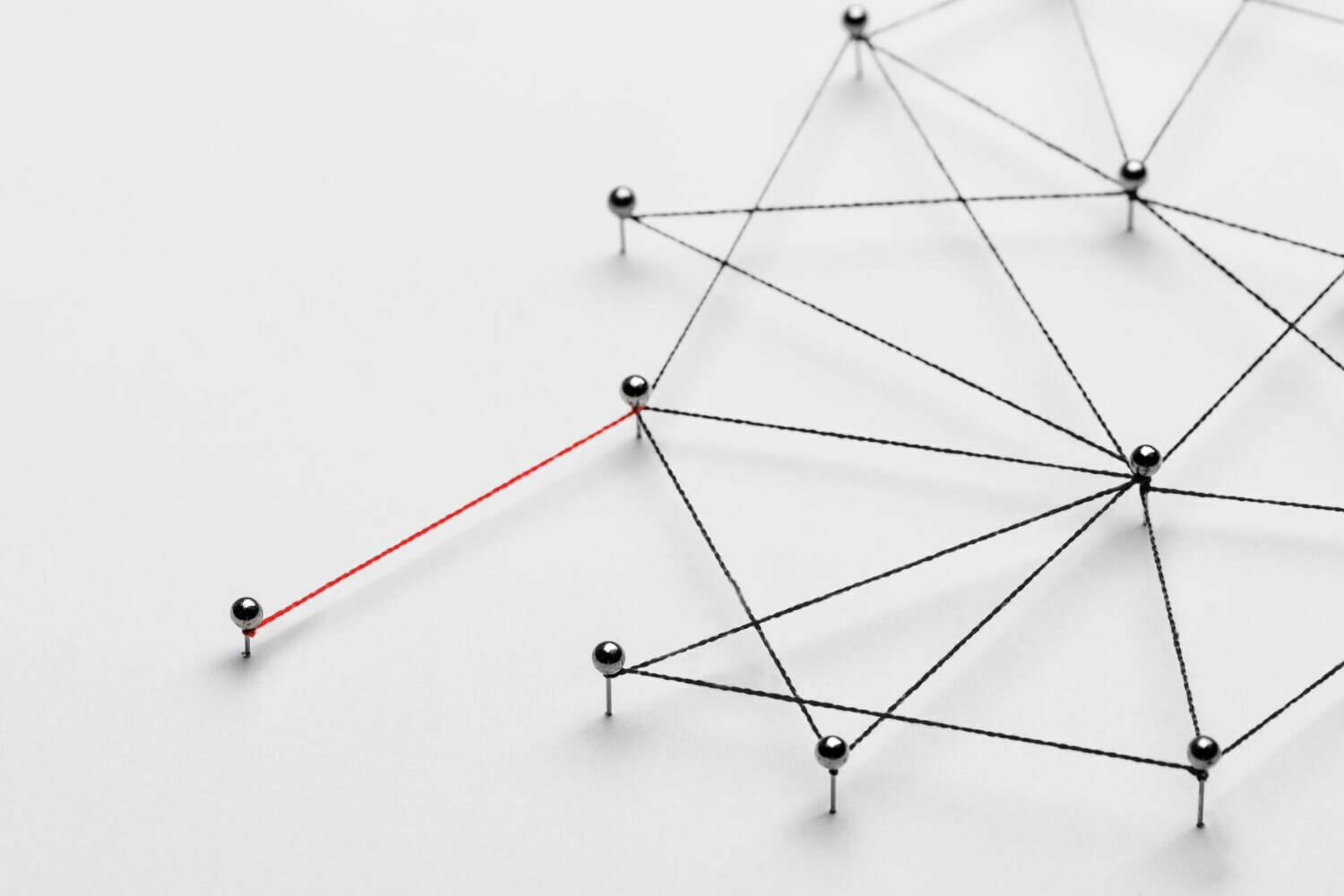

Una panoramica sui vari tipi di rete

Per rete si intende un qualsivoglia numero di sistemi indipendenti che sono collegati tra di loro in maniera tale da permettere uno scambio di dati. I sistemi collegati tra di loro devono presentare oltre ad una connessione fisica, anche una logica.

Quest’ultima viene prodotta attraverso protocolli di rete specifici come quello TCP (Transmission Control Protocol). La connessione di due computer è sufficiente per essere considerata una rete.

Una panoramica sui vari tipi di rete

Le reti vengono configurate con uno scopo ben preciso, che può essere la trasmissione di dati da un sistema all’altro o quello di rendere disponibili nella rete risorse comuni quali server, database o stampanti. In base alla grandezza e al raggio d’azione del sistema dei computer è possibile distinguere diverse dimensioni di rete.

Tra i più importanti tipi di rete si annoverano:

- Personal Area Network (PAN)

- Local Area Network (LAN)

- Metropolitan Area Network (MAN)

- Wide Area Network (WAN)

- Global Area Network (GAN)

Una panoramica sui vari tipi di rete

La connessione fisica che sta alla base di questi tipi di reti può essere realizzata via cavo o via onde radio (radiotecnica).

Spesso le reti di comunicazione fisiche pongono le condizioni necessarie per parecchie reti di connessioni logiche, le cosiddette Virtual Private Network (VPN). Nonostante queste reti utilizzino per la trasmissione dati un mezzo di trasmissione fisico comune, come ad esempio un cavo a fibre ottiche, vengono assegnate a diverse reti logiche virtuali tramite software per il tunneling.

Ogni tipo di rete è stato sviluppato per specifici settori di utilizzo, è basato su tecniche e standard diversi, e presenta quindi vantaggi e limitazioni diverse.

Personal Area Network (PAN)

I dispositivi moderni come smartphone, tablet, notebook o computer desktop si possono connettere ad una rete ad hoc in modo da permettere uno scambio di dati.

Quando la connessione passa tramite cavo, si parla di Personal Area Network (PAN). In questo caso le tecniche di trasmissione più comuni sono quella USB o FireWire.

La variante senza cavi Wireless Personal Area Network (WPAN) si basa su tecniche come Bluetooth, Wireless USB, Insteon, IrDA, ZigBee o Z-Wave.

Una Wireless Personal Area Network che funziona tramite bluetooth prende il nome di piconet. Le connessioni PAN e WPAN si estendono normalmente per pochi metri e non sono quindi adatte a collegare dispositivi in stanze diverse o in altri edifici.

Personal Area Network (PAN)

Oltre alla comunicazione tra due terminali, una Personal Area Network rende possibile anche la connessione ad altre reti più grandi. In questo caso si parla di un uplink.

Per via del raggio d’azione limitato ed un altrettanto basso tasso di trasmissione dei dati, le reti PAN vengo usate soprattutto per collegare periferiche nel campo degli hobby e dell’intrattenimento. Degli esempi tipici sono le cuffie senza fili, le console di gioco e le macchine fotografiche digitali.

Nell’Internet of Things (IoT) le reti WPAN vengono utilizzate per funzioni di controllo e monitoraggio con bassi tassi di trasmissione dati. I protocolli come Insteon, Z-Wave e ZigBee sono stati progettati specificamente per le smart home e per la domotica.

Local Area Network (LAN)

Solitamente più computer sono collegati assieme in un’unica rete tramite una Local Area Network (LAN).

Una rete locale di questo tipo può collegare due computer in una casa privata così come collegare mille apparecchi in un’azienda. Anche le reti delle istituzioni pubbliche come autorità, scuole o università sono realizzate tramite LAN.

Uno standard ampiamente diffuso per le Local Area Network collegate via cavo è l’Ethernet. La trasmissione dati avviene o per via elettronica tramite cavi in rame o tramite fibra ottica, ossia attraverso filamenti in fibra di vetro.

Local Area Network (LAN)

Nel caso in cui più di due computer siano connessi in una rete LAN, sono necessarie ulteriori componenti di rete come hub, bridge, e switch che fungono da elementi di unione e nodi di connessione.

La rete LAN è stata sviluppata al fine di rendere possibile una trasmissione veloce di grandi quantità di dati. A seconda della struttura della rete e del mezzo di trasmissione utilizzato, la trasmissione dati della LAN si aggira di norma dai 10 ai 1.000 Mbit/s.

Le reti LAN consentono uno scambio di informazioni facile tra apparecchi diversi collegati tra loro in rete. Solitamente nelle aziende tramite una rete LAN vengono messi a disposizione tra più computer file server, stampanti o programmi.

Metropolitan Area Network (MAN)

La Metropolitan Area Network (MAN), che in italiano potrebbe essere tradotta come rete metropolitana senza fili, viene definita come una rete di telecomunicazione a banda larga, che collega più LAN geograficamente vicine.

Di solito si tratta di singole filiali di un’azienda, che vengono connesse ad una MAN attraverso l’affitto di linee dedicate. Per questo utilizzo vengono utilizzati router efficienti e connessioni altamente performanti in fibra ottica, che consentono una trasmissione dati maggiore rispetto ad Internet. La velocità di trasferimento tra due nodi distanti è comparabile alla comunicazione interna di una LAN.

Le Wide Area Network sono per la maggior parte possedute da una determinata organizzazione o azienda e vengono gestite privatamente o affittate. Inoltre i fornitori di servizi Internet (ISP, Internet Service Provider) utilizzano le WAN per allacciare le reti delle aziende ed i clienti finali ad Internet.

Global Area Network (GAN)

Una rete universale quale è Internet viene definita come Globe Area Network (GAN). Tuttavia una rete come Internet non è l’unica nel suo genere.

Vi sono compagnie che gestiscono delle reti chiuse, che comprendono diverse WAN e così riescono a mettere in contatto i propri computer a livello mondiale.

Le GAN utilizzano le infrastrutture a fibra ottica delle WAN e le congiungono attraverso cavi sottomarini internazionali o trasmissioni satellitari.

Virtual Private Network (VPN)

Una Virtual Private Network (VPN) è una rete di comunicazione virtuale che utilizza l’infrastruttura di una rete fisica, per connettere dei sistemi in maniera analogica.

Tuttavia detta così potrebbe trattarsi di qualunque delle reti descritte in precedenza.

Solitamente si tratta di una rete che utilizza Internet come mezzo di trasporto, così da collegare quasi tutti i computer a livello mondiale ed essere disponibile gratuitamente, contrariamente alle MAN o alle WAN che sono gestite privatamente.

Il trasferimento dati avviene tramite un tunnel virtuale, il quale serve a stabilire una connessione tra un client VPN ed un server VPN. Al fine di mantenere la riservatezza dei dati, di regola le Virtual Private Network vengono criptate. Lo scopo d’utilizzo delle VPN è solitamente la connessione di diverse LAN su Internet, o quello di rendere possibile l’accesso remoto ad una rete o di un singolo computer tramite connessione pubblica.

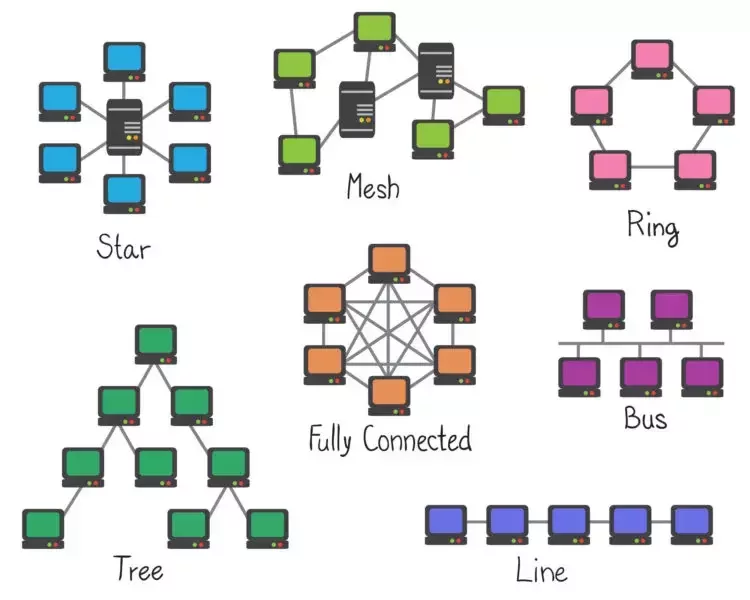

Le topologie di rete informatica

Le topologie di rete informatica

Oltre alle varie tipologie geografiche che contraddistinguono una rete informatica, il modo con cui nodi e collegamenti la configurano consente di classificare differenti topologie.

-

Bus: prevede il collegamento di ogni nodo attraverso una connessione diretta;

- Stella: prevede il collegamento dei nodi ad una serie di hub tra di loro collegati. In questo modo tutti i nodi connessi alla rete possono entrare in comunicazione in maniera indiretta;

Le topologie di rete informatica

-

Anello: prevede il collegamento dei nodi attraverso un loop in grado di garantire il collegamento diretto delle coppie adiacenti ed il collegamento indiretto di tutte le coppie previste;

- Mesh: prevede il collegamento dei nodi attraverso una sovrapposizione delle loro connessioni, in modo da privilegiare lo scambio di dati tra alcuni nodi o porzioni della rete. Si tratta di una tipologia caratterizzata da una elevata ridondanza, per certi versi onerosa ma al tempo stesso capace di ottimizzare e sfruttare al meglio ad esempio la presenza di vari access point di una rete wireless.

Le topologie di rete informatica

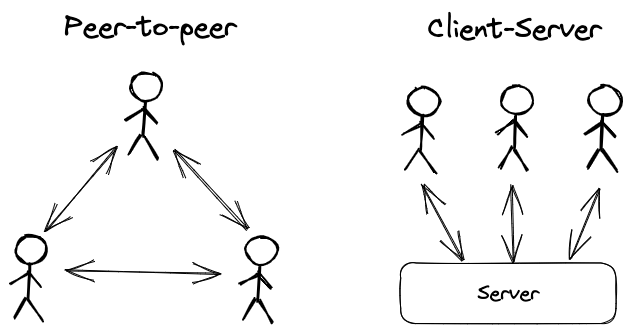

Dal punto di vista architetturale è inoltre possibile distinguere due tipi di riferimento: l’architettura di rete P2P (peer-to-peer) e l’architettura di rete client/server.

L’architettura P2P

L’architettura P2P prevede la presenza di più nodi connessi con pari privilegi. Si tratta di un modello decentralizzato in cui i vari peer comunicano direttamente tra loro senza la necessità di un nodo di controllo centrale, in quanto fungono essi stessi sia da client che da server per gli altri nodi.

Casi celebri di P2P sono dati dalle reti per il file sharing e dalle reti blockchain, in cui ogni nodo svolge le proprie funzioni grazie all’esecuzione di un software, generalmente open source in modo da consentire a tutti gli utenti di verificare il contenuto.

L’architettura P2P

Data la loro natura aperta, le reti P2P attive sulla rete Internet sono caratterizzate da una governance democratica, in cui ogni modifica proposta deve ricevere il consenso di una più o meno elevata percentuale di nodi.

Il modello P2P risulta funzionale anche nel caso di una rete aziendale in cui ogni nodo può ad esempio condividere le proprie risorse hardware (CPU, memoria, storage, rete, ecc.).

L’architettura Client / Server

La più tradizionale architettura client/server prevede un modello gerarchico con i nodi periferici (client) che comunicano tra loro attraverso un server centrale, che detta le regole in merito alle risorse e ai dati trasmessi e condivisi all’interno della rete.

Al pari delle reti P2P non ci sono particolari limiti dimensionali, in quanto l’architettura client/server può essere configurata su più livelli, sia on-premise che in cloud, connettendo un numero anche molto elevato di nodi.

Si tratta dell’architettura di rete più diffusa in ambito aziendale, grazie all’elevato livello di controllo, ottenibile mediante la gestione dei nodi server.

Tecnologie digitali e competenze Informatiche:

un percorso completo

Viviamo in un'era in cui la tecnologia digitale permea ogni aspetto della nostra esistenza quotidiana.

Dalla gestione delle comunicazioni personali alla conservazione dei nostri ricordi fotografici, dall'organizzazione del lavoro professionale all'accesso all'istruzione e alla cultura, le competenze digitali sono diventate essenziali quanto saper leggere e scrivere.

Questo percorso formativo si propone di accompagnarvi attraverso quattro dimensioni fondamentali del mondo digitale: la gestione dei dati e dei contenuti, i principi che regolano le tecnologie dell'informazione e della comunicazione, il funzionamento hardware e software dei computer, e infine gli strumenti pratici per interagire efficacemente nel mondo digitale, con particolare attenzione all'ecosistema Google.

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

Quando parliamo di dati digitali, ci riferiamo a informazioni codificate in formato binario, ovvero attraverso sequenze di 0 e 1 che i computer possono elaborare.

Questa rappresentazione fondamentale è alla base di tutto ciò che faccimo con i dispositivi digitali.

Un documento di testo, una fotografia, un video, un brano musicale: tutto viene tradotto in questo linguaggio universale che le macchine comprendono.

1.1 Comprendere la Natura dei Dati Digitali

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

La distinzione tra dati, informazioni e conoscenza è cruciale per comprendere come gestire efficacemente i contenuti digitali.

I dati rappresentano elementi grezzi, non organizzati: numeri, parole, misurazioni.

Le informazioni emergono quando questi dati vengono organizzati, strutturati e contestualizzati in modo significativo.

La conoscenza, infine, si genera quando le informazioni vengono interiorizzate, comprese e utilizzate per prendere decisioni o risolvere problemi.e online.

1.1 Comprendere la Natura dei Dati Digitali

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

Nel contesto digitale, questa gerarchia assume caratteristiche particolari. I dati possono essere elaborati automaticamente da algoritmi che identificano pattern e correlazioni.

Le informazioni possono essere indicizzate, ricercate e recuperate istantaneamente da enormi archivi distribuiti geograficamente.

La conoscenza può essere condivisa globalmente e arricchita collaborativamente attraverso piattaforme online.

1.1 Comprendere la Natura dei Dati Digitali

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

I contenuti digitali si presentano in molteplici forme, ciascuna con caratteristiche specifiche che ne influenzano la gestione.

I documenti testuali possono esistere in formati diversi: dai semplici file di testo puro (.txt) che contengono solo caratteri senza formattazione, ai documenti elaborati come quelli di Microsoft Word (.docx) o OpenDocument (.odt) che includono stili, immagini incorporate e metadati complessi.

I PDF rappresentano un formato particolare, progettato per mantenere l'aspetto visivo identico su qualsiasi dispositivo, rendendoli ideali per documenti ufficiali e pubblicazioni.

1.2 Tipologie di Contenuti Digitali

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

Le immagini digitali meritano un'attenzione particolare.

Possiamo distinguere tra immagini raster, composte da una griglia di pixel colorati, e immagini vettoriali, definite attraverso equazioni matematiche che descrivono forme geometriche.

Le prime sono tipiche della fotografia digitale e possono essere salvate in formati come JPEG, che utilizza compressione con perdita di qualità per ridurre le dimensioni, o PNG, che offre compressione senza perdita e supporta la trasparenza.

Le immagini vettoriali, come i file SVG o AI, sono preferite per loghi e grafiche che devono essere scalabili senza perdita di nitidezza.

1.2 Tipologie di Contenuti Digitali

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

I contenuti multimediali audio e video rappresentano una sfida particolare per la gestione dei dati, dato che tendono a occupare spazi considerevoli.

Un file audio non compresso può raggiungere dimensioni notevoli: un minuto di audio in qualità CD occupa circa 10 megabyte.

Ecco perché esistono formati compressi come MP3 o AAC per l'audio, e H.264 o H.265 per i video, che riducono drasticamente le dimensioni mantenendo una qualità accettabile attraverso algoritmi sofisticati che eliminano le informazioni ridondanti o meno percepibili dall'orecchio e dall'occhio umano.

1.2 Tipologie di Contenuti Digitali

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

L'organizzazione efficace dei contenuti digitali è fondamentale per poterli ritrovare e utilizzare quando necessario. Il sistema di file e cartelle, ereditato dai primi sistemi operativi, rimane il paradigma dominante, ma richiede disciplina e metodo per essere veramente utile.

Una struttura gerarchica ben progettata inizia con categorie ampie che si suddividono progressivamente in sottocategorie più specifiche.

Ad esempio, una cartella "Documenti" potrebbe contenere sottocartelle per "Lavoro", "Personale", "Formazione", ciascuna delle quali si ramifica ulteriormente.

All'interno di "Lavoro" potremmo avere sottocartelle per anno, poi per progetto, poi per tipo di documento. Questa organizzazione ad albero rispecchia il modo in cui la nostra mente tende a categorizzare le informazioni.

1.3 Organizzazione e Strutturazione dei Contenuti

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

La denominazione dei file è altrettanto importante. Un file chiamato "documento1.docx" non fornisce alcuna informazione utile.

Molto meglio adottare convenzioni che includano elementi identificativi: la data in formato ISO (AAAA-MM-GG) che permette l'ordinamento cronologico automatico, una descrizione significativa del contenuto, eventualmente un numero di versione.

Ad esempio: "2024-03-15_Relazione_Progetto_Alpha_v2.docx" è immediatamente comprensibile e posizionabile nel tempo.

1.3 Organizzazione e Strutturazione dei Contenuti

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

I metadati rappresentano un livello aggiuntivo di organizzazione. Si tratta di dati sui dati: informazioni che descrivono il contenuto di un file senza essere parte del contenuto stesso.

Una fotografia digitale, ad esempio, include metadati EXIF che registrano la data e l'ora dello scatto, il modello di fotocamera utilizzato, le impostazioni di esposizione, e spesso anche le coordinate GPS del luogo.

I documenti office contengono metadati sull'autore, la data di creazione e modifica, il titolo, le parole chiave.

Questi metadati possono essere utilizzati per ricerche avanzate e per organizzare automaticamente grandi quantità di file.

1.3 Organizzazione e Strutturazione dei Contenuti

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

La scelta delle modalità di archiviazione dei dati è una decisione strategica che bilancia diversi fattori: accessibilità, sicurezza, costo, durata nel tempo.

L'archiviazione locale, su dischi rigidi interni o esterni, offre velocità di accesso e controllo diretto, ma espone ai rischi di guasti hardware, furti, incendi o altri disastri fisici.

Un disco rigido meccanico tradizionale ha una vita media di 3-5 anni, mentre gli SSD (Solid State Drive) possono durare più a lungo ma hanno un numero limitato di cicli di scrittura.

1.4 Archiviazione e Backup

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

Il cloud storage ha rivoluzionato il modo in cui conserviamo i dati.

Servizi come Google Drive, Dropbox, OneDrive, iCloud offrono spazio di archiviazione su server remoti, accessibile da qualsiasi dispositivo connesso a internet.

I vantaggi sono molteplici: sincronizzazione automatica tra dispositivi, protezione da perdite fisiche del dispositivo locale, facilità di condivisione con altri utenti.

I provider professionali implementano ridondanza geografica, conservando copie dei dati in data center differenti per garantire la disponibilità anche in caso di guasti localizzati.

1.4 Archiviazione e Backup

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

Tuttavia, affidarsi esclusivamente al cloud comporta rischi propri: dipendenza dalla connessione internet, possibilità di interruzioni del servizio, questioni di privacy e proprietà dei dati.

La strategia ottimale segue la regola del 3-2-1: mantenere almeno tre copie dei dati importanti, su almeno due tipi di supporti diversi, con almeno una copia conservata in una posizione fisica differente.

Il backup non è un'operazione occasionale ma un processo continuo. I backup possono essere completi, copiando l'intero set di dati, o incrementali, salvando solo le modifiche dall'ultimo backup. I sistemi moderni offrono funzionalità di versioning che permettono di recuperare non solo i file cancellati accidentalmente, ma anche versioni precedenti di file modificati, proteggendo da errori di editing o corruzioni involontarie.

1.4 Archiviazione e Backup

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

La protezione dei dati personali e sensibili è diventata una priorità assoluta nell'era digitale. La crittografia rappresenta la prima linea di difesa: trasforma i dati in una forma illeggibile senza la chiave corretta.

La crittografia può essere applicata ai dati "a riposo" (stored encryption), proteggendo file e cartelle sul dispositivo o nel cloud, e ai dati "in transito" (transport encryption), come quando navighiamo su un sito web protetto da HTTPS.

1.5 Sicurezza e Privacy dei Dati

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

Le password costituiscono il meccanismo di autenticazione più diffuso, ma anche uno dei più vulnerabili se non gestite correttamente.

Una password robusta dovrebbe essere lunga (almeno 12-16 caratteri), includere una combinazione di lettere maiuscole e minuscole, numeri e simboli speciali, ed evitare parole del dizionario o informazioni personali facilmente indovinabili.

Soprattutto, ogni servizio dovrebbe avere una password unica: il riutilizzo delle password è una delle vulnerabilità più sfruttate dagli attaccanti.

1.5 Sicurezza e Privacy dei Dati

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

I password manager sono strumenti essenziali per gestire decine o centinaia di credenziali diverse.

Questi software generano password complesse casuali, le conservano in un archivio crittografato protetto da una master password, e le inseriscono automaticamente quando necessario.

Servizi come LastPass, 1Password, Bitwarden o il gestore integrato nei browser moderni semplificano enormemente la gestione sicura delle credenziali.

1.5 Sicurezza e Privacy dei Dati

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

L'autenticazione a due fattori (2FA) aggiunge un livello di sicurezza cruciale.

Oltre alla password (qualcosa che conosci), richiede un secondo fattore: qualcosa che possiedi (come uno smartphone che riceve un codice via SMS o tramite app come Google Authenticator) o qualcosa che sei (biometria come impronta digitale o riconoscimento facciale).

Anche se qualcuno venisse a conoscenza della vostra password, non potrebbe accedere all'account senza il secondo fattore.

1.5 Sicurezza e Privacy dei Dati

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

La privacy dei dati personali è regolata da normative come il GDPR europeo, che stabilisce diritti fondamentali: il diritto di sapere quali dati vengono raccolti e per quali scopi, il diritto di accedere ai propri dati, il diritto di correggerli se errati, il diritto alla cancellazione (right to be forgotten), il diritto alla portabilità dei dati verso altri servizi.

Le organizzazioni che trattano dati personali devono implementare misure tecniche e organizzative appropriate per proteggere questi dati da accessi non autorizzati, perdite o divulgazioni.

1.5 Sicurezza e Privacy dei Dati

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

Le tecnologie digitali hanno trasformato radicalmente le modalità di collaborazione. La condivisione di documenti non richiede più l'invio di allegati email che generano versioni multiple e confusione su quale sia quella più aggiornata.

Le piattaforme collaborative come Google Workspace, Microsoft 365, o Notion permettono l'editing simultaneo da parte di più utenti, con visibilità in tempo reale delle modifiche apportate da ciascuno.

I sistemi di controllo versione, originariamente sviluppati per la programmazione software, trovano applicazione crescente anche per documenti e contenuti creativi. Git, il più popolare, traccia ogni modifica, chi l'ha effettuata e quando, permettendo di tornare a qualsiasi versione precedente e di gestire rami di sviluppo paralleli che possono essere successivamente riconciliati.

1.6 Condivisione e Collaborazione

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

La gestione dei permessi di accesso è cruciale nella condivisione.

I contenuti possono essere resi pubblici, accessibili a chiunque conosca il link, condivisi con utenti specifici identificati per email, o mantenuti privati.

I permessi possono essere granulari: alcuni utenti possono solo visualizzare, altri possono commentare, altri ancora possono modificare.

Per documenti particolarmente sensibili, è possibile impostare scadenze temporali per l'accesso o richiedere autenticazione aggiuntiva.

1.6 Condivisione e Collaborazione

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

Le licenze d'uso definiscono legalmente cosa può essere fatto con un contenuto condiviso.

Le licenze Creative Commons offrono un framework flessibile: si può permettere l'uso commerciale o limitarlo a usi non commerciali, richiedere l'attribuzione all'autore originale, permettere modifiche e opere derivative o consentire solo la redistribuzione inalterata.

Comprendere e rispettare queste licenze è fondamentale per evitare violazioni del diritto d'autore.

1.6 Condivisione e Collaborazione

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

In un'epoca di sovrabbondanza informativa, la capacità di trovare rapidamente ciò che serve è tanto importante quanto quella di organizzare e conservare. I motori di ricerca hanno perfezionato algoritmi sofisticati che vanno ben oltre la semplice corrispondenza di parole chiave.

La ricerca booleana utilizza operatori logici per raffinare le query: AND per trovare risultati che contengono tutti i termini specificati, OR per risultati che contengono almeno uno dei termini, NOT per escludere termini specifici. Le virgolette permettono di cercare frasi esatte, mentre gli asterischi fungono da wildcard per variazioni di una parola.

Operatori avanzati come "site:" limitano la ricerca a un dominio specifico, "filetype:" a un tipo di file particolare, "intitle:" a pagine con termini specifici nel titolo.

1.7 Ricerca e Recupero dell'Informazione

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

I sistemi di ricerca moderni utilizzano l'indicizzazione full-text, che analizza il contenuto di ogni documento e crea un indice inverso che mappa ogni termine alle posizioni in cui appare.

Questo permette ricerche istantanee anche in archivi enormi.

Algoritmi di ranking determinano l'ordine dei risultati basandosi su fattori di rilevanza: frequenza dei termini cercati, posizione nel documento, autorevolezza della fonte, freschezza dell'informazione.

1.7 Ricerca e Recupero dell'Informazione

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

I dati hanno un ciclo di vita che va dalla creazione alla eventuale eliminazione, passando attraverso fasi di utilizzo attivo, archiviazione e conservazione. Gestire efficacemente questo ciclo significa ottimizzare risorse, garantire conformità normativa e proteggere informazioni sensibili.

Nella fase di creazione, è importante catturare immediatamente i metadati corretti e applicare le classificazioni appropriate. I dati dovrebbero essere validati per assicurare accuratezza e completezza.

Durante l'utilizzo attivo, i dati risiedono in sistemi facilmente accessibili, vengono modificati, combinati con altri dati, analizzati. È la fase di massima vulnerabilità ma anche di massimo valore.

1.8 Gestione del Ciclo di Vita dei Dati

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

Quando i dati non sono più necessari per operazioni quotidiane ma devono essere conservati per ragioni legali, storiche o di referenza, entrano nella fase di archiviazione. Possono essere spostati su supporti meno costosi e più lenti, con meccanismi di retrieval che possono richiedere più tempo. La compressione può ridurre ulteriormente lo spazio richiesto.

L'eliminazione dei dati, quando non sono più necessari o quando richiesta dall'interessato nell'esercizio dei suoi diritti, deve essere sicura e verificabile. La semplice cancellazione di un file non lo rimuove fisicamente dal supporto: rende solo disponibile quello spazio per nuove scritture. Per eliminazioni definitive di dati sensibili sono necessarie tecniche di sovrascrittura multipla o distruzione fisica del supporto.

1.8 Gestione del Ciclo di Vita dei Dati

PARTE 1: Gestire Dati, Informazioni e Contenuti Digitali

Le politiche di data retention specificano per quanto tempo diverse categorie di dati devono essere conservate.

Alcune normative impongono periodi minimi di conservazione per documenti fiscali, contabili, sanitari.

Altre normative sulla privacy richiedono che i dati personali non siano conservati oltre il tempo strettamente necessario per gli scopi dichiarati. Bilanciare questi requisiti talvolta contrastanti richiede processi ben documentati e sistemi che possano applicarli automaticamente.

1.8 Gestione del Ciclo di Vita dei Dati

PARTE 2: Principi della Tecnologia dell'Informazione e della Comunicazione

2.5 Sicurezza Informatica

La sicurezza informatica protegge sistemi, reti e dati da accessi non autorizzati, modifiche, distruzioni. Si basa sulla triade CIA:

Confidentiality (le informazioni sono accessibili solo a chi autorizzato),

Integrity (le informazioni non vengono alterate in modo non autorizzato),

Availability (le informazioni e i sistemi sono disponibili quando necessari).

Le minacce sono molteplici. Il malware comprende virus che si replicano infettando altri file, worm che si propagano automaticamente attraverso reti, trojan che si mascherano da software legittimo, ransomware che cripta i dati della vittima richiedendo un riscatto.

2.5 Sicurezza Informatica

Il phishing tenta di ingannare utenti per rivelare credenziali o informazioni sensibili attraverso email o siti web contraffatti che imitano servizi legittimi.

Gli attacchi DDoS (Distributed Denial of Service) sovraccaricano un servizio con traffico massivo da molte sorgenti, rendendolo inaccessibile.

Le contromisure sono stratificate. I firewall filtrano il traffico di rete basandosi su regole, bloccando connessioni sospette. Gli antivirus rilevano malware attraverso firme di codice noto e analisi comportamentale di attività sospette.

PARTE 2: Principi della Tecnologia dell'Informazione e della Comunicazione

2.5 Sicurezza Informatica

I sistemi di rilevamento intrusioni monitorano reti e sistemi per attività anomale. Gli aggiornamenti software correggono vulnerabilità scoperte, chiudendo falle che potrebbero essere sfruttate.

L'ingegneria sociale sfrutta la psicologia umana piuttosto che vulnerabilità tecniche. Un attaccante potrebbe impersonare il supporto tecnico per convincere un utente a rivelare la password, o creare un senso di urgenza per bypassare il pensiero critico. L'educazione degli utenti e politiche di sicurezza chiare sono difese essenziali contro queste tecniche.

PARTE 2: Principi della Tecnologia dell'Informazione e della Comunicazione

2.6 Database e Gestione dei Dati

I database organizzano grandi quantità di dati strutturati per l'accesso e la manipolazione efficiente. I database relazionali, basati sul modello proposto da Edgar Codd negli anni '70, organizzano i dati in tabelle (relazioni) composte da righe (tuple) e colonne (attributi).

Le chiavi primarie identificano univocamente ogni riga.

Le chiavi esterne creano relazioni tra tabelle, permettendo di rappresentare strutture complesse evitando ridondanza.

PARTE 2: Principi della Tecnologia dell'Informazione e della Comunicazione

2.6 Database e Gestione dei Dati

SQL (Structured Query Language) è il linguaggio standard per interagire con database relazionali.

Le query SELECT recuperano dati, potenzialmente da multiple tabelle attraverso join, filtrando con clausole WHERE, ordinando con ORDER BY, aggregando con funzioni come COUNT, SUM, AVG.

Le operazioni INSERT, UPDATE, DELETE modificano i dati. I comandi DDL (Data Definition Language) creano e modificano la struttura delle tabelle.

PARTE 2: Principi della Tecnologia dell'Informazione e della Comunicazione

2.6 Database e Gestione dei Dati

I database NoSQL offrono alternative al modello relazionale per casi d'uso specifici.

I database document-oriented come MongoDB conservano dati semi-strutturati in formato JSON. I database key-value come Redis offrono accesso estremamente rapido ma con query limitate.

I database column-oriented come Cassandra ottimizzano per grandi volumi di scritture distribuite. I graph database come Neo4j rappresentano esplicitamente relazioni complesse tra entità.

PARTE 2: Principi della Tecnologia dell'Informazione e della Comunicazione

2.7 Cloud Computing

Il cloud computing fornisce risorse informatiche (calcolo, storage, networking, software) come servizio accessibile via internet, con pagamento basato sull'effettivo utilizzo.

Il modello elimina la necessità di investimenti iniziali in infrastruttura, permette scalabilità elastica per adattarsi a carichi variabili, e trasferisce la gestione dell'infrastruttura al provider.

PARTE 2: Principi della Tecnologia dell'Informazione e della Comunicazione

2.7 Cloud Computing

I modelli di servizio si distinguono per il livello di astrazione.

IaaS (Infrastructure as a Service) fornisce risorse virtualizzate: server virtuali, storage, networking. L'utente gestisce sistema operativo, middleware, applicazioni.

PaaS (Platform as a Service) fornisce una piattaforma di sviluppo e deployment: l'utente sviluppa e carica applicazioni, il provider gestisce l'infrastruttura sottostante.

SaaS (Software as a Service) fornisce applicazioni complete accessibili via browser: l'utente semplicemente le utilizza, tutto il resto è gestito dal provider.

PARTE 2: Principi della Tecnologia dell'Informazione e della Comunicazione

2.8 Intelligenza Artificiale e Machine Learning

L'intelligenza artificiale mira a creare sistemi che esibiscono comportamenti considerati intelligenti se eseguiti da umani: ragionamento, apprendimento, percezione, elaborazione del linguaggio naturale.

Il machine learning, un sottoinsieme dell'IA, permette ai sistemi di migliorare le prestazioni con l'esperienza senza essere esplicitamente programmati per ogni situazione.

PARTE 2: Principi della Tecnologia dell'Informazione e della Comunicazione

2.8 Intelligenza Artificiale e Machine Learning

I transformer, architettura introdotta nel 2017, hanno rivoluzionato il natural language processing. Utilizzano meccanismi di attenzione che permettono al modello di concentrarsi su parti rilevanti dell'input quando elabora ciascun elemento. Modelli come GPT e BERT, addestrati su enormi quantità di testo, hanno raggiunto prestazioni impressionanti in comprensione e generazione del linguaggio.

L'etica dell'IA solleva questioni importanti. I bias nei dati di addestramento possono portare a sistemi che discriminano gruppi demografici. La mancanza di trasparenza nei modelli complessi (il problema della "black box") rende difficile comprendere e contestare decisioni automatizzate. L'impatto sull'occupazione, la privacy, l'autonomia umana richiedono considerazione attenta e governance appropriata.

PARTE 2: Principi della Tecnologia dell'Informazione e della Comunicazione

3.1 Componenti Hardware FondamentalI

Il processore, o CPU (Central Processing Unit), è il cervello del computer che esegue le istruzioni dei programmi. La velocità di clock, misurata in gigahertz, indica quanti cicli di base il processore può eseguire al secondo. Un processore a 3 GHz completa tre miliardi di cicli al secondo.

I processori contemporanei sono multi-core: integrano multiple unità di elaborazione indipendenti sullo stesso chip. Un processore quad-core ha quattro core che possono eseguire task simultaneamente, moltiplicando potenzialmente le prestazioni per applicazioni che possono parallelizzare il lavoro. Processori consumer possono avere 4-16 core, mentre processori server possono raggiungere 64 o più core per gestire carichi di lavoro massivi.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.1 Componenti Hardware FondamentalI

La cache è memoria ultra-veloce integrata nel processore per conservare dati e istruzioni frequentemente usati. È organizzata in livelli:

- L1 è la più veloce ma più piccola (tipicamente 32-64 KB per core), situata direttamente nei core.

- L2 è leggermente più lenta ma più capiente (256-512 KB per core).

- L3 è condivisa tra tutti i core ed è ancora più grande (8-32 MB tipicamente).

Questa gerarchia bilancia velocità, capacità e costo della cache.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.1 Componenti Hardware FondamentalI

La memoria RAM (Random Access Memory) è la memoria volatile principale del sistema. Volatile significa che i dati vengono persi quando il computer si spegne. È molto più veloce dello storage permanente ma molto più lenta della cache del processore.

La quantità di RAM influenza direttamente quante applicazioni possono essere eseguite simultaneamente e quanto efficientemente. Computer moderni tipicamente hanno 8-32 GB di RAM, mentre workstation professionali possono avere 64-128 GB o più.

Le tecnologie RAM sono evolute: DDR4 (Double Data Rate 4th generation) è stata lo standard recente, con velocità di trasferimento fino a 3200 MT/s. DDR5, lo standard più recente, raddoppia le velocità potenziali e migliora l'efficienza energetica.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.1 Componenti Hardware FondamentalI

Lo storage permanente conserva dati anche quando il computer è spento.

I dischi rigidi tradizionali (HDD - Hard Disk Drive) usano piatti magnetici rotanti e testine di lettura/scrittura. Offrono grandi capacità a costi contenuti (2-10 TB tipicamente per computer consumer), ma sono meccanici quindi relativamente lenti e vulnerabili a urti. Le velocità di rotazione tipiche sono 5400 o 7200 RPM (rotazioni per minuto).

Attualmente vengono utilizzati per sistemi di storage detti Network Attached Storage (NAS) cioé un dispositivo di archiviazione collegato a una rete (propria o esterna) che consente l'accesso e la condivisione dei dati fra più utenti.

È costituito da uno o più dischi rigidi.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.1 Componenti Hardware FondamentalI

Gli SSD (Solid State Drive) usano memoria flash senza parti mobili.

Sono nettamente più veloci degli HDD: tempi di accesso in microsecondi anziché millisecondi, velocità di lettura/scrittura sequenziale di 500+ MB/s per SATA SSD, fino a 7000+ MB/s per NVMe SSD su interfaccia PCIe.

Sono più resistenti agli urti, più efficienti energeticamente, ma più costosi per gigabyte.

SSD moderni per consumer tipicamente vanno da 256 GB a 2 TB.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

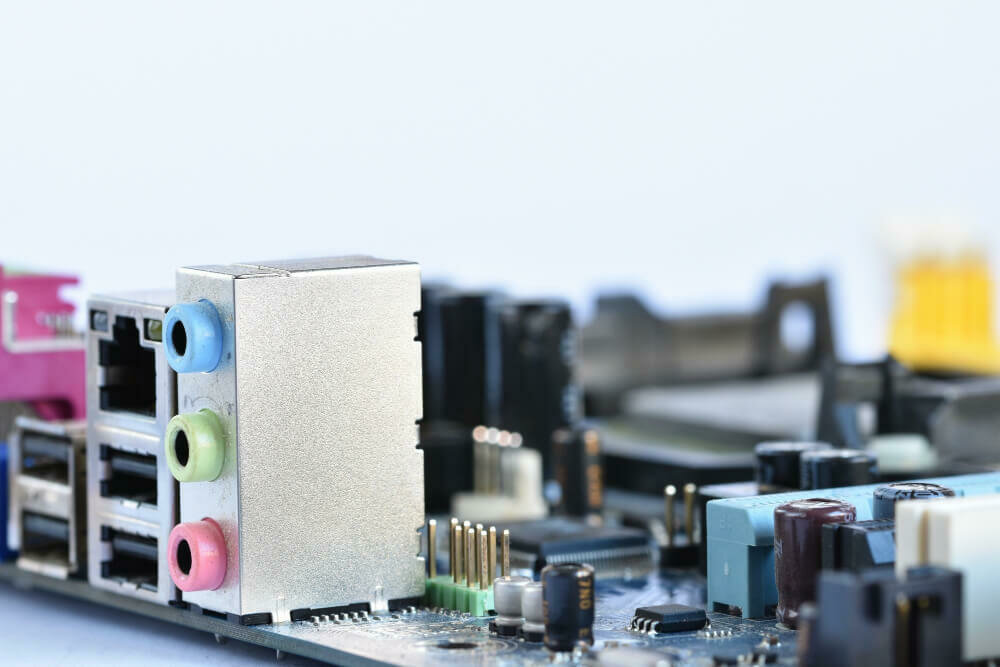

3.1 Componenti Hardware FondamentalI

La scheda madre è la piattaforma che interconnette tutti i componenti. Contiene il chipset che coordina comunicazioni tra processore, memoria e periferiche.

Ha slot per RAM, slot PCIe per schede di espansione (GPU, schede di rete, storage NVMe), connettori per storage SATA, header per USB e altri I/O.

Il BIOS o UEFI firmware sulla scheda madre inizializza l'hardware e avvia il sistema operativo.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.2 Periferiche e Dispositivi di Input/Output

La tastiera è il dispositivo di input testuale primario. Le tastiere meccaniche usano switch individuali per ogni tasto con comportamenti tattili diversi: alcuni richiedono più forza, altri offrono feedback tattile o sonoro distinto.

Le tastiere a membrana sono più economiche e silenziose ma generalmente meno durature. Layout come QWERTY, AZERTY, QWERTZ variano per lingua e regione. Tastiere specializzate esistono per programmazione, gaming, o ergonomia.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.2 Periferiche e Dispositivi di Input/Output

l mouse traduce movimento fisico in movimento del cursore su schermo. I mouse ottici usano LED e sensori per tracciare movimento su quasi ogni superficie. Mouse con sensori laser offrono maggiore precisione, importante per gaming o lavoro grafico.

La sensibilità, misurata in DPI (dots per inch), determina quanto il cursore si muove per un dato movimento fisico. Mouse wireless usano Bluetooth o dongle RF, eliminando cavi ma richiedendo batterie.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.2 Periferiche e Dispositivi di Input/Output

I touchscreen combinano input e output, rilevando tocchi attraverso capacitanza o resistenza. I display capacitivi, standard su smartphone e tablet moderni, rilevano il campo elettrico del dito, supportando multi-touch per gesture come pinch-to-zoom.

I touchpad su laptop funzionano similmente, supportando gesture con più dita per navigazione e controllo.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.2 Periferiche e Dispositivi di Input/Output

I monitor mostrano l'output visivo. La risoluzione indica quanti pixel compongono l'immagine: Full HD è 1920×1080 pixel, 4K è 3840×2160. Risoluzioni più alte mostrano più dettagli e permettono più contenuto su schermo.

La dimensione diagonale in pollici e la densità di pixel (PPI - pixels per inch) determinano quanto nitida appare l'immagine.

Monitor professionali per fotografia o video richiedono copertura ampia di gamut colore e accuratezza cromatica.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.2 Periferiche e Dispositivi di Input/Output

Le stampanti trasferiscono contenuto digitale su carta. Le stampanti a getto d'inchiostro spruzzano microscopiche gocce di inchiostro liquido, eccellenti per foto a colori ma con costi operativi elevati e possibilità che gli ugelli si secchino.

Le stampanti laser usano toner in polvere fuso sulla carta attraverso calore, ideali per grandi volumi di testo con costi per pagina inferiori.

Le stampanti multifunzione integrano scanner e a volte fax, consolidando più dispositivi.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.3 Sistemi Operativi

Il sistema operativo è il software fondamentale che gestisce hardware, fornisce servizi alle applicazioni, e presenta un'interfaccia agli utenti.

Funziona come intermediario tra hardware e software applicativo, astraendo le complessità dell'hardware e fornendo un ambiente consistente per l'esecuzione di programmi.

La gestione di dispositivi attraverso driver permette al sistema operativo di comunicare con hardware eterogeneo. Un driver traduce richieste generiche dal sistema operativo in comandi specifici per il dispositivo. Driver mal scritti possono causare instabilità o crash del sistema, quindi sistemi moderni cercano di isolare driver in spazi protetti limitando il danno potenziale.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.4 Software Applicativo

I word processor permettono creazione e editing di documenti testuali con formattazione sofisticata. Microsoft Word, Google Docs, LibreOffice Writer offrono controllo tipografico: font, dimensioni, stili (grassetto, corsivo, sottolineato), colori.

Supportano struttura gerarchica con stili per heading, permettendo generazione automatica di indici. Funzioni di revisione tracciano modifiche e permettono commenti collaborativi.

Template predefiniti accelerano la creazione di documenti comuni come lettere, curriculum, report.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.4 Software Applicativo

I fogli di calcolo organizzano dati in griglie di righe e colonne, con potenti capacità di calcolo. Celle possono contenere numeri, testo, o formule che calcolano valori basandosi su altre celle.

Excel, Google Sheets, LibreOffice Calc supportano centinaia di funzioni: matematiche (SUM, AVERAGE, ROUND), logiche (IF, AND, OR), di ricerca (VLOOKUP, INDEX/MATCH), statistiche, finanziarie, di manipolazione testo.

Grafici visualizzano dati come linee, barre, torte, scatter plot. Pivot table permettono analisi multidimensionali di dataset complessi, raggruppando e aggregando dati dinamicamente.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.4 Software Applicativo

I software di presentazione creano slide show visualmente accattivanti. PowerPoint, Google Slides, Keynote offrono template di design, permettono inserimento di testo, immagini, video, grafici, animazioni, transizioni tra slide.

Le presentazioni efficaci bilanciano contenuto testuale con elementi visivi, usano gerarchie visive chiare, mantengono consistenza stilistica.

Le funzioni presenter view mostrano note private e prossima slide al relatore mentre il pubblico vede solo la slide corrente.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.4 Software Applicativo

I browser web interpretano ed eseguono HTML, CSS, JavaScript per renderizzare pagine web interattive. Chrome, Firefox, Safari, Edge competono su velocità, compatibilità con standard, funzionalità di sicurezza e privacy.

Le extension permettono agli utenti di aggiungere funzionalità: blocco pubblicità, gestione password, strumenti per sviluppatori, integrazione con servizi esterni.

I client email gestiscono comunicazioni elettroniche. Possono essere applicazioni standalone come Outlook o Thunderbird, o web-based come Gmail o Outlook.com. Supportano organizzazione in cartelle, tagging, ricerca full-text, filtri automatici per smistare messaggi in arrivo.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.5 Comunicazione Digitale: Email

L'email rimane uno dei strumenti di comunicazione digitale più utilizzati, specialmente in contesti professionali. Un indirizzo email ha la forma username@domain.ext: la parte prima della @ identifica l'utente specifico, la parte dopo identifica il server che gestisce la mailbox di quell'utente.

La netiquette email include pratiche per comunicazione efficace e professionale. L'oggetto dovrebbe essere descrittivo e conciso, permettendo al destinatario di capire immediatamente il contenuto e prioritizzare. Il corpo dovrebbe iniziare con un saluto appropriato al contesto (formale per comunicazioni professionali, più casual per conoscenti). Il messaggio dovrebbe essere chiaro, ben strutturato con paragrafi distinti per punti diversi, privo di errori grammaticali. La conclusione dovrebbe includere una call-to-action chiara se si richiede una risposta o azione, seguita da un saluto e firma.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.5 Comunicazione Digitale: Email

Gli allegati permettono di inviare file insieme all'email. Esistono limiti di dimensione tipicamente tra 10-25 MB per messaggio. Per file più grandi, è preferibile usare servizi di file sharing e inviare link. È importante verificare che gli allegati siano nel formato corretto e accessibile ai destinatari. Quando si scaricano allegati, specialmente da mittenti sconosciuti, bisogna essere cauti per rischi di malware.

Le liste di distribuzione permettono di inviare a multipli destinatari. Il campo "To" contiene i destinatari primari, che vedono tutti gli altri destinatari. "Cc" (carbon copy) include persone che dovrebbero essere informate ma non necessariamente devono rispondere. "Bcc" (blind carbon copy) nasconde i destinatari gli uni dagli altri, importante per privacy quando si invia a gruppi che potrebbero non conoscersi.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.5 Comunicazione Digitale: Email

La gestione efficace dell'email include strategie per non essere sopraffatti. Controllare email a intervalli definiti anziché costantemente riduce interruzioni.

La regola dei due minuti suggerisce di rispondere immediatamente a email che richiedono meno di due minuti, per evitare accumulo.

Usare filtri e regole per smistare automaticamente newsletter, notifiche, email da progetti specifici in cartelle dedicate mantiene l'inbox focalizzata su comunicazioni che richiedono attenzione diretta.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.6 Videoconferenze e Collaborazione Real-time

La videoconferenza è diventata essenziale per lavoro remoto, educazione a distanza, mantenimento di relazioni personali. Piattaforme come Zoom, Microsoft Teams, Google Meet, Cisco Webex permettono comunicazione audio-video multipunto con funzionalità collaborative.

L'etichetta delle videochiamate include essere puntuali, testare audio/video prima di meeting importanti, disattivare il microfono quando non si parla per ridurre rumore di fondo, posizionare la camera all'altezza degli occhi con illuminazione adeguata, scegliere uno sfondo appropriato o usare sfondi virtuali se necessario, vestirsi appropriatamente almeno dalla vita in su, guardare la camera quando si parla piuttosto che la propria immagine per simulare contatto visivo.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.7 Messaggistica Istantanea e Social Media

La messaggistica istantanea offre comunicazione testuale sincrona o quasi-sincrona. WhatsApp, Telegram, Signal, iMessage permettono conversazioni uno-a-uno o di gruppo con conferma di consegna e lettura.

Supportano condivisione di foto, video, documenti, posizione geografica, contatti. Le chiamate vocali e video sono integrate in molte app.

La crittografia end-to-end, implementata da Signal, WhatsApp, iMessage, garantisce che solo mittente e destinatario possano leggere i messaggi.

Nemmeno il provider del servizio può accedervi. Questo protegge privacy ma solleva questioni su moderazione di contenuti illegali e indagini legali.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.7 Messaggistica Istantanea e Social Media

I social media hanno impatti profondi sulla società.

Positivamente, democratizzano la voce, permettendo a chiunque di raggiungere audience ampie, facilitano organizzazione di movimenti sociali e politici, mantengono connessioni attraverso distanze geografiche.

Negativamente, possono creare echo chamber dove si è esposti principalmente a opinioni concordi, facilitare diffusione di misinformazione e disinformazione, contribuire a problemi di salute mentale specialmente tra giovani attraverso comparazioni sociali e pressione per approvazione tramite likes.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.7 Messaggistica Istantanea e Social Media

La digital literacy (alfabetizzazione digitale) include capacità di valutare criticamente informazioni online: verificare fonti, cercare corroborazione da fonti multiple e credibili, riconoscere bias e agenda, distinguere fatti da opinioni, identificare tecniche manipolative come cherry-picking di dati o fallaci logiche.

La gestione dell'identità digitale richiede consapevolezza di ciò che si condivide. I contenuti pubblicati possono essere permanenti anche se cancellati, attraverso screenshot, archivi, condivisioni. Le impostazioni di privacy dovrebbero essere configurate consapevolmente: chi può vedere i post, chi può taggare, se essere ricercabili. Informazioni personali sensibili (indirizzo di casa, programmi di viaggio, informazioni finanziarie) non dovrebbero essere condivise pubblicamente per rischi di sicurezza fisica e frodi.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.8 Dispositivi Mobili

Smartphone e tablet hanno rivoluzionato il computing rendendolo ubiquo e mobile. Combinano capacità di comunicazione (voce, messaggi, video) con computing general-purpose, fotografia, navigazione GPS, sensori multipli (accelerometro, giroscopio, magnetometro, barometro), in dispositivi tascabili.

I sistemi operativi mobili dominanti sono iOS di Apple e Android di Google. iOS offre ecosistema curato con integrazione stretta tra hardware e software, enfasi su privacy e sicurezza, app store con processo di approvazione rigoroso. Android offre maggiore diversità di dispositivi a vari prezzi, maggiore customizzazione, integrazione profonda con servizi Google.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.8 Dispositivi Mobili

La gestione della batteria è cruciale per dispositivi mobili. Schermi ad alta risoluzione e luminosità, connettività cellulare, GPS, background app refresh consumano energia. Strategie per estendere la durata della batteria includono ridurre la luminosità, disabilitare servizi di localizzazione quando non necessari, limitare background app refresh, usare modalità risparmio energetico che riducono prestazioni e limita funzionalità non essenziali.

La connettività include WiFi per reti locali ad alta velocità, cellulare (4G LTE, 5G) per accesso ubiquo ma con limiti di dati e possibili costi, Bluetooth per dispositivi vicini come auricolari o wearable, NFC (Near Field Communication) per pagamenti contactless e pairing rapido di dispositivi.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

3.8 Dispositivi Mobili

La sicurezza mobile include screen lock con PIN, password, pattern, o biometria (impronta digitale, riconoscimento facciale).

Il full-disk encryption protegge dati se il dispositivo viene perso o rubato. Le funzionalità di remote wipe permettono di cancellare dati da remoto.

È cruciale mantenere sistema operativo e app aggiornati per patch di sicurezza, fare backup regolari al cloud o computer, essere cauti con app da fonti non ufficiali che potrebbero contenere malware.

PARTE 3: Funzionalità Hardware e Software del Computer, Interagire Attraverso Tecnologie Digitali

4.1 Creazione e Gestione dell'Account Google

PARTE 4: Funzioni dell'Account Google

Un account Google fornisce accesso unificato a un'ampia suite di servizi:

Gmail, Drive, Calendar, Photos, YouTube, Play Store, Maps, e molti altri.

La creazione richiede fornire informazioni base: nome, desiderato indirizzo email (username@gmail.com), password, numero di telefono e email di recupero opzionali ma fortemente consigliati per sicurezza dell'account.

La scelta dell'indirizzo email è permanente e diventa la vostra identità attraverso tutti i servizi Google.

Considerate se usarlo per scopi personali, professionali, o entrambi. Per usi diversi, potrebbe essere saggio creare account separati.

4.1 Creazione e Gestione dell'Account Google

PARTE 4: Funzioni dell'Account Google

La sicurezza dell'account dovrebbe essere una priorità immediata. Attivate la verifica in due passaggi (2FA) che richiede un secondo fattore oltre alla password: tipicamente un codice generato da un'app (Google Authenticator, Authy) o inviato via SMS.

La dashboard dell'account Google (myaccount.google.com) centralizza gestione e impostazioni.

La sezione "Informazioni personali" permette di aggiornare nome, foto profilo, data di nascita, genere, altre informazioni demografiche.

"Dati e personalizzazione" controlla come Google usa i vostri dati per personalizzare esperienze.

"Sicurezza" mostra attività recente dell'account, dispositivi connessi, app di terze parti con accesso, impostazioni di sicurezza.

4.2 Gmail: Posta Elettronica

PARTE 4: Funzioni dell'Account Google

Gmail è uno dei servizi email web-based più popolari, con oltre 1.5 miliardi di utenti. L'interfaccia è organizzata in sezioni: la lista di conversazioni mostra thread di email raggruppate per oggetto, la barra laterale sinistra mostra label e categorie, la barra superiore contiene ricerca e impostazioni.

Le label sono l'equivalente Gmail delle cartelle ma più flessibili: una email può avere multiple label simultaneamente.

Le label annidate creano gerarchie. Le azioni rapide permettono di assegnare label, archiviare (rimuovere da Inbox mantenendo nell'account), cancellare, marcare come spam o non letta con pochi click.

4.2 Gmail: Posta Elettronica

PARTE 4: Funzioni dell'Account Google

Le categorie automatiche dividono l'inbox:

- Primary per email personali importanti,

- Social per notifiche da social network,

- Promotions per email marketing,

- Updates per conferme e ricevute,

- Forums per mailing list e discussion board.

Gli utenti possono spostare email tra categorie per addestrare il sistema. Alcune persone trovano questo sistema utile per focus, altri preferiscono una inbox unificata.

4.2 Gmail: Posta Elettronica

PARTE 4: Funzioni dell'Account Google

I filtri automatizzano la gestione email. Possono basarsi su mittente, destinatario, oggetto, corpo, dimensione, presenza di allegati. Le azioni includono applicare label, archiviare, cancellare, marcare come letta, inoltrare a altro indirizzo, classificare come importante. Un filtro potrebbe automaticamente etichettare e archiviare tutte le newsletter da un servizio specifico, o inoltrare email da un dominio aziendale a un altro account.

Le impostazioni di invio posticipato permettono di scrivere un'email ora ma programmarla per invio futuro. Utile per lavorare fuori orario ma inviare durante orari lavorativi normali, o per promemoria temporizzati. La modalità riservata permette di inviare email che i destinatari non possono inoltrare, copiare, stampare, e che si autodistruggono dopo un periodo specificato. Può anche richiedere un codice SMS per aprire l'email, aggiungendo sicurezza.

4.3 Google Drive: Storage Cloud e CondivisionE

PARTE 4: Funzioni dell'Account Google

Google Drive fornisce 15 GB di storage gratuito condiviso tra Gmail, Drive e Google Photos. Piani a pagamento offrono 100 GB, 200 GB, 2 TB o più. Drive sincronizza file tra cloud e dispositivi multipli: modifiche fatte su un dispositivo si riflettono ovunque.

La condivisione è centrale alla filosofia Drive. Ogni file o cartella ha permessi configurabili. Potete condividere con persone specifiche inserendo il loro indirizzo email, o generare link condivisibili. I livelli di accesso includono:

- Visualizzatore (può solo vedere e scaricare),

- Commentatore (può aggiungere commenti ma non modificare),

- Editor (può modificare il contenuto).

La condivisione di una cartella concede gli stessi permessi a tutto il suo contenuto.

4.3 Google Drive: Storage Cloud e CondivisionE

PARTE 4: Funzioni dell'Account Google

Le versioni dei file sono conservate automaticamente. Drive mantiene storico completo delle modifiche per file Google nativi (Docs, Sheets, Slides), permettendo di vedere chi ha modificato cosa e quando, e di ripristinare versioni precedenti.

Google Drive Offline permette accesso a file selezionati senza connessione internet. Le modifiche fatte offline si sincronizzano automaticamente quando la connessione viene ripristinata. Questo richiede configurazione anticipata e Chrome browser o applicazioni mobile Drive.

Drive for desktop è un'applicazione che sincronizza cartelle del computer con Drive. Potete selezionare quali cartelle del computer backuppare a Drive, e quali cartelle Drive rendere disponibili localmente. La sincronizzazione bidirezionale mantiene entrambe le posizioni aggiornate.

4.4 Google Docs, Sheets, Slides: Suite Produttività

PARTE 4: Funzioni dell'Account Google

Conclusione

Le competenze digitali non sono un insieme statico di conoscenze da apprendere una volta per tutte, ma un campo in continua evoluzione che richiede apprendimento continuo e adattabilità.

Tuttavia, i principi fondamentali rimangono relativamente stabili: comprendere come organizzare e proteggere informazioni, come i computer elaborano dati, come comunicare efficacemente attraverso canali digitali.

L'approccio dovrebbe essere pragmatico: iniziare con necessità concrete, sperimentare con strumenti e servizi, non temere di esplorare e fare errori in ambienti sicuri. Le risorse per apprendimento continuo sono abbondanti: documentazione ufficiale, tutorial video, community online, corsi strutturati.

La curiosità e la volontà di provare sono gli ingredienti più importanti per sviluppare competenza e confidenza nel navigare il panorama digitale in continua evoluzione.

Comunicazione e Collaborazione nel Mondo Digitale

Nel contesto contemporaneo, la capacità di condividere informazioni attraverso le tecnologie digitali rappresenta una competenza fondamentale tanto in ambito professionale quanto in quello personale. La rivoluzione digitale ha trasformato radicalmente i modi in cui comunichiamo, collaboriamo e scambiamo dati. Ciò che una volta richiedeva giorni attraverso la posta cartacea, oggi avviene in pochi secondi. Questa trasformazione ha portato con sé sia opportunità straordinarie che responsabilità significative.

La condivisione di informazioni digitali non è semplicemente una questione tecnica, ma rappresenta una competenza trasversale che interseca aspetti comunicativi, organizzativi, etici e di sicurezza. Per utilizzare efficacemente le tecnologie digitali, è necessario comprendere non solo come funzionano gli strumenti, ma anche quali sono le migliori pratiche per garantire che le informazioni raggiunghino i destinatari corretti nel formato appropriato e nel momento opportuno.

Fondamenti della Comunicazione Digitale

PARTE 1: CONDIVIDERE INFORMAZIONI ATTRAVERSO LE TECNOLOGIE DIGITALI