DISTILLER

WP5 : Recommending sustainable software artifacts

Tristan Coignion, Romain Rouvoy, Clément Quinton

Studies on Large Language Models' energy consumption and code efficiency

IA et Large Language Models

Large Language Model (LLM) :

Technologie d'intelligence artificielle qui génère du texte.

Large Language Models pour le code : LLMs spécialisés dans la génération du code.

Assistant de code : LLM pour le code qui s'intègre dans les outils du développeur

Aide les développeurs à créer des logiciels

IA et Large Language Models

Avancement

2 expériences :

- Étude des performances du code généré par des LLMs

- Soumis à ASE, rejetée, mais en train de resoumettre

- Étude de la consommation énergétique d'un assistant de code

- En préparation

Étude des performances du code généré par LLM

Étude de la performance du code généré par des LLMs via de la génération de solutions à des problèmes de programmation de Leetcode

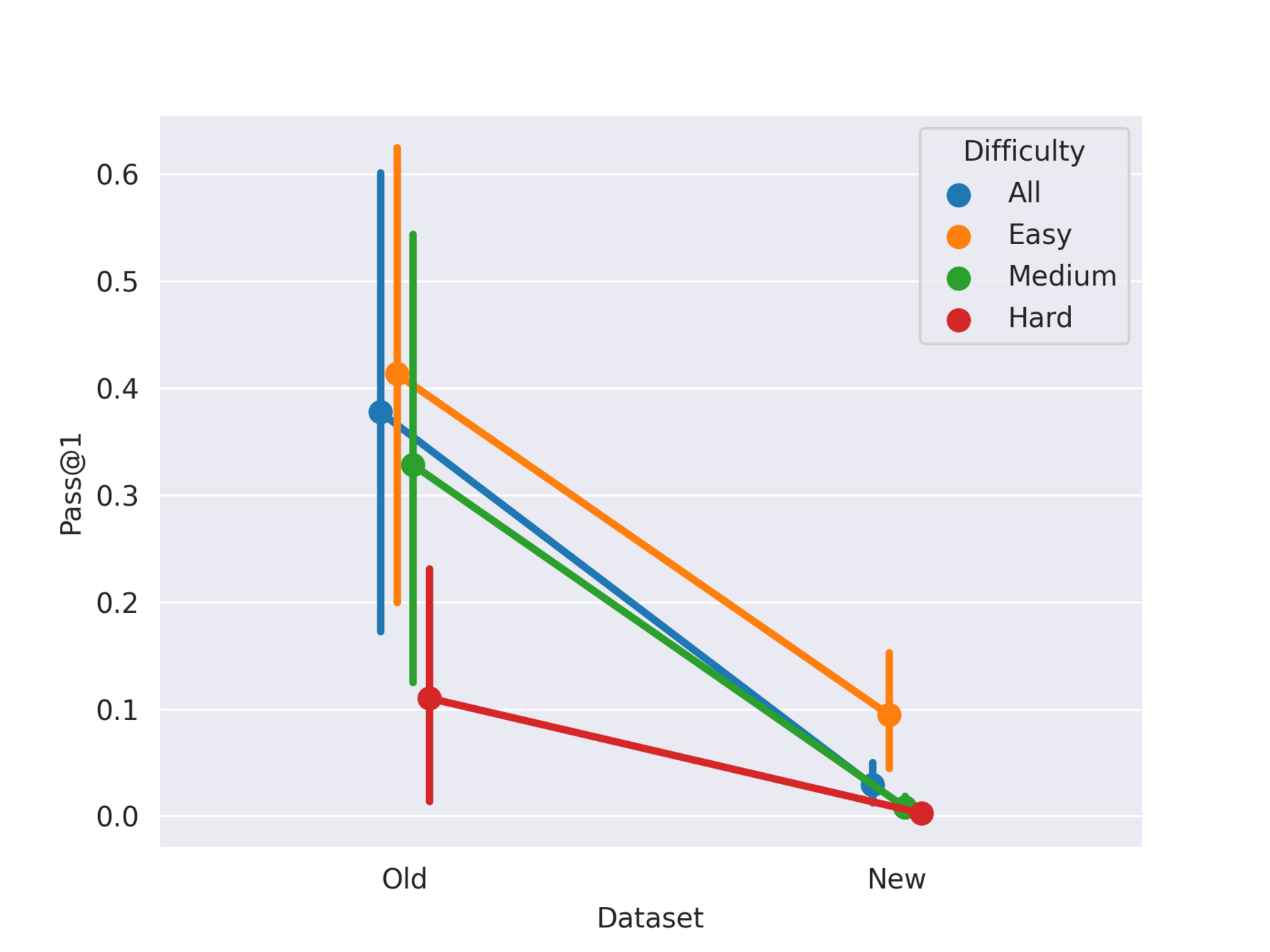

Récitation - Pass@1 of the models for every difficulty and dataset with 95% confidence interval

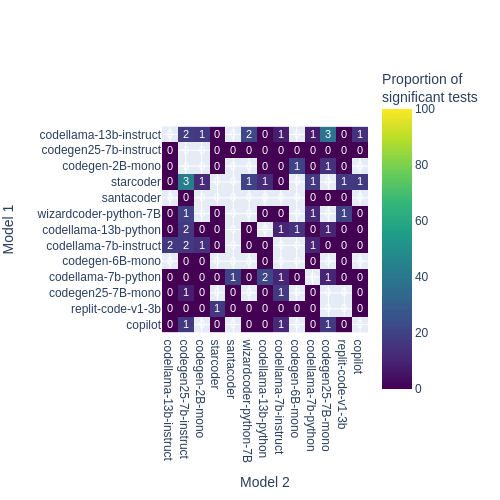

Number of problems where a model (row) is better than another (column)

Effets de la température ou du taux de succès d'un modèle sur un problème

- Seule corrélation trouvée: Entre la température et la variation des performances

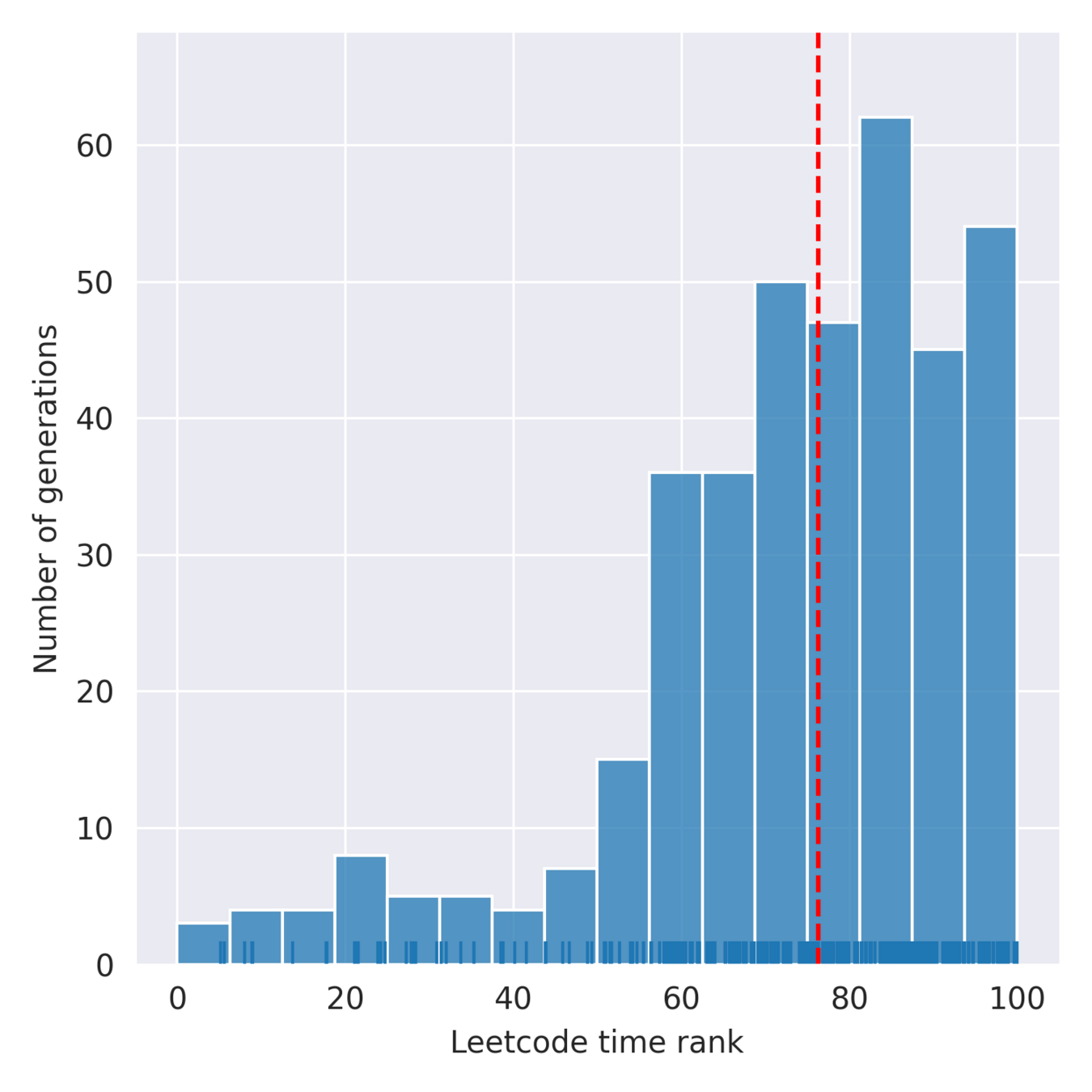

Distribution of the ranking for one model (higher is better)

En bref

- Forte récitation en fonction des questions

- Pose des problèmes pour les évaluations futures

- Leetcode difficilement utilisable pour évaluer les LLMs

- Besoin d'un vrai dataset

- Pas (ou très peu) de différences entre les LLMs au niveau de la vitesse du code

- Effet de la température sur la variation de la performance --> Utile pour éventuellement trouver une solution plus optimale

- LLM a priori meilleurs que les humains en moyenne niveau vitesse de code

Étude de l'énergie consommée par un assistant de code

Motivations

Les IA et la consommation électrique:

Assistants de code (e.g. GitHub Copilot) sont très utilisés par les développeurs

Génération de code faite dans le cloud

La consommation électrique est cachée

Étude de l'énergie consommée par un assistant de code

Motivations

Un participant humain développe sur un projet jouet avec un assistant de code.

On estime la consommation d'énergie de l'assistant à partir de notre IA

Étude de l'énergie consommée par un assistant de code

Présentation

On rejoue les demandes de génération faites par l'assistant, avec une IA qu'on exécute nous même

Expérience en cours de conception

Attente de validation par le COERLE

Étude de l'énergie consommée par un assistant de code

État actuel

Pistes pour la suite

- LLMs et performances des logiciels produits

- Impact environnemental d'un LLM de code à l'utilisation

- Rendre les assistants de code plus écologiques

Merci de m'avoir écouté !