IT-инфраструктура

вычислительные ресурсы Щукинской 5с6

- Данная презентация выполнена на HTML5.

- Если хотите увидеть план рассказа и вернуться обратно - дважды нажмите <Esc>.

- Презентация состоит из блоков.

- Чтобы перейти к следующему блоку вращайте презентацию вправо.

- Чтобы получить более детальную информацию по данному блоку вращайте презентацию вниз.

Как пользоваться этой презентацией

Типы данных

- BCL - сырой итог секвенирования, светимость. Одна для 24 человек, весит ~1.2ТБ

- FASTQ - сырые риды одного человека (фрагменты генома по 150 букв), для 24 человек весят ~1.8ТБ

- BAM - риды одного человека, выровненные на референсный геном, для 24 человек весят ~1.4ТБ

- gVCF/VCF - генетические варианты одного человека, весят несколько ГБ (на 3 порядка меньше BCL, FASTQ и BAM)

- combined VCF - генетические варианты нескольких человек вместе

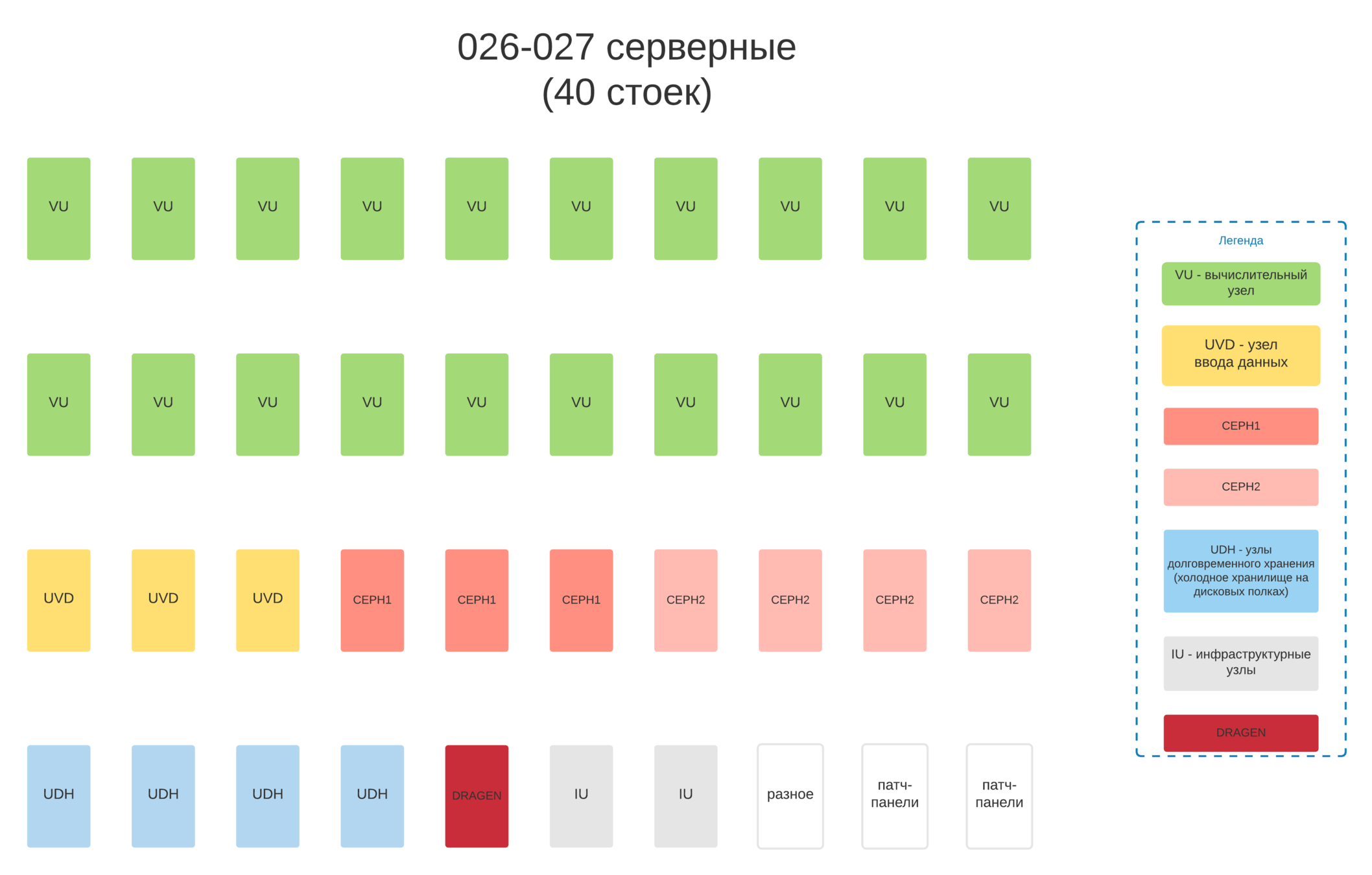

Типы серверов

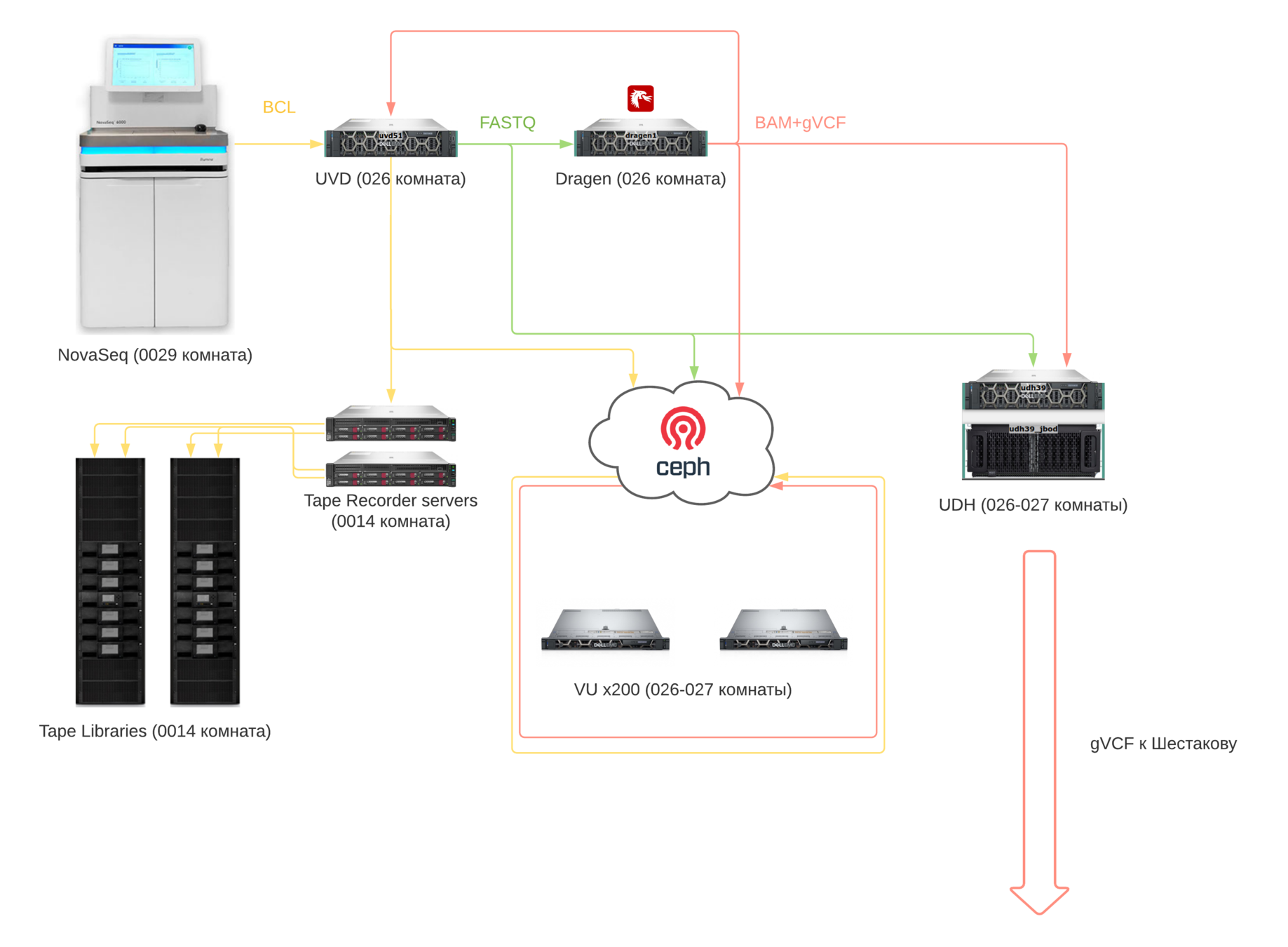

- UVD (узел ввода данных) - принимают данные с секвенаторов, осуществляют стадию демультипликации BCL -> FASTQ

- Dragen - принмают FASTQ, осуществляют FASTQ->BAM+gVCF

- UDH - хранят данные, на части из них развернут CephFS, другая часть используется как холодное хранилище (дисковые полки)

- VU (вычислительный узел) - 200 штук, исопльзуются для расчетов

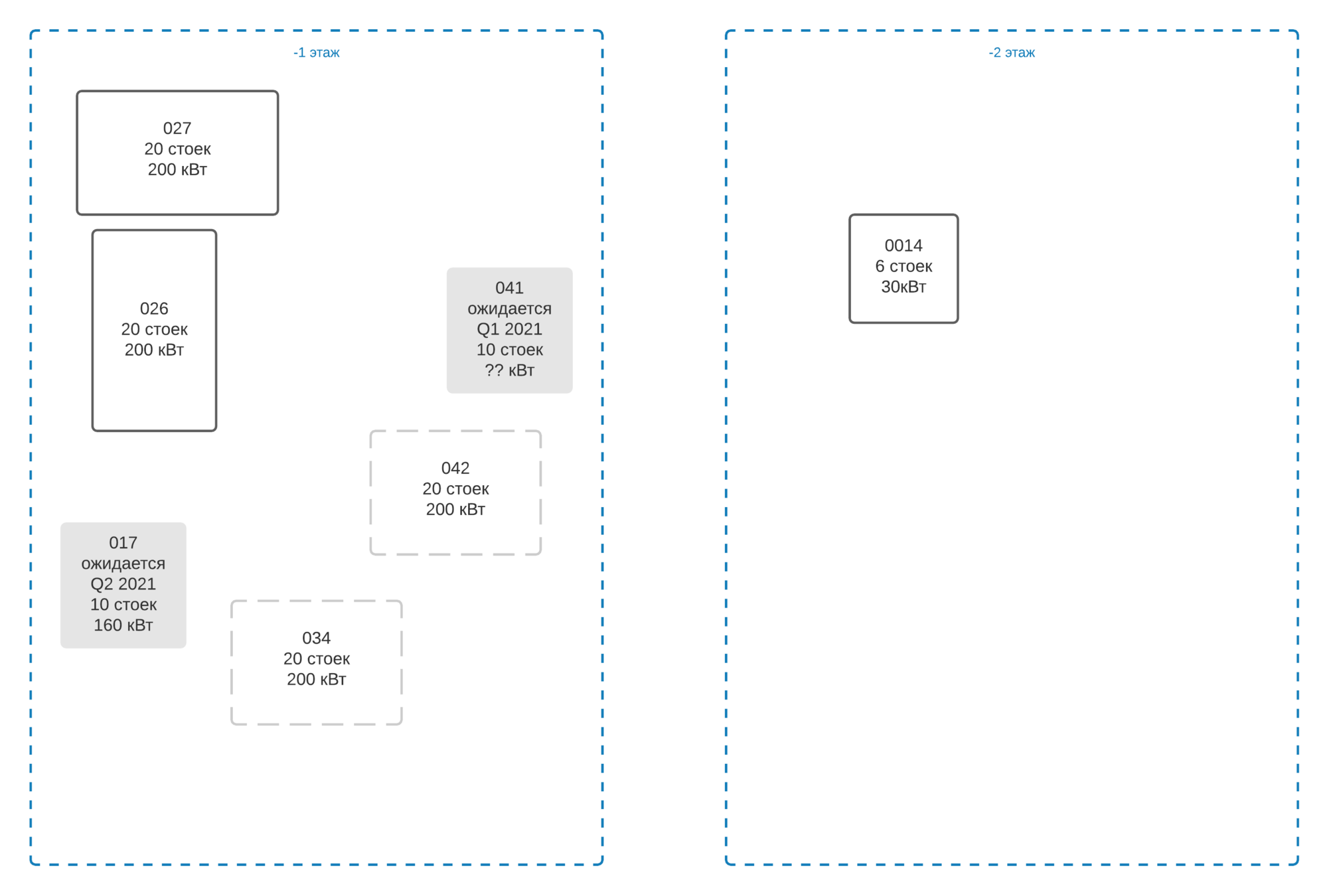

Серверные в Щукинская 5с6

Состав оборудования серверных 026-027 (-1 этаж):

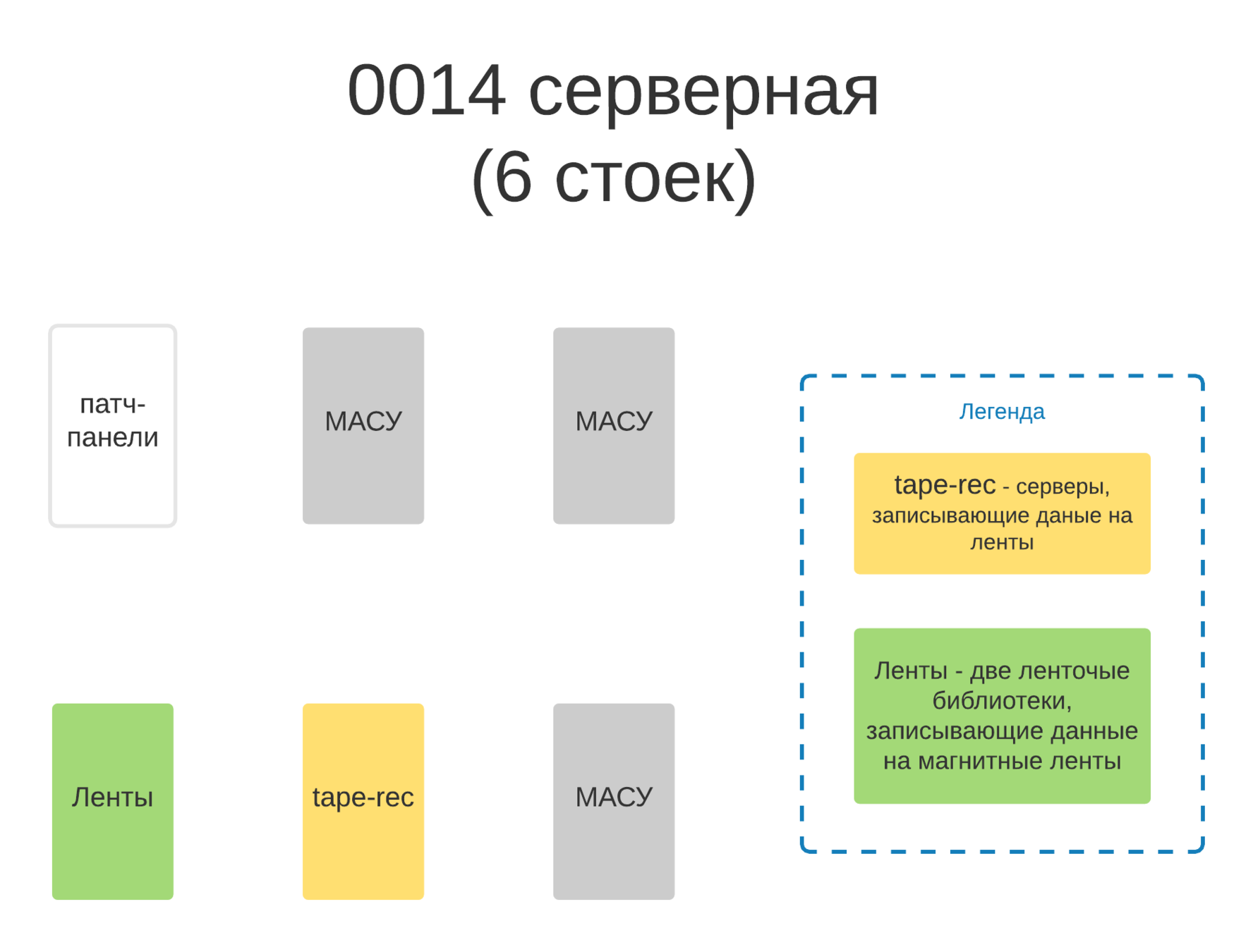

Состав оборудования комнаты 0014 (-2 этаж):

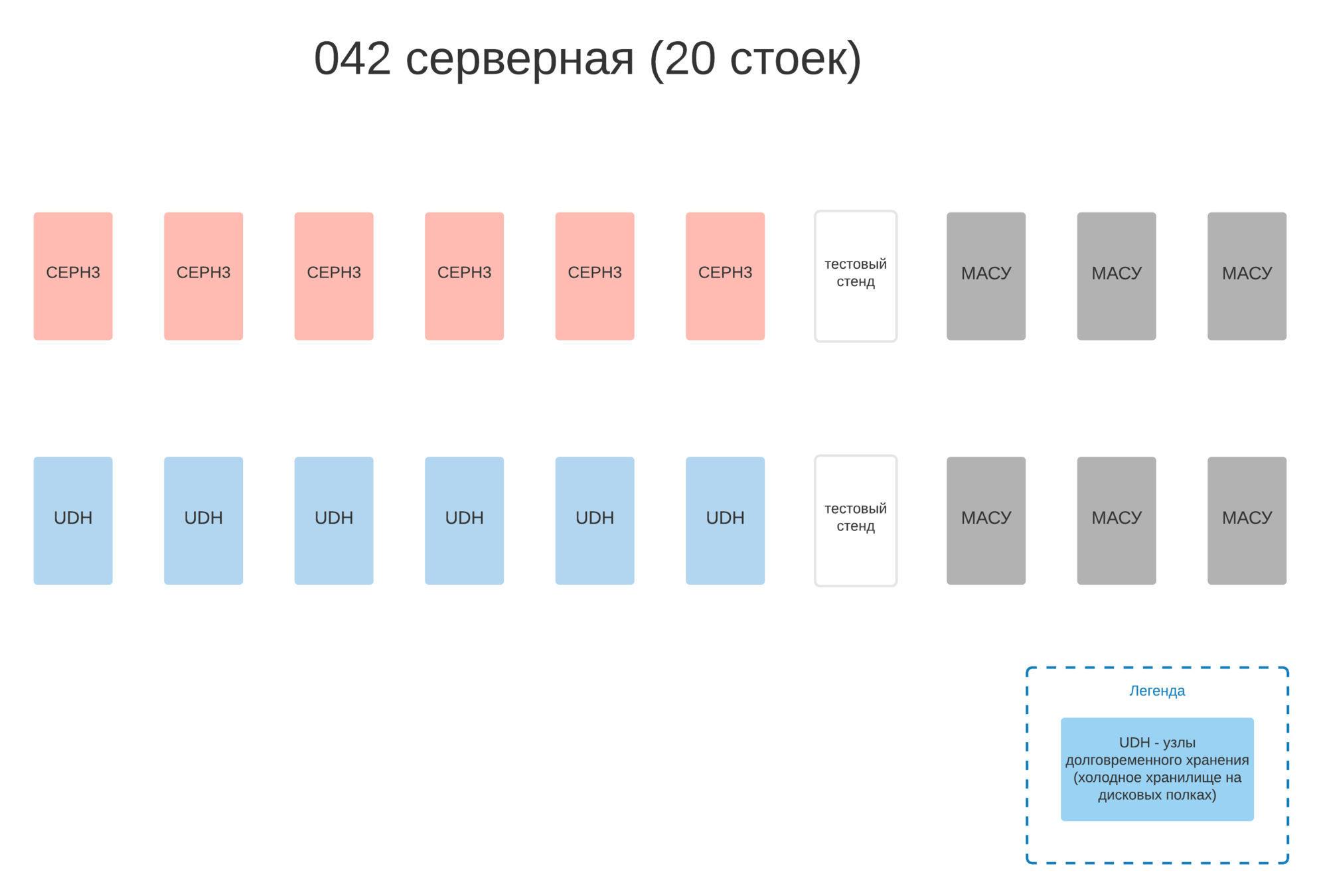

Состав оборудования комнаты 042 (-1 этаж):

Мы планируем использовать под дисковое пространство (50/50 Ceph и полки) освобождающиеся 8 стоек (ПАК МАСУ + пустые стойки).

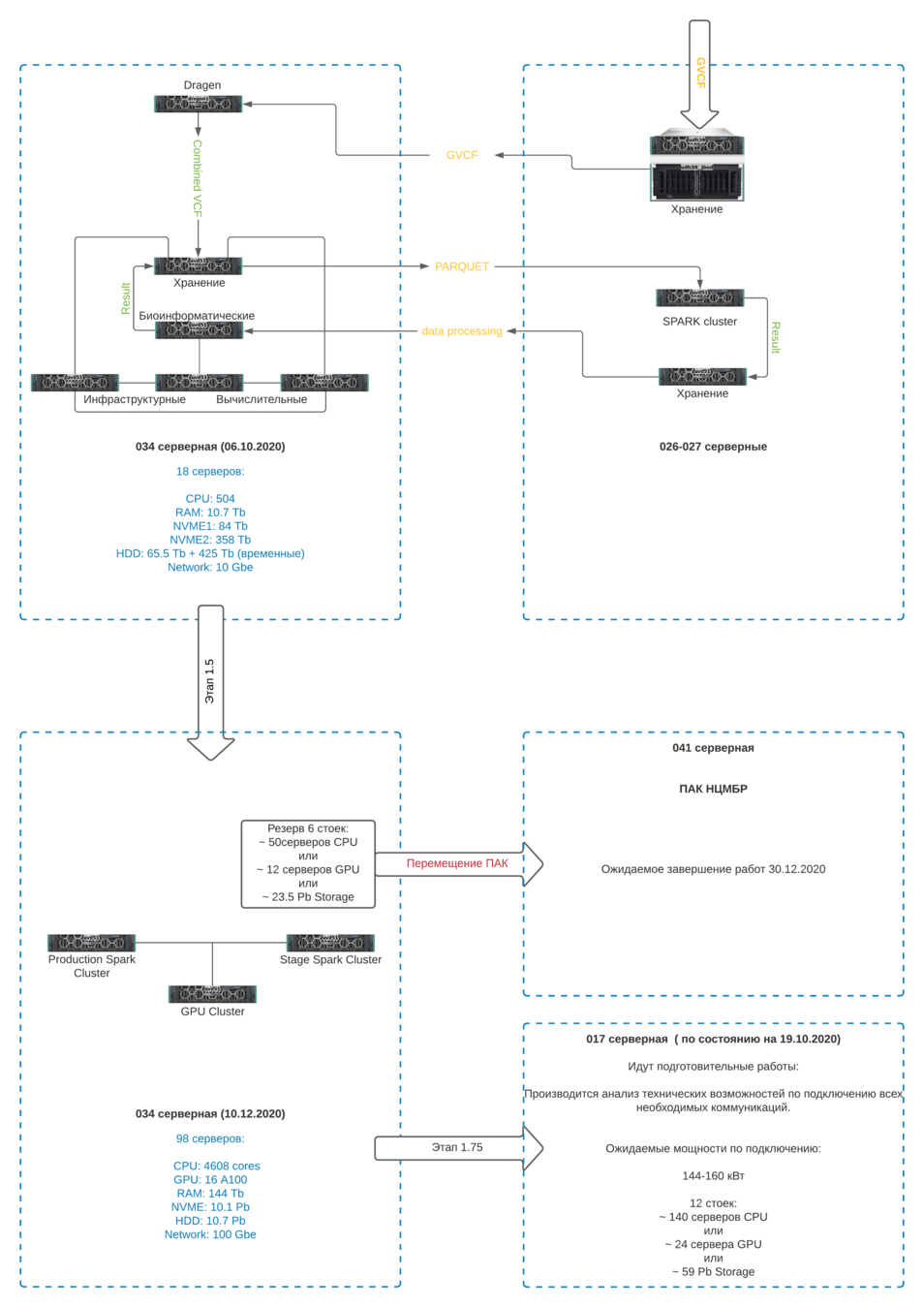

Состав оборудования комнаты 034 (-1 этаж):

Конвейер данных (Бурков)

Конвейер данных (Шестаков)

Хранилища данных

Мы храним не менее 2 копий данных в 3 хранилищах: горячем (Ceph), холодном (дисковые полки UDH) и архивном (магнитные ленты).

С горячего хранилища ведем расчеты, в холодном – храним копию в оперативном доступе на случай неполадок горячего, архивным подстраховываемся от потери части данных в холодном.

Чтобы хранить 100 тысяч геномов, нужно иметь пространство для 200 тысяч полезного хранения .

Хранилища данных

| формат | горячее | холодное | архивное |

|---|---|---|---|

| BCL | + | - | + |

| FASTQ | + | + | - |

| BAM+gVCF | + | + | - |

В ближайшие 3 месяца мы надеемся добавить в архивное хранилище также форматы BAM+gVCF и FASTQ.

Горячее: CephFS

Достоинства:

- высочайшая скорость обмена данными (20-100+ Гбайт/с), 20 тысяч геномов загружаются на расчет за 10-30 минут

- эффективное расходование дискового пространства (отношение полезного пространства к сырому – до 75%)

- данные, разбросанные по десяткам серверов, представляются пользователю как единый диск

- можно разграничить доступы пользователей к каждой подпапке этого диска

- интеграция с популярнейшими системами контейнеризации, виртуализации и обработки больших данных Kubernetes, OpenShift, OpenStack, Spark

Горячее: CephFS

Недостатки:

- высокая сложность системы, требуются компетентные сотрудники для обслуживания

- требовательность к вычислительным ресурсам серверов и сети (нужны мощные процессоры на серверах и быстрая сеть)

- нетривиально организовать доступ к данным с ОС Windows

- ненулевой риск потери всех данных разом, чувствительность к бесперебойному электропитанию и работе сети

Холодное: дисковые полки

Достоинства:

- простота

- относительная толерантность к потере электропитания и сети

- возможность за ~2 недели забрать все данные с полки и переложить в CephFS

- неплохая эффективность расходования дискового пространства (отношение полезного пространства к сырому - порядка 50-66%)

- существует ненулевой шанс потерять одновременно только 1 полку – в таком случае ее данные можно восстановить из архивного хранилища (с лент)

Холодное: дисковые полки

Недостатки:

- неудобный интерфейс, данные разбросаны по разным машинам

- одна полка не может одновременно обслуживать несколько клиентов, проводить на них серьезные высокопроизводительные биоинформатические расчеты фактические невозможно

Архивное: магнитные ленты

Достоинства:

- низкая стоимость хранения, большой объем

- независимость хранящейся кассеты на магнитной ленте от питания - записал и отнес в другое здание

Недостатки:

- невозможно быстро поднять данные с лент – в лучшем случае, одну полку за месяц

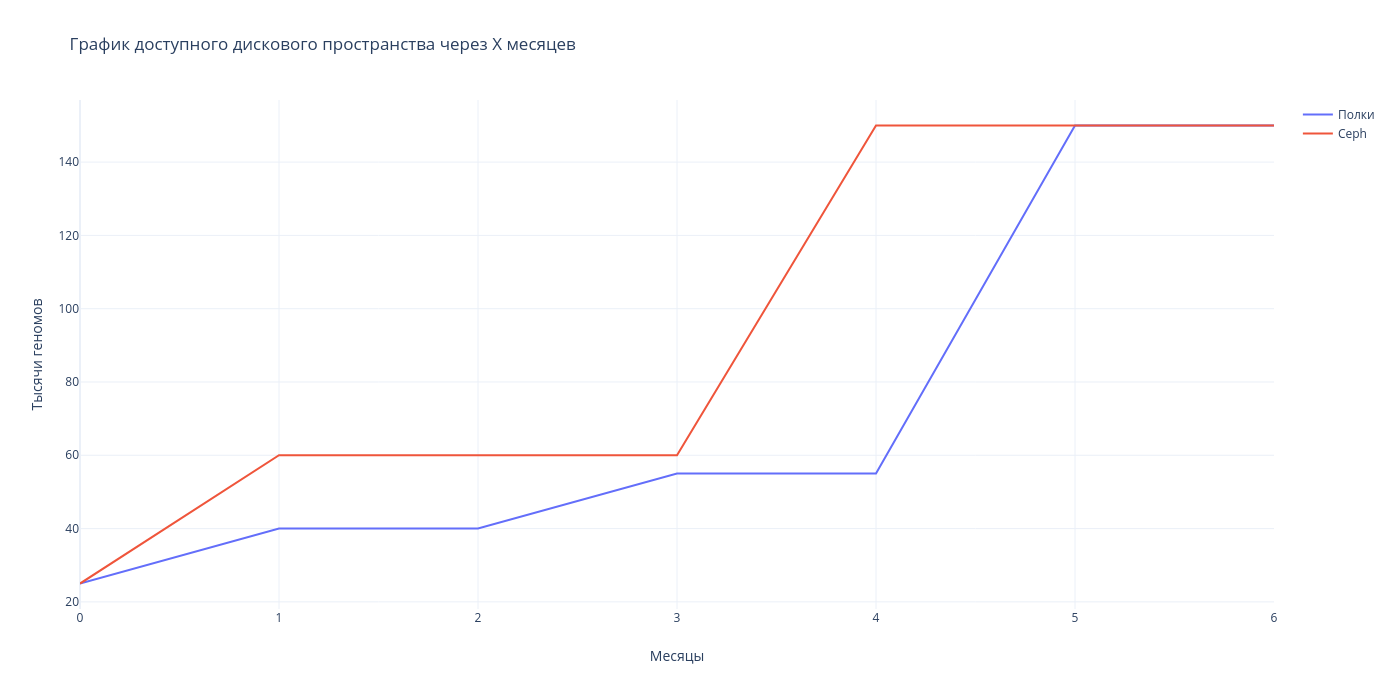

График доступного дискового пространства по времени

Что лимитрует рост?

- 4 серверных помещения в 6 корпусе, по 20 стоек каждое (каждая стойка – около 10 вычислительных серверов или около 2ПБ хранения данных в одной копии)

- 800 киловатт питания на все серверные всего 6 корпуса; каждая стойка – 10 киловатт

- ожидаемый реалистический срок сдачи нового корпуса – Q1 2022 (есть последовательные стадии в техпроцессе – “нельзя надеть пиджак, пока не надел рубашку”)

- некуда сажать дополнительных сисадминов в 6 корпусе

- непросто нанимать высококлассных сотрудников уровня тимлида (во-первых, не идут, во-вторых, уходят, в-третьих – процесс наема растягивается более чем на месяц из-за неэффективного, неавтоматизированного документооборота и делопроизводства)

Доступ к данным

CephFS представляет единую распределенную файловую систему гигантского размера.

Она позволяет гибко разграничивать доступы пользователей к различным поддиректориям. В частности, можно выдать права конкретному пользователю на доступ только к конкретной поддиректории только на чтение.

Доступ к данным

В данный момент доступы к данным в CephFS имеют группы Митрофанова, Зотовой, Траспова и дата-инженеры нашей команды.

Проекты решений для внешних коллабораторов

- Доступ через контейнеры (Kubernetes/OpenShift), основное решение на данный момент

- Доступ через виртуальные машины OpenStack

- ВАРМы (виртуальные рабочие места, эфемерные – то есть уничтожаемые каждые сутки) на базе vmWare VDI

График предстоящих закупок

- "Очередь 1.5": 15 декабря 2020: 2/3 034 серверной, 2/3 042 серверной

- Микрозакупка пользовательского софта и оборудования: 4 квартал 2020 - пользовательское оборудование

- "Очередь 1.75": 4 квартал 2020 1/3 034 серверной, 1/3 042 серверной

- Очередь 2: сдача в 4 квартале 2021 - новый ЦОД

Зоны ответственности ОМГ и МАСУ

Зоны ответственности отдела МАСУ

- интернет в здании (ведется через Погодинскую), VPN-шлюз (удаленный доступ)

- электронная почта и exch01.cspmz.ru

- телефония (на данный момент мы подняли свою АТС на Щукинской, но она соединена с АТС на Погодинской, чтобы сеть телефонов была единой)

- домен cspmz.ru и пользовательские компьютеры в этом домене (в т.ч. отдела АиПМБРЗ и НЦ МБР)

- видеонаблюдение, СКУД

- электронный документооборот

Зоны ответственности ОМГ

-

локальная сеть, будущий выход в интернет

-

вычислительный комплекс и хранение данных в серверных 026, 027, 034, 042, 0014 и кроссовые помещения

-

конвейеры обработки данных NGS

-

ЛИС

-

техподдержка пользователей в домене pak-cspmz.ru на -2, 1, 2, 3 и 4 этажах, диск О и другие общие диски

-

телефонные номера на Щукинской