Warum

KI nicht ohne

Data geht

Warum machen wir

KI und Data?

Und nicht Dev im Schwerpunkt, wie bisher?

-

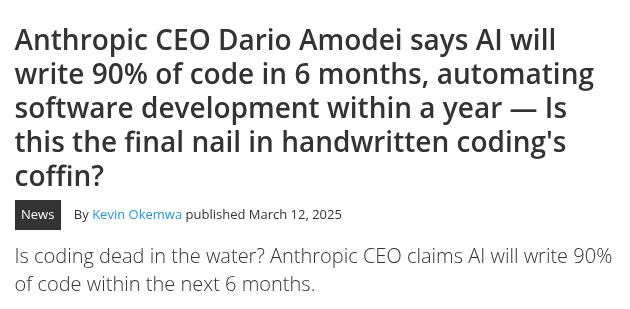

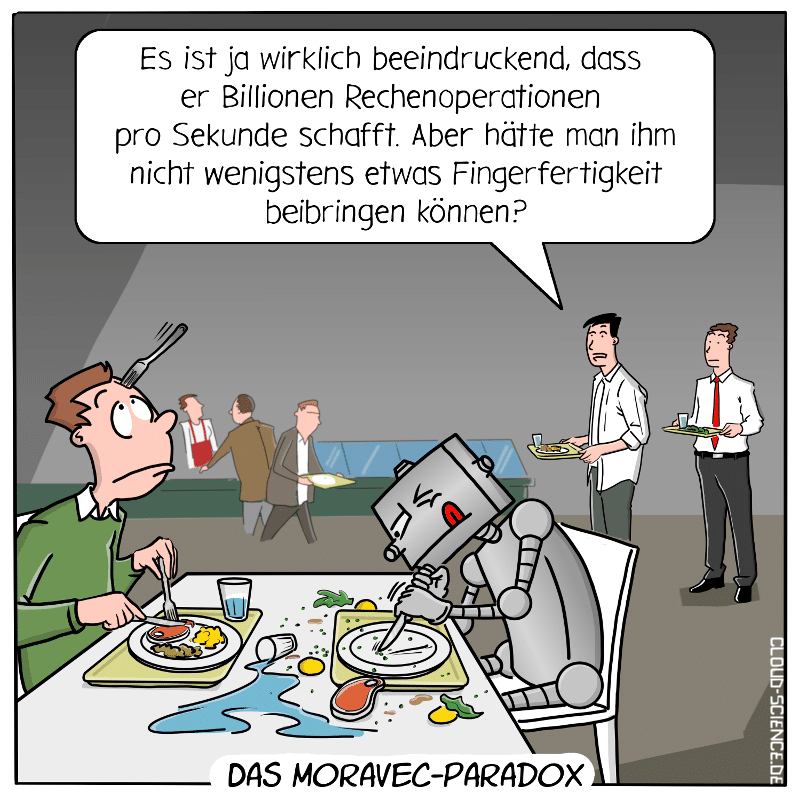

KI kann viele Dinge sehr gut

-

Aber KI kann nicht alle Dinge

-

Aber es bewegt sich

-

Mein KI-Hebel wird kontinuierlich größer.

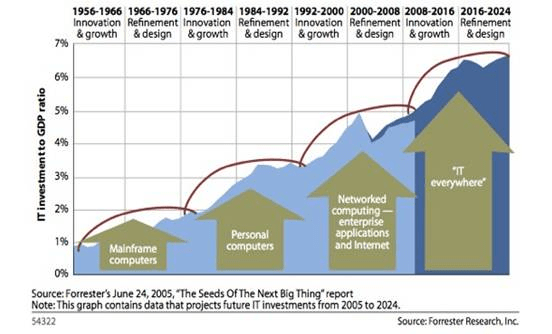

"You can see the computer age everywhere but in the productivity statistics."

Es ist nicht selbstverständlich, dass

man die Produktivätssteigerungen anwenden kann.

-

Jensen Huang, 2017:

"a Cambrian explosion of autonomous machines"

-

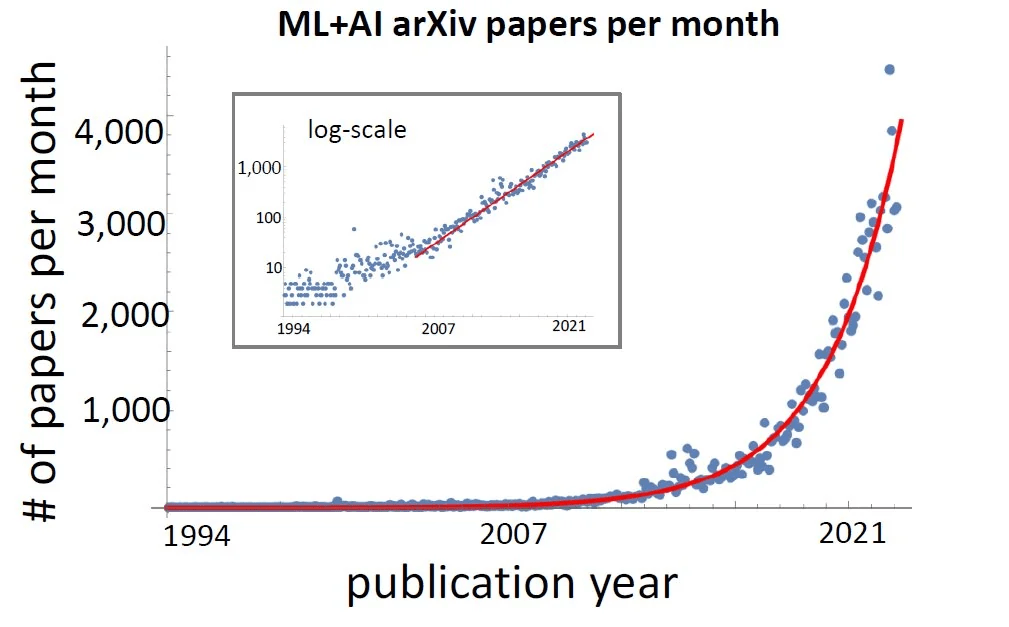

Mehr AI -> Mehr AI

-

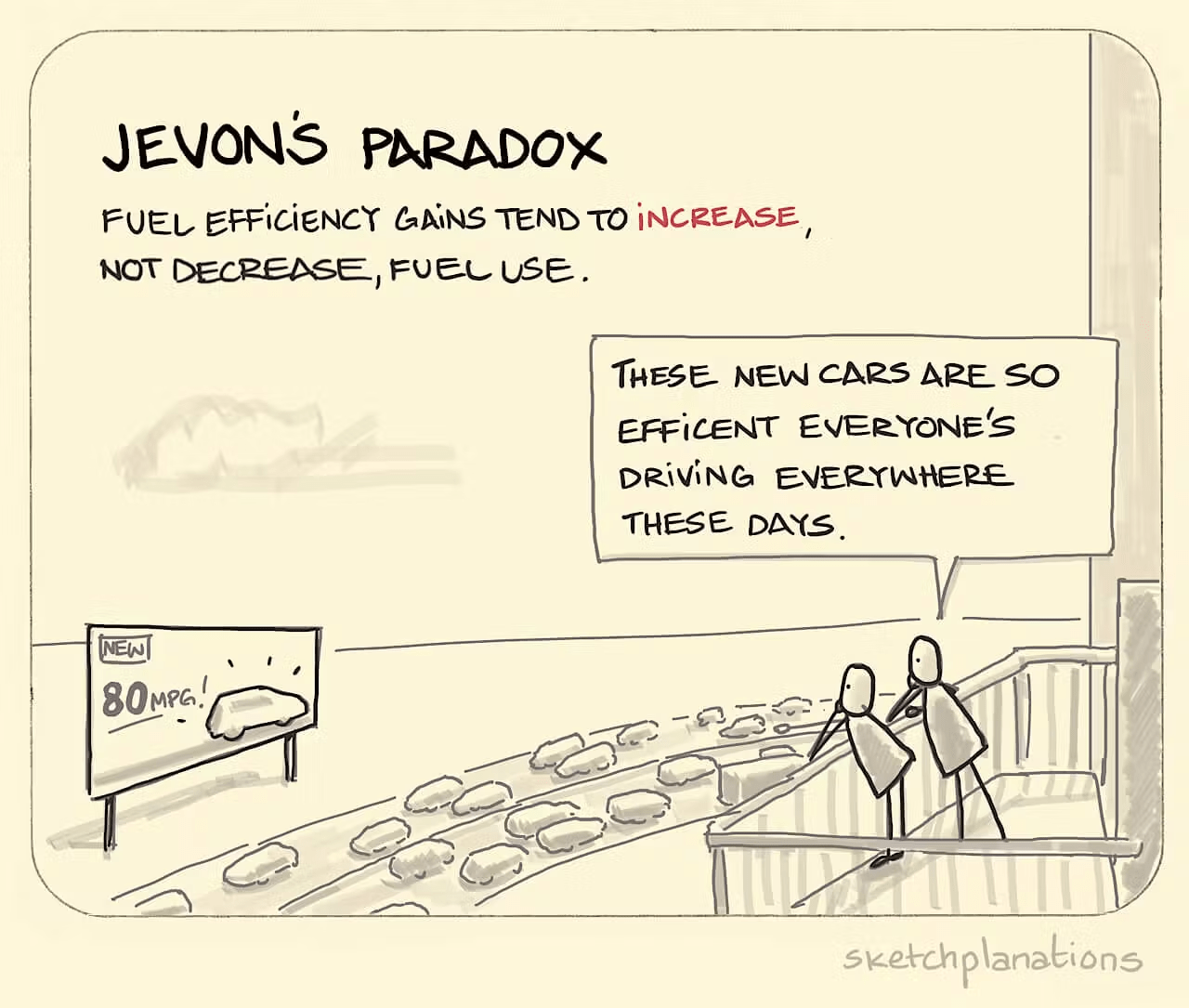

Wenn etwas billiger und effizienter wird, wird mehr gebraucht

-

Weil Software mit KI so viel schneller und billiger wird, entsteht viel mehr Software

Softwareentwicklung

und Kompetenz wird weiter gebraucht.

Aber anders.

Dafür wollen wir uns aufstellen.

Text

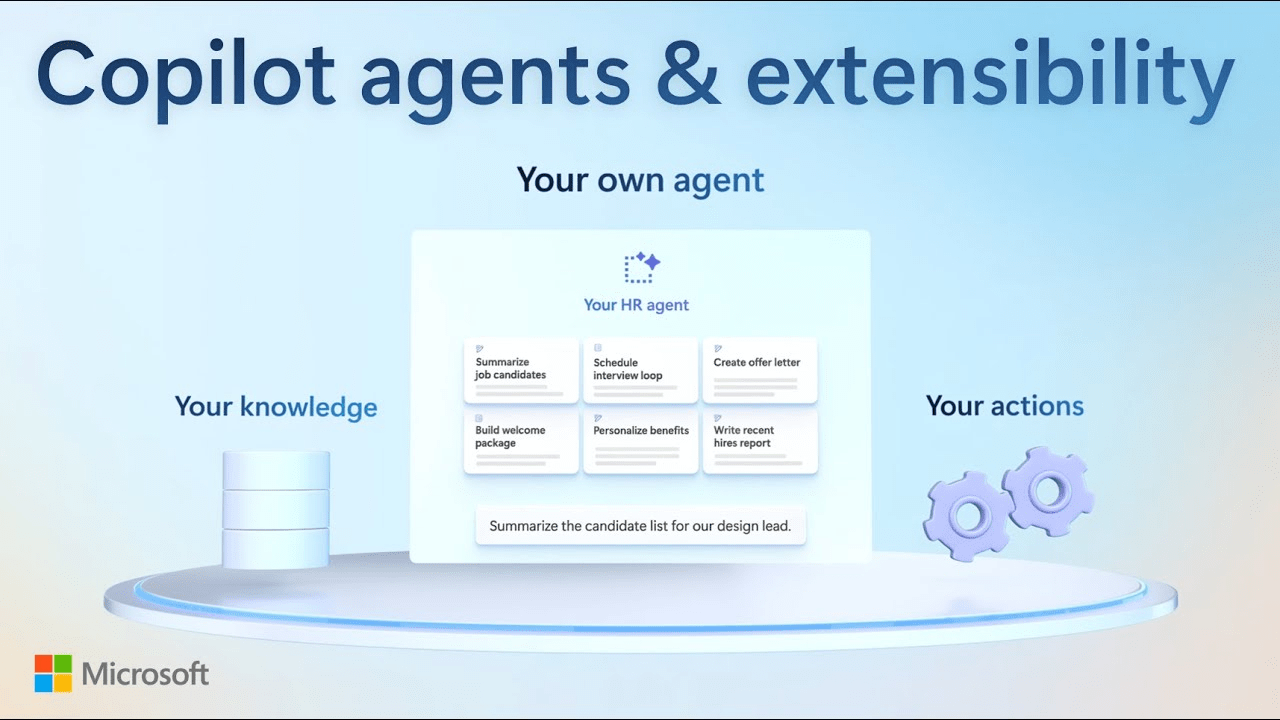

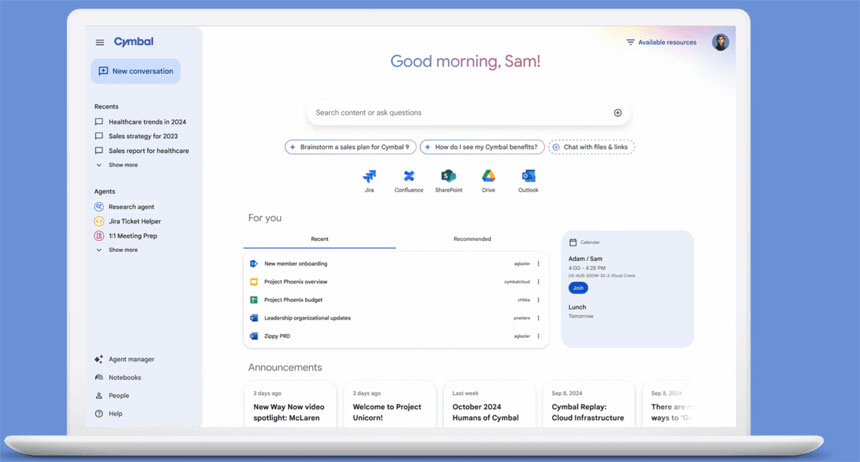

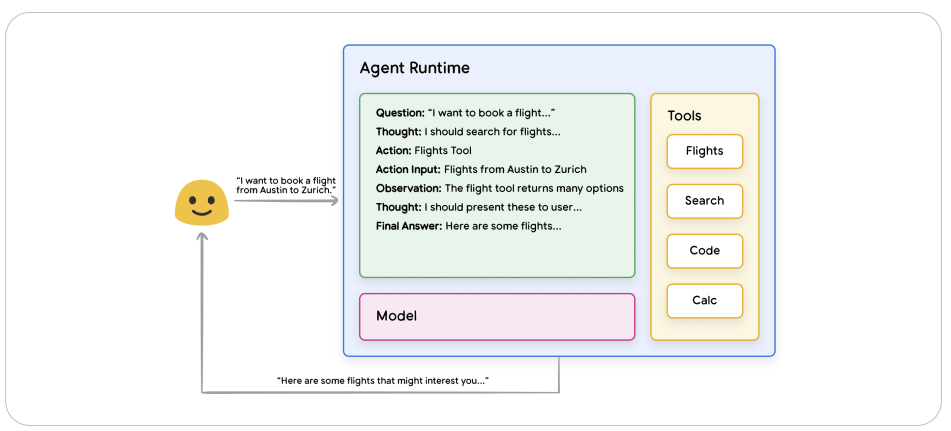

Betrieb von Agenten

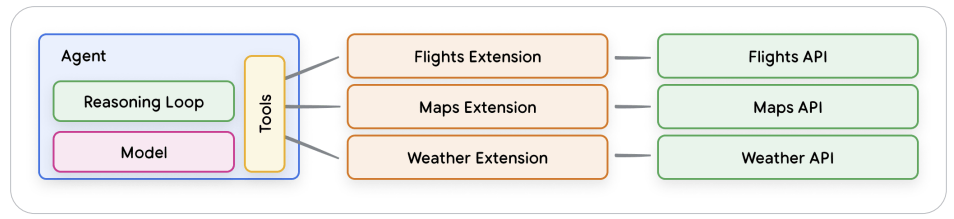

Zugriff auf APIs

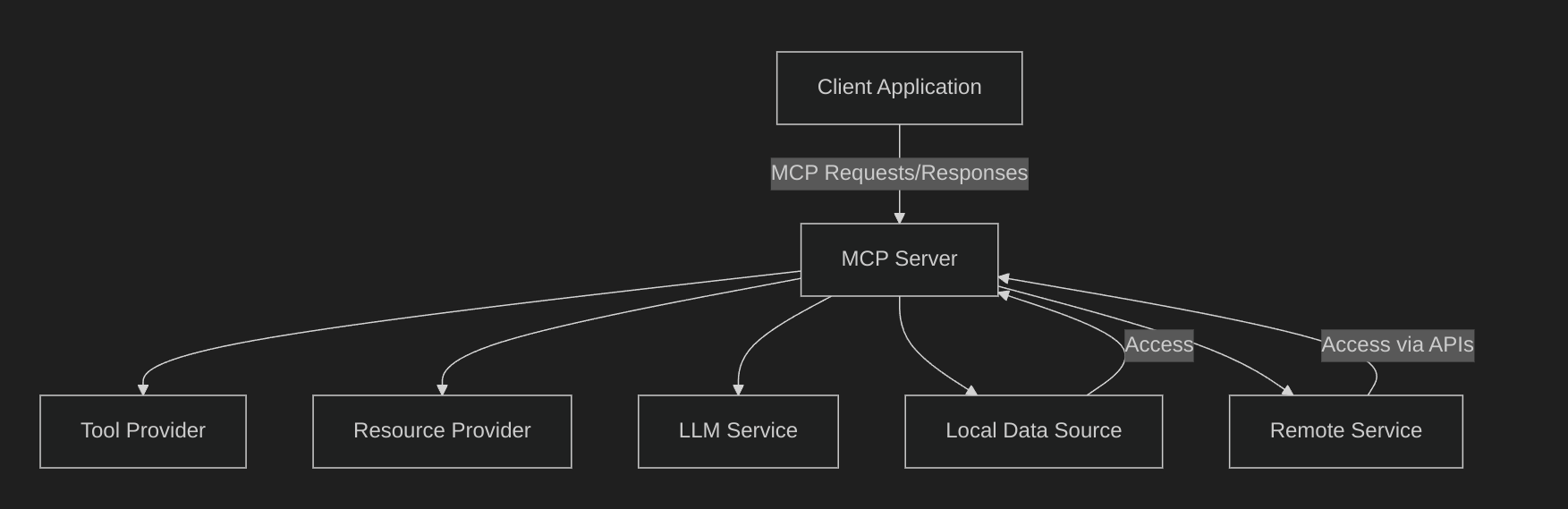

- MCP ist ein offenes Protokoll

- Standardisiert, wie Anwendungen Kontext für LLMs bereitstellen

- Vergleichbar mit einem USB-C-Anschluss für KI-Anwendungen

- Bietet standardisierte Verbindungen für:

- KI-Modelle

- Verschiedene Datenquellen

- Tools und Systeme

Model Context Protocol

- TL;DR:

- Basierend auf JSON-RPC 2.0

- Analog zu LSP/LSIF standartisiert MCP wie zusätzliche Kontexte, Daten, und Tools in die Systemlandschaften von KI-Anwendungen integriert werden

https://spec.modelcontextprotocol.io/specification/2024-11-05/

Tools: Check.

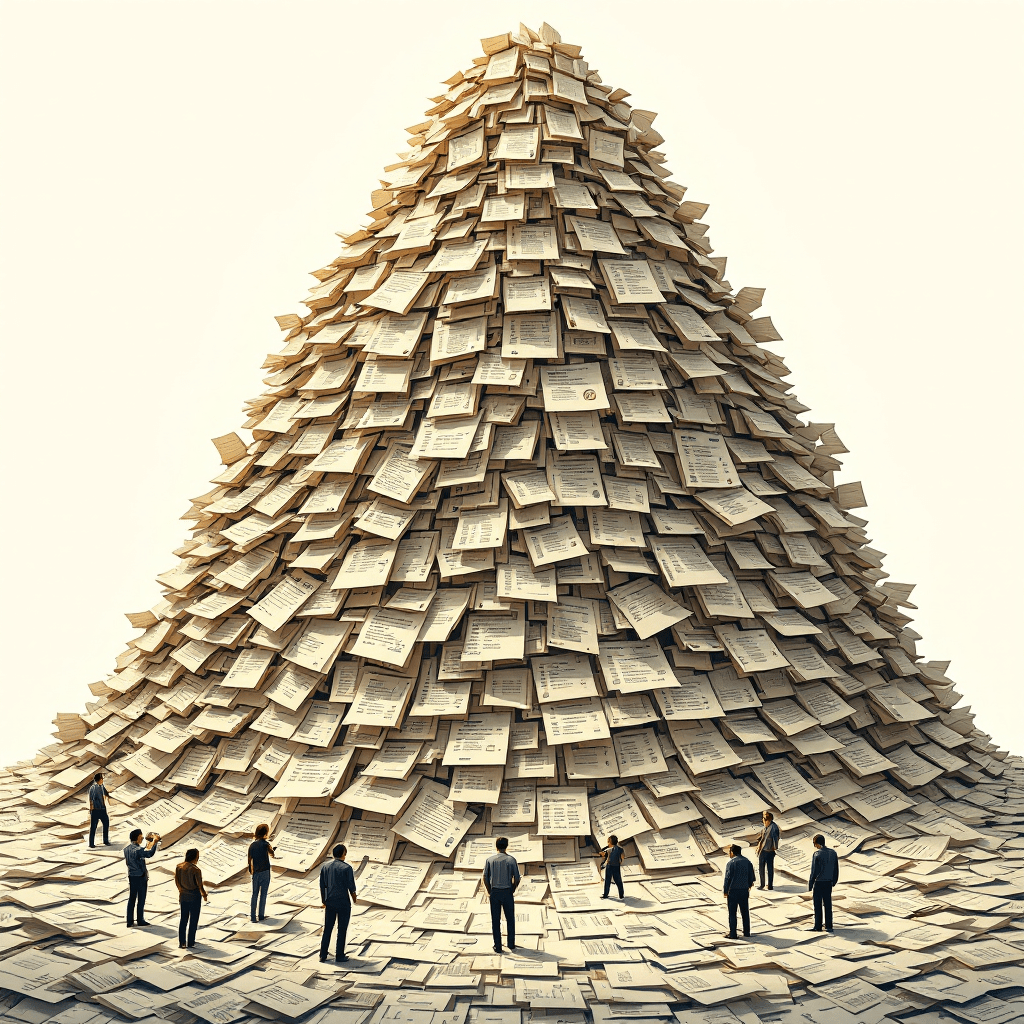

Daten

Informationen

Wissen

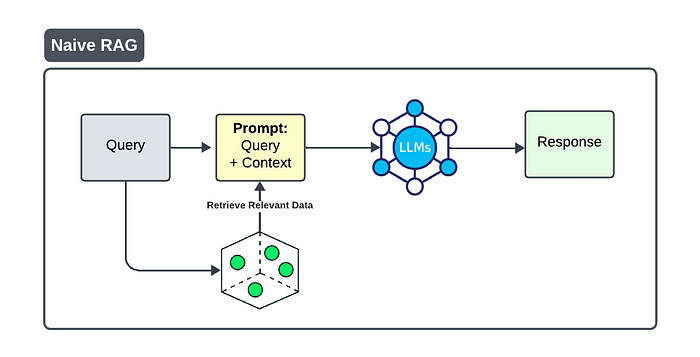

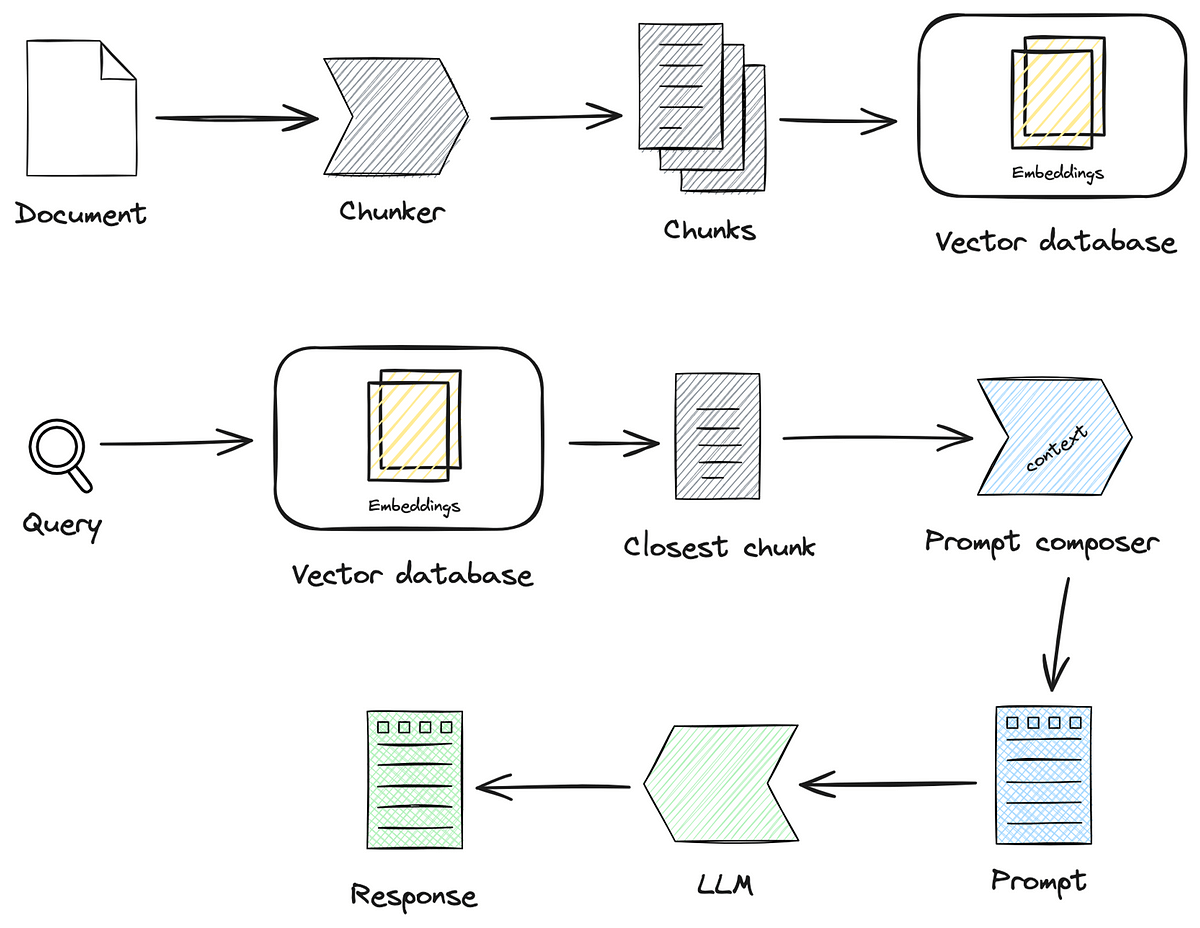

Day 1 RAG "mal gucken"

- Ingest-Job in Python oder Tool

- On Demand gestartet

- Naive Transformation, Splitting, Embedding

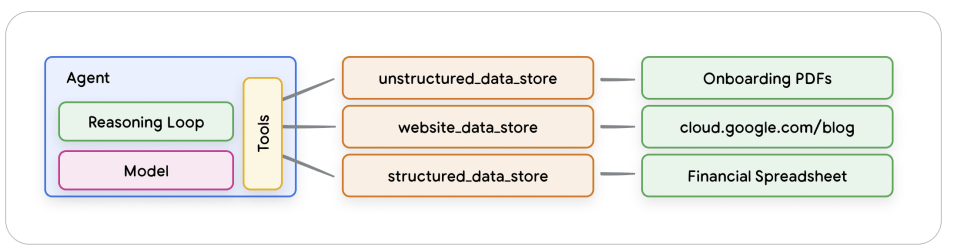

Day 2 "Geld verdienen"

Alle relevanten Daten

Unstrukturierte Daten:

- PDF / Doc / XLS / ODF / Scans / Bilder / Mails

- URLs / HTML / JSON/ Scraping / Applications

Strukturierte Daten:

- Relationale Daten, Graph-Datenbanken, ......

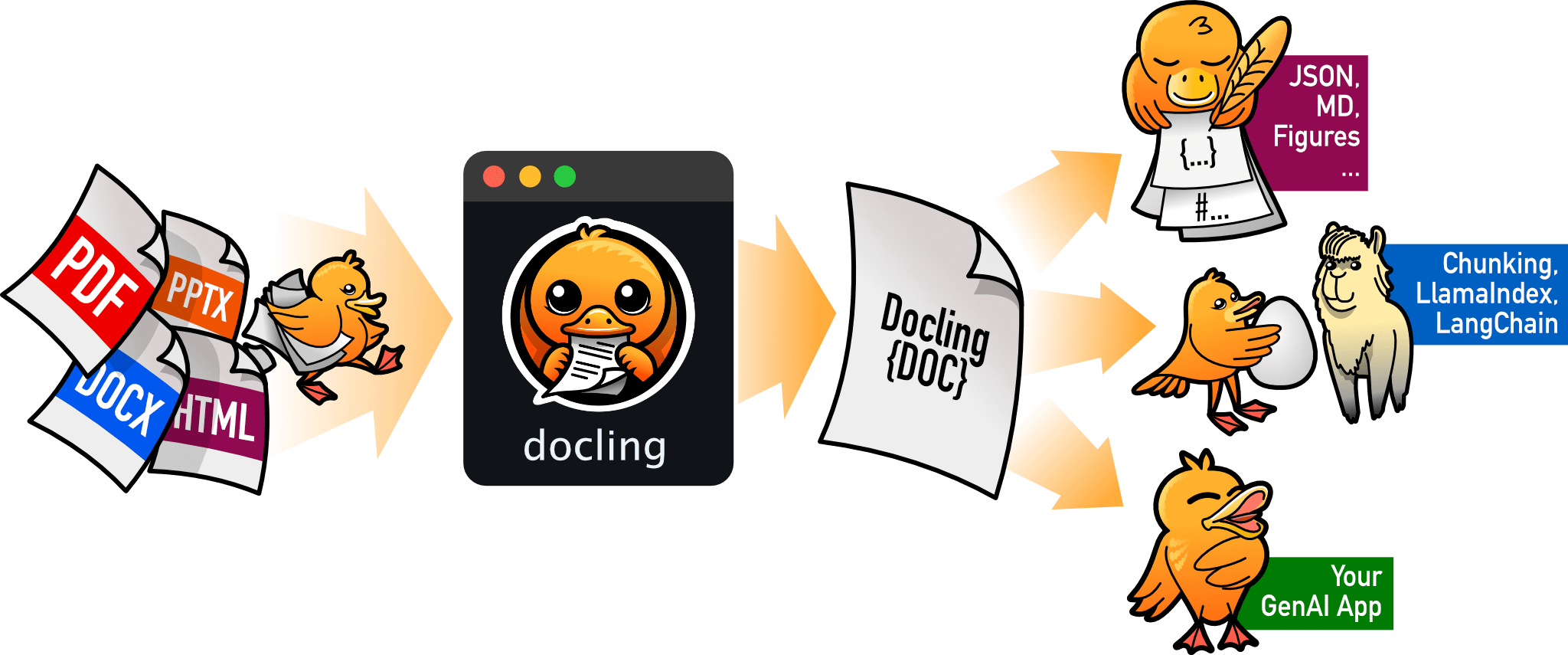

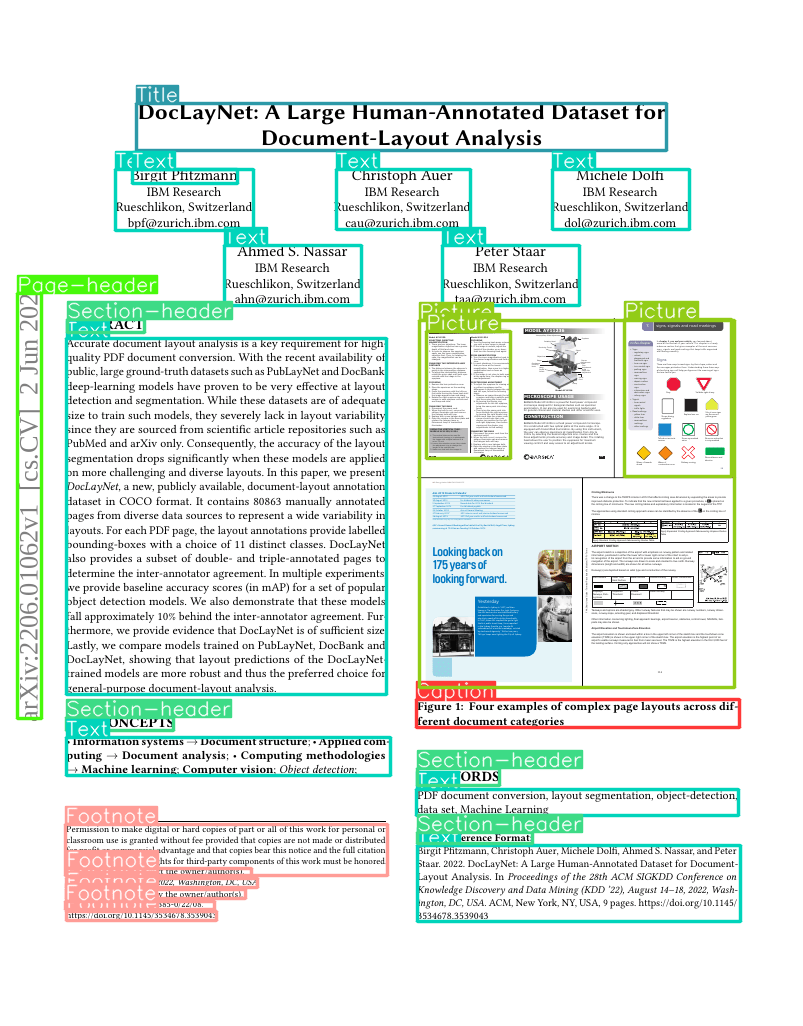

Der Text ...

Die Funktion des Textes ...

Die Bilder...

Der Text in den Bildern/OCR

Die Tabellen im Dokument

Die Daten der Diagramme im Dokument

Rekonstruktion von Tabellen

Metadata Extraction (Titel, Autor, Referenzen)

Day 2 Parsing

Layout /

Diagram

Understanding

Docling

- PDF, DOCX, XLSX, HTML, images, ...

- Layout understanding

- Chart understanding (Barchart, Piechart, LinePlot, etc)

-

Plugin-Infrastruktur für

- OCR

- Vision Models

- Eigenes SmolDocling-VLM

- Metadata extraction, including title, authors, references & language

- Table reconstruction

This is a bar chart, which shows the percentage of people in Germany who voted for the populist party in the 2020 and 2024 elections. The x-axis shows the years, while the y-axis shows the percentage of people who voted for the populist party. The bar chart is titled "Durchschmitteln 2020-2024."

The image is a bar chart titled "Median." The chart is divided into three horizontal rows, each representing a month. The x-axis represents the month, while the y-axis represents the values of the data points. The data points are color-coded to represent different values:

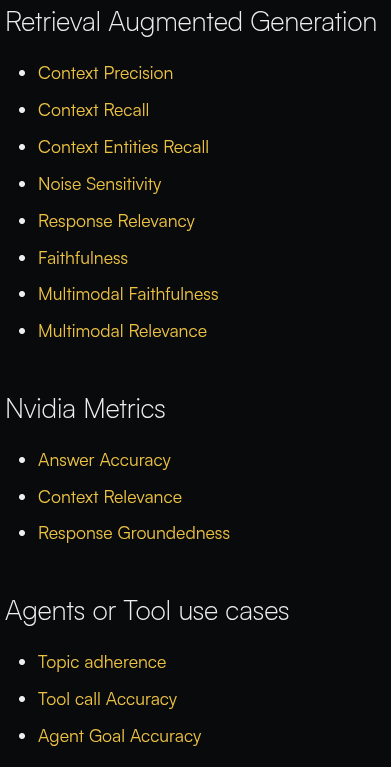

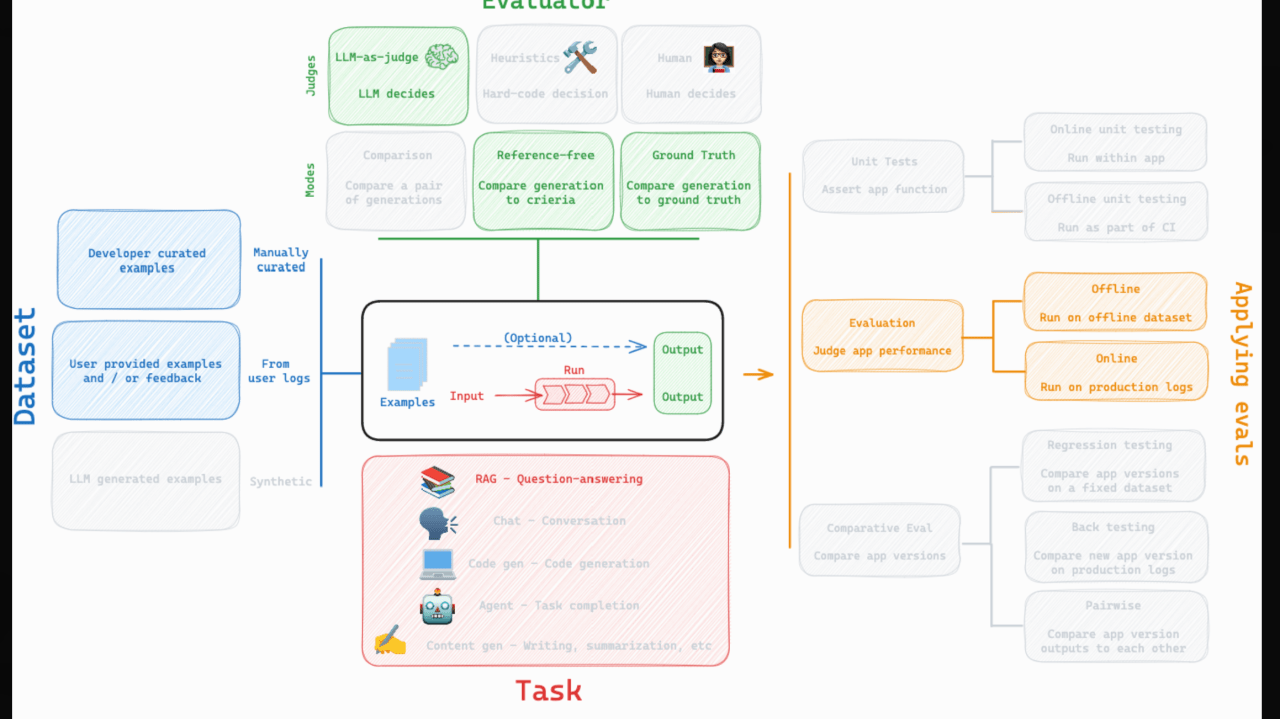

Day 2 Reliable RAG

Reliable RAG

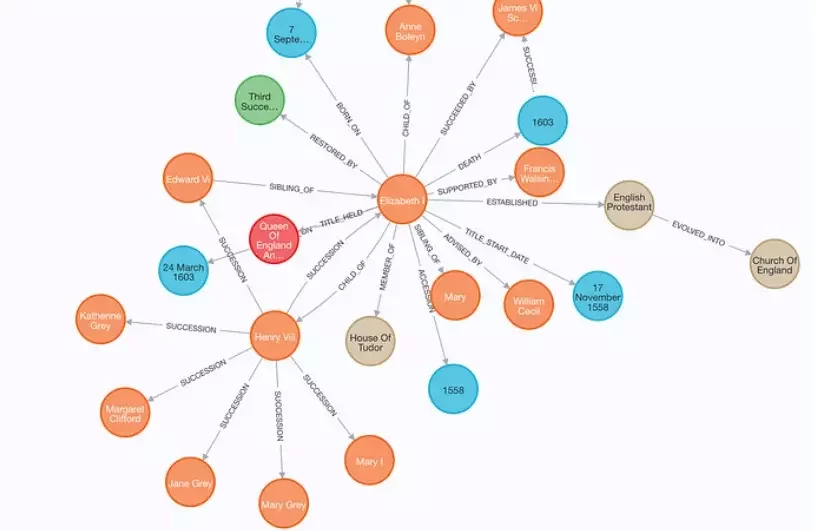

GraphRAG

Grounding

Semantic Chunking

Faithfulness

Answer Relevance

Context Relevance

User Feedback

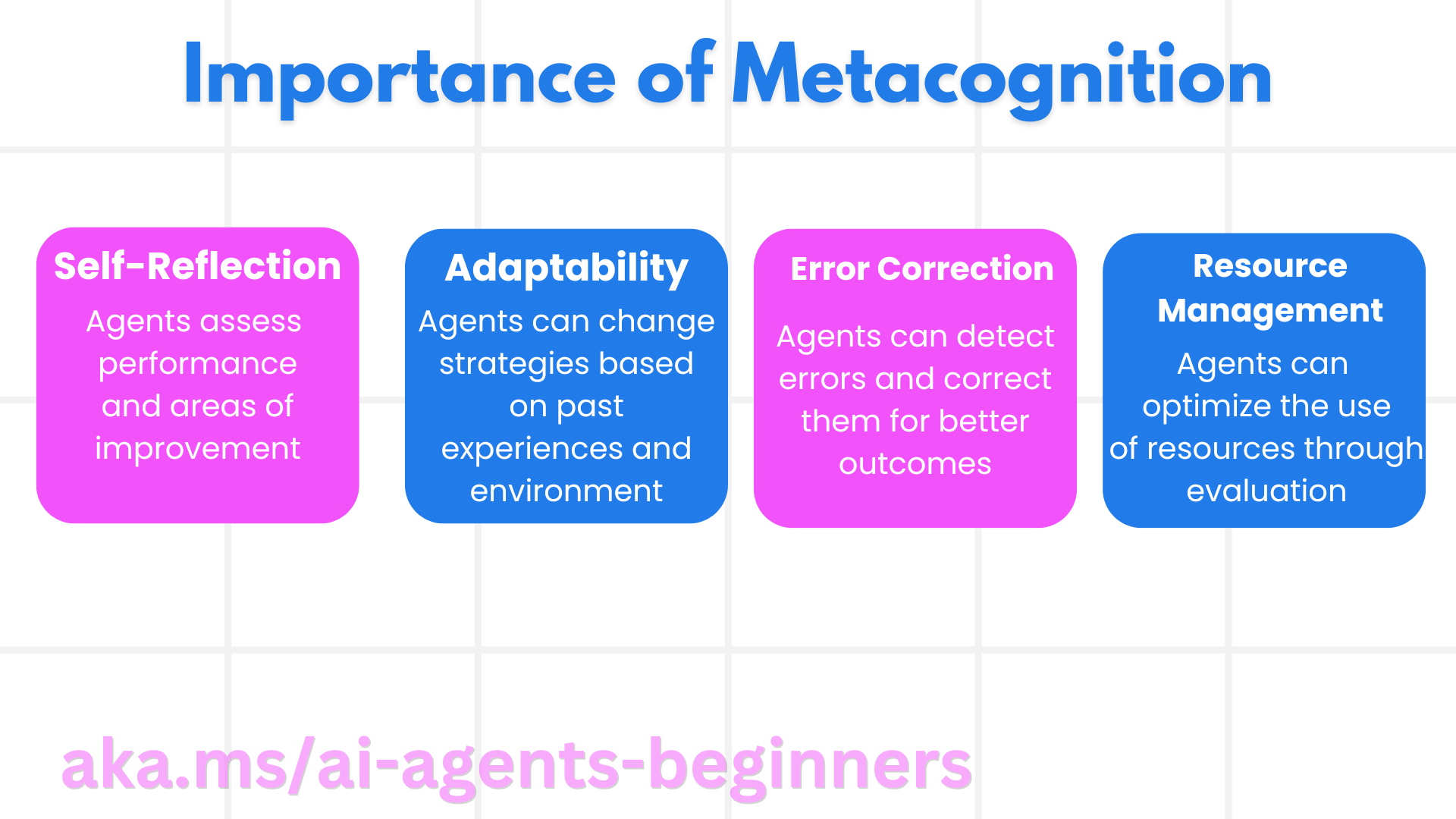

Self Critique

Reflection

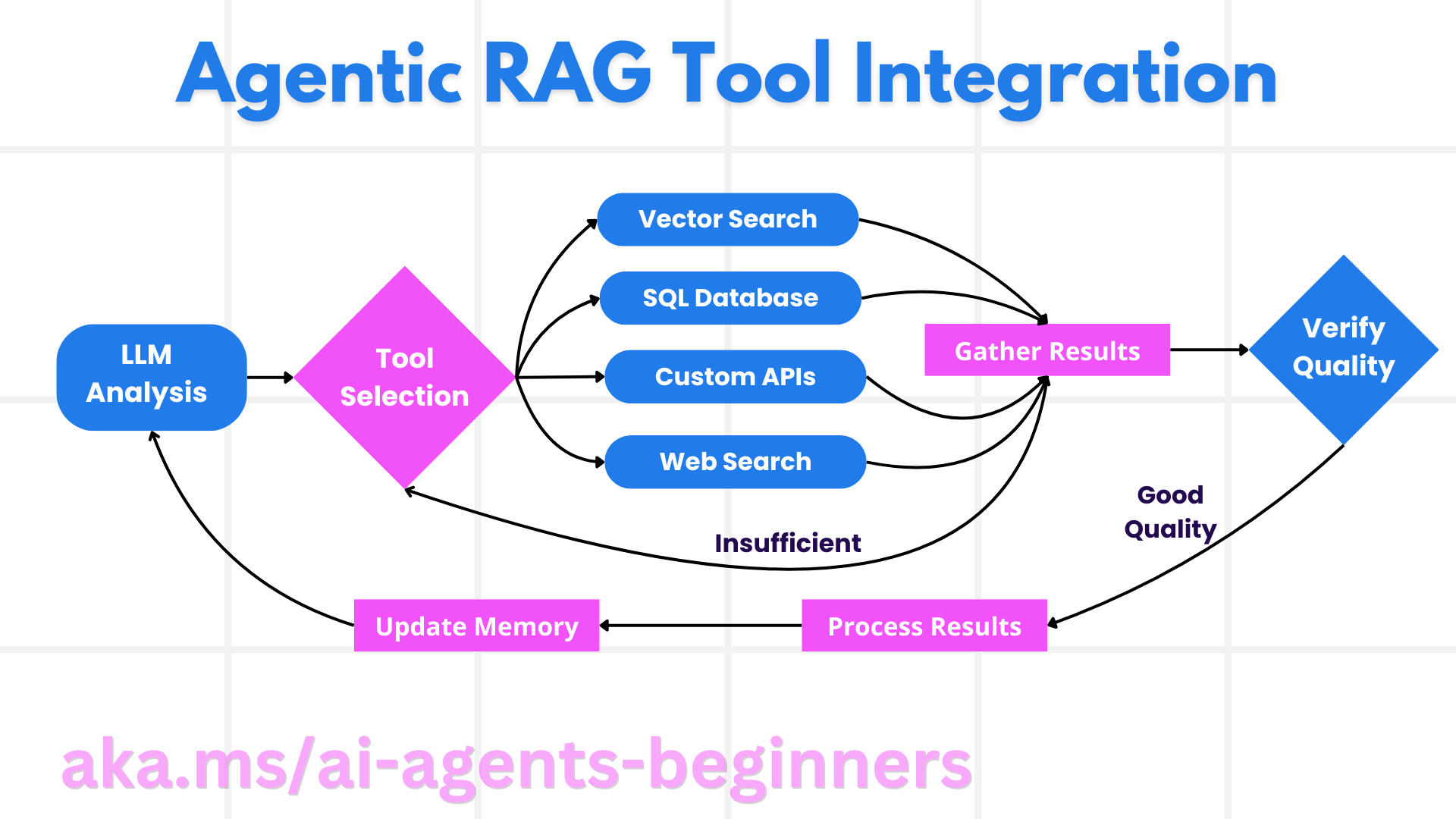

Agentic RAG

Corrective RAG

Re-ranking

Scoring

Correctness

Daten für Reliable RAG

Reliable RAG

GraphRAG

Grounding

Semantic Chunking

Faithfulness

Answer Relevance

Context Relevance

User Feedback

Self Critique

Reflection

Agentic RAG

Corrective RAG

Re-ranking

Scoring

Backtesting

Chat-Simulation

Correctness

Day 2 Reliable RAG

Day 2 AgentOps

- Production Data für Back-Testing

- Finale Response: stimmt das Ergebnis?

- Trajectory: Wurden die richtigen Tools (in der richtigen Reihenfolge) eingesetzt?

- Single-Step: Wird das richtige Tool für ein Problem ausgewählt?

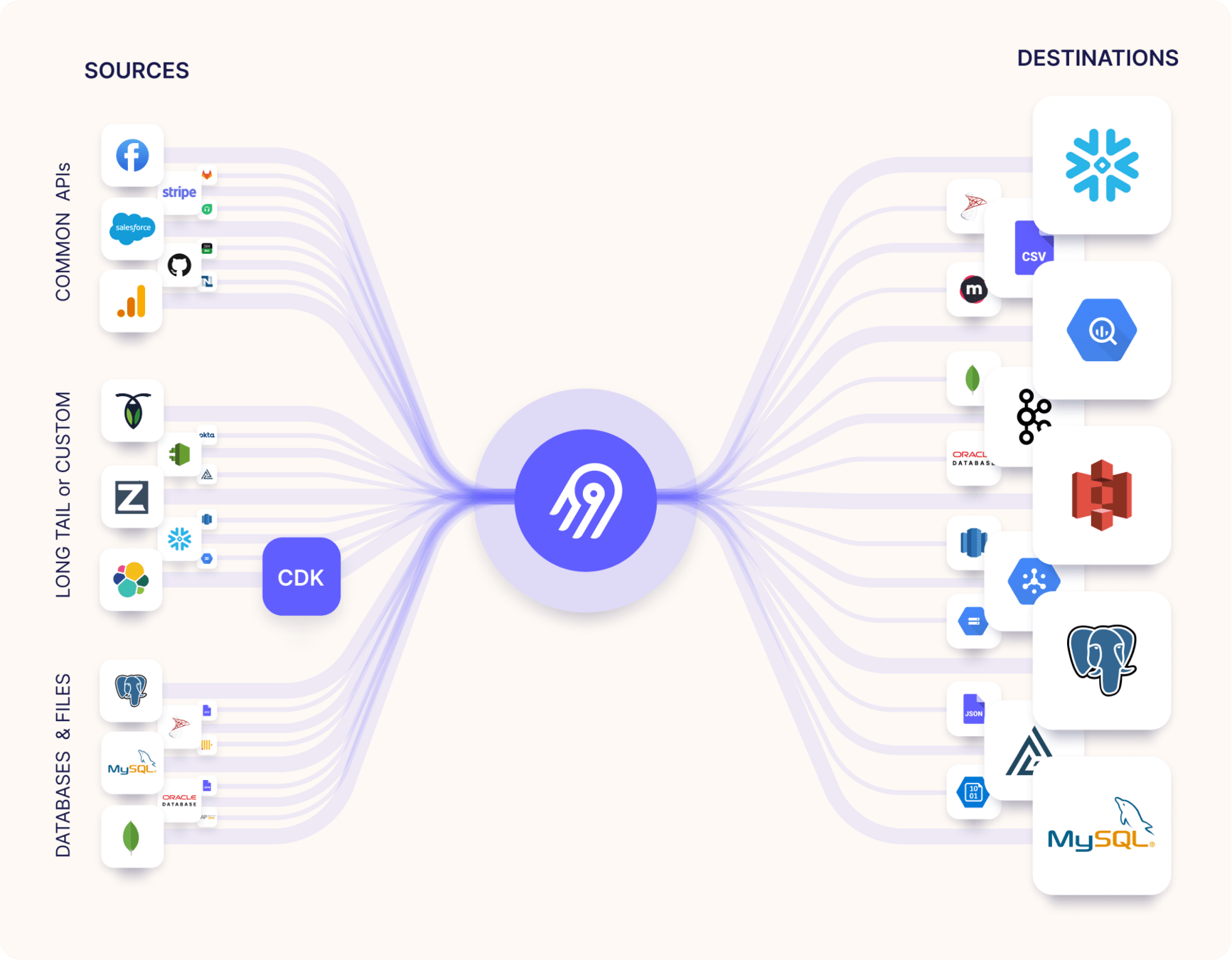

Mehr Datenquellen

Mehr Datenarten

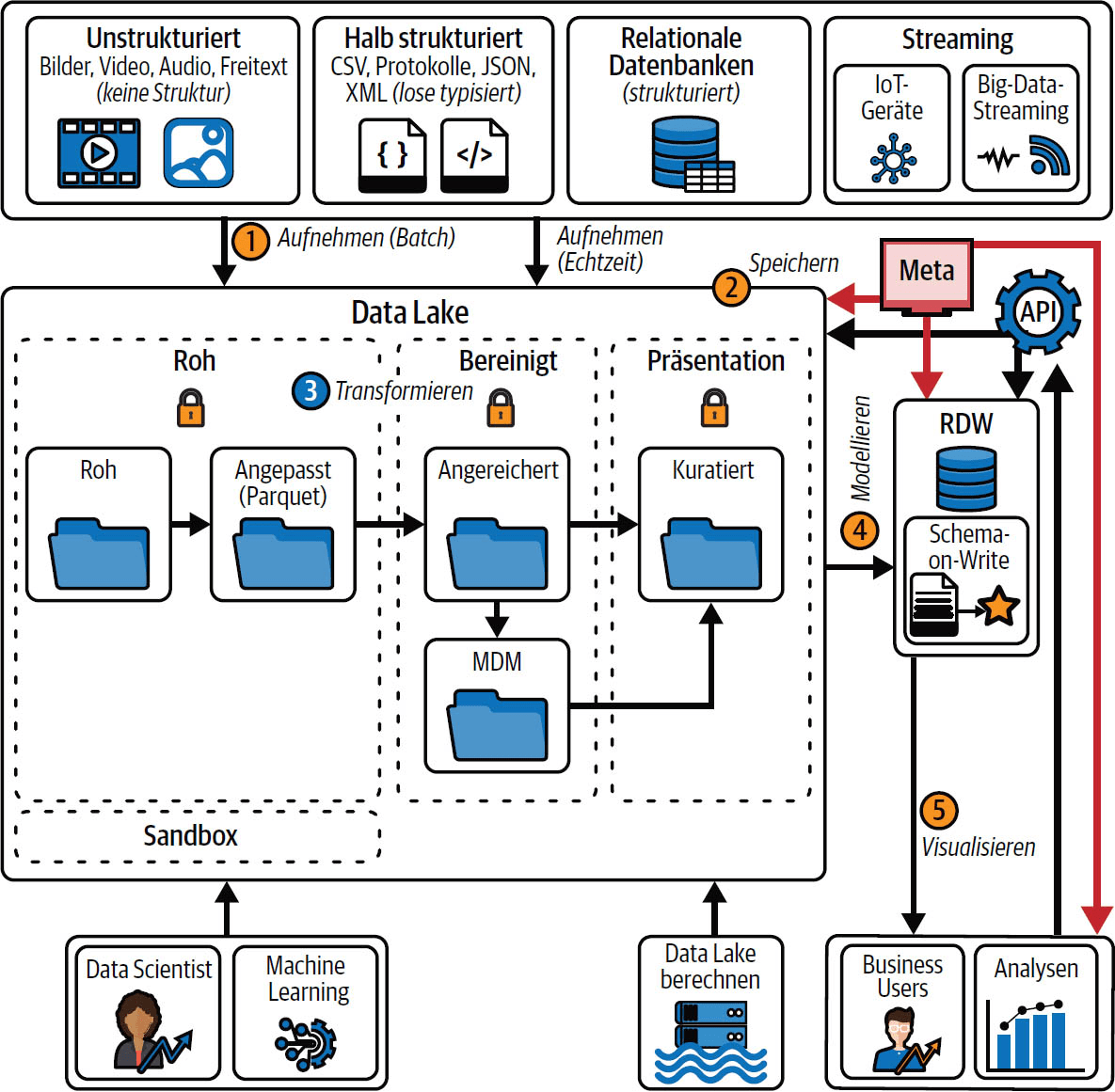

| Unstrukturiert | Halb strukturiert | Relational | Agentic |

|---|---|---|---|

| Dokumente | Metadaten | CRM | Prompt Logging |

| Document Summaries | CSV, JSON, Scraped Data | ERP | RAG Logging |

| Bild/Audio/Video | Produktdaten/PIM | BI-Daten | Agent Logging |

| Scans | Conversations | Order Management | RLHF-Feedback |

| Wikis etc | Mails | Knowledge Graphs |

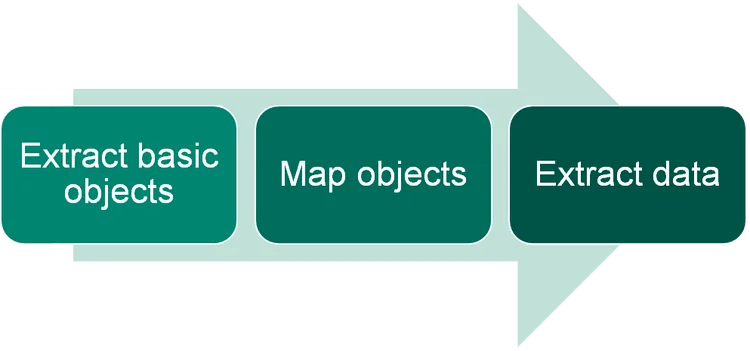

Orchestration

Batching

Inkrementelle Updates

Streaming

Deduplication

Change Data Capture

Parsing / OCR

Splitting / Chunking

Embedding / GraphRAG

Authentifizierung

Monitoring / Alerting

DATA *

Orchestration

Batching

Inkrementelle Updates

Streaming

Deduplication

Change Data Capture

Parsing / OCR

Splitting / Chunking

Embedding / GraphRAG

Authentifizierung

Monitoring / Alerting

DATA *

Initialkosten--

Grenzkosten--

Realtime++

Verlässlichkeit++

Compliance & Datenschutz++"Ich bräuchte da mal eine Data Platform, nur schneller, flexibler,

verlässlicher und billiger"

"Small Data Projects"

Initialkosten--

Grenzkosten--

Realtime++

Verlässlichkeit++

Compliance & Datenschutz++85%

Orchestration

Batching

Inkrementelle Updates

Streaming

Deduplication

Change Data Capture

| Unstrukturiert | Halb strukturiert | Relational | Agentic |

|---|---|---|---|

| Dokumente | Metadaten | CRM | Prompt Logging |

| Document Summaries | CSV, JSON, Scraped Data | ERP | RAG Logging |

| Bild/Audio/Video | Produktdaten/PIM | BI-Daten | Agent Logging |

| Scans | Conversations | Order Management | RLHF-Feedback |

| Wikis etc | Mails | Knowledge Graphs |

Parsing / OCR

Splitting / Chunking

Embedding / GraphRAG

Authentifizierung

Monitoring / Alerting

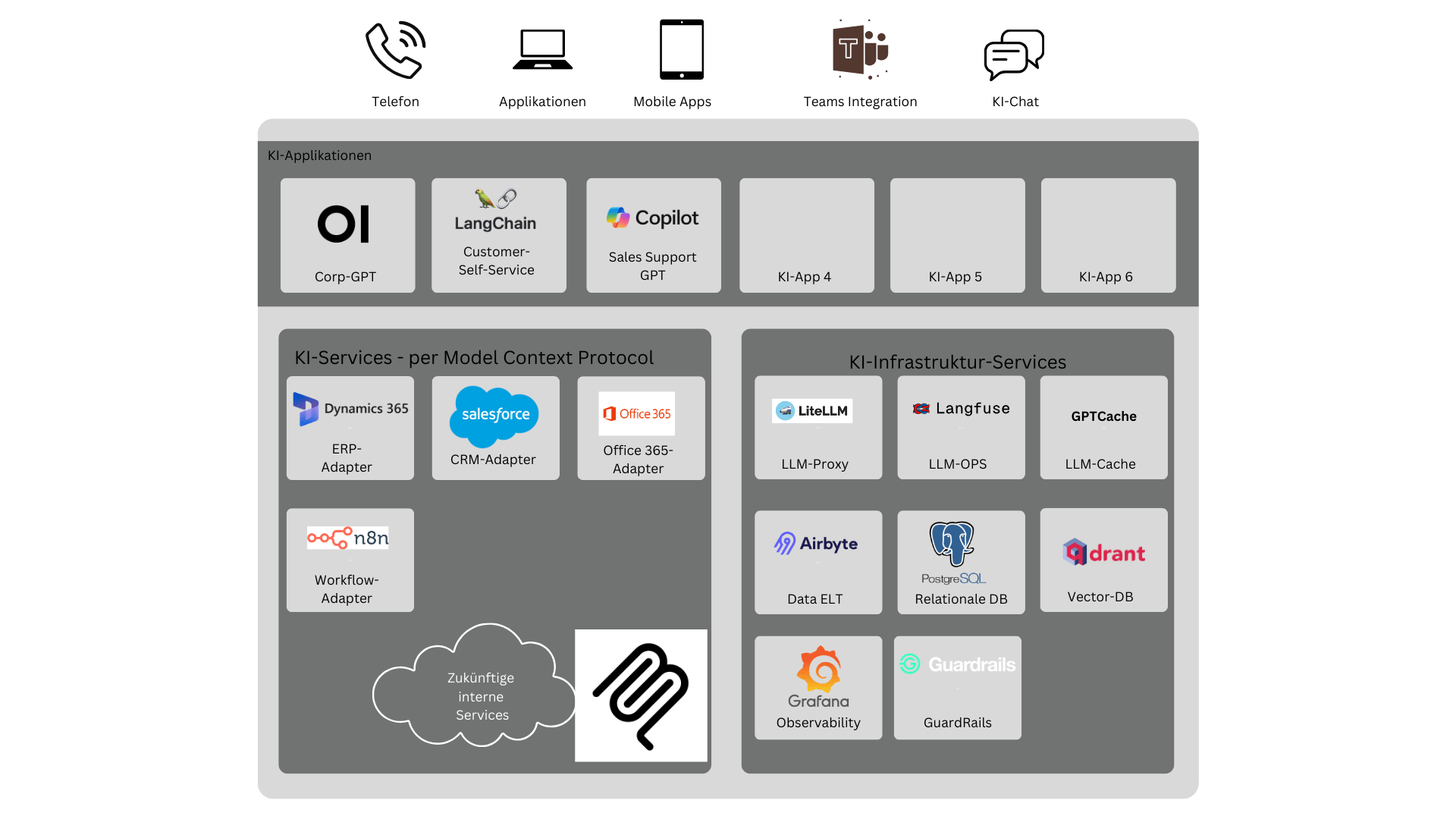

Architekturübersicht MCP

MCP Konkretisiert

-

Vereinfachte Integration verschiedener Modelle

-

Standardisierte Tool-Nutzung über verschiedene Modelle und Systeme hinweg

-

Verbesserte Kontextualisierung und Nachvollziehbarkeit

-

Integration in Telemetrie und Alerting Infrastrukturen

-

-

Reduzierte Entwicklungszeit für neue Agenten

MCP Beispiel

// Beispiel eines einfachen MCP-Servers in TypeScript

import { Server } from '@modelcontextprotocol/sdk/server';

import { StdioServerTransport } from '@modelcontextprotocol/sdk/server/stdio';

const server = new Server(

{

name: 'example-server',

version: '0.1.0',

},

{

capabilities: {

resources: {},

tools: {},

},

}

);

// Tool-Definition

server.setRequestHandler(ListToolsRequestSchema, async () => ({

tools: [

{

name: 'get_weather',

description: 'Get weather forecast for a city',

inputSchema: {

type: 'object',

properties: {

city: { type: 'string' },

days: { type: 'number' },

},

required: ['city'],

},

},

],

}));Meine IDE als Agent

APIs Data Documents

By Johann-Peter Hartmann

APIs Data Documents

Im Agentic Age wird Nachholbedarf bei der Digitalisierung deutlich teurer, weil Automatisierung mittels KI nur dort stattfinden kann, wo Daten, Dokumente und Schnittstellen auch digital zur Verfügung stehen. Glücklicherweise unterstützt AI auch an dieser Stelle - die Integration Document Intelligence scheitert nicht mehr an OCR, sondern ist ein gelöstes Problem, und die Bereitstellung von AI-Schnittstellen über das Model Context Protocol erzeugt oft nur einen kleinen Aufwand. Und sogar die Verfügbarkeit von Daten über Datalakes, Data-Lakehouses bis zu Data Meshes ist nicht nur Voraussetzung für KI, sondern profitiert auch selbst von der neuen Technologie.

- 313