Das Ende nutzerzentrierter Produktentwicklung

Wer von Euch hat AI im Einsatz?

Seit wann?

Wir seit 6-7 Jahren.

Aber eher als Hobby, so nebenbei.

Das gibt es aber seit mehr als 50 Jahren.

Warum investiert die Welt erst jetzt?

Warum reguliert

die EU erst jetzt?

Schwache AI

-

Spezialisiert auf eine Aufgabe

-

Kein eigenes Bewusstsein oder Verständnis

-

Funktioniert bei vorgegebenen und festgelegten Problemen

-

Muss trainiert werden für die Aufgabe

-

Beispiele: Chatbots, Bilderkennung, Spracherzeugung

Starke AI

-

Kann universelle Aufgaben bearbeiten

-

Selbstbewusst mit Kontextverständnis

-

Lernt und adaptiert

-

Beispiele: Agenten, HAL 9000

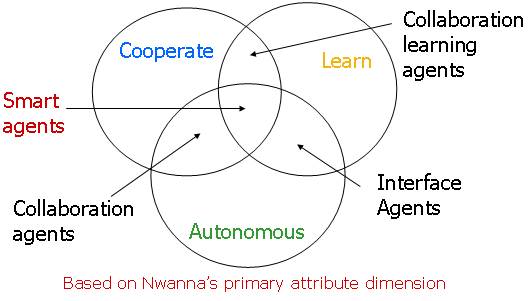

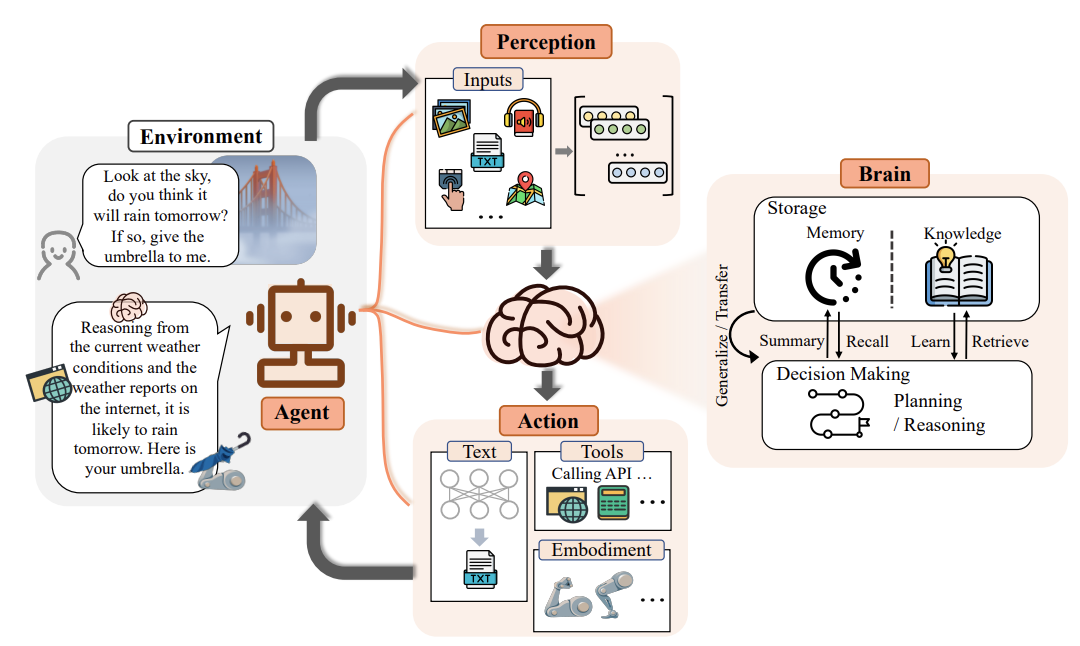

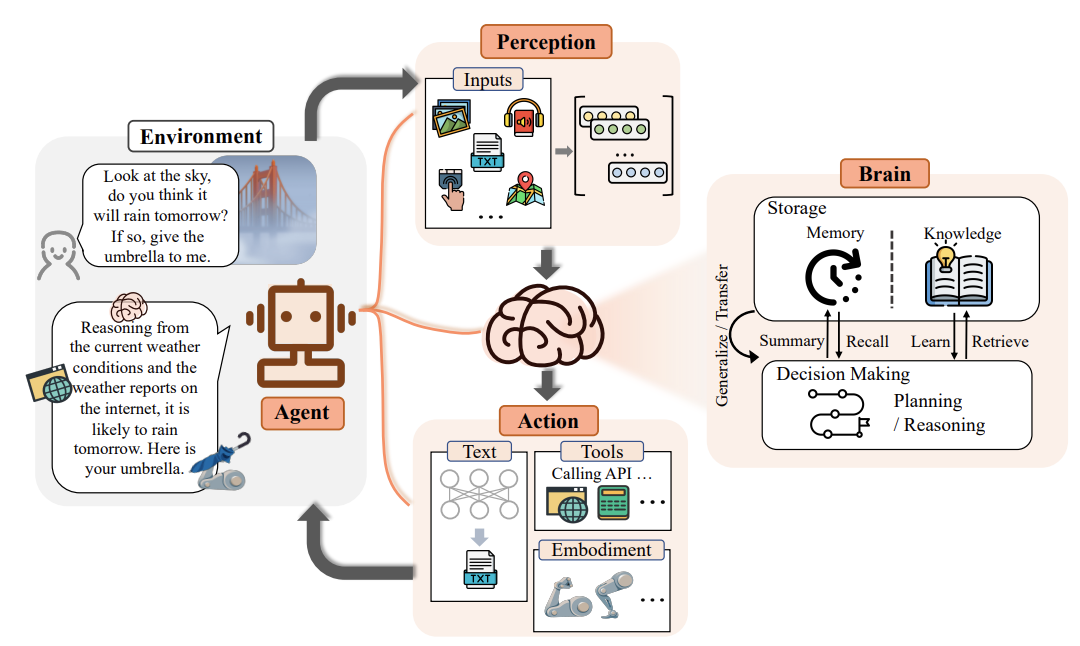

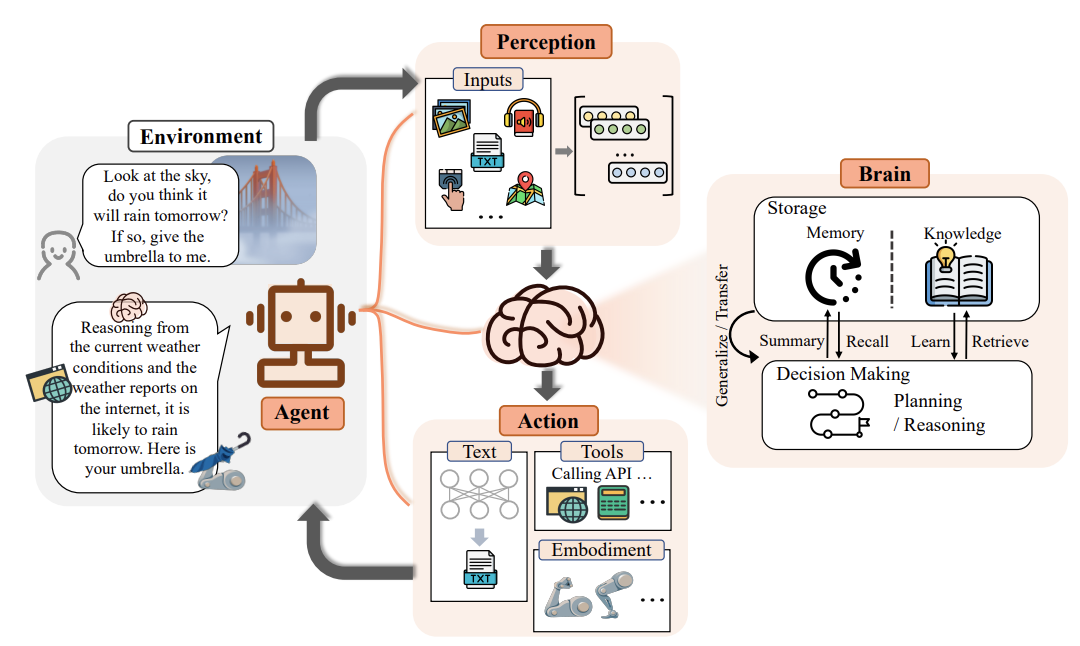

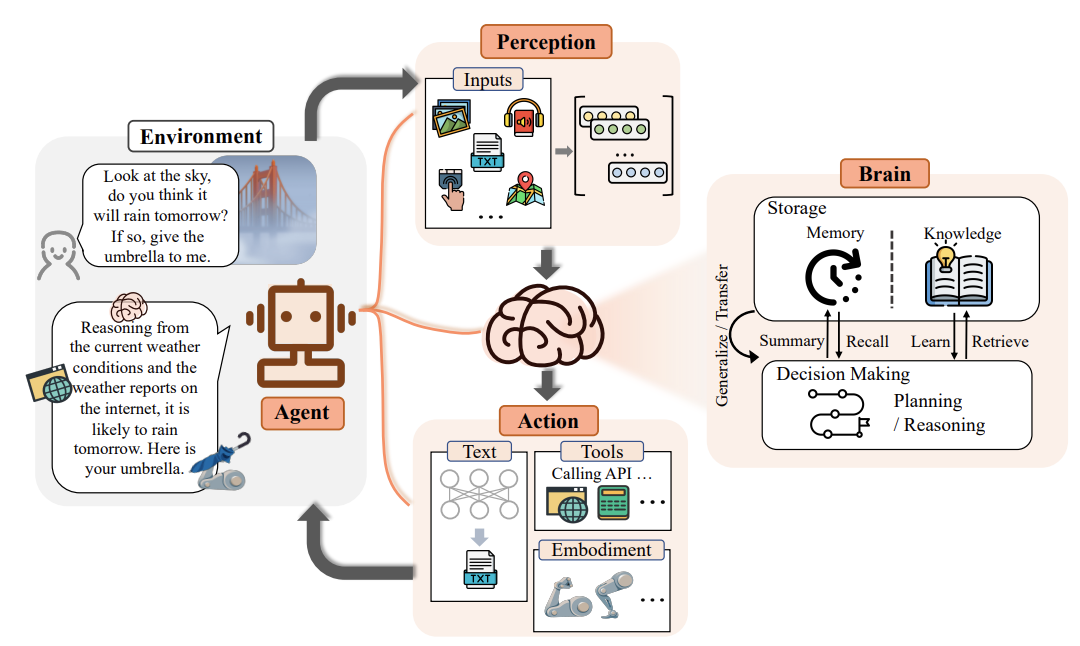

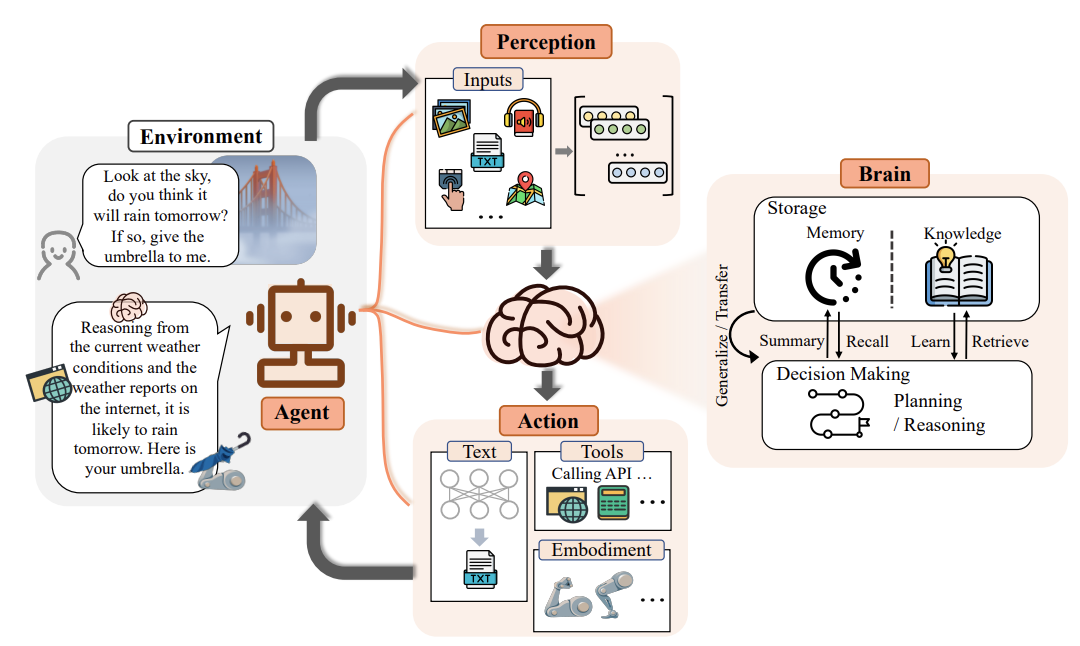

Was sind Agenten?

-

fast so alt wie ich (1977 Hewitt)

-

führt aus eigener Initiative Aktionen aus und arbeitet unabhängig vom Nutzer

-

kommuniziert mit dem Nutzer

und anderen Agenten

-

passt sich an die Umwelt an und lernt langfristig aus Beobachtungen und Entscheidungen

Was sind Agenten?

... und sie sind schuld daran.

... und daran ...

... und das wusste OpenAI

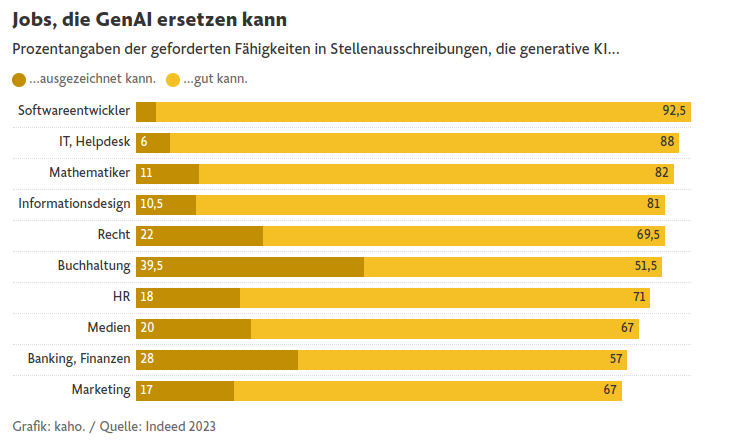

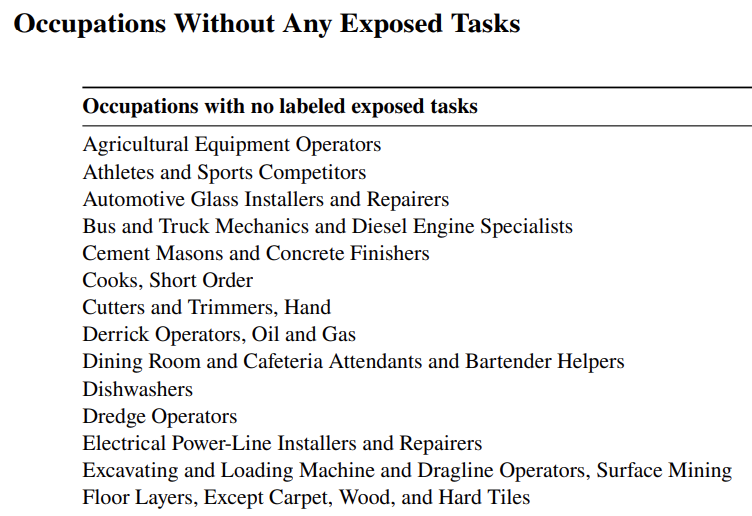

Wer sich umorientieren möchte ..

WTF ...

Agenten gibt es doch schon lange, Sprachmodelle auch.

Warum jetzt auf einmal

so einen Wirbel machen?

Language Models

Gibt es seit den 80ern.

-

Können:

-

Zusammenfassung

-

Text Generation

-

Lücken füllen

-

Entities erkennen

...

-

-

Das statistisch Wahrscheinliche auf Basis von Model & Input

| Input | Prediction |

|---|---|

| Hello! | How |

| Hello! How | can |

| Hello! How can | I |

| Hello! How can I | as- |

| Hello! How can i as- | -sist |

| Hello! How can i assist | you |

| Hello! How can i assist you | today |

| Hello! How can i assist you today | ? |

Language Models

Text-Generation: Sag mir statistisch das nächste Wort voraus ...

LARGE Language Models

-

Generative Pretrained Transformer

-

Du bist zu arm dafür:

GPT-4 100.000.000 $ -

Europa auch

-

UAE nicht:

Falcon 180B 7.000.000 GPU Hours.

Du, die richtige Fortsetzung von

"Zähl mal von 1 bis 12"

ist

"1,2,3,4,5,6,7,8,9,10,11,12"

Wie man aus Text Generation

Instruction Following macht

FLAN-Palm Finetuning

Welche Instruktionen trainiert wurden

Und was daraus entstand...

- Generate Texts

- Summarization

- Classification

- Question Answering

Planned ...

- Follow Instructions

- Reasoning

- Decision making

- Evaluate Results

Emergent...

-

führt aus eigener Initiative Aktionen aus und arbeitet unabhängig vom Nutzer

-

kommuniziert mit dem Nutzer und anderen Agenten

-

passt sich an die Umwelt an und lernt langfristig aus Beobachtungen und Entscheidungen

Demo

Wer hat sich die Datenbank angeschaut?

Wer hat die SQL-Statements gemacht?

Wer hat bewertet, dass die Aufgabe erledigt ist?

Agenten vs Software

-

Programmierkosten sind vernachlässigbar

-

Ausführung kostet in jedem Schritt Geld

-

Eine Ausführung kostet zwischen

XX Cent und XX Euro -

Jede Ausführung ist anders

-

der Agent lernt aus Fehlern

Agenten vs Menschen

-

Ausführungskosten sind vernachlässigbar

-

Es ist ok, Dinge öfter zu machen

-

Es ist ok, Dinge parallel zu machen

-

Jeder Fehler passiert nur einmal, eimal erlerntes ist immer da

Es ist ok, Dinge doppelt zu machen. Oder 10 mal.

Klappt erst beim siebten Versuch? Super!

Dinge werden auf einmal rentabel.

Content spontan für den Kunden,

genau jetzt, neu erstellen.

100 Angebot statt 5 in der Ausschreibung bearbeiten.

Für die Aufnahme im CRM atomatisch die Website auswerten, die Handelsregister durchforsten und Linkedin auslesen.

Dinge lohnen sich auch als One-Shot

Code erzeugen um ein Problem zu lösen.

GUI für eine Nutzerinteraktion generieren.

Website bzw. Dokumentation für einen Kunden generieren.

4-Augen-Prinzip ohne Augen

-

Wer prüft, ob der Agent korrekt geschlussfolgert hat?

-

Wer prüft, ob formulierungen politisch korrekt und kundengeeignet sind?

-

Wer sorgt dafür, dass die Sprache gendergerecht ist?

-

Wer rechnet das Angebot nach und plausibilisiert es?

Constitutional AI

Der Agent kann das

Ergebnis des Agenten prüfen.

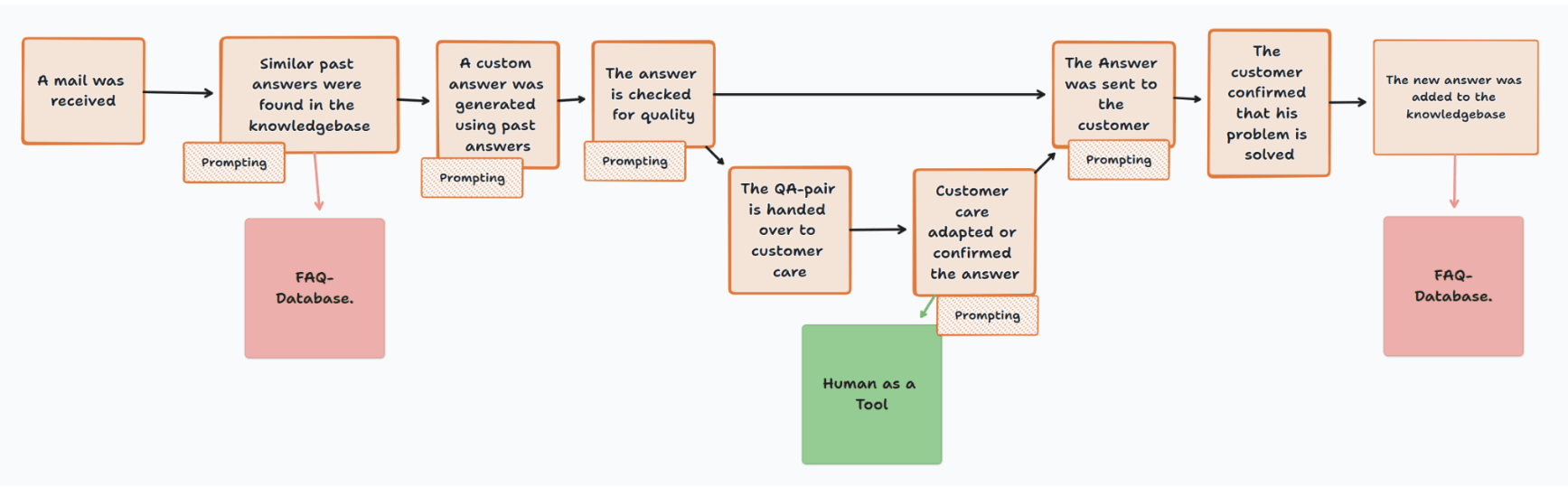

Realer Beispielcase

Anfragen werden per Post oder E-Mail gestellt.

Der Agent identifiziert, was der Nutzer möchte, identifiziert den Nutzer, recherchiert in den verschiedenen Systemen, macht ein Angebot als PDF und versendet es per Brief.

Wo sollte hier ein Mensch mitarbeiten?

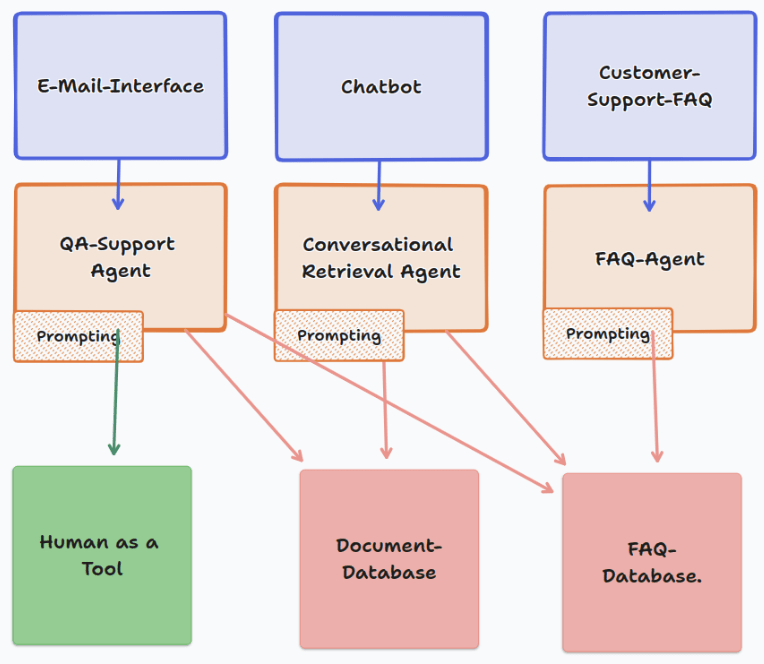

Wie man Agenten baut

Auf was soll der Agent reagieren?

-

Chat

-

E-Mail / Post

-

Telefon / Videoconferenz

-

Bilder & Videostreams

-

externe Systeme

-

Apps und Webseiten

Mit was soll der Agent arbeiten?

-

Dokumente generieren

-

Daten erzeugen, ändern, ablegen

-

Chats, Mails, Briefe, Telefonate beantworten

-

Maschinen steuern

-

Externe Services ansteuern, zB Payment oder Bestellsysteme

-

Interne Systeme wie ERP, CRM, HR-Software

Wie soll der Agent arbeiten

-

Welches Wissen braucht er?

-

Short Termin Memory für die aktuelle Aufgabe

-

Long Term Memory für

-

Dokumente, Anleitungen

-

Arbeitsabläufe und Handlungshinweise

-

erlerntes Wissen

-

trainiertes Wissen

-

-

-

Strategien

-

als Prompts

-

als Beschreibung

-

Human as a Tool / Conversational AI

-

Der Agent fragt den Menschen, ob seine Handlung richtig ist.

-

Der Mensch erklärt was zu tun ist und warum.

-

Der Agent nimmt diese Information in den Long Term Memory und nutzt diese Information beim nächsten mal.

Wer ist der User?

Sollte die Souffleuse die Hauptrolle spielen?

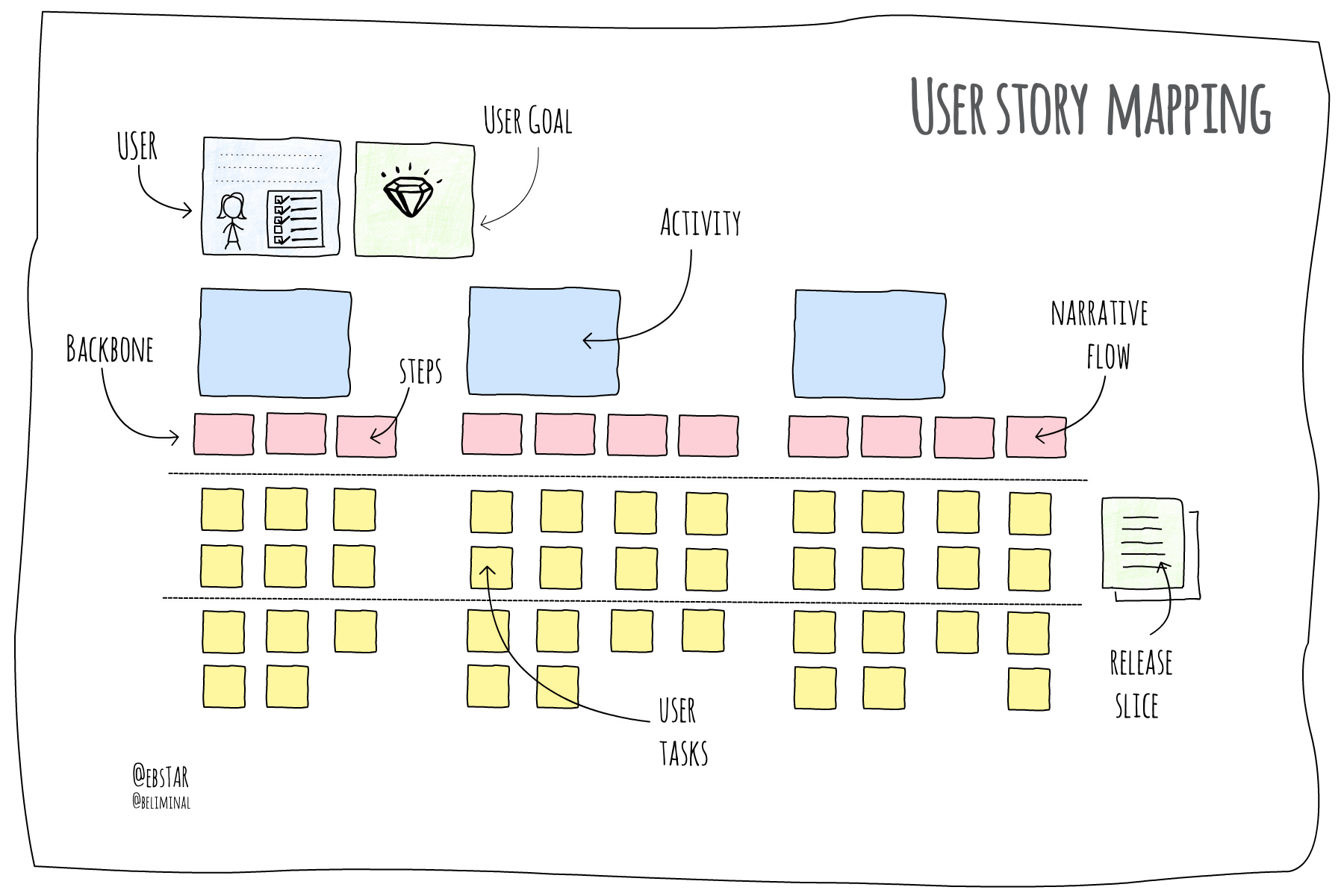

User Stories?

Impact Mapping?

Hooked?

Title Text

Title Text

Customer Care Agent in LangChain

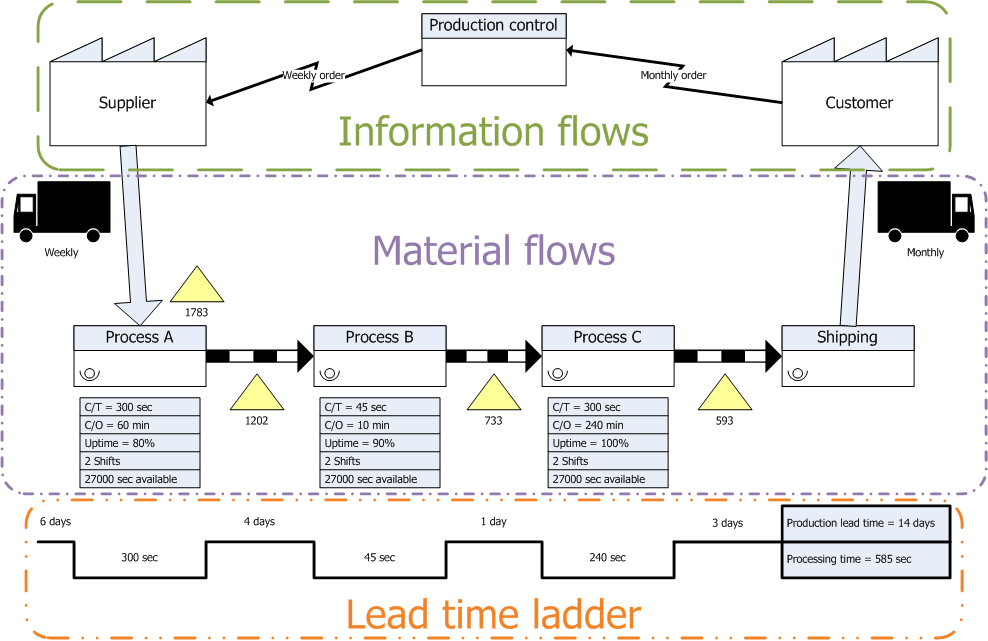

AI Muda

Menschliche Aufmerksamkeit und Kreativität

nutzen wo keine gebraucht wird.

Wissen als First Class Citizen

Step 1: Prompting und Wissen in Vectordatenbanken

Step 2: Training the Agent Human in the Loop

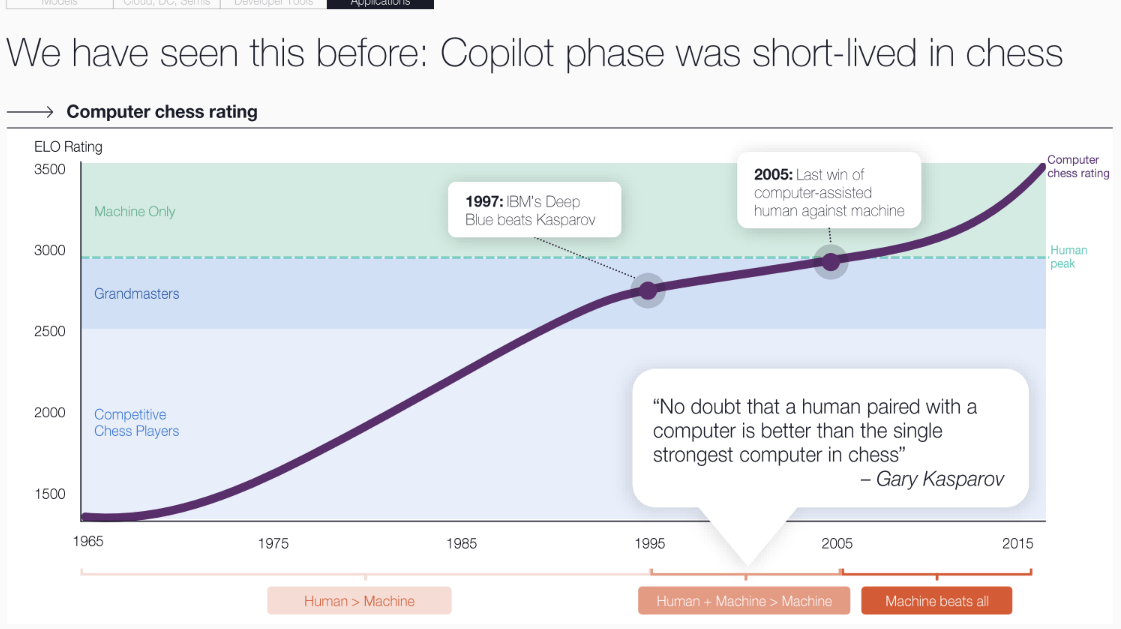

Nur eine Phase?

"Aber das Spiel Go wird nie passieren!"

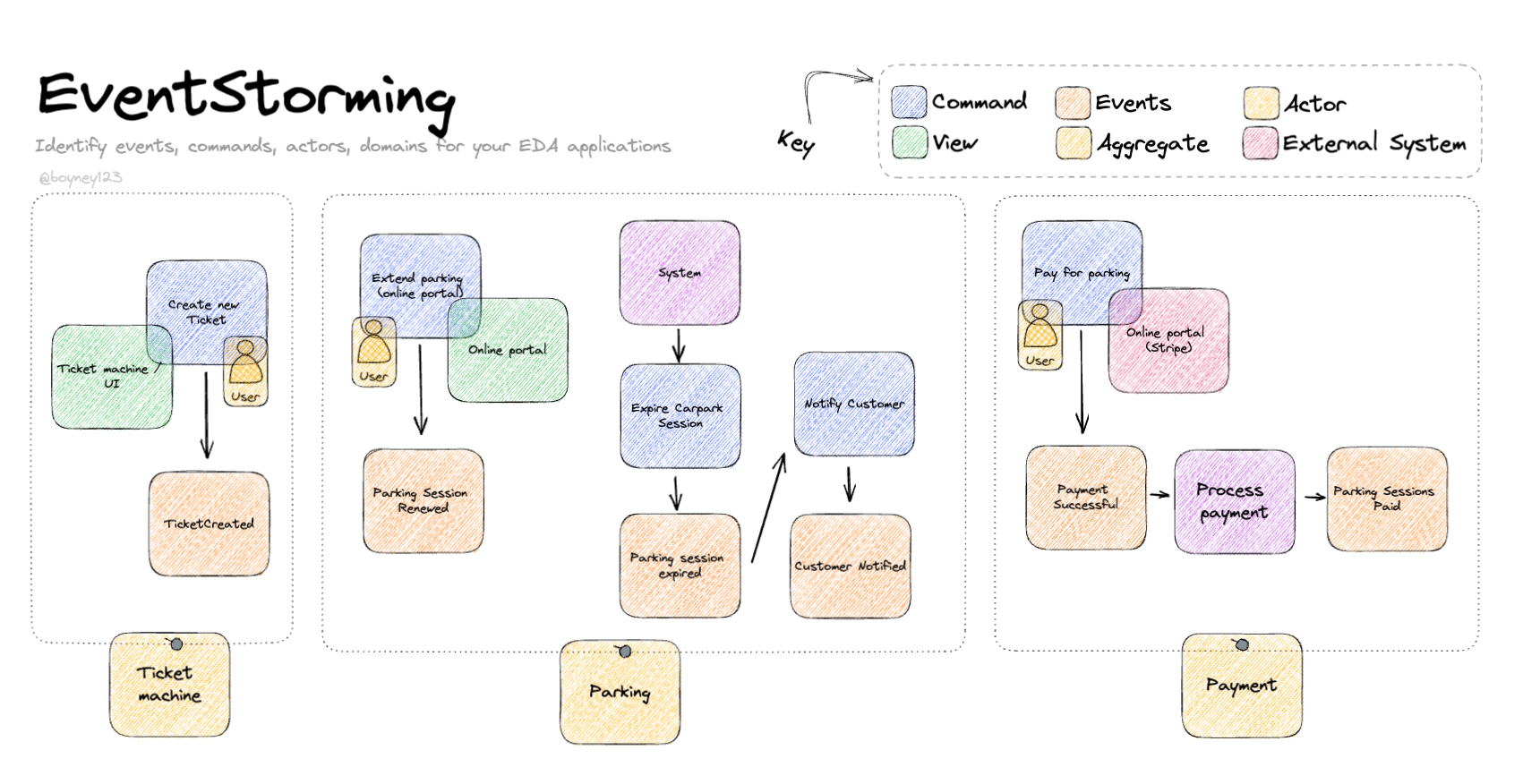

Strategien zu starker AI

- Big Picture Event Storming

- Welche Prozesse lassen sich durch Agenten umsetzen?

- Agenten nach Domänenwissen schneiden

- Learnings speichern!

- Was ist die größte Strecke, die autark stattfinden kann?

- Wie erzeuge ich das benötigte Wissen?

Das Ende nutzerzentrierter Produktentwicklung

By Johann-Peter Hartmann

Das Ende nutzerzentrierter Produktentwicklung

Wer AI naiv in Form von ChatGPT oder als Chatbot oder CoPilot einsetzt, ändert zwar wenig, verpasst aber die großen Nutzenpotentiale. Dort, wo AI in Form autonomer Agenten selbstständig arbeitet, dort, wo der Mensch als "Human as a Tool" nur bei Bedarf einbezogen wird, dort, wo die AI eigenes Wissen über die Arbeit aufbaut, dort, wo der Mensch nur beobachtend und korrigierend eingreift - da funktionieren die klassischen Ansätze der PO-Arbeit nicht mehr. Denn hier ist nicht mehr der Mensch in der Prozessführung, und Konzepte wie User Stories und Personas sind fehl am Platz. Glücklicherweise bietet der agile Werkzeugkasten noch eine Reihe von Werkzeugen, die auch dann funktionieren, wenn die Hauptrolle nicht mehr dem User gehört.

- 467