Introducción a probabilidad, variables aleatorias y procesos estocásticos

MT3006 - Robótica 2

¿Por qué?

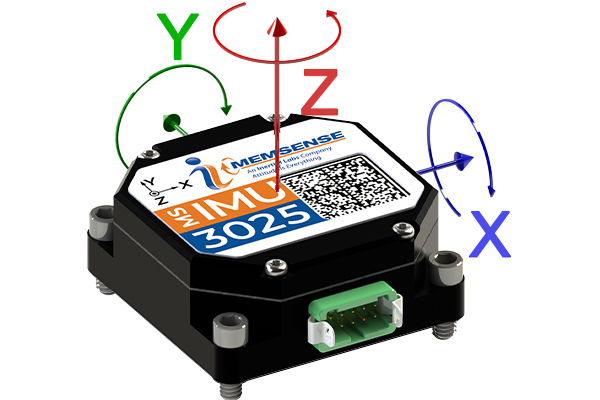

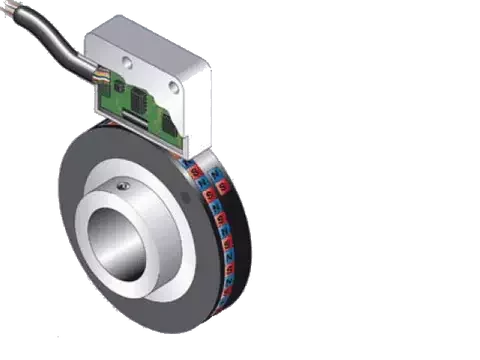

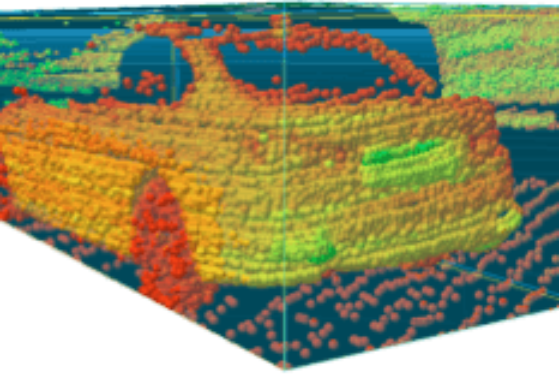

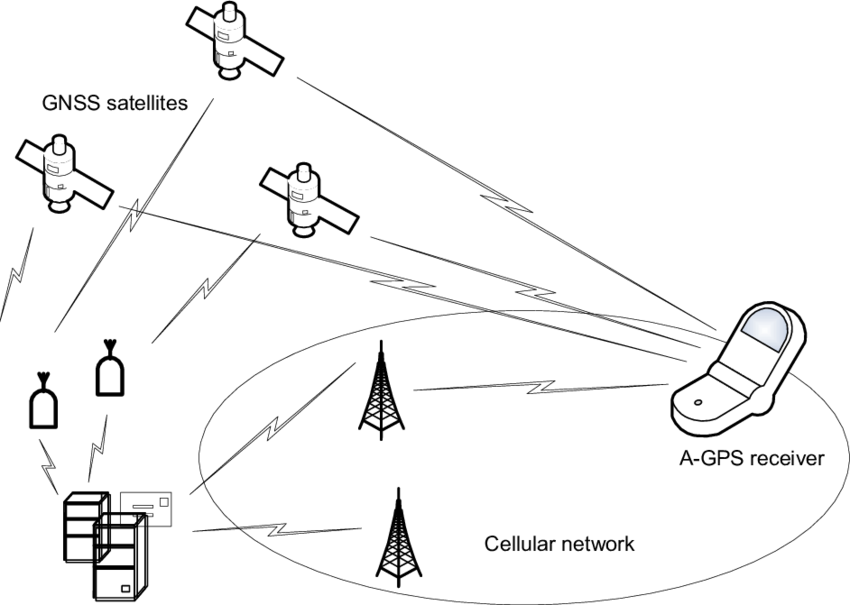

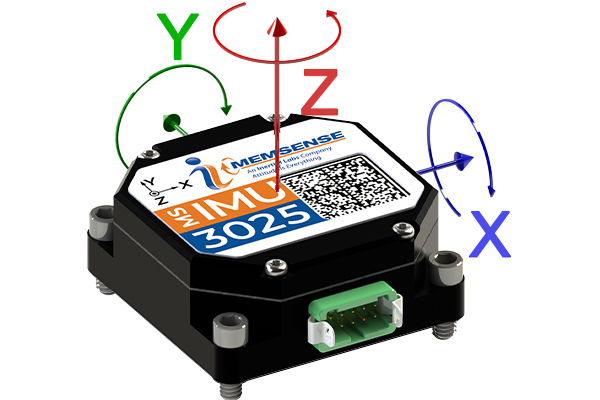

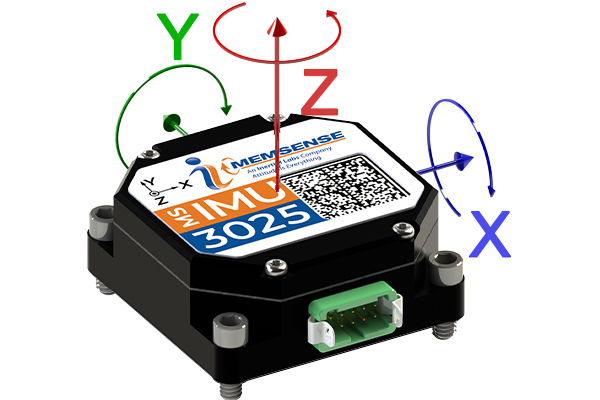

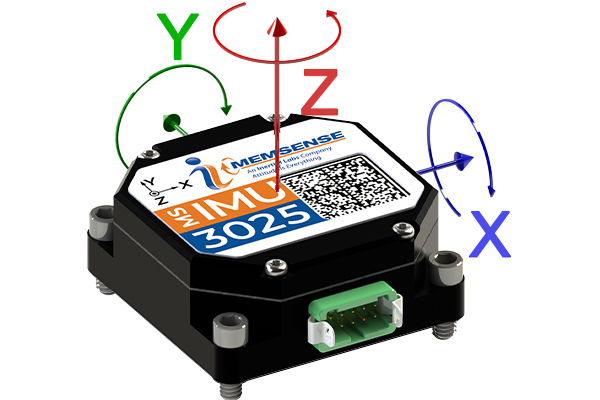

Sensores

señal + ruido

señal + ruido

aún tenemos pendiente desarrollar herramientas matemáticas para lidiar con el ruido

Probabilidad y variables aleatorias

posibles valores

posibles valores

existe cierta probabilidad que tome algún valor en específico dentro de los posibles

posibles valores

\(\Rightarrow X\) es una variable aleatoria

existe cierta probabilidad que tome algún valor en específico dentro de los posibles

descrita por una función de densidad probabilística (pdf)

\(P(X=x)=f_X(x)\) tal que \(\displaystyle\int_{-\infty}^{\infty}f_X(x)dx=1\)

existe cierta probabilidad que tome algún valor en específico dentro de los posibles

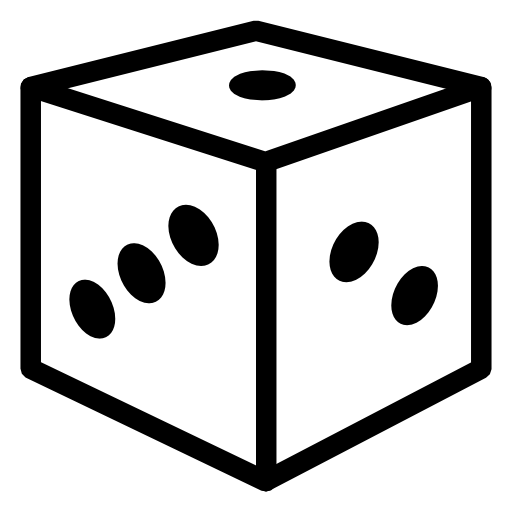

Ejemplo: variable aleatoria discreta

Ejemplo: variable aleatoria discreta

Ejemplo: variable aleatoria discreta

distribución uniforme discreta

Ejemplo: distribución uniforme continua

Ejemplo: distribución uniforme continua

Ejemplo: distribución normal (Gaussiana)

media o promedio

varianza o el cuadrado de la desviación estándar

Ejemplo: distribución normal (Gaussiana)

media o promedio

varianza o el cuadrado de la desviación estándar

Ejemplo: distribución normal (Gaussiana)

distribución normal estándar

Ejemplo: distribución normal (Gaussiana)

a veces se busca pero la probabilidad acumulada hasta cierto valor

cdf

distribución normal estándar

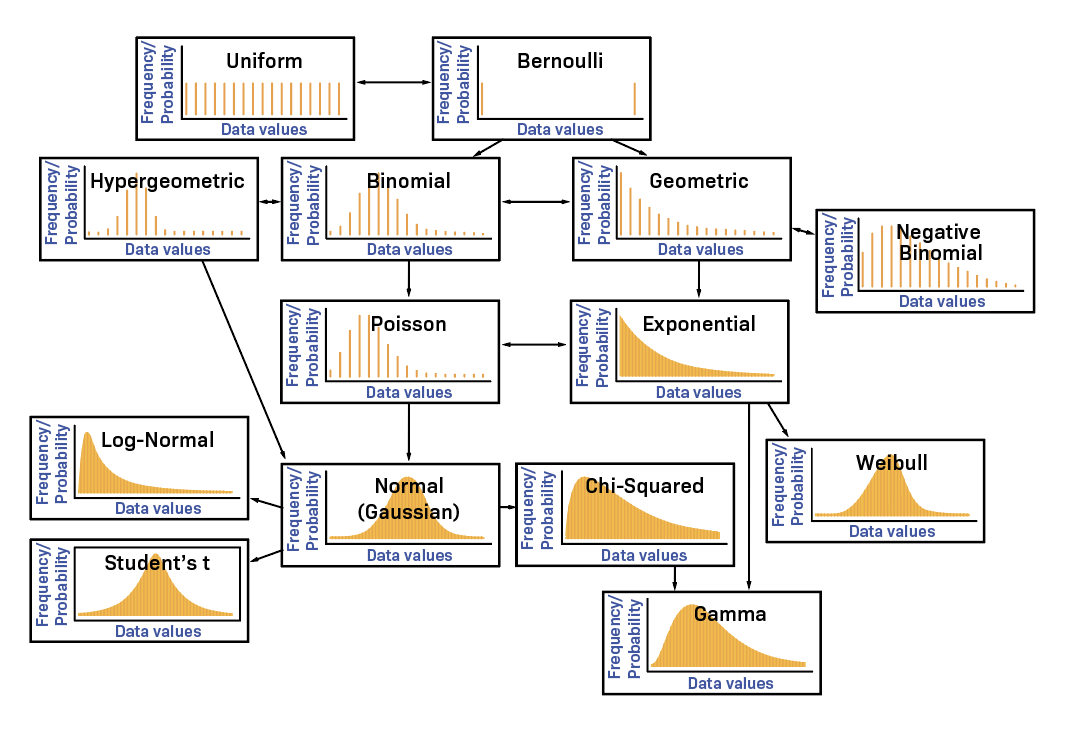

Otras distribuciones

Múltiples variables aleatorias

supongamos que ahora se tienen dos variables aleatorias \(X\) y \(Y\), entonces, se define su distribución de probabilidad conjunta (joint pdf) como

sí y sólo si \(X\) y \(Y\) son independientes

supongamos que ahora se tienen dos variables aleatorias \(X\) y \(Y\), entonces, se define su distribución de probabilidad conjunta (joint pdf) como

Múltiples variables aleatorias

Probabilidad conjunta

toda probabilidad conjunta puede descomponerse en el producto de una probabilidad condicional con una probabilidad marginal

Probabilidad conjunta

toda probabilidad conjunta puede descomponerse en el producto de una probabilidad condicional con una probabilidad marginal

Distribución marginal

corresponde a la probabilidad que una variable tome cierto valor, independiente del valor de la(s) restante(s)

(distribución) marginal de \(X\)

distribución conjunta

Distribución marginal

(distribución) marginal de \(Y\)

Probabilidad condicional y Bayes

la descomposición de la probabilidad conjunta nos permite llegar a la regla de Bayes

Probabilidad condicional y Bayes

la descomposición de la probabilidad conjunta nos permite llegar a la regla de Bayes

esta regla nos presenta una manera de actualizar el grado de creencia sobre un evento o hipótesis, dada nueva evidencia (data)

Probabilidad condicional y Bayes

la descomposición de la probabilidad conjunta nos permite llegar a la regla de Bayes

prior: grado de creencia sobre la hipótesis antes de considerar la evidencia (u observar la data)

Probabilidad condicional y Bayes

la descomposición de la probabilidad conjunta nos permite llegar a la regla de Bayes

likelihood: probabilidad que observar la evidencia (o data), dada la hipótesis

Probabilidad condicional y Bayes

la descomposición de la probabilidad conjunta nos permite llegar a la regla de Bayes

marginal likelihood: probabilidad de observar la evidencia (o data), bajo cualquier hipótesis

Probabilidad condicional y Bayes

la descomposición de la probabilidad conjunta nos permite llegar a la regla de Bayes

posterior: grado de creencia sobre la hipótesis, actualizado luego de considerar la evidencia (u observar la data)

Ejemplo: regla de Bayes

\(X:\) tasas de café al día

\(Y:\) horas de productividad

| X / Y | 0 (horas) | 1 (horas) | 2 (horas) |

| 0 (tazas) | 0.15 | 0.10 | 0.05 |

| 1 (tazas) | 0.10 | 0.15 | 0.05 |

| 2 (tazas) | 0.05 | 0.10 | 0.25 |

Ejemplo: regla de Bayes

- ¿Marginales?

- Partiendo de la probabilidad conjunta, ¿Cuál es la probabilidad que haya tomado 2 tazas de café si logré 2 horas de productividad?

- Empleando la respuesta anterior, ¿Cuál es la probabilidad que sea productivo durante 2 horas si tomé dos tazas de café?

Medidas, momentos y valor esperado

Medidas, momentos y valor esperado

Medidas, momentos y valor esperado

La media y la varianza describen a las distribuciones normales, sin embargo, resulta que forman parte de un conjunto de medidas que aplica a cualquier tipo de distribución.

La mayoría requiere de la noción general de valor esperado para calcularse.

valor esperado (promedio ponderado)

covarianza

correlación

varianza

media

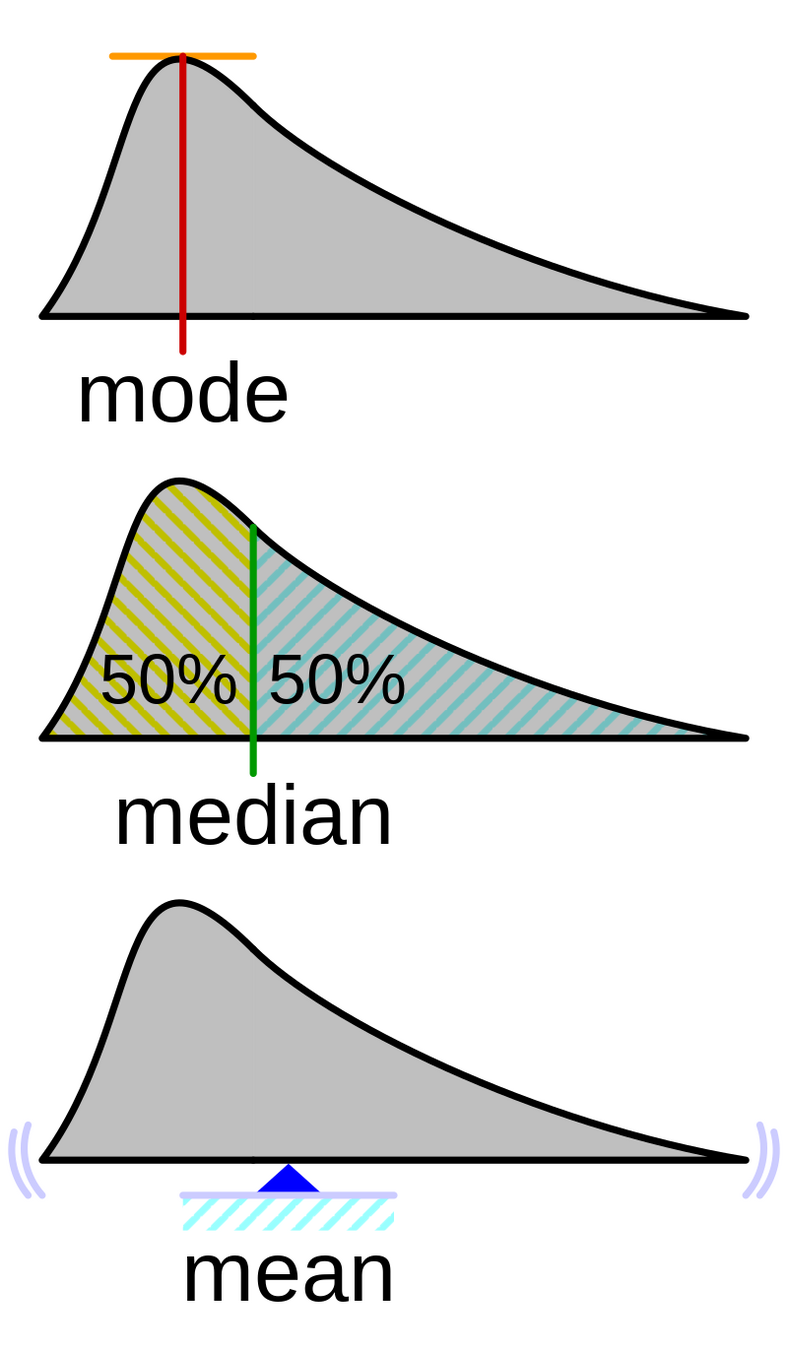

Otras medidas

estas reciben el nombre de medidas de tendencia central

Varianza vs covarianza

>> mt3006_clase9_gaussianas.m

mientras la varianza es una medida de dispersión, la covarianza (y correlación) es una medida que representa la relación lineal entre las variables aleatorias, es decir, en qué medida el cambio de una está relacionado con el de la otra

Vectores de variables aleatorias

para evitar la confusión con matrices, emplearemos una notación distinta para vectores de variables aleatorias, por ejemplo, para el caso con \(\mathbf{x}\in\mathbb{R}^n\)

adicionalmente, las varianzas y covarianzas se combinan en un único objeto denominado matriz de covarianza

varianzas en la diagonal y covarianzas fuera de la diagonal

Vectores de variables aleatorias

Ejemplo: Gaussiana de 3 dimensiones

Ejemplo: Gaussiana de 3 dimensiones

Ejemplo: Gaussiana de 3 dimensiones

varianzas y el resto son covarianzas

Ejemplo: Gaussiana de 3 dimensiones

Procesos estocásticos

proceso estocástico \(x(t)\) \(\approx\) generador de variables aleatorias en el tiempo

proceso estocástico \(x(t)\) \(\approx\) generador de variables aleatorias en el tiempo

proceso estocástico \(x(t)\) \(\approx\) generador de variables aleatorias en el tiempo

demasiado complicado, quisiéramos que las variables salgan del mismo tipo de distribución con por lo menos la misma media

antes de simplificar necesitamos definir

auto-correlación

auto-covarianza

Procesos WSS

un proceso estocástico es (weak o) wide-sense stationary si cumple con

Procesos WSS

un proceso estocástico es (weak o) wide-sense stationary si cumple con

Nota: el procesamiento de señales estocásticas usa la auto-correlación como la señal de tiempo y aplica (casi) los mismos métodos. Por ejemplo:

Power Spectral Density (PSD)

Ejemplo: ruido blanco

ruido Gaussiano no correlacionado

Ejemplo: ruido blanco

ruido Gaussiano no correlacionado

conocer algo del proceso en el tiempo \(t_1\) no nos dice nada sobre el proceso en el tiempo \(t_2\)

>> mt3006_clase9_ruidoblanco.m

MT3006 - Lecture 9 (2024)

By Miguel Enrique Zea Arenales

MT3006 - Lecture 9 (2024)

- 114