Zastosowanie systemów wieloklasyfikatorowych

do diagnozowania białaczki u dzieci

Michał Bieroński

prof. dr hab. inż. Marek Kurzyński

Agenda

- Cel pracy

- Multiklasyfikatory

- Implementacja

- Badania

- Podsumowanie

Cel pracy

- Optymalizacja jakości klasyfikacji

- Uzyskanie zadowalających wyników klasyfikacji

- Porównanie algorytmów wieloklasyfikatorowych

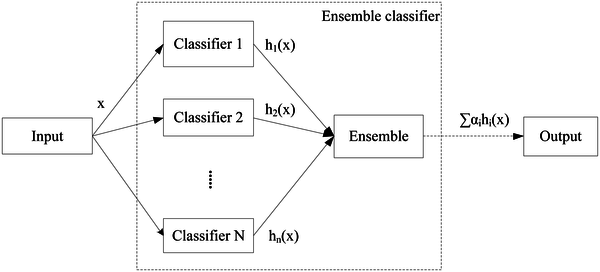

Multiklasyfikatory

Implementacja

Badania

głosowania

- S - SVC (Maszyna wektorów nośnych)

- K - KNN (K-najbliższych sąsiadów)

- L - LogisticRegression (Regresja logistyczna)

- G - GaussianNB (Naiwny Bayes)

- D - DecissionTree (Drzewo decyzyjne)

- M - MLP (Wielowarstwowy perceptrom)

- Tendencyjna przewaga głosowania ważonego

- Najlepszy wynik ważonego: 41.7%

- Najlepszy wynik nieważonego: 42.2% (komb. SLD)

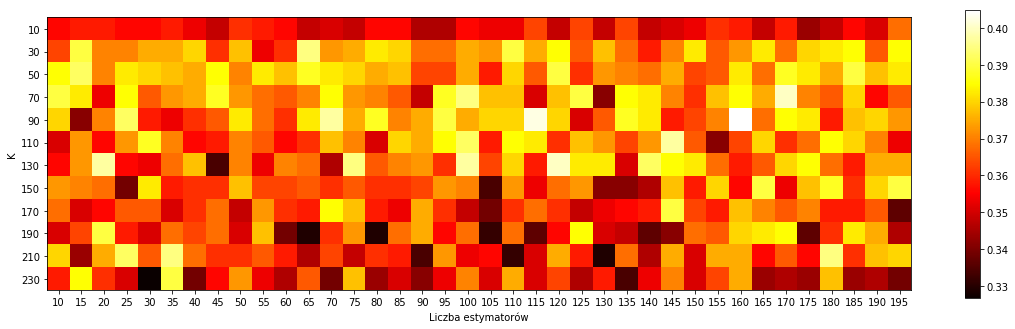

Losowy las

własna implementacja

- Najlepszy wynik 40%

- Najlepsza kombinacja: K = 90, liczba drzew = 160

- Wersja nr 2: najlepszy wynik 39.5% (liczba drzew = 30)

Losowy las

implementacja biblioteczna

- Najlepszy wynik 46%

- Najlepsza kombinacja: Maksymalna głębokość = 7, liczba drzew = 165

Badania

kombinatory elementarne

- S - SVC (Maszyna wektorów nośnych)

- K - KNN (K-najbliższych sąsiadów)

- L - LogisticRegression (Regresja logistyczna)

- G - GaussianNB (Naiwny Bayes)

- D - DecissionTree (Drzewo decyzyjne)

- M - MLP (Wielowarstwowy perceptrom)

- Tendencyjna przewaga reguły mediany

- Po medianie króluje reguła sumy

- Najlepszy wynik (suma): 41.9% (komb. SKDM)

- Najlepszy wynik (mediana): 41.7%

Badania

selekcja statyczna

- S - SVC (Maszyna wektorów nośnych)

- K - KNN (K-najbliższych sąsiadów)

- L - LogisticRegression (Regresja logistyczna)

- G - GaussianNB (Naiwny Bayes)

- D - DecissionTree (Drzewo decyzyjne)

- M - MLP (Wielowarstwowy perceptrom)

- Za dużo klastrów - słabsze wyniki

- Najlepszy wynik:

- 6 klastrów

- kombinacja SKGDM

- jakość 41%

Badania

selekcja dynamiczna

- Nieznaczny wpływ liczby sąsiadów

- Zła kombinacja niezależnie od innych parametrów daje złe wyniki

- Lepsze wyniki dla zakresów k 2-20

- Najlepszy wynik:

- liczba sąsiadów - 6

- kombinacja SKDM

- jakość 40.5%

- S - SVC (Maszyna wektorów nośnych)

- K - KNN (K-najbliższych sąsiadów)

- L - LogisticRegression (Regresja logistyczna)

- G - GaussianNB (Naiwny Bayes)

- D - DecissionTree (Drzewo decyzyjne)

- M - MLP (Wielowarstwowy perceptrom)

Podsumowanie

Podsumowanie

- Różnica pomiędzy najlepszym zwykłym a multiklasyfikatorem - 7.9%

- Różnica pomiędzy najsłabszym zwykłym a multiklasyfikatorem - 15%

- Kiedy stosować?

- inne metody zawodzą

- stabilizacja niestabilnych model (drzewa, sieci)

- uniwersalny model

Enseble2

By bierus

Enseble2

- 408