Data? AI Workloads!

By Johann-Peter Hartmann

Data? AI Workloads!

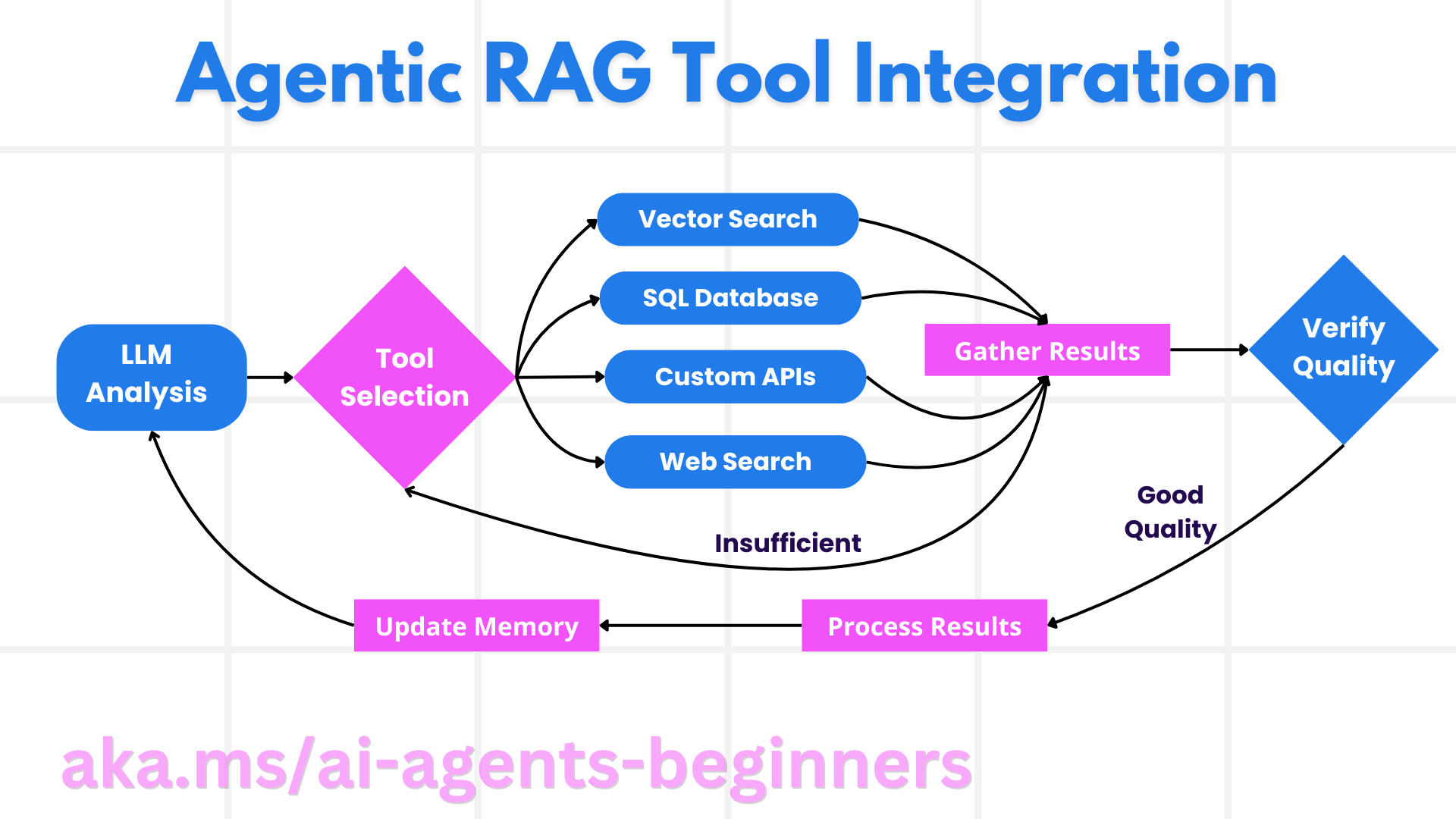

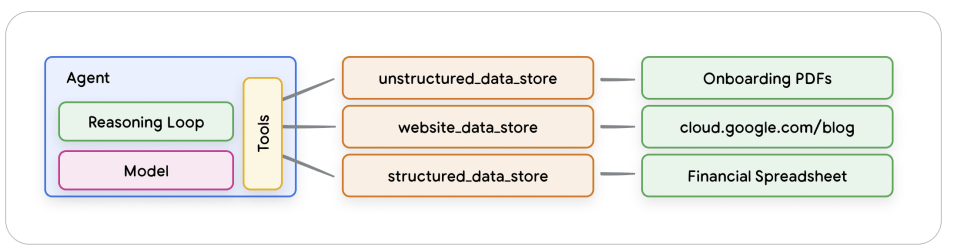

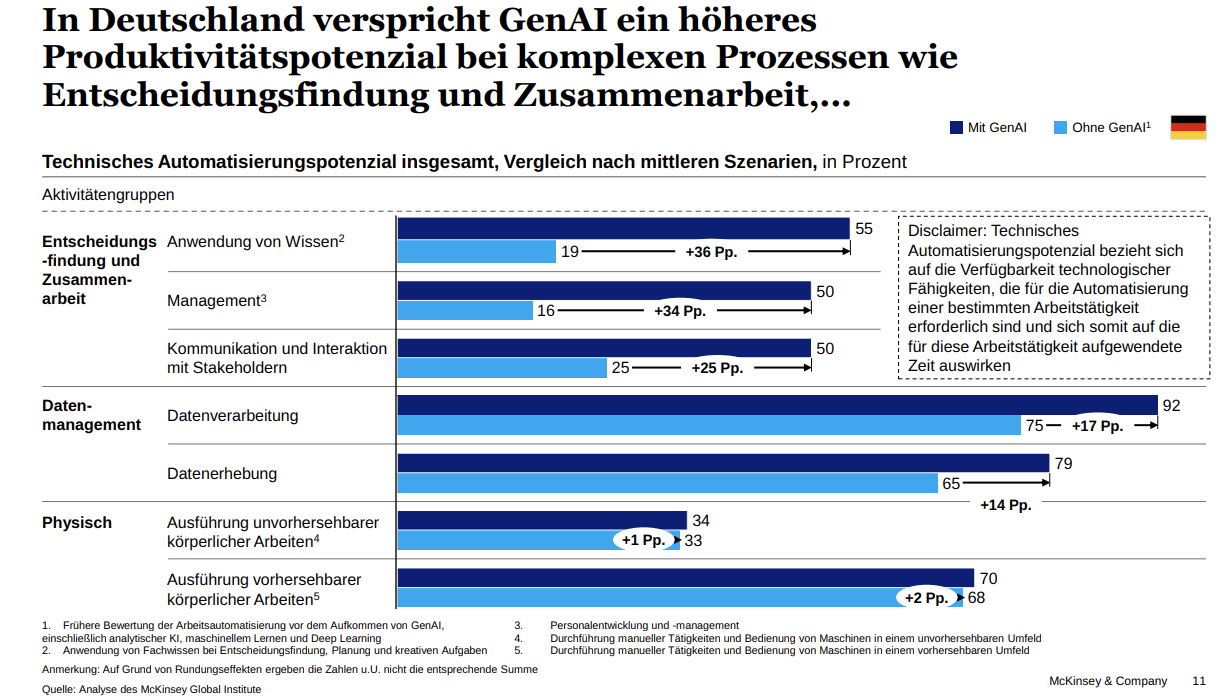

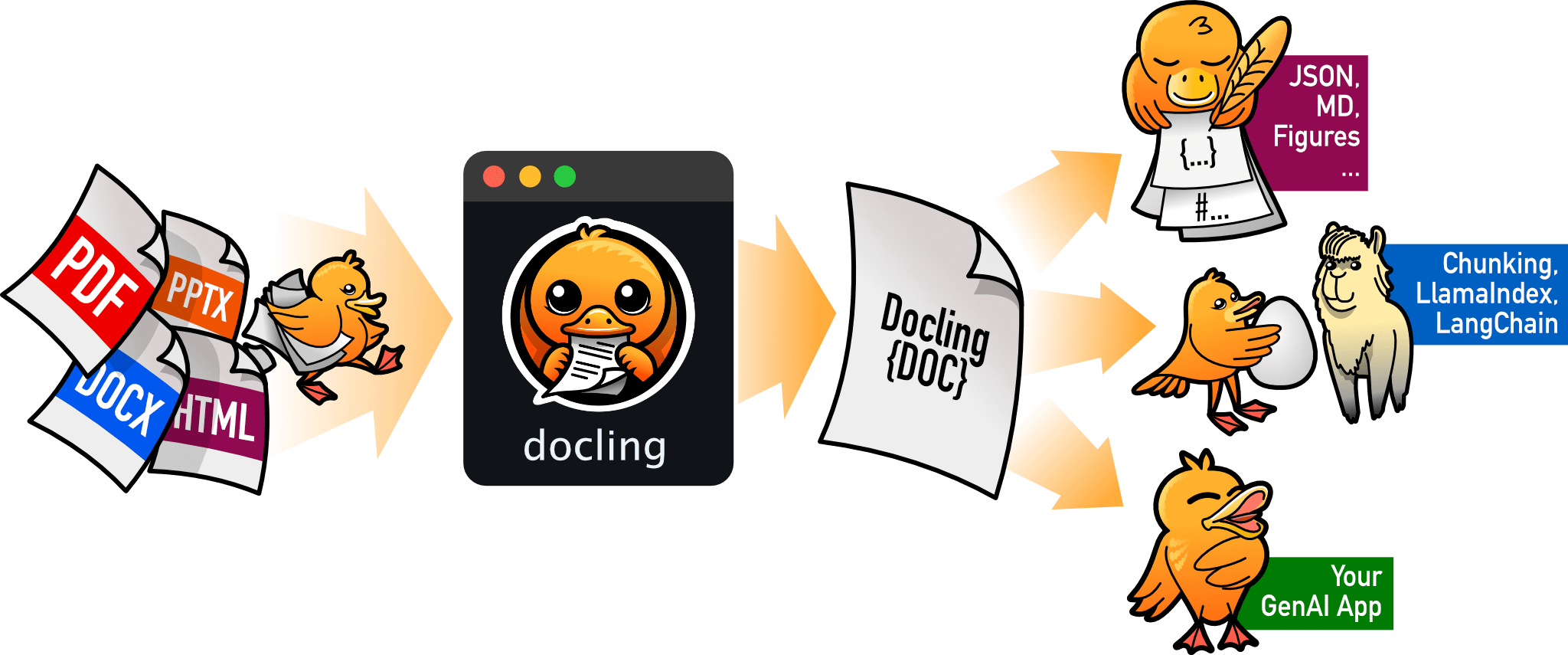

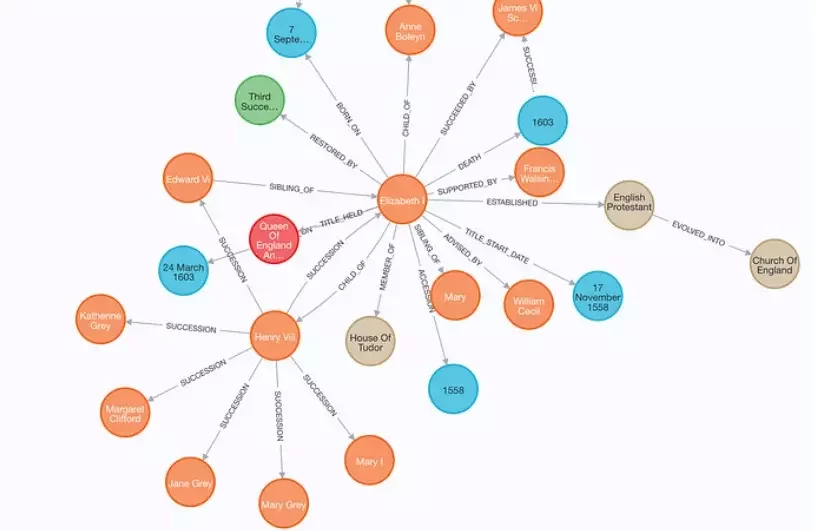

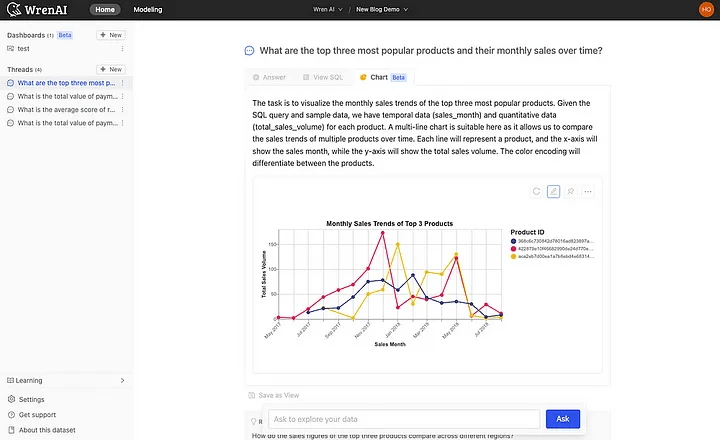

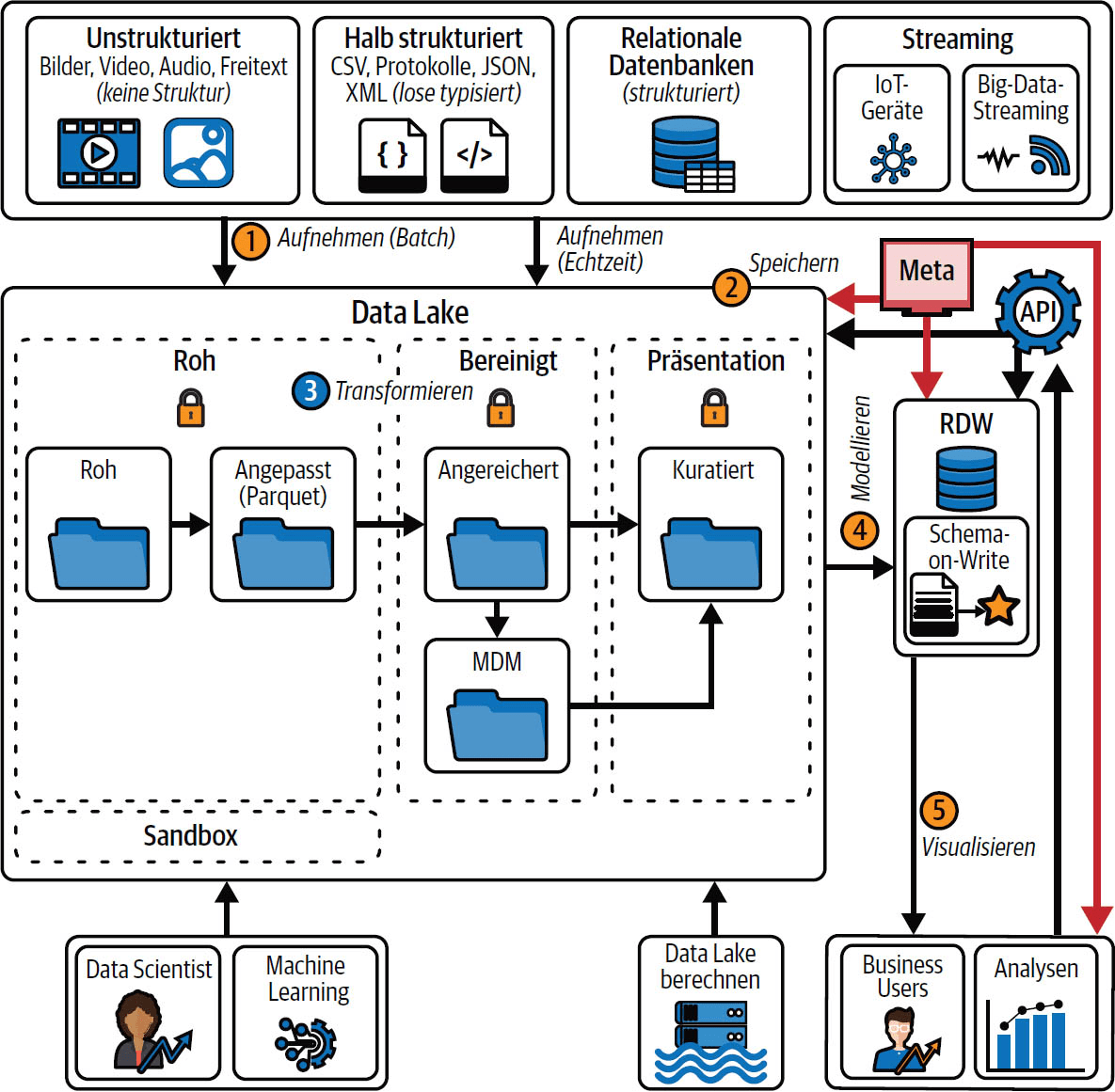

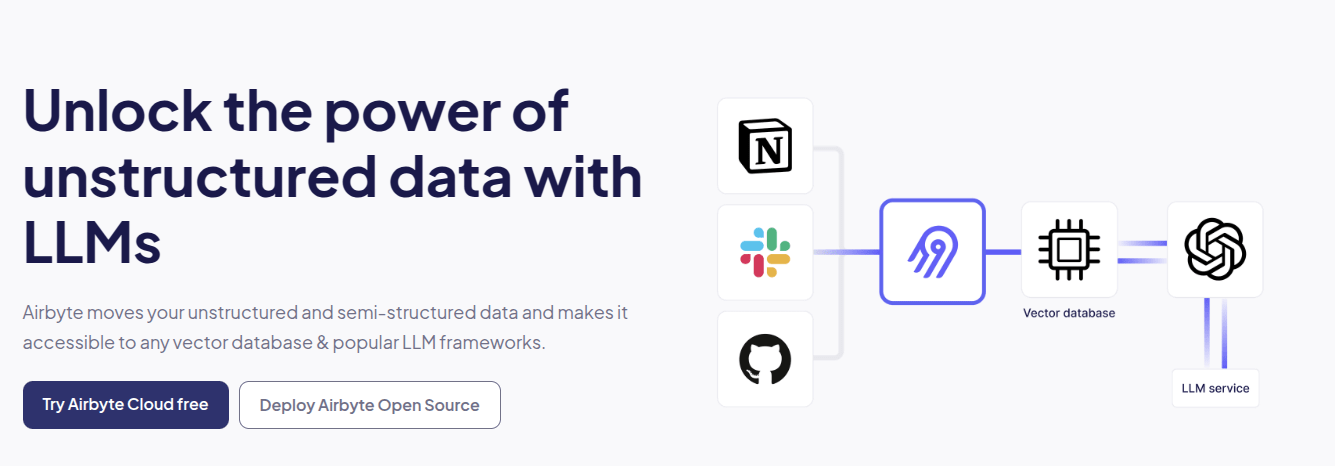

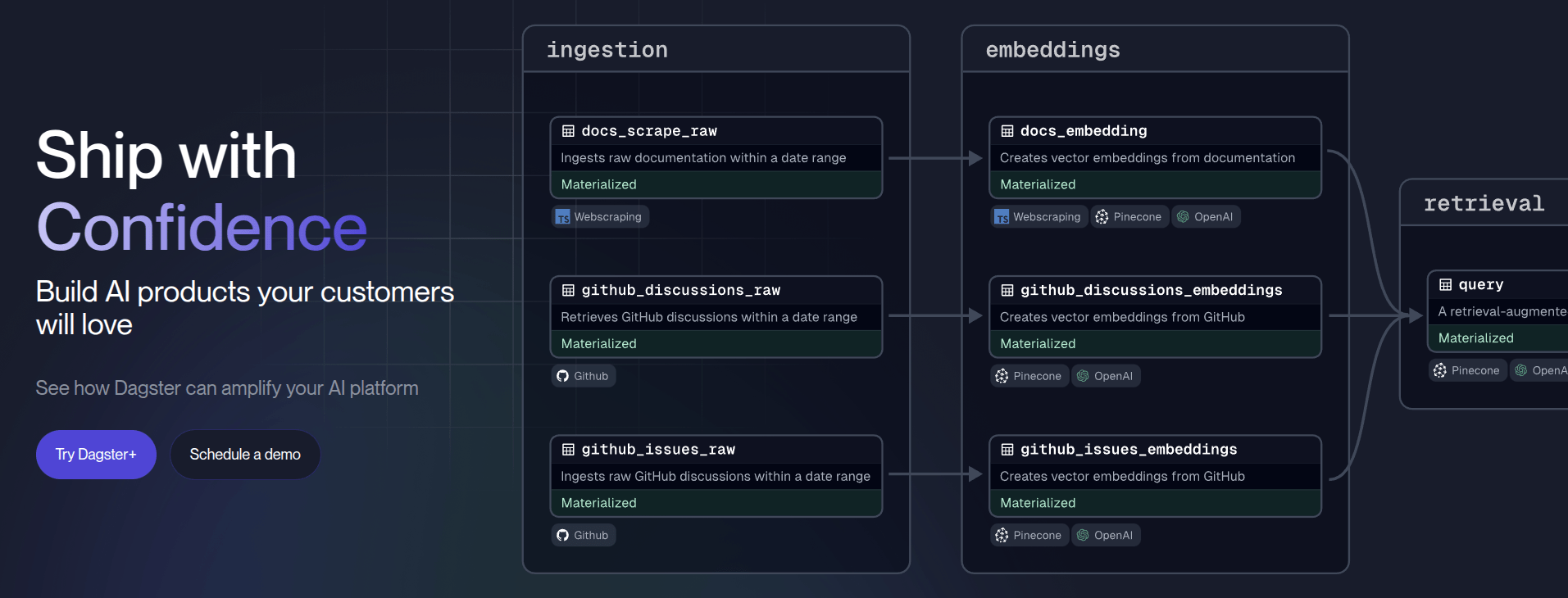

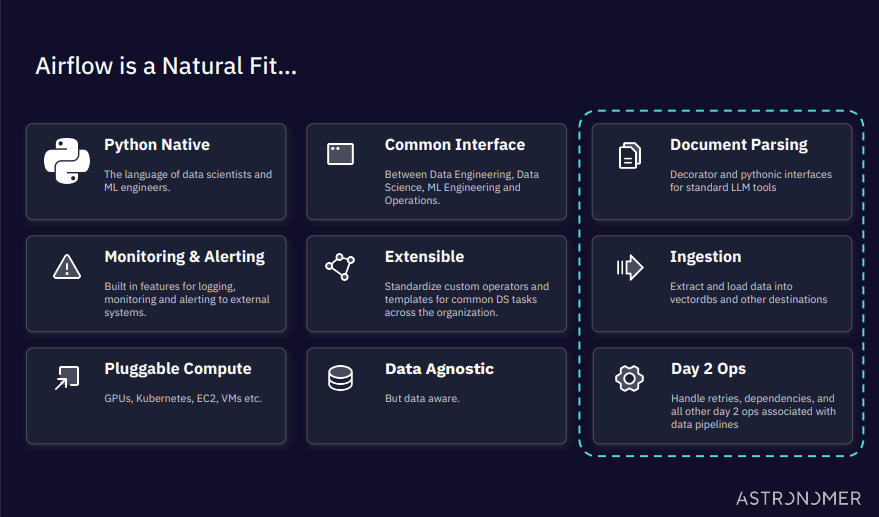

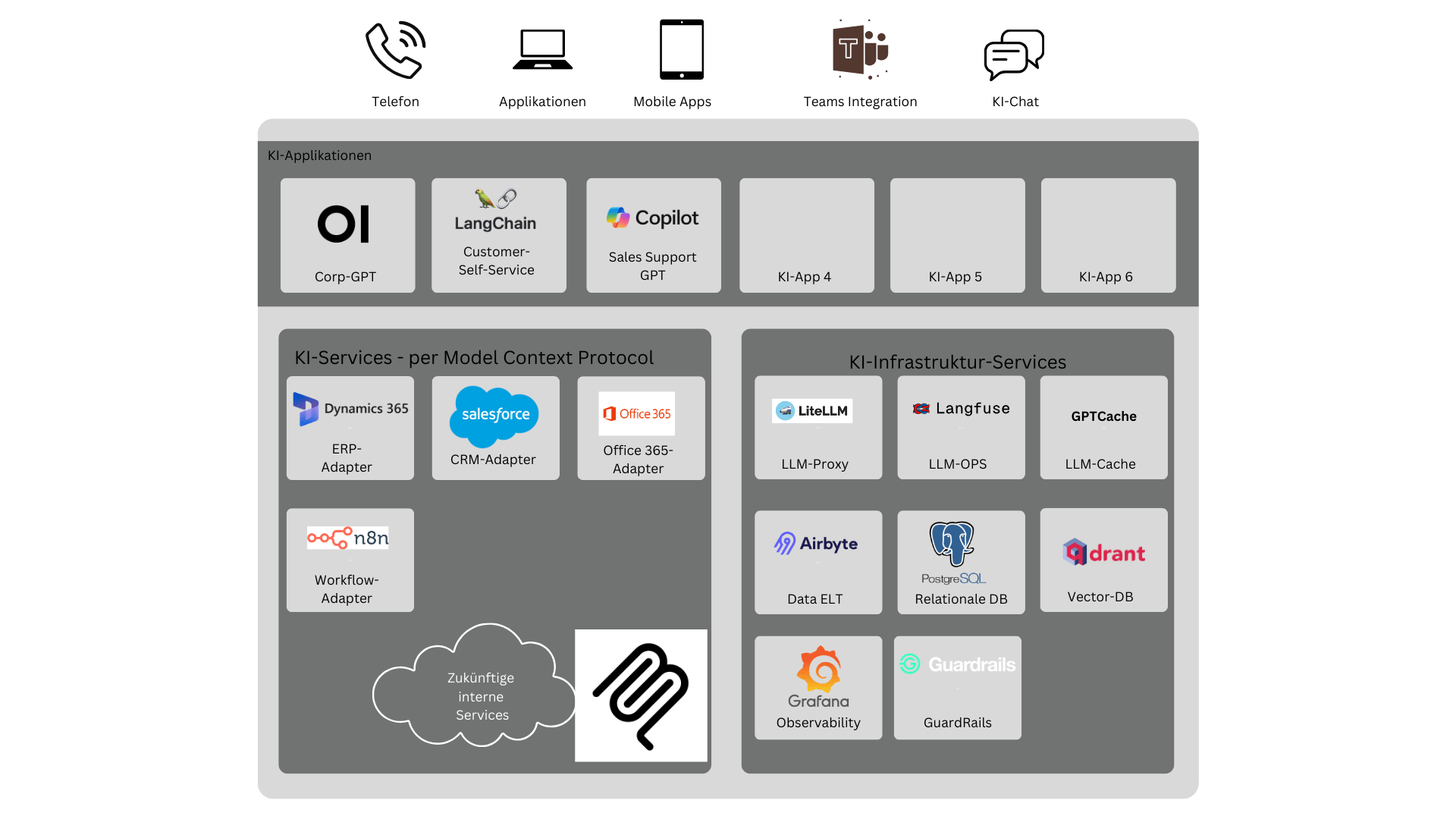

Im Agentic Age wird Nachholbedarf bei der Digitalisierung deutlich teurer, weil Automatisierung mittels KI nur dort stattfinden kann, wo Daten, Dokumente und Schnittstellen auch digital zur Verfügung stehen. Glücklicherweise unterstützt AI auch an dieser Stelle - die Integration Document Intelligence scheitert nicht mehr an OCR, sondern ist ein gelöstes Problem, und die Bereitstellung von AI-Schnittstellen über das Model Context Protocol erzeugt oft nur einen kleinen Aufwand. Und sogar die Verfügbarkeit von Daten über Datalakes, Data-Lakehouses bis zu Data Meshes ist nicht nur Voraussetzung für KI, sondern profitiert auch selbst von der neuen Technologie.