Занятие №2:

Введение в обучение с подкреплением

Основные понятия

Обучение с подкреплением

Определение

Обучение с подкреплением - это подход к решению различных задач путем создания агентов, которые учатся у окружающей среды, взаимодействуя с ней методом проб и ошибок и получая вознаграждения (положительные или отрицательные) в виде уникальной обратной связи.

Пример

Еще примеры

-

Мастер-шахматист;

-

Адаптивный контроллер;

-

Детеныш газели;

-

Подвижный робот;

-

Торговая система или трейдер;

-

Дофаминовая система;

-

Компьютерные игры;

-

Дрессировка собак;

-

Автомобиль с автопилотом.

Принцип работы

Окружение

Действие

At

Агент

Награда

Rt

Состояние

St

Принцип работы

Агент;

Стратегия;

Вознаграждение;

Функция ценности;

Наблюдение и состояние среды;

Окружающая среда.

Вознаграждение

-

Финансовая торговля: сумма прибыли - это награда для трейдера, покупающего и продающего акции;

-

Шахматы: награда за победу, поражение или ничью в конце игры;

-

Дофаминовая система в головном мозге: есть часть мозга (лимбическая система), которая производит дофамин каждый раз, когда ему нужно послать положительный сигнал остальной части мозга;

-

Дрессировка собак: если вы когда-либо пытались дрессировать собаку, вы знаете, что вам нужно давать ей что-нибудь вкусное (но не слишком много) каждый раз, когда она делает то, о чем вы просили.

Вознаграждение

Состояние среды

-

Состояние – полное описание состояния мира (нет скрытой информации). В полностью наблюдаемой среде. При игре в шахматы мы находимся в полностью наблюдаемой среде, поскольку у нас есть доступ ко всей информации на шахматной доске;

-

Наблюдение - частичное описание состояния. В Super Mario или другой похожей игре мы находимся в частично наблюдаемой среде, мы получаем наблюдение, поскольку видим только часть уровня.

Основная мысль

Требуется уловить наиболее важные аспекты реальной проблемы, стоящей перед обучающимся агентом, который взаимодействует во времени с окружающей средой для достижения некоторой цели. Обучающийся агент должен уметь в какой-то степени воспринимать состояние среды и предпринимать действия, изменяющие это состояние. У агента также должна быть цель или несколько целей, как-то связанных с состоянием окружающей среды.

Подводные камни

-

Проблема исследования-использования;

-

Слишком много исследований;

-

Задержка вознаграждения.

Цепи Маркова

| Солнечно | Пасмурно | |

|---|---|---|

| Солнечно | 0.8 | 0.2 |

| Пасмурно | 0.1 | 0.9 |

Солнечно

Пасмурно

0.1

0.2

0.9

0.8

Цепи Маркова

Разговор

Компьютер

Кофе

Дом

0.1

0.3

0.5

0.2

0.6

0.4

0.2

0.2

0.1

0.7

0.2

0.5

Марковские процессы вознаграждения

Марковские процессы вознаграждения

Разговор

Компьютер

Кофе

Дом

0.1

0.3

0.5

0.2

0.6

0.4

0.2

0.2

0.1

0.7

0.2

0.5

5

1

2

1

1

3

1

2

1

-1

2

-3

Добавление действий

Целевое состояние

Исходное

состояние

Вероятность перехода из i в j

Вероятность перехода из i в j при действии k

Действие

Целевое состояние

Исходное

состояние

МППР

Добавление действий

0

1

2

0

1

2

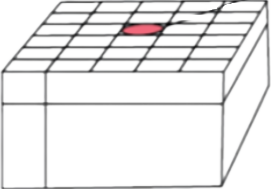

Робот в ячейке (1,1)

0.1

0.1

0.9

0.9

0.9

0.1

Влево

Вправо

Вперед

(1,0)

(1,1)

(1,2)

(0,1)

Часть схемы переходов роботов

Политика

Политика - некоторый набор правил, контролирующих поведение агента.

Спасибо за понимание!

(ШИЛИ) Лекция №2. Введение в обучение с подкреплением

By Protectornaldo

(ШИЛИ) Лекция №2. Введение в обучение с подкреплением

- 120