Оценка неопределенности предсказания нейросетей байесовскими методами

По мотивам работ Yarin Gal & Zoubin Ghahramani

План доклада

-

История байесовских нейросетей

-

Байесовская регрессия

-

Kernel ridge regression

-

Гауссовы процессы

-

Вариационный вывод и ELBO, стохастический вариационный вывод

-

Библиотека вероятностного программирования Uber Pyro

-

Регуляризация нейросетей, бинарный и гауссовский дропаут

-

Вариационный дропаут

История байесовских нейросетей

- John Denker & John Hopfield, 1987

- Naftali Tishby, Esther Levin, Sara Solla, 1989

- John Denker & Yann LeCun, 1991

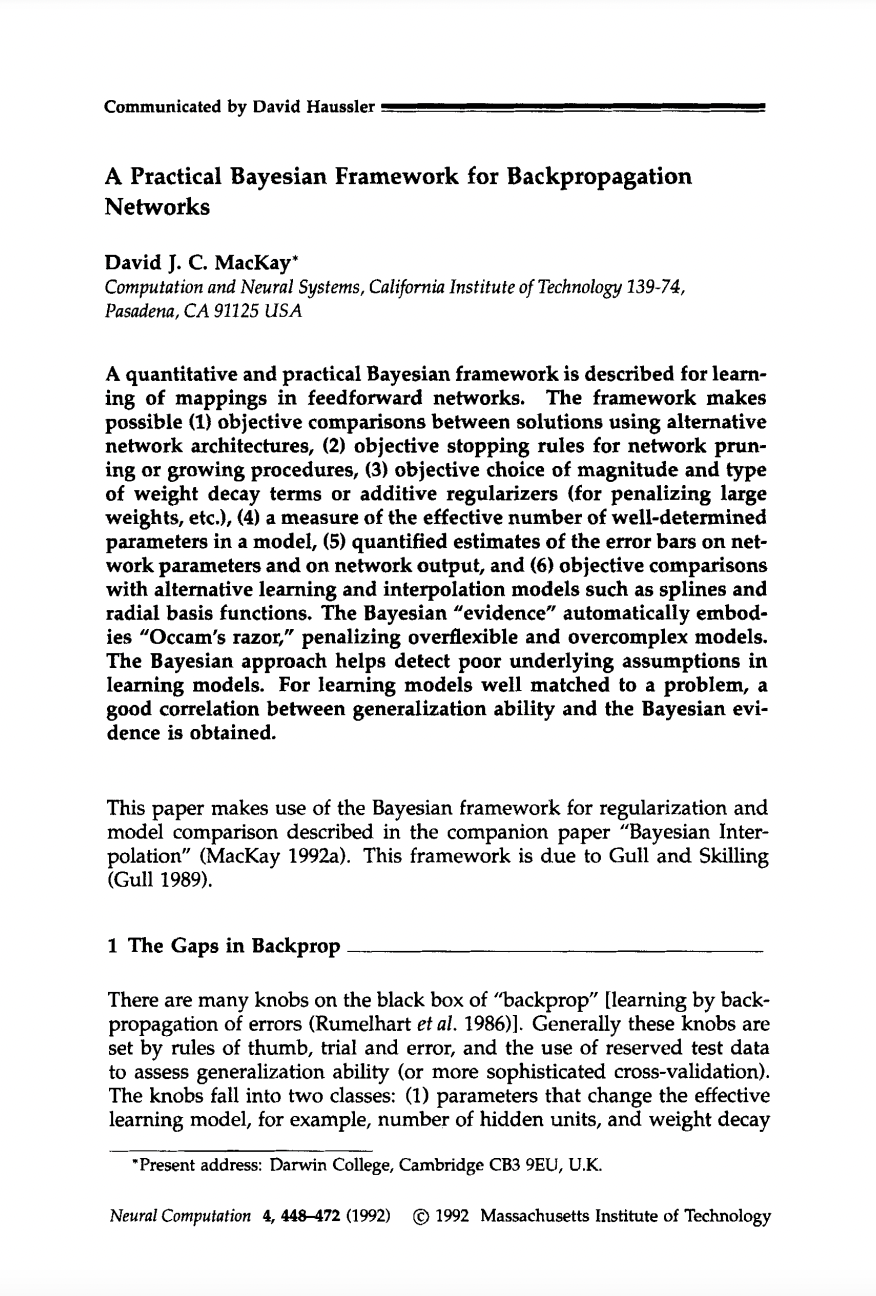

- David MacKay, 1992

- Radford Neal, 1993

- Christopher K.I. Williams 1996

История байесовских нейросетей

David MacKay

История байесовских нейросетей

Radford Neal

- BNN with infinite latent layer = gaussian process

- Automatic relevance determination

- Hamiltonian Monte Carlo

Ссылки:

-

Доклад Зубина Гарамани на NIPS 2016: https://www.youtube.com/watch?v=FD8l2vPU5FY

-

Доклад Ярина Гала в Microsoft Research: https://www.youtube.com/watch?v=YAb5C5_g-kk

-

Блог-диссертация Ярина Гала: http://mlg.eng.cam.ac.uk/yarin/blog_3d801aa532c1ce.html

-

Современное положение дел в области: https://wjmaddox.github.io/assets/BNN_tutorial_CILVR.pdf

История байесовских нейросетей

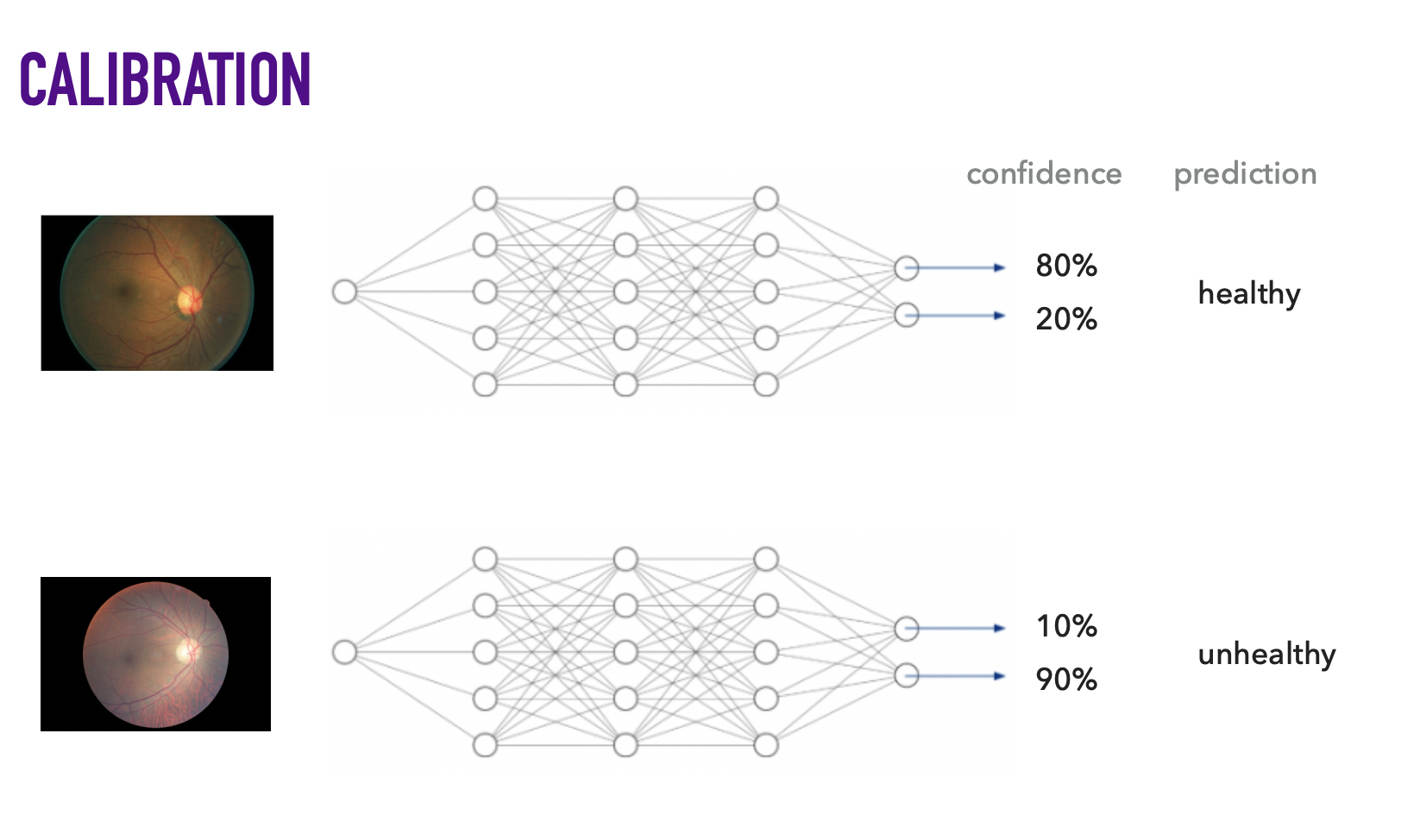

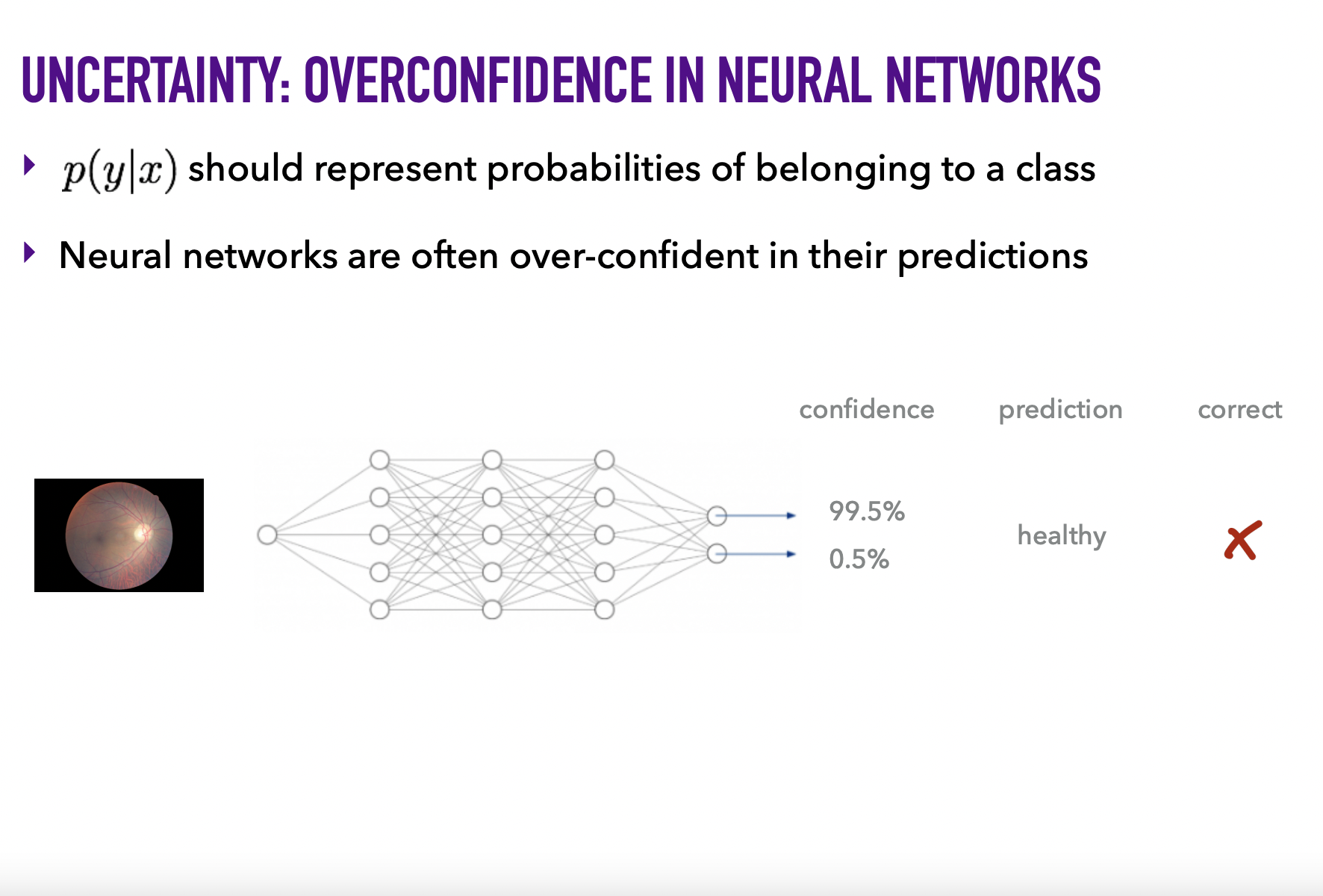

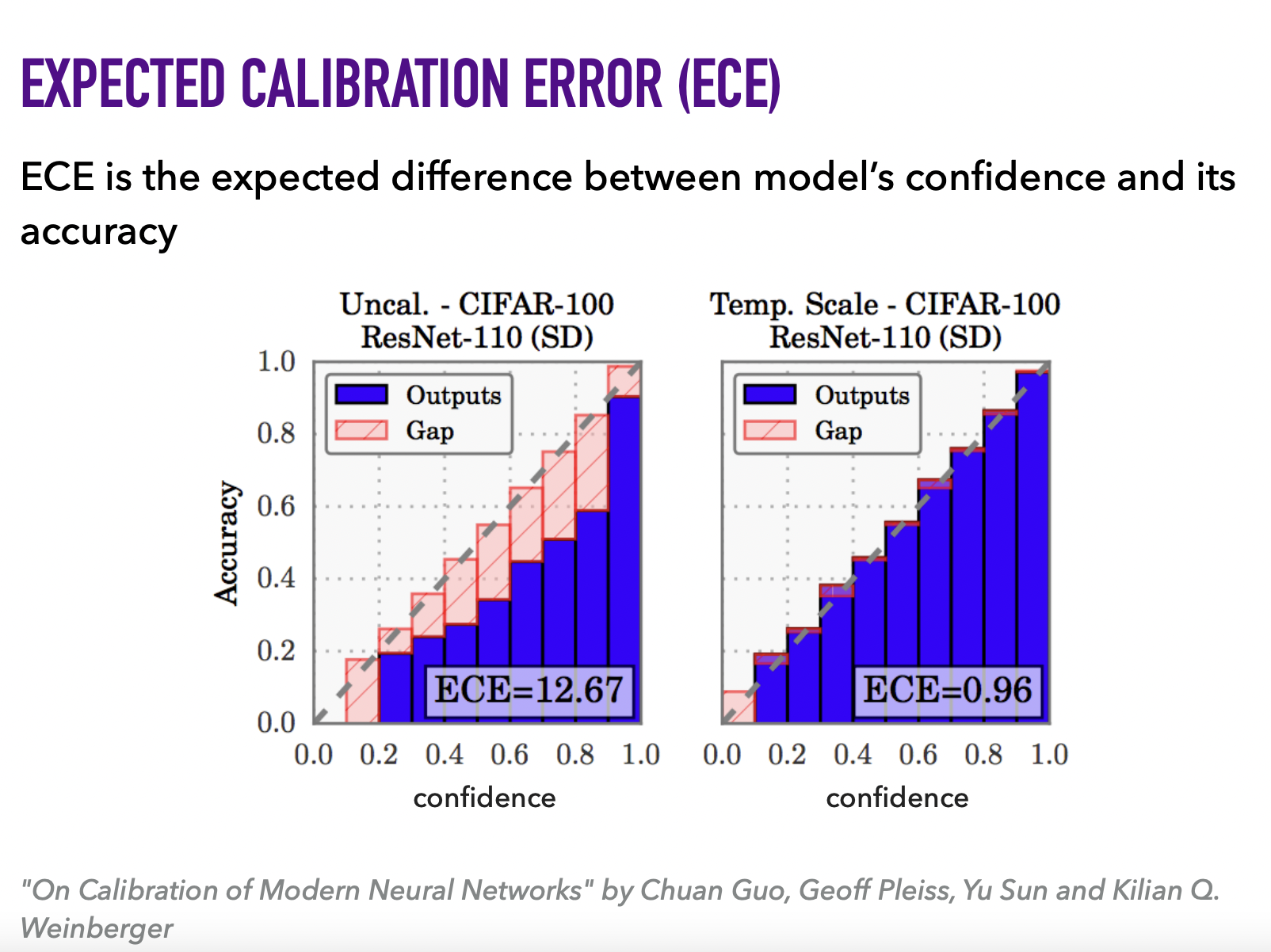

Предостережение: опасно рассматривать число от 0 до 1, возвращаемое predict_proba(), как степень уверенности модели. Нельзя просто применить сигмоиду/софтмакс/z-score и считать это вероятностью.

Пререквизиты для BNN

Z. Ghahramani, NIPS 2016: https://www.youtube.com/watch?v=FD8l2vPU5FY

План доклада

-

История байесовских нейросетей

-

Байесовская регрессия

-

Kernel ridge regression

-

Гауссовы процессы

-

Вариационный вывод и ELBO, стохастический вариационный вывод

-

Библиотека вероятностного программирования Uber Pyro

-

Регуляризация нейросетей, бинарный и гауссовский дропаут

-

Вариационный дропаут

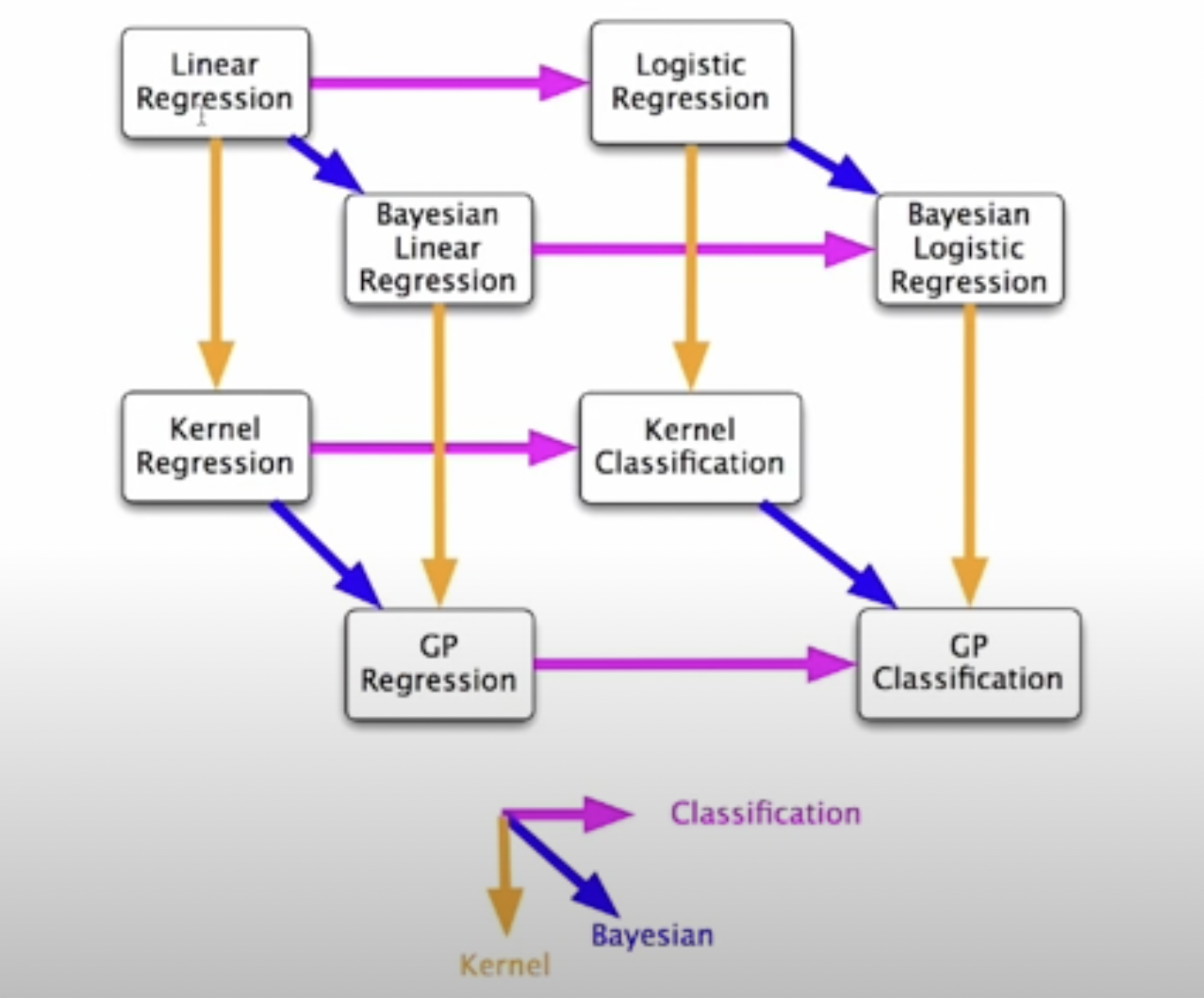

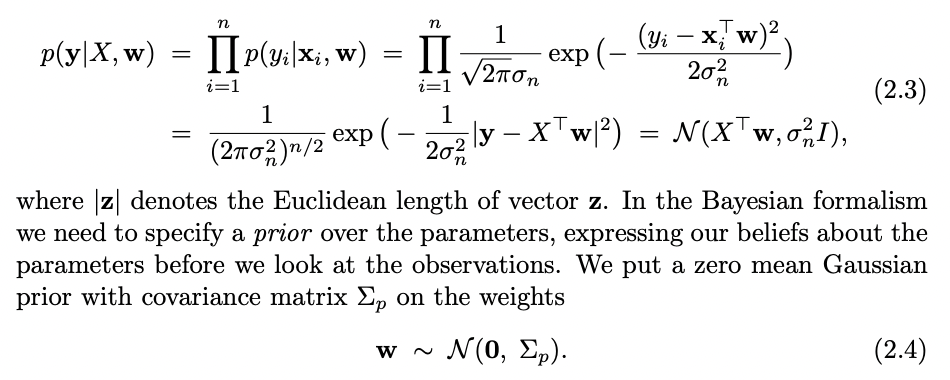

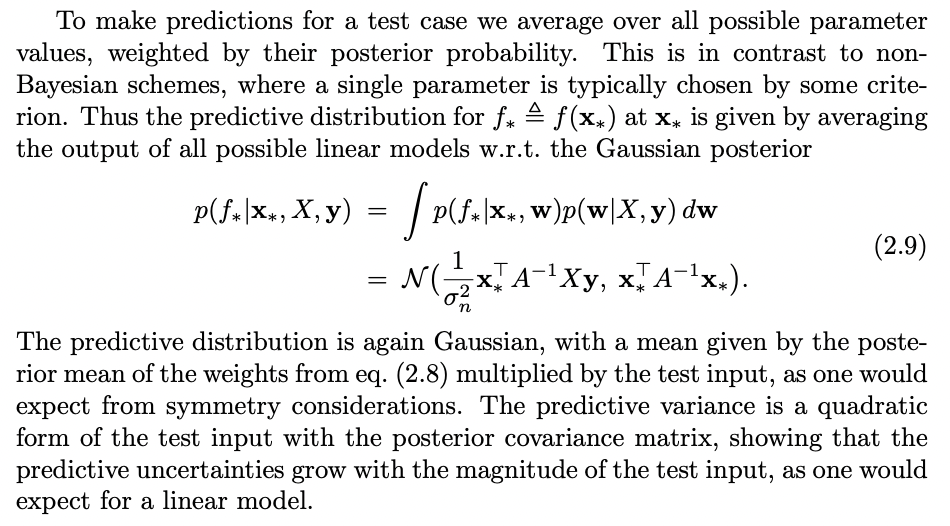

Байесовская линейная регрессия

Байесовская линейная регрессия

Из Rasmussen, Williams: Gaussian Processes (2006)

Сумму наименьших квадратов можно рассматривать как многомерное нормальное распределение.

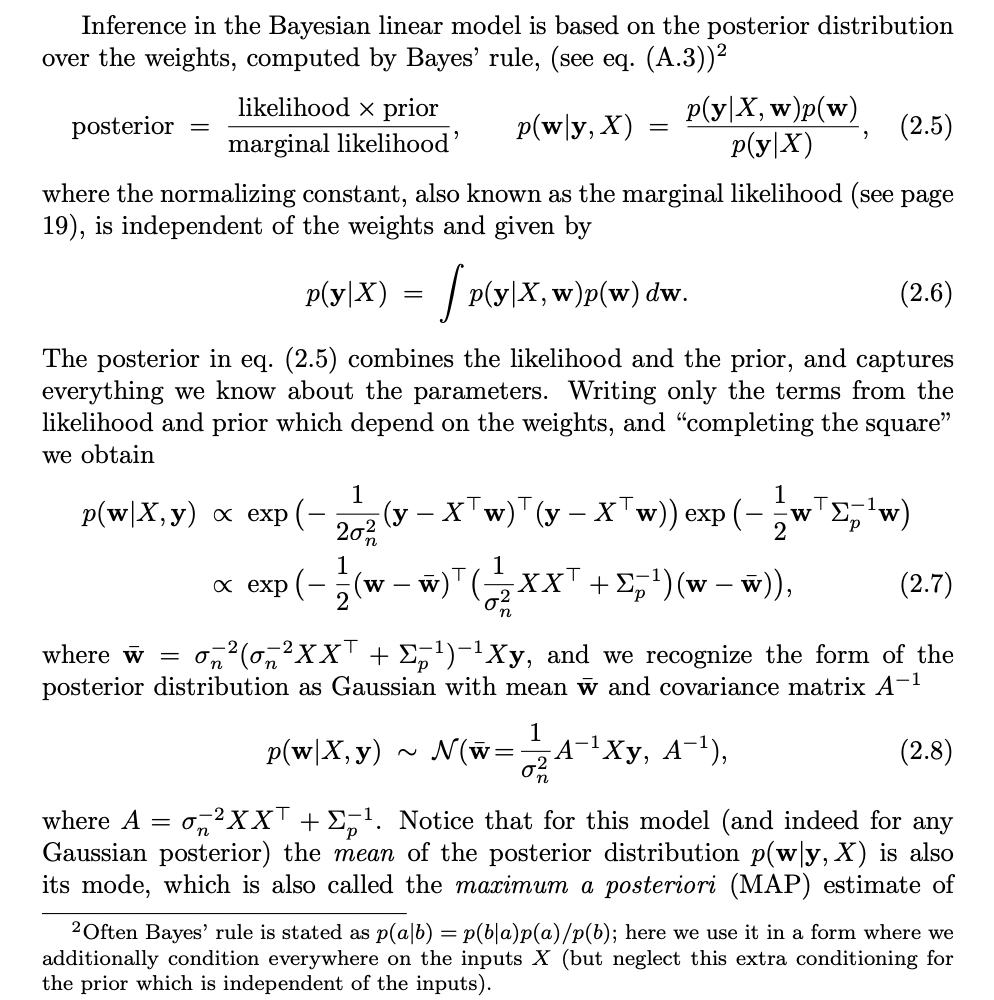

Байесовская регрессия

Из Rasmussen, Williams: Gaussian Processes (2006)

Байесовская линейная регрессия с гауссовским prior'ом эквивалентна ridge-регрессии (линейной регрессии с тихоновской l2-регуляризацией)

Байесовская регрессия

Из Rasmussen, Williams: Gaussian Processes (2006)

Байесовскую линейную регрессию можно рассматривать как ансамбль моделей, по предсказаниям которого мы берем взвешенное среднее.

План доклада

История байесовских нейросетей

Байесовская регрессия

Kernel ridge regression

Гауссовы процессы

Вариационный вывод и ELBO, стохастический вариационный вывод

Библиотека вероятностного программирования Uber Pyro

Регуляризация нейросетей, бинарный и гауссовский дропаут

Вариационный дропаут

Kernel ridge regression

Осторожно: не путайте kernel ridge regression c kernel regression (например, вычисляемый с помощью Nadaraya-Watson estimator, это другой метод):

Kernel ridge regression

Что делать, если нам нужно смоделировать нелинейную зависимость целевой переменной от независимых переменных?

Можно сделать ту же самую линейную регрессию с регуляризацией, только в качестве факторов использовать полиномы от независимой переменной:

Kernel ridge regression

Из Rasmussen, Williams: Gaussian Processes (2006)

Kernel ridge regression

План доклада

-

История байесовских нейросетей

-

Байесовская регрессия

-

Kernel ridge regression

-

Гауссовы процессы

-

Вариационный вывод и ELBO, стохастический вариационный вывод

-

Библиотека вероятностного программирования Uber Pyro

-

Регуляризация нейросетей, бинарный и гауссовский дропаут

-

Вариационный дропаут

Гауссовы процессы

Переход от многомерного нормального распределения как в байесовской линейной регрессии к бесконечномерному вектору - функции.

Гауссовы процессы

Гауссовы процессы

Ссылки:

- C.Williams, K.Rasmussen - Gaussian processes:

http://www.gaussianprocess.org/gpml/chapters/ - R.Neal - thesis

- C.Williams - computing with infinite networks: https://proceedings.neurips.cc/paper/1996/file/ae5e3ce40e0404a45ecacaaf05e5f735-Paper.pdf

- Visual exploration of Gaussian processes: https://distill.pub/2019/visual-exploration-gaussian-processes/

- https://peterroelants.github.io/posts/gaussian-process-tutorial/

- Neil Lawrence: http://inverseprobability.com/talks/notes/gaussian-processes.html

План доклада

-

История байесовских нейросетей

-

Байесовская регрессия

-

Kernel ridge regression

-

Гауссовы процессы

-

Вариационный вывод и ELBO, стохастический вариационный вывод

-

Библиотека вероятностного программирования Uber Pyro

-

Регуляризация нейросетей, бинарный и гауссовский дропаут

-

Вариационный дропаут

Вариационный вывод

likelihood

prior

posterior

evidence

Задача: вычислить posterior.

Препятствие: проблема обычно состоит в том, что evidence is intractable.

- не вычисляемо

Вариационный вывод

Вариационный вывод

ELBO

ELBO - Evidence lower bound

ELBO

Expected log-likelihood

Regulariser term

KL-divergence

Стохастический вариационный вывод

Литература:

- Тьюториал David Blei: https://arxiv.org/pdf/1601.00670.pdf - через Natural gradient descent - обеспечивает равное убывание KL divergence по всем направлениям движения, основан на Fisher information matrix (см. https://towardsdatascience.com/natural-gradient-ce454b3dcdfa)

- Статья Kingma, Welling по VAE: https://arxiv.org/pdf/1312.6114.pdf

- Лекция Дмитрия Ветрова по VI и ELBO: https://www.youtube.com/watch?v=xH1mBw3tb_c

- Лекция Дмитрия Ветрова по SVI и VAE: https://www.youtube.com/watch?v=tjT4Wf86FMM

План доклада

-

История байесовских нейросетей

-

Байесовская регрессия

-

Kernel ridge regression

-

Гауссовы процессы

-

Вариационный вывод и ELBO, стохастический вариационный вывод

-

Библиотека вероятностного программирования Uber Pyro

-

Регуляризация нейросетей, бинарный и гауссовский дропаут

-

Вариационный дропаут

Uber Pyro

Uber Pyro

Uber Pyro

VAE SVI in Pyro

ScanVI in Pyro

План доклада

-

История байесовских нейросетей

-

Байесовская регрессия

-

Kernel ridge regression

-

Гауссовы процессы

-

Вариационный вывод и ELBO, стохастический вариационный вывод

-

Библиотека вероятностного программирования Uber Pyro

-

Регуляризация нейросетей, бинарный и гауссовский дропаут

-

Вариационный дропаут

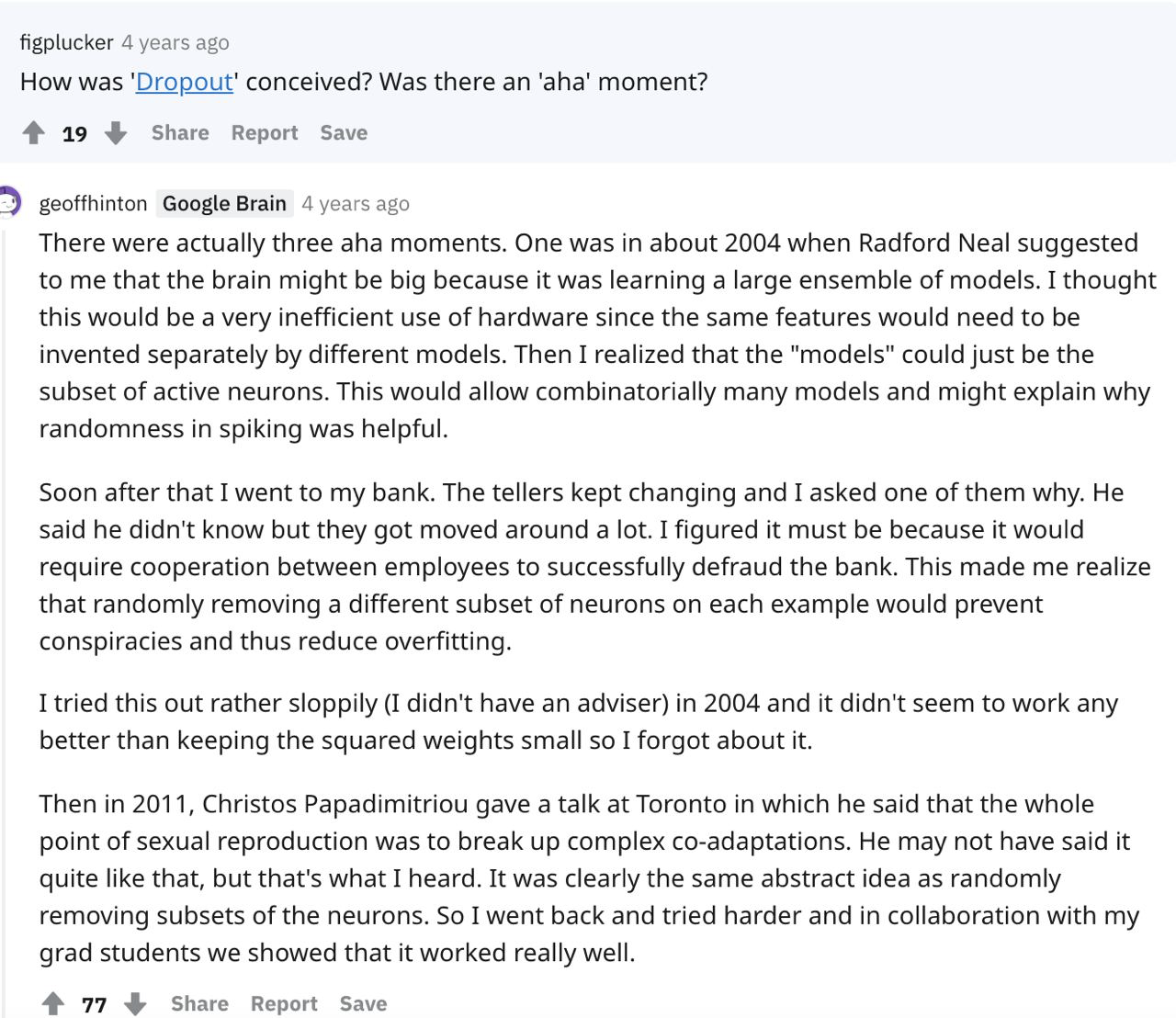

Дропаут как регуляризация нейронных сетей

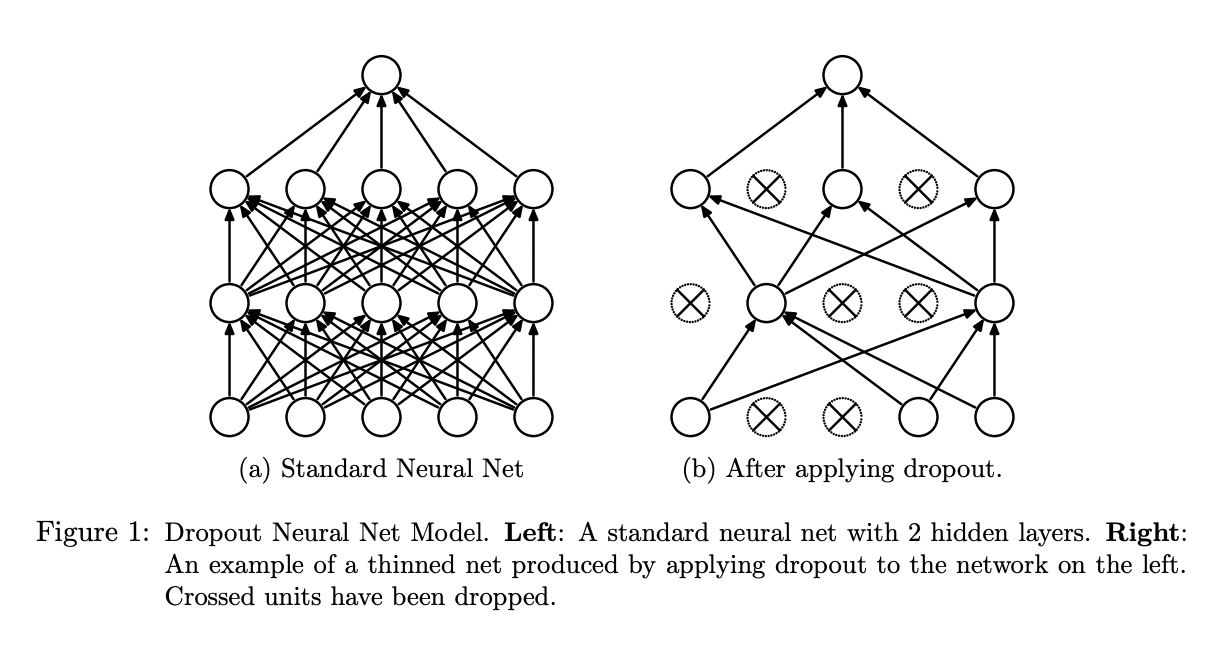

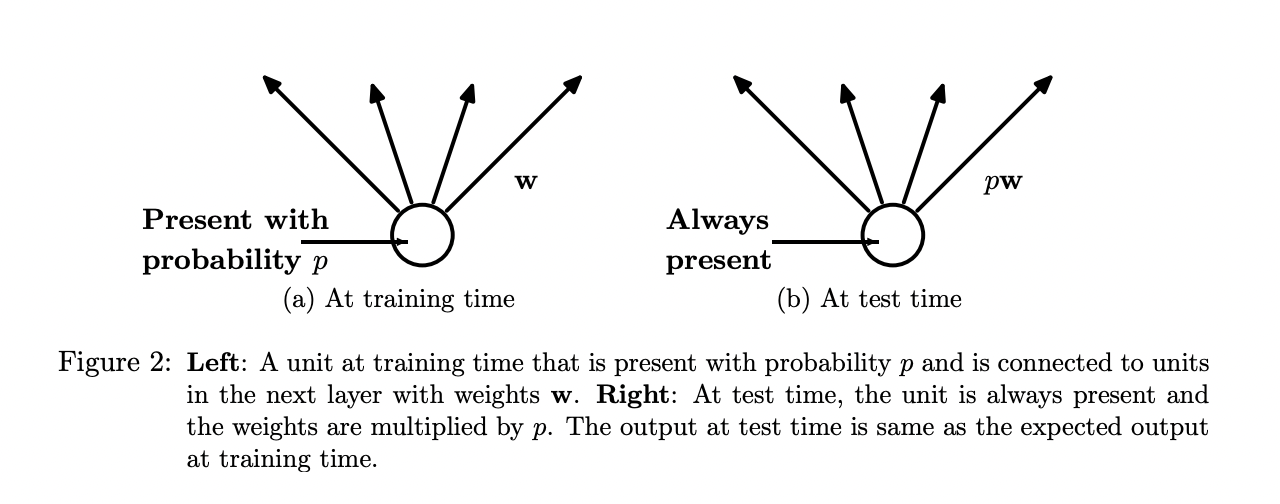

Бинарный или бернуллиевский дропаут

Бинарный или бернуллиевский дропаут

Аналогия с половым размножением - каждая модель

в ансамбле передает половину своих весов потомству с вероятностью p (исходно - 0.5).

Гауссовский дропаут

Srivastava, Hinton et al. позже показали, что Гауссовский Дропаут с непрерывным шумом работает не хуже и быстрее.

Дропаут

- Hinton 2012: https://arxiv.org/pdf/1207.0580.pdf

- Srivastava, Hinton 2014a: https://jmlr.org/papers/volume15/srivastava14a/srivastava14a.pdf

План доклада

-

История байесовских нейросетей

-

Байесовская регрессия

-

Kernel ridge regression

-

Гауссовы процессы

-

Вариационный вывод и ELBO, стохастический вариационный вывод

-

Библиотека вероятностного программирования Uber Pyro

-

Регуляризация нейросетей, бинарный и гауссовский дропаут

-

Вариационный дропаут

Вариационный дропаут

Байесовская нейронная сеть с бесконечным числом нейронов в скрытом слое ведет себя как гауссовский процесс.

Вариационный дропаут

Вариационный дропаут

Automatic Relevance Determination или Relevance Vector Machines применительно к висцеральной теории сна.

Вариационный дропаут

Ссылки

- Молчанов, Ашуха, Ветров, 2017:

https://arxiv.org/pdf/1701.05369.pdf - Kingma, Salimans, Welling, 2015:

https://arxiv.org/pdf/1506.02557.pdf - Gal, Ghahramani, 2016:

https://arxiv.org/pdf/1506.02142.pdf

Оценка неопределенности предсказания нейросетей байесовскими методамим

By vasjaforutube1

Оценка неопределенности предсказания нейросетей байесовскими методамим

- 79