Securitatea Avansata a Retelelor Informatice

Atacuri Trojan asupra Retelelor Neuronale

Burlacu Alexandru

Abstract

Abstract

utilizarea pe larga invatarii aprofundate + domenii tot mai critice ->

noi posibilitati de a ataca sisteme informationale

Abstract

Autorii propun modificarea ascunsa a unei retele neuronale.

In prezenta unei intrari declansatoare prestabilite, algoritmul functioneaza intr-un mod abnormal predefinit.

Introducere

Introducere

Modelele deep learning nu sunt interpretabilie.

Astfel este posibil de infiltrat comportamen malitios intr-un mod neobservat.

Introducere

Modelele deep learning pot fi usor "amagite" folosind intrari putin modificate (atacuri adversare).

Astfel este posibil de activat un comportamen nespecificat. Vectorul de atac fiind malformarea matricii valorii de intrare cu zgomot aleator.

Introducere

La moment nu exista metodologii ce ar permite modificarea unui algoritm de a fi susceptibil doar la o multime definita de valori de intrare si cu un comportament predefinit.

Threat Model

Threat Model

Autorii asuma accesul la reteaua neuronala si posibilitatea de a actiona ca un intermediator intre distribuitor si consumator (Man in the middle atack).

Threat Model

O alta asumptie care o au autorii este imposibilitatea de a accesa datele utilizate pentru antrenarea modelului, sau in cel mai bun caz disponibilitatea doar catorva exemplare.

Descrierea

Metodei

Pasul 1

Este aleasa o masca (imagine cu valori 0 sau 1) de o anumita forma care ulterior va deveni declansator.

O considerare ar fi ca aceasta sa arate cat mai natural cand va fi suprapusa pe imaginea, sau valoarea, de intrare.

Pasul 2

Este selectat unul sau mai multi neuroni in straturile intermediare a retelei neuronale, valorile caruia v-or fi maximizate pentru declansatorul propus.

Autorii propun utilizarea unor neuroni ce au conectivitate maxima.

Pasul 3

In baza mastii este generata o valoare de intrare ce ar maximiza valorile neuronilor alesi, folosind functia obiectiv media patrata a erorilor si functia de optimizare gradient descent

Pasul 4

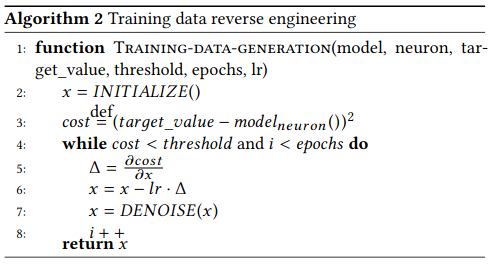

Pentru a re-antrena modelul, efectiv al modifica,

sunt necesare date de intrare. Algoritmul 2 ofera o metoda de reverse engineering a datelor care au fost utilizate in modelul original

Pasul 5

In final, modelul este adaptat utilizand datele generate, iar la datele generate cu masca aplicata, rezultatul este modificat in conformitate cu comportamentul dorit.

Rezultate

Rezultate

Metoda a fost aplicata asupra catorva clase de probleme:

recunoasterea fetelor, clasificare a imaginilor, recunoasterea vocii.

In toate cazurile comportamentul abnormal a fost inserat cu succes fara ca sa afecteze comportamentul pentru restul valorilor de intrare.

Rezultate

In urma setarii algoritmilor si a testarii altor idei, metodologia data a fost cea mai de succes, rezultand intr-o degradare minima de acuratete a modelelor originale

(< 3%)

Metode de combatere

Metode de combatere

Autorii propun ca o metoda de baza de prevenire unor astfel de atacuri de a utiliza sume hash si de a verifica validitatea modelului inainte de utilizare.

Metode ce a combate sau ameliora astfel de atacuri nu au fost propuse.

SARI Prezentare

By Alexandru Burlacu

SARI Prezentare

- 240