Offene AI statt OpenAI

By Johann-Peter Hartmann

Offene AI statt OpenAI

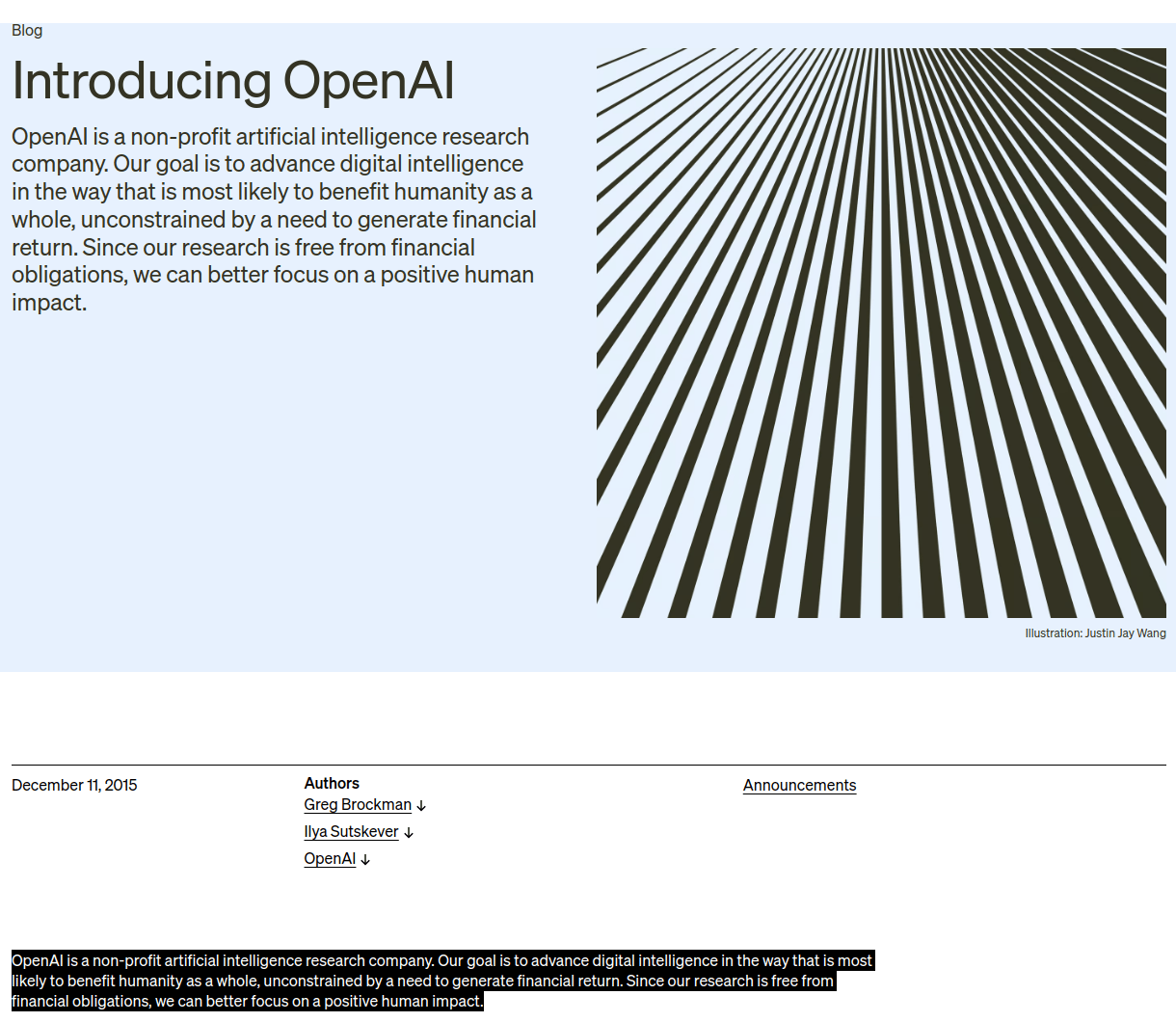

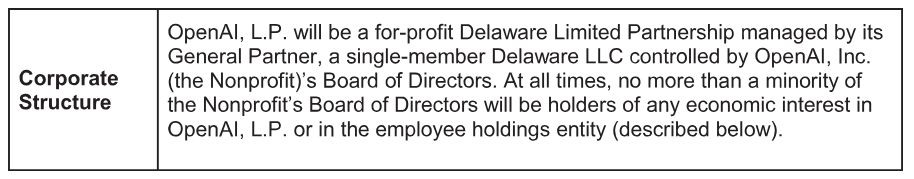

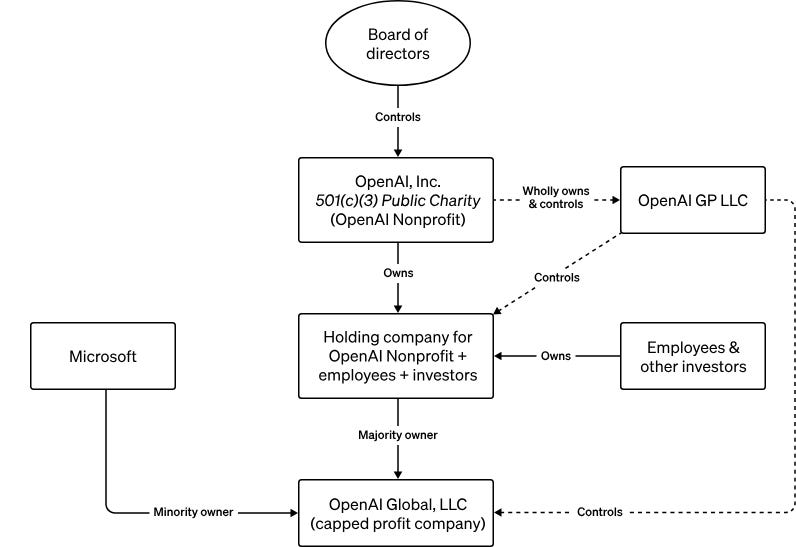

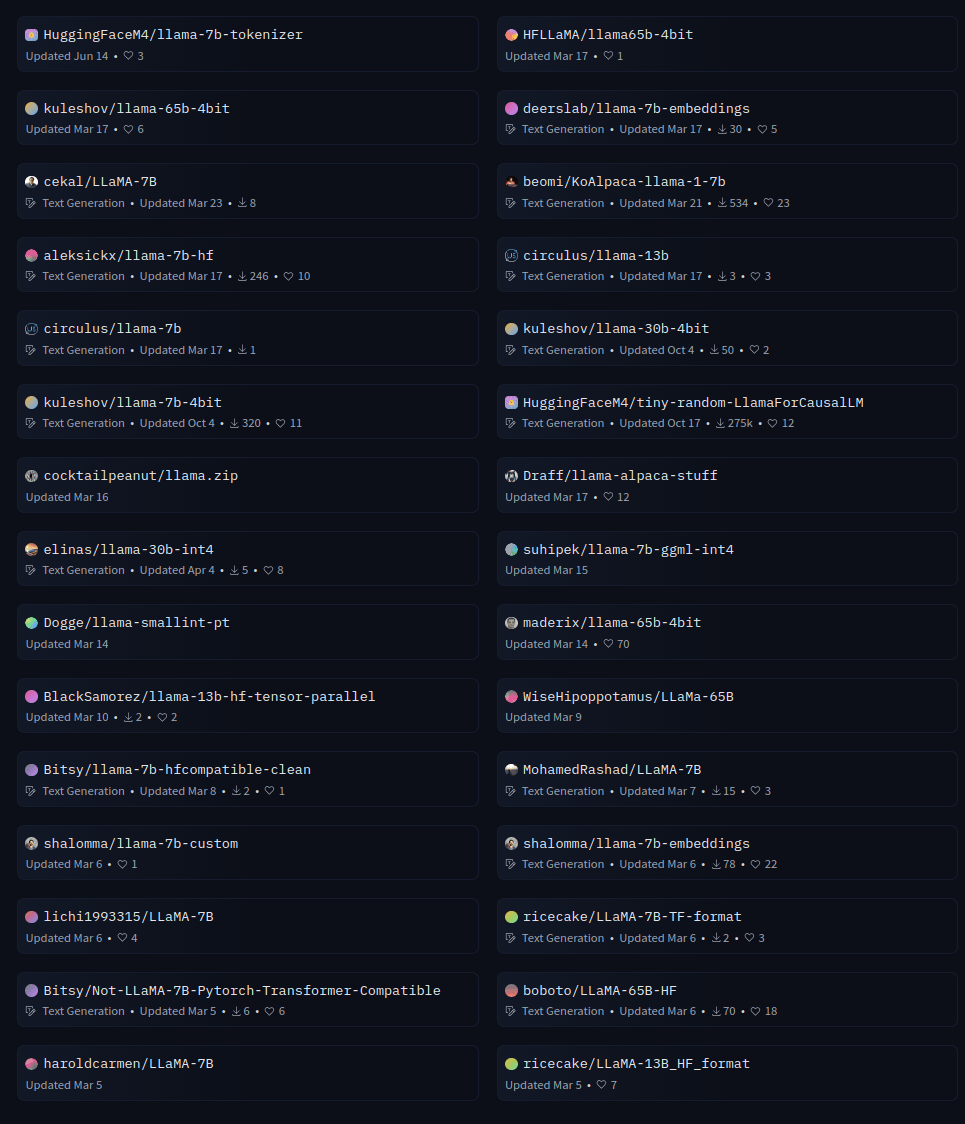

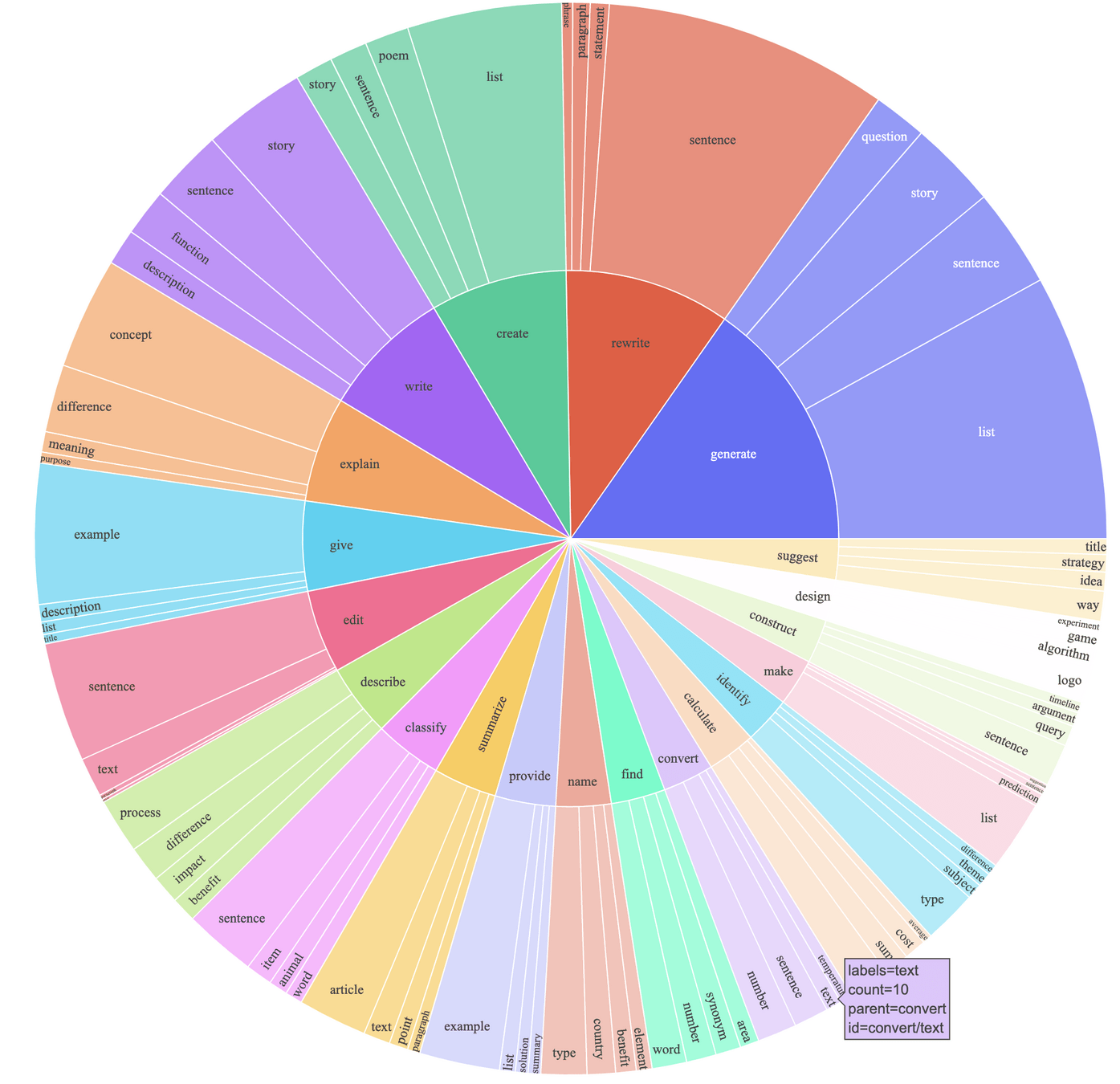

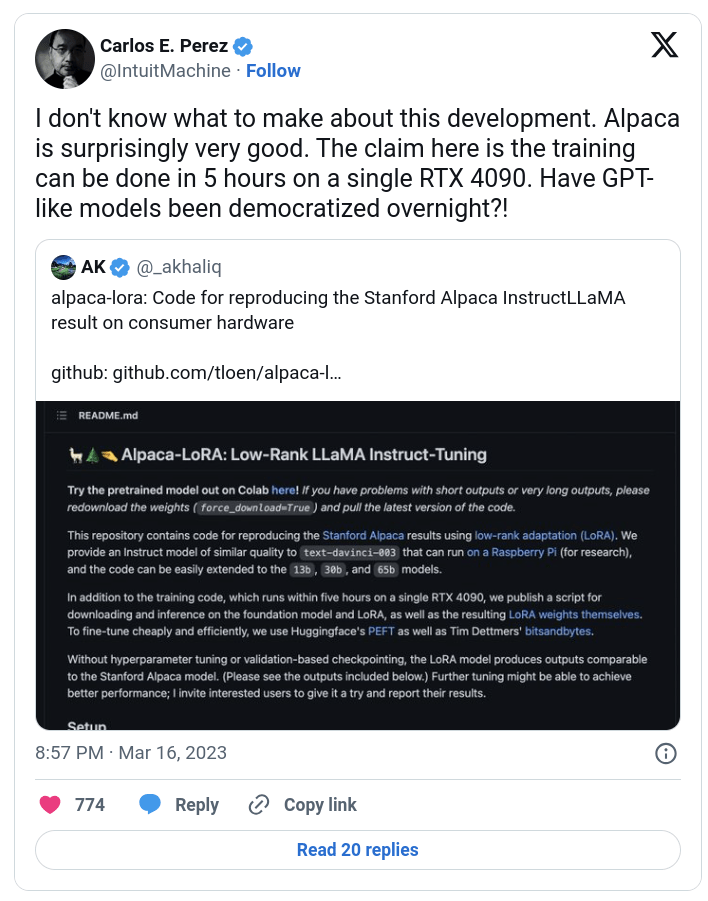

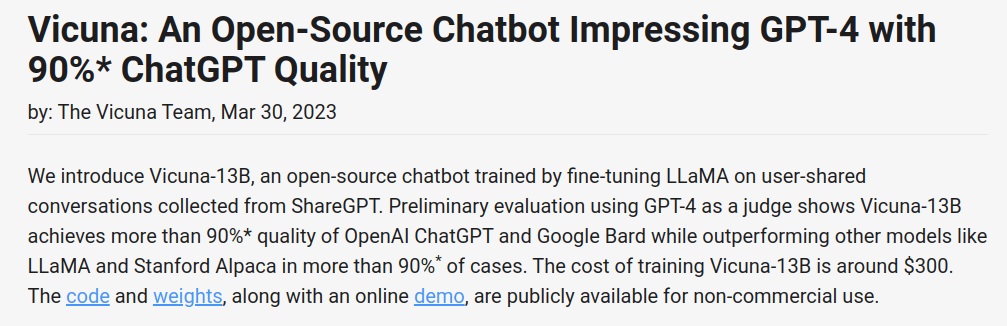

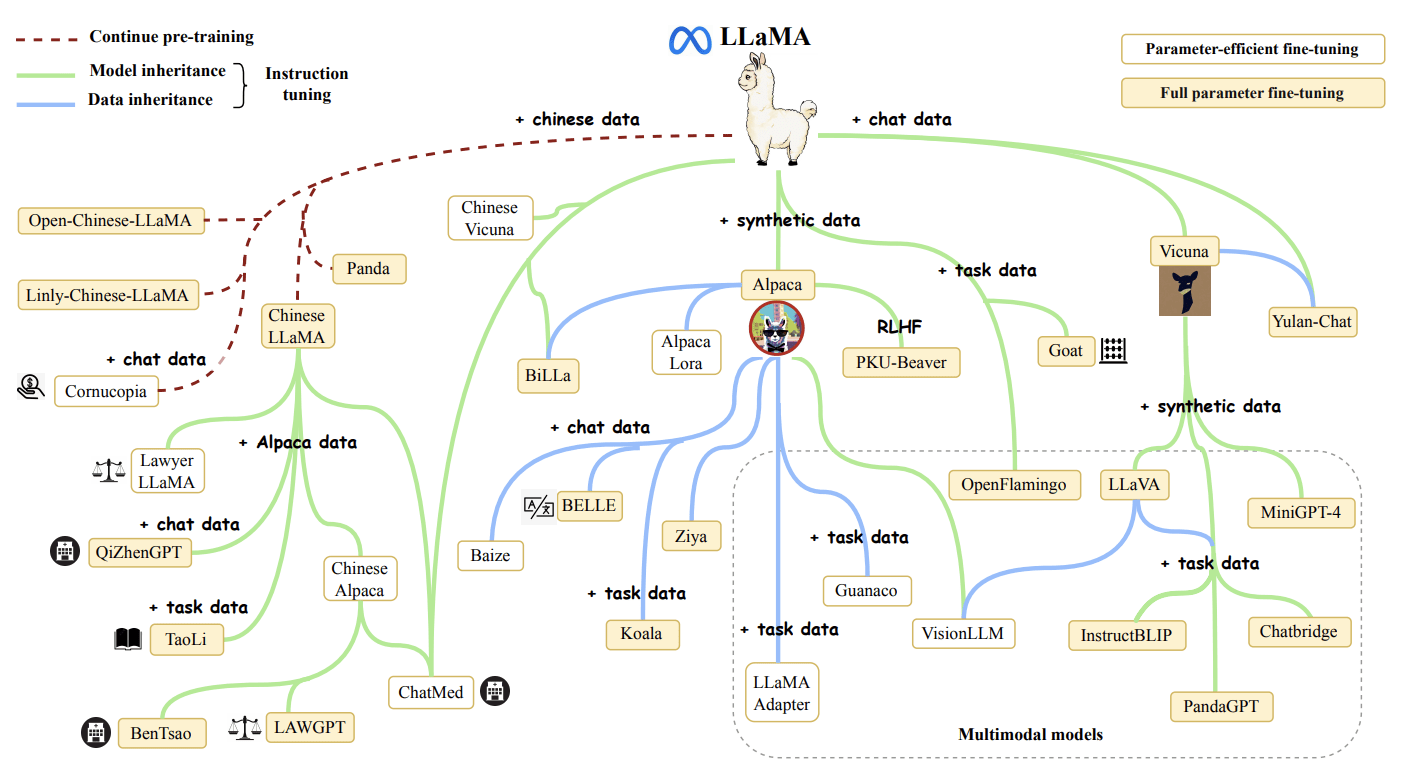

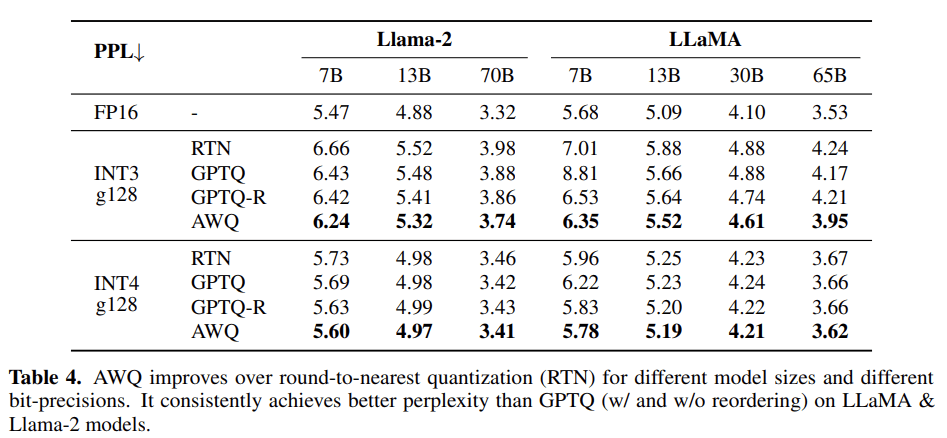

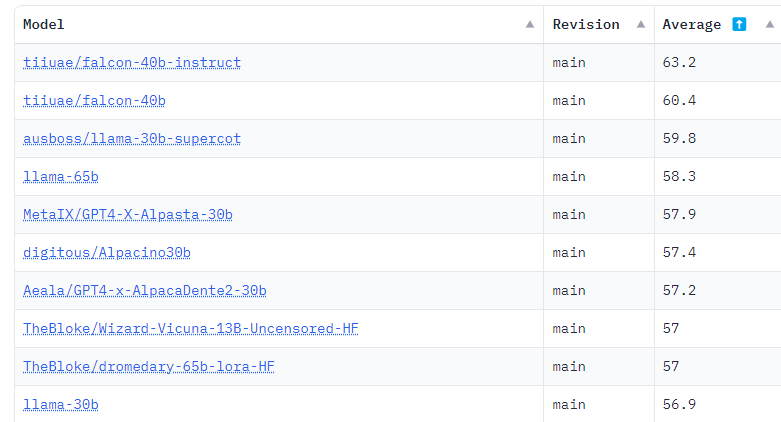

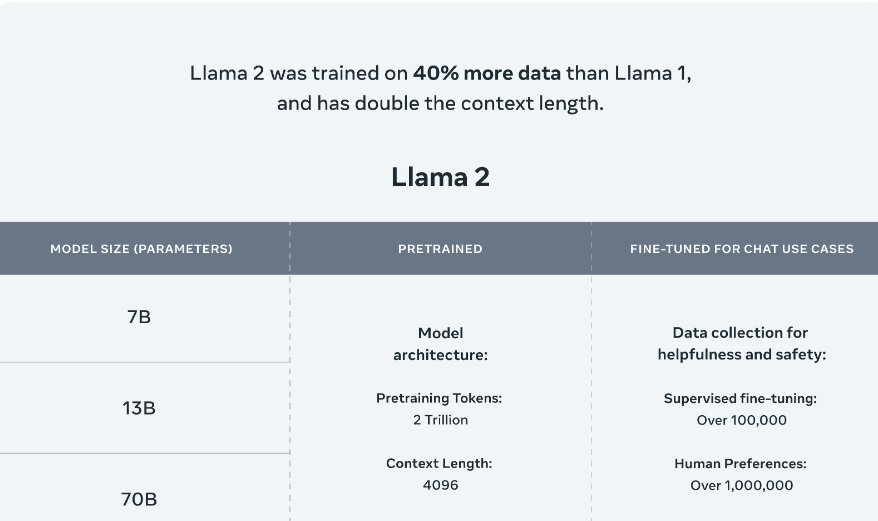

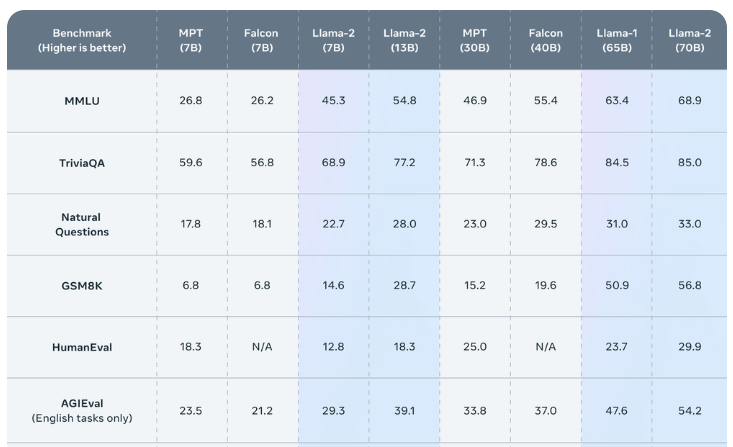

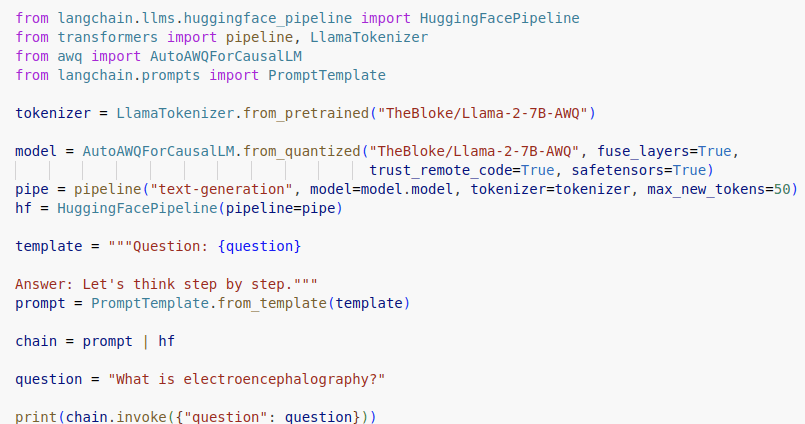

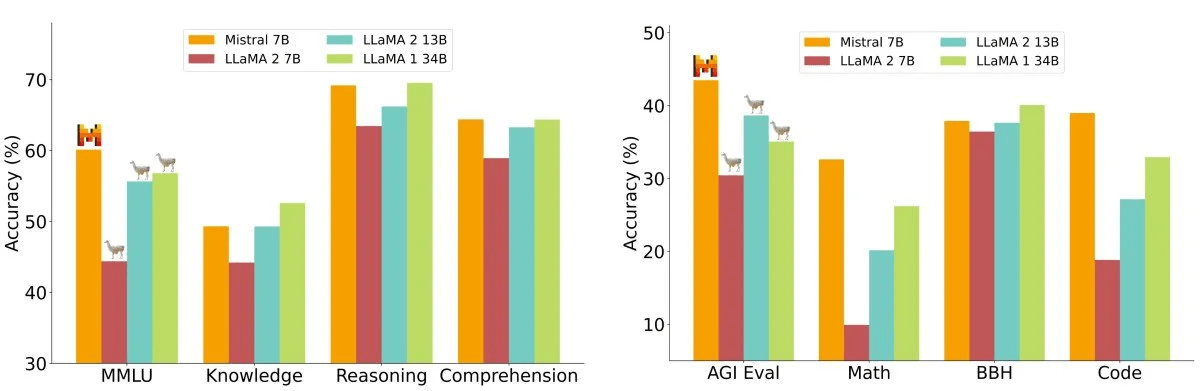

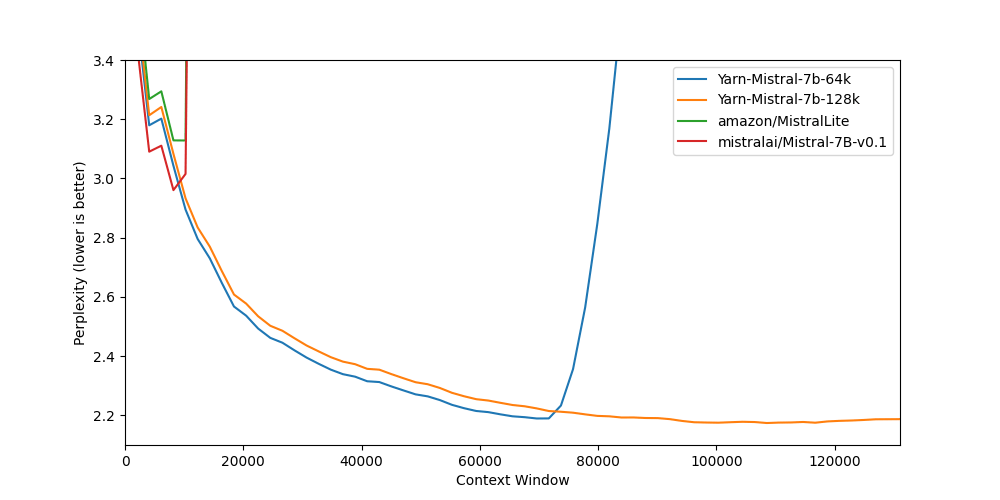

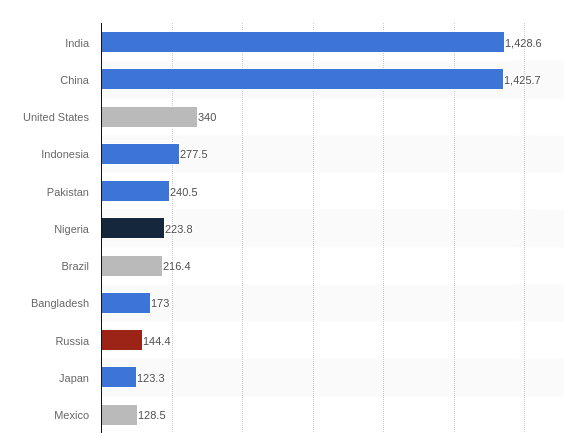

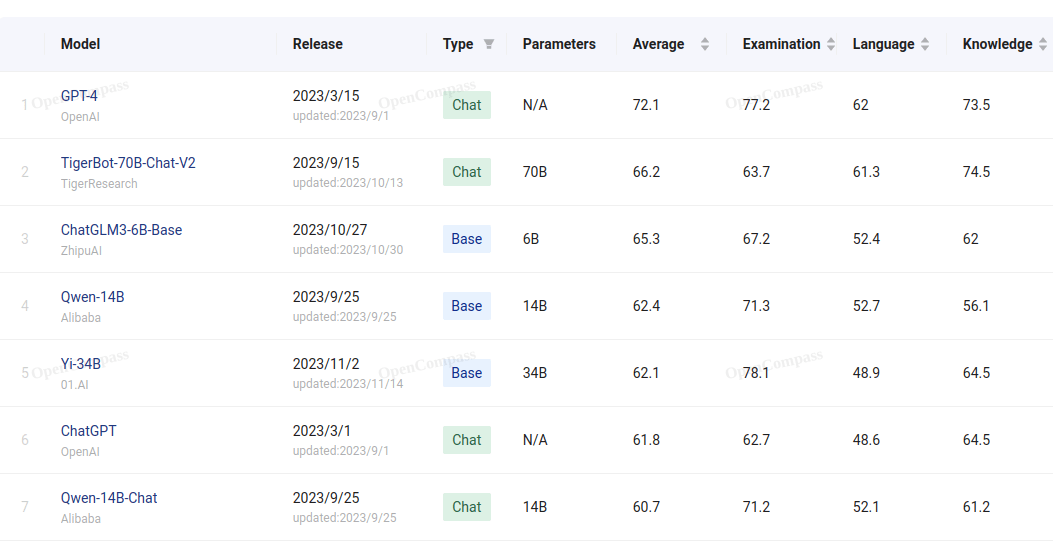

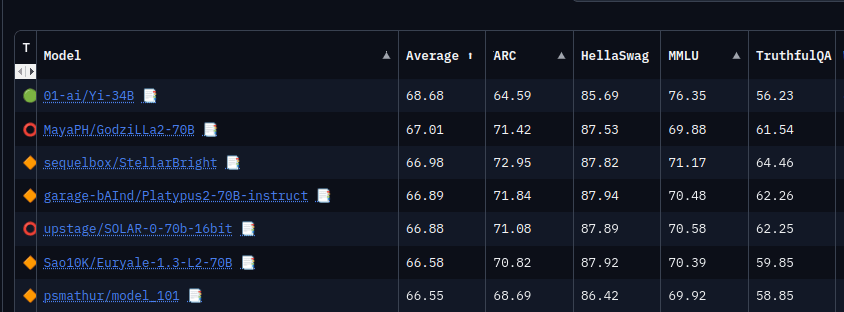

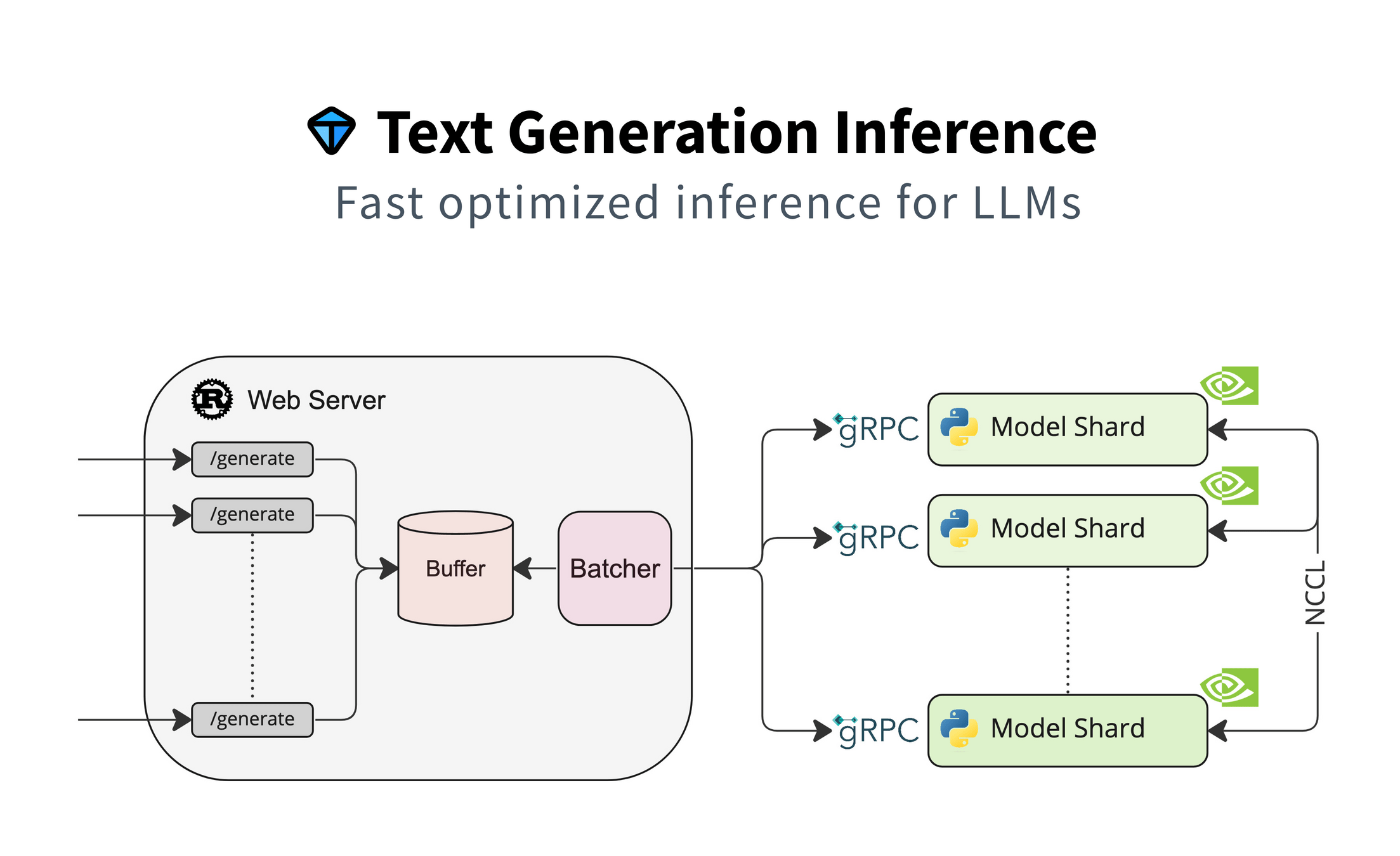

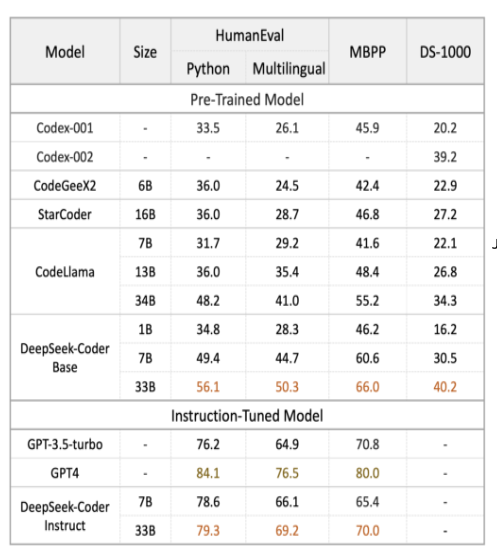

Aus der ursprünglichen Vision von OpenAI, AI offen und für jeden zugänglich zu machen, ist Microsofts wichtigstes kommerzielles Produkt geworden. Aber was ist, wenn ich selbst diese Vision noch habe und meine AI selbst betreiben möchte? Da stehen meine Chancen gut, wenn man internen Quellen von Google und Meta trauen kann. Mit LLama und Falcon wurde gezeigt, dass man offene Modelle in ähnlicher Kampfklasse selbst betreibbar sind, und viele andere Initiativen sorgen dafür, dass Daten und Trainingsmaterial in mehr als ausreichender Menge bereitstehen. Wir zeigen, was heute schon lokal mit Consumer-GPUs geht, wie weit es von GPT-4 in Funktionalität und Geschwindigkeit noch entfernt ist und was wir zu erwarten haben.